Суперкомпьютеры мира: новые проблемы, или новые возможности? Отметьте в списке все суперкомпьютеры

Суперкомпьютеры мира: новые проблемы, или новые возможности?

Статья раскрывает наличие огромного потенциала у современной вычислительной техники, позволяющей решать значительной число задач в разных отраслях знаний. Современные суперкомпьютеры задействованы в исследованиях от наноуровня до масштабов Вселенной, но рациональность их использования не всегда имеет место быть. В частности, вместо решения, например глобальных проблем современности (такой как продовольственная), более важными становятся проблемы аэродинамики, то есть экономические выгоды противоречат прогрессивной научной мысли в том её понимании, где речь идет о существовании человека в гармонии с природой.

Ключевые слова: суперкомпьютеры, Стивен Хокинг, петафлопсы. Tianhe-2, искусственный интеллект, моделирование, нанотехнологии, освоение космоса

Обработка информации – объективно существующая реальность и процесс, порождающий расширенное воспроизводство знаний. Подобно тому, как ответы на одни вопросы порождают большее количество новых, но более высокого порядка, информация по мере развития человечества накапливалась и увеличивалась, порождая необходимость в разработке более совершенных методов её сбора, хранения, накопления, изменения, защиты и транспортировки.

С появлением персональных компьютеров происходит существенное изменение понимания роли информации в современной жизни общества. Теперь это новый ресурс, а иногда и способ заработка, «кто владеет информацией, тот владеет миром». О скорости распространения информации свидетельствует и другое общеизвестное высказывание о том, что на одном конце Планеты только подумали о каком-либо действии, на другом конце эту идею уже реализовали.

Когда процесс производства, или оказания услуг, построен с использованием различных средств вычислительной техники, как правило, происходит экономия трудозатрат и рост производительности труда работников, который, в свою очередь, должен порождать рост заработной платы. Однако сам по себе компьютер не дает определенных преимуществ. Они возникают только при условии его целевого использования [3].

Уровень развития вычислительной техники определяется максимальной производительностью самого современного на этот момент изобретения. В эпоху развития робототехники, систем поддержки принятия решений и искусственного интеллекта такими «инженерными творениями» являются суперкомпьютеры. Такие «сверхЭВМ» представляют собой вычислительные машины, превосходящие в десятки, сотни и тысячи раз все современные, доступные большинству пользователей персональные компьютеры. Основной единицей измерения их производительности являются пета флопы, показывающие какое количество операций с плавающей точкой такая ЭВМ может осуществлять в секунду.

Отследить динамику развития суперкомпьютеров возможно по формируемым каждые полгода спискам топ500 по производительности. И здесь важно отметить одну интересную деталь. В частности, с началом текущего тысячелетия производительность суперкомпьютеров с каждым списком неизменно возрастала, порой опережая прежних лидеров вдвое и более раз. Однако, на протяжении последних 5 списков (с 2013г.) лидером остается китайский Tianhe-2 с пиковой производительностью в 54,902 петафлопса (54902000000000000 операций в секунду) и 3120000 ядер [2].

Огромные вычислительные мощности, доступные человечеству на данный момент определяются не только этим компьютером, но и другими из этого списка. Неизменность лидера можно объяснить опережающим ростом научно-технического прогресса в области вычислительной техники и возможностями её использования. Фактически мощности есть, но использовать их в полной мере с высокой окупаемостью пока весьма проблематично.

Для ответа на вопрос, почему это происходит, следует определить, для каких целей сегодня используются суперкомпьютеры. Во-первых, для прогнозирования и изучения погоды. Отметим при этом тот факт, что ещё Лоренцом была установлена невозможность точного предсказания погоды на долгосрочный период, где разброс в одну десятитысячную в исходных данных приводил к резонансным последствиям. Во-вторых в моделировании сложных процессов, в том числе связанных с природой. Фактически, это продолжение первого. Да, сегодня вычислительные возможности позволяют выстраивать более точные модели, но учесть все факторы по-прежнему не представляется возможным, хотя бы по причине недостаточной изученности проблемы.

Останавливаясь на моделировании, следует отметить тот факт, что оно направлено как правило на изучение реального объекта, как правило большего по своим размерам, либо его изучение «вживую» экономически нецелесообразно. Целью таких исследований выступает решение определенной проблемы (в качестве которых иногда выступают пробелы в знаниях).

В методологии решения проблем модели можно разделить на две категории: дескриптивные и нормативные. Первые отличаются неопределенностью, вероятности наступления альтернатив, или исходов событий, не всегда известны, имеется ряд ограничений. Применительно к суперкомпьютерам решение дескриптивных моделей приближает их к искусственному интеллекту, что на текущий момент в полной мере не реализовано, а, следовательно, делает такое не вполне возможным. В нормативных моделях все исходи известны, что делает моделирование почти идеальным, и именно такое моделирование посильно суперкомпьютерам, однако количество таких моделей ограничено и в настоящей действительности они имеют место быть только в условиях абстрагирования. Создание суперкомпьютеров было направлено скорее на решение реальных, нежели идеальных моделей.

Вместе с тем, именно благодаря им (в третьих) сегодня возможно более глубокое изучение космоса. Сверхвысокоточные измерения позволяют до минимума сводить погрешности космических расчетов и добиваться существенных результатов в освоении Вселенной. В четвертых, развитие нано-технологий как возможности получения новых материалов с заданными свойствами. В пятых, изучение химии и медицины: от строения вещества и природы химической связи до создания новых лекарств. В шестых, в физике – турбины электростанций, аэродинамические трубы, горение материалов, создание совершенных форм крыльев, автомобилей и проч.

Сегодня все вычислительные способности суперкомпьютеров направлены на то, чтобы сделать мир более приспособленным к обитанию в нем человека, который «что бы ни создавал, всегда создает оружие». Фактически, не исключая что с суперкомпьютерами и высокоточными моделями возможно решить ряд глобальных проблем человечества (экологическую, энергетическую, продовольственную), возникает ловушка поглощения научно-техническим прогрессом.

Законы перехода количественных изменений в качественные действуют не только в экономике, но и других сферах жизнедеятельности общества. Применительно к суперкомпьютерам, С. Хокинг отмечал: "Все эти достижения меркнут на фоне того, что нас ждет в ближайшие десятилетия. Успешное создание искусственного интеллекта станет самым большим событием в истории человечества. К сожалению, оно может оказаться последним, если мы не научимся избегать рисков."[1].

Фактически, сегодня уже существуют технологии, позволяющие роботам производить роботов без участия человека. Дальнейшая насыщаемость может привести к созданию искусственного интеллекта, который сначала упростит человечеству управление финансовыми потоками, затем рынками, потом всеми сферами жизнедеятельности, безопасностью. Последним звеном будет создание элементов, находящихся за гранью понимания человеческим мозгом (например, создание оружия, принцип которого будет понятен только сверхкомпьютеру с искусственным интеллектом).

Безусловно, та помощь и роль, которую играют современные суперкомпьютеры, сложно переоценить, но они уже сегодня управляют ядерным потенциалом всей планеты, исход такого управления на текущий момент зависит от человеческого фактора, однако с созданием искусственного интеллекта существует риск потери и этого контролирующего элемента.

Проблемы, или новые возможности открывают для человека суперкомпьютеры – данная дилемма возникает ещё и потому, что, как было отмечено выше, высокопроизводительные мощности существуют достаточно давно, а проблемы, которые призваны они решать остаются. Также губительно проходят торнадо и землетрясения, разливаются нефтяные платформы, количество эпидемий различными болезнями только увеличивается, а голодающие африканские страны сытыми по-прежнему не назовешь. С точки зрения моделирования, современные проблемы беженцев в Европе можно отнести к задачам на распределение ресурсов, транспортной задаче, вычислительных мощностей суперкомпьютера, находящегося в Европе, хватило бы для точного математического расчета. Однако какая от данного решения была бы экономическая выгода? Самый мощный суперкомпьютер мира по разным оценкам обошёлся в 200-300 миллионов долларов, и естественно, что не смотря на открытия общемирового масштаба, его главной целью является решения задач в стране-производителе (в данном случае Китае). До тех пор пока мощности этих гигантов обработки информации не будут направлены на достижение всеобщих благ, говорить о правильности использования преждевременно[4].

Подводя итог изложенному заметим, так как на протяжении нескольких лет первенство удерживается одним суперкомпьютером, это может свидетельствовать о достижении определенного порога, за которым последует резкий качественно новый прорыв в области высоких технологий. Если говорить о России, то её вычислительные мощности определены суперкомпьютером «Ломоносов», производительность которого составляет 0,8 Петафлопс, что значительно меше китайского. В связи с экономическим, производственным и социальным спадом в 90-е годы прошлого столетия сегодня в нашей стране много вопросом, решение которых может быть осуществлено с помощью суперкомпьютеров. В этой связи, в региональном аспекте применение современных и высокоточных технологий позволит добиться значительных результатов.

- Стивен Хокинг: "искусственный интеллект – величайшая ошибка человечества" [электронный ресурс] режим доступа: http://nig.mirtesen.ru/blog/43761849374/Stiven-Hoking:-Iskusstvennyiy-intellekt-–-velichayshaya-oshibka- (дата обращения 29.01.2016г.)

- Центр компьютерногго инжиниринга СПбПУ [электронный ресурс] режим доступа: http://fea.ru/news/6241 (дата обращения 29.01.2016г.)

- Экономические исследования: анализ состояния и перспективы развития. Монография. Том 34/Яковлев А.С., Польшакова Н.В. и др.: Воронеж: ВГПУ, 2014 г....–С.88-99

- Kovalev A.S., Alfeyeva Ye.L., Polshakova N.V., Morozova O.Yu. Some problems of computer work stability augmentation in academic process and its service term prolongation under the control of Windows Vista operating system // European Journal of Natural History. 2008. № 1. С. 109-110.

Основные термины (генерируются автоматически): искусственный интеллект, суперкомпьютер, вычислительная техника, модель, моделирование, текущий момент, Европа, полная мера, научно-технический прогресс, мощность.

moluch.ru

Суперкомпьютеры

Министерство образования Российской Федерации

НОВОСИБИРСКИЙ ГОСУДАРСТВЕННЫЙ ТЕХНИЧЕСКИЙ УНИВЕРСИТЕТ

Кафедра Автоматики и Вычислительной Техники

Реферат

на тему: "Современные суперЭВМ"

Факультет: АВТ Преподаватель: ……………………….

Группа: АП-318

Студент: Цырендылыков Батор

Новосибирск,

2003 г.

Содержание:

Суперкомпьютеры - что это?. 3

Суперкомпьютеры - зачем это?. 5

Суперкомпьютеры - как это?. 7

Все новое - это хорошо забытое старое. 9

А что же сейчас используют в мире?. 12

Если где-то прибудет, то где-то обязательно уменьшится. 14

Приложения. 16

Первые 25 суперкомпьютеров из списка Top500 (ноябрь 2003): 16

Сверхсложные вычислительные задачи, решаемые на суперкомпьютерах. 18

Классификация архитектур вычислительных систем (Классификация Флинна) 19

Наиболее распространенные сегодня суперкомпьютеры: 21

Список использованной литературы: 23

Суперкомпьютеры - что это?

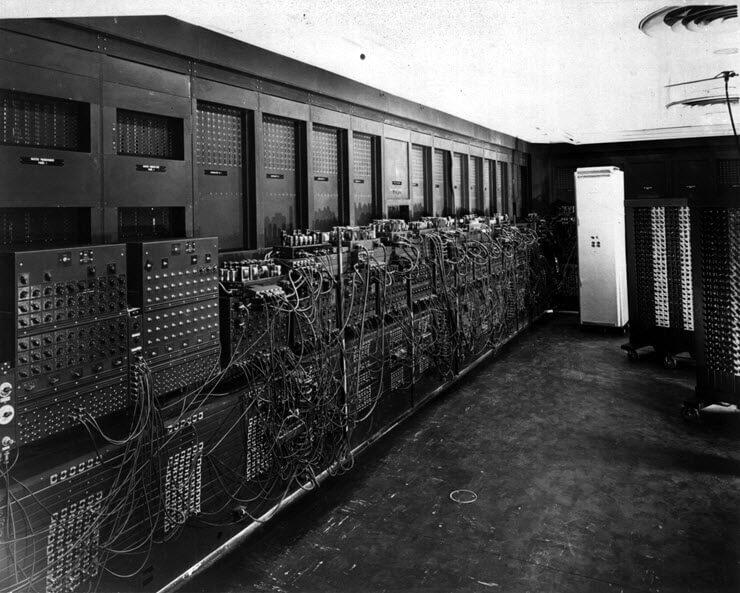

О том, что где-то существуют некие мистические "очень мощные" компьютеры слышал, наверное, каждый. В самом деле, не так давно было много разговоров о поставке в Гидрометеоцентр России могучих компьютеров фирмы Cray Research. В прессе регулярно проходят сообщения о нелегальных поставках вычислительной техники, попадающей под эмбарго американского правительства. Опять же, если компьютер с именем Deep Blue самого Гарри Каспарова, то он, согласитесь - и здесь интуиция Вас не подвела, ну никак не может быть простой персоналкой.

Для многих подобные компьютеры так и остаются тайной за семью печатями, некой TERRA INCOGNITA, с которой ассоциации всегда связаны с чем-то большим: огромные размеры, большие задачи, крупные фирмы и компании, невероятные скорости работы или что-то иное, но обязательно это будет "на грани", для чего "обычного" явно мало, а подойдет только "супер", суперкомпьютер или супер-ЭВМ. В этом интуитивном восприятии есть изрядная доля истины, поскольку к классу супер-ЭВМ принадлежат лишь те компьютеры, которые имеют максимальную производительность в настоящее время. Быстрое развитие компьютерной индустрии определяет относительность данного понятия - то, что десять лет назад можно было назвать суперкомпьютером, сегодня под это определение уже не попадает. Например, производительность персональных компьютеров, использующих Pentium-II/300MHz, сравнима с производительностью суперкомпьютеров начала 70-х годов, однако по сегодняшним меркам суперкомпьютерами не являются ни те, ни другие.

В любом компьютере все основные параметры тесно связаны. Трудно себе представить универсальный компьютер, имеющий высокое быстродействие и мизерную оперативную память, либо огромную оперативную память и небольшой объем дисков. Следуя логике, делаем вывод: супер-ЭВМ это компьютеры, имеющие в настоящее время не только максимальную производительность, но и максимальный объем оперативной и дисковой памяти, а также специализированное ПО, с помощью которого можно эффективно всем этим воспользоваться.

Определений суперкомпьютерам пытались давать много, иногда серьезных, иногда ироничных. В частности, лет пять назад, когда эта тема поднималась в конференции comp.parallel, Кен Батчер (Ken Batcher) предложил такой вариант: суперкомпьютер - это устройство, сводящее проблему вычислений к проблеме ввода/вывода. Все верно, в каждой шутке есть доля шутки: что раньше долго вычислялось, временами сбрасывая нечто на диск, на супер-ЭВМ может выполниться мгновенно, переводя стрелки неэффективности на относительно медленные устройства ввода/вывода.

Так о чем же речь, и какие суперкомпьютеры существуют в настоящее время в мире? Вот несколько примеров, показывающих основные параметры машин этого класса.

CRAY T932, векторно-конвейерный компьютер фирмы CRAY Research Inc. (в настоящее время это подразделение Silicon Graphics Inc.), впервые выпущенный в 1996 году. Максимальная производительность одного процессора равна почти 2 млрд. операций в секунду, оперативная память наращивается до 8Гб (Гига это в тысячу раз больше, чем Мега), дисковое пространство до 256000Гб (т.е. 256Тб, Тера это в тысячу раз больше, чем Гига). Компьютер в максимальной конфигурации содержит 32 подобных процессора, работающих над единой общей памятью, поэтому максимальная производительность всей вычислительной системы составляет более 60 млрд. операций в секунду.

IBM SP2, массивно-параллельный компьютер фирмы IBM (иногда такие компьютеры называют компьютерами с массовым параллелизмом). В настоящее время строится на основе стандартных микропроцессоров PowerPC 604e или POWER2 SC, соединенных между собой через высокоскоростной коммутатор, причем каждый имеет свою локальную оперативную память и дисковую подсистему. Характеристики этих микропроцессоров известны и особых удивлений не вызывают, однако в рамках одной SP системы их может быть объединено очень много. В частности, максимальная система, установленная в Pacific Northwest National Laboratoriy (Richland, USA), содержит 512 процессоров. Исходя из числа процессоров, можно представить суммарную мощность всей вычислительной системы...

HP Exemplar, компьютер с кластерной архитектурой от Hewlett-Packard Inc. В частности, модель V2250 (класс V) построена на основе микропроцессора PA-8200, работающего с тактовой частотой 240MHz. До 16 процессоров можно объединить в рамках одного узла с общей оперативной памятью до 16Гб. В свою очередь узлы в рамках одной вычислительной системы соединяются между собой через высокоскоростные каналы передачи данных.

ASCI RED, детище программы Accelerated Strategic Computing Initiative, - это самый мощный на настоящий момент компьютер. Построенный по заказу Министерства энергетики США, он объединяет 9152 (!) процессоров Pentium Pro, имеет 600Гб суммарной оперативной памяти и общую производительность 1800 миллиардов операций в секунду. Человеку потребовалось бы 57000 лет, чтобы даже с калькулятором выполнить все те операции, которые этот компьютер делает за 1 секунду!

Простые расчеты показывают, что даже умеренные конфигурации таких компьютеров могут стоить не один миллион долларов США - ради интереса прикиньте, сколько стоят, скажем, лишь 600 Гбайт оперативной памяти? Возникает целый ряд естественных вопросов:

Какие задачи настолько важны, что требуются компьютеры стоимостью несколько миллионов долларов?

Или, какие задачи настолько сложны, что хорошего Pentium-IV не достаточно?

Суперкомпьютеры - зачем это?

Для того, чтобы оценить сложность решаемых на практике задач, возьмем конкретную предметную область, например, оптимизацию процесса добычи нефти. Имеем подземный нефтяной резервуар с каким-то число пробуренных скважин - по одним на поверхность откачивается нефть, по другим обратно закачивается вода. Нужно смоделировать ситуацию в данном резервуаре, чтобы оценить запасы нефти или понять необходимость в дополнительных скважинах.

Примем упрощенную схему, при которой моделируемая область отображается в куб, однако и ее будет достаточно для оценки числа необходимых арифметических операций. Разумные размеры куба, при которых можно получать правдоподобные результаты - это 100*100*100 точек. В каждой точке куба надо вычислить от 5 до 20 функций: три компоненты скорости, давление, температуру, концентрацию компонент (вода, газ и нефть - это минимальный набор компонент, в более реалистичных моделях рассматривают, например, различные фракции нефти). Далее, значения функций находятся как решение нелинейных уравнений, что требует от 200 до 1000 арифметических операций. И наконец, если исследуется нестационарный процесс, т.е. нужно понять, как эта система ведет себя во времени, то делается 100-1000 шагов по времени. Что получилось:

106(точек сетки)*10(функций)*500(операций)*500(шагов по времени) = 2.5*1012

2500 миллиардов арифметических операций для выполнения одного лишь расчета! А изменение параметров модели? А отслеживание текущей ситуации при изменении входных данных? Подобные расчеты необходимо делать много раз, что накладывает очень жесткие требования на производительность используемых вычислительных систем.

Примеры использования суперкомпьютеров можно найти не только в нефтедобывающей промышленности (см. Приложение).

По данным Марка Миллера (Mark Miller, Ford Motor Company), для выполнения crash-тестов, при которых реальные автомобили разбиваются о бетонную стену с одновременным замером необходимых параметров, съемкой и последующей обработкой результатов, компании Форд понадобилось бы от 10 до 150 прототипов новых моделей при общих затратах от 4 до 60 миллионов долларов. Использование суперкомпьютеров позволило сократить число прототипов на одну треть.

В 1995 году корпус автомобиля Nissan Maxima удалось сделать на 10% прочнее благодаря использованию суперкомпьютера фирмы Cray (The Atlanta Journal, 28 мая, 1995г). С помощью него были найдены не только слабые точки кузова, но и наиболее эффективный способ их удаления. Совсем свежий пример - это развитие одной из крупнейших мировых систем резервирования Amadeus, используемой тысячами агентств со 180000 терминалов в более чем ста странах. Установка двух серверов Hewlett-Packard T600 по 12 процессоров в каждом позволила довести степень оперативной доступности центральной системы до 99.85% при текущей загрузке около 60 миллионов запросов в сутки.

И подобные примеры можно найти повсюду. В свое время исследователи фирмы DuPont искали замену хлорофлюорокарбону. Нужно было найти материал, имеющий те же положительные качества: невоспламеняемость, стойкость к коррозии и низкую токсичность, но без вредного воздействия на озоновый слой Земли. За одну неделю были проведены необходимые расчеты на суперкомпьютере с общими затратами около 5 тысяч долларов. По оценкам специалистов DuPont, использование традиционных экспериментальных методов исследований потребовало бы около трех месяцев и 50 тысяч долларов и это без учета времени, необходимого на синтез и очистку необходимого количества вещества.

mirznanii.com

Суперкомпьютер: Прогресс | Журнал Популярная Механика

Соображения, заставляющие строить суперкомпьютеры, пугающе напоминают логику, которая двигала гонкой вооружений. Нам нужны все большие компьютерные мощности, чтобы наши конкуренты не использовали против нас свое технологическое превосходство.

Анатомия суперкомпьютера

Крис Маррокин залез по пояс в открытый на полу люк. Этот высокий парень среднего телосложения сейчас выглядит коротышкой, а его рубашка раздута до шварценеггеровского объема вырывающимся из люка прохладным ветром. Сжимая в руках дюймовый шланг, он пытается объяснить мне устройство системы жидкостного охлаждения в суперкомпьютерах IBM следующего поколения, однако из-за ревущего ветра я почти ничего не слышу. Мы находимся на заводе IBM в Рочестере, штат Миннесота, в экспериментальном цеху. Здесь инженеры компании собирают и испытывают суперкомпьютеры Blue Gene. Воздушный поток, который сейчас раздувает рубашку Маррокина, должен охлаждать небольшую, собранную всего на четырех стойках систему Blue Gene/P. Ее производительность — 13,9 терафлопа в пересчете на одну стойку. А вот шланг, который Маррокин держит в руках, — часть куда более продвинутой системы охлаждения. Через него идет деионизированная вода с бензотриазолом в качестве антикоррозионной добавки и небольшой дозой антисептика, и этот шланг тянется к прототипу сверхмощной новинки — компьютеру Blue Gene/Q. Стойка Blue Gene/Q установлена как бы на приподнятой трибуне и обеспечена собственной системой охлаждения — это 250 м медных трубок с контрольными клапанами, легкосъемными резиновыми шлангами и электронным монитором, который следит за скоростью потока, давлением и точкой росы. Если что-то в системе пойдет наперекосяк, она должна автоматически отключиться.

Впрочем, в разряд наивысших достижений современной техники этот аппарат попал не из-за своей весьма сложной системы охлаждения, а благодаря неслыханной вычислительной мощности — в каждой стойке здесь содержится 1024 процессорных чипа, и в каждом таком микропроцессоре имеется по 16 ядер. Умножив, получим 16384 — это общее число действующих процессоров, которые, работая совместно, выдают производительность 209 терафлопов (это в 15 раз больше, чем у компьютера Blue Gene/P). В будущем году 96 комплектов Blue Gene/Q отправятся в Калифорнию, в Национальную лабораторию им. Лоуренса в Ливерморе (LLNL), прямо в руки к Брюсу Гудвину. Будучи включены в единую сеть, эти 96 стоек превратятся в самый мощный компьютер мира. Супермашина сможет предсказывать пути движения ураганов, расшифровывать генные цепочки и вести анализ топографии океанского дна в поисках нефтяных месторождений. Правда, у Гудвина для нее уготовлена в основном другая работа — его интересуют ядерные взрывы.

Раньше Гудвин подрывал ядерные заряды старым дедовским способом. С 1983 по 1991 год он разработал и провел пять испытаний ядерного оружия в Неваде на испытательном полигоне министерства энергетики. Вместе с коллегами он бурил колодец глубиной 600 м, укладывал боеголовку вместе с измерительным оборудованием в стальной контейнер высотой с 10-этажный дом и весом в 500 т и спускал этот контейнер на дно колодца. Потом всем оставалось только отбежать подальше, скрестить пальцы и нажать на кнопку. «Когда сидишь в пультовом бункере за 16 км от эпицентра, чувствуешь себя как при землетрясении магнитудой 5 — 6 баллов», — рассказывает Гудвин.

В октябре 1992 года все переменилось — президент Джордж Буш объявил мораторий на все виды ядерных испытаний. Этот акт предшествовал «Всестороннему договору 1996 года о запрете ядерных испытаний». С этого момента, если у страны возникала потребность испытать какую-либо боеголовку в своем многотысячном арсенале, она могла обратиться только к компьютерному моделированию. Таким образом, потребность в мощных компьютерах вышла в число национальных приоритетов.

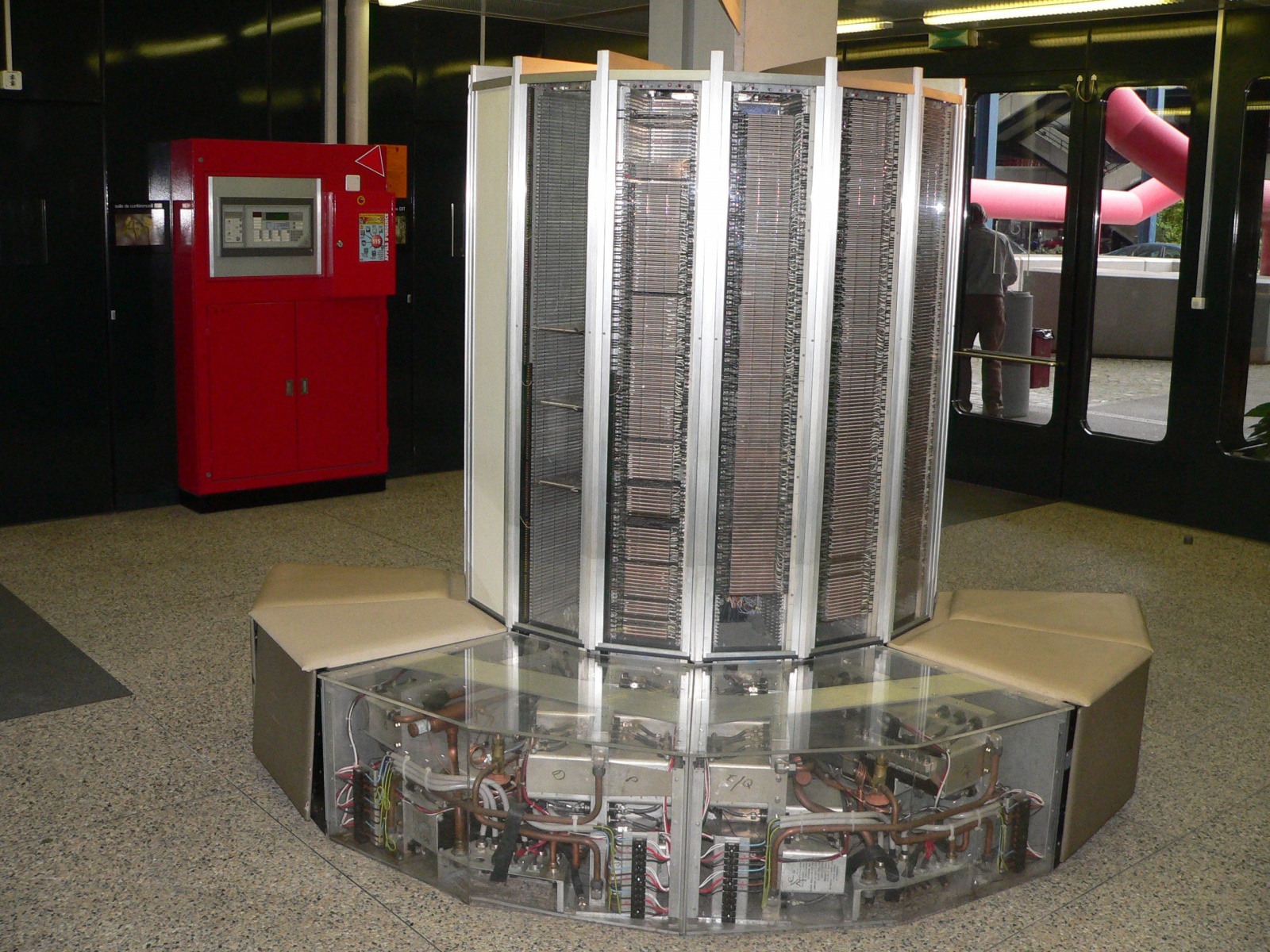

Понятие «суперкомпьютер» существует почти так же долго, как и само представление о компьютере, но этот термин вошел в оборот только в 1976 году, когда Сеймур Крей построил аппарат Cray-1. Он обошелся в $8,8 млн ($35 млн по нынешнему курсу) и работал со скоростью 160 мегафлопов. Да уж! Современный ПК раз в 50 превосходит по быстродействию тогдашний Cray. Приставка «супер» в этом контексте стала настолько расплывчатой, что многие компьютерщики теперь вообще избегают термина «суперкомпьютер» и называют такие машины просто «высокопроизводительными компьютерами» (High-Performance Computers, HPC). Чтобы внести хоть немного ясности в этот вопрос, с 1993 года частная группа Top500 начала два раза в год публиковать список из 500 самых мощных компьютеров мира.

Список Top500 публикуется уже 18 лет, и в течение 17 из них первые места делились между американскими и японскими машинами. Но вот пришел 2010 год, и Китай объявил претензию на первое место, представив аппарат Tianhe-1A мощностью 2,6 петафлопа. Обычно компьютерные специалисты, разрабатывающие и воплощающие эти технические решения, служат в транснациональных компаниях, а потому не торопятся объявлять о своих достижениях как о поводе для национальной гордости. Тем не менее суперкомпьютер стал символом технического уровня государства. Теперь космическая гонка как бы продолжилась, но уже в форме состязаний на поприще транзисторных технологий. В нынешних гонках лидеры и догоняющие поминутно меняются местами. Не прошло и восьми месяцев, как Япония снова обошла Китай, продемонстрировав в июне 2011 года K Computer мощностью 8 петафлопов. В августе китайцы ответили публикацией своей «дорожной карты», ведущей к компьютерным технологиям уровня exascale (это значит повышение быстродействия еще на три порядка — от «пета» до «экза»). В течение ближайших 10 лет обещано 125-кратное увеличение компьютерного быстродействия. В этом контексте Tianhe-1A можно рассматривать как китайский аналог первого советского спутника. Тогда проект exascale будет аналогичен полету на Луну.

Роль суперкомпьютеров в поддержании боеспособности американского ядерного потенциала обеспечивает им приоритетный статус. Теперь, когда Китай бросает вызов западному компьютерному превосходству, многие специалисты в этой области, равно как и многие эксперты по политической части, заговорили о том, что суперкомпьютеры должны играть немалую роль и в обеспечении национальной экономической безопасности. Эти машины многократно умножают мощь американской науки, инженерных разработок и коммерческого планирования, так что обладатели самых мощных компьютеров имеют фору в экономической гонке. Суперкомпьютеры не просто отражают достигнутый уровень интеллектуальной и технологической мощи — они сами способны повышать этот уровень.

В Рочестере, на заводе IBM, сотрудники не слишком много думают о претензиях Китая на мировое господство в области суперкомпьютеров. Их дело — решать инженерные задачи при создании Blue Gene/Q, так что в центре их внимания не политика, а конструкция, над которой они работают. Это настоящие технари, и их звания согласно штатному расписанию звучат по‑бюрократически коряво и ничего не говорят посторонним об их реальных полномочиях. «Наше дело просто вкалывать, закатав рукава, — объясняет Пат Маллиган, начальник экспериментального цеха в системе Global Server Integration (у него действительно были закатаны рукава, что подкрепляло искренность его слов). — Мы не слишком интересуемся вопросами национального приоритета и просто стараемся делать компьютеры как можно лучше».

Само здание, в котором Маррокин, Маллиган и остальные сотрудники IBM конструируют самые мощные компьютеры XXI века, можно считать памятником корпоративному честолюбию в стиле середины ХХ века. Его проектировал знаменитый архитектор Ээро Сааринен (Мост Сан-Луи — это тоже его работа), раскинувшаяся во все стороны постройка облицована темно-синим стеклом. Внутри здания цеха проходы почти на километр. Когда-то компания, старающаяся всегда быть на переднем крае технического прогресса, заложила под полом этих залов электрические кабели — чтобы роботы могли самостоятельно перевозить детали для сборки и прочую технику из цеха в цех. Роботов здесь уже нет — мечта о полной механизации не устояла под натиском реальности. Роботы оказались слишком медлительны и так часто ломались, что на заводе решили вернуться к обычным погрузчикам с ручным управлением.

Те компьютеры Blue Gene/Q, которые мне показали в середине лета, еще нельзя назвать частью суперкомпьютера Брюса Гудвина (ему дано имя Sequoia). Это были пока еще только тестовые модели, которые используются для испытаний и поиска ошибок в аппаратной и программной части. Производство тех 96 стоек, из которых будет собрана Sequoia, должно начаться позднее. Гудвин со своей командой в лаборатории им. Лоуренса в Ливерморе уже что-то вводит в эту еще не до конца собранную машину, что-то свое подстраивает, действуя из своего далекого далека. На одной из стоек в сборочном цеху Рочестера красуется табличка «LLNL, блок удаленного доступа».

Установка моделирования терамасштаба (TSF), которая стоит у Гудвина в Ливерморе, — это один из двух центров DOE (министерства энергетики), выполняющих работы по ядерному компьютерному моделированию и являющихся частью программы Stockpile Stewardship (второй такой центр расположен в Нью-Мексико, в Национальной лаборатории в Лос-Аламосе). Для того чтобы проводимое моделирование отражало реальные физические процессы с приемлемой точностью, в лаборатории Гудвина строят трехмерную модель 50-микросекундного фрагмента взрыва с пространственным разрешением до 10 микрон. «Задача становится очень сложной, — говорит Гудвин. — Вещество здесь и сжимается, и взрывается, а вам нужно отслеживать всю динамику в этих потоках с точностью швейцарских часов». Каждый раз, когда в американских боеголовках заменяют или модернизируют тот или иной компонент, на TSF проводят новую серию виртуальных тестов, чтобы убедиться, что обновленная бомба взорвется именно в нужный момент. При компьютерном моделировании всплывают такие аспекты ядерной реакции, которые изначально даже и не предполагались, так что число и сложность используемых алгоритмов непрерывно растут. При современных технологиях за один цикл моделируется лишь какая-то часть полного взрыва, и даже при таком дроблении самые сложные программы, которые прогоняют в лаборатории Гудвина, могут содержать до миллиона строчек кода. Если бы у нас была в запасе тысяча лет, все эти расчеты можно было бы провести и на обычном ноутбуке, та система Blue Gene/P, которая стоит сейчас в Ливерморе и имеет мощность 500 терафлопов (ей присвоено имя Dawn), управляется с задачами моделирования высокой степени сложности за один месяц. Когда в 2012 году запустят систему Sequoia быстродействием в 20 петафлопов, время прогона одного теста снизится до нескольких дней".

Математика, воплощенная в суперкомпьютерах, обретает невиданную силу. Так, компьютер Blue Gene/P недавно просчитал число «пи» до миллиардного знака. Интересно еще и то, что конструкция современного суперкомпьютера позволяет легко менять его масштаб. Рассмотрим эту возможность на примере компьютера Sequoia, который состоит из 96 отдельных стоек с процессорами. Как говорит доктор Джордж Л.Т. Чу, один из ведущих исследователей в компании IBM, проведя относительно несложную перестройку в аппаратной части и программном обеспечении, Blue Gene/Q можно раздуть до агрегата, содержащего 32768 отдельных стоек. При этом его быстродействие должно достичь 6848 петафлопов. «Теперь вас может ограничивать только сумма в долларах, которую вы готовы потратить, — говорит Чу. — Ну и конечно, вам потребуется приличный источник энергии».

Да, мы чуть не забыли об электроэнергии. Здесь суперкомпьютеры сталкиваются с серьезной проблемой. Sequoia станет самым мощным суперкомпьютером в мире, но при этом она будет и самым прожорливым аппаратом. На пиковых нагрузках Sequoia должна потреблять больше 9 МВт — это энергозапросы примерно 7200 частных жилых домов. С другой стороны, та же Sequoia обещает стать и самым экономичным компьютером, так как в удельном пересчете картина выглядит гораздо оптимистичней. Эта машина на один израсходованный ватт электроэнергии будет выполнять 2 гигафлопа вычислений. Сравним с японским рекордсменом по имени K Computer — тот на 1 Вт электроэнергии выполняет всего 800 мегафлопов, то есть в 2,5 раза меньше. Отметим, что, наращивая вычислительную мощность такого компьютера, мы прямо пропорционально увеличиваем и его энергопотребление. Берем компьютер Sequoia и удваиваем в нем количество стоек. В результате получим вдвое более высокую производительность, но зато новый компьютер будет потреблять вдвое больше энергии. Доведя энергоэффективность до уровня мирового рекорда, мы, конечно, смягчаем эту проблему, но решенной ее считать нельзя.

Китай — не единственная страна, замахнувшаяся на exascale. В министерстве энергетики США считают, что американская технологическая конкурентоспособность напрямую зависит от достижений в области суперкомпьютеров. Такие компании, как Intel и Nvidia, уже к концу этого десятилетия обещают выйти на уровень exascale. Это настоящий технический вызов, который нужно встретить во всеоружии, когда не обойдешься простым наращиванием вычислительных мощностей. «Для того чтобы создавать машины уровня exascale, необходимо предвидеть, как будут выглядеть прикладные задачи и программы через 10, 15 или 20 лет», — говорит Дэйв Турек, вице-президент IBM, занимающийся работами в направлении exascale. Турек хорошо представляет себе наше будущее, когда объемы данных и скорость их поступления на машины повысятся на несколько порядков, когда потребуется радикальный пересмотр всех основ компьютерной техники — таких, как принципы хранения данных, организация работы сетей, программное обеспечение и системы энергопитания.

Разработка суперкомпьютеров — это такое хобби, которое влетает государству в копеечку. В министерстве энергетики оценивают общую стоимость разработки компьютера Sequoia и Blue Gene/P Dawn примерно в $250 млн. Плюс к этому годовые энергорасходы на работу компьютера петауровня составляют от 5 до 10 млн. Специалисты в этой области уже понимают, что нельзя и дальше повышать расходы, надеясь, что они окупятся новыми вычислительными возможностями. С другой стороны, Гудвин и другие такие же потребители уже не мыслят жизни без подобных компьютеров. Гудвин обращает наше внимание на то, что китайское правительство официально поставило перед собой цель использовать суперкомпьютеры, чтобы вывести страну на передовой промышленный уровень. Естественно, никому не хочется отставать. «Используя суперкомпьютер при разработке новой продукции, можно заранее предвидеть многие скрытые инженерные проблемы и довести продукт до рынка в пять раз быстрее, чем это делалось раньше, когда в работоспособности нового продукта нужно было убеждаться собственными глазами, — говорит Гудвин. — Подумайте, как это скажется на национальной экономике, если Boeing, General Motors или General Electric будут выпускать на рынок новую продукцию, тратя не годы, а всего лишь месяцы. Это играет огромную роль, и если кто-то успеет на рынок впятеро быстрее, чем вы, вам придется просто уйти из бизнеса».

Понятна нынешняя потребность в подобных машинах, так как они нужны для поддержания ядерных арсеналов в боевой готовности, но строительство такой техники в будущем напоминает нам недавнюю ситуацию с гонкой ядерного вооружения. Либо у нас будут большие вычислительные мощности, чем у конкурентов, либо же они используют против нас свое технологическое превосходство. Какой же компьютер удовлетворил бы Гудвина с его моделированием ядерных взрывов? Если компьютер с быстродействием 500 терафлопов решает такие задачи за месяц, а компьютер с быстродействием 20 петафлопов управляется за считанные дни, сможет ли компьютер с экзафлоповой производительностью проводить моделирование в режиме реального времени? Ответ самого Гудвина таков: «Для моделирования в режиме реального времени экзафлоповая машина все еще слишком медлительна». Он объяснил, что для режима реального времени потребуется компьютер с производительностью 100 йоттафлопов — это означает 100 х 1024 вычислений в секунду, то есть в 100 млн раз быстрее, чем должна работать «экзафлоповая» машина.

Статья опубликована в журнале «Популярная механика» (№2, Февраль 2012).www.popmech.ru

Современные суперкомпьютеры | Журнал сетевых решений/LAN

СУПЕРКОМПЬЮТЕР K COMPUTER

Ранее занимавший первое место суперкомпьютер K Computer отодвинут на третье место. Его производительность составляет 11,28 Пфлопс (см. Рисунок 1). Напомним, что флопс (FLoating-point Operations Per Second, FLOPS) — это единица измерения производительности компьютеров, которая показывает, сколько операций с плавающей запятой в секунду способна выполнить данная вычислительная система.

| Рисунок 1. В основу суперкомпьютера K Computer с производительностью 11,28 Тфлопс положена архитектура распределенной памяти. |

K Computer является совместной разработкой Института физико-химических исследований Рикагаку Кенкийо (RIKEN) и Fujitsu. Он создавался в рамках инициативы High-Performance Computing Infrastructure (Инфраструктура высокопроизводительных компьютерных вычислений), возглавляемой японским министерством образования, культуры, спорта, науки и технологий (MEXT). Суперкомпьютер установлен на территории Института передовых вычислительных наук в японском городе Кобе.

В основу суперкомпьютера положена архитектура распределенной памяти. Система состоит из более чем 80 000 вычислительных узлов и размещается в 864 стойках, каждая из которых вмещает 96 вычислительных узлов и 6 узлов ввода/вывода. Узлы, содержащие по одному процессору и по 16 Гбайт оперативной памяти, соединяются между собой в соответствии с топологией «шестимерная петля / тор». В общей сложности в системе используется 88 128 восьмиядерных процессоров SPARC64 VIIIfx (705 024 ядра), произведенных Fujitsu по технологии 45 нм.

Этот суперкомпьютер общего назначения обеспечивает высокий уровень производительности и поддержку широкого ряда приложений. Система используется для проведения исследований в области климатических изменений, предотвращения стихийных бедствий и медицины.

Уникальная система водяного охлаждения позволяет снизить вероятность отказа оборудования и сократить общее энергопотребление. Экономия энергии достигается за счет применения высокоэффективного оборудования, системы когенерации тепло- и электроэнергии и массива солнечных батарей. Кроме того, механизм повторного использования отработанной воды из охладителя позволяет снизить негативное влияние на окружающую среду.

Здание, в котором расположен K Computer, является сейсмоустойчивым и способно выдерживать землетрясения магнитудой 6 и более баллов по японской шкале (0–7). Для более эффективного размещения стоек с оборудованием и кабелей третий этаж размером 50 × 60 м полностью освобожден от несущих колонн. Современные технологии строительства позволили обеспечить допустимый уровень нагрузки (до 1 т/м2) для установки стоек, вес которых может достигать 1,5 т.

СУПЕРКОМПЬЮТЕР SEQUOIA

Суперкомпьютер Sequoia, установленный в Ливерморской национальной лаборатории им. Лоуренса, обладает производительностью 16,32 Пфлопс и занимает вторую строчку рейтинга (см. Рисунок 2).

| Рисунок 2. Система Sequoia с производительностью 16,32 Пфлопс состоит из 96 стоек и 98 304 вычислительных узлов (1024 узла на стойку). |

Этот петафлопсный суперкомпьютер, разработанный компанией IBM на базе Blue Gene/Q, создан для Национальной администрации по ядерной безопасности США (NNSA) в рамках реализации программы Advanced Simulation and Computing (Высокотехнологичное моделирование и компьютерные вычисления).

Система состоит из 96 стоек и 98 304 вычислительных узлов (1024 узла на стойку). Каждый узел включает в себя 16-ядерный процессор PowerPC A2 и 16 Гбайт оперативной памяти DDR3. В целом используется 1 572 864 процессорных ядра и 1,6 Пбайт памяти. Узлы соединяются между собой в соответствии с топологией «пятимерный тор». Занимаемая системой площадь равна 280 м2. Общее энергопотребление составляет 7,9 МВт.

На суперкомпьютере Sequoia впервые в мире были проведены научные вычисления, для которых требовалась вычислительная мощность более 10 Пфлопс. Так, системе космологического моделирования HACC потребовалось около 14 Пфлопс при запуске в режиме 3,6 трлн частиц, а во время запуска кода проекта Cardiod для моделирования электрофизиологии человеческого сердца производительность достигла почти 12 Пфлопс.

СУПЕРКОМПЬЮТЕР TITAN

Самым быстрым в мире суперкомпьютером был признан суперкомпьютер Titan, установленный в Окриджской национальной лаборатории (ORNL) в США. В тестовых испытаниях Linpack его производительность составила 17,59 Пфлопс.

В Titan реализована гибридная архитектура CPU-GPU (см. Рисунок 3). Система состоит из 18 688 узлов, каждый из которых оснащен 16-ядерным процессором AMD Opteron и графическим ускорителем Nvidia Tesla K20X. В общей сложности используется 560 640 процессоров. Titan представляет собой обновление ранее эксплуатировавшегося в ORNL суперкомпьютера Jaguar и занимает те же серверные шкафы (общей площадью 404 м2).

| Рисунок 3. В самом быстром в мире суперкомпьютере Titan с производительностью 17,59 Пфлопс реализована гибридная архитектура CPU-GPU. |

Возможность использования уже существующих систем питания и охлаждения позволила сэкономить в ходе строительства около 20 млн долларов. Энергопотребление суперкомпьютера составляет 8,2 МВт, что на 1,2 МВт больше показателей Jaguar, при этом его производительность при выполнении операций с плавающей точкой выше почти в 10 раз.

Titan в первую очередь будет использоваться для проведения исследований в области науки о материалах и ядерной энергетики, а также исследований, касающихся повышения эффективности работы двигателей внутреннего сгорания. Кроме того, с его помощью будут выполняться моделирование климатических изменений и анализ потенциальных стратегий по устранению связанных с ними негативных последствий.

САМЫЙ «ЗЕЛЕНЫЙ» СУПЕРКОМПЬЮТЕР

Помимо рейтинга Top500, нацеленного на определение наиболее высокопроизводительной системы, существует рейтинг Green500, где отмечены самые «зеленые» суперкомпьютеры. Здесь за основу принят показатель энергоэффективности (Мфлопс/Вт). На данный момент (последний выпуск рейтинга — ноябрь 2012 года) лидером Green500 является суперкомпьютер Beacon (253-е место в Top500). Показатель его энергоэффективности составляет 2499 Мфлопс/Вт.

Beacon работает на базе сопроцессоров Intel Xeon Phi 5110P и процессоров Intel Xeon E5-2670, поэтому пиковая производительность может достигать 112 200 Гфлопс при общем энергопотреблении в 44,9 кВт. Сопроцессоры Xeon Phi 5110P обеспечивают высокую производительность при низком энергопотреблении. Каждый сопроцессор обладает мощностью в 1 Тфлопс (при выполнении операций с двойной точностью) и поддерживает до 8 Гбайт памяти класса GDDR5 с пропускной способностью в 320 Гбит/с.

Пассивная система охлаждения Xeon Phi 5110P рассчитана на TDP 225 Вт, что является идеальным показателем для серверов высокой плотности.

СУПЕРКОМПЬЮТЕР EURORA

Однако в феврале 2013 года появились сообщения о том, что суперкомпьютер Eurora, расположенный в городе Болонья (Италия), по энергоэффективности превзошел Beacon (3150 Мфлопс/ватт против 2499 Мфлопс/Вт).

Eurora построен компанией Eurotech и состоит из 64 узлов, каждый из которых включает в себя два процессора Intel Xeon E5-2687W, два ускорителя Nvidia Tesla K20 GPU и другое оборудование. Габариты подобного узла не превышают габаритов ноутбука, однако их производительность выше в 30 раз, а энергопотребление ниже в 15 раз.

Высокая эффективность энергопотребления в Eurora достигнута путем использования нескольких технологий. Наибольший вклад вносит водяное охлаждение. Так, каждый узел суперкомпьютера представляет собой своеобразный бутерброд: центральное оборудование снизу, водяной теплообменник в середине и еще один блок электроники сверху (см. Рисунок 4).

| Рисунок 4. Система водяного охлаждения в суперкомпьютере Eurora. |

Столь высокие результаты обеспечиваются благодаря применению материалов с хорошей теплопроводностью, а также разветвленной сетью охлаждающих каналов. При установке нового вычислительного модуля его каналы совмещаются с каналами системы охлаждения, что позволяет менять конфигурацию суперкомпьютера в зависимости от конкретных потребностей. По заверению производителей, риск протечек исключен.

Электропитание элементов суперкомпьютера Eurora осуществляется посредством 48-вольтовых источников постоянного тока, внедрение которых позволило сократить число преобразований энергии. Наконец, отводимая от вычислительного оборудования теплая вода может использоваться и в других целях.

ЗАКЛЮЧЕНИЕ

Отрасль суперкомпьютеров активно развивается и ставит все новые и новые рекорды производительности и энергоэффективности. Следует отметить, что именно в этой отрасли, как нигде более, сегодня широко применяются технологии жидкостного охлаждения и 3D-моделирования, так как перед специалистами стоит задача скомпоновать сверхмощную вычислительную систему, которая была бы способна функционировать в ограниченном объеме при минимальных потерях энергии.

Юрий Хомутский — главный инженер проектов компании «Ай-Теко». С ним можно связаться по адресу: [email protected]. В статье использованы материалы интернет-портала о центрах обработки данных «www.AboutDC.ru — Решения для ЦОД».

www.osp.ru

Более ста суперкомпьютеров из Top 500 используют ускорители вычислений

Не секрет, что всё больше суперкомпьютеров используют вычислительные ускорители на базе графических процессоров, или же специальные сопроцессоры, чтобы достигнуть невиданной мощности при относительно небольшом энергопотреблении. Согласно данным из нового списка пятисот самых мощных суперкомпьютеров в мире, более сотни уже использует GPU-ускорители. Карты NVIDIA Tesla продолжают оставаться самыми популярными ускорителями для высокопроизводительных вычислений (high-performance computing, HPC).

Рост производительности суперкомпьютеров замедляется

Согласно обновлённому списку Top 500, опубликованному на этой неделе, общая вычислительная мощность всех самых мощных суперкомпьютеров в мире выросла до 420 квадриллионов операций с плавающей запятой в секунду (420 петафлопс – PetaFLOPS [floating point operations per second]) с 361 петафлопс год назад. 80 HPC-систем имеют производительность в один петафлопс, по сравнению с 67 машинами в июле этого года года. Наименее мощный суперкомпьютер из Top 500 может выполнять 204,3 триллионов операций в секунду (терафлопс), тогда как ранее мощность самой медленной Top 500 системы в мире была 164 терафлопс.

Суперкопьютер Cray XK7

Авторы рейтинга Top 500 отмечают, что рост производительности самых быстрых суперкомпьютеров замедляется. Во многом это происходит вследствие замедления роста производительности центральных процессоров, а также некоторых задержек с выходом в свет новейших ускорителей и сопроцессоров для супервычислений.

Количество GPU в суперкомпьютерах растёт

В общей сложности 104 системы в списке пятисот самых мощных суперкомпьютеров в мире используют вычислительные ускорители AMD FirePro S, NVIDIA Tesla или сопроцессоры Intel Xeon Phi. А еще в июле этого года лишь 90 систем использовали подобные устройства. 66 систем из 104 использует NVIDIA Tesla, 27 используют Intel Xeon Phi и три используют AMD FirePro. Четыре системы используют комбинацию из NVIDIA Tesla и Intel Xeon Phi. NVIDIA продолжает доминировать на рынке суперкомпьютерных ускорителей, однако успех Intel Xeon Phi налицо. Примечательно, что, по данным NVIDIA, 23 из 24 новых GPU-ускоренных систем в списке построенным на базе Tesla.

«Я верю, что в один прекрасный день GPU-ускорение будет доступно у всех суперкомпьютеров мира», — сказал Дженсен Хуанг (Jen-Hsun Huang), соучредитель и генеральный директор NVIDIA. «К GPU-ускоряемым вычислениям уже обратились ведущие суперкомпьютерные центры мира, что нашло отражение в актуальной версии списка TOP500. Учитывая, что темп научных открытий растет и ученые все чаще обращаются к вычислениям, машинному обучению и визуализации, в будущем эта тенденция только усилится».

Intel Xeon Phi в составе Tianhe 2

Согласно данным последнего исследования компании Intersect360 Research, почти 70 % из 50 самых популярных HPC-приложений — и 90% из 10 ведущих — поддерживают GPU-ускоренные вычисления. Таким образом, всё указывает на то, что доля графических процессоров в суперкомпьютерах продолжит расти в ближайшие годы.

«Ландшафт индустрии HPC сегодня серьезно изменился, и произошло это благодаря графическим процессорам NVIDIA Tesla», — отметил Эддисон Снелл (Addison Snell), один из авторов исследования, генеральный директор Intersect360 Research. «Применение ускорителей и число GPU-ускоренных версий ведущих HPC кодов неуклонно растет».

Tianhe 2 остаётся самым мощным суперкомпьютером

В верхней части нового списка из пятисот самых мощных суперкомпьютеров в мире, который был выпущен на этой неделе, не произошло существенных изменений.

Самым мощным суперкомпьютером на планете по-прежнему является китайский Tianhe 2, спроектированный оборонным научно-техническим университетом народно-освободительной армии Китайской Народной Республики и компанией Inspur. Он способен выполнять 33,86 квадриллионов операций с плавающей запятой в секунду (33,86 петафлопс). Данная система базируется на процессорах Intel Xeon E5-2692v2 (двенадцать ядер, тактовая частота 2,2 ГГц), а также использует 48 тысяч сопроцессоров Xeon Phi Intel 31S1P. В общей сложности, Tianhe 2 располагает 3,12 миллионами x86-ядер.

Суперкомпьютер Tianhe 2

На втором месте находится суперкомпьютер Titan, который установлен в национальной лаборатории Ок-Ридж (Oak Ridge) министерства энергетики США, и обладает мощностью 17,59 петафлопс. Данная система представляет собой кластер Cray XK7 c шестнадцатиядерными AMD Opteron и ускорителями NVIDIA Tesla K20X.

Третья по мощности HPC-система в мире — Sequoia — может выполнять 17,173 квадриллионов операций с плавающей запятой в секунду и принадлежит Ливерморской национальной лаборатории министерства энергетики США имени Э. Лоуренса (Lawrence Livermore National Laboratory, LLNL). Система использует 98 304 процессора IBM Power BQC (шестнадцать ядер, частота 1,60 ГГц) и была построена IBM.

Суперкомпьютер Ломоносов 2

Самым мощным суперкомпьютером в России остался Ломоносов 2, который имеет мощность 1,849 петафлопс (36 место в рейтинге). Данная система была построена компанией T-Platforms для МГУ имени М.В. Ломоносова на базе процессоров Intel Xeon E5-2697v3 (14 ядер, 2,60 ГГц) и ускорителей NVIDIA Tesla K40m.

Если вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

3dnews.ru

Суперкомпьютеры: почти искусственный интеллект - ITC.ua

Мощнейшие вычислительные системы современности, суперкомпьютеры, задействованы в физических, химических и биологических исследованиях, прогнозируют погоду на всей планете и даже наравне с людьми принимают участие в интеллектуальных викторинах.

История

Называть гордым именем «суперкомпьютер» принято вычислительные системы, существенно превосходящие по производительности типичные ПК своего времени. Так, первым в истории вычислительным монстром считается антикитерский механизм – аналоговый компьютер из Древней Греции (100 год до н. э.). Хитроумное устройство и правда превосходило по возможностям все астрономические приборы того времени и не имело аналогов аж до эпохи Возрождения.

Антикитерский механизм

Антикитерский механизмВпервые термин «супервычисления» засветился в статье про табулятор IBM из Колумбийского университета в газете New York World еще в 1920 году. Термин же «суперкомпьютер» приписывают инженерам Джорджу Майклу и Сиднею Фернбаху, в 1960-х трудившихся в Ливерморской национальной лаборатории и компании CDC.

Табулятор IBM Hollerith Type III

Табулятор IBM Hollerith Type IIIНо пионером и одним из активнейших деятелей в мировом суперкомпьютеростроении по праву считается Сеймур Крэй. Он с середины 1960-х до 1996 года создавал мощнейшие вычислительные системы для правительственных учреждений и научно-исследовательских центров США. С именем ученого даже связано альтернативное шутливое толкование термина «суперкомпьютер» – любой компьютер, созданный Крейем.

Сеймур Крэй и первый полностью им спроектированный суперкомпьютер Cray-1 (1974 год, производительность 80 MFLOPS)

Сеймур Крэй и первый полностью им спроектированный суперкомпьютер Cray-1 (1974 год, производительность 80 MFLOPS)Лучшие из лучших

Рейтинг мощнейших в мире суперкомпьютеров TOP500 обновляется дважды в год. Свежий список был опубликован месяц назад и, как это часто случается, произошла смена лидера.

Топ-десятка мощнейших суперкомпьютеров на планете

Топ-десятка мощнейших суперкомпьютеров на планетеНепобедимым как минимум на полгода, до публикации нового рейтинга, будет оставаться китайский вычислительный монстр TH-IVB-FEP Cluster с кодовым именем Tianhe-2. Спроектирован он компанией Inspur и размещен в Оборонном научно-техническом университете НОАК в городе Чанша.

Многочисленные монтажные шкафы суперкомпьютера Tianhe-2

Многочисленные монтажные шкафы суперкомпьютера Tianhe-2Вычислительная мощь Tianhe-2 равна 33,86 PFLOPS, чего удалось достичь путем объединения в кластер шестнадцати тысяч узлов. Каждый узел включает два процессора Intel Xeon E5-2692 (12 ядер), три сопроцессора Intel Xeon Phi 31S1P (57 упрощенных ядер, 8 ГБ памяти GDDR5) и 64 ГБ оперативной памяти. Суммарный объем оперативной памяти Tianhe-2 составляет 1 ПБ, а энергопотребление – 17,8 МВт.

Локальная сеть Tianhe-2

Локальная сеть Tianhe-2Второе место в обновленном рейтинге TOP500 занимает экс-чемпион – американский суперкомпьютер Cray XK7 с кодовым именем Titan. Выполнен он по схожей с Tianhe-2 схеме, сочетающей центральные процессоры и сопроцессоры (графические ускорители). Вот только вместо чипов Intel в Titan применяются процессоры AMD Opteron 6274 (16 ядер) и серверные видеокарты NVIDIA Tesla K20X.

Суперкомпьютер Titan украшен стильным граффити

Суперкомпьютер Titan украшен стильным граффитиСуперкомпьютер Titan – уже не первый вычислительный монстр компании Cray Inc., построенный по заказу Окриджской национальной лаборатории. Зато он самый мощный (17,59 PFLOPS) и самый прожорливый (8,21 МВт) из них.

Но эта цифра ничто по сравнению с энергопотреблением японского K computer (четвертое место в рейтинге TOP500): 12,66 МВт при производительности 10,51 PFLOPS. Тут-то и проявляется несовершенство архитектуры суперкомпьютеров, в которой применяются только центральные процессоры (в случае K computer – это восьмиядерные Fujitsu SPARC64 VIIIfx).

Величественный на вид K computer

Величественный на вид K computerАналогичный подход при проектировании суперкомпьютеров использует компания IBM. Третье и восьмое места рейтинга американские BlueGene/Q Sequoia и Vulcan построены исключительно на центральных процессорах IBM Power BQC (16 ядер).

Монтаж одного из узлов Sequoia

Монтаж одного из узлов SequoiaПравда, процессорная архитектура Power является куда более энергоэффективной, чем SPARC64. Как результат, Sequoia и Vulcan демонстрирует неплохое соотношение вычислительной мощности и прожорливости: 17,17 PFLOPS при 7,8 МВт и 4,29 PFLOPS при 1,97 МВт.

IBM BlueGene/Q Vulcan – новичок в топ-десятке мощнейших суперкомпьютеров планеты

IBM BlueGene/Q Vulcan – новичок в топ-десятке мощнейших суперкомпьютеров планетыВопрос энергопотребления и охлаждения суперкомпьютеров действительно стоит очень остро. Помимо рейтинга мощнейших суперкомпьютеров существует список самых энергоэффективных систем – Green500.

Топ-десятка самых энергоэффективных суперкомпьютеров на планете

Топ-десятка самых энергоэффективных суперкомпьютеров на планетеЛидирует в нем итальянский суперкомпьютер Eurotech Aurora HPC 10-20 с кодовым именем Eurora (467 место в TOP500), который выдает 3,2 GFLOPS/Вт. Опять-таки хорошо проявило себя сочетание центральных процессоров Intel и графических ускорителей NVIDIA.

Гордость нации

Суперкомпьютеры – это не только неоценимая помощь для науки, но и предмет национальной гордости. Наравне с космической гонкой и гонкой вооружений ведется негласная война за звание ведущей суперкомпьютерной державы. Так, на территории США находится 252 из полтысячи мощнейших вычислительных систем мира. Китай владеет 66 мощнейшими суперкомпьютерами, Япония – 30, Великобритания – 29, Франция – 23, Германия – 19, а Индия – 11.

Процентное соотношение количества и производительности суперкомпьютеров в разных странах мира

Процентное соотношение количества и производительности суперкомпьютеров в разных странах мираА вот Украина в рейтинге TOP500, к величайшему сожалению, не представлена. Мощнейший отечественный суперкомпьютер, размещенный в НТУУ «Киевский политехнический институт», по производительности не дотягивает даже до нижней границы TOP500. Ему явно не помешала бы модернизация.

Для сравнения, у наших соседей – России и Польши – в рейтинг TOP500 попали восемь и три суперкомпьютера соответственно. Мощнейший Российский суперкомп T-Platforms T-Blade 2 с кодовым именем Lomonosov (31 место в рейтинге, производительность 901,9 TFLOPS) установлен в Научно-исследовательском вычислительном центре МГУ.

Флагманский российский суперкомпьютер назван в честь ученого-естествоиспытателя Михаила Ломоносова

Флагманский российский суперкомпьютер назван в честь ученого-естествоиспытателя Михаила ЛомоносоваПольский же вычислительный монстр Cluster Platform SL390, также известный под именем Zeus (113 место в рейтинге, производительность 266,9 TFLOPS), работает в Академическом компьютерном центре Cyfronet в городе Краков.

Выводы

IBM Watson наравне с людьми принимает участие в викторине Jeopardy!

IBM Watson наравне с людьми принимает участие в викторине Jeopardy!С одной стороны, назвать современные суперкомпьютеры искусственным интеллектом нельзя – уж больно они зависимы от людей. В процессе монтажа и последующего обслуживания одного такого вычислительного монстра может быть задействовано до полтысячи человек. С другой стороны, при должном подходе суперкомпьютеры быстро обучаются, с легкостью оперируют накопленными знаниями и даже понимают естественную речь.Яркий тому пример IBM Watson – наверно, самый известный суперкомп в мире. В 2011 году он победил в американской интеллектуальной телепередаче Jeopardy!. Соперниками суперкомпьютера были признанные ассы данной викторины Брэд Раттер и Кен Дженнингс.

Интересно было бы сравнить искусственный интеллект Watson с острым умом российско-украинским трио «знатоков»: Анатолием Вассерманом, Александром Друзем и Борисом Бурдой.

itc.ua

Новый рейтинг TOP500 суперкомпьютеров | Компьютерра

Новый список пятисот самых мощных компьютеров в мире был представлен на проходящей в Новом Орлеане конференции по суперкомпьютерным вычислениям SC’14. Суммарная мощность всех высокопроизводительных систем превысила 309 петафлопс, что почти на четверть выше прошлогоднего результата.

В четвёртый раз подряд рейтинг возглавляет система Tianhe-2, разработанная в Китайском Национальном университете оборонных технологий. Архитектура и особенности создания этого суперкомпьютера рассматривались на страницах «Компьютерры» в прошлом году.

Суперкомпьютер Тяньхэ-2 (фото: mil.cnr.cn).За прошедшее время США не смогли вернуть пальму первенства в области разработки высокопроизводительных компьютерных систем, которую ранее удерживали безраздельно. Реванш взять вновь не удалось, хотя вычислительная мощность главного конкурента осталась без изменений. Tianhe-2 по-прежнему демонстрирует 33,86 петафлопс (квадриллионов вычислений в секунду) в тесте Linpack.

Расстановка первых девяти номинантов не изменилась, а вот десятая позиция выглядит немного загадочно. На ней оказался новый суперкомпьютер Cray CS-Storm, место расположения которого не указывается. Известно только, что он был разработан по заказу американского правительства.

Его основой стали процессоры Intel Xeon E5-2660v2, каждый из которых содержит десять двухпоточных ядер (двадцать логических). Однако в десятку лучших этот суперкомпьютер привели не чипы архитектуры x86-64, а векторные ускорители Nvidia Tesla K40 с ядром GK110B (Kepler). Именно они обеспечивают львиную долю его производительности. Все вычислительные узлы соединяются по высокоскоростной шине Infiniband FDR, что позволяет быстро перераспределять нагрузку.

Суперкомпьютер Cray CS-Storm (изображение: сray.com).Прежний лидер (Titan, Cray XK7) тоже использовал ускорители Nvidia, но более простые (по сегодняшним меркам) – Tesla K20.

В Китае решили сделать ставку на ускорители с другой архитектурой, и не прогадали. Представленный два года назад Tianhe-2 был оснащён сопроцессорами Intel Xeon Phi 31S1P. Он практически вдвое превзошёл Titan во всех тестовых заданиях. Китайский триумф стал настолько ошеломительным, что первенство этой системы среди суперкомпьютеров до сих пор не может оспорить ни одна страна.

Справедливости ради отметим, что суммарная производительность всех суперкомпьютеров в стране пока ещё остаётся самой высокой в США. Однако число мощных американских систем продолжает падать. Год назад их было больше половины во всём списке – 265. За первую половину года их осталось уже 233, а с последним обновлением рейтинга выбыли ещё два суперкомпьютера. Такими темпами США приблизится к историческому минимуму уже в следующем году.

Сопроцессоры Intel Xeon Phi 31S1P в суперкомпьютере Tianhe-2 (фото: netlib.org).Несмотря на внушительные результаты Tianhe-2, общее число суперкомпьютеров Китая также снижается. Из новой версии рейтинга исчезли пятнадцать китайских систем, а остались только шестьдесят одна. В остальной части азиатского региона также отмечается спад: общее число высокопроизводительных систем снизилось в нём за полгода на двенадцать суперкомпьютеров. Осталось только сто двадцать мощных систем на весь регион.

Святое место не бывает пустым: освобождающиеся строчки рейтинга TOP500 активно занимает Европа и Япония. Число высокопроизводительных европейских систем выросло на четырнадцать и составило сто тридцать суперкомпьютеров. В Японии прибавилось два новых: Magnolia (#174) и HELIOS (#265). Теперь Япония обладает тридцатью двумя мощными системами.

Бразилия утрачивает и без того невысокие позиции в сфере высокопроизводительных вычислений: в списке TOP500 осталось всего четыре бразильских суперкомпьютера, и ни один из них не входит даже в первую сотню. Чуть лучше дела у Канады – из шести мощных систем пять занимают позиции между второй и третьей сотней. Лидирует суперкомпьютер Торонтского университета BlueGene/Q с процессорами IBM PowerPC (#74).

Канадский суперкомпьютер архитектуры IBM BlueGene/Q (фото: labcanada.com).Австралия постепенно начинает играть заметную роль: на её долю теперь приходится девять суперкомпьютеров. Самый мощный из них – Magnus (Cray XC40) на базе двенадцатиядерных процессоров Xeon E5-2690v3 с поддержкой Hyper-Threading (#41).

Российских суперкомпьютеров в новом списке также всего девять. Главный из них – кластер A-Class, созданный компанией «Т-Платформы» для Научно-исследовательского вычислительного центра МГУ. Впервые в рейтинге TOP500 он появился в июне этого года, а сейчас занимает в нём двадцать второе место.

Другой знаменитый суперкомпьютер «Ломоносов», также разработанный компанией «Т-Платформы» для МГУ, переместился на пятьдесят восьмое место, уступив за полгода шестнадцать позиций.

Новый суперкомпьютер появился в Санкт-Петербургском государственном политехническом университете. Это кластер архитектуры «РСК Торнадо», созданный группой компаний РСК. Он занял восемьдесят первую строчку в списке TOP500. Ещё один суперкомпьютер СПбГПУ RSC PetaStream переместился на позицию #390.

Российский суперкомпьютер RSC PetaStream. Каждый шкаф содержит 1024 узла с прямым жидкостным охлаждением (фото: rscgroup.ru).Остальные шесть российских систем вышли за пределы первой сотни. Кластер МВС-10П (#133) МСЦ РАН ещё полтора года назад был вторым среди самых мощных суперкомпьютеров на территории России и СНГ. Кластер «Лобачевский» (#189) и модернизированный «РСК Торнадо ЮУрГУ» (#190) завершают перечень отечественных суперкомпьютеров для научных исследований.

Гибридный кластер «Лобачевский» был установлен в НОЦ «СКТ-Приволжье» Нижегородского государственного университета имени Н. И. Лобачевского компанией «Ниагара Компьютерс». Его отдельные сегменты подобны модулям суперкомпьютеров «Титан» и «Тяньхэ-2». В первом сегменте кластера используются как сопроцессоры Intel Xeon Phi 5110P, так и ускорители Nvidia Tesla K20x. Во втором вместо них установлены графические процессоры NVIDIA Tesla M2090. Всего оба сегмента кластера объединяют сто шестьдесят гибридных вычислительных узлов. Текущий рейтинг TOP500 учитывает данные о скорости вычислений только на девяноста однородных узлах, снятые совместно со специалистами Nvidia. Каждый такой узел содержит два восьмиядерных процессора Intel Xeon E5-2660 с поддержкой Hyper-Threading и три векторных ускорителя Nvidia Tesla K20x. Пиковая производительность гибридного кластера составляет 550 терафлопс. В официальный зачёт пошли результаты теста Linpack, показавшие среднее значение 289,5 терафлопс.

Кластер «РСК Торнадо ЮУрГУ» был разработан для Южно-уральского государственного университета. Система на базе Intel Xeon Phi SE10X пришла на смену работающему с июня 2008 года суперкомпьютеру “СКИФ-Аврора”, чья производительность в сто терафлопс уже выходит за рамки TOP500.

Российский суперкомпьютер “РСК Торнадо ЮУрГУ” (фото: rscgroup.ru).Замыкают общий список российских суперкомпьютеров два специализированных сервера для коммерческого использования. Это двухсокетные блейд-серверы HP ProLiant BL460c Gen8. Модель на базе Intel Xeon E5-2680v2 занимает позицию #337, а система на основе восьмиядерных Xeon E5-2660 оказалась почти в самом конце рейтинга (#457).

С момента первой публикации в июне 1993 года, список TOP500 служил общепринятой мерой производительности суперкомпьютеров. Самые мощные вычислительные системы со всего мира тестировались в Linpack и ранжировались в соответствии с полученными результатами. В последние два года наметился общий спад: темпы прироста средней производительности неуклонно снижаются от списка к списку.

Стагнация в первой десятке резко контрастирует с постоянной сменой позиций в средней и особенно финальной части списка. Это может восприниматься как признак переориентирования производителей на сегмент малых суперкомпьютерных систем и как временное достижение рационального предела в наращивании мощности отдельных кластеров.

www.computerra.ru