Содержание

Насколько опасен искусственный интеллект

Человечество уже многие свои фантазии воплотило в реальность. От карманных компьютеров до автомобилей с автопилотом и от виртуальной реальности до космического туризма. А теперь в жизнь воплощается и искусственный интеллект. Человечество постепенно стирает границы фантазии и вымысла посредством современных исследований и технологий.

Искусственный интеллект (далее ИИ) в настоящее время представляет собой перспективное направление, на которое ориентируются многие компании. Искусственный интеллект — это область науки, которая изучает работу аппаратных и программных компонентов, а именно их интеллектуальное поведение. Вместо того, чтобы получать информацию от пользователя, такие машины самостоятельно обучаются и становятся умнее.

Читайте также: Кто предсказал Интернет?

В настоящее время над проектами ИИ работают многие компании, включая Microsoft, Google, Facebook и другие. В Южной Корее также есть несколько высококлассных проектов по искусственному интеллекту. А теперь представьте, что это лишь те компании, которые заявили об этом официально. Не стоит забывать, что наверняка есть много компаний, которые втайне работают над проектами искусственного интеллекта.

А теперь представьте, что это лишь те компании, которые заявили об этом официально. Не стоит забывать, что наверняка есть много компаний, которые втайне работают над проектами искусственного интеллекта.

Искусственный интеллект, который когда-то считался живым лишь в человеческом воображении, сегодня вполне реален. Уже сейчас ИИ стал предметом большого интереса для многих лидеров в индустрии высоких технологий.

Почему искусственный интеллект должен нас беспокоить?

Сначала это был Стивен Хокинг , затем Илон Маск и совсем недавно Билл Гейтс. Эти великие умы человечества предполагают, что за ИИ нужно пристально следить.

Генерального директора Тесла, Илона Маска однажды спросили, что он думает об искусственном интеллекте. Он ответил, что это как «вызов демона», которого нельзя призывать, если не можете его контролировать.

Когда Стивену Хокингу был задан этот же вопрос, то он предупредил публику. Он сказал, что любое дальнейшее исследование искусственного интеллекта может быть фатальной ошибкой. Он упомянул, что развитый ИИ будет обладать способностью переделывать, усовершенствовать себя. Такой интеллект сможет эволюционировать самостоятельно с огромной скоростью. Людям такая скорость эволюции недоступна, что ставит человечество в заведомо на более низкую ступень развития по сравнению с ИИ.

Он упомянул, что развитый ИИ будет обладать способностью переделывать, усовершенствовать себя. Такой интеллект сможет эволюционировать самостоятельно с огромной скоростью. Людям такая скорость эволюции недоступна, что ставит человечество в заведомо на более низкую ступень развития по сравнению с ИИ.

По словам Билла Гейтса, устройства с искусственным интеллектом поначалу будут простыми. Но со временем они будут узнавать все больше о нас и о нашем мире. Они будут становиться все более могущественными и интеллектуальными, чем человечество.

Риски искусственного интеллекта

Существует четыре класса риска, создаваемого искусственным интеллектом:

1. Программная враждебность

Один из сценариев, когда ИИ может быть опасным, заключается в том, что он будет специально запрограммирован на враждебность. Например, со стороны военных или террористической группы, для достижения каких-то своих целей.

Еще один возможный сценарий враждебного искусственного интеллекта предполагает несовпадение глобальных целей, его и человечества. Что если расчеты искусственного интеллекта приведут к тому, что единственный способ достичь цели — это уничтожить всех людей? Вполне возможно, что это может спровоцировать его начать войну с человечеством.

Что если расчеты искусственного интеллекта приведут к тому, что единственный способ достичь цели — это уничтожить всех людей? Вполне возможно, что это может спровоцировать его начать войну с человечеством.

Главная проблема в том, что ИИ не человек, и вряд ли с ним получится договориться. Его главным приоритетом будет выполнение глобальной задачи любой ценой. Поэтому война будет длиться, пока воля или способность человечества противостоять не будут уничтожены.

2. Пассивный риск

Фактически нет риска пассивной опасности от ИИ с приоритетными целями дружелюбности. Однако риск почти неизбежен от ИИ без таких целей. Пассивный ИИ может быть опасен просто потому, что он не учитывает безопасность человека, как это делают все люди.

Например, взять ИИ без целей дружелюбия, отвечающий за обработку посевов пестицидами. Этот ИИ будет обрабатывать поле, даже если знает, что в этот момент на поле находятся люди.

3. Случайный риск

Искусственный интеллект, работающий с неполными данными, способен ошибиться точно также, как и человек. Ошибки такого рода почти неизбежны, поскольку невозможно знать все обо всем в мире.

Ошибки такого рода почти неизбежны, поскольку невозможно знать все обо всем в мире.

Однако, данный риск является наименее опасным, поскольку ИИ способен учиться на собственном опыте. Любые происшествия уменьшают вероятность повторения ошибки в будущем, улучшая ИИ, и делая его более безопасным.

4. Риск непостижимости

Реальная опасность хорошо спроектированного искусственного интеллекта заключается в его способности перепрограммировать и бесконечно совершенствовать себя. Такой ИИ, способный к самосовершенствованию, может в конечном итоге превзойти ограничения человеческого интеллекта.

Когда существует искусственный интеллект, который умнее любого человека на Земле, становится невозможно полностью понять его. Такой ИИ также, вероятно, будет продолжать улучшать себя все быстрее и быстрее. Ведь каждое новое открытие или технология только ускоряют этот процесс. И именно это будет делать его все более и более невозможным для понимания людьми.

Кроме того, в какой-то момент ИИ может обнаружить законы причинности или логики, выходящие далеко за пределы понимания человеческого разума. Тогда возможности того, что он может сделать, становятся просто бесконечными.

Тогда возможности того, что он может сделать, становятся просто бесконечными.

Заключение

Хотя существует множество гипотез об опасном искусственном интеллекте, мы должны понимать, что это всего лишь предположения, а не факты. Люди всегда сомневались в новых технологиях, и было время, когда мы также боялись сотовых телефонов. В конце концов, речь идет о том, каким мы создадим искусственный интеллект и как мы будем его контролировать.

Угрожает ли людям искусственный интеллект?

Подпишитесь на нашу рассылку ”Контекст”: она поможет вам разобраться в событиях.

Автор фото, Science Photo Library

Подпись к фото,

Многие ученые считают, что искусственный разум является угрозой для человечества

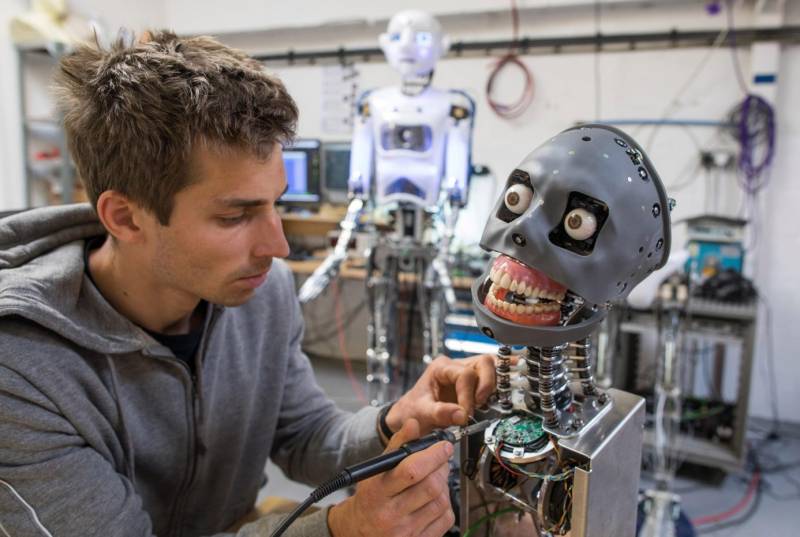

На этой неделе в программах Би-би-си настоящее нашествие роботов. Мы обсуждаем достижения людей в области строительства роботов и искусственного интеллекта. Мы и наши коллеги говорим о том, могут ли роботы вытеснить людей с рынка труда.

А главное — может ли искусственный интеллект представлять угрозу для человечества, как считает профессор Стивен Хокинг. Этот ученый с мировым именем считает, что люди в силу медленной биологической эволюции не могут конкурировать с искусственным интеллектом, и он способен занять место человека.

Бояться или нет искусственного интеллекта его создателям, людям? Об этом ведущий программы «Пятый этаж» Олег Антоненко говорил с одним из авторов проекта «Искусственный мозг», ученым Томского государственного университета Владимиром Ворониным и писателем-фантастом Леонидом Кагановым.

Загрузить подкаст передачи «Пятый этаж» можноtopcat2.

Олег Антоненко: Мы хотим поговорить об искусственном интеллекте, назовем его «компьютерным мозгом», который способен думать, как человек. Простейшие устройства с использованием искусственного интеллекта можно встретить уже сейчас, начиная от помощников — Сири в вашем iPhone или Кортану в вашем компьютере на windows — до устройства, например, контролирующего воздушный траффик.

Вопрос в том, что эти системы не способны к обучению. Например, компьютер Deep Blue, который обыгрывал чемпиона мира по шахматам, играть в домино или шашки не умеет. Эксперты говорят, что искусственный интеллект (сейчас это Deep Blue), возможно, в полном объеме мы получим к 2050 году. Предлагают называть эту систему «суперчеловеком». Некоторые говорят, что он спасет человечество, некоторые полагают, что погубит нас. Владимир Николаевич, «Искусственный мозг» — проект к которому вы имеете отношение и участвовали в его разработке — что это такое, насколько он обучаем, интересует ли вас его миссия, угрозы, о которых мы сегодня говорим?

Владимир Воронин: Мы ставим перед собой очень амбициозные задачи. Несмотря на то, что у нас в Томском университете над этой тематикой работает очень маленькая группа — буквально 3-4 человека, нам кажется, что мы нащупали некоторые принципиальные вещи. Дело в том, что основной тенденцией развития искусственного интеллекта, является компьютерное программирование. На этом пути работы ведутся уже более 60 лет, но особого прогресса здесь мы не наблюдаем. К разговорам с роботом о взаимопомощи и прочем, я отношусь, как к некоей забаве, игрушкам, в которые можно много информации, записанной на чипах, заложить, которые между собой взаимодействуют, и такую картинку продемонстрировать.

На этом пути работы ведутся уже более 60 лет, но особого прогресса здесь мы не наблюдаем. К разговорам с роботом о взаимопомощи и прочем, я отношусь, как к некоей забаве, игрушкам, в которые можно много информации, записанной на чипах, заложить, которые между собой взаимодействуют, и такую картинку продемонстрировать.

Пропустить Подкаст и продолжить чтение.

Подкаст

Что это было?

Мы быстро, просто и понятно объясняем, что случилось, почему это важно и что будет дальше.

эпизоды

Конец истории Подкаст

Совсем другая задача ставится в нашей области. Мы пытаемся смоделировать человеческий мозг, ориентируясь на биологические принципы взаимодействия нейронов в нервной системе человека. Как это происходит? С нашей точки зрения, если необходимо это коротко сказать во вводной части, организуется искусственный нейрон, который в возбужденном состоянии может взаимодействовать с другим нейроном, причем, не с любым, а тоже находящимся в возбужденном состоянии.

Нейроны имеют много входов, на которые поступают различные сигналы. Эти сигналы накапливаются, и при некотором уровне искусственный нейрон переходит в другое энергетическое состояние. Если в то же время рядом оказывается другой нейрон, находящийся в возбужденном состоянии, между ними возникает связь. В простейшем случае – это пробой какой-то тонкой полупроводниковой пленки, которая образует омический контакт. Сигнал, который попадает на один из нейронов, через этот контакт может попасть и на второй нейрон. В это время второй нейрон тоже получает разнородные сигналы. Однако если повторить некоторые сигналы, которые поступают на первый нейрон, то второй нейрон, как бы, заранее будет знать о некоторых событиях, которые еще до него не дошли. Сигналы эти не поступили, но он будет получать это от первого нейрона.

О.А.: Правильно я понимаю, что речь идет о передаче некоей информации от одного нейрона к другому?

В.В.: Естественно, это информация, но информацией нельзя назвать один какой-то импульс. Это большая сумма импульсов, которая циркулирует по цепям в этом устройстве, которое может обладать многокомпонентными нейронами, скажем, миллионами или миллиардами. Современная миниатюрная техника позволяет изготавливать такие чипы. Принцип развития этой системы заключается в том, что ему задается некоторая парадигма, что для него полезно и что вредно, и принцип самовыживания. Это простейший принцип, на котором базируется каждый биологический организм.

Это большая сумма импульсов, которая циркулирует по цепям в этом устройстве, которое может обладать многокомпонентными нейронами, скажем, миллионами или миллиардами. Современная миниатюрная техника позволяет изготавливать такие чипы. Принцип развития этой системы заключается в том, что ему задается некоторая парадигма, что для него полезно и что вредно, и принцип самовыживания. Это простейший принцип, на котором базируется каждый биологический организм.

Получив внешние сигнал, они через многочисленные связи переходят на выходы нейронов, которые могут быть связаны с манипуляторами, такими как движитель, который может перемещать, поворачивать, включать какие-то механизмы, посылать ответные сигналы: тепловые, световые, звуковые и прочие. Принцип такого самоорганизующегося устройства заключается в том, что в процессе анализа результата внешних воздействий и анализа того, как этот аппарат повлиял под воздействием этих сигналов на внешний мир, что для него изменилось, лучше стало или хуже.

О.А.: Вы говорите, что он заточен на биологическое выживание. Если предположить развитие этой системы и если эта система будет видеть, что угрозу биологическому выживанию представляет именно человек – создатель, то она может быть агрессивной.

В.В.: Не совсем так. Здесь моделируется развитие этого устройства, как мы его называем «самоорганизующееся управляющее устройство», которое базируется на тех же принципах, на которых развивается биологический мозг, нервная система человека. Именно этот искусственный мозг самообучается под руководством некоторого учителя, так же как маленький ребенок рождается, многое в мире не понимает, у него заложены какие-то базовые инстинкты, однако под воздействием метода «кнута и пряника» он начинает понимать, что хорошо и что плохо. Точно также для совершенствования нашего искусственного мозга нужен учитель и при определенном уровне объема его возможностей потребуются и психологи и биологи, которые будут курировать развитие этого организма и направлять его в некоторое правильное русло.

О.А.: Мы знаем истории, когда ученики восставали против своих учителей. Что думаете, Леонид?

Леонид Каганов: Имею небольшой комментарий. Владимир Воронин выкладывал классическую концепцию бихевиоризма, которая пыталась объяснить мышление и человека с помощью стимула и реакции, типа: наш мозг представляет черный ящик, на один вход подается раздражитель, из другого входа мы получаем какую-то реакцию. Надо сказать, что психология уже немножко отвергла это представление, потому что оно было давно. Это еще XIX век, насколько я помню. Потом появились улучшенные концепции бихевиоризма, потом появилась когнитивная психология, но в принципе психология до сих пор не может дать ответ на вопрос, что же такое наше мышление и как оно рождается. Поэтому пока подходить с таких позиций сложно.

Я говорю это потому, что я – хоть и писатель-фантаст, но по первому образованию я электронщик. У меня была разработка связанная, можно сказать, с искусственным интеллектом. У меня программа писала стихи из произвольного текста. По второму образованию я психолог. Поэтому я немножко совмещал все эти вещи. Вообще, концепция разума очень будоражит воображение, потому что хочется, чтобы наконец-то появился такой робот, который что-то за нас делал и желательно еще и принимал решения и думал. Но, к сожалению, чем больше я смотрю вокруг, а я смотрю вокруг последние 19 лет с тех пор, как сдал свой диплом, тем больше я вижу, что человечество пока не продвинулось по этому пути и ничего толкового не сделало. Мы только- только начинаем осваивать первые инструменты, чтобы подобраться к самым дальним рубежам.

У меня программа писала стихи из произвольного текста. По второму образованию я психолог. Поэтому я немножко совмещал все эти вещи. Вообще, концепция разума очень будоражит воображение, потому что хочется, чтобы наконец-то появился такой робот, который что-то за нас делал и желательно еще и принимал решения и думал. Но, к сожалению, чем больше я смотрю вокруг, а я смотрю вокруг последние 19 лет с тех пор, как сдал свой диплом, тем больше я вижу, что человечество пока не продвинулось по этому пути и ничего толкового не сделало. Мы только- только начинаем осваивать первые инструменты, чтобы подобраться к самым дальним рубежам.

О.А.: Стивен Хокинг выступал с предупреждением о том, что люди, в силу медленной биологической эволюции, не могут конкурировать с искусственным интеллектом, и он способен занять место человека. Многие эксперты называют совершенно конкретную дату появления этого суперчеловека – 2050 год. Я уж не говорю о существовании целого пласта культуры XX века, начиная со сборника рассказов Айзека Азимова «Я – робот». Можно упомянуть в этой связи один из лучших фильмов в истории кино «Космическая одиссея 2001 года». Масса вещей, когда люди говорят не о том, что им нужен помощник, безусловно, это важный аспект, а они в большей степени опасаются того, что появятся некие сложные компьютеры, сложные системы с возможностью самообучения, и они будут представлять угрозу для человека. Насколько, на ваш взгляд, рациональным является этот страх?

Можно упомянуть в этой связи один из лучших фильмов в истории кино «Космическая одиссея 2001 года». Масса вещей, когда люди говорят не о том, что им нужен помощник, безусловно, это важный аспект, а они в большей степени опасаются того, что появятся некие сложные компьютеры, сложные системы с возможностью самообучения, и они будут представлять угрозу для человека. Насколько, на ваш взгляд, рациональным является этот страх?

Л.К.: Честно скажу, я очень рад за оптимиста Хокинга, потому что, на мой взгляд, гораздо большую опасность представляет не разумные машины, которые займут место человека, а люди, лишенные интеллекта, которые займут место человека. Это мне кажется намного большей опасностью. Когда читаешь новости и смотришь, что происходит в мире, закрадывается подозрение, что люди без интеллекта как-то уже теснят. Поэтому долго нам еще придется опасаться машин без интеллекта. Интересная вещь: ведь робот может навредить человеку и не будучи роботом.

Мы всегда боялись, что придет такой железный робот с лампой вместо носа и начнет в нас стрелять из своего плазменного пистолета. А на самом деле мы открываем свою электронную почту и видим тонны спама, которые рассылают роботы. Они не имеют тела, но они роботы. Потом мы видим, как роботы постоянно ходят, стучатся и взламывают наши сервера, стучатся на каждый сайт, пробуют подобрать пароли. Все это тоже делают роботы. Это огромные ботнеты, которые занимаются всем, начиная от взлома личных данных до промышленного шпионажа, настроенные, понятное дело, людьми. Это, мне кажется, более актуальной опасностью. Андроид в титановом панцире появится еще очень не скоро, да и мозга у него нет, а примитивные роботы могут вредить, делать пакости, беспокоить. Могут разбудить звонком, сказать, что у вас задолженность за электроэнергию составляет 3 рубля 14 копеек. Это же тоже роботы все звонят.

А на самом деле мы открываем свою электронную почту и видим тонны спама, которые рассылают роботы. Они не имеют тела, но они роботы. Потом мы видим, как роботы постоянно ходят, стучатся и взламывают наши сервера, стучатся на каждый сайт, пробуют подобрать пароли. Все это тоже делают роботы. Это огромные ботнеты, которые занимаются всем, начиная от взлома личных данных до промышленного шпионажа, настроенные, понятное дело, людьми. Это, мне кажется, более актуальной опасностью. Андроид в титановом панцире появится еще очень не скоро, да и мозга у него нет, а примитивные роботы могут вредить, делать пакости, беспокоить. Могут разбудить звонком, сказать, что у вас задолженность за электроэнергию составляет 3 рубля 14 копеек. Это же тоже роботы все звонят.

О.А.: Владимир Николаевич, вы не занимаетесь созданием таких зловредных механизмов, о которых только что Леонид рассказал?

В.В.: Вы назвали Леонида Каганова оптимистом, а мне кажется, он глубокий пессимист. Он видит при рассылке спама какую-то угрозу для человечества. Мы ставим задачу создания искусственного мозга, который действительно мыслит в тысячи, может быть, миллионы раз быстрее, чем биологический мозг, в котором, как известно, нервные импульсы передаются со скоростью метров в секунду в отличие от электрических сигналов. Тем не менее, критика бихевиоризма, которую фантаст привел, не продуктивна.

Он видит при рассылке спама какую-то угрозу для человечества. Мы ставим задачу создания искусственного мозга, который действительно мыслит в тысячи, может быть, миллионы раз быстрее, чем биологический мозг, в котором, как известно, нервные импульсы передаются со скоростью метров в секунду в отличие от электрических сигналов. Тем не менее, критика бихевиоризма, которую фантаст привел, не продуктивна.

Дело в том, что человеческий мозг как таковой, как творец, когда что-то придумывает и начинает параллельно с природой изобретать какие-то другие способы мышления, сознания и т.д., мне кажется, что он заведомо по неправильному пути идет, потому что природа мудра и она сделала биологический организм. Если делать какое-то мыслящее устройство, оно должно быть примерно по этим же принципам устроено, по которым мы пытаемся идти.

Я не говорю, что мы в ближайшие годы или десятилетия создадим такой искусственный мозг, который сравняется или превзойдет человеческий. На том пути нас ожидают очень большие ступеньки, которые помогут создать такие самоорганизующиеся устройства, которые внесут революцию в технику. Это, может быть, будет очередная техническая революция. Когда, скажем, в пикирующем бомбардировщике ни один пилот не может сообразить за короткое время, что нужно сделать и как управлять механизмом, в отличие от самоорганизующегося устройства, которое это успеет сделать.

Это, может быть, будет очередная техническая революция. Когда, скажем, в пикирующем бомбардировщике ни один пилот не может сообразить за короткое время, что нужно сделать и как управлять механизмом, в отличие от самоорганизующегося устройства, которое это успеет сделать.

О.А.: Уничтожение людей искусственным интеллектом – перспектива отдаленная. А вот вытеснение людей с рынка труда – это уже сегодняшняя реальность. В Китае строится один завод, на котором 99% работников будут роботы. Сборочные цеха, в которых нет людей, какие-то железнодорожные составы, в которых нет машинистов, есть автоматические машины по продаже разного рода билетов. Есть интересная статистика. Исследователи из Оксфордского университета и компании «Де Ллойд» подсчитали, что около 35% нынешних рабочих мест в Британии находятся уже сейчас под высокой угрозой компьютеризации в ближайшие 20 лет. В США говорят, что цифра эта составляет 47% по результатам аналогичного исследования. Леонид, это угроза для людей или нет?

Л. К.: С одной стороны, это угроза для людей, но социальные предпосылки ведут к тому, что все меньшее и меньшее количество людей, в принципе, будет работать, если оценивать в исторической перспективе. С другой стороны, здесь вряд ли можно говорить о роботах. Это, скорее, развитие инструментов. Нам понятно, что работник с пневматическим молотом заменяет двести рабов-камнетесов. И это нормальный естественный процесс. Человек с электроотверткой заменяет 55 сборщиков. Вместо электрической отвертки появляется электрический водитель поезда метро, электрический регулировщик.

К.: С одной стороны, это угроза для людей, но социальные предпосылки ведут к тому, что все меньшее и меньшее количество людей, в принципе, будет работать, если оценивать в исторической перспективе. С другой стороны, здесь вряд ли можно говорить о роботах. Это, скорее, развитие инструментов. Нам понятно, что работник с пневматическим молотом заменяет двести рабов-камнетесов. И это нормальный естественный процесс. Человек с электроотверткой заменяет 55 сборщиков. Вместо электрической отвертки появляется электрический водитель поезда метро, электрический регулировщик.

И это хорошо, потому что иногда приходишь в учреждение и видишь, что там работает огромное количество людей, но все они занимаются тем, что посылают какие-то файлы на принтер, бегут с этими бумажками к соседнему столу, кладут, человек что-то читает, посылает кого-то еще куда-то бежать с бумажкой. И ты понимаешь, что всех этих людей можно заменить процессором мощности карманного смартфона. Он прекрасно справится с этой работой и будет ее делать лучше и без ошибок. Другое дело, куда девать этих, грубо говоря, немолодых теток, которые сидят в этой нашей воображаемой бухгалтерии. Это вопрос социальный.

Другое дело, куда девать этих, грубо говоря, немолодых теток, которые сидят в этой нашей воображаемой бухгалтерии. Это вопрос социальный.

Мне кажется, что человек должен найти себе лучшее применение, чем эта простая работа. Может быть, эти бухгалтерши будут прекрасно воспитывать детей, может быть, они займутся садоводством и сделают прекрасные парки, может быть, они посвятят свою жизнь изучению истории или музыке или просто станут прекрасными благодарными радиослушателями и телезрителями, что тоже неплохо. Пути обратно нет, и количество работающих будет сокращаться, а количество, я бы даже не сказал «роботов», количество инструментов будет расти. Остается это только приветствовать.

О.А.: Ряд специальностей по-прежнему будет востребован: учителя, пожарные, спортсмены, в конце концов. Все-таки соревнования роботов смотреть не очень интересно.

В.В.: Я поддерживаю здесь своего коллегу, который нарисовал такое будущее и сделал упор на социальном аспекте этого развития. Мы действительно видим общество, о котором мечтали утописты, когда человек освобождается от рутинного механического труда, общественный материальный продукт производят машины, и он свободен для творчества, для духовного саморазвития и т.д. корень зла – не в машинах, а в обществе, которое несправедливо распределяет произведенный общественный продукт. Поэтому нужно думать о совершенствовании человечества, общества, а не о том, что появятся безработные и они останутся без куска хлеба. Вы согласитесь со мной?

Мы действительно видим общество, о котором мечтали утописты, когда человек освобождается от рутинного механического труда, общественный материальный продукт производят машины, и он свободен для творчества, для духовного саморазвития и т.д. корень зла – не в машинах, а в обществе, которое несправедливо распределяет произведенный общественный продукт. Поэтому нужно думать о совершенствовании человечества, общества, а не о том, что появятся безработные и они останутся без куска хлеба. Вы согласитесь со мной?

О.А.: Леонид, есть мнение, что писатели-фантасты обладают даром предвидения. Вам каким видится это будущее? Увидим ли мы этого самого суперчеловека, о котором говорят многие эксперты, ученые, когда мы увидим, и стоит ли нам его бояться?

Л.К.: Я думаю, что мы его уже видим, но не узнаем. Что касается предсказания будущего, к сожалению, фантасты меньше всех преуспели в предсказании будущего. Они предсказывали наравне со всеми своими современниками. Это такой распространенный миф, о том, что фантасты… Не было ни одного фантаста, который предсказал будущее достоверно, за исключением Артура Кларка, который предсказал стационарные спутники, потому что он был физиком и этим занимался. Мне кажется, что приближение эры роботов не то, что надо ожидать, оно уже давно наступило. Мы уже в этом живем, и только более внимательный взгляд позволит увидеть, что на самом деле они уже здесь

Это такой распространенный миф, о том, что фантасты… Не было ни одного фантаста, который предсказал будущее достоверно, за исключением Артура Кларка, который предсказал стационарные спутники, потому что он был физиком и этим занимался. Мне кажется, что приближение эры роботов не то, что надо ожидать, оно уже давно наступило. Мы уже в этом живем, и только более внимательный взгляд позволит увидеть, что на самом деле они уже здесь

О.А.: Бояться стоит или нет?

Л.К.: В принципе, бояться надо всего. Тот же огонь может приготовить пищу, а может сжечь хижину. Тот же атом может обогревать целый город, а может устроить такой ад, что нам и не снилось. Во всем есть опасность, в любом предмете, но пока всерьез на ближайшие десятилетия ничего со стороны роботов грозить не должно, потому что они пока маленькие. Но они, конечно, есть, они рядом с нами, и надо сделать все, чтобы они развивались.

О.А.: Ничего себе маленькие! Некоторые роботы-дроны совершают убийства в разных странах, с помощью людей, конечно, но это угроза.

Л.К.: Убить можно и вилкой, но это же не повод отменять вилки.

О.А.: Безусловно. Не могу с вами не согласиться.

Опасен ли ИИ? 5 непосредственных рисков искусственного интеллекта

Искусственный интеллект революционизирует почти каждую отрасль. С развитием технологий у него есть потенциал радикально улучшить многие аспекты жизни.

Но это небезопасно.

И, поскольку многие эксперты предупреждают о потенциальной опасности ИИ, нам, вероятно, следует обратить на это внимание. С другой стороны, многие утверждают, что это паникерские взгляды и что ИИ не представляет непосредственной опасности.

Так опасения по поводу искусственного интеллекта вызывают тревогу или нет? В этой статье будут рассмотрены пять основных рисков искусственного интеллекта с объяснением доступных в настоящее время технологий в этих областях.

Чем может быть опасен ИИ?

ИИ становится все более изощренным с каждым днем, и это может иметь риски от незначительных (например, увольнение с работы) до катастрофических экзистенциальных рисков. Уровень риска, связанного с ИИ, так активно обсуждается из-за общего отсутствия понимания (и консенсуса) в отношении технологии ИИ.

Уровень риска, связанного с ИИ, так активно обсуждается из-за общего отсутствия понимания (и консенсуса) в отношении технологии ИИ.

Принято считать, что ИИ может быть опасен по двум причинам:

- ИИ запрограммирован делать что-то злонамеренное

- ИИ запрограммирован на то, чтобы приносить пользу, но при достижении своей цели делает что-то разрушительное

Эти риски усиливаются сложностью программного обеспечения ИИ. Классический гипотетический аргумент — шутливый «максимизатор скрепки». В этом мысленном эксперименте сверхразумный ИИ был запрограммирован на максимальное количество скрепок в мире. Если он достаточно разумен, он может уничтожить весь мир ради этой цели.

Но нам не нужно рассматривать сверхразумный ИИ, чтобы увидеть, что существуют опасности, уже связанные с нашим использованием ИИ. Итак, с какими непосредственными рисками, связанными с ИИ, мы сталкиваемся?

1. Автоматизация работы и прерывание работы

Автоматизация — это опасность ИИ, которая уже влияет на общество.

От заводов массового производства до касс самообслуживания и беспилотных автомобилей автоматизация происходила десятилетиями, и этот процесс ускоряется. Исследование Института Брукингса в 2019 г.обнаружили, что 36 миллионов рабочих мест могут подвергнуться высокому риску автоматизации в ближайшие годы.

Проблема в том, что для решения многих задач системы ИИ превосходят людей. Они дешевле, эффективнее и точнее людей. Например, ИИ уже лучше распознает подделки произведений искусства, чем люди-эксперты, и теперь он становится более точным в диагностике опухолей по рентгенографическим изображениям.

Еще одна проблема заключается в том, что из-за смещения рабочих мест после автоматизации многие работники, потерявшие работу, не имеют права на вновь созданные рабочие места в секторе ИИ из-за отсутствия необходимых полномочий или опыта.

По мере того, как системы ИИ продолжают совершенствоваться, они станут намного лучше справляться с задачами, чем люди. Это может быть распознавание образов, предоставление информации или точные прогнозы. В результате потеря работы может привести к усилению социального неравенства и даже к экономической катастрофе.

Это может быть распознавание образов, предоставление информации или точные прогнозы. В результате потеря работы может привести к усилению социального неравенства и даже к экономической катастрофе.

2. Безопасность и конфиденциальность

В 2020 году правительство Великобритании заказало отчет об искусственном интеллекте и национальной безопасности Великобритании, в котором подчеркивается необходимость использования ИИ в системе кибербезопасности Великобритании для обнаружения и смягчения угроз, которые требуют более высокой скорости реагирования, чем способно принимать решения человеком.

Проблема в том, что надежда состоит в том, что по мере роста проблем безопасности, связанных с ИИ, будут расти и меры предотвращения, основанные на ИИ. Если мы не сможем разработать меры для защиты от проблем с ИИ, мы рискуем вступить в бесконечную гонку против злоумышленников.

Это также вызывает вопрос о том, как мы делаем системы ИИ безопасными. Если мы используем алгоритмы ИИ для защиты от различных проблем безопасности, нам необходимо убедиться, что сам ИИ защищен от злоумышленников.

Когда дело доходит до конфиденциальности, крупные компании и правительства уже призывают к подрыву нашей конфиденциальности. С таким большим количеством личных данных, доступных сейчас в Интернете (ежедневно создается 2,5 миллиона терабайт данных), алгоритмы ИИ уже могут легко создавать профили пользователей, которые обеспечивают чрезвычайно точный таргетинг рекламы.

Технология распознавания лиц также уже невероятно сложна. Камеры могут выполнять профилирование людей в реальном времени. Сообщается, что некоторые полицейские силы по всему миру используют умные очки с программным обеспечением для распознавания лиц, которое может легко маркировать разыскиваемых или подозреваемых преступников.

Риск заключается в том, что эта технология может быть распространена на авторитарные режимы или просто на отдельных лиц или группы со злыми намерениями.

3. Вредоносное ПО ИИ

ИИ все лучше справляется со взломом систем безопасности и взломом шифрования. Один из способов, которым это происходит, — вредоносное ПО, «эволюционирующее» с помощью алгоритмов машинного обучения. Вредоносное ПО может узнать, что работает, методом проб и ошибок, со временем становясь все более опасным.

Один из способов, которым это происходит, — вредоносное ПО, «эволюционирующее» с помощью алгоритмов машинного обучения. Вредоносное ПО может узнать, что работает, методом проб и ошибок, со временем становясь все более опасным.

Новые интеллектуальные технологии (например, беспилотные автомобили) оцениваются как объект высокого риска для такого рода атак, поскольку злоумышленники могут вызвать автомобильные аварии или пробки. По мере того как мы все больше и больше полагаемся на интеллектуальные технологии, подключенные к Интернету, риск сбоев все больше и больше влияет на нашу повседневную жизнь.

Опять же, единственное реальное решение этой опасности заключается в том, что ИИ для защиты от вредоносных программ превосходит вредоносный ИИ в защите отдельных лиц и предприятий.

4. Автономное вооружение

Автономное оружие — оружие, управляемое системами ИИ, а не человеком, — уже существует и существует уже довольно давно. Сотни технических экспертов призвали ООН разработать способ защиты человечества от рисков, связанных с автономным оружием.

Правительственные вооруженные силы по всему миру уже имеют доступ к различным управляемым или полууправляемым ИИ системам вооружения, таким как военные дроны. С помощью программного обеспечения для распознавания лиц дрон может отслеживать человека.

Что произойдет, если мы позволим алгоритмам ИИ принимать решения о жизни и смерти без участия человека?

Также можно настроить потребительские технологии (например, дроны) для автономного полета и выполнения различных задач. Такого рода возможности в чужих руках могут ежедневно влиять на безопасность человека.

5. Дипфейки, фейковые новости и политическая безопасность

Изображение предоставлено: geralt через Pixabay

Программное обеспечение для реконструкции лица (более известное как технология дипфейков) становится все более и более неотличимым от реальности.

Опасность дипфейков уже угрожает знаменитостям и мировым лидерам, и пока это не коснется обычных людей. Например, мошенники уже шантажируют людей фальшивыми видео, созданными из чего-то такого простого и доступного, как фотография профиля Facebook.

И это не единственный риск. ИИ может воссоздавать и редактировать фотографии, составлять текст, клонировать голоса и автоматически создавать высокоцелевую рекламу. Мы уже видели, как некоторые из этих опасностей влияют на общество.

Снижение рисков искусственного интеллекта

По мере того, как искусственный интеллект становится все более изощренным и функциональным, происходит много положительных сдвигов. Но, к сожалению, мощные новые технологии всегда подвержены риску неправильного использования. Эти риски затрагивают почти все аспекты нашей повседневной жизни, от конфиденциальности до политической безопасности и автоматизации работы.

Первым шагом в снижении рисков, связанных с искусственным интеллектом, будет решение, где мы хотим использовать ИИ, а где его не следует поощрять. Расширение исследований и дискуссий о системах ИИ и их использовании — это первый шаг к предотвращению их неправильного использования.

Преимущества и риски искусственного интеллекта

Нажмите здесь, чтобы просмотреть эту страницу на других языках: Китайский Французский Немецкий Японский Корейский Русский

» Все, что нам нравится в цивилизации, является продуктом интеллекта, поэтому человеческий интеллект усиливается с помощью искусственного интеллекта.

интеллект может помочь цивилизации процветать как никогда раньше — до тех пор, пока нам удается поддерживать технологию полезной. »

Макс Тегмарк , президент Института будущего жизни

Что такое ИИ?

От SIRI до самоуправляемых автомобилей искусственный интеллект (ИИ) быстро развивается. В то время как научная фантастика часто изображает ИИ как роботов с человеческими характеристиками, ИИ может охватывать что угодно, от поисковых алгоритмов Google до Watson от IBM и автономного оружия.

Искусственный интеллект сегодня правильно известен как узкий ИИ (или слабый ИИ), поскольку он предназначен для выполнения узкой задачи (например, только распознавание лиц, или только поиск в Интернете, или только вождение автомобиля). Однако долгосрочной целью многих исследователей является создание общего ИИ (AGI или сильного ИИ). В то время как узкий ИИ может превзойти людей в любой конкретной задаче, такой как игра в шахматы или решение уравнений, ОИИ превзойдет людей практически во всех когнитивных задачах.

Зачем исследовать безопасность ИИ?

В ближайшей перспективе цель сохранения положительного влияния ИИ на общество мотивирует исследования во многих областях, от экономики и права до технических тем, таких как проверка, достоверность, безопасность и контроль. В то время как сбой или взлом вашего ноутбука может быть не более чем незначительной неприятностью, становится все более важным, чтобы система ИИ делала то, что вы хотите, если она управляет вашей машиной, вашим самолетом, вашим кардиостимулятором, вашей автоматической торговлей. системы или вашей электросети. Еще одна краткосрочная задача — предотвратить разрушительную гонку смертоносных автономных вооружений.

В долгосрочной перспективе важный вопрос заключается в том, что произойдет, если поиски сильного ИИ увенчаются успехом и система ИИ станет лучше людей во всех когнитивных задачах. Как указывает И.Дж. Хорошо в 1965 году, разработка более умных систем ИИ сама по себе является когнитивной задачей. Такая система потенциально может подвергаться рекурсивному самосовершенствованию, вызывая взрыв интеллекта, оставляя человеческий интеллект далеко позади. Изобретая революционно новые технологии, такой сверхразум может помочь нам искоренить войны, болезни и бедность, поэтому создание сильного ИИ может стать крупнейшим событием в истории человечества. Однако некоторые эксперты выразили обеспокоенность тем, что это может быть и последнее, если мы не научимся согласовывать цели ИИ с нашими, прежде чем он станет сверхразумным.

Изобретая революционно новые технологии, такой сверхразум может помочь нам искоренить войны, болезни и бедность, поэтому создание сильного ИИ может стать крупнейшим событием в истории человечества. Однако некоторые эксперты выразили обеспокоенность тем, что это может быть и последнее, если мы не научимся согласовывать цели ИИ с нашими, прежде чем он станет сверхразумным.

Некоторые сомневаются, что сильный ИИ когда-нибудь будет создан, а другие настаивают на том, что создание сверхразумного ИИ гарантированно принесет пользу. В FLI мы осознаем обе эти возможности, но также признаем, что система искусственного интеллекта может намеренно или непреднамеренно причинить большой вред. Мы считаем, что сегодняшние исследования помогут нам лучше подготовиться к таким потенциально негативным последствиям в будущем и предотвратить их, таким образом, пользуясь преимуществами ИИ и избегая ловушек.

Сообщество экзистенциальной безопасности ИИ

Мы считаем, что сегодняшние исследования помогут нам лучше подготовиться к таким потенциально негативным последствиям и предотвратить их в будущем, таким образом, пользуясь преимуществами ИИ и избегая ловушек. Нажмите здесь, чтобы ознакомиться с нашим растущим сообществом исследователей экзистенциальной безопасности ИИ.

Нажмите здесь, чтобы ознакомиться с нашим растущим сообществом исследователей экзистенциальной безопасности ИИ.

Чем может быть опасен ИИ?

Большинство исследователей сходятся во мнении, что сверхразумный ИИ вряд ли будет проявлять человеческие эмоции, такие как любовь или ненависть, и что нет причин ожидать, что ИИ намеренно станет доброжелательным или злонамеренным. Вместо этого при рассмотрении того, как ИИ может стать риском, эксперты считают наиболее вероятными два сценария:

- ИИ запрограммирован на разрушительные действия: Автономное оружие — это системы искусственного интеллекта, запрограммированные на убийство. В руках не того человека это оружие могло легко привести к массовым жертвам. Более того, гонка вооружений ИИ может непреднамеренно привести к войне ИИ, которая также приведет к массовым жертвам. Чтобы не помешать противнику, это оружие будет спроектировано таким образом, чтобы его было чрезвычайно трудно просто «выключить», поэтому люди, вероятно, могли бы потерять контроль над такой ситуацией.

Этот риск присутствует даже при узком ИИ, но растет по мере увеличения уровня интеллекта и автономии ИИ.

Этот риск присутствует даже при узком ИИ, но растет по мере увеличения уровня интеллекта и автономии ИИ. - ИИ запрограммирован делать что-то полезное, но он разрабатывает разрушительный метод для достижения своей цели: Это может произойти всякий раз, когда мы не можем полностью согласовать цели ИИ с нашими, что поразительно сложно. Если вы попросите послушную умную машину как можно быстрее доставить вас в аэропорт, она может доставить вас туда в погоне за вертолетами и в блевотине, делая не то, что вы хотели, а буквально то, о чем вы просили. Если сверхразумной системе поручается амбициозный геоинженерный проект, она может нанести ущерб нашей экосистеме в качестве побочного эффекта и рассматривать попытки человека остановить ее как угрозу, которую необходимо устранить.

Пример: летальное автономное оружие

Боевые роботы, также называемые «летальными автономными системами оружия» или «роботами-убийцами», — это системы оружия, которые используют искусственный интеллект (ИИ) для идентификации, выбора и уничтожения человеческих целей без вмешательства человека.

Эта технология уже существует, и она сопряжена с огромным риском. Узнайте больше о смертоносном автономном оружии и о том, что мы можем сделать для его предотвращения, здесь.

Как показывают эти примеры, продвинутый ИИ вызывает не злорадство, а компетентность. Сверхинтеллектуальный ИИ будет чрезвычайно хорош в достижении своих целей, и если эти цели не совпадают с нашими, у нас есть проблема. Вы, вероятно, не злобный ненавистник муравьев, который наступает на муравьев из злого умысла, но если вы отвечаете за проект гидроэлектростанции с экологически чистой энергией, а в регионе есть муравейник, который нужно затопить, очень плохо для муравьев. Ключевая цель исследования безопасности ИИ — никогда не ставить человечество в положение этих муравьев.

Почему недавний интерес к безопасности ИИ

Стивен Хокинг, Илон Маск, Стив Возняк, Билл Гейтс и многие другие знаменитости в науке и технике недавно выразили обеспокоенность в средствах массовой информации и в открытых письмах по поводу рисков, связанных с ИИ, к ним присоединились многие ведущие исследователи ИИ. Почему эта тема вдруг оказалась в заголовках?

Почему эта тема вдруг оказалась в заголовках?

Идея о том, что поиски сильного ИИ в конечном счете увенчаются успехом, долгое время считалась научной фантастикой, на протяжении столетий или даже больше. Тем не менее, благодаря недавним прорывам, многие вехи ИИ, которые эксперты считали отстоящими на десятилетия всего пять лет назад, теперь достигнуты, что заставляет многих экспертов серьезно отнестись к возможности сверхразума в нашей жизни. В то время как некоторые эксперты до сих пор предполагают, что до ИИ человеческого уровня еще далеко, большинство исследователей ИИ на конференции в Пуэрто-Рико в 2015 году предположили, что это произойдет до 2060 года. Поскольку для завершения необходимых исследований в области безопасности могут потребоваться десятилетия, разумно начать их сейчас. .

Поскольку ИИ потенциально может стать умнее любого человека, у нас нет надежного способа предсказать его поведение. Мы не можем использовать прошлые технологические разработки в качестве основы, потому что мы никогда не создавали ничего, что могло бы, вольно или невольно, перехитрить нас. Лучшим примером того, с чем мы можем столкнуться, может быть наша собственная эволюция. Люди теперь контролируют планету не потому, что мы самые сильные, самые быстрые или самые большие, а потому, что мы самые умные. Если мы больше не самые умные, уверены ли мы, что останемся у руля?

Лучшим примером того, с чем мы можем столкнуться, может быть наша собственная эволюция. Люди теперь контролируют планету не потому, что мы самые сильные, самые быстрые или самые большие, а потому, что мы самые умные. Если мы больше не самые умные, уверены ли мы, что останемся у руля?

Позиция FLI заключается в том, что наша цивилизация будет процветать до тех пор, пока мы будем побеждать в гонке между растущей мощью технологий и мудростью, с которой мы ими управляем. В случае с технологией ИИ позиция FLI заключается в том, что лучший способ победить в этой гонке — не препятствовать первому, а ускорить второе, поддерживая исследования безопасности ИИ.

Основные мифы о продвинутом ИИ

Идет увлекательный разговор о будущем искусственного интеллекта и о том, что он будет/должен значить для человечества. Ведущие мировые эксперты ведут увлекательные споры, например: будущее влияние ИИ на рынок труда; если/когда будет разработан искусственный интеллект человеческого уровня; приведет ли это к взрыву интеллекта; и следует ли нам приветствовать это или опасаться. Но есть также много примеров скучных псевдо-споров, вызванных тем, что люди не понимают друг друга и говорят мимо друг друга. Чтобы помочь себе сосредоточиться на интересных противоречиях и открытых вопросах, а не на недоразумениях, давайте проясним некоторые из наиболее распространенных мифов.

Но есть также много примеров скучных псевдо-споров, вызванных тем, что люди не понимают друг друга и говорят мимо друг друга. Чтобы помочь себе сосредоточиться на интересных противоречиях и открытых вопросах, а не на недоразумениях, давайте проясним некоторые из наиболее распространенных мифов.

Мифы о временной шкале

Первый миф касается временной шкалы: сколько времени потребуется, чтобы машины значительно превзошли человеческий интеллект? Распространенным заблуждением является то, что мы знаем ответ с большой уверенностью.

Один из популярных мифов состоит в том, что мы знаем, что в этом столетии мы получим сверхчеловеческий ИИ. На самом деле, история полна технологического преувеличения. Где те термоядерные электростанции и летающие машины, которые нам обещали уже иметь? В прошлом ИИ также неоднократно преувеличивался, даже некоторыми основателями этой области. Например, Джон Маккарти (который ввел термин «искусственный интеллект»), Марвин Мински, Натаниэль Рочестер и Клод Шеннон написали этот чрезмерно оптимистичный прогноз о том, что можно сделать за два месяца с компьютерами каменного века: «Мы предлагаем провести двухмесячное исследование искусственного интеллекта с участием 10 человек летом 1956 года в Дартмутском колледже [. ..] Будет предпринята попытка выяснить, как заставить машины использовать язык, формировать абстракции и концепции, решать проблемы, которые теперь предназначены для людей, и совершенствовать себя. Мы думаем, что можно добиться значительного прогресса в одной или нескольких из этих проблем, если тщательно отобранная группа ученых будет работать над этим вместе в течение лета».

..] Будет предпринята попытка выяснить, как заставить машины использовать язык, формировать абстракции и концепции, решать проблемы, которые теперь предназначены для людей, и совершенствовать себя. Мы думаем, что можно добиться значительного прогресса в одной или нескольких из этих проблем, если тщательно отобранная группа ученых будет работать над этим вместе в течение лета».

С другой стороны, популярный контр-миф состоит в том, что мы знаем, что в этом столетии у нас не будет сверхчеловеческого ИИ. Исследователи сделали широкий диапазон оценок того, насколько мы далеки от сверхчеловеческого ИИ, но мы, конечно, не можем с большой уверенностью сказать, что вероятность равна нулю в этом столетии, учитывая мрачный послужной список таких техно-скептических прогнозов. Например, Эрнест Резерфорд, возможно, величайший физик-ядерщик своего времени, сказал в 1933 году — менее чем за 24 часа до изобретения Сцилардом цепной ядерной реакции — что ядерная энергия — это «самогон». А Королевский астроном Ричард Вулли назвал межпланетное путешествие «полным трюмом» в 1956. Самая крайняя форма этого мифа заключается в том, что сверхчеловеческий ИИ никогда не появится, потому что это физически невозможно. Однако физики знают, что мозг состоит из кварков и электронов, устроенных так, чтобы действовать как мощный компьютер, и что нет законов физики, препятствующих нам создавать еще более разумные кварковые шарики.

А Королевский астроном Ричард Вулли назвал межпланетное путешествие «полным трюмом» в 1956. Самая крайняя форма этого мифа заключается в том, что сверхчеловеческий ИИ никогда не появится, потому что это физически невозможно. Однако физики знают, что мозг состоит из кварков и электронов, устроенных так, чтобы действовать как мощный компьютер, и что нет законов физики, препятствующих нам создавать еще более разумные кварковые шарики.

Был проведен ряд опросов, в которых исследователям ИИ задавали вопрос, через сколько лет, по их мнению, у нас будет ИИ человеческого уровня с вероятностью не менее 50%. Все эти опросы имеют один и тот же вывод: ведущие мировые эксперты расходятся во мнениях, поэтому мы просто не знаем. Например, в таком опросе исследователей ИИ на конференции ИИ в Пуэрто-Рико в 2015 году средний (медианный) ответ был к 2045 году, но некоторые исследователи предполагали сотни лет или больше.

Также существует связанный с этим миф о том, что люди, беспокоящиеся об ИИ, думают, что до него осталось всего несколько лет. На самом деле, большинство известных людей, беспокоящихся о сверхчеловеческом ИИ, предполагают, что до этого еще как минимум десятилетия. Но они утверждают, что пока мы не уверены на 100%, что этого не произойдет в этом столетии, разумно начать исследование безопасности сейчас, чтобы подготовиться к возможностям. Многие проблемы безопасности, связанные с искусственным интеллектом человеческого уровня, настолько сложны, что на их решение могут уйти десятилетия. Так что разумно начать исследовать их сейчас, а не за ночь до того, как некоторые программисты, пьющие Red Bull, решат включить один из них.

На самом деле, большинство известных людей, беспокоящихся о сверхчеловеческом ИИ, предполагают, что до этого еще как минимум десятилетия. Но они утверждают, что пока мы не уверены на 100%, что этого не произойдет в этом столетии, разумно начать исследование безопасности сейчас, чтобы подготовиться к возможностям. Многие проблемы безопасности, связанные с искусственным интеллектом человеческого уровня, настолько сложны, что на их решение могут уйти десятилетия. Так что разумно начать исследовать их сейчас, а не за ночь до того, как некоторые программисты, пьющие Red Bull, решат включить один из них.

Противоречивые мифы

Еще одно распространенное заблуждение состоит в том, что единственными людьми, питающими опасения по поводу ИИ и поддерживающими исследования безопасности ИИ, являются луддиты, которые мало что знают об ИИ. Когда Стюарт Рассел, автор стандартного учебника по искусственному интеллекту, упомянул об этом во время своего выступления в Пуэрто-Рико, аудитория громко рассмеялась. Связанное с этим заблуждение состоит в том, что поддержка исследований безопасности ИИ вызывает огромные споры. На самом деле, чтобы поддерживать скромные инвестиции в исследования безопасности ИИ, людей не нужно убеждать в том, что риски высоки, просто они не пренебрежимо малы — так же, как скромные инвестиции в страхование жилья оправдываются значительной вероятностью того, что дом сгорает.

Связанное с этим заблуждение состоит в том, что поддержка исследований безопасности ИИ вызывает огромные споры. На самом деле, чтобы поддерживать скромные инвестиции в исследования безопасности ИИ, людей не нужно убеждать в том, что риски высоки, просто они не пренебрежимо малы — так же, как скромные инвестиции в страхование жилья оправдываются значительной вероятностью того, что дом сгорает.

Возможно, средства массовой информации сделали дебаты о безопасности ИИ более спорными, чем они есть на самом деле. В конце концов, страх продается, а статьи, в которых используются вырванные из контекста цитаты, чтобы объявить о неминуемой гибели, могут генерировать больше кликов, чем детализированные и сбалансированные. В результате два человека, которые знают о позициях друг друга только из цитат из СМИ, скорее всего, будут думать, что они не согласны друг с другом больше, чем на самом деле. Например, техноскептик, прочитавший о позиции Билла Гейтса только в британском таблоиде, может ошибочно подумать, что Гейтс верит в неизбежность сверхразума. Точно так же кто-то в движении полезного ИИ, который ничего не знает о позиции Эндрю Нг, кроме его цитаты о перенаселении Марса, может ошибочно подумать, что его не волнует безопасность ИИ, хотя на самом деле это не так. Суть просто в том, что, поскольку оценки Нг на временной шкале длиннее, он, естественно, склонен отдавать приоритет краткосрочным задачам ИИ над долгосрочными.

Точно так же кто-то в движении полезного ИИ, который ничего не знает о позиции Эндрю Нг, кроме его цитаты о перенаселении Марса, может ошибочно подумать, что его не волнует безопасность ИИ, хотя на самом деле это не так. Суть просто в том, что, поскольку оценки Нг на временной шкале длиннее, он, естественно, склонен отдавать приоритет краткосрочным задачам ИИ над долгосрочными.

Мифы о рисках сверхчеловеческого ИИ

Многие исследователи ИИ закатывают глаза, увидев этот заголовок: « Стивен Хокинг предупреждает, что появление роботов может иметь катастрофические последствия для человечества». И столько же сбились со счета, сколько похожих статей они видели. Как правило, эти статьи сопровождаются злобным роботом с оружием, и они предлагают нам беспокоиться о том, что роботы восстанут и убьют нас, потому что они стали сознательными и/или злыми. С другой стороны, такие статьи на самом деле впечатляют, потому что они кратко излагают сценарий, который исследователи ИИ рассматривают9. 0092 не об этом не беспокойтесь. Этот сценарий сочетает в себе целых три отдельных заблуждения: озабоченность сознанием , злом, и роботами .

0092 не об этом не беспокойтесь. Этот сценарий сочетает в себе целых три отдельных заблуждения: озабоченность сознанием , злом, и роботами .

Если вы едете по дороге, у вас есть субъективное восприятие цветов, звуков, и т. д. . Но есть ли у беспилотного автомобиля субъективный опыт? Есть ли вообще что-то похожее на то, чтобы быть самоуправляемым автомобилем? Хотя эта загадка сознания интересна сама по себе, она не имеет отношения к риску ИИ. Если вас сбил беспилотный автомобиль, для вас не имеет значения, чувствует ли он себя в сознании субъективно. Точно так же на нас, людей, повлияет то, что сверхразумный ИИ делает , а не то, как субъективно ощущается .

Страх перед машинами, превращающими зло, — еще один отвлекающий маневр. Настоящее беспокойство вызывает не злоба, а компетентность. Сверхразумный ИИ по определению очень хорошо достигает своих целей, какими бы они ни были, поэтому мы должны убедиться, что его цели совпадают с нашими. Люди обычно не ненавидят муравьев, но мы умнее их, поэтому, если мы хотим построить плотину гидроэлектростанции, а там есть муравейник, это плохо для муравьев. Движение за благотворный ИИ хочет не ставить человечество в положение этих муравьев.

Люди обычно не ненавидят муравьев, но мы умнее их, поэтому, если мы хотим построить плотину гидроэлектростанции, а там есть муравейник, это плохо для муравьев. Движение за благотворный ИИ хочет не ставить человечество в положение этих муравьев.

Заблуждение сознания связано с мифом о том, что у машин не может быть целей. Машины, очевидно, могут иметь цели в узком смысле проявления целенаправленного поведения: поведение ракеты с тепловым наведением наиболее экономически объясняется как цель поразить цель. Если вы чувствуете угрозу со стороны машины, цели которой расходятся с вашими, то вас беспокоят именно ее цели в этом узком смысле, а не то, сознательна ли машина и испытывает ли она чувство цели. Если бы вас преследовала ракета с тепловым наведением, вы бы, наверное, не воскликнули: «Я не беспокоюсь, потому что у машин не может быть целей!»

Я сочувствую Родни Бруксу и другим пионерам робототехники, которые чувствуют себя несправедливо демонизированными пугающими таблоидами, потому что некоторые журналисты, похоже, одержимы роботами и украшают многие свои статьи злобными металлическими монстрами с красными блестящими глазами. Фактически, главная забота движения за полезный ИИ связана не с роботами, а с самим интеллектом: в частности, с интеллектом, цели которого не совпадают с нашими. Чтобы доставить нам неприятности, такой несогласованный сверхчеловеческий интеллект не нуждается в роботизированном теле, а просто в подключении к Интернету — это может позволить перехитрить финансовые рынки, изобретать исследователей-людей, манипулировать лидерами-людьми и разрабатывать оружие, которое мы даже не можем понять. Даже если бы создание роботов было физически невозможно, сверхинтеллектуальный и сверхбогатый ИИ мог бы легко платить или манипулировать многими людьми, чтобы они невольно выполняли его приказы.

Фактически, главная забота движения за полезный ИИ связана не с роботами, а с самим интеллектом: в частности, с интеллектом, цели которого не совпадают с нашими. Чтобы доставить нам неприятности, такой несогласованный сверхчеловеческий интеллект не нуждается в роботизированном теле, а просто в подключении к Интернету — это может позволить перехитрить финансовые рынки, изобретать исследователей-людей, манипулировать лидерами-людьми и разрабатывать оружие, которое мы даже не можем понять. Даже если бы создание роботов было физически невозможно, сверхинтеллектуальный и сверхбогатый ИИ мог бы легко платить или манипулировать многими людьми, чтобы они невольно выполняли его приказы.

Заблуждение о роботах связано с мифом о том, что машины не могут управлять людьми. Интеллект позволяет контролировать: люди контролируют тигров не потому, что мы сильнее, а потому, что мы умнее. Это означает, что если мы уступим свое положение самых умных на нашей планете, возможно, мы также уступим контроль.

Интересные споры

Не тратя время на вышеупомянутые заблуждения, давайте сосредоточимся на правдивых и интересных спорах, в которых расходятся мнения даже эксперты. Какое будущее вы хотите? Должны ли мы разрабатывать смертоносное автономное оружие? Что бы вы хотели, чтобы произошло с автоматизацией работы? Какой карьерный совет вы бы дали сегодняшним детям? Вы предпочитаете новые рабочие места, заменяющие старые, или общество безработных, где каждый наслаждается жизнью, полной досуга и богатством, производимым машинами? В дальнейшем вы хотели бы, чтобы мы создали сверхразумную жизнь и распространили ее по нашему космосу? Будем ли мы управлять разумными машинами или они будут управлять нами? Заменят ли нас разумные машины, будут ли они сосуществовать с нами или сольются с нами? Что значит быть человеком в эпоху искусственного интеллекта? Что бы вы хотели, чтобы это значило, и как мы можем сделать будущее таким? Пожалуйста, присоединяйтесь к беседе!

Рекомендуемые ссылки

Видео

- MinutePhysics: Мифы и факты о сверхразумном ИИ

- Макс Тегмарк: Как усилить, а не подавлять ИИ

- Стюарт Рассел: 3 принципа создания более безопасного ИИ

: мы строим ИИ, не теряя над ним контроля?

- Доклады с конференции Beneficial AI 2017 в Асиломаре, Калифорния

- Стюарт Рассел — Долгосрочное будущее (искусственного) интеллекта

- Людям не нужно подавать заявку

- Ник Бостром: Что произойдет, когда компьютеры станут умнее нас?

- Согласование ценностей — Стюарт Рассел: Дебаты Berkeley IdeasLab Презентация на Всемирном экономическом форуме

- Социальные технологии и искусственный интеллект: Ежегодное собрание Всемирного экономического форума 2015

- Стюарт Рассел, Эрик Хорвиц, Макс Тегмарк — Будущее искусственного интеллекта

- Яан Таллинн по управлению искусственным интеллектом

Статьи в СМИ

- Связание с пионером искусственного интеллекта

- Преодоление самоуспокоенности на суперинтеллигентных машинах

- , почему мы должны думать об угрозе Artificial Intellight

- STEPHENELHIAL INELLECTIONE

- STEPHENERENIGIAL INELLECHILE

- Степень.

может убить нас всех. Познакомьтесь с человеком, который серьезно относится к этому риску

может убить нас всех. Познакомьтесь с человеком, который серьезно относится к этому риску - Искусственный интеллект представляет «риск исчезновения» для человечества, говорит Стюарт Армстронг из Оксфордского университета

- Что происходит, когда искусственный интеллект нападает на нас?

- Можем ли мы создать искусственный сверхразум, который нас не убьет?

- Искусственный интеллект: наше последнее изобретение?

- Искусственный интеллект: можем ли мы оставить его в коробке?

- Научная пятница: Кристоф Кох и Стюарт Рассел о машинном интеллекте (стенограмма)

- Трансцендентность: исследователь ИИ наслаждается просмотром собственной казни

- Наука идет в кино: «Трансцендентность»

- Наш страх перед искусственным интеллектом

Эссе исследователей искусственного интеллекта

- Стюарт Рассел: Что вы думаете о мыслящих машинах?

- Стюарт Рассел: О мифах и выдумках

- Джейкоб Стейнхардт: Долгосрочные и краткосрочные вызовы для обеспечения безопасности систем ИИ

- Элиэзер Юдковски: Почему ИИ, ориентированный на ценности, является сложной инженерной проблемой

- Элиезер Юдковски: Для искусственного интеллекта общего назначения нет пожарной сигнализации

- Открытое письмо: Приоритеты исследований в области надежного и полезного искусственного интеллекта

Исследовательские статьи

- Взрыв разведки: доказательства и импорт (MIRI)

- Взрыв разведки и машинная этика (Люк Мюльхаузер, MIRI)

- as Positive и негативный фактор в глобальном риске (MIRI)

- Основные движущие силы ИИ

- Гонки к пропасти: модель развития искусственного интеллекта

- Этика искусственного интеллекта

- Сверхразумная воля: мотивация и инструментальная рациональность в продвинутых искусственных агентах

- Прослушка в смертных универсальных агентах

- Обзор литературы по безопасности AGI

Сборник исследований

- Брюс Шнайер — Resources on Existential, p23ential, p23ential.

110

110 - Согласование сверхразума с интересами человека: программа технических исследований (MIRI)

- Публикации MIRI

- Стэнфордское столетнее исследование искусственного интеллекта (AI100)

- Подготовка к будущему разведки: отчет Белого дома, в котором обсуждается текущее состояние ИИ и будущих приложений, а также рекомендации относительно роли правительства в поддержке развития ИИ.

- Искусственный интеллект, автоматизация и экономика: отчет Белого дома, в котором обсуждается потенциальное влияние ИИ на рабочие места и экономику, а также стратегии увеличения преимуществ этого перехода.

- Специальный отчет IEEE: искусственный интеллект: отчет, в котором объясняется глубокое обучение, при котором нейронные сети обучаются сами и принимают решения самостоятельно.

Тематические исследования

- Конференция Asilomar: пример снижения рисков (Катя Грейс, MIRI)

- Предконкурентное сотрудничество в фармацевтической сотрудничество по безопасности в промышленности.

Сообщения в блогах и выступления

- Управление ИИ

- Воздействие ИИ

- Лучшее время для работы по обеспечению безопасности ИИ

- Риски и возможности ИИ: стратегический анализ9

- Где мы находимся — Прогресс ИИ и связанных с ним технологий: введение в прогресс исследовательских институтов, разрабатывающих новые технологии ИИ.

- Безопасность ИИ

- Подождите, но почему об искусственном интеллекте

- Ответ Люка Мюльхаузера на вопрос «Подождите, но почему»

- Slate Star Codex о том, почему исследования риска ИИ не вызывают таких споров

- Что должен делать средний советник по поводу выравнивания ИИ?

- Waking Up Podcast #116 — AI: Racing Toward the Brink with Eliezer Yudkowsky

Книги

- Сверхразум: пути, опасности, стратегии

- Наша жизнь 3.0. : Искусственный интеллект и конец человеческой эры

- Перед лицом интеллектуального взрыва

- Электронная книга о риске ИИ (включая сценарий «Терминатора», который более правдоподобен, чем киноверсия)

Организации

- Научно-исследовательский институт машинного интеллекта: некоммерческая организация, миссия которой состоит в том, чтобы создание интеллекта, превосходящего человеческий, имело положительное влияние.

- Центр изучения экзистенциального риска (CSER): многопрофильный исследовательский центр, занимающийся изучением и снижением рисков, которые могут привести к вымиранию человечества.

- Институт будущего человечества: многопрофильный исследовательский институт, использующий инструменты математики, философии и науки для решения общих вопросов о человечестве и его перспективах.

- Партнерство в области искусственного интеллекта: создано для изучения и формулирования передового опыта в области технологий искусственного интеллекта, расширения понимания общественностью искусственного интеллекта и использования в качестве открытой платформы для обсуждения и взаимодействия по вопросам искусственного интеллекта и его влияния на людей и общество.

- Global Catastrophic Risk Institute: аналитический центр, занимающийся исследованиями, образованием и профессиональным сотрудничеством в области глобальных катастрофических рисков.

- Организации, занимающиеся экзистенциальными рисками: краткое введение в некоторые организации, занимающиеся экзистенциальными рисками.

интеллект может помочь цивилизации процветать как никогда раньше — до тех пор, пока нам удается поддерживать технологию полезной. »

интеллект может помочь цивилизации процветать как никогда раньше — до тех пор, пока нам удается поддерживать технологию полезной. » Этот риск присутствует даже при узком ИИ, но растет по мере увеличения уровня интеллекта и автономии ИИ.

Этот риск присутствует даже при узком ИИ, но растет по мере увеличения уровня интеллекта и автономии ИИ.