titan (суперкомпьютер). Титан суперкомпьютер

Титан (суперкомпьютер) • ru.knowledgr.com

Титан - суперкомпьютер, построенный Крэем в Окриджской национальной лаборатории для использования во множестве научных проектов. Титан - модернизация Ягуара, предыдущего суперкомпьютера в Ок-Ридже, который использует единицы обработки графики (GPUs) в дополнение к обычным центральным процессорам (центральные процессоры). Титан первый такой гибрид, чтобы выполнить более чем 10 petaFLOPS. Модернизация началась в октябре 2011, начатое тестирование стабильности в октябре 2012, и это стало доступным исследователям в начале 2013. Начальные затраты на модернизацию составляли 60 миллионов долларов США, финансируемых прежде всего Министерством энергетики Соединенных Штатов.

Титан должен затмиться в Ок-Ридже Саммитом в 2018, который строится IBM и показывает меньше узлов с намного большей способностью GPU за узел, а также местное энергонезависимое кэширование за узел данных о файле от параллельной файловой системы системы.

Титан использует центральные процессоры AMD OPTERON вместе с Тесла Nvidia GPUs, чтобы улучшить эффективность использования энергии, обеспечивая увеличение порядка величины вычислительной власти над Ягуаром. Это использует 18 688 центральных процессоров, соединенных с равным количеством GPUs, чтобы выступить на теоретическом пике 27 petaFLOPS; в оценке LINPACK, используемой, чтобы оценить скорость суперкомпьютеров, это выступило в 17.59 petaFLOPS. Этого было достаточно, чтобы занять первое место в списке в ноябре 2012 организацией TOP500, но Тяньхэ 2 настиг его в списке в июне 2013.

Титан доступен в любой научной цели; доступ зависит от важности проекта и его потенциала, чтобы эксплуатировать гибридную архитектуру. Любой отобранный кодекс должен также быть выполнимым на других суперкомпьютерах, чтобы избежать единственной зависимости от Титана. Шесть кодексов авангарда были отобранным первым. Они имели дело главным образом с молекулярной физикой масштаба или моделями климата, в то время как 25 других стояли в очереди позади них. Включение GPUs заставило авторов изменять свои кодексы. Модификации, как правило, увеличивали степень параллелизма, учитывая, что GPUs предлагают еще много одновременных нитей, чем центральные процессоры. Изменения часто приводят к большей работе даже на машинах только для центрального процессора.

История

Планы создать суперкомпьютер, способный к 20 petaFLOPS на Средстве для Вычисления Лидерства Ок-Риджа (OLCF) в Окриджской национальной лаборатории (ORNL) еще, произошли 2005, когда Ягуар был построен. Титан будет самостоятельно заменен приблизительно 200 petaFLOPS системами в 2016 как часть плана ORNL управлять exascale (1000 petaFLOPS к 1 exaFLOPS) машина к 2020. Первоначальный план построить новые 15 000 квадратных метров (160 000 футов) здание для Титана, был отказан в пользу использования существующей инфраструктуры Ягуара. Точная системная архитектура не была завершена до 2010, хотя соглашение с Nvidia, чтобы поставлять GPUs было подписано в 2009. О титане сначала объявили в частном ACM/IEEE Супервычисление Конференции (SC10) 16 ноября 2010 и публично объявили 11 октября 2011, когда первая фаза модернизации Титана началась.

Ягуар получил различные модернизации начиная со своего создания. Это началось с Крэя платформа XT3, которая привела к 25 teraFLOPS. К 2008 Ягуар был расширен с большим количеством кабинетов и модернизирован до платформы XT4, достигнув 263 teraFLOPS. В 2009 это было модернизировано до платформы XT5, поразив 1.4 petaFLOPS. Его заключительные модернизации принесли Ягуар к 1.76 petaFLOPS.

Титан финансировался прежде всего американским Министерством энергетики через ORNL. Финансирование было достаточно, чтобы купить центральные процессоры, но не все GPUs, таким образом, Национальное управление океанических и атмосферных исследований согласилось финансировать остающиеся узлы взамен вычислительного времени. Научный вычислительный руководитель ORNL Джефф Николс отметил, что Титан стоил первичных приблизительно $60 миллионов, которых вклад NOAA составлял меньше чем $10 миллионов, но точные числа были охвачены соглашениями о неразглашении. Полный срок контракта с Крэем включал $97 миллионов, исключая потенциальные модернизации.

Годовое преобразование началось 9 октября 2011. Между октябрем и декабрем, 96 из 200 кабинетов Ягуара, каждый содержащий 24 лезвия XT5 (два центральных процессора с 6 ядрами за узел, четыре узла за лезвие), были модернизированы до лезвий XK7 (один центральный процессор с 16 ядрами за узел, четыре узла за лезвие), в то время как остаток от машины остался в использовании. В декабре вычисление было перемещено к 96 кабинетам XK7, в то время как оставление 104 кабинетами было модернизировано до лезвий XK7. Системное межсоединение (сеть, по которой центральные процессоры общаются друг с другом) было обновлено, и внешняя связь ORNL ESnet была модернизирована от 10 Гбит/с до 100 Гбит/с. Системная память была удвоена до 584 ТИБ. 960 из узлов XK7 (10 кабинетов) были оснащены базируемым GPU Ферми, поскольку Kepler GPUs не были тогда доступны; эти 960 узлов упоминались как Титандев и раньше проверяли кодекс. Эта первая фаза модернизации увеличила пиковую производительность Ягуара к 3.3 petaFLOPS. Начинаясь 13 сентября 2012, Nvidia K20X, GPUs были приспособлены ко всем XK7 Ягуара, вычисляет лезвия, включая 960 узлов Титандева. В октябре задача была выполнена, и компьютер был наконец окрещенным Титаном.

Сеть внутренней связи была также модернизирована.

Дизайн Seastar, используемый в Ягуаре, был модернизирован до сети Gemini, используемой в Титане.

Сеть Gemini соединяет узлы Титана в прямую 3D соединительную сеть торуса.

Близнецы используют управление потоками червоточины внутренне.

В марте 2013 Nvidia начала Титана GTX, потребительская видеокарта, которая использует тот же самый GPU, умирает как K20X GPUs в Титане. Титан подвергся приемному тестированию в начале 2013, но только закончил 92% тестов, за исключением необходимых 95%. Проблемой, как обнаруживали, было избыточное золото в женских соединителях края слотов PCIe материнских плат, вызывающих трещины в припое материнских плат. Расходы на ремонт понеслись Крэем, и между 12 и 16 кабинетами восстанавливались каждую неделю. В течение ремонта пользователям предоставили доступ к доступным центральным процессорам. 11 марта они получили доступ к 8,972 GPUs. 8 апреля ORNL объявил, что ремонт был завершен, и о завершении приемочного испытания объявили 11 июня 2013.

аппаратных средств титана есть теоретическая пиковая производительность 27 petaFLOPS с «прекрасным» программным обеспечением. 12 ноября 2012, организация TOP500, которая оценивает суперкомпьютеры миров работой LINPACK, оцениваемый Титан сначала в 17.59 petaFLOPS, перемещая Секвойю IBM. Титан также занял третье место на Green500, те же самые 500 суперкомпьютеров, оцениваемых с точки зрения эффективности использования энергии. В июне 2013 ранжирование TOP500, Титан упал на второе место позади Тяньхэ 2 и на двадцать девятый в списке Green500. Титан не повторно проверял на ранжирование в июне 2013, потому что это все еще займет второе место в 27 petaFLOPS.

Аппаратные средства

Титан использует 200 кабинетов Ягуара, покрывая 404 квадратных метра (4 352 фута), с замененными внутренностями и модернизированной организацией сети. Многократное использование власти и систем охлаждения Ягуара сэкономило приблизительно $20 миллионов. Власть предоставлена каждому кабинету в 480 В. Это требует более тонких кабелей, чем американские стандартные 208 В, экономя $1 миллион в меди. На его пике Титан тянет 8,2 МВт, 1,2 МВт больше, чем Ягуар, но пробеги, почти в десять раз более быстрые с точки зрения вычислений с плавающей запятой. В случае перебоя в питании хранение власти махового колеса углеволокна может держать инфраструктуру организации сети и хранения, бегущую в течение максимум 16 секунд. После 2 секунд без власти дизельные генераторы разжигают, занимая приблизительно 7 секунд, чтобы достигнуть полной мощности. Они могут обеспечить власть неопределенно. Генераторы разработаны только, чтобы сохранять компоненты организации сети и хранения приведенными в действие так, чтобы перезагрузка была намного более быстрой; генераторы не способны к включению инфраструктуры обработки.

титана есть 18 688 узлов (4 узла за лезвие, 24 лезвия за кабинет), каждый содержащий центральный процессор AMD С 16 ЯДРАМИ OPTERON 6274 с 32 гибибайтами памяти DDR3 ECC и тесла K20X GPU Nvidia с памятью GDDR5 ECC на 6 гибибайт. Есть в общей сложности 299 008 ядер процессора, и В ОБЩЕЙ СЛОЖНОСТИ 693,6 ТИБ центрального процессора и ГПУ РАМА.

Первоначально, Титан использовал 10 PB Ягуара хранения Блеска со скоростью передачи 240 ГБ/с, но в апреле 2013, хранение было модернизировано до 40 PB со скоростью передачи 1,4 TB/с. GPUs были отобраны для их значительно более высокой параллельной эффективности обработки по центральным процессорам. Хотя у GPUs есть более медленная тактовая частота, чем центральные процессоры, каждый GPU содержит 2,688 ядер CUDA в 732 МГц, приводящих к более быстрой полной системе. Следовательно, ядра центральных процессоров используются, чтобы ассигновать задачи GPUs вместо того, чтобы непосредственно обработать данные как в обычных суперкомпьютерах.

Титан управляет Крэем Окружающая среда Linux, полная версия Linux на узлах логина что пользователи непосредственно доступ, но меньшая, более эффективная версия на вычислить узлах.

Компоненты титана охлаждаются теплоотводами, но воздух охлажден прежде чем быть накачанным через кабинеты. Шум поклонника столь громкий, что защита органов слуха требуется для людей, проводящих больше чем 15 минут в машинной комнате. Система имеет охлаждающуюся мощность 23,2 МВт (6 600 тонн) и работает пугающей водой к 5.5 °C (42 °F), который в свою очередь охлаждает повторно распространенный воздух.

Уисследователей также есть доступ к ЭВЕРЕСТУ (Исследовательская Окружающая среда Визуализации для Исследования и Технологии), чтобы лучше понять данные тот Титан продукция. ЭВЕРЕСТ - комната визуализации с 10 на 3 метра (33 на 10 футов) экран и меньший, вторичный экран. Экраны составляют 37 и 33 мегапикселя соответственно со стереоскопической 3D способностью.

Проекты

В 2009 Средство для Вычисления Лидерства Ок-Риджа, которое управляет Титаном, сузило эти пятьдесят заявлений на первое использование суперкомпьютера вниз к шести кодексам «авангарда», выбранным для важности исследования и для их способности полностью использовать систему. Шесть проектов авангарда использовать Титана были:

- S3D, проект, который моделирует молекулярную физику сгорания, стремится повышать эффективность двигателей биотоплива и дизеля. В 2009, используя Ягуар, это произвело первое полностью решенное моделирование автозагорающегося огня углеводорода, относящегося к эффективности дизельных двигателей с прямым впрыском топлива.

- WL-LSMS моделирует взаимодействия между электронами и атомами в магнитных материалах при температурах кроме абсолютного нуля. Более ранняя версия кодекса была первой, чтобы выступить в большем, чем один petaFLOPS на Ягуаре.

- Деново моделирует ядерные реакции с целью повышения эффективности и сокращения траты ядерных реакторов. Работа Деново на обычных основанных на центральном процессоре машинах удвоилась после щипков для Титана и это выступает в 3.5 раза быстрее на Титане, чем это сделало на Ягуаре.

- Крупномасштабный Атомный/Молекулярный В широком масштабе Параллельный Симулятор (LAMMPS) является молекулярным кодексом динамики, который моделирует частицы через диапазон весов, от кванта до релятивистского, чтобы улучшить материаловедение с возможным применением в полупроводнике, биомолекуле и развитии полимера.

- КУЛАК-SE - комбинация двух кодексов: Модель Атмосферы Сообщества, модель планетарной атмосферы и Высокого уровня Окружающая среда Моделирования Метода, кодекс, который решает жидкие и термодинамические уравнения. КУЛАК-SE позволит большую точность в моделированиях климата.

- Неравновесное Радиационное Распространение (NRDF) готовит незаряженные частицы через суперновинки с возможным применением в лазерном сплаве, гидрогазодинамике, медицинском отображении, ядерных реакторах, аккумулировании энергии и сгорании. Его кодекс химеры использует сотни частичных отличительных уравнений, чтобы отследить энергию, угол, угол разброса и тип каждого нейтрино, смоделированного в звезде, идущей сверхновая звезда, приводящая к миллионам отдельных уравнений. Кодекс назвали химерой в честь мифологического существа, потому что у этого есть три «головы»: первое моделирует гидродинамику звездного материала, второе моделирует радиационный транспорт, и третье моделирует ядерное горение.

VERA - легкое водное реакторное моделирование, написанное в Консорциуме для Передового Моделирования Легких Водных Реакторов (CASL) на Ягуаре. VERA позволяет инженерам контролировать работу и статус любой части реакторного ядра всюду по целой жизни реактора, чтобы определить интересные места. Хотя не один из первых шести проектов, VERA был запланирован, чтобы бежать на Титане за оптимизацией с помощью со стороны CAAR и проверяющий на Титандеве. Программист Том Эванс нашел, что адаптация к гибридной архитектуре Титана была более трудной, чем к предыдущим основанным на центральном процессоре суперкомпьютерам. Он стремился моделировать весь реакторный топливный цикл, восемнадцать - тридцать шесть месячных процессов, через одну неделю на Титане.

В 2013 тридцать один кодекс был запланирован, чтобы бежать на Титане, как правило четыре или пять в любой момент.

Кодовые модификации

Кодекс многих проектов должен быть изменен, чтобы удовлетворить обработке GPU Титана, но каждый кодекс требуется, чтобы быть выполнимым на основанных на центральном процессоре системах так, чтобы проекты не становились исключительно зависящими от Титана. OLCF создал Центр Ускоренной Прикладной Готовности (CAAR), чтобы помочь с процессом адаптации. Это проводит семинары разработчика в главном офисе Nvidia, чтобы рассказать пользователям об архитектуре, компиляторах и заявлениях на Титане. CAAR работал над компиляторами с Nvidia и кодовыми продавцами, чтобы объединить директивы для GPUs на их языки программирования. Исследователи могут таким образом выразить параллелизм в своем кодексе с их существующим языком программирования, как правило ФОРТРАН, C или C ++, и компилятор может выразить его GPUs. Доктор Бронсон Мессер, вычислительный астрофизик, сказал относительно задачи:" ... применение, используя Титана для самого большого должно также найти способ заставить GPU напряженно трудиться, помня все время, что GPU быстр, но менее гибок, чем центральный процессор». Moab Cluster Suite используется, чтобы расположить по приоритетам рабочие места к узлам, чтобы поддержать использование на высоком уровне; это повысило эффективность от 70% приблизительно до 95% в проверенном программном обеспечении. Некоторые проекты нашли, что изменения увеличили эффективность своего кодекса по non-GPU машинам; работа Деново удвоилась на основанных на центральном процессоре машинах.

Сумма кодового изменения, требуемого бежать на GPUs, варьируется проектом. Согласно доктору Мессеру NRDF, только небольшой процент его кодекса бежит на GPUs, потому что вычисления относительно просты, но обработаны неоднократно и параллельно. NRDF написан в ФОРТРАНе CUDA, версии ФОРТРАНа с расширениями CUDA для GPUs. Третья «голова» химеры была первой, чтобы бежать на GPUs, поскольку ядерное горение могло наиболее легко быть моделировано архитектурой GPU. Другие аспекты кодекса были запланированы, чтобы быть измененными вовремя. На Ягуаре проект смоделировал 14 или 15 ядерных разновидностей, но Мессер ожидал моделировать до 200 разновидностей, позволяя намного большую точность, сравнивая моделирование с эмпирическим наблюдением.

См. также

- Список Продвинутого Научного Вычислительного Лидерства Исследования Вычислительные отчисления проблемы

- Средство для вычисления лидерства Ок-Риджа

Внешние ссылки

ru.knowledgr.com

Titan (суперкомпьютер) — википедия орг

История

Осенью 2012 года начался последний этап модернизации Jaguar’а до более мощного суперкомпьютера, которому дано новое название Titan.

Львиную долю компьютерного времени Titan’а планировалось отдать под приложения государственной программы Министерства энергетики США под названием «Innovative and Novel Computational Impact on Theory and Experiment program» (INCITE)[7]. В течение предшествующих двух лет исследователи и программисты переписывали свои приложения под новую архитектуру Titan’а, чтобы начать его использование с первых же дней введения его в строй.

Суперкомпьютер Titan планируется заменить новым суперкомпьютером Summit, постройку которого IBM планирует завершить в середине 2018 года. Предполагается, что Titan проработает еще один год после ввода в строй суперкомпьютера Summit, а потом будет демонтирован.[8]

Архитектура и устройство

Применение

Львиная доля компьютерного времени Titan-а будет отдана под приложения государственной программы Министерства энергетики США под названием «Innovative and Novel Computational Impact on Theory and Experiment program» (INCITE)[7].

Несмотря на то, что Titan можно использовать для любого проекта, количество заявок превысило имеющееся компьютерное время. Поэтому было решено провести тщательный отбор. В 2009 году Oak Ridge Computing Leadership Facility (OCLF) рассмотрел 50 заявок и сузил список до 6 проектов, которые были выбраны не только из-за важности исследовательских тем, но и из-за способности программного обеспечения проектов как можно полнее использовать возможности гибридной системы.[9] Программный код этих проектов пришлось изменить так, чтобы он мог исполняться на графических процессорах Titan-а, при этом требовалось оставить возможность исполнения кода на обычных процессорах, чтобы он не был привязан исключительно к Titan-у.[9]. В течение двух лет исследователи и программисты переписывали свои приложения, чтобы начать его использование с первых же дней введения Titan-а в строй.

Первыми проектами, которые получат доступ к Titan-у являются:

- Процессы сгорания топлива: С помощью приложения S3D исследователи могут смоделировать турбулентное сгорание различных видов и составов топлива. Результаты исследований позволят создавать высокоэффективные, экономичные, оптимальные двигательные системы, почти не загрязняющие окружающую среду.[9]

- Наука о материалах: С помощью приложения WL-LSMS исследователи смогут находить и создавать новые материалы, исследуя их магнитные свойства при разных температурах на нано-уровне. Результаты исследований позволят создавать новые электродвигатели и электрогенераторы.

- Атомная энергия: С помощью приложения Denovo исследователи смогут моделировать поведение нейтронов в ядерном реакторе. Результаты исследований позволят выяснить, как более эффективно использовать стареющие ядерные реакторы США при сохранении их безопасности. На Titan-е приложение Denovo смоделирует за 13 часов один полный цикл службы стержня ядерного топлива, в то время как на Jaguar-е на это требовалось 60 часов.

- Изменения климата: Программа Community Atmosphere Model-Spectral Element (CAM-SE) симулирует долгосрочные глобальные изменения климата. Результаты вычислений позволят исследователям вычислить качество воздуха в ближайшем будущем, а также влияние его состава на климат. Titan позволяет за один день компьютерного времени сделать прогноз на 1—5 лет вперёд, в то время как на Jaguar за один день можно было вычислить прогноз только на 3 месяца.

Примечания

- ↑ Feldman, Michael Titan Sets High Water Mark for GPU Supercomputing. HPC Wire (October 29, 2012). Проверено 30 октября 2012. Архивировано 8 января 2013 года.

- ↑ Lal Shimpi, Anand Inside the Titan Supercomputer. Anandtech (October 31, 2012). Проверено 2 ноября 2012. Архивировано 8 января 2013 года.

- ↑ Feldman, Michael GPUs Will Morph ORNL's Jaguar Into 20-Petaflop Titan. HPC Wire (October 11, 2011). Проверено 29 октября 2012. Архивировано 8 января 2013 года.

- ↑ Oak Ridge changes Jaguar’s spots from CPUs to GPUs by Timothy Prickett Morgan, The Register Oct 11, 2011 [1]

- ↑ Poeter, Damon Cray's Titan Supercomputer for ORNL Could Be World's Fastest. PC Magazine (October 11, 2011). Проверено 29 октября 2012. Архивировано 8 января 2013 года.

- ↑ Tibken, Shara Titan supercomputer debuts for open scientific research. CNET (October 29, 2012). Проверено 29 октября 2012. Архивировано 8 января 2013 года.

- ↑ 1 2 Пресс-релиз Лаборатории о суперкомпьютре Titan ORNL Debuts Titan Supercomputer

- ↑ With the Summit Supercomputer, U.S. Could Retake Computing’s Top Spot

- ↑ 1 2 3 TITAN: Built for Science. Oak Ridge Leadership Computing Facility. Проверено 29 октября 2012. Архивировано 8 января 2013 года.

См. также

Ссылки

www-wikipediya.ru

titan (суперкомпьютер) Вики

Titan — суперкомпьютер компании Cray Inc. установленный в национальной лаборатории Оук-Ридж (сокращённо ORNL, национальная лаборатория Министерства энергетики США, Теннесси) для использования в научных проектах. Является обновлением суперкомпьютера Jaguar, при котором было увеличено количество центральных процессоров и добавлены GPU Nvidia Tesla K20x.[3][4]

Анонсирован в октябре 2011, введен в строй в октябре 2012.[5][6] Занял 1 строку в ноябре 2012 года в рейтинге TOP500 суперкомпьютеров мира по производительности на тесте Linpack. В июле 2013 года был смещён на 2-ю позицию компьютером Tianhe-2. В июне 2016 года был уже на 3-ей позиции после суперкомпьютеров Tianhe-2 и Sunway TaihuLight (93 Пфлопс).

История[ | код]

Осенью 2012 года начался последний этап модернизации Jaguar’а до более мощного суперкомпьютера, которому дано новое название Titan.

Львиную долю компьютерного времени Titan’а планировалось отдать под приложения государственной программы Министерства энергетики США под названием «Innovative and Novel Computational Impact on Theory and Experiment program» (INCITE)[7]. В течение предшествующих двух лет исследователи и программисты переписывали свои приложения под новую архитектуру Titan’а, чтобы начать его использование с первых же дней введения его в строй.

Суперкомпьютер Titan планируется заменить новым суперкомпьютером Summit, постройку которого IBM планирует завершить в середине 2018 года. Предполагается, что Titan проработает еще один год после ввода в строй суперкомпьютера Summit, а потом будет демонтирован.[8]

Архитектура и устройство[ | код]

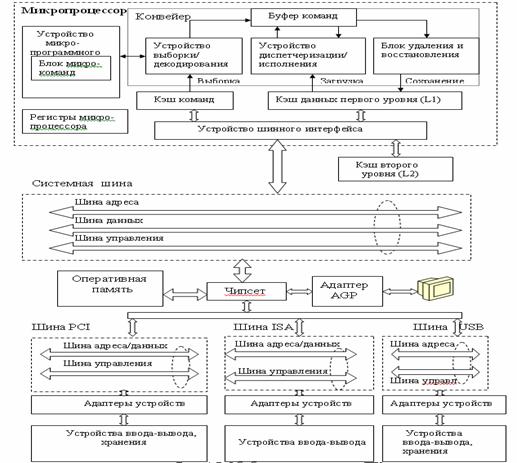

Titan — массово-параллельный суперкомпьютер, построенный на платформе Cray XK7 с гибридной архитектурой: помимо 16-ядерных процессоров AMD Opteron 6274 в каждый из 18 688 узлов суперкомпьютерной системы установлен графический процессор общего назначения NVIDIA Tesla K20x (архитектура Kepler). Таким образом общее число ядер компьютера составляет 299 008. Компилятор, специально разработанный для Titan-а, автоматически распараллеливает исполнение кода между центральным и графическим процессорами.

Применение[ | код]

Львиная доля компьютерного времени Titan-а будет отдана под приложения государственной программы Министерства энергетики США под названием «Innovative and Novel Computational Impact on Theory and Experiment program» (INCITE)[7].

Несмотря на то, что Titan можно использовать для любого проекта, количество заявок превысило имеющееся компьютерное время. Поэтому было решено провести тщательный отбор. В 2009 году Oak Ridge Computing Leadership Facility (OCLF) рассмотрел 50 заявок и сузил список до 6 проектов, которые были выбраны не только из-за важности исследовательских тем, но и из-за способности программного обеспечения проектов как можно полнее использовать возможности гибридной системы.[9] Программный код этих проектов пришлось изменить так, чтобы он мог исполняться на графических процессорах Titan-а, при этом требовалось оставить возможность исполнения кода на обычных процессорах, чтобы он не был привязан исключительно к Titan-у.[9]. В течение двух лет исследователи и программисты переписывали свои приложения, чтобы начать его использование с первых же дней введения Titan-а в строй.

Первыми проектами, которые получат доступ к Titan-у являются:

- Процессы сгорания топлива: С помощью приложения S3D исследователи могут смоделировать турбулентное сгорание различных видов и составов топлива. Результаты исследований позволят создавать высокоэффективные, экономичные, оптимальные двигательные системы, почти не загрязняющие окружающую среду.[9]

- Наука о материалах: С помощью приложения WL-LSMS исследователи смогут находить и создавать новые материалы, исследуя их магнитные свойства при разных температурах на нано-уровне. Результаты исследований позволят создавать новые электродвигатели и электрогенераторы.

- Атомная энергия: С помощью приложения Denovo исследователи смогут моделировать поведение нейтронов в ядерном реакторе. Результаты исследований позволят выяснить, как более эффективно использовать стареющие ядерные реакторы США при сохранении их безопасности. На Titan-е приложение Denovo смоделирует за 13 часов один полный цикл службы стержня ядерного топлива, в то время как на Jaguar-е на это требовалось 60 часов.

- Изменения климата: Программа Community Atmosphere Model-Spectral Element (CAM-SE) симулирует долгосрочные глобальные изменения климата. Результаты вычислений позволят исследователям вычислить качество воздуха в ближайшем будущем, а также влияние его состава на климат. Titan позволяет за один день компьютерного времени сделать прогноз на 1—5 лет вперёд, в то время как на Jaguar за один день можно было вычислить прогноз только на 3 месяца.

Примечания[ | код]

- ↑ Feldman, Michael Titan Sets High Water Mark for GPU Supercomputing. HPC Wire (October 29, 2012). Проверено 30 октября 2012. Архивировано 8 января 2013 года.

- ↑ Lal Shimpi, Anand Inside the Titan Supercomputer. Anandtech (October 31, 2012). Проверено 2 ноября 2012. Архивировано 8 января 2013 года.

- ↑ Feldman, Michael GPUs Will Morph ORNL's Jaguar Into 20-Petaflop Titan. HPC Wire (October 11, 2011). Проверено 29 октября 2012. Архивировано 8 января 2013 года.

- ↑ Oak Ridge changes Jaguar’s spots from CPUs to GPUs by Timothy Prickett Morgan, The Register Oct 11, 2011 [1]

- ↑ Poeter, Damon Cray's Titan Supercomputer for ORNL Could Be World's Fastest. PC Magazine (October 11, 2011). Проверено 29 октября 2012. Архивировано 8 января 2013 года.

- ↑ Tibken, Shara Titan supercomputer debuts for open scientific research. CNET (October 29, 2012). Проверено 29 октября 2012. Архивировано 8 января 2013 года.

- ↑ 1 2 Пресс-релиз Лаборатории о суперкомпьютре Titan ORNL Debuts Titan Supercomputer

- ↑ With the Summit Supercomputer, U.S. Could Retake Computing’s Top Spot

- ↑ 1 2 3 TITAN: Built for Science. Oak Ridge Leadership Computing Facility. Проверено 29 октября 2012. Архивировано 8 января 2013 года.

См. также[ | код]

Ссылки[ | код]

ru.wikibedia.ru

Titan (суперкомпьютер) - Вики

История

Осенью 2012 года начался последний этап модернизации Jaguar’а до более мощного суперкомпьютера, которому дано новое название Titan.

Львиную долю компьютерного времени Titan’а планировалось отдать под приложения государственной программы Министерства энергетики США под названием «Innovative and Novel Computational Impact on Theory and Experiment program» (INCITE)[7]. В течение предшествующих двух лет исследователи и программисты переписывали свои приложения под новую архитектуру Titan’а, чтобы начать его использование с первых же дней введения его в строй.

Суперкомпьютер Titan планируется заменить новым суперкомпьютером Summit, постройку которого IBM планирует завершить в середине 2018 года. Предполагается, что Titan проработает еще один год после ввода в строй суперкомпьютера Summit, а потом будет демонтирован.[8]

Архитектура и устройство

Применение

Львиная доля компьютерного времени Titan-а будет отдана под приложения государственной программы Министерства энергетики США под названием «Innovative and Novel Computational Impact on Theory and Experiment program» (INCITE)[7].

Несмотря на то, что Titan можно использовать для любого проекта, количество заявок превысило имеющееся компьютерное время. Поэтому было решено провести тщательный отбор. В 2009 году Oak Ridge Computing Leadership Facility (OCLF) рассмотрел 50 заявок и сузил список до 6 проектов, которые были выбраны не только из-за важности исследовательских тем, но и из-за способности программного обеспечения проектов как можно полнее использовать возможности гибридной системы.[9] Программный код этих проектов пришлось изменить так, чтобы он мог исполняться на графических процессорах Titan-а, при этом требовалось оставить возможность исполнения кода на обычных процессорах, чтобы он не был привязан исключительно к Titan-у.[9]. В течение двух лет исследователи и программисты переписывали свои приложения, чтобы начать его использование с первых же дней введения Titan-а в строй.

Первыми проектами, которые получат доступ к Titan-у являются:

- Процессы сгорания топлива: С помощью приложения S3D исследователи могут смоделировать турбулентное сгорание различных видов и составов топлива. Результаты исследований позволят создавать высокоэффективные, экономичные, оптимальные двигательные системы, почти не за

ru.wikiredia.com

Titan (суперкомпьютер) - WikiVisually

1. Министерство энергетики США – The United States Department of Energy is a Cabinet-level department of the United States Government concerned with the United States policies regarding energy and safety in handling nuclear material. It also directs research in genomics, the Human Genome Project originated in a DOE initiative, DOE sponsors more research in the physical sciences than any other U. S. federal agency, the majority of which is conducted through its system of National Laboratories. Former Governor of Texas Rick Perry is the current Secretary of Energy and he was confirmed by a 62 to 37 vote in the United States Senate on March 2,2017. In 1942, during World War II, the United States started the Manhattan Project, after the war in 1946, the Atomic Energy Commission was created to control the future of the project. The 1973 oil crisis called attention to the need to consolidate energy policy, on August 4,1977, President Jimmy Carter signed into law The Department of Energy Organization Act of 1977, which created the Department of Energy. Former Secretary of Defense James Schlesinger, who served under Presidents Nixon, a DOE spokesperson denied that phrases had been banned. In December 1999, the FBI was investigating how China obtained plans for a nuclear device. Wen Ho Lee was accused of stealing nuclear secrets from Los Alamos National Laboratory for the Peoples Republic of China, Federal officials, including then-Energy Secretary Bill Richardson, publicly named Lee as a suspect before he was charged with a crime. The U. S. Congress held hearings to investigate the Department of Energys mishandling of his case, republican senators thought that an independent agency should be in charge of nuclear weapons and security issues, not the Department of Energy. All but one of the 59 charges against Lee were eventually dropped because the investigation proved that the plans the Chinese obtained could not have come from Lee. Lee filed suit and won a $1.6 million settlement against the federal government, the department is under the control and supervision of a United States Secretary of Energy, a political appointee of the President of the United States. The Energy Secretary is assisted in managing the department by a United States Deputy Secretary of Energy, also appointed by the president, the department also has three under secretaries, each appointed by the president, who oversee the major areas of the departments work. The president also appoints seven officials with the rank of Assistant Secretary of Energy who have line management responsibility for major elements of the Department. The Energy Secretary assigns their functions and duties. S.4 billion budget request for DOE for fiscal year 2010, including $2.3 billion for the DOE Office of Energy Efficiency and Renewable Energy. The budget aims to expand the use of renewable energy sources while improving energy transmission infrastructure. It also makes significant investments in hybrids and plug-in hybrids, in smart grid technologies, most of the stimulus spending was in the form of grants and contracts. The contractor guarantees the energy improvements will generate savings, and after the contract ends, in loan guarantees, a conditional commitment requires to meet an equity commitment, as well as other conditions, before the loan guarantee is completed. The DOE budget includes $280 million to fund eight Energy Innovation Hubs, yet another hub will develop smart materials that will allow the electrical grid to adapt and respond to changing conditions

2. Теннесси – Tennessee is a state located in the southeastern region of the United States. Tennessee is the 36th largest and the 17th most populous of the 50 United States, Tennessee is bordered by Kentucky and Virginia to the north, North Carolina to the east, Georgia, Alabama, and Mississippi to the south, and Arkansas and Missouri to the west. The Appalachian Mountains dominate the eastern part of the state, Tennessees capital and second largest city is Nashville, which has a population of 654,610. Memphis is the states largest city, with a population of 655,770, the state of Tennessee is rooted in the Watauga Association, a 1772 frontier pact generally regarded as the first constitutional government west of the Appalachians. What is now Tennessee was initially part of North Carolina, Tennessee was admitted to the Union as the 16th state on June 1,1796. Tennessee was the last state to leave the Union and join the Confederacy at the outbreak of the American Civil War in 1861, occupied by Union forces from 1862, it was the first state to be readmitted to the Union at the end of the war. Tennessee furnished more soldiers for the Confederate Army than any other state besides Virginia and this sharply reduced competition in politics in the state until after passage of civil rights legislation in the mid-20th century. This city was established to house the Manhattan Projects uranium enrichment facilities, helping to build the worlds first atomic bomb, Tennessees major industries include agriculture, manufacturing, and tourism. Poultry, soybeans, and cattle are the primary agricultural products, and major manufacturing exports include chemicals, transportation equipment. In the early 18th century, British traders encountered a Cherokee town named Tanasi in present-day Monroe County, the town was located on a river of the same name, and appears on maps as early as 1725. The meaning and origin of the word are uncertain, some accounts suggest it is a Cherokee modification of an earlier Yuchi word. It has been said to mean meeting place, winding river, according to ethnographer James Mooney, the name can not be analyzed and its meaning is lost. The modern spelling, Tennessee, is attributed to James Glen, the governor of South Carolina, the spelling was popularized by the publication of Henry Timberlakes Draught of the Cherokee Country in 1765. In 1788, North Carolina created Tennessee County, the county to be established in what is now Middle Tennessee. When a constitutional convention met in 1796 to organize a new out of the Southwest Territory. Other sources differ on the origin of the nickname, according to the Columbia Encyclopedia. Tennessee ties Missouri as the state bordering the most other states, the state is trisected by the Tennessee River. The highest point in the state is Clingmans Dome at 6,643 feet, Clingmans Dome, which lies on Tennessees eastern border, is the highest point on the Appalachian Trail, and is the third highest peak in the United States east of the Mississippi River

3. Nvidia Tesla – Nvidia Tesla is Nvidias brand name for their products targeting stream processing and/or general purpose GPU. Products use GPUs from the G80 series onward, the underlying Tesla microarchitecture of the GPUs and the Tesla product line are named after pioneering electrical engineer Nikola Tesla. With their very high computational power compared to microprocessors, the Tesla products target the high-performance computing market, as of 2012, Nvidia Teslas power some of the worlds fastest supercomputers, including Titan at Oak Ridge National Laboratory and Tianhe-1A, in Tianjin, China. For equivalent single precision output, Fermi-based Nvidia GeForce cards have four times less dual-precision performance, Tesla products primarily operate, in simulations and in large scale calculations for high-end image generation for applications in professional and scientific fields with the use of OpenCL or CUDA. Nvidia intends to offer ARMv8 processor cores embedded into future Tesla GPUs as part of Project Denver and this will be a 64-bit follow on to the 32-bit Tegra chips. The defense industry currently accounts for less than a sixth of Tesla sales,5 To calculate the processing power see Tesla #Performance, Fermi #Performance, Kepler #Performance, Maxwell #Performance, or Pascal #Performance. A number range specifies the minimum and maximum processing power at, respectively, multiple boost clocks are available, but this table lists the highest clock supported by each card. 8 Core architecture version according to the CUDA programming guide, for the basic specifications of Tesla, refer to the GPU Computing Processor specifications. Due to Teslas non-output nature, fillrate and graphics API compatibility are not applicable

4. Суперкомпьютер – A supercomputer is a computer with a high level of computing performance compared to a general-purpose computer. Performance of a supercomputer is measured in floating-point operations per second instead of instructions per second. As of 2015, there are supercomputers which can perform up to quadrillions of FLOPS and it tops the rankings in the TOP500 supercomputer list. Sunway TaihuLights emergence is also notable for its use of indigenous chips, as of June 2016, China, for the first time, had more computers on the TOP500 list than the United States. However, U. S. built computers held ten of the top 20 positions, in November 2016 the U. S. has five of the top 10, throughout their history, they have been essential in the field of cryptanalysis. The use of multi-core processors combined with centralization is an emerging trend, the history of supercomputing goes back to the 1960s, with the Atlas at the University of Manchester and a series of computers at Control Data Corporation, designed by Seymour Cray. These used innovative designs and parallelism to achieve superior computational peak performance, Cray left CDC in 1972 to form his own company, Cray Research. Four years after leaving CDC, Cray delivered the 80 MHz Cray 1 in 1976, the Cray-2 released in 1985 was an 8 processor liquid cooled computer and Fluorinert was pumped through it as it operated. It performed at 1.9 gigaflops and was the second fastest after M-13 supercomputer in Moscow. Fujitsus Numerical Wind Tunnel supercomputer used 166 vector processors to gain the top spot in 1994 with a speed of 1.7 gigaFLOPS per processor. The Hitachi SR2201 obtained a performance of 600 GFLOPS in 1996 by using 2048 processors connected via a fast three-dimensional crossbar network. The Intel Paragon could have 1000 to 4000 Intel i860 processors in various configurations, the Paragon was a MIMD machine which connected processors via a high speed two dimensional mesh, allowing processes to execute on separate nodes, communicating via the Message Passing Interface. Approaches to supercomputer architecture have taken dramatic turns since the earliest systems were introduced in the 1960s, early supercomputer architectures pioneered by Seymour Cray relied on compact innovative designs and local parallelism to achieve superior computational peak performance. However, in time the demand for increased computational power ushered in the age of massively parallel systems, supercomputers of the 21st century can use over 100,000 processors connected by fast connections. The Connection Machine CM-5 supercomputer is a parallel processing computer capable of many billions of arithmetic operations per second. Throughout the decades, the management of heat density has remained a key issue for most centralized supercomputers, the large amount of heat generated by a system may also have other effects, e. g. reducing the lifetime of other system components. There have been diverse approaches to management, from pumping Fluorinert through the system. Systems with a number of processors generally take one of two paths

5. Cray – Cray Inc. is an American supercomputer manufacturer headquartered in Seattle, Washington. It also manufactures systems for storage and analytics. Several Cray supercomputer systems are listed in the TOP500, which ranks the most powerful supercomputers in the world, the number of Cray systems on the list varies from year to year. Cray manufactures its products in Chippewa Falls, Wisconsin, where its founder, Seymour Cray, was born, the company also has offices in St. Paul, Minnesota, and numerous other sales, service, engineering, and R&D locations around the world. The companys predecessor, Cray Research, Inc. was founded in 1972 by computer designer Seymour Cray, Seymour Cray went on to form the spin-off Cray Computer Corporation, in 1989, which went bankrupt in 1995, while Cray Research was bought by SGI the next year. Cray Inc. was formed in 2000 when Tera Computer Company purchased the Cray Research Inc. business from SGI, Seymour Cray began working in the computing field in 1950 when he joined Engineering Research Associates in Saint Paul, Minnesota. There, he helped to create the ERA1103, ERA eventually became part of UNIVAC, and began to be phased out. He left the company in 1960, a few years after former ERA employees set up Control Data Corporation and he initially worked out of the CDC headquarters in Minneapolis, but grew upset by constant interruptions by managers. He eventually set up a lab at his town in Chippewa Falls, Wisconsin. Cray had a string of successes at CDC, including the CDC6600, copying the previous arrangement, Cray kept the research and development facilities in Chippewa Falls, and the business headquarters in Minneapolis. The companys first product, the Cray-1 supercomputer, was a success because it was faster than all other computers at the time. The first system was sold within a month for US$8.8 million, Seymour Cray continued working, this time on the Cray-2, though it only ended up being marginally faster than the Cray X-MP, developed by another team at the company. Cray soon left the CEO position to become an independent contractor, however, the changing political climate resulted in poor sales prospects. Ultimately, only one Cray-3 was delivered, and a number of designs were never completed. The company filed for bankruptcy in 1995, cCCs remains then began Crays final corporation, SRC Computers, Inc. which still exists. Cray Research continued development along a line of computers, originally with lead designer Steve Chen. The uncertainty of the Cray-2 project gave rise to a number of Cray-object-code compatible Crayette firms, Scientific Computer Systems, American Supercomputer, Supertek, most sites with a Cray installation were considered a member of the exclusive club of Cray operators. Cray computers were considered quite prestigious because Crays were extremely expensive machines, new vendors introduced small supercomputers, known as minisupercomputers during the late 1980s and early 1990s, which out-competed low-end Cray machines in the market

6. Jaguar (суперкомпьютер) – Jaguar was a petascale supercomputer built by Cray at Oak Ridge National Laboratory in Oak Ridge, Tennessee. The massively parallel Jaguar had a performance of just over 1,750 teraFLOPS. It had 224,256 x86-based AMD Opteron processor cores, Jaguar was a Cray XT5 system, a development from the Cray XT4 supercomputer. In both November 2009 and June 2010, TOP500, the semiannual list of the worlds top 500 supercomputers, the November 2010 TOP500 list confirmed the new rankings. In 2012 the Cray XT5 Jaguar was upgraded to the Cray XK7 Titan hybrid supercomputing system by adding the Gemini network interconnect, the Jaguar system has been through a series of upgrades since installation as a 25-teraFLOPS Cray XT3 in 2005. By early 2008, Jaguar was a 263-teraFLOPS Cray XT4, in 2008, Jaguar was expanded with the addition of a 1. 4-petaFLOPS Cray XT5. The XT4 and XT5 parts of Jaguar are combined into a system using an InfiniBand network that links each piece to the Spider file system. Jaguars XT5 partition contains 18,688 compute nodes in addition to dedicated login/service nodes, each XT5 compute node contains dual hex-core AMD Opteron 2435 processors and 16 GB of memory. Jaguars XT4 partition contains 7,832 compute nodes in addition to dedicated login/service nodes, each XT4 compute node contains a quad-core AMD Opteron 1354 processor and 8 GB of memory. Total combined memory amounts to over 360 terabytes, Jaguar uses an external Lustre file system called Spider for all file storage. The file system read/write benchmark is 240 GB/s, and it provides over 10 petabytes of storage, hundreds of applications have been ported to run on the Cray XT series, many of which have been scaled up to run on 20,000 to 150,000 processor cores. Computer science Computing Jaguar, The Worlds Most Powerful Computer

7. Cray XK7 – XK7 is a supercomputing platform, produced by Cray, launched on October 29,2012. Laboratories that host XK7 machines host workshops to train researchers in the new programming languages needed for XK7 machines, the platform is used in Titan, the worlds second fastest supercomputer in the November 2013 list as ranked by the TOP500 organization. Other customers include the Swiss National Supercomputing Centre which has a 272 node machine and Blue Waters has a machine that has Cray XE6, XK7 is scalable up to 500 cabinets, each contains 24 blades and each blade contains 4 nodes. The CPUs available are of the 16-core AMD Opteron 6200 Interlagos series, each CPU can be paired with either 16 or 32 GB of error-correcting code memory while the GPUs have either 5 or 6 GB of ECC memory depending on the model of GPU used. The nodes communicate with each other via the Gemini Interconnect, each Gemini chip services 2 nodes with a capacity of 160 GB/s. Depending on the used, a full cabinet will consume between 45 and 54.1 kW of electricity which is converted into heat, thus the cabinets need cooling. XK7 based machines run the Cray Linux Environment which incorporates SUSE Linux Enterprise Server, code to run on an XK7 machine can be written in a range of programming languages. The XK7 platform was announced on October 29,2012 to coincide with the completion of Titan at Oak Ridge National Laboratory, Titan has 18,688 XK7 nodes, each containing an Opteron 6274 CPU with 32 GB of memory and a K20X GPU with 6 GB. Titan uses 8.2 MW of electricity and is third on the Green500 list which ranks supercomputers by their energy efficiency, the National Center for Supercomputing Applications in Illinois has a machine, Blue Waters, using a combination of Cray XE6 and XK7 nodes. The machine has 3072 XK7 nodes and 22,752 XE6 nodes, each XE6 node has two Opteron 6276 and 32 GB of memory per CPU. The XK7 nodes also have Opteron 6276 CPUs with 32 GB of memory, the Swiss National Supercomputing Centre machine named Todi was upgraded to XK7 on October 22,2012. Todi has 272 nodes with Opteron 6272 CPUs with 32 GB of memory, Todi has a theoretical peak performance of 393 teraFLOPS and performed at 274 teraFLOPS in the November 2012 TOP500 list taking 91st place. Todi consumes 122 kW and is ranked fourth, one behind Titan, on the November 2012 Green500 list

8. Opteron – Opteron is AMDs x86 server and workstation processor line, and was the first processor which supported the AMD64 instruction set architecture. It was released on April 22,2003 with the SledgeHammer core and was intended to compete in the server and workstation markets, processors based on the AMD K10 microarchitecture were announced on September 10,2007 featuring a new quad-core configuration. The most-recently released Opteron CPUs are the Piledriver-based Opteron 4300 and 6300 series processors, codenamed Seoul, in January 2016, the first ARMv8-A based Opteron SoC was released. The second capability, by itself, is noteworthy, as major RISC architectures have been 64-bit for many years. The Opteron processor possesses an integrated memory controller supporting DDR SDRAM and this both reduces the latency penalty for accessing the main RAM and eliminates the need for a separate northbridge chip. In multi-processor systems, the CPUs communicate using the Direct Connect Architecture over high-speed HyperTransport links, each CPU can access the main memory of another processor, transparent to the programmer. The Opteron approach to multi-processing is not the same as symmetric multiprocessing, instead of having one bank of memory for all CPUs. Thus the Opteron is a Non-Uniform Memory Access architecture, the Opteron CPU directly supports up to an 8-way configuration, which can be found in mid-level servers. Enterprise-level servers use additional routing chips to support more than 8 CPUs per box, in particular, the Opterons integrated memory controller allows the CPU to access local RAM very quickly. In contrast, multiprocessor Xeon system CPUs share only two buses for both processor-processor and processor-memory communication. As the number of CPUs increases in a typical Xeon system, Intel is migrating to a memory architecture similar to the Opterons for the Intel Core i7 family of processors and their Xeon derivatives. In April 2005, AMD introduced its first multi-core Opterons, at the time, AMDs use of the term multi-core in practice meant dual-core, each physical Opteron chip contained two processor cores. This effectively doubled the performance available to each motherboard processor socket. One socket could then deliver the performance of two processors, two sockets could deliver the performance of four processors, and so on, because motherboard costs increase dramatically as the number of CPU sockets increase, multicore CPUs enable a multiprocessing system to be built at lower cost. AMDs model number scheme has changed somewhat in light of its new multicore lineup, at the time of its introduction, AMDs fastest multicore Opteron was the model 875, with two cores running at 2.2 GHz each. AMDs fastest single-core Opteron at this time was the model 252, for multithreaded applications, or many single threaded applications, the model 875 would be much faster than the model 252. Second-generation Opterons are offered in three series, the 1000 Series, the 2000 Series, and the 8000 Series, the 1000 Series uses the AM2 socket. The 2000 Series and 8000 Series use Socket F. AMD announced its third-generation quad-core Opteron chips on September 10,2007 with hardware vendors announcing servers in the following month, based on a core design codenamed Barcelona, new power and thermal management techniques were planned for the chips

9. PC Magazine – PC Magazine is an American computer magazine published by Ziff Davis. A print edition was published from 1982 to January 2009, publication of online editions started in late 1994 and continues to this day. In an early review of the new IBM PC, Byte reported the announcement of a new magazine called PC and it is published by David Bunnell, of Software Communications, Inc. It should be of great interest to owners of the IBM Personal Computer, the first issue of PC, dated February–March 1982, appeared early that year. PC Magazine was created by Bunnell and Cheryl Woodard, who also helped David found the subsequent PC World and Macworld magazines, eddie Currie and Tony Gold, a co-founder of Lifeboat Associates who financed the magazine, were early investors in PC Magazine. The magazine grew beyond the required to publish it, and to solve this problem, Gold sold the magazine to Ziff-Davis who moved it to New York City. Bunnell and his left to form PC World magazine. By its third issue PC was square-bound because it was too thick for saddle-stitch, at first the magazine published new issues every two months, but became monthly as of the August 1982 issue, its fourth. In March 1983 a reader urged the magazine to consider switching to a biweekly schedule because of its thickness, although the magazine replied to the readers proposal with Please say youre kidding about the bi-weekly schedue. After the December 1983 issue reached 800 pages in size, in 1984 PC began publishing new issues every two weeks, with each about 400 pages in size, in January 2008 the magazine dropped back to monthly issues. Print circulation peaked at 1.2 million in the late 1990s, in November 2008 it was announced that the print edition would be discontinued as of the January 2009 issue, but the online version at pcmag. com would continue. By this time print circulation had declined to about 600,000, dan Costa is the current editor-in-chief of PCMag. com, the website of the now-folded magazine. Prior to this position, Costa was executive editor under the previous editor-in-chief, Ulanoff held the position of editor-in-chief from July 2007 to July 2011, the last print edition of the magazine appeared in January 2009, although Ulanoff continued on with the website PCMag. com. Jim Louderback had held this position of editor-in-chief before Ulanoff, from 2005, and left when he accepted the position of executive officer of Revision3. Editor Bill Machrone wrote in 1985 that weve distilled the contents of PC Magazine down to the point where it can be expressed as a formula, EP stands for evaluating products and enhancing productivity. If an article doesnt do one or the other, chances are it doesnt belong in PC Magazine, PC Magazine provides reviews and previews of the latest hardware and software for the information technology professional. Articles are written by leading experts including John C, dvorak, whose regular column and Inside Track feature are among the magazines most popular attractions. The magazine has evolved significantly over the years and this is also the primary reason for the November 2008 decision to discontinue the print version

wikivisually.com

Титан – как устроен самый быстрый в мире компьютер

16 ноября 2012 года завершилась проходившая в Солт-Лейк-Сити двадцать пятая конференция по высокопроизводительным вычислениям Supercomputing 2012 (SC12). Обсуждаемые в отрасли изменения нашли отражение в обновлённом рейтинге суперкомпьютеров TOP500. Вновь изменилась расстановка сил, и укрепились наметившиеся в июне тенденции.

Пять мест в десятке лидеров (включая первые два) и 251 суперкомпьютер среди пятисот самых быстрых в мире установлены в США. Второе место по числу высокопроизводительных систем (72 из топовых 500) занял Китай, сместив Японию на третье место.

Основной вклад в вычислительную мощь Европы примерно в равных долях вносят Великобритания, Франция и Германия. На их территории расположены 65 из 500 лучших суперкомпьютеров.

Победители TOP500

За прошедшие пять месяцев список претерпел существенные изменения, что лишний раз демонстрирует скорость развития данной отрасли. Прежний лидер – система Sequoia Ливерморской национальной лаборатории имени Лоуренса, покорившая в июне планку в 16,32 петафлопс, оказалась на втором месте.

Суперкомпьютер IBM Sequoia (BlueGene/Q) - второе место в ноябрьском рейтинге TOP500 2012 (фото: IBM)

На третьем месте с результатом 10.51 петафлопс в бенчмарке LINPACK находится созданный компанией Fujitsu японский суперкомпьютер K Computer, установленный в Институте физико-химических исследований RIKEN (г. Кобе).

Суперкомпьютер Fujitsu K Computer - третье место (фото: Fujitsu)

Пятое и шестое место принадлежат Германии. Разработанные в IBM суперкомпьютеры JUQUEEN (самый быстрый в Европе) и SuperMUC продемонстрировали производительность на уровне 4,14 и и 2.89 петафлопс соответственно.

Китайский суперкомпьютер Tianhe-1A, созданный в оборонном научно-техническом университете города Тяньцзинь, переместился на восьмое место рейтинга с результатом 2,57 петафлопс.

Суперкомпьютер Tianhe-1A (фото: National Supercomputing Center of Tianjin)

Девятое место занимает итальянский Fermi (1,73 петафлопс), а десятое – DARPA Trial Subset (1,52 петафлопс).

Самый быстрый российский суперкомпьютер «Ломоносов», принадлежащий МГУ, оказался на 26 месте с результатом 0,9 петафлопс.

Суперкомпьютер "Ломоносов" (фото: "Т-Платформы")

Возглавляющий список Titan (Cray XK7) расположен в Национальной Лаборатории Окриджа – ведущем вычислительном центре министерства энергетики США. Он стал не просто самым быстрым суперкомпьютером. Его архитектура и оригинальные технические решения заслуживают самого пристального внимания.

Titan

«Титан» состоит из 18 688 вычислительных узлов. Каждый узел включает в себя 16-ядерный процессор AMD Opteron 6274/6276 с четырёхканальным контроллером оперативной памяти, 32 ГБ ОЗУ DDR3 (registered ECC) и главный козырь – графический ускоритель NVIDIA Tesla K20X с 2688 ядрами CUDA и 6 ГБ собственной памяти GDDR5.

Суперкомпьютер Titan (Cray XK7) - лидер ноябрьского рейтинга TOP500 2012 (фото: Oak Ridge National Laboratory)

Вычислительные узлы «Титана» объединяются по 8 штук в блоки и далее соединяются в отдельно стоящие модули при помощи сетевого интерфейса Gemini с пропускной способностью 160 ГБ/с на чип.

Вычислительный блок суперкомпьютера Titan (фото: Oak Ridge National Laboratory)

Внешне модули напоминают стандартные 19” шкафы 42U, однако фактические размеры одного модуля составляют 236 x 144 x 57 см, а масса – около 725 кг без учёта системы водяного охлаждения. На момент составления рейтинга «Титан» состоял из 208 таких модулей. Пиковая потребляемая мощность одного модуля составляет немногим более 54 кВт.

В сумме 18688 узлов обеспечивают 299008 ядер архитектуры x86 с частотой 2,2 – 3,2 ГГц и 50 233 344 ядер CUDA в 261 632 SMX блоках. В качестве общего количества вычислительных ядер суперкомпьютера Titan указывается сумма всех ядер архитектуры x86 и SMX блоков – 560 640.

Используемые процессоры AMD серии Opteron 6200 (Interlagos) стали первым серверным решением на базе архитектуры Bulldozer с энергоэффективностью 4,375 Вт на ядро.

Последнее обстоятельство и применение графических ускорителей позволило «Титану» занять также третье место в рейтинге Green500. Помимо статуса самого быстрого он стал ещё и одним из самых энергоэффективных суперкомпьютеров с результатом 2142,77 мегафлопс на Ватт потребляемой энергии.

По разным оценкам ускорители Nvidia обеспечивают порядка 85% – 90% всей вычислительной мощности. Отказ от них в пользу наращивания числа процессоров потребовал бы увеличения занимаемой площади примерно в 4 раза и во столько же увеличил бы энергопотребление. Использование графических ускорителей прочно «вошло в моду», что хорошо заметно на графике ниже.

Динамика роста использования графических ускорителей (фото: Nvidia)

Сейчас «Титану» требуется для размещения 404 квадратных метра, а усреднённое значение его потребляемой мощности составляет 8,2 МВт.

Разработка «Титана» не велась с нуля. Он был создан в процессе обновления предыдущего суперкомпьютера – Jaguar (Cray XT5). В 2008 году «Ягуар» стал первым компьютером, преодолевшим рубеж в 1 петафлопс, а в 2009 году возглавил список TOP500.

Модернизация «Ягуара» и его превращение в «Титана» заняла около года. Помимо добавления графических ускорителей Nvidia Tesla K20 она включала установку оперативной памяти суммарным объёмом 710 144 ГБ.

По оценкам Cray, дальнейшая модернизация и масштабирование позволит ей наращивать производительность до 50 петафлопс, удерживая престиж лидера ценой минимально возможных вложений.

Работает «Титан» в программной среде Cray Linux Environment на основе SUSE Linux Enterprise Server 11. Примечательно, что он открыт для свободных научных исследований. С его помощью учёные надеются значительно ускорить процессы моделирования и визуализации в самых разных областях, включая астрономию, геологию, океанологию, квантовую химию, физику элементарных частиц, генетику и многие другие.

lab201.jimdo.com

Titan (суперкомпьютер) — ВиКи

История

Осенью 2012 года начался последний этап модернизации Jaguar’а до более мощного суперкомпьютера, которому дано новое название Titan.

Львиную долю компьютерного времени Titan’а планировалось отдать под приложения государственной программы Министерства энергетики США под названием «Innovative and Novel Computational Impact on Theory and Experiment program» (INCITE)[7]. В течение предшествующих двух лет исследователи и программисты переписывали свои приложения под новую архитектуру Titan’а, чтобы начать его использование с первых же дней введения его в строй.

Суперкомпьютер Titan планируется заменить новым суперкомпьютером Summit, постройку которого IBM планирует завершить в середине 2018 года. Предполагается, что Titan проработает еще один год после ввода в строй суперкомпьютера Summit, а потом будет демонтирован.[8]

Архитектура и устройство

Применение

Львиная доля компьютерного времени Titan-а будет отдана под приложения государственной программы Министерства энергетики США под названием «Innovative and Novel Computational Impact on Theory and Experiment program» (INCITE)[7].

Несмотря на то, что Titan можно использовать для любого проекта, количество заявок превысило имеющееся компьютерное время. Поэтому было решено провести тщательный отбор. В 2009 году Oak Ridge Computing Leadership Facility (OCLF) рассмотрел 50 заявок и сузил список до 6 проектов, которые были выбраны не только из-за важности исследовательских тем, но и из-за способности программного обеспечения проектов как можно полнее использовать возможности гибридной системы.[9] Программный код этих проектов пришлось изменить так, чтобы он мог исполняться на графических процессорах Titan-а, при этом требовалось оставить возможность исполнения кода на обычных процессорах, чтобы он не был привязан исключительно к Titan-у.[9]. В течение двух лет исследователи и программисты переписывали свои приложения, чтобы начать его использование с первых же дней введения Titan-а в строй.

Первыми проектами, которые получат доступ к Titan-у являются:

- Процессы сгорания топлива: С помощью приложения S3D исследователи могут смоделировать турбулентное сгорание различных видов и составов топлива. Результаты исследований позволят создавать высокоэффективные, экономичные, оптимальные двигательные системы, почти не загрязняющие окружающую среду.[9]

- Наука о материалах: С помощью приложения WL-LSMS исследователи смогут находить и создавать новые материалы, исследуя их магнитные свойства при разных температурах на нано-уровне. Результаты исследований позволят создавать новые электродвигатели и электрогенераторы.

- Атомная энергия: С помощью приложения Denovo исследователи смогут моделировать поведение нейтронов в ядерном реакторе. Результаты исследований позволят выяснить, как более эффективно использовать стареющие ядерные реакторы США при сохранении их безопасности. На Titan-е приложение Denovo смоделирует за 13 часов один полный цикл службы стержня ядерного топлива, в то время как на Jaguar-е на это требовалось 60 часов.

- Изменения климата: Программа Community Atmosphere Model-Spectral Element (CAM-SE) симулирует долгосрочные глобальные изменения климата. Результаты вычислений позволят исследователям вычислить качество воздуха в ближайшем будущем, а также влияние его состава на климат. Titan позволяет за один день компьютерного времени сделать прогноз на 1—5 лет вперёд, в то время как на Jaguar за один день можно было вычислить прогноз только на 3 месяца.

Примечания

- ↑ Feldman, Michael Titan Sets High Water Mark for GPU Supercomputing. HPC Wire (October 29, 2012). Проверено 30 октября 2012. Архивировано 8 января 2013 года.

- ↑ Lal Shimpi, Anand Inside the Titan Supercomputer. Anandtech (October 31, 2012). Проверено 2 ноября 2012. Архивировано 8 января 2013 года.

- ↑ Feldman, Michael GPUs Will Morph ORNL's Jaguar Into 20-Petaflop Titan. HPC Wire (October 11, 2011). Проверено 29 октября 2012. Архивировано 8 января 2013 года.

- ↑ Oak Ridge changes Jaguar’s spots from CPUs to GPUs by Timothy Prickett Morgan, The Register Oct 11, 2011 [1]

- ↑ Poeter, Damon Cray's Titan Supercomputer for ORNL Could Be World's Fastest. PC Magazine (October 11, 2011). Проверено 29 октября 2012. Архивировано 8 января 2013 года.

- ↑ Tibken, Shara Titan supercomputer debuts for open scientific research. CNET (October 29, 2012). Проверено 29 октября 2012. Архивировано 8 января 2013 года.

- ↑ 1 2 Пресс-релиз Лаборатории о суперкомпьютре Titan ORNL Debuts Titan Supercomputer

- ↑ With the Summit Supercomputer, U.S. Could Retake Computing’s Top Spot

- ↑ 1 2 3 TITAN: Built for Science. Oak Ridge Leadership Computing Facility. Проверено 29 октября 2012. Архивировано 8 января 2013 года.

См. также

Ссылки

xn--b1aeclack5b4j.xn--j1aef.xn--p1ai