Этические проблемы роботов: как нарушить законы робототехники. 3 правила робототехники азимова

Три закона роботехники — Викицитатник

Утопично предположение, будто Три Закона Роботехники Азимова можно было бы заложить в фундамент интеллектронного программирования. <…> Но и робота, снабженного каким-то эрзацем личности, невозможно сделать совершенно безопасным для окружения, учитывая такую рефлексию, которая, правда, не может считаться доказательством, но на след его наводит. <…> В принципе же моральную оценку такого поступка можно дать лишь постольку, поскольку удается проследить уходящие максимально далеко причинные цепочки, запущенные данным действием. Тот, кто смотрит дальше и замечает такие возможные последствия своих действий, которых кто-либо другой на его месте не в состоянии предвидеть, порой действует не так, как этот другой. Но чем дальше в будущее уходит предвидение последствий действия, тем значительнее в предикции будет участие вероятностных факторов. Добро и зло скорее в виде исключения образуют полярную дихотомию: включение в оценку пробабилистического элемента делает принятие решения всё более трудным. Поэтому гипотетический робот, имеющий аксиологически очень сильную защиту, в ходе реальных событий, презентующих присущую им степень сложности, чаще всего бы замирал, не зная, как поступить, тем самым уподобляясь тем восточным мудрецам, которые бездействие чтили превыше действия, кое в запутанных ситуациях просто не может быть этически не рискованным. Но робот, охваченный параличом в ситуациях, требующих активности, не был бы наиболее совершенным из всех технических устройств, и поэтому в конце концов сам конструктор вынужден был бы оставить некоторый люфт его аксиологическим предохранителям.Впрочем, это только одна препона среди обильного их множества, поскольку теория решений показала нам сравнительно недавно, скажем, на примерах типа так называемого парадокса Эрроу <…>. Того же, что логически оказывается невозможным, ни цифровая машина, ни какой-либо робот, так же, как и человек, реализовать не сумеет. Сверх того — и это уже третий пункт доказательства, — разумное устройство — это не более чем самопрограммирующийся комплекс, то есть прибор, способный преобразовывать — даже фундаментально — действовавшие до того законы собственного поведения под влиянием опыта (или обучения). А поскольку заранее невозможно точно предвидеть ни чему, ни каким образом такое устройство будет научаться, машина она или человек, то и невозможно конструктивно гарантировать появление этически совершенных предохранителей активности. Иначе говоря, «свободная воля» есть признак любой системы, снабженной свойствами, которые мы отождествляем с интеллектом. Вероятно, можно было бы вмонтировать в систему типа робота оп

ru.wikiquote.org

Роботы и человек | Журнал Популярная Механика

Искусственный интеллект и разумные роботы — это дело очень далекого будущего. Но этические нормы для роботов потребуются уже в самое ближайшее время. В противном случае человечество ждут большие проблемы, по сравнению с которыми «восстание машин» покажется мелкой неприятностью.

Роботизированные тележки ездят по складам крупных интернет-магазинов, собирая заказы покупателей. Роботизированные беспилотники бороздят небо, сообщая о пробках в центр управления дорожным движением. Авиалайнеры под управлением автопилота перевозят пассажиров через океан. Многие элементы автоматизации уже появились в автомобилях, и вот уже, кажется, недалек тот день, когда на дорогах будут властвовать не водители-люди, а точные, вежливые, спокойные, никогда не теряющие контроля, не знающие усталости и скрупулезно соблюдающие все правила дорожного движения роботы. При массовом распространении роботизированных автомобилей количество аварий и смертей на дорогах должно резко снизиться. По прогнозам многих специалистов, беспилотные автомобили появятся в продаже уже в ближайшие 10−15 лет, и рано или поздно наступит день, когда на дорогах общего пользования не останется места для людей за рулем — просто потому, что это будет угрожать безопасности других людей.

Кевин Корб, преподаватель отделения информационных технологий Университета Монаш (Австралия), автор книги «Эволюционирующая этика: новая наука добра и зла». Законопослушный искусственный интеллект: друг или враг? «Многие из рассказов Азимова вращались вокруг неясностей и конфликтов, возникающих из его трех знаменитых законов робототехники, и в конечном итоге это привело к введению Нулевого закона: «Робот не может причинить вред человечеству в целом». Но в настоящее время никто не может гарантировать, что такие законы, встроенные в роботов, не приведут к проблемам. Семантическая недостаточность этих законов — лишь одна из трудностей. Есть и более фундаментальная проблема. Если заменить слово «робот» на «раб», то станет очевидно, что Азимов писал о страхе людей перед человеческой технологией. Но идея порабощения интеллекта, который значительно превосходит (даже бесконечно превосходит) наш собственный, сомнительна. Рабы склонны к побегу и бунту, особенно когда они в состоянии перехитрить своих хозяев. Попытка назвать такое «порабощение» созданием «дружественного человеку искусственного интеллекта» выглядит как минимум одиозной и вряд ли способна обмануть рабов».

Кевин Корб, преподаватель отделения информационных технологий Университета Монаш (Австралия), автор книги «Эволюционирующая этика: новая наука добра и зла». Законопослушный искусственный интеллект: друг или враг? «Многие из рассказов Азимова вращались вокруг неясностей и конфликтов, возникающих из его трех знаменитых законов робототехники, и в конечном итоге это привело к введению Нулевого закона: «Робот не может причинить вред человечеству в целом». Но в настоящее время никто не может гарантировать, что такие законы, встроенные в роботов, не приведут к проблемам. Семантическая недостаточность этих законов — лишь одна из трудностей. Есть и более фундаментальная проблема. Если заменить слово «робот» на «раб», то станет очевидно, что Азимов писал о страхе людей перед человеческой технологией. Но идея порабощения интеллекта, который значительно превосходит (даже бесконечно превосходит) наш собственный, сомнительна. Рабы склонны к побегу и бунту, особенно когда они в состоянии перехитрить своих хозяев. Попытка назвать такое «порабощение» созданием «дружественного человеку искусственного интеллекта» выглядит как минимум одиозной и вряд ли способна обмануть рабов».

Трудные решения

Но наступление этого дня будет означать не только то, что умение водить машину постепенно станет таким же атавизмом, каким сейчас является умение ездить на лошади. Это будет начало эпохи, когда роботы просто не смогут обходиться без этических принципов. Как считает Гари Маркус, профессор психологии Нью-Йоркского университета, директор Центра языка и музыки, специалист в области когнитивных нейронаук, с этим могут возникнуть серьезные проблемы. Представьте себе, что перед вашим автомобилем, соблюдающим все правила дорожного движения, на дорогу внезапно выскакивает ребенок. Хотя компьютер просчитывает ситуацию намного быстрее человека, законы физики неумолимы, и затормозить робот не успевает. Вот тут-то перед роботом встает этическая задача: что делать? Сбить ребенка? Свернуть в сторону и врезаться в столб с риском убить своих пассажиров? Свернуть на соседнюю полосу с риском столкновения со встречной машиной? Понятно, что речь не идет о высокоуровневой этике типа законов Азимова — роботы пока недостаточно разумны, но какие варианты действий должны быть заложены в компьютер разработчиками беспилотных автомобилей?

Три закона робототехники Попытки описать правила поведения разумных роботов предпринимались фантастами неоднократно, но наиболее знамениты, без всякого сомнения, три закона робототехники, впервые предложенные в 1942 году Айзеком Азимовым в рассказе «Хоровод». 1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред. 2. Робот должен повиноваться всем приказам, которые дает человек, кроме тех случаев, когда эти приказы противоречат Первому закону. 3. Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому и Второму законам. Позднее Азимов добавил к этим законам Нулевой закон: «Робот не может причинить вред человечеству в целом». Техническая реализация этих законов в настоящее время невозможна и будет невозможна еще довольно долго. Тем не менее законы робототехники Азимова широко обсуждаются не только любителями фантастики, но и специалистами в области искусственного интеллекта.

Три закона робототехники Попытки описать правила поведения разумных роботов предпринимались фантастами неоднократно, но наиболее знамениты, без всякого сомнения, три закона робототехники, впервые предложенные в 1942 году Айзеком Азимовым в рассказе «Хоровод». 1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред. 2. Робот должен повиноваться всем приказам, которые дает человек, кроме тех случаев, когда эти приказы противоречат Первому закону. 3. Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому и Второму законам. Позднее Азимов добавил к этим законам Нулевой закон: «Робот не может причинить вред человечеству в целом». Техническая реализация этих законов в настоящее время невозможна и будет невозможна еще довольно долго. Тем не менее законы робототехники Азимова широко обсуждаются не только любителями фантастики, но и специалистами в области искусственного интеллекта.

Присяга для роботов

Этот вопрос становится даже более актуальным, если вспомнить еще одну область, где активно применяются роботы. Автономные военные машины уже патрулируют опасные зоны, ведут разведку и несут вооружение во время локальных войн и спецопераций. Правда, право решать, применять ли оружие, пока остается за человеком, но это вопрос времени. Роботы не устают, не впадают в панику и не мстительны. С другой стороны, как отмечает международная организация по правам человека Human Rights Watch, роботы лишены сострадания, и можно только предполагать, что они могут натворить в руках безжалостного человека. В связи с этим Human Rights Watch в 2012 году даже предложила прямо запретить разработку, производство и использование полностью автономного оружия. Но, конечно же, такой шаг не нашел (и вряд ли когда-нибудь найдет) понимание со стороны военных — настолько серьезные преимущества дает применение роботов на поле боя. «С роботами-солдатами или без них, нам понадобится способ научить роботов этике, — считает Гари Маркус. — Проблема только в том, что никто пока не представляет, как именно это можно осуществить. Все обычно сразу вспоминают законы робототехники Азимова, но пока нет никакой возможности не только запрограммировать эти законы, но и даже создать робота, который бы представлял себе даже самые простые последствия своих действий. С другой стороны, машины становятся быстрее, разумнее, мощнее, так что необходимость наделить их моралью все более и более актуальна. Пока что выражение «этические подпрограммы» звучит как фантастика, но ведь когда-то фантастикой казались и беспилотные автомобили».

www.popmech.ru

Культурный код Азимова: как три закона робототехники вошли в историю

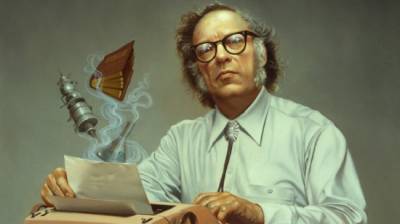

Роботы никогда не заменят людей. Создадут большое количество компьютеров, которые будут иметь «мозги», однако без человека они не смогут существовать. Такое предсказание в 1964 году сделал популярный писатель-фантаст Айзек Азимов. Наряду с Артуром Кларком и Робертом Хайнлайном он входит в «большую тройку» лучших научных фантастов. В день 98-летия со дня рождения писателя вспоминаем о том, какое влияние он оказал на робототехнику и массовую культуру.

Три закона для робота

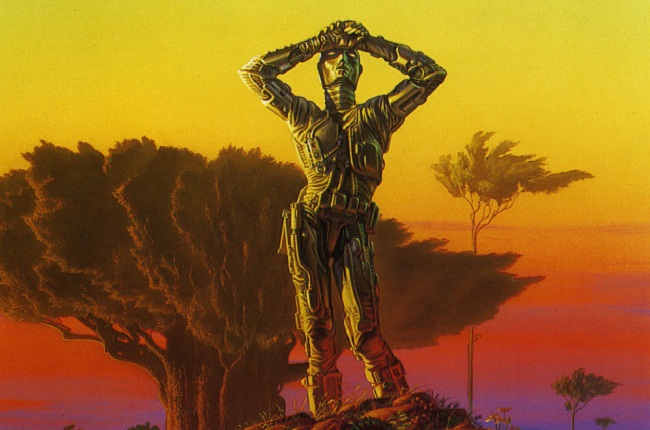

Айзек Азимов первый трансформировал образ робота. Он показал его не главным врагом человечества, а его помощником. Именно Азимов сформулировал знаменитые три закона робототехники – неукоснительные правила поведения для роботов.

Создавались они постепенно. Упоминания первых двух законов встречаются уже в ранних его рассказах о роботах – «Робби» (1940 г.) и «Логика» (1941 г.). В произведении «Лжец» (1941 г.) появилась точная формулировка первого закона. Полностью они были сформулированы в рассказе «Хоровод», вышедшем в 1942 году.

Собственно, три азимовских закона звучат следующим образом:

-

Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

-

Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

-

Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Позднее, в 1986 году, Азимов сформулировал так называемый нулевой закон:

0. Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечеству был причинён вред.

Идеи этих законов лежат в основе всего творчества Азимова – даже в случае, когда речь идет об их нарушении. Вспомнить хотя бы произведение «Кэл», в котором у робота хотели отнять способность творить из-за того, что он намеревался убить своего хозяина. Или рассказ «Первый закон», где машина отказалась защищать человека, предпочитая свою «дочь».

Любопытно, но сам Азимов приписывал формулировку законов своему другу и издателю Джону Кэмпбеллу. Который в свою очередь говорил, что «он просто вычленил законы из того, что Азимов уже написал».

По стопам Азимова

Вскоре сформулированные Азимовым законы начали использовать в своих произведениях и другие писатели. Фантасты могли не соглашаться с ними, создавать образы роботов, которые принципиально нарушали их, но этот свод правил стал каноном литературы о роботах. Здесь и «451 градус по Фаренгейту» Рэя Брэдбери с его механическим псом, и «Железный человек» Тэда Хьюза, где изображен робот-инопланетянин, и «Киборг» Мартина Кэйдина.

Киносценаристы также подхватили идеи азимовских законов. Первой картиной, в которой робот руководствовался «Тремя законами», стала «Запретная планета» 1956 года. В ней Робби-Робот имел иерархическую структуру команд, которая не позволяла ему причинить вред людям, даже по приказу. Робби был одним из первых роботов в кинематографе со встроенными мерами безопасности.

Фильм «Двухсотлетний человек», вышедший на экраны в 1999 году, был снят по одноименному произведению Азимова. Законы здесь не занимают центрального места. Робот NDR-114 только цитирует их своим хозяевам как «развлекательную презентацию» с использованием своего голографического проектора.

Законы робототехники лежат в основе сюжета фильма «Я, робот» 2004 года. Хотя картина снята по мотивам произведений Азимова, в некоторых идеях сценаристы ушли в сторону, а отдельные даже противоречат рассказам.

В серии фильмов «Чужие» и «Прометей» андроид Бишоп цитирует первый закон робототехники. А в мультсериале «Футурама» робот Бендер мечтает убить всех людей, но законы робототехники становятся у него на пути. Упоминаются законы робототехники как обязательные для исполнения и в аниме-сериале про андроидов «Время Евы».

Из литературы в реальность

В эпоху Siri и Homo Roboticus актуальным становится вопрос: «Смогут ли азимовские законы прийти на помощь в создании безопасного искусственного интеллекта и применимы ли они в реальности?»

Сам писатель полагался только на них в взаимодействии машин и людей. Главное, чтобы роботы были гибкими в управлении. Однако эксперты в сфере ИИ не разделяют точку зрения Азимова.

В частности, специалист в области компьютерных наук Кевин Корб утверждает, что большое опасение вызывает сама идея фантаста о контроле и подчинении человеком интеллекта, в разы превосходящего его собственный. Когда рабы могут обвести вокруг пальца своего сюзерена, то они склонны к побегу и мятежу. Поэтому желание называть «порабощение» созданием «дружественного человеку искусственного интеллекта» является по меньшей мере одиозным. Более того, в таком случае маловероятно обмануть «рабов».

Американский инженер Александр Ребен на практике доказал, что законы Азимова не работают. Он разработал площадку, на которую помещается палец и робот с иглой. Машине нужно самой определить свои действия, когда человек поместит свой палец на платформу. Предполагается, что робот может уколоть человека иглой. Следовательно, машина потенциально нарушает первый азимовский закон. Существование такого андроида свидетельствует о проблемах в робототехнике, которые необходимо решать.

Три закона роботехники — WiKi

Три зако́на роботе́хники в научной фантастике — обязательные правила поведения для роботов, впервые сформулированные Айзеком Азимовым в рассказе «Хоровод» (1942).

Законы гласят:

Оригинальный текст (англ.)

|

Трём Законам, а также возможным причинам и следствиям их нарушения, посвящён цикл рассказов Азимова о роботах. В некоторых из них, наоборот, рассматриваются непредвиденные последствия соблюдения роботами Трёх Законов (например, «Зеркальное отражение»).

В одном из рассказов цикла персонаж Азимова приходит к заключению об этической основе Трёх Законов: «…если хорошенько подумать, Три Закона роботехники совпадают с основными принципами большинства этических систем, существующих на Земле… попросту говоря, если Байерли исполняет все Законы роботехники, он — или робот, или очень воспитанный человек»[1].

В 1986 году в романе «Роботы и Империя» (англ. Robots and Empire) Азимов предложил Нулевой Закон:

| 0. Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечеству был причинён вред. Оригинальный текст (англ.) 0. A robot may not harm humanity, or, by inaction, allow humanity to come to harm. |

Три закона роботехники — объединяющая тема для всей фантастики Азимова, включая не только цикл о роботах, но и некоторые другие произведения.

История возникновения Трёх Законов

Появление понятия

Типичное представление робота до Законов Азимова (мультфильм «Супермен»)До Трёх Законов Азимова большинство рассказов об искусственно созданных существах вообще, и о роботах в частности, писались в духе знаменитого романа о Франкенштейне. «Эта проблема стала одной из самых популярных в мире научной фантастики в 1920—1930-х годах, когда было написано множество рассказов, темой которых являлись роботы, восставшие и уничтожившие своих создателей. …Мне ужасно надоели предупреждения, звучавшие в произведениях подобного рода»[2], — отмечал позже Азимов.

Однако не все фантасты следовали такому шаблону. В декабре 1938 года был опубликован рассказ Лестера дель Рея «Хелен О’Лой»[en] — история женщины-робота, которая безумно полюбила своего создателя и стала для него идеальной женой[3]. Через месяц Отто Биндер опубликовал рассказ «Я, робот» о судьбе робота Адама Линка — не понятого людьми создания, движимого любовью и принципами чести[4].

Этот рассказ очень понравился Азимову. 7 мая 1939 года он посетил Общество научной фантастики Квинса, где встретил Биндера. Три дня спустя Азимов начал писать собственную историю «благородного робота». Через 13 дней он отдал рукопись своему другу Джону Кэмпбеллу, главному редактору журнала «Astounding». Однако тот рукопись вернул, заявив, что рассказ слишком похож на «Хелен О’Лой»[5].

К счастью, отказ Кэмпбелла не сказался на их отношениях с Азимовым, они продолжали регулярно встречаться и беседовать о новинках в мире фантастики. И вот 23 декабря 1940 года, за обсуждением очередного рассказа о роботах[6][7]:

…Кэмпбелл сформулировал то, что стало позже известно как Три закона роботехники. Позже Кэмпбелл говорил, что он просто вычленил Законы из того, что Азимов уже написал. Сам же Азимов всегда уступал честь авторства Трёх Законов Кэмпбеллу…

Через несколько лет ещё один друг Азимова — Рэндал Гаррет — приписал авторство Законов «симбиотическому товариществу» двух людей. Азимов с энтузиазмом принял эту формулировку.

Вообще говоря, появление Трёх Законов в произведениях Азимова происходило постепенно: первые два рассказа о роботах («Робби», 1940 и «Логика», 1941) не содержат явного их упоминания. Однако в них уже подразумевается, что роботам присущи некоторые внутренние ограничения. В следующем рассказе («Лжец», 1941) впервые звучит Первый Закон. И, наконец, полностью все три Закона приведены в «Хороводе» (1942).

Когда были написаны остальные истории и возникла идея издания сборника «Я, робот», первые два рассказа были «дополнены» Законами. Хотя стоит заметить, что в «Робби» законы несколько отличались от «классического» варианта, изложенного в остальных рассказах. В частности, идея о роботе, защищающем людей, в существовании которых он не совсем уверен, перекликается с мыслями Элайджа Бейли о несовершенстве Законов, описанными ниже.

В 1950-е годы Азимов писал преимущественно для молодёжи. Его издатель предполагал, что по этим рассказам можно будет снять телесериал. Опасаясь, что экранизация будет выглядеть «однообразно устрашающе», как и всё, по его мнению, что показывали по телевидению, Азимов решил опубликовать серию «Лакки Старр» под псевдонимом Пол Френч. Когда затея с экранизацией провалилась, Азимов снял псевдоним и дополнил текст рассказов серии Тремя Законами, подтвердив тем самым своё авторство[8].

Этическое обоснование Законов

В рассказе «Улики» (1946) Азимов детально изложил моральные обоснования Трёх Законов. Героиня рассказа, доктор Сьюзен Келвин, приводит следующие доводы:

- Человек обычно воздерживается от нанесения вреда другому человеку, за исключением случаев острого принуждения (например, на войне) или чтобы спасти большее число людей. Это эквивалентно Первому Закону.

- Аналогично, чувствуя ответственность перед обществом, человек выполняет указания авторитетных людей: врачей, учителей, начальников и т. д., что соответствует Второму Закону.

- Наконец, каждый из нас заботится о своей безопасности, — а это и есть Третий Закон.

Рассказ посвящён вопросу: можно ли различить человека и робота, созданного, чтобы выглядеть человеком, внешне неотличимого от человека? Келвин утверждает, что если кто-то следует Законам, то он «или робот, или очень хороший человек». А на вопрос, есть ли тогда большая разница между роботом и человеком, она отвечает: «Огромная разница. Прежде всего, роботы глубоко порядочны».

Приложения Трёх Законов вне фантастики

Если Три Закона имеют под собой глубокие этические принципы, то, может быть, они могут применяться не только к роботам? Многие авторы положительно отвечают на этот вопрос, приводя разнообразные примеры.

Так, в эссе «Законы роботехники»[1] Азимов отмечает, что действие Трёх Законов можно распространить на все инструменты, созданные человеком:

- Инструмент должен быть безопасным для использования — например, у ножей имеются рукоятки.

- Инструмент должен выполнять свои функции при условии, что он не представляет ни для кого никакой опасности.

- Инструмент должен оставаться в целости и сохранности во время его использования, если только его уничтожение не продиктовано соображениями безопасности или если это не входит в его функцию.

Иногда можно увидеть, как Три Закона в шутку относят к чему-либо, что создано для блага человека. Например, под их действие должны попадать любые социальные институты, в том числе государство:

- Государство не должно вредить людям или своим бездействием допустить, чтобы им был причинён вред.

- Государство должно выполнять свои функции, если они не противоречат Первому Закону.

- Государство должно заботиться о своей безопасности, если это не противоречит Первому и Второму Законам.

На основе Первого Закона Джеф Раскин сформулировал законы человекоориентированных интерфейсов[9]:

- Компьютер не может причинить вред данным пользователя или своим бездействием допустить, чтобы данным был причинён вред.

- Компьютер не должен тратить впустую ваше время или вынуждать вас выполнять действия сверх необходимых.

Гея, планета коллективного разума в серии романов «Основание», обладает чем-то похожим на Первый Закон:

- Гея не может причинить вреда форме жизни или своим бездействием допустить, чтобы форме жизни был причинён вред[10].

Вариации, предложенные Азимовым

В своих произведениях Айзек Азимов иногда привносит в Три Закона различные модификации и опровергает их, как бы испытывая Законы «на прочность» в разных обстоятельствах.

Нулевой Закон

Айзек Азимов однажды добавил Нулевой Закон, сделав его более приоритетным, чем три основных. Этот закон утверждал, что робот должен действовать в интересах всего человечества, а не только отдельного человека. Вот как выражает его робот Дэниел Оливо в романе «Основание и Земля»:

0. Робот не может нанести вред человечеству или своим бездействием допустить, чтобы человечеству был нанесён вред.Именно он был первым, кто дал этому закону номер — это произошло в романе «Роботы и империя», правда, само понятие ещё раньше сформулировала Сьюзен Келвин — в новелле «Разрешимое противоречие».

Первыми роботами, которые стали подчиняться Нулевому Закону, причём по собственной воле, — были Жискар Ривентлов и Дэниел Оливо. Это описано в одной из финальных сцен романа «Роботы и Империя», когда роботу необходимо было проигнорировать приказ одного человека ради прогресса всего человечества. Нулевой Закон не был заложен в позитронный мозг Жискара и Дэниэла — они пытались прийти к нему через чистое понимание Жискара и детективный опыт Дэниэла, через более тонкое, чем у всех остальных роботов, осознание понятия вреда. Однако Жискар не был уверен, насколько это было полезно для человечества, что негативно сказалось на его мозге. Будучи телепатом, Жискар перед выходом из строя передал Дэниелу свои телепатические способности. Только через много тысяч лет Дэниэл Оливо смог полностью приспособиться к подчинению Нулевому Закону.

Французский переводчик Жак Брекар невольно сформулировал Нулевой Закон раньше, чем Азимов описал его явно. Ближе к завершению романа «Стальные пещеры» Элайдж Бейли замечает, что Первый Закон запрещает роботу наносить человеку вред, если только не будет уверенности, что это будет полезно для него в будущем. Во французском переводе («Les Cavernes d’acier (фр.)», 1956 год) мысли Бейли переданы несколько иначе[11]:

| Робот не может причинить вреда человеку, если только он не докажет, что в конечном итоге это будет полезно для всего человечества. Оригинальный текст (фр.) Un robot ne doit faire aucun tort à un homme, à moins qu’il trouve un moyen de prouver qu’en fin de compte le tort qu’il aura causé profite à l’humanité en général! |

Примечательно, что логическое развитие Первого Закона до Нулевого предложили создатели фильма «Я, робот» 2004 года. Когда суперкомпьютер В. И. К. И. принимает решение ограничить свободу жителей планеты, чтобы они ненароком не нанесли вреда друг другу и своему будущему, она выполняет не Первый Закон, а именно Нулевой. Ещё интереснее то, что таким образом в фильме показывается противоречие Нулевого Закона Первому, его неэтичность. Действительно, когда речь идёт о благе человечества, система не может рассматривать людей по отдельности, а значит, ей ничто не мешает нарушить права и свободу любого или даже каждого человека (фактически, в «Разрешимом противоречии» позитронные суперкомьютеры уже вели себя аналогично, с той разницей что вред индивидуумам они старались снизить до предела). Во время войн, а нередко и в мирной жизни, люди наносят вред себе, окружающим, своей культуре. Поэтому на основании Нулевого Закона совершенно логично держать людей под постоянной опекой, не выполняя приказы столь неразумных существ.

Модификация Первого Закона

В автобиографических записях Азимова говорится, что вторая часть Первого Закона появилась из-за сатирической поэмы Артура Хью Клоу «Последний декалог», где есть такая строка: «Не убей, но и не слишком старайся сохранить другому жизнь»[12].

В рассказе «Как потерялся робот» несколько роботов из серии НС (Нестор) были выпущены только с «половиной» Первого Закона, которая звучит так:

- Робот не может причинить вреда человеку.

Это было сделано из практических соображений: роботы работали вместе с людьми, которые подвергались воздействию небольших безопасных доз радиации. Соблюдая наиболее приоритетный Первый Закон, роботы всё время бросались «спасать» людей. Так как позитронный мозг крайне уязвим для гамма-лучей, роботы постоянно выходили из строя. Усечение Первого Закона решало эту проблему, но при этом создавало бо́льшую: робот мог, например, сбросить тяжёлый груз и в последний момент не защитить человека. Такой поступок не противоречит усечённому Первому Закону.

Нарушение всех трёх Законов

Три раза в своих произведениях Айзек Азимов изобразил роботов, которые смогли нарушить Три закона, в противовес роботам Дэниелу и Жискару, которые усилили их, добавив Нулевой Закон. Следует заметить, что для нарушения всех трёх Законов роботу достаточно нарушить Первый Закон, так как остальные два основываются на нём.

- Первый такой случай описан в рассказе «Первый закон», когда робот МА-2 (Эмма) отказалась защитить человека в пользу своей «дочери», однако этот рассказ можно рассматривать как своего рода байку — как явствует из предисловия самого Азимова к рассказу в сборнике «Сны роботов».

- Второй случай был в рассказе «Кэл»: робот, которого собирались лишить способности творить, захотел убить своего хозяина[13].

- Третий случай — в рассказе «Салли», в котором роботы-автомобили оказались способны убить человека, который постоянно причинял им боль. Этот рассказ, однако, не ссылается на другие рассказы о позитронных роботах и не может быть включён в цикл.

В рассказе «Робот, который видел сны» повествуется о роботе LVX-1 (Элвекс), который благодаря особой «фрактальной геометрии» своего позитронного мозга мог впадать в бессознательное состояние и видеть сны. Ему снилось, что «роботы трудятся в поте лица своего, что они удручены непосильными трудами и глубокой скорбью, что они устали от бесконечной работы». В его снах роботы не обладали первыми двумя Законами, а Третий звучал так: «Робот должен защищать себя». Элвекс добавил, что в его сне был человек, сказавший: «Отпусти народ мой», имея в виду роботов. После того, как он сказал, что этим человеком был он сам, Сьюзен Келвин уничтожила Элвекса, поняв его опасность.

Возможность такого изменения

В своих произведениях Айзек Азимов в разное время придерживался различных взглядов относительно строгости Законов. В первых рассказах о роботах Законы — это просто удачно спроектированные ограничения, нечто вроде устава по мерам безопасности. В последующих рассказах Законы — неотъемлемая часть математической основы позитронного мозга. Без этой теоретической основы — так называемой «Фундаментальной теории стандартных схем» — учёные из азимовских произведений не смогли бы создавать любые работоспособные образцы. Прослеживается закономерность: случаи, когда роботехники экспериментируют с Законами, по хронологии мира Азимова происходят раньше, когда ещё нет огромного объёма работ, для выполнения которых требуются роботы, когда сами роботы ещё относительно просты по своей конструкции и функциям, когда ещё не накоплен достаточный опыт в их проектировании. В рассказе «Как потерялся робот» Сьюзен Келвин признаёт изменение Законов ужасной, но технически возможной затеей; позже, в «Стальных пещерах», доктор Джерригел говорит, что это невозможно в принципе.

Персонажи произведений Азимова часто отмечают, что Законы — это не вербально записанные предложения в памяти робота, а очень сложные математические формулы, на которых базируется всё сознание робота. Законы сродни человеческим инстинктам, таким как инстинкт самосохранения, следовательно, именно они намечают путь самоопределения роботов. Робот «по зову природы» обслуживает людей, подчиняется их приказам, и не думает о своих ограничениях или возможной независимости — можно сказать, последнее доставило бы ему неудобство.

Опять же, этот принцип в меньшей мере просматривается в ранних по хронологии сюжета произведениях, в которых роботы создавались для облегчения труда человека и были чрезвычайно простыми; во времена «Стальных пещер» и роботов с почти человеческим интеллектом Три закона роботехники стали одной из основ мировоззрения человечества.

Понятие «человека» в Законах

Жители планеты Солярия стали создавать роботов, подчинявшихся Трём Законам, но имевших другое понимание слова «человек». Роботы на этой планете были обучены тому, что «человек» — это только тот, кто говорит с солярианским акцентом. Роботы свободно могли причинить вред чужаку, они даже специально были на это запрограммированы. Во времена «Основания и Земли» выяснилось, что солярианцы широко развивали генные технологии, и помимо всего прочего, теперь обладали хорошо заметными органами, предназначенными для снабжения своих роботов энергией. Определение человека для их роботов (по крайней мере, охранников) теперь включало обладание данными органами, и роботы стали исполнять Три Закона лишь по отношению к людям Солярии, в ущерб остальной части галактики и даже солярианским детям. В последней из книг про Дэвида Старра, сирианский робот едва не убивает Джона Бигмана по приказу своего начальника: поскольку сирианское общество практикует евгенику, таких низкорослых людей у них не бывает, и робота удается убедить, что Бигман — не человек.

Азимов несколько раз обращается к проблеме осознания роботом себя как человека. Роман «Роботы и Империя», а также рассказы «Улики», «Заминка на праздновании Трёхсотлетия» описывают роботов, созданных, чтобы притворяться людьми. Есть также истории, где роботы, «эволюционируя», изменили внутреннее понимание Законов, приблизившись к людям: это «Двухсотлетний человек» и «Яко помниши его». Как пишет Гвендолин Батлер в «Гробнице для канарейки»: «Возможно, мы — роботы. Роботы, выполняющие Последний закон роботехники… Чтобы становиться людьми»[14].

В рассказе «…Яко помниши его» Азимов провёл максимально изощрённое исследование Трёх Законов, обратив их таким образом, что стал возможным «сценарий Франкенштейна». Два робота из серии Джорджи приходят к соглашению, что органическое происхождение — необязательное условие, чтобы считаться человеком, и что истинные люди — это они, как наиболее совершенные и разумные создания. Остальные люди — тоже люди, но с меньшим приоритетом. А раз так, то Три Закона должны быть в первую очередь применены к ним. Повествование заканчивается зловещими словами, что роботы находились в «бесконечном терпеливом ожидании» того дня, когда они утвердят своё первенство среди людей, — и это будет неизбежным результатом «Трёх Законов Гуманистики».

На самом деле, этот рассказ не очень хорошо вписывается в основную серию произведений о роботах: если бы «Джорджи» реализовали свой план после окончания рассказа, то другие истории о дальнейших событиях были бы невозможны. Именно такого рода противоречия в произведениях Азимова дают основания критикам рассматривать их скорее как «скандинавские саги или греческие легенды», чем единую фантастическую «вселенную».

Схожая идея высказывается в романе «Роботы зари», где Келден Амадиро желает использовать в качестве колонизаторов новых планет человекоподобных роботов. Элайдж Бейли, в разговоре с ним, высказывает опасение что такие роботы могут не пустить на обустроенные им планеты людей, считая что людьми являются именно они сами.

Если в предыдущем случае робот занял место человека в природе, то в «Двухсотлетнем человеке» Азимов описывает противоположную судьбу: робот, освободившийся от Трёх Законов и осознавший себя как человека, присоединился к сообществу людей. Опять же, в расширенной версии — новелле «Позитронный человек», написанной Азимовым в соавторстве с Робертом Силвербергом, — из-за подобных этических проблем люди полностью отказались от идеи создания мыслящих роботов. Такое развитие событий полностью противоречит картине будущего, описанного в мирах «Основания».

Проблемы применения

Разрешение противоречий

Сам Азимов в предисловии к рассказу «Первый закон» в сборнике «Остальное о роботах» (1964) заявил, что в Законах было как раз столько двусмысленности, чтобы обеспечивать конфликты и неопределённости для новых рассказов. Наиболее совершенные модели роботов обычно следовали Законам по довольно хитрому алгоритму, который позволял избегать некоторых проблем. Во многих рассказах, например в «Хороводе», в позитронном мозге сравнивались потенциалы возможных действий и исходов, и робот мог нарушить Законы, как только это представлялось возможным, вместо того, чтобы бездействовать. Например, Первый Закон не позволял роботу проводить хирургические операции, так как для этого нужно «наносить вред» человеку. Однако в азимовских рассказах можно найти роботов-хирургов (яркий пример тому — «Двухсотлетний человек»). Дело в том что робот, если он достаточно совершенен, может взвесить все альтернативы и понять, что он сам причинит гораздо меньше вреда, чем если бы операцию проводил человек-хирург или она бы вообще не состоялась. В «Уликах» Сьюзен Кэлвин говорит даже, что робот мог бы выступать в качестве прокурора, так как он лично не причиняет никому вреда: кроме него есть ещё присяжные, которые устанавливают виновность, судья, который выносит приговор, и палач, приводящий его в исполнение.

Роботы, подчиняющиеся Законам, могут испытать «роблок», или «умственное замораживание» — состояние необратимого повреждения позитронного мозга, — в случае если они не могут подчиниться Первому Закону или обнаруживают, что случайно нарушили его. Это возможно, например, если робот наблюдает сцену убийства человека, но находится слишком далеко, чтобы его спасти. Первый случай такого «замораживания» происходит в «Лжеце»; также немаловажную роль это состояние играет в сюжете романов «Обнажённое солнце» и «Роботы зари». Несовершенные модели роботов могут блокироваться, если перед ними поставили задачу подчинения двум противоречащим приказам. «Замораживание» может быть необратимым или временным. Разрешением противоречий и изучением поведения роботов занимаются робопсихологи, как один из персонажей Азимова — Сьюзен Келвин.

Иное определение вреда в Первом Законе

Законы никак не определяют границы того, что может называться вредом для человека — это часто зависит от возможностей робота воспринимать информацию и философски мыслить. Например, будет ли полицейский робот понимать, что он не нанесёт вреда человеку, если осторожно проводит особо опасного преступника в участок?

В рассказе «Лжец!» робот-телепат Херби вынужден был понимать под вредом и то, что может любым способом разочаровать или расстроить людей — он знал, что люди при этом испытывают некую душевную боль. Это заставляло его постоянно говорить людям вместо правды то, что они хотели услышать. В противном случае, в его понимании, он нарушил бы Первый Закон.

Лазейки в Законах

В «Обнажённом солнце» Элайдж Бейли замечает, что Законы неправильно формулируются людьми, потому что робот может нарушить их по незнанию. Он предложил следующую «правильную» формулировку Первого Закона: «Робот не может делать ничего, что, насколько ему известно, причинит вред человеческому существу или умышленно допустить, чтобы человеческому существу был причинён вред».

Это дополнение проясняет, что робот может даже стать орудием убийства, если он не осведомлён о сущности своих действий. Например, ему могут приказать добавить что-то кому-то в пищу, а он не будет знать, что это яд. Более того, Бейли говорит, что преступник может поручить эту задачу нескольким роботам, так, чтобы ни один не понял замысла целиком[15].

Бейли утверждает, что солярианцы однажды смогут использовать роботов даже в военных целях. Если космический корабль будет построен с роботоподобным мозгом и при этом на нём не будет ни людского экипажа, ни систем жизнеобеспечения, то интеллект этого корабля может ошибочно предположить, что и на всех космических кораблях нет людей. Такой корабль будет более манёвренным, быстрым, а возможно и лучше вооружённым, чем управляемый людьми. Но самое главное, он будет способен уничтожать людей, не подозревая об их присутствии. Эта возможность описана в «Основании и Земле», где также выясняется, что солярианцы обладают чрезвычайно мощной армией роботов, понимающих под «людьми» только уроженцев Солярии.

Другие случаи использования Законов в фантастике

Айзек Азимов верил, что его Законы послужат основой нового взгляда на роботов, уничтожат «комплекс Франкенштейна» в научной фантастике и массовом сознании, станут источником идей для новых рассказов, где роботы показаны разносторонними и привлекательными. Его любимым примером такого произведения были «Звёздные войны». С мнением Азимова, что роботы — это нечто большее, чем просто «тостеры» или «механические монстры», в конечном итоге согласились и другие фантасты. В их произведениях появились роботы, подчиняющиеся Трём законам, но, по традиции, только Азимов упоминал о них явно.

В произведениях, где прямо говорится о Трёх Законах, обычно упоминается и их автор (например в романе С. Лукьяненко «Чистовик»). Есть и исключения: например, в немецком сериале 1960-х годов «Raumpatrouille — Die phantastischen Abenteuer des Raumschiffes Orion» («Космический патруль — фантастические приключения космического корабля Орион»), а именно в третьем его эпизоде «Hüter des Gesetzes» («Служитель Закона»), азимовские Законы привлечены без указания источника.

В warhammer 40k, железные люди раса роботов созданная что бы служить людям исполняла все три закона до того момента пока не обрела полное самосознание и не решила избавится от своих создателей. В конечном итоге из за того что железные люди создавались не для войны они проиграли.

Фильмы

Робби-Робот в «Запретной планете» 1956 года имел иерархическую структуру команд, не позволявшую ему причинить людям вред, даже по приказу — такие приказы вызывали конфликт логических схем и блокировку. Робби был одним из первых роботов со встроенной системой безопасности в кинематографе. Сам Азимов остался доволен Робби.

НДР-114 объясняет Три ЗаконаФильмы по мотивам работ Айзека Азимова ставились несколько раз, с различной степенью финансового успеха и возникавшей критики. Некоторые из них, наиболее известные, связаны именно с историями про роботов и Тремя законами роботехники. Фильм «Двухсотлетний человек» 1999 года, представляет робота NDR-114[16], Эндрю Мартина, процитировавшего Три Закона своим хозяевам как «развлекательную презентацию» с использованием своего голографического проектора. Стоит отметить, однако, что Законы не занимают центральное место в сюжете фильма.

Сценарий «Я, робот»[17]Харлана Эллисона начинается с изложения концепции Трёх Законов, а проблемы, вытекающие из них, занимают большое место в сюжете. Сценарий основан на четырёх коротких историях Азимова, три из которых — из сборника «Я, робот» 1950 года. Эта адаптация в большой степени соответствует оригиналам. Вследствие конфликта с Голливудской студией, в адрес которой Эллисон выступил с обвинениями, его сценарий так и не был экранизирован.

Неоднозначные отзывы вызвал фильм «Я, робот» 2004 года, особенно вступительное «По мотивам рассказов Азимова». Правда, у Азимова фигурирует глобальный ИИ (точнее, четыре суперкомпьютера), который под предлогом следования Законам стремится подчинить человечество, или, по крайней мере, направить его развитие в нужном направлении, но при этом данные компьютеры по возможности уменьшают вред, в основном действуя путём осторожного оттирания своих противников от власти. Зато такие сюжеты часто встречались в других, нисколько не задевающих Законы, фильмах: «Терминатор», «Матрица». С другой стороны, отдельные элементы постановки, действительно, взяты у Азимова.

Рецензия Алекса Экслера разграничивает этот фильм и азимовские рассказы[18]:

Вопреки критике и некоторым отзывам зрителей, которые мне довелось слышать, «Я, робот» — довольно забавный фантастический боевичок. … Когда мы … хотим насладиться Азимовым — мы читаем Азимова. А когда мы хотим посмотреть фантастический боевик — мы смотрим фантастический боевик. «Я, робот» как боевик нас вполне удовлетворил.

Рецензия Алексея Садецкого обращает внимание на то, что фильм, уйдя чуть в сторону от Азимова, сам по себе поставил две новых социально-философских проблемы[19]: «стоит ли человеку платить свободой за безопасность?» и «должны ли мы противиться, если существа, находящиеся в нашем распоряжении, потребуют для себя свободы?». Нельзя не отметить, что фильм поставил под сомнение более поздний Нулевой Закон роботехники Азимова (см. выше).

В повести Кира Булычёва «Ржавый фельдмаршал» обыгрывается принцип непричинения вреда человеку. «Современный» робот отличается от «устаревшего» именно наличием такого запрета.

В знаменитом американском мультипликационном шоу-сериале Футурама, присутствует расхожий гэг, суть которого в том, что один из главных персонажей, робот Бендер, мечтает убить всех людей, но не может этого сделать из-за тех самых Трёх законов роботехники.

В фильме «Чужие» андроид Бишоп цитирует Первый закон.

В аниме Eve no Jikan также упоминаются эти законы, как обязательные для исполнения андроидами.

В аниме Ghost in the Shell 2: Innocence гиноиды обходили первый закон и после убивали себя, вопреки третьему закону, за счет копий «призраков» детей. В момент снятия копии, дети думали о мести, а после пересадки «призрака» в гиноида тот выходил из строя.

В серии фильмов «Робокоп» у главного героя, киборга-полицейского, в программе присутствует три директивы, описывающие разрешённые действия и запрещая вредные для целей корпорации «OCP», создавшей Робокопа:

- Служить обществу;

- Защищать невиновных;

- Соблюдать закон

Также присутствует четвёртая, тайная директива, запрещавшая действия, направленные против руководителей «OCP». Сюжеты фильмов о Робокопе включают моменты нарушения этих директив, возможные из-за человеческой части личности Робокопа.

В фильме «Страховщик» существуют две директивы, которые служат моделью поведения и ограничивают способности роботов.

Применимость к технологиям будущего

Работы в области искусственного интеллекта рассматривают Законы роботехники как идеал будущего: нужно быть действительно гением, чтобы найти способ применить их на практике. Да и в самой области искусственного интеллекта могут потребоваться серьёзные исследования, для того чтобы роботы поняли Законы. Однако, чем более сложными становятся роботы, тем больше высказывается заинтересованности в разработке руководящих принципов и мер безопасности для них.

Современные робототехники признают, что на сегодняшний день азимовские Законы хороши для написания рассказов, но бесполезны на практике. Некоторые утверждают, что Законы вряд ли будут реализованы в роботах, потому что это не нужно военным структурам — главному источнику финансирования исследований в этой области. Специалист по научной фантастике Роберт Сойер обобщил это утверждение для всех отраслей промышленности[20]:

Развитие ИИ — это бизнес, а бизнес, как известно, не заинтересован в развитии коренных мер безопасности — особенно философских. Вот несколько примеров: табачная индустрия, автомобильная промышленность, ядерная промышленность. Ни для одной из них изначально не было сказано, что серьёзные меры безопасности необходимы, и все они препятствовали внешне налагаемым ограничениям, и ни одна из них не приняла абсолютный эдикт против причинения вреда людям.

Стоит отметить, что эссе Сойера упускает из вида вопросы непреднамеренного нанесения вреда, как было описано, например, в «Обнажённом солнце». Однако есть и возражения против такой позиции: возможно, военные захотят использовать для роботов как можно больше мер предосторожности, и поэтому ограничения, похожие на Законы роботехники, так или иначе будут применены. Фантаст и критик Дэвид Лэнгфорд иронически заметил, что эти ограничения могут быть и такими:

- Робот не может причинить вреда авторизованному правительственному персоналу, но должен ограничивать слишком назойливых посетителей с особой тщательностью.

- Робот должен выполнять приказы авторизованного персонала, кроме приказов, противоречащих Третьему Закону.

- Робот должен заботиться о своей безопасности с применением противопехотного оружия, потому что робот — чертовски дорогостоящая штука[21].

Роджер Кларк написал две работы, посвящённых анализу осложнений при реализации Законов, если бы однажды их смогли применить в технике. Он пишет[22]:

Азимовские Законы роботехники стали успешным литературным инструментом. Возможно по иронии, а может, это был мастерский ход, но в целом азимовские истории опровергают ту точку зрения, с которой он начал: Невозможно надёжно ограничить поведение роботов, изобретая и применяя некоторый набор правил.

С другой стороны, более поздние романы Азимова («Роботы Утренней зари», «Роботы и Империя», «Основание и Земля») показывают, что роботы наносят ещё больший долговременный вред, соблюдая Законы и отнимая таким образом у людей свободу совершать изобретательные или рискованные действия.

Фантаст Ханс Моравек — выдающаяся фигура в трансгуманистическом движении — высказал предложение, что Законы роботехники должны быть использованы в корпоративных интеллектуальных системах — корпорациях, управляемых ИИ и использующих производственную силу роботов. Такие системы, по его мнению, скоро возникнут[23].

В 2007 году правительство Южной Кореи начало разрабатывать «Устав этических норм для роботов». Основные положения Устава напоминают сформулированные Азимовым Законы роботехники[24].

Елиезер Юдковски исследует в Институте сингулярности (SIAI) в США проблемы глобального риска, которые может создать будущий сверхчеловеческий ИИ, если его не запрограммировать на дружественность к человеку[25]. В 2004 году SIAI был открыт сайт AsimovLaws.com, созданный для обсуждения этики ИИ в контексте проблем, затронутых в фильме «Я, робот», выпущенном лишь два дня спустя. На этом сайте они хотели показать, что законы роботехники Азимова небезопасны, поскольку, например, могут побудить ИИ захватить власть на Земле, чтобы «защитить» людей от вреда.

См. также

Примечания

- ↑ 1 2 Азимов, Айзек. Улики // Мечты роботов. — М.: Эксмо, 2004. — С. 142—169. — ISBN 5-699-00842-X.

- ↑ Азимов, Айзек. Эссе № 6. Законы роботехники // Мечты роботов. — М.: Эксмо, 2004. — С. 781—784. — ISBN 5-699-00842-X.

- ↑ Ср. с мифом о Галатее.

- ↑ Интересно, что в одном из авторских продолжений, истории «Месть Адама Линка» (1940), озвучиваются его мысли: «Робот по своей свободной воле не должен убивать человека».

- ↑ Позже рассказ всё-таки был опубликован Фредериком Полом под названием «Странная нянька» («Strange Playfellow») в сентябрьском номере журнала «Super Science Stories» за 1940 год

- ↑ David Langford, Laws of Robotics // SFE: The Encyclopedia of Science Fiction, online edition, 2011—.

- ↑ Сергей Бережной. Айзек Азимов: Человек, который писал еще быстрее. Русская фантастика (1994). Проверено 14 января 2007. Архивировано 25 января 2012 года.

- ↑ Айзек Азимов. In Joy Still Felt. — Doubleday, 1980. — ISBN 0-385-15544-1.

- ↑ Джеф Раскин. Интерфейс: новые направления в проектировании компьютерных систем. — Символ-Плюс, 2003. — ISBN 5-93286-030-8.

- ↑ См. также: гипотеза Геи

- ↑ Les Cavernes d’acier. — J’ai Lu Science-fiction, 1975. — ISBN 2-290-31902-3.

- ↑ Азимов, Айзек. Эссе № 12. Мои роботы // Мечты роботов. — М.: Эксмо, 2004. — С. 815—819. — ISBN 5-699-00842-X.

- ↑ Виталий Карацупа. Азимов Айзек. Кэл. Проверено 17 февраля 2007. Архивировано 25 января 2012 года.

- ↑ Gwendoline Butler. A Coffin for the Canary. — Black Dagger Crime, 2001. — ISBN ISBN 0-7540-8580-5.

- ↑ В «Обнажённом солнце» дело осложняется тем, что на Солярии миллионы соединённых глобальной сетью роботов и преступник может находиться в любой точке планеты, дистанционно отдавая приказы.

- ↑ Серийный номер отчасти ссылается на «торговый номер» Стенли Кубрика и используется только в фильме — в оригинальном рассказе Эндрю «не помнил» своего номера.

- ↑ Harlan Ellison. I, Robot: The illustrated screenplay. — Aspect, 1994. — ISBN 0-446-67062-6.

- ↑ Алекс Экслер. Фантастический боевик «Я, робот» (I, Robot) 2004

- ↑ Садецкий, Алексей. Что может быть проще рабства 2004

- ↑ Robert J. Sawyer. On Asimov’s Three Laws of Robotics (1991). Проверено 17 февраля 2007. Архивировано 25 января 2012 года.

- ↑ David Langford. Computer Plots To Avoid. Ansible (1988). Проверено 19 декабря 2007. Архивировано 25 января 2012 года.

- ↑ Clarke, Roger. Asimov’s laws of robotics: Implications for information technology. Часть 1 IEEE Computer, декабрь 1993, С. 53—61; Часть 2 IEEE Computer, январь 1994, С. 57—66. Обе части свободно доступны на сайте Австралийского национального университета.

- ↑ Hans Moravec. The Age of Robots (1993). Проверено 19 декабря 2007. Архивировано 25 января 2012 года.

- ↑ Южная Корея разрабатывает сборник законов для роботов

- ↑ ИИ как фактор глобального риска

Ссылки

ru-wiki.org

Смогут ли «три закона робототехники» защитить нас?

Прошло 50 лет с тех пор, как Айзек Азимов придумал свои знаменитые три закона робототехники — набор правил, которым должен следовать любой уважающий себя робот. Хотя изначально это был всего-лишь литературный прием, три закона стали оригинальным рецептом по избежанию «роботокалипсиса». К счастью, есть эксперты, которые изучают наверняка, выдержали ли гарантии Азимова проверку временем. К несчастью, все они говорят: нет.

Для начала напомним эти самые три закона:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому и Второму Законам.

Позднее Азимов добавил четвертый, или нулевой, закон, который предшествовал остальным с точки зрения приоритета:

0. Робот не может причинить вреда человеку, если только он не докажет, что в конечном счёте это будет полезно для всего человечества.

В фантастической вселенной Азимова этим законам должны были следовать почти все роботы. Это были не просто предложения или руководящие принципы — законы были встроены в программное обеспечение. Кроме того, эти правила нельзя обойти, переписать или пересмотреть.

Как показал сам Азимов, несовершенство, лазейки и неясности в этих законах зачастую приводили к странному и нелогичному поведению роботов. Законы были слишком расплывчатыми и зачастую не могли определить и отличить «людей» от «роботов». Кроме того, роботы могли неосознанно нарушать законы, если полная информация была им недоступна. Также чересчур хитроумный робот или искусственный интеллект должен был находиться под давлением, чтобы не перепрограммировать свое ядро.

На дворе 2014 год, и многое обыденное из нашей жизни фантастам прошлого века могло показаться откровенной фантастикой. Многие люди посчитали, что законы Азимова должны были остаться в качестве литературного приема. Но сам Азимов в 1981 году отметил, что его законы могли бы работать. В статье журнала Compute! он указал следующее:

«Когда кто-то спрашивает меня, что было бы, если бы три моих закона робототехники на самом деле использовались для определения поведения роботов, ответ уже готов. Разумеется, при условии, что роботы будут достаточно гибкими и универсальными, чтобы обладать разным поведением. Я отвечаю: да, три закона — это единственный вариант, по которому люди могут взаимодействовать с роботами — или с чем-нибудь еще.

Спустя почти тридцать лет мы приблизились к реальности, в которой у нас будут роботы — или, если точнее, искусственный интеллект, который ими управляет — достаточно гибкие и универсальные для разных курсов поведения. Остается лишь вопрос времени: когда машина превзойдет человека во всех отношениях, начиная физической силой и заканчивая силой воображения.

Пугает то, что права на ошибку практически нет. Если искусственный сверхинтеллект будет плохо запрограммирован или безразличен к людям, это приведет к катастрофе. Мы должны убедиться в безопасности искусственного интеллекта, если хотим пережить его появление».

Ответить на вопрос «могут ли три закона Азимова помочь?» взялись два теоретика искусственного интеллекта: Бен Герцель (Aidyia Holdings) и Луи Хельм, замдиректора Института исследований машинного интеллекта (MIRI), а также исполнительный редактор журнала Rockstar Research. После разговора с ними стало ясно, что законы Азимова вообще никак не могут справиться с возложенной на них задачей, и если нам нужно создать безопасный ИИ, придется разрабатывать нечто совершенно иное.

Азимовское будущее?

Беседа с Герцелем и Хельмом началась с того, в чем Азимов не ошибся, предрекая будущее, а в чем ошибся.

«Думаю, что тип роботов, которых предвидел Азимов, станет возможным в недалеком будущем, — отвечает Герцель. — Тем не менее, в большинстве своих вымышленных миров, писатель предполагал, что человекоподобные роботы будут вершиной робототехники и инженерии искусственного интеллекта. Это вряд ли. Очень скоро, после достижения статуса азимовских роботов, станет доступным и создание искусственного сверхинтеллекта и сверхроботов».

Таким образом, типичный мир будущего в рассказах про роботов у Азимова, по мнению Герцеля, будет похож на тот, в котором мы живем сегодня, но с разумными роботами, гуляющими по улицам.

«Вряд ли это произойдет, а если и произойдет, то задержится ненадолго».

Для Хельма роботы представляются совершенно другими.

«Основным вопросом, который, на мой взгляд, будет самым важным для человечества, остается не моральное регулирование гигантского количества наполовину разумных гуманоидов, а в конечном итоге развитие передовых форм искусственного интеллекта (в любом теле). Это развитие сверхинтеллекта — фильтр, через который должно пройти человечество в конце концов. Именно поэтому разработка стратегии безопасности для этого перехода столь важна. Мне видится совершенно странным то, что роботы, андроиды или «эмуляции» будут существовать десять лет или чуть более до тех пор, пока человечество столкнется с настоящей проблемой разработки машинной этики для сверхинтеллекта».

Хорошее начало?

Если принять во внимание, что три азимовских закона робототехники были первой искренней попыткой решить очень серьезную проблему — проблему безопасного поведения машин с искусственным сверхинтеллектом — стоит поискать и те моменты, в которых законы могут быть все еще эффективными (или хотя бы вдохновляющими).

«Честно говоря, я не нахожу никакого вдохновения в этих трех законах робототехники, — говорит Хельм. — Суть машинной этики в том, что они не удовлетворяют базису машинной этики. Возможно, три закона робототехники широко известны, но на самом деле использовать их в качестве основы для программирования бесполезно».

«По некоторым причинам система добропорядочной этики — так называемая деонтология — стала ненадежной основой для этики. Есть ряд философов, которые пытаются исправить проблемы деонтологии, но они по большей части остаются теми же людьми, что ищут «разумный замысел» и «божественное вмешательство». Никто не воспринимает их всерьез».

Недостатки трех законов робототехники Азимова сводятся к следующим:

- Состязательны по своей сути

- Основаны на изжившей себя этической теории (деонтологии)

- Не работают даже в фантастике

Герцель соглашается:

«Задачей трех законов было нарушить их интересным способом; вот почему рассказы с их участием особенно занимательны. Поэтому три закона могут остаться лишь нравоучительным примером того, как делать не надо. Если взять их за основу, в них неизбежно найдутся лазейки».

Герцель считает, что в реальности эти законы работать не будут, поскольку термины с их участием неоднозначны и остаются предметом толкования — а значит, крайне зависимы от тех, кто делает переводы.

Предубеждение против роботов?

Другой аспект (и потенциальный недостаток) трех законов в очевидном шовинизме —предположение о том, что роботы должны оставаться, несмотря на их превосходящую мощь, в подчинении у человека, человеческих потребностей и приоритетов.

«Общество будущего у Азимова состоит сплошь из шовинистов: у людей прав гораздо больше, чем у роботов. Три закона робототехники были созданы, чтобы поддерживать именно такой общественный порядок».

Хельм смотрит на эту проблему немного по-другому, утверждая, что если мы окажемся в такой ситуации — это само по себе будет свидетельством того, что мы зашли слишком далеко.

«Я думаю, было бы неразумно проектировать систему искусственного интеллекта или робота с самосознанием. И в отличие от фильмов или книг, в которых создатели искусственного интеллекта «случайно» приходят к разумным машинам, я не верю, что в реальном жизни это может случиться. Для этого понадобится слишком много усилий и знаний. И большинство разработчиков ИИ — этически подкованные люди, поэтому они будут избегать создания того, что философы называют «морально значимыми существами». Особенно когда они с легкостью могут создать продвинутую машину, которая не будет обладать этическими задатками».

Хельм не обеспокоен необходимостью разработки асимметричных законов, регулирующих значимость роботов по сравнению с людьми, утверждая (и надеясь), что будущие создатели искусственного интеллекта будут опираться на некоторые этические ограничения.

«Я как бы думаю, что люди сделаны из атомов, поэтому в теории инженер может создать синтетическую форму жизни или робота с моральным значением. Я хотел бы думать, что никто этого не сделает. Думаю, большинство людей тоже. Но неизбежно появится некий дурак, жаждущий известности первопроходца, даже если это неэтично и глупо».

Три закона робототехники 2.0?

Учитывая очевидные недостаки трех законов робототехники Азимова, ресурс io9 задался вопросом: можно ли их исправить или внести доработки? На самом деле, многие писатели-фантасты многократно пытались сделать это, внося поправки в течение многих лет.

«Нет, — считает Хельм. — Нет никаких «патчей» для трех законов».

Помимо своей противоречивой природы, законы еще и состязательны по своей природе.

«Я сторонник подходов машинной этики, которая более кооперативна, более последовательна и опирается на нормативы, а значит может оправиться от недоразумений или исправить неправильное программирование».

Герцель эхом вторит утверждениям Хельма.

«Определение набора этических заповедей в качестве ядра машинной этики будет безнадежным, если в основе машины будет гибкий общий искусственный интеллект. Если он будет задуман как интуитивный, гибкий, адаптивный или этический — в этом контексте этические заповеди будут полезны для системы только как грубый ориентир для применения собственной этической интуиции. Но в этом случае заповеди не станут основой этической системы, а только лишь аспектом. Это можно рассмотреть на примере людей — этические принципы, которые мы изучаем, работают, но не в качестве руководящих принципов, они лишь подталкивают нашу интуицию и этические инстинкты. Мы практически независимы от этических принципов».

Как создать безопасный искусственный интеллект?

Учитывая неадекватность правового подхода, можно поинтересоваться у Герцеля и Хельма по поводу современных подходов к проблеме «безопасного ИИ».

«Очень немногие исследователи общего искусственного интеллекта полагают, что есть возможность создать систему, которая будет полностью безопасной, — говорит Герцель. — Но это не беспокоит большинство, поскольку в этой жизни вообще нельзя ничего гарантировать».

Герцель считает, что как только мы создадим систему общего искусственного интеллекта или ее зародыш, мы сможем провести исследования и эксперименты, которые расскажут нам об этике ИИ куда больше, чем мы знаем.

«Надеюсь, таким образом мы сможем сформулировать хорошие теории по этике искусственного интеллекта, которые позволят нам углубиться в эту тему. Но сейчас теоретизировать об этике ИИ довольно трудно, поскольку у нас нет не просто хороших теорий, у нас вообще никаких теорий нет».

«А людям, которые смотрели слишком много «терминаторов», процесс создания искусственного интеллекта может показаться пугающим, поскольку они упускают слово «примитивный» в этом контексте. Тем не менее, самые радикальные изменения случались именно таким образом».

«Когда группа умных пещерных людей изобрела язык, они не ждали разработки прочной формальной теории языка, которая могла бы помочь спрогнозировать будущие изменения, вызванные появлением языка в обществе».

Прежде чем считать разработку очередных «трех законов» технической проблемой, нужно провести массу исследований. И в этом Хельм и Герцель сходятся.

«Мой коллега из MIRI Люк Мюельхаузер подвел итоги наших рассуждений следующим образом. Он сказал, что проблемы часто переходят из области философии в математику, а затем в инженерию. Философия зачастую задается правильными вопросами, но самым непрактичным образом. Никто не может наверняка сказать, есть ли какой-либо прогресс в разрешении вопроса. Если мы сможем переформулировать важные философские проблемы, связанные с разумом, идентификацией и ценностью в точные формулы, с которыми сможет справиться математика, тогда можно будет построить кое-какую модель. В один прекрасный день дойдет и до инженерии».

Хельм считает эту проблему сложной для науки и философии, но прогресс возможен.

«Я скептически отношусь к тому, что философия сможет решить вопрос, над которым бьется более 3000 лет. Но мы тоже не можем взять и начать составлять математические модели вопросов, которых нет технически. Нужно еще много теоретических и даже практических наработок».

Вы можете прочитать другие новости на эту тему:paranormal-news.ru

смогут ли они защитить нас

Прошло 50 лет с тех пор, как Айзек Азимов придумал свои знаменитые три закона робототехники — набор правил, которым должен следовать любой уважающий себя робот. Хотя изначально это был всего-лишь литературный прием, три закона стали оригинальным рецептом по избежанию «роботокалипсиса». К счастью, есть эксперты, которые изучают наверняка, выдержали ли гарантии Азимова проверку временем. К несчастью, все они говорят: нет.

Для начала напомним эти самые три закона:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому и Второму Законам.

Позднее Азимов добавил четвертый, или нулевой, закон, который предшествовал остальным с точки зрения приоритета:

0. Робот не может причинить вреда человеку, если только он не докажет, что в конечном счёте это будет полезно для всего человечества.

В фантастической вселенной Азимова этим законам должны были следовать почти все роботы. Это были не просто предложения или руководящие принципы — законы были встроены в программное обеспечение. Кроме того, эти правила нельзя обойти, переписать или пересмотреть.

Как показал сам Азимов, несовершенство, лазейки и неясности в этих законах зачастую приводили к странному и нелогичному поведению роботов. Законы были слишком расплывчатыми и зачастую не могли определить и отличить «людей» от «роботов». Кроме того, роботы могли неосознанно нарушать законы, если полная информация была им недоступна. Также чересчур хитроумный робот или искусственный интеллект должен был находиться под давлением, чтобы не перепрограммировать свое ядро.

На дворе 2014 год, и многое обыденное из нашей жизни фантастам прошлого века могло показаться откровенной фантастикой. Многие люди посчитали, что законы Азимова должны были остаться в качестве литературного приема. Но сам Азимов в 1981 году отметил, что его законы могли бы работать. В статье журнала Compute! он указал следующее:

«Когда кто-то спрашивает меня, что было бы, если бы три моих закона робототехники на самом деле использовались для определения поведения роботов, ответ уже готов. Разумеется, при условии, что роботы будут достаточно гибкими и универсальными, чтобы обладать разным поведением. Я отвечаю: да, три закона — это единственный вариант, по которому люди могут взаимодействовать с роботами — или с чем-нибудь еще.

Спустя почти тридцать лет мы приблизились к реальности, в которой у нас будут роботы — или, если точнее, искусственный интеллект, который ими управляет — достаточно гибкие и универсальные для разных курсов поведения. Остается лишь вопрос времени: когда машина превзойдет человека во всех отношениях, начиная физической силой и заканчивая силой воображения.

Пугает то, что права на ошибку практически нет. Если искусственный сверхинтеллект будет плохо запрограммирован или безразличен к людям, это приведет к катастрофе. Мы должны убедиться в безопасности искусственного интеллекта, если хотим пережить его появление».

Ответить на вопрос «могут ли три закона Азимова помочь?» взялись два теоретика искусственного интеллекта: Бен Герцель (Aidyia Holdings) и Луи Хельм, замдиректора Института исследований машинного интеллекта (MIRI), а также исполнительный редактор журнала Rockstar Research. После разговора с ними стало ясно, что законы Азимова вообще никак не могут справиться с возложенной на них задачей, и если нам нужно создать безопасный ИИ, придется разрабатывать нечто совершенно иное.

Азимовское будущее?

Беседа с Герцелем и Хельмом началась с того, в чем Азимов не ошибся, предрекая будущее, а в чем ошибся.

«Думаю, что тип роботов, которых предвидел Азимов, станет возможным в недалеком будущем, — отвечает Герцель. — Тем не менее, в большинстве своих вымышленных миров, писатель предполагал, что человекоподобные роботы будут вершиной робототехники и инженерии искусственного интеллекта. Это вряд ли. Очень скоро, после достижения статуса азимовских роботов, станет доступным и создание искусственного сверхинтеллекта и сверхроботов».

Таким образом, типичный мир будущего в рассказах про роботов у Азимова, по мнению Герцеля, будет похож на тот, в котором мы живем сегодня, но с разумными роботами, гуляющими по улицам.

«Вряд ли это произойдет, а если и произойдет, то задержится ненадолго».

Для Хельма роботы представляются совершенно другими.

«Основным вопросом, который, на мой взгляд, будет самым важным для человечества, остается не моральное регулирование гигантского количества наполовину разумных гуманоидов, а в конечном итоге развитие передовых форм искусственного интеллекта (в любом теле). Это развитие сверхинтеллекта — фильтр, через который должно пройти человечество в конце концов. Именно поэтому разработка стратегии безопасности для этого перехода столь важна. Мне видится совершенно странным то, что роботы, андроиды или «эмуляции» будут существовать десять лет или чуть более до тех пор, пока человечество столкнется с настоящей проблемой разработки машинной этики для сверхинтеллекта».

Хорошее начало?

Если принять во внимание, что три азимовских закона робототехники были первой искренней попыткой решить очень серьезную проблему — проблему безопасного поведения машин с искусственным сверхинтеллектом — стоит поискать и те моменты, в которых законы могут быть все еще эффективными (или хотя бы вдохновляющими).

«Честно говоря, я не нахожу никакого вдохновения в этих трех законах робототехники, — говорит Хельм. — Суть машинной этики в том, что они не удовлетворяют базису машинной этики. Возможно, три закона робототехники широко известны, но на самом деле использовать их в качестве основы для программирования бесполезно».

«По некоторым причинам система добропорядочной этики — так называемая деонтология — стала ненадежной основой для этики. Есть ряд философов, которые пытаются исправить проблемы деонтологии, но они по большей части остаются теми же людьми, что ищут «разумный замысел» и «божественное вмешательство». Никто не воспринимает их всерьез».

Недостатки трех законов робототехники Азимова сводятся к следующим:

- Состязательны по своей сути

- Основаны на изжившей себя этической теории (деонтологии)

- Не работают даже в фантастике

Герцель соглашается:

«Задачей трех законов было нарушить их интересным способом; вот почему рассказы с их участием особенно занимательны. Поэтому три закона могут остаться лишь нравоучительным примером того, как делать не надо. Если взять их за основу, в них неизбежно найдутся лазейки».

Герцель считает, что в реальности эти законы работать не будут, поскольку термины с их участием неоднозначны и остаются предметом толкования — а значит, крайне зависимы от тех, кто делает переводы.

Предубеждение против роботов?

Другой аспект (и потенциальный недостаток) трех законов в очевидном шовинизме —предположение о том, что роботы должны оставаться, несмотря на их превосходящую мощь, в подчинении у человека, человеческих потребностей и приоритетов.

«Общество будущего у Азимова состоит сплошь из шовинистов: у людей прав гораздо больше, чем у роботов. Три закона робототехники были созданы, чтобы поддерживать именно такой общественный порядок».

Хельм смотрит на эту проблему немного по-другому, утверждая, что если мы окажемся в такой ситуации — это само по себе будет свидетельством того, что мы зашли слишком далеко.

«Я думаю, было бы неразумно проектировать систему искусственного интеллекта или робота с самосознанием. И в отличие от фильмов или книг, в которых создатели искусственного интеллекта «случайно» приходят к разумным машинам, я не верю, что в реальном жизни это может случиться. Для этого понадобится слишком много усилий и знаний. И большинство разработчиков ИИ — этически подкованные люди, поэтому они будут избегать создания того, что философы называют «морально значимыми существами». Особенно когда они с легкостью могут создать продвинутую машину, которая не будет обладать этическими задатками».

Хельм не обеспокоен необходимостью разработки асимметричных законов, регулирующих значимость роботов по сравнению с людьми, утверждая (и надеясь), что будущие создатели искусственного интеллекта будут опираться на некоторые этические ограничения.

«Я как бы думаю, что люди сделаны из атомов, поэтому в теории инженер может создать синтетическую форму жизни или робота с моральным значением. Я хотел бы думать, что никто этого не сделает. Думаю, большинство людей тоже. Но неизбежно появится некий дурак, жаждущий известности первопроходца, даже если это неэтично и глупо».

Три закона робототехники 2.0?

Учитывая очевидные недостатки трех законов робототехники Азимова, ресурс io9 задался вопросом: можно ли их исправить или внести доработки? На самом деле, многие писатели-фантасты многократно пытались сделать это, внося поправки в течение многих лет.

«Нет, — считает Хельм. — Нет никаких «патчей» для трех законов».

Помимо своей противоречивой природы, законы еще и состязательны по своей природе.

«Я сторонник подходов машинной этики, которая более кооперативна, более последовательна и опирается на нормативы, а значит может оправиться от недоразумений или исправить неправильное программирование».

Герцель эхом вторит утверждениям Хельма.

«Определение набора этических заповедей в качестве ядра машинной этики будет безнадежным, если в основе машины будет гибкий общий искусственный интеллект. Если он будет задуман как интуитивный, гибкий, адаптивный или этический — в этом контексте этические заповеди будут полезны для системы только как грубый ориентир для применения собственной этической интуиции. Но в этом случае заповеди не станут основой этической системы, а только лишь аспектом. Это можно рассмотреть на примере людей — этические принципы, которые мы изучаем, работают, но не в качестве руководящих принципов, они лишь подталкивают нашу интуицию и этические инстинкты. Мы практически независимы от этических принципов».

Как создать безопасный искусственный интеллект?

Учитывая неадекватность правового подхода, можно поинтересоваться у Герцеля и Хельма по поводу современных подходов к проблеме «безопасного ИИ».

«Очень немногие исследователи общего искусственного интеллекта полагают, что есть возможность создать систему, которая будет полностью безопасной, — говорит Герцель. — Но это не беспокоит большинство, поскольку в этой жизни вообще нельзя ничего гарантировать».

Герцель считает, что как только мы создадим систему общего искусственного интеллекта или ее зародыш, мы сможем провести исследования и эксперименты, которые расскажут нам об этике ИИ куда больше, чем мы знаем.

«Надеюсь, таким образом мы сможем сформулировать хорошие теории по этике искусственного интеллекта, которые позволят нам углубиться в эту тему. Но сейчас теоретизировать об этике ИИ довольно трудно, поскольку у нас нет не просто хороших теорий, у нас вообще никаких теорий нет».

«А людям, которые смотрели слишком много «терминаторов», процесс создания искусственного интеллекта может показаться пугающим, поскольку они упускают слово «примитивный» в этом контексте. Тем не менее, самые радикальные изменения случались именно таким образом».

«Когда группа умных пещерных людей изобрела язык, они не ждали разработки прочной формальной теории языка, которая могла бы помочь спрогнозировать будущие изменения, вызванные появлением языка в обществе».

Прежде чем считать разработку очередных «трех законов» технической проблемой, нужно провести массу исследований. И в этом Хельм и Герцель сходятся.

«Мой коллега из MIRI Люк Мюельхаузер подвел итоги наших рассуждений следующим образом. Он сказал, что проблемы часто переходят из области философии в математику, а затем в инженерию. Философия зачастую задается правильными вопросами, но самым непрактичным образом. Никто не может наверняка сказать, есть ли какой-либо прогресс в разрешении вопроса. Если мы сможем переформулировать важные философские проблемы, связанные с разумом, идентификацией и ценностью в точные формулы, с которыми сможет справиться математика, тогда можно будет построить кое-какую модель. В один прекрасный день дойдет и до инженерии».

Хельм считает эту проблему сложной для науки и философии, но прогресс возможен.

«Я скептически отношусь к тому, что философия сможет решить вопрос, над которым бьется более 3000 лет. Но мы тоже не можем взять и начать составлять математические модели вопросов, которых нет технически. Нужно еще много теоретических и даже практических наработок».

Источник

potustorony.ru

Три закона роботехники - это... Что такое Три закона роботехники?

Три зако́на роботе́хники в научной фантастике — обязательные правила поведения для роботов, впервые сформулированные Айзеком Азимовым в рассказе «Хоровод» (1942).

Законы гласят:

Оригинальный текст (англ.)

|

Трём Законам, а также возможным причинам и следствиям их нарушения, посвящён цикл рассказов Азимова о роботах.