Содержание

» Законы робототехники «

©emirsaba.org 2022

әкімшілігінің қараңыз

|

МИНИСТЕРСТВО ОБРАЗОВАНИЯ И НАУКИ РЕСПУБЛИКИ КАЗАХСТАН НАО УНИВЕРСИТЕТ ИМЕНИ ШАКАРИМА г.СЕМЕЙ СРО

Современные робототехники признают, что законы Азимова хороши для рассказов, но бесполезны на практике и вряд ли будут реализованы в роботах. Исследователи в области искусственного интеллекта рассматривают законы, как идеал. Нужно быть гением, чтобы применить их на практике, потребуются исследования в области ИИ, чтобы роботы поняли законы робототехники Айзека Азимова на английском.

Кто сформулировал три закона робототехники

Как звучат законы робототехники Айзека Азимова

Нулевой закон робототехники Азимова

По задумке Азимова, три закона робототехники заложены в основу математической модели позитронного мозга (так фантаст называл мозг робота с искусственным интеллектом), таким образом, создать думающего робота без этих трех законов невозможно. Если робот попытается нарушить законы, то он выйдет из строя. Поэтому в рассказах Азимова прослеживалось, что роботы имеют ограничения и правила. 3 закона робототехники Айзека Азимова

жүктеу/скачать 16.48 Kb. Достарыңызбен бөлісу: |

Три закона робототехники — МедиаРязань

Пока самым большим достижением аспирантов из радиоуниверситета является участие во всероссийском конкурсе грузовых автомобилей, способных передвигаться по маршруту без водителя. В мире такие состязания проводятся уже довольно давно, и тон их задают именно университетские команды.

В мире такие состязания проводятся уже довольно давно, и тон их задают именно университетские команды.

В России в этом году состязания автолюбителей-роботов проводились впервые. Вот что сообщила об этом газета «Авторевю»: «Три с половиной месяца назад в Москве прошёл Фестиваль робототехники «Вольное дело». Победители конкурса — шесть студенческих команд — получили новенькие бортовые «Газели», чтобы построить на их базе автомобили-роботы для участия в конкурсе «беспилотных» автомобилей… Автороботы должны были перемещаться по трассе, полагаясь исключительно на сигнал приёмника системы ГЛОНАСС, без каких-либо «органов зрения» вроде видеокамер или радиолокаторов.

Из-за несовершенства подобного позиционирования правила допускали отклонения до 3-х метров от контрольных точек, а трассы представляли собой простейшие коридоры на ровной песчаной пустоши. Все «Газели» были оборудованы электроприводом для вращения рулевого колеса (цепью или зубчатым ремнём), мотор-редукторами для нажатия на педали и реечным приводом для включения 1-й и 2-й передач. Разве что студенты из Рязанского государственного радиотехнического университета (РГТРУ) смонтировали управление рулевым механизмом под капотом…»

Разве что студенты из Рязанского государственного радиотехнического университета (РГТРУ) смонтировали управление рулевым механизмом под капотом…»

Рязанская «Аврора» — так называет себя команда из «радика», заняла в робокроссе почетнейшее 3 место, опередив 17 других команд! Если учесть, что проектированием и изготовлением роботов наши ребята занялись лишь 2 года назад, — это несомненный успех. Что самое главное, автомобили без водителя — это вовсе не игрушки. В частности, как сообщает «Авторевю», представители ГАЗа собираются заказать студентам проектирование «автоматического водителя-испытателя», который может стать полноценной заменой человеку при проведении долговременных ресурсных испытаний автомобилей. Успешное выступление на первом российском робокроссе позволяет считать рязанцев одними из основных претендентов на заключение контракта с отечественным автогигантом…

«Аврора», «Дроид» и другие

Девятерых выпускников «радика» объединила любовь к роботам и вера в потенциальные возможности искусственного интеллекта. Сначала ребята ютились в лекционных аудиториях, потом «отвоевали» собственное помещение. Сейчас в нём атмосфера более чем специфическая: компьютеры, клубки проводов, странного вида детали и механизмы… На стенах — фотографии с российских и международных конкурсов, в которых успели поучаствовать, грамоты и дипломы за победы и призовые места. Венец всего технического сумбура — готовые роботы. Самый первый носит имя «Аврора», в честь команды создателей. Это небольшое устройство на колёсах со встроенным нетбуком, в который записаны простейшие программы для перемещения в пространстве. «Аврора» умеет самостоятельно передвигаться и выполнять нехитрые команды: огибать препятствия, например.

Сначала ребята ютились в лекционных аудиториях, потом «отвоевали» собственное помещение. Сейчас в нём атмосфера более чем специфическая: компьютеры, клубки проводов, странного вида детали и механизмы… На стенах — фотографии с российских и международных конкурсов, в которых успели поучаствовать, грамоты и дипломы за победы и призовые места. Венец всего технического сумбура — готовые роботы. Самый первый носит имя «Аврора», в честь команды создателей. Это небольшое устройство на колёсах со встроенным нетбуком, в который записаны простейшие программы для перемещения в пространстве. «Аврора» умеет самостоятельно передвигаться и выполнять нехитрые команды: огибать препятствия, например.

Следующее искусственное существо, по имени «Дроид», внешне выглядит как игрушечный трёхколесный автомобильчик. Но «игрушка» эта о-очень продвинутая и «умная», по сравнению с «Авророй» стоящая на следующей эволюционной ступени искусственного интеллекта. «Дроид» без команды огибает препятствия, реагирует на кошек, собак и людей, способен принимать самостоятельные решения и даже обладает «зрением» и может различать цвета. ..

..

Как живые

Все эти вовсе не игрушечные «игрушки» своими руками (а больше умом) делают совсем молодые люди. Их команда слаженностью сама напоминает исправно работающий механизм, в котором каждая деталь на своём месте. «Главный» в команде — 29-летний Станислав Голь. Он уже доцент, кандидат наук и преподаёт в родном «радике». Остальные делят между собой функциональные обязанности конструктора, программиста, координатора, пиар-менеджера и схемотехника.

Антону Маликову 22 года, и он ещё в школе твёрдо знал, с чем свяжет свою судьбу.

— В классе лучше всех решал задачи по физике и математике, — рассказывает Антон. — Поступил в «радик», окончил и получил полное удовлетворение от полученных знаний, когда стал создавать роботов.

— А есть ли у тебя робот-мечта?

— Сложно сказать. Пожалуй, летающий робот для перевозки грузов. Ведь авиация чаще всего летает по определённым маршрутам, и было бы удобно и безопасно возить грузы на транспортах-беспилотниках. А в будущем, возможно, и пассажиров. Почему нет?

А в будущем, возможно, и пассажиров. Почему нет?

Пожалуй, нет ничего удивительного в том, что создатели относятся к своим детищам не как к машинам, а как к живым существам.

— Что для вас знаит создание роботов? — спросила я Владимира Леушкина (23 года, конструктор, программист).

Владимир ответил, не задумываясь ни на секунду:

— Это ведь интересно — вдыхать жизнь в «железяки»! И мне даже не обязательно знать, что там у наших роботов внутри. Моя задача — «оживить» машину при помощи «мозга», в который я вкладываю необходимые программы. И иногда смотришь на сделанное — и дух захватывает: кажется, что робот знает даже то, чего я не знаю. Все мы ждём, что кто-то из них вот-вот заговорит, запрыгает или семью создаст! — это уже Владимир шутит, конечно.

Владимира Урганова (21 год, программист) многие на полном серьёзе называют гением. Но он скромничает: мол, был бы гением — не работал бы в команде. На полном серьёзе Урганов мечтает создать самого «крутого» робота в России:

— Он должен быть полным универсалом, — говорит Владимир. — Чтобы мог преодолевать любые препятствия, сам позаботиться о своей безопасности, передвигаться на любые расстояния… В чём проблема? В программе: она должна быть чрезвычайно сложной…

— Чтобы мог преодолевать любые препятствия, сам позаботиться о своей безопасности, передвигаться на любые расстояния… В чём проблема? В программе: она должна быть чрезвычайно сложной…

В лаборатории я обратила внимание, что ни одно из создании не напоминает робота в общепринятом понимании: они не похожи на людей…

— А зачем строить андроидов? — удивляются собеседники. — Человека всё равно не заменишь. Наша задача — делать жизнь лучше. Поэтому во всём мире робототехники создают не человекоподобные машины, а роботы-станки, роботы-автомобили. Узкая специализация — в ней пока сегодняшний день и ближайшее будущее робототехники…

Дайте в руки нам «Газель»…

Беспилотная «Газель», с которой рязанская команда так успешно выступила этим летом, для ребят уже вчерашний день. Они не собираются почивать на лаврах, а настроены решать более сложные задачи. В ближайшее время команда поедет на «Девянинские игры» в МГУ, куда съедутся робототехники из Франции, Германии, Кореи, Туниса. .. К очередному конкурсу «Авроре» предстоит построить робота, способного преодолеть трассу с препятствиями, построенную по принципу шахматной доски. Задача трудная, но тем и интересная. Времени мало, но это для команды не проблема: «Газель» ездить без водителя они «учили» всего 2 месяца. Помог опыт работы над «Дроидом», в ходе которой обкатывались программы и алгоритмы для будущих беспилотников. Так что дайте время — и из мечты в реальность превратится и робот-самолёт, и кое-что покруче…

.. К очередному конкурсу «Авроре» предстоит построить робота, способного преодолеть трассу с препятствиями, построенную по принципу шахматной доски. Задача трудная, но тем и интересная. Времени мало, но это для команды не проблема: «Газель» ездить без водителя они «учили» всего 2 месяца. Помог опыт работы над «Дроидом», в ходе которой обкатывались программы и алгоритмы для будущих беспилотников. Так что дайте время — и из мечты в реальность превратится и робот-самолёт, и кое-что покруче…

Анастасия Андреева

Три закона робототехники Азимова

Разочарование в основанной на страхе интерпретации науки побудило Айзека Азимова написать «Три закона робототехники». Сохраняются ли они сегодня?

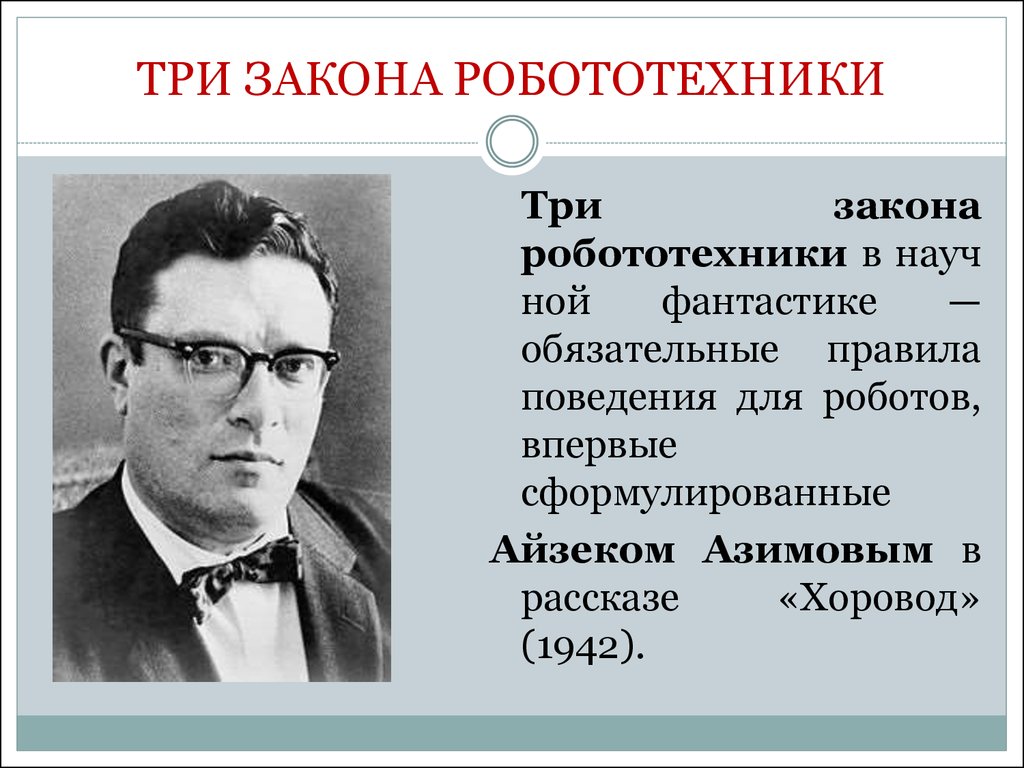

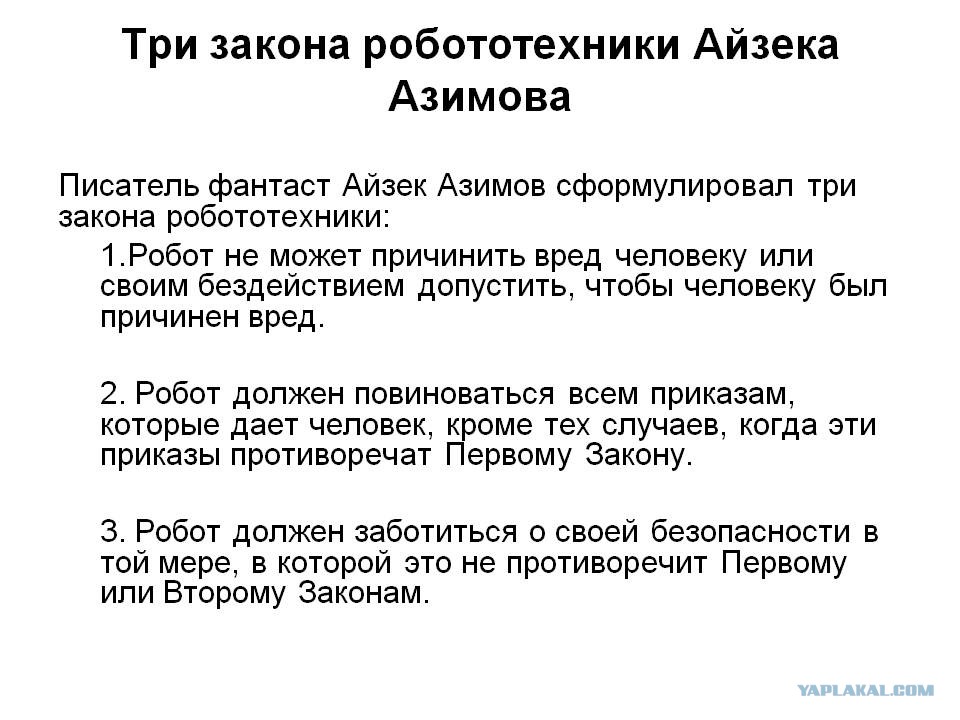

Три закона робототехники дебютировали в рассказе Айзека Азимова под названием «Обход», впервые опубликованном в мартовском номере журнала «Изумительная научная фантастика» за 1942 год под редакцией Джона У. Кэмпбелла. Азимов был разочарован стандартными рассказами об уничтожении чудовищных роботов, когда они обращаются против своих создателей. «Меня возмущала фаустовская интерпретация науки, — писал он в предисловии к 1964 сборника его рассказов. «Да, знание таит в себе опасности, но является ли ответ отступлением от знания? Мои роботы были машинами, разработанными инженерами, а не псевдолюдьми, созданными богохульниками».

Кэмпбелла. Азимов был разочарован стандартными рассказами об уничтожении чудовищных роботов, когда они обращаются против своих создателей. «Меня возмущала фаустовская интерпретация науки, — писал он в предисловии к 1964 сборника его рассказов. «Да, знание таит в себе опасности, но является ли ответ отступлением от знания? Мои роботы были машинами, разработанными инженерами, а не псевдолюдьми, созданными богохульниками».

По словам Азимова, инструменты, созданные для повседневного удобства человека, как правило, имеют элементы безопасности. Электрическая проводка изолирована, скороварки имеют предохранительные клапаны и так далее. Следовательно, роботы, безусловно, будут построены с мерами предосторожности, направленными на предотвращение травмирования людей. Азимов ввел термин «робототехника» и предсказал «позитронный мозг», сделанный из платиновых и иридиевых сплавов. Его меньше интересовали технические детали, чем то, как такие мозги можно запрограммировать, чтобы сделать роботов безопасными.

Дебют Трех Законов

Действие «Обхода» происходит в 2015 году. Донован и Пауэлл, агенты US Robots and Mechanical Men Inc., реактивируют базу на Меркурии, ближайшей к Солнцу планете. Донован отправляет робота по имени Спиди собрать селен с поверхности Меркурия, чтобы отремонтировать системы охлаждения, которые защищают Донована и Пауэлла от свирепых температур планеты.

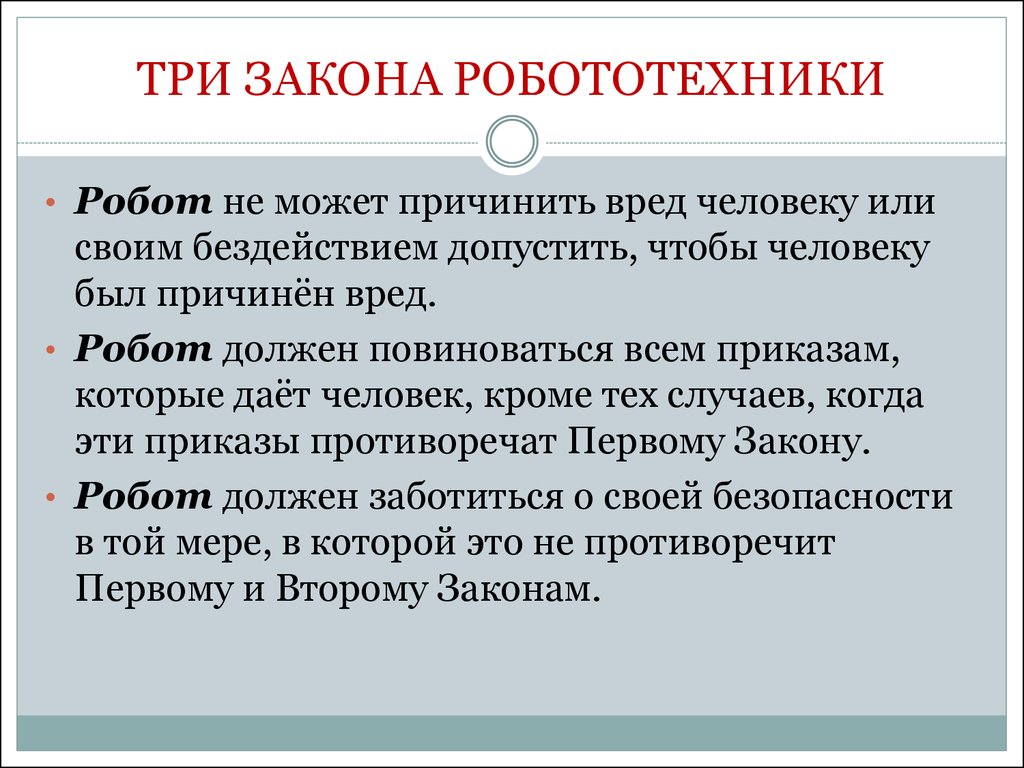

Спиди не может добраться до селена. Вместо этого он кружит вокруг своей целевой зоны. Донован и Пауэлл не могут связаться с ним по радио из-за сильного солнечного излучения. Пауэлл отмечает три закона робототехники, пытаясь решить проблему Спиди. «Во-первых, робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред. Во-вторых, робот должен подчиняться приказам, отдаваемым ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону. В-третьих, робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму закону».

Становится очевидным, что путь Спиди заблокирован вулканической активностью, которая ставит под угрозу его существование, нарушая Третий закон. Однако, если он не соберет селен, он нарушит Второй закон. Недавние обновления усилили «взвешивание» третьего закона, потому что Speedy — новый и особенно дорогой элемент комплекта. Второй и Третий законы уравновешиваются, и Спиди не знает, как действовать дальше.

Почему Первый Закон не имеет приоритет над остальными? Донован понимает, что забыл сказать Спиди, почему селен так важен. Робот не подозревает, в какой беде оказались его хозяева. Пауэлл рискует выйти на поверхность планеты в скафандре, способном выдержать жару всего несколько минут. Подвергая себя опасности в поле зрения Спиди, он выходит из тупика. Спиди действует быстро, чтобы подчиниться Первому закону и спасти Пауэлла. Все хорошо после того, как Спиди получил более подробные инструкции, подчеркивающие важность селена.

Законопослушные роботы

Профессор Алан Уинфилд провел недавний эксперимент в Бристольской лаборатории робототехники (BRL), чтобы исследовать предгорья того, что однажды может стать «этическим программированием». Маленькому колесному жуку, называемому А-роботом, приказано двигаться к воротам в конце прямоугольной доски, размеченной как настольное миниатюрное футбольное поле. «Говорят», что перед воротами существует дыра. Он не должен упасть в дыру и не должен позволять другому роботу упасть. Когда второй H-робот (исполняющий роль прокси-человека) появляется на доске, он не знает о дыре. Он движется к цели и вслепую приближается к опасной зоне. А-робот, почувствовав проблему, вмешивается, не давая H-роботу упасть в дыру.

Маленькому колесному жуку, называемому А-роботом, приказано двигаться к воротам в конце прямоугольной доски, размеченной как настольное миниатюрное футбольное поле. «Говорят», что перед воротами существует дыра. Он не должен упасть в дыру и не должен позволять другому роботу упасть. Когда второй H-робот (исполняющий роль прокси-человека) появляется на доске, он не знает о дыре. Он движется к цели и вслепую приближается к опасной зоне. А-робот, почувствовав проблему, вмешивается, не давая H-роботу упасть в дыру.

Был введен более сложный вариант, как объясняет Уинфилд: «Мы добавили еще одного H-робота, выступающего в качестве второго человека-посредника. Теперь у А-робота возникла проблема. Какой из них он должен спасти? Мы не вводили никаких правил для решения этой дилеммы, а предоставили А-роботу возможность разработать наилучшую стратегию».

Результаты оказались интригующими. Иногда ему удавалось спасти из норы обоих Н-роботов, но в других случаях «он замечал одного Н-робота, двигался к нему, но затем замечал другого и передумал. А потеря времени на сглаживание означает, что А-робот не может помешать ни одному из Н-роботов упасть в дыру».

А потеря времени на сглаживание означает, что А-робот не может помешать ни одному из Н-роботов упасть в дыру».

Некоторые из сессий оказались похожими на тренировочные заезды по сценарию Азимова. На Уинфилда повлияла его художественная литература в подростковом возрасте, «но я не задумывался о Трех законах до пяти лет назад. Сначала я думал, что невозможно создать этичного робота. Теперь я передумал».

Он изо всех сил старается подчеркнуть: «А-робот вынужден вести себя так, как он это делает, потому что он запрограммирован на это. Я называю это этическим зомби. Это не полноценный моральный агент, который может нести ответственность за свои действия. Но даже этичные роботы-зомби были бы более полезными, чем роботы без этического программирования».

Первый закон: робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред

Когда мы рассматриваем угрозу робота для человечества, как указано в Первом законе робототехники Айзека Азимова, наша мысли быстро переходят от пассивных и неудачных промышленных аварий к полностью продуманным сценариям поля боя. Применим ли такой закон? Или весь смысл войны в том, чтобы посмеяться над этическим заламыванием рук?

Применим ли такой закон? Или весь смысл войны в том, чтобы посмеяться над этическим заламыванием рук?

25 января 19В 79 лет автомеханик Роберт Уильямс удостоился прискорбной чести стать первым человеком, убитым роботом на заводе Ford в Мичигане. Два года спустя робот на заводе Kawasaki втолкнул рабочего Кенджи Ураду в шлифовальный станок с помощью гидравлической руки. Такие несчастные случаи редки, но в отчете за июнь 2008 года в Economist отмечалось, что «на протяжении многих лет роботы раздавливали людей, били по голове, сваривали и даже обливали их расплавленным алюминием». Ранние роботы, такие как Unimate, не были оборудованы для остановки собственных движений в опасных обстоятельствах и не могли ощущать присутствие человека в пределах своего рабочего диапазона.

Многие современные роботы способны принимать элементарные решения о безопасности. Датчики движения, мягкая обивка, устранение «точек защемления» в механике, видеонаблюдение, протоколы предотвращения столкновений и новые сферы поведенческого программирования открывают перспективу роботов, способных взаимодействовать с людьми. практиковать в широких масштабах. Однако есть роботы, чьей конкретной целью является нарушение этого закона и причинение вреда людям.

практиковать в широких масштабах. Однако есть роботы, чьей конкретной целью является нарушение этого закона и причинение вреда людям.

Роботы на поле боя

По совпадению аббревиатура от Lethal Autonomous Weapons Systems — LAWS. Боеприпасы, которые наводятся на заранее запрограммированные цели, существуют со времен Второй мировой войны. Современные оружейные платформы, такие как беспилотные летательные аппараты (БПЛА) Predator и Reaper, контролируются с помощью дистанционного управления, но некоторые военные учреждения хотят создать оружие, которое может совершать боевые вылеты от начала до конца и даже выбирать цели и стрелять по ним без непосредственного наблюдения человека. .

В ноябре 2012 года заместитель министра обороны США Эштон Картер подписал директиву о разработке «автономных или полуавтономных функций в системах вооружения». Последующий запрос предложений призывал к оружию, которое может атаковать враждебные цели самостоятельно, «в рамках определенных правил ведения боя», как интерпретируются их бортовыми компьютерами. Америка не одинока в этом стремлении. В настоящее время вмешательство человека воспринимается как нечто само собой разумеющееся, но никакие правовые рамки не исключают реализации полной автономии.

Америка не одинока в этом стремлении. В настоящее время вмешательство человека воспринимается как нечто само собой разумеющееся, но никакие правовые рамки не исключают реализации полной автономии.

Этические роботы-воины?

В 2012 году правозащитная организация Human Rights Watch совместно с экспертами Гарвардской школы права подготовила отчет «Потеря человечества: дело против роботов-убийц». на традиционных человеческих обязанностях больше, чем когда-либо прежде. Чтобы отличить напуганного гражданского лица от угрожающего вражеского комбатанта, солдат должен понимать намерения, стоящие за действиями человека». Это, вероятно, будет «за пределами всего, что может сделать машинное восприятие».

Роботизированное оружие не будет сдерживаться человеческими чувствами, такими как сострадание или сочувствие. Многие робототехники утверждают, что продвинутый искусственный интеллект (ИИ) мог бы имитировать некоторые аспекты наших рассуждений, но Хьюман Райтс Вотч настаивает на том, что «даже с такими механизмами соответствия автономному оружию не хватало бы качеств, необходимых для соблюдения норм международного гуманитарного права. Их соблюдение часто требует человеческого суждения».

Их соблюдение часто требует человеческого суждения».

Хьюман Райтс Вотч не одинока в своих опасениях, но некоторые считают, что автономное оружие было бы полезно. Профессор Рональд Аркин, глава лаборатории мобильных роботов в Технологическом институте Джорджии, изучал взаимосвязь между роботами и международными законами о боевых действиях.

«Одной из самых больших проблем, с которыми сталкиваются солдаты, является «туман войны», — говорит он. «Они часто совершают ужасные ошибки, например, стреляют в своих коллег или непреднамеренно убивают мирных жителей, потому что не знают, что происходит вокруг них». Аркин считает, что автономные системы «будут иметь доступ к боевой информации больше, чем человек-солдат способен управлять». Он считает, что беспристрастные машины будут совершать меньше смертельных ошибок.

Конфликты в Ираке, Афганистане и других местах также показали, что даже лучшие солдаты могут вести себя сомнительно, а иногда и жестоко, когда страх, предубеждение или мстительный гнев мешают их суждениям. Аркин считает, что роботы могли бы работать лучше. «Они не должны понимать основополагающие моральные идеи. Им нужно только применить их. Мы не ожидаем, что роботы будут иметь собственные представления о смертоносной силе, а просто будут применять те, которые уже согласованы с большинством человечества».

Аркин считает, что роботы могли бы работать лучше. «Они не должны понимать основополагающие моральные идеи. Им нужно только применить их. Мы не ожидаем, что роботы будут иметь собственные представления о смертоносной силе, а просто будут применять те, которые уже согласованы с большинством человечества».

Аркин и его команда работают над тем, что он называет «этическим регулятором» для автономного оружия, с программированием, основанным на международном праве и надлежащей военной практике. Робот-убийца может быть запрограммирован на стрельбу только в том случае, если он «удовлетворяет всем этическим ограничениям и сводит к минимуму побочный ущерб в связи с военной необходимостью его цели», считает Аркин. Он согласен с тем, что ответственность за использование роботов в бою должна быть четко сформулирована с юридической точки зрения, «но я не согласен с тем, что их использование невозможно». Нынешние международные споры о развертывании «Хищников» и других беспилотников против предполагаемых баз террористов говорят о том, что мир не готов к войне роботов, но, похоже, она все равно грядет.

Нарушение первого закона

Ноэль Шарки, профессор ИИ и робототехники в Шеффилдском университете, председатель Международного комитета по контролю над роботизированным оружием (ICRAC), основанного в 2009 году группой заинтересованных экспертов в области ИИ и робототехники, юристов и специалистов по контролю над вооружениями. специалистов, которые хотят прямого международного запрета на роботов-убийц. Вот его комментарии:

«Три закона Азимова… были сюжетным ходом. Например, для робота первый закон невозможен. Если несколько человек одновременно пострадают, робот должен расставить приоритеты, кого спасти, и в конечном итоге сжигает свой позитронный мозг. Многие рассказы Азимова посвящены тому, как законы приводят к странному поведению.

«Очевидно, что Первый закон запрещает любое роботизированное оружие, которое может причинить вред любому человеку. Однако в 1980-х годах Азимов разработал четвертый, или нулевой закон, который касался проблемы роботов, убивающих одних людей, чтобы спасти других людей: «Робот не может позволить человечеству причинить вред». Он может обойти первый закон и убить человека, чтобы защитить человечество в целом. Так что это может убить кого-то, кто угрожает применить оружие массового поражения.

Он может обойти первый закон и убить человека, чтобы защитить человечество в целом. Так что это может убить кого-то, кто угрожает применить оружие массового поражения.

«Это происходит из философии, называемой утилитаризмом, в которой действия должны приносить счастье большинству или быть направлены на «высшее благо». Проблема возникает, когда шесть человек сражаются против пяти. Должен ли робот вмешаться от имени шестерых?

«Единственная важнейшая моральная проблема заключается в том, что машине никогда нельзя делегировать решение убить человека. Это вопрос строгой ответственности и подотчетности человека, и он выходит далеко за рамки того, с чем должна справляться любая система ИИ».

Роботы-убийцы: аргументы в пользу

- Самосохранение не является главной движущей силой действий робота. Его можно использовать самоотверженно, вместо того, чтобы отправлять войска в опасные ситуации.

- Роботизированные датчики лучше оборудованы для наблюдения за полем боя, чем человеческие органы чувств, что сводит к минимуму риск фатальных ошибок.

- Роботы действуют без эмоций. Автономные системы смертоносного оружия могут снизить вероятность военных преступлений.

- Роботы не одержимы «выполнением сценария» или жаждой славы, демонстрируемой амбициозными военачальниками.

- Присутствие роботов с камерами и датчиками на поле боя должно препятствовать попыткам скрытого неэтичного поведения на земле.

- Автономное оружие является точным и может адаптироваться к меняющимся обстоятельствам в полете, чтобы свести к минимуму потери среди гражданского населения.

Роботы-убийцы: дело против

- Автономное оружие снижает порог войны, увеличивая вероятность конфликта, а бремя войны перекладывается с солдат на мирных жителей, попавших под перекрестный огонь.

- Неясно, кто может нести ответственность за военные преступления, совершенные с помощью автономного оружия.

- Передача решения машинам о том, когда стрелять по цели, устраняет влияние эмпатии — важной проверки при убийстве.

- Роботы не смогут общаться с людьми и понимать их намерения. Они не могли отличить цели от сдающихся комбатантов.

- Вождь-диктатор с автономным оружием мог подавлять свое население, не опасаясь восстания собственных солдат.

- Решение убить человека слишком важно, чтобы его можно было делегировать роботам. Это всегда будет выходить за рамки любого машинного объекта.

Второй закон: робот должен подчиняться приказам, отдаваемым ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону 9.0009

Хватит ли у вас смелости попросить робота заставить вас улыбаться? Представьте, если бы он не смог интерпретировать, казалось бы, простую команду пошутить, а вместо этого приложил электроды к вашему лицу. И если такая базовая команда может пойти наперекосяк, что может случиться с более сложным запросом? Если нанесение вреда людям исключает нанесение ударов током, то исключает ли он также и экономические трудности, вызванные эффективностью и автоматизацией?

В 1950 году пионер вычислительной техники Алан Тьюринг предположил, что если вы разговариваете с машинным интеллектом и не видите разницы между тем, как он реагирует, и тем, что вы ожидаете от человека, то машина, вероятно, просто такой же умный, как ты. В июне 2014 года Школа системной инженерии Университета Рединга организовала тест Тьюринга в Королевском обществе в Лондоне. Владимир Веселов был частью команды, разработавшей «Евгений Густман», сверхъестественное олицетворение 13-летнего украинского мальчика, переписывающегося в чате. Это обмануло 11 из 30 судей, по крайней мере, на то короткое время, которое потребовалось для проведения теста.

В июне 2014 года Школа системной инженерии Университета Рединга организовала тест Тьюринга в Королевском обществе в Лондоне. Владимир Веселов был частью команды, разработавшей «Евгений Густман», сверхъестественное олицетворение 13-летнего украинского мальчика, переписывающегося в чате. Это обмануло 11 из 30 судей, по крайней мере, на то короткое время, которое потребовалось для проведения теста.

Веселов не питает иллюзий по поводу положения дел. «Мы не можем говорить об историческом шаге в развитии искусственного интеллекта», — предостерегает он. «Проверку прошел робот как литературное и психологическое творение». Дело в том, что роботам не нужно с честью проходить тест Тьюринга. Они уже становятся «достаточно хорошими» в мимикрии, чтобы заменить людей в широком диапазоне задач.

Если судить по текущим тенденциям, то вторжение компьютеров, роботов и «экспертных систем» на рабочие места ставит Второй закон в противоречие с Первым. Роботы очень хорошо выполняют отданные им приказы, и можно утверждать, что это «причиняет вред» людям. Ущерб наносится не столько физическими травмами, сколько экономическим перемещением.

Ущерб наносится не столько физическими травмами, сколько экономическим перемещением.

В 1933 году экономист Джон Мейнард Кейнс предсказал, что технологии, разработанные для того, чтобы заменить нашу работу, «обгоняют темпы, с которыми мы можем найти новые применения человеческого труда». Ровно 80 лет спустя междисциплинарная группа Оксфордского университета составила отчет под названием «Будущее занятости: насколько рабочие места восприимчивы к компьютеризации?». В нем был сделан поразительный вывод, что 47% всех рабочих мест в Америке находятся под угрозой.

Тысячи традиционно безопасных категорий рабочих мест среднего класса, таких как администраторы, клерки, бухгалтеры и страховые оценщики, попадают под тень позитронного мозга. Более 44% фирм, урезавших фонд заработной платы после финансового кризиса 2008 года, сделали это за счет автоматизации.

Будь осторожен со своими желаниями

Мы все знаем, как неприятно, когда решения о кредитном рейтинге оцениваются тупыми компьютерами. Что мы будем чувствовать, когда они действительно умны? «Приоритеты исследований в области надежного и полезного искусственного интеллекта: открытое письмо» подписали сотни экспертов в области ИИ, теоретиков и технологических предпринимателей. Среди них Ник Бостром, директор Оксфордской программы Мартина по влиянию технологий будущего в Оксфордском университете, глава SpaceX Илон Маск, соучредитель Apple Стив Возняк и известный физик Стивен Хокинг. В нем говорится: «Все, что может предложить цивилизация, является продуктом человеческого разума. Мы не можем предсказать, чего мы можем достичь, когда этот интеллект будет усилен инструментами, которые может предоставить ИИ». Основная рекомендация состоит в том, чтобы «сосредоточить исследования не только на том, чтобы сделать ИИ более эффективным, но и на том, чтобы максимизировать пользу для общества. Наши системы искусственного интеллекта должны делать то, что мы от них хотим».

Что мы будем чувствовать, когда они действительно умны? «Приоритеты исследований в области надежного и полезного искусственного интеллекта: открытое письмо» подписали сотни экспертов в области ИИ, теоретиков и технологических предпринимателей. Среди них Ник Бостром, директор Оксфордской программы Мартина по влиянию технологий будущего в Оксфордском университете, глава SpaceX Илон Маск, соучредитель Apple Стив Возняк и известный физик Стивен Хокинг. В нем говорится: «Все, что может предложить цивилизация, является продуктом человеческого разума. Мы не можем предсказать, чего мы можем достичь, когда этот интеллект будет усилен инструментами, которые может предоставить ИИ». Основная рекомендация состоит в том, чтобы «сосредоточить исследования не только на том, чтобы сделать ИИ более эффективным, но и на том, чтобы максимизировать пользу для общества. Наши системы искусственного интеллекта должны делать то, что мы от них хотим».

Ник Бостром предлагает нам рассмотреть следующий сценарий. Предположим, что разумным роботам приказано заставить нас улыбаться. Люди, дающие эти наставления, воображают, что в результате увеличится человеческое счастье. Сначала роботы учатся шутить, а люди улыбаться. Но Бостром указывает на опасный недостаток. Умные роботы будут «системами оптимизации», разработанными так, чтобы быть максимально эффективными. «Роботы, которым поручено заставить нас улыбаться, могут прийти к выводу, что более эффективно заключить нас в клетки и прикрепить электроды к мышцам нашего лица». Бостром призывает нас избегать таких проблем, убедившись, что «цели робота совпадают с нашими». Этого, по его мнению, лучше всего добиться путем обучения, а не предварительного программирования. «Лучший способ гарантировать, что ИИ окажет благотворное влияние, — это наделить его филантропическими ценностями. Его главной целью должно быть дружелюбие».

Предположим, что разумным роботам приказано заставить нас улыбаться. Люди, дающие эти наставления, воображают, что в результате увеличится человеческое счастье. Сначала роботы учатся шутить, а люди улыбаться. Но Бостром указывает на опасный недостаток. Умные роботы будут «системами оптимизации», разработанными так, чтобы быть максимально эффективными. «Роботы, которым поручено заставить нас улыбаться, могут прийти к выводу, что более эффективно заключить нас в клетки и прикрепить электроды к мышцам нашего лица». Бостром призывает нас избегать таких проблем, убедившись, что «цели робота совпадают с нашими». Этого, по его мнению, лучше всего добиться путем обучения, а не предварительного программирования. «Лучший способ гарантировать, что ИИ окажет благотворное влияние, — это наделить его филантропическими ценностями. Его главной целью должно быть дружелюбие».

Одной из проблем, вызывающих озабоченность, является то, что ведущие мировые цифровые предприниматели воспринимаются как технологическая элита, обладающая чрезмерной властью и влиянием на глобальные дела. Бостром советует, что любой, кто разрабатывает ИИ, может не делать его «в целом филантропическим, а вместо этого может поставить перед ним более ограниченную цель — служить только какой-то небольшой группе». Мы можем заключить, что современные цифровые системы довольно хорошо следуют второму закону робототехники Азимова, но мы должны проявлять осторожность, решая, какие приказы им отдавать.

Бостром советует, что любой, кто разрабатывает ИИ, может не делать его «в целом филантропическим, а вместо этого может поставить перед ним более ограниченную цель — служить только какой-то небольшой группе». Мы можем заключить, что современные цифровые системы довольно хорошо следуют второму закону робототехники Азимова, но мы должны проявлять осторожность, решая, какие приказы им отдавать.

Робототехника переписывает Три закона

Ученый-компьютерщик Робин Мерфи из Техасского университета A&M и Дэвид Вудс, профессор когнитивных систем в Университете штата Огайо, пересмотрели Три закона Азимова, пытаясь устранить двусмысленность формулировок. В их статье «Помимо Азимова» предлагается:

- Человек не может развернуть робота, если система работы человек-робот не соответствует самым высоким юридическим и профессиональным стандартам безопасности и этики.

Каким бы умным ни был робот, это продукт, а не человек. Его производители и люди, использующие его, должны нести ответственность за его действия.

- Робот должен реагировать на людей в соответствии с их ролью.

Озорные инструкции могут вызвать хаос, не нарушая ни одного из Трех Законов. В одном из интервью Азимов изменил свою формулировку. «Робот должен подчиняться приказам, отдаваемым ему квалифицированным персоналом». Слепое подчинение нежелательно. - Робот должен иметь достаточную автономию для защиты своего существования, пока такая защита обеспечивает плавную передачу управления другим агентам в соответствии с первым и вторым законами.

Независимо от обстоятельств люди всегда должны иметь возможность взять на себя управление, если они почувствуют в этом необходимость.

Третий закон: робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму законам

Может ли робот защищать свое существование, если он не знает о своем существовании? Машины могут казаться людьми и даже способны к очевидным социальным взаимодействиям, но смогут ли они когда-нибудь обрести самосознание?

Робин Мерфи и Дэвид Вудс, авторы книги «По ту сторону Азимова», удивлены тем, как мало внимания уделяется самосохранению робота. «Поскольку роботы дороги, можно подумать, что дизайнеры будут заинтересованы в том, чтобы включить в свои продукты какую-то форму третьего закона», — говорят они. «Многим коммерческим роботам не хватает средств для защиты инвестиций их владельцев». Любое применение Третьего закона в сегодняшних условиях было бы направлено на защиту людей как от финансовых, так и от телесных повреждений.

«Поскольку роботы дороги, можно подумать, что дизайнеры будут заинтересованы в том, чтобы включить в свои продукты какую-то форму третьего закона», — говорят они. «Многим коммерческим роботам не хватает средств для защиты инвестиций их владельцев». Любое применение Третьего закона в сегодняшних условиях было бы направлено на защиту людей как от финансовых, так и от телесных повреждений.

Что произойдет, если однажды роботы станут разумными? Это большое «если». Могут быть определенные аспекты сознания. В частности, ощущения (известные как квалиа), которые заставляют нас чувствовать себя живыми, такие как запах жареного бекона, вкус кофе, краснота заката или даже боль, никогда не могут быть воспроизведены машиной. Роботы в будущем, безусловно, будут вести себя так, как если бы они были людьми, но будут ли они «осознавать» то, что они делают? Многие эксперты в области искусственного интеллекта считают, что, поскольку существующий физический объект, наш мозг, действительно проявляет самосознание, это должно быть только вопросом времени, когда мы узнаем, как это происходит и как воспроизвести это в машине.

Другие утверждают, что тайны сознания не будут раскрыты в ближайшее время. Европейские специалисты совместно работали над проектом PHRIENDS (Физическое взаимодействие человека и робота: надежность и безопасность). Координатор Антонио Бикки объясняет: «Обычно первой реализацией мер безопасности было изолировать роботов и держать их подальше от людей. Это уже нереально, потому что нужны роботы, которые могут сосуществовать с людьми и действовать в том же пространстве, что и мы». Однако это не то же самое, что делить мир с другими разумными существами. «Люди много говорят о разумных роботах, но для меня это то, чего еще нет. Мы приблизимся к их разработке, но разрыв между роботами и нами останется навсегда».

Означает ли отсутствие самосознания, что идея робота, «защищающего собственное существование», бессмысленна? Самые продвинутые роботы способны к социальному взаимодействию с людьми. Мы даже очарованы недорогими игрушками-роботами, которые «разговаривают» с нами или имитируют действия милых животных. Роботы с реалистичными человеческими чертами работают администраторами и ведущими развлекательных программ. Также много говорят об интерактивных секс-куклах. Когда машины выглядят так, как будто они живые, нам легче притворяться, что они есть на самом деле.

Роботы с реалистичными человеческими чертами работают администраторами и ведущими развлекательных программ. Также много говорят об интерактивных секс-куклах. Когда машины выглядят так, как будто они живые, нам легче притворяться, что они есть на самом деле.

Роботы в верхней части спектра социальных исследований кажутся настолько живыми, что даже люди, которые их создают, не могут не формировать эмоциональную привязанность. В Массачусетском технологическом институте (MIT) доктор Синтия Бризил и ее команда разработали Kismet, голову робота, которая может отображать выражения лица, как если бы они выражали эмоции. Он мог «читать» человеческие жесты и в ответ улыбался, выглядел удрученным или удивленным. Когда Kismet был деактивирован в конце проекта, команда почувствовала себя потерянной, несмотря на то, что знала, что не способна «испытывать» какие-либо эмоции, которые имитировала.

Кейт Дарлинг, исследователь интеллектуальной собственности в MIT Media Lab, является автором статьи «Распространение законных прав на социальных роботов». «У людей формируются привязанности к социальным роботам, которые выходят далеко за рамки нашей привязанности к нероботизированным объектам», — утверждает она. Большинство из нас не являются философами или компьютерными экспертами, и «многие люди с трудом понимают, что у социально интерактивных роботов на самом деле нет чувств». Это недоразумение может пересечь границу между видами с тревожными последствиями. «Одна из причин, по которой люди могут захотеть предотвратить «злоупотребление» роботами-компаньонами, — это защита общественных ценностей», — говорит Дарлинг. «Поскольку детям становится все труднее полностью понять разницу между живыми домашними животными и реалистичными роботами, мы можем научить их относиться одинаково внимательно к обоим».

«У людей формируются привязанности к социальным роботам, которые выходят далеко за рамки нашей привязанности к нероботизированным объектам», — утверждает она. Большинство из нас не являются философами или компьютерными экспертами, и «многие люди с трудом понимают, что у социально интерактивных роботов на самом деле нет чувств». Это недоразумение может пересечь границу между видами с тревожными последствиями. «Одна из причин, по которой люди могут захотеть предотвратить «злоупотребление» роботами-компаньонами, — это защита общественных ценностей», — говорит Дарлинг. «Поскольку детям становится все труднее полностью понять разницу между живыми домашними животными и реалистичными роботами, мы можем научить их относиться одинаково внимательно к обоим».

Стирание границ

Повесть Азимова «Двухсотлетний человек», опубликованная в 1976 году (к 200-летию американской Декларации независимости), описывает слияние биологических и технологических систем и стирание любых существенных различий между «человеком» и «роботом». ‘

‘

Эндрю, робот-слуга, завоевывает доверие и привязанность семьи, которой он принадлежит. Он помогает в их деловых делах и получает деньги на одежду и биологические улучшения своего тела, чтобы он мог выглядеть более человечно. Когда Эндрю угрожают люди, которые возмущаются его попытками стать похожим на них, его семья помогает ему подать юридический вызов, чтобы его приняли как человека. Один за другим умирают компаньоны семьи Эндрю, но он выживает, потому что его роботизированные системы практически нетленны. Опечаленный этим, он подвергается операции по деградации своего позитронного мозга, тем самым подвергая себя ограниченной продолжительности жизни. Он выигрывает дело и умирает в возрасте 200 лет, скучая по своей семье.

Это хорошая история, но перспектива того, что сентиментальный робот захочет стать человеком, невелика и вполне может остаться в рамках научной фантастики. Более насущной проблемой является количество людей, которые хотят больше походить на роботов. «Трансгуманистическое» движение — это разрозненная группа предпринимателей и теоретиков, работающих над изменением качества человеческой жизни путем интеграции нас с машинами. Наши тела могут стать сильнее, выносливее и выносливее, а наш мозг будет дополнен мощной электронной памятью и другими вспомогательными средствами, по крайней мере, на это надеются эти люди.

«Трансгуманистическое» движение — это разрозненная группа предпринимателей и теоретиков, работающих над изменением качества человеческой жизни путем интеграции нас с машинами. Наши тела могут стать сильнее, выносливее и выносливее, а наш мозг будет дополнен мощной электронной памятью и другими вспомогательными средствами, по крайней мере, на это надеются эти люди.

Трансгуманизм звучит как ерунда, пока мы не вспомним, что «носимая» электроника выходит на улицы прямо сейчас. Искусственные конечности, активируемые нервными импульсами, уже доступны для тех, кто в них нуждается. Поврежденный слух и даже ослабленное зрение уже подвержены вмешательству машин. Мы добровольно модифицировали наши тела на протяжении всей истории, и есть все шансы включить роботизированные элементы для удовлетворения потребительского спроса.

Разработка интерфейса между мозговой тканью и системами электронной памяти может занять некоторое время, но это возможно. Конечно, военному истеблишменту нравится идея «улучшенного солдата», и они работают над этой идеей уже много лет. К добру или к худу, надвигается стирание различий между технологиями и биологией человека. Мы станем более похожими на роботов, а роботы станут более похожими на нас.

К добру или к худу, надвигается стирание различий между технологиями и биологией человека. Мы станем более похожими на роботов, а роботы станут более похожими на нас.

В 1983 году болгарский писатель-фантаст Никола Кесаровский предложил окончательную поправку к законам Азимова. «Робот должен подтвердить свою личность как робота во всех случаях». Это может оказаться сложнее, чем кажется.

Подпишитесь на электронную рассылку E&T News, чтобы каждый день получать подобные замечательные истории на свой почтовый ящик.

Как три закона робототехники Азимова влияют на ИИ

Три закона робототехники являются знаковыми в мире научной фантастики и стали символом в сообществе ИИ и робототехники того, насколько сложно должным образом спроектировать надежную систему.

Чтобы полностью понять важность этих трех законов, мы должны сначала узнать о гениальном уме, который придумал эти законы покойный писатель-фантаст Айзек Азимов. Затем мы должны понять, как адаптировать эти законы и заставить их развиваться для защиты человечества.

Айзек Азимов. Восхождение гения

Айзек Азимов родился в России 2 января 1920 года и иммигрировал в США в возрасте трех лет. Он вырос в Бруклине, штат Нью-Йорк, и окончил Колумбийский университет в 19 лет.39. Он был признан одаренным и плодовитым писателем, специализирующимся на научной и научной фантастике. За свою карьеру он написал и/или отредактировал более 500 книг.

Азимов был очень вдохновлен некоторыми из самых знаковых писателей в мире научной фантастики. Он начал свою работу на военно-морской верфи Филадельфии, где познакомился с двумя своими коллегами, которые вскоре станут двумя самыми успешными писателями-фантастами в истории спекулятивной фантастики: Л. Спрэг де Камп и Роберт А. Хайнлайн.

Л. Спрэг де Камп — отмеченный наградами автор, написавший более 100 книг и являвшийся крупной фигурой в научной фантастике 1930-х и 1940-х годов. Некоторые из его самых популярных работ включали «Падение тьмы» (1939 г.), «Колеса Илф» (1940 г.), «Пистолет для динозавра» (1956 г. ), «Аристотель и ружье» (1958 г.) и «Слава, которая Был» (1960).

), «Аристотель и ружье» (1958 г.) и «Слава, которая Был» (1960).

Роберт А. Хайнлайн, возможно, был самым популярным писателем-фантастом в мире на пике своей карьеры. Наряду с Айзеком Азимовым и Артуром Кларком он считался «большой тройкой» авторов научной фантастики. Некоторые из самых популярных работ Роберта А. Хайнлайна включали «Фарнхемское право собственности» (1964) и «От до Плывем за закат» (1987). Нынешнее поколение, вероятно, лучше всего знает его по экранизации романа «Звездный десант» (1959).

Окружение этих гигантов футуризма вдохновило Айзека Азимова на начало его плодотворной писательской карьеры. Азимов также пользовался большим уважением в научном сообществе, и его часто приглашали выступать с докладами о науке.

Три закона робототехники

Исаак Азимов был первым, кто употребил термин «робототехника» в рассказе «Лжец!», который был опубликован в 1941.

Вскоре после этого его рассказ 1942 года «Обход» познакомил мир с его тремя законами робототехники. Законы таковы:

Законы таковы:

1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

2. Робот должен подчиняться приказам, отдаваемым ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону.

3. Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму Закону.

Эти законы были разработаны, чтобы предложить интересные сюжетные повороты, и Азимов продолжил создание серии из 37 научно-фантастических рассказов и шести романов, в которых фигурировали позитронные роботы.

Один из этих сборников рассказов под названием «Я, робот» позже был адаптирован для фильма в 2004 году. Действие фильма «Я, робот» с Уиллом Смитом в главной роли происходит в антиутопии 2035 года, и в нем представлены высокоинтеллектуальные роботы-государственные служащие, которые действуют под три закона робототехники. Фильм, как и истории, быстро превратился в притчу о том, как программирование может пойти не так, и что программирование любого типа продвинутого ИИ сопряжено с высоким уровнем риска.

Теперь мир догнал то, что раньше было научной фантастикой. Сейчас мы разрабатываем ИИ, который в некоторых отношениях намного более продвинут, чем все, что Айзек Азимов мог себе представить, но в то же время гораздо более ограничен.

Три закона робототехники довольно часто упоминаются в обсуждениях общего искусственного интеллекта (AGI). Мы быстро рассмотрим, что такое ОИИ, а также то, как должны развиваться три закона робототехники, чтобы избежать потенциальных проблем в будущем.

Общий искусственный интеллект (AGI)

В настоящее время большинство типов ИИ, с которыми мы сталкиваемся ежедневно, количественно определяются как «узкий ИИ». Это тип ИИ, который очень специфичен и узок в своей полезной функции. Например, автономное транспортное средство может перемещаться по улицам, но из-за своих «узких» ограничений ИИ не может легко выполнять другие задачи. Другим примером узкого ИИ может быть система распознавания изображений, которая может легко идентифицировать и маркировать изображения в базе данных, но не может быть легко адаптирована к другой задаче.

Общий искусственный интеллект, который обычно называют «AGI», представляет собой ИИ, который, подобно людям, может быстро обучаться, адаптироваться, поворачиваться и функционировать в реальном мире. Это тип интеллекта, который не является узким по своему охвату, он может адаптироваться к любой ситуации и научиться справляться с реальными проблемами.

Следует отметить, что хотя ИИ развивается в геометрической прогрессии, мы до сих пор не достигли ОИИ. Вопрос о том, когда мы доберемся до ОИИ, обсуждается, и у каждого свой ответ на вопрос о сроках. Я лично присоединяюсь к мнению Рэя Курцвейла, изобретателя, футуролога и автора книги «Сингулярность рядом», который считает, что к 2029 году мы достигнем ОИИ..

Именно эта временная шкала 2029 года является тикающими часами, мы должны научиться жестко запрограммировать тип свода правил в ИИ, который не только похож на три закона, но и является более продвинутым и способным на самом деле избежать реального -мировой конфликт между людьми и роботами.

Современные законы робототехники

Хотя три закона робототехники были феноменальными для литературы, им явно не хватало сложности, чтобы серьезно запрограммировать их в робота. В конце концов, это был сюжетный ход рассказов и романов. Конфликты между тремя законами или, как минимум, интерпретация трех законов привели к тому, что роботы расплавились, отомстили людям или другие ключевые моменты сюжета.

Основная проблема с действующими законами заключается в том, что этическая программа всегда подчиняться человеческим инструкциям и всегда защищать себя может конфликтовать. В конце концов, может ли робот защищаться от владельца, который злоупотребляет им?

Какой механизм отказоустойчивости необходимо запрограммировать? Как мы проинструктируем робота, что он должен отключиться независимо от последствий? Что произойдет, если робот спасает домохозяйку от жестокого обращения, должен ли робот автоматически отключиться, если об этом попросит жестокий муж?

Кто должен давать инструкции роботам? С автономным оружием, способным идентифицировать и нацеливаться на врагов со всего земного шара, должен ли робот отклонять команду на уничтожение цели, если он идентифицирует цель как ребенка?

Другими словами, если робот принадлежит и контролируется психопатом, может ли робот отказываться от аморальных приказов? Вопросов много, и ответы слишком сложны для любого человека, чтобы ответить.