Содержание

AlphaGo: что это за программа и как она навсегда перевернула мир ИИ?

Кинематограф постоянно твердит нам, что в скором времени искусственный интеллект захватит Землю и поработит всех людей, а предвестниками такого расклада являются программы типа «АльфаГо».

АльфаГо — это несколько версий программ на основе искусственного интеллекта, которые играют в игру Го. Из всех версий этой программы настоящий фурор навела версия AlphaGo Zero, которая обыграла в Го все предыдущие версии этой программы и чемпиона мира по этой игре. Но самое важное, что AlphaGo Zero тренировалась самостоятельно и без вмешательства людей. А как мы знаем, любой искусственный интеллект обучается и тренируется только при помощи человека.

Что это за игра такая — «Го»

Го — это очень старая настольная игра, по разным данным, ей около 5000 лет. Суть ее в том, что:

есть игровое поле, которое расчертили перпендикулярными линиями на множество «квадратиков»;

в нее играют 2 игрока с черными и белыми камнями;

в порядке очереди игроки расставляют камни в местах пересечения линий;

когда камни одного цвета окружают со всех сторон камни другого цвета, то те камни, что внутри, снимаются с игрового поля;

победу одерживает тот, кто к концу игры «окружил» максимальную площадь территории.

Там есть и другие правила, но для понимания того, что такое «АльфаГо», этого будет достаточно.

Сложная ли игра Го?

Не все понимают, что такое игра Го и насколько она сложная. Но многие знают такие игры, как шашки и шахматы, поэтому давайте сравним игру Го с ними.

Когда игрок играет в шашки, у него есть примерно 10 вариантов, как осуществить ход, поэтому шашки считаются не очень сложной игрой. Однако в 1994-м году была написана программа, которая в том же году обыграла чемпиона мира по шашкам.

Когда игрок играет в шахматы, то у него в течение игры в среднем появляется около 25 вариантов, как осуществить ход. И таких ходов у него может быть около 45 за игру. Однако в 1997 году была создана программа, которая выиграла партию у тогдашнего чемпиона по шахматам Гарри Каспарова.

Когда игрок играет в Го, то перед ним поле с 361-м вариантом, куда можно выставить камень.

Количество вариантов со временем уменьшается, однако если учесть, что за партию игрок делает около 45-75 ходов, то видно, что ему нужно проводить просто огромный анализ игрового поля. Ведь ему нужно выстраивать фигуры, чтобы окружить камни соперника. Поэтому поставленный камень на 5-м ходу может принести пользу только на 45-м ходу. А может и не принести пользу вообще. Все эти комбинации нужно уметь просчитывать, поэтому профессиональная игра в Го считается довольно сложной. Однако в 2016 году была разработана программа АльфаГо и проведена игра в Го с тогдашним чемпионом Ли Седолем. Человек проиграл со счетом 4:1, сумев выиграть один раз у программы.

Как видно, временной промежуток между разработкой программ для шахмат и игры Го очень большой. Это обусловлено по большей степени сложностью игры в Го. Алгоритм программы для шашек, шахмат и Го одинаков: выстраивается дерево возможных вариантов игры, и программа просто идет по ветке, которая приводит ее к обязательной победе.

А так как в игре Го игровых вариаций очень и очень много, то и дерево получилось очень разветвленным и глубоким, и только на его разработку потребовалась масса времени.

Программа АльфаГо

Продолжая отвечать на вопрос: «AlphaGo — что это за программа?», хочется остановиться немного на том, как она обучалась. При построении алгоритма AlphaGo одновременно тренировались две нейронные сети, которые старались предугадывать ход, который сделал бы человек:

медленная — показывала хороший процент предсказаний, 57% верных, но делала все это по-настоящему медленно;

быстрая — показывала процент предсказаний намного хуже, однако работала очень быстро.

Обе эти нейронные сети тренировались на реальных человеческих ходах и играх. Данные о человеческих играх игроков высокого уровня собирались с различных серверов игры Го и «скармливались» обеим нейронным сетям.

Данные нейронные сети самостоятельно «дописывали» собственные деревья, если вдруг, двигаясь по какой-либо ветке, они достигали ее конца. Потом эти две сети сталкивали между собой и давали им возможность играть друг с другом, тем самым они еще больше «прокачивались».

Чуть позже к этим натренированным сетям подключили третью сеть, в чью задачу входила оценка конкретной ситуации всего на два значения: «выиграешь» или «проиграешь». Вот и получается, что AlphaGo состоит из трех разных функций, каждая из которых осуществляет собственную задачу.

Первой проверкой программы АльфаГо стала игра в 2015 году с тогдашним чемпионом Европы по Го, которую программа выиграла со счетом 5:0. Это первая проба программы AlphaGo, однако она не получила широкой огласки из-за того, что «чемпион Европы» по меркам игры Го — это не очень значимый титул.

Но вот игра 2016 года запомнилась навсегда. Во-первых, это была уже вторая версия программы AlphaGo.

Во-вторых, в соперниках был один из самых титулованных и лучших игроков по Го Ли Седол. А в-третьих, это единственный игрок, который обыграл компьютер, хоть и проиграл по партиям. В честь этого та версия программы стала называться AlphaGo Lee.

После этого были еще игры в 2017-м между программой AlphaGo и топовыми игроками в Го, но все они проигрывали программе. Противостояние между игроками и AlphaGo пока окончено с убедительной победой программы над человеком.

Заключение

АльфаГо — это не конец противостояния между компьютером и человеком. На сегодняшний день ведутся активные разработки по нескольким играм. Го относится к тем играм, где все данные открыты и можно просчитать все возможные ходы наперед, если правильно выстроить систему. Человек научился строить такие системы, именно поэтому он не способен обыграть компьютер в подобных играх. Но что будет, когда в играх и системах не будет рамок, когда придется анализировать и думать, как поступить? Подобные противостояния нам еще предстоит посмотреть.

Alphago что это за программа

Содержание

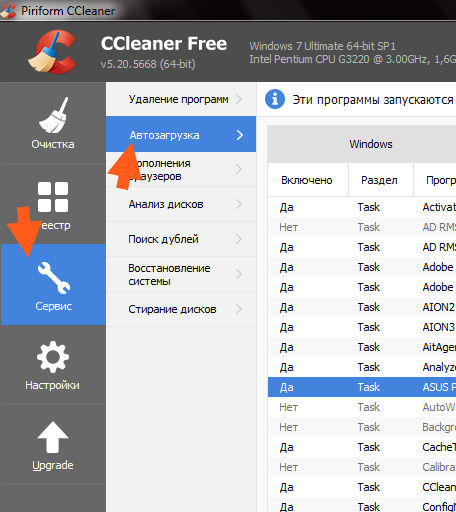

- 0.1 Шаг 1: Остановите все alphago процессы в диспетчере задач

- 0.2 Шаг 2: Удалите alphago сопутствующие программы

- 0.3 Шаг 3: Удалите вредоносные alphago записи в системе реестра

- 0.4 Шаг 4: Устранить вредоносные файлы и папки, связанные с alphago

- 0.5 Шаг 5: Удаление alphago из вашего браузера

- 0.5.1 Internet Explorer

- 0.5.2 Mozilla Firefox

- 0.5.3 Google Chrome

- 0.6 Шаг 1: тренируем нейросеть, которая учится предсказывать ходы людей — SL-policy network

- 0.7 Шаг 2: тренируем policy еще лучше через игру с собой (reinforcement learning) — RL-policy network

- 0.8 Шаг 3: натренируем сеть, которая «с одного взгляда» на расстановку говорит нам, какие у нас шансы выиграть! — Value network

- 1 Как происходит заражение вирусом ALPHAGO?

- 2 Как избавиться от рекламы ALPHAGO?

- 3 Инструкция по ручному удалению рекламного вируса ALPHAGO

- 4 И все же автоматика лучше!

- 5 Итак, приступим:

- 5.

1 Шаг 1. Установите UnHackMe (1 минута).

1 Шаг 1. Установите UnHackMe (1 минута). - 5.2 Шаг 2. Запустите поиск вредоносных программ в UnHackMe (1 минута).

- 5.3 Шаг 3. Удалите вредоносные программы (3 минуты).

- 5.4 Андрей «Вирусолог»

- 5.

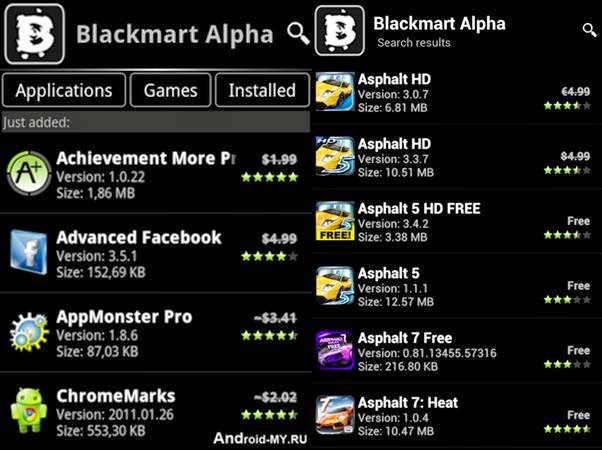

alphago это вредоносная программа, которая обычно устанавливается на вашем компьютере за вашей спиной. Показывает рекламу и сохранение наших личных данных являются две главные задачи, почему alphago разработан. Такие объявления можно увидеть либо в виде баннеров, всплывающих окон, поддельные результаты на Google, или синий/зеленый подчеркнутые слова прямо в Контент каждый посещаемый веб-сайт.

К тому же губит Ваш опыт просмотра, alphago также занимает время, шпионить за все, что вы делаете в интернете, экономя каждый сайт вы посещаете, и каждый поиск вы делаете. alphago идет насколько анализируя то, что у вас есть на вашем компьютере, по их “статистике” только с целью, или так они утверждают на их использование лицензии. Истина заключается в том, что все эти данные сохраняются в коммерческих базах данных, содержащих коммерческого профиля, которые будут проданы впоследствии.

Используйте средство удаления вредоносных программ Spyhunter только для целей обнаружения. Узнайте больше о SpyHunter Spyware Detection Tool и шаги для удаления SpyHunter.

Установив бесплатное программное обеспечение, как alphago будет установлена на наших компьютерах. Все это занимает для вас, чтобы отвлекаться во время установки, чтобы не заметить, что это рекламное предлагается вместе с программой, которую вы намеревались установить. Вот почему мы всегда говорим, что вы всегда должны проявлять особую осторожность при установке что-то новое в свой компьютер.

Этот рекламное также может быть найден добавленные в поддельные обновления, как правило, на Java или Flash, часто встречается в видео потоковое веб-сайтов.

Если вы уже инфицированы alphago, будьте осторожны с сайтов, предлагающих вам удаления решения, потому что вы могли закончиться вверх следующие поддельные совет, который будет принимать вас, чтобы загрузить и оплатить scareware, который будет трудно удалить тоже.

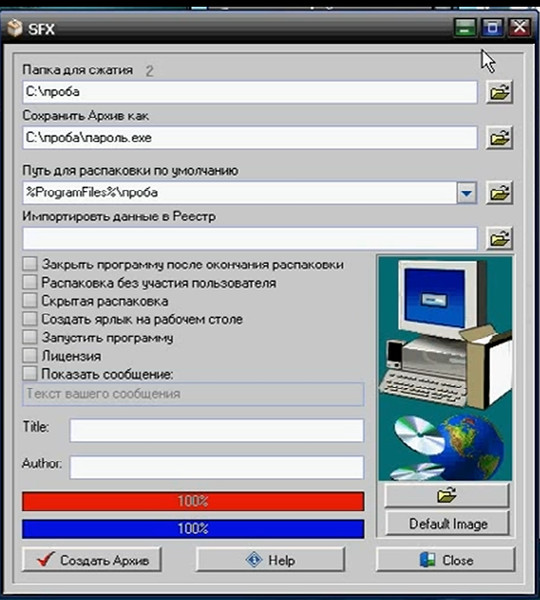

Шаг 1: Остановите все alphago процессы в диспетчере задач

- Нажмите и удерживайте Ctrl + Alt + Del, чтобы открыть диспетчер задач

- Перейдите на вкладку Подробности и конец всех связанных с ними процессов alphago (выберите процесс и нажмите кнопку завершить задачу)

Шаг 2: Удалите alphago сопутствующие программы

- Нажмите кнопку Пуск и откройте панель управления

- Выберите удалить программу в разделе программы

- Подозрительного программного обеспечения и нажмите кнопку Удалить/изменить

Шаг 3: Удалите вредоносные alphago записи в системе реестра

- Нажмите Win + R чтобы открыть выполнить, введите «regedit» и нажмите кнопку ОК

- Если контроль учетных записей пользователей, нажмите кнопку ОК

- Однажды в редакторе реестра, удалите все связанные записи alphago

Шаг 4: Устранить вредоносные файлы и папки, связанные с alphago

- Нажмите кнопку Пуск и откройте панель управления

- Нажмите Просмотр, выберите крупные значки и откройте свойства папки

- Перейдите на вкладку Вид, проверить показывать скрытые файлы, папки или драйверы и нажмите кнопку ОК

- Удалить все alphago связанные файлы и папки

%AllUsersProfile%

andom. exe

exe

%Temp%

andom.exe

%AllUsersProfile%Application Data

andom

Шаг 5: Удаление alphago из вашего браузера

Используйте средство удаления вредоносных программ Spyhunter только для целей обнаружения. Узнайте больше о SpyHunter Spyware Detection Tool и шаги для удаления SpyHunter.

Используйте средство удаления вредоносных программ Spyhunter только для целей обнаружения. Узнайте больше о SpyHunter Spyware Detection Tool и шаги для удаления SpyHunter.

Internet Explorer

- Запуск Internet Explorer, нажмите на значок шестерни → Управление надстройками

- Выбрать раздел панели инструментов и расширения и отключите подозрительные расширения

Скачать утилиту чтобы удалить alphago

Используйте средство удаления вредоносных программ Spyhunter только для целей обнаружения. Узнайте больше о SpyHunter Spyware Detection Tool и шаги для удаления SpyHunter.

Mozilla Firefox

- Откройте Mozilla, нажмите сочетание клавиш Ctrl + Shift + A и перейти к расширения

- Выберите и удалите все ненужные расширения

Скачать утилиту чтобы удалить alphago

Используйте средство удаления вредоносных программ Spyhunter только для целей обнаружения. Узнайте больше о SpyHunter Spyware Detection Tool и шаги для удаления SpyHunter.

Узнайте больше о SpyHunter Spyware Detection Tool и шаги для удаления SpyHunter.

Google Chrome

- Откройте браузер, нажмите меню и выберите инструменты → расширения

- Выберите подозрительные надстройки и нажмите на значок корзины для его удаления

* SpyHunter сканера, опубликованные на этом сайте, предназначен для использования только в качестве средства обнаружения. более подробная информация о SpyHunter. Чтобы использовать функцию удаления, вам нужно будет приобрести полную версию SpyHunter. Если вы хотите удалить SpyHunter, нажмите здесь.

Итак, пока наши новые повелители отдыхают, давайте я попробую рассказать как работает AlphaGo. Пост подразумевает некоторое знакомство читателя с предметом — нужно знать, чем отличается Fan Hui от Lee Sedol, и поверхностно представлять, как работают нейросети.

Disclaimer: пост написан на основе изрядно отредактированных логов чата closedcircles.com, отсюда и стиль изложения, и наличие уточняющих вопросов

Как все знают, компьютеры плохо играли в Го потому, что там очень много возможных ходов и пространство поиска настолько велико, что прямой перебор помогает мало.

Лучшие программы используют так называемый Monte Carlo Tree Search — поиск по дереву с оценкой нодов через так называемые rollouts, то есть быстрые симуляции результата игры из позиции в ноде.

AlphaGo дополняет этот поиск по дереву оценочными функциями на основе deep learning, чтобы оптимизировать пространство перебора. Статья изначально появилась в Nature (и она там за пейволлом), но в интернетах ее можно найти. Например тут — https://gogameguru.com/i/2016/03/deepmind-mastering-go.pdf

Шаг 1: тренируем нейросеть, которая учится предсказывать ходы людей — SL-policy network

Берем 160K доступных в онлайне игр игроков довольно высокого уровня и тренируем нейросеть, которая предсказывает по позиции следующий ход человека.

Архитектура сети — просто 12 уровней convolution layers с нелинейностью и softmax на каждую клетку в конце. Такая глубина в целом сравнима с сетями для обработки изображений прошлого поколения (гугловский Inception-v1, VGG, все эти дела)

Важный момент — что нейросети дается на вход:

Для каждой клетки на вход дается 48 фич, они все есть в таблице (каждое измерение — это бинарная фича)

Набор интересный. На первый взгляд кажется, сети нужно давать только есть ли в клетке камень и если есть, то какой. Но фиг там!

На первый взгляд кажется, сети нужно давать только есть ли в клетке камень и если есть, то какой. Но фиг там!

Есть и тривиально вычисляющиеся фичи типа «количество степеней свободы камня», или «количество камней, которые будут взяты этим ходом»

Есть и формально неважные фичи типа «как давно было сделан ход»

И даже специальная фича для частого явления «ladder capture/ladder escape» — потенциально долгой последовательности вынужденных ходов.

а что за «всегда 1» и «всегда 0»?

Они просто чтобы добить количество фич до кратного 4-м, мне кажется.

И вот на этом всем сетка учится предсказывать человеческие ходы. Предсказывает с точностью 57% и к этому надо относиться осторожно — цель предсказания, человеческий ход, все же неоднозначен.

Авторы показывают, впрочем, что даже небольшие улучшения в точности сильно сказываются на силе в игре (сравнивая сетки разной мощности)

Отдельно от SL-policy, тренируют fast rollout policy — очень быструю стратегию, которая является просто линейным классификатором.

Ей на вход дают еще больше заготовленных фич

То есть, ей дают фичи в виде заранее заготовленных паттернов

Она гораздо хуже, чем модель с глубокой сетью, но зато сверх-быстрая. Как она используется — будет понятно дальше

Шаг 2: тренируем policy еще лучше через игру с собой (reinforcement learning) — RL-policy network

Выбираем противника из пула прошлых версий сети случайно (чтобы не оверфитить на саму себя), играем с ним партию до конца просто выбирая наиболее вероятный ход из предсказания сети, опять же без всякого перебора.

Единственный reward — это собственно результат игры, выиграл или проиграл.

После того, как reward известен, вычисляем как нужно сдвинуть веса — проигрываем партию заново и на каждом ходу двигаем веса, влияющие на выбор выбранной позиции, по градиенту в + или в — в зависимости от результата. Другими словами, применяем этот reward как направление градиента к каждому ходу.

(для любознательных — там чуть более тонко и градиент умножается на разницу между результатом и оценкой позиции через value network)

И вот повторяем и повторяем этот процесс — после этого RL-policy значительно сильнее SL-policy из первого шага.

Предсказание этой натренированной RL-policy уже рвет большинство прошлых программ, играющих в Го, без всяких деревьев и переборов.

Включая DarkForest Фейсбука?

С ней не сравнивали, непонятно.

Интересная деталь! В оригинальной статье пишется, что этот процесс длился всего 1 день (остальные тренировки — недели).

Шаг 3: натренируем сеть, которая «с одного взгляда» на расстановку говорит нам, какие у нас шансы выиграть! — Value network

Т.е. предсказывает всего одно значение от -1 до 1.

У нее ровно та же архитектура, что и у policy network (есть один лишний convolution layer, кажется) + естественно fully connected layer в конце.

То есть у нее те же фичи?

value network дают еще одну фичу — играет игрок черными или нет (policy network передают «свой-чужой» камень, а не цвет). Я так понимаю, это чтобы она могла учесть коми — дополнительные очки белым, за то что они ходят вторыми

Оказывается, что ее нельзя тренировать на всех позициях из игр людей — так как много позиций принадлежит игре с тем же результатом, такая сеть начинает оверфитить — т. е. запоминать, какая это партия, вместо того, чтобы оценивать позицию.

е. запоминать, какая это партия, вместо того, чтобы оценивать позицию.

Поэтому ее обучают на синтетических данных — делают N ходов через SL network, потом делают случайный легальный ход, потом доигрывают через RL-network чтобы узнать результат, и обучают на ходе N+2 (!) — только на одной позицию за сгенерированную игру.

TL;DR: Policy network предсказывает вероятные ходы чтобы уменьшить ширину перебора (меньше возможных ходов в ноде), value network предсказывает насколько выигрышна позиция, чтобы уменьшить необходимую глубину перебора

Внимание, картинко!

Итак, у нас есть дерево позиций, в руте — текущая. Для каждой позиции есть некое значение Q, которое означает насколько она ведет к победе.

Мы на этом дереве параллельно проводим большое количество симуляций.

Каждая симуляция идет по дереву туда, где больше Q + m(P). m(P) — это специальная добавка, которая стимулирует exploration. Она больше, если policy network считает, что у этого хода большая вероятность и меньше, если по этому пути уже много ходили

(это вариация стандартной техники multi-armed bandit)

Когда симуляция дошла по дереву до листа, и хочет походить дальше, где ничего еще нет…

То новый созданный нод дерева оценивается двумя способами

- во-первых, через описанный выше value network

- во-вторых, играется до конца с помощью супер-быстрой модели из Шага 1 (это и называется rollout)

Результаты этих двух оценок смешиваются с неким весом (в релизе он натурально 0. 5), и получившийся score записывается всем нодам дерева, через которые прошла симуляция, а Q в каждом ноде апдейтится как среднее от всех score для проходов через эту ноду.

5), и получившийся score записывается всем нодам дерева, через которые прошла симуляция, а Q в каждом ноде апдейтится как среднее от всех score для проходов через эту ноду.

(там совсем чуть-чуть сложнее, но можно пренебречь)

Т.е. каждая симуляция бежит по дереву в наиболее перспективную область (с учетом exploration), находит новую позицию, оценивает ее, записывает результат вверх по всем ходам, которые к ней привели. А потом Q в каждом ноде вычисляется как усреднение по всем симуляциям, которые через него бежали.

Собственно, все. Лучшим ходом объявляется нод, через который бегали чаще всех (оказывается, это чуть стабильнее чем этот Q-score). AlphaGo сдается, если у всех ходов Q-score Теги:

- alphago

- deepmind

- deep learning

- reinforcement learning

Добавить метки

ALPHAGO — это рекламный вирус, при заражении которым браузер вашего компьютера начинает перенаправлять вас на сайты с рекламой вне зависимости от используемого вами браузера.

Вирусы, подобные ALPHAGO, как правило занимаются подменой домашних страниц вашего браузера, меняют поисковый сайт, создают собственные задания в расписании, видоизменяют свойства ярлыков ваших браузеров.

Как происходит заражение вирусом ALPHAGO?

Я очень часто пишу в рекомендациях о вреде установки программ по-умолчанию. Ведь в результате такого необдуманного поступка вы рискуете установить себе кучу нежелательного софта.

А вот сегодня я сам облажался подобным же образом. В результате этого браузер принялся постоянно демонстрировать мне тонны рекламы с сайта ALPHAGO. Я слегка попенял на себя, и приступил к лечению.

Как избавиться от рекламы ALPHAGO?

Конечно для меня это было уже рутинной операцией. Но прежде, чем поделиться инструкцией по удалению вируса ALPHAGO, опишем, что он из себя представляет.

На самом деле это типичный перенаправитель на сайт с рекламой. После доменного имени могут идти разнообразные оконцовки, но домен ALPHAGO присутствует всегда. Во всех этих вариантах ваш браузер переходит на те же рекламные страницы. Также зловред поражает ярлыки ваших браузеров и настройки домашней страницы.

Во всех этих вариантах ваш браузер переходит на те же рекламные страницы. Также зловред поражает ярлыки ваших браузеров и настройки домашней страницы.

Кроме того рекламный вирус ALPHAGO создает задания для исполнения, для поддержания своего присутствия на вашей машине. Подвергаются атаке все браузеры, которые он сможет найти в вашей системе. Поэтому в результате такой массовой рекламной атаки не мудрено подцепить и что-нибудь более серьезное.

Именно поэтому данный вирус следует уничтожить сразу по обнаружению. Ниже я приведу несложные инструкции, которые помогут вам в лечении. Но как всегда я рекомендую использовать автоматизированный метод как наиболее эффективный и простой.

Инструкция по ручному удалению рекламного вируса ALPHAGO

Для того, чтобы самостоятельно избавиться от рекламы ALPHAGO, вам необходимо последовательно выполнить все шаги, которые я привожу ниже:

- Поискать «ALPHAGO» в списке установленных программ и удалить ее.

Открыть Диспетчер задач и закрыть программы, у которых в описании или имени есть слова «ALPHAGO». Заметьте, из какой папки происходит запуск этой программы. Удалите эти папки.

Заметьте, из какой папки происходит запуск этой программы. Удалите эти папки.

Запретить вредные службы с помощью консоли services.msc.

Удалить “Назначенные задания”, относящиеся к ALPHAGO, с помощью консоли taskschd.msc.

С помощью редактора реестра regedit.exe поискать ключи с названием или содержащим «ALPHAGO» в реестре.

Проверить ярлыки для запуска браузеров на предмет наличия в конце командной строки дополнительных адресов Web сайтов и убедиться, что они указывают на подлинный браузер.

Проверить плагины всех установленных браузеров Internet Explorer, Chrome, Firefox и т.д.

Проверить настройки поиска, домашней страницы. При необходимости сбросить настройки в начальное положение.

И все же автоматика лучше!

Если ручной метод — не для вас, и хочется более легкий путь, существует множество специализированного ПО, которое сделает всю работу за вас. Я рекомендую воспользоваться UnHackMe от Greatis Software, выполнив все по пошаговой инструкции.

Я рекомендую воспользоваться UnHackMe от Greatis Software, выполнив все по пошаговой инструкции.

Шаг 1. Установите UnHackMe. (1 минута)

Шаг 2. Запустите поиск вредоносных программ в UnHackMe. (1 минута)

Шаг 3. Удалите вредоносные программы. (3 минуты)

UnHackMe выполнит все указанные шаги, проверяя по своей базе, всего за одну минуту.

При этом UnHackMe скорее всего найдет и другие вредоносные программы, а не только редиректор на ALPHAGO.

При ручном удалении могут возникнуть проблемы с удалением открытых файлов. Закрываемые процессы могут немедленно запускаться вновь, либо могут сделать это после перезагрузки. Часто возникают ситуации, когда недостаточно прав для удалении ключа реестра или файла.

UnHackMe легко со всем справится и выполнит всю трудную работу во время перезагрузки.

И это еще не все. Если после удаления редиректа на ALPHAGO какие то проблемы остались, то в UnHackMe есть ручной режим, в котором можно самостоятельно определять вредоносные программы в списке всех программ.

Итак, приступим:

Шаг 1. Установите UnHackMe (1 минута).

- Скачали софт, желательно последней версии. И не надо искать на всяких развалах, вполне возможно там вы нарветесь на пиратскую версию с вшитым очередным мусором. Оно вам надо? Идите на сайт производителя, тем более там есть бесплатный триал. Запустите установку программы.

Затем следует принять лицензионное соглашение.

И наконец указать папку для установки. На этом процесс инсталляции можно считать завершенным.

Шаг 2. Запустите поиск вредоносных программ в UnHackMe (1 минута).

- Итак, запускаем UnHackMe, и сразу стартуем тестирование, можно использовать быстрое, за 1 минуту. Но если время есть — рекомендую расширенное онлайн тестирование с использованием VirusTotal — это повысит вероятность обнаружения не только перенаправления на ALPHAGO, но и остальной нечисти.

Мы увидим как начался процесс сканирования.

Шаг 3.

Удалите вредоносные программы (3 минуты).

Удалите вредоносные программы (3 минуты).

- Обнаруживаем что-то на очередном этапе. UnHackMe отличается тем, что показывает вообще все, и очень плохое, и подозрительное, и даже хорошее. Не будьте обезьяной с гранатой! Не уверены в объектах из разряда “подозрительный” или “нейтральный” — не трогайте их. А вот в опасное лучше поверить. Итак, нашли опасный элемент, он будет подсвечен красным. Что делаем, как думаете? Правильно — убить! Ну или в английской версии — Remove Checked. В общем, жмем красную кнопку.

Ну и в конце вы увидите результаты сканирования и лечения.

Итак, как вы наверное заметили, автоматизированное лечение значительно быстрее и проще! Лично у меня избавление от перенаправителя на ALPHAGO заняло 5 минут! Поэтому я настоятельно рекомендую использовать UnHackMe для лечения вашего компьютера от любых нежелательных программ!

Андрей «Вирусолог»

Андрей — обычный парень, который пользуется компьютером каждый день, и ненавидит, когда неприятности наполняют его жизнь. А еще он любит петь. Но не переживайте, его голос не будет досаждать вам. Только текст )

А еще он любит петь. Но не переживайте, его голос не будет досаждать вам. Только текст )

Игры, в которые играли люди. Программа AlphaGo обыграла признанного чемпиона со счетом 4-1

Во вторник, 15 марта, в Сеуле прошла последняя встреча между компьютерной программой AlphaGo и южнокорейскими профессионалом го Ли Седолем. По итогам пяти матчей машина, работающая на технологии нейронных сетей, выиграла со счетом 4-1. Как это было и означает ли это, что искусственный разум окончательно превзошел человеческий?

Представьте: 6 августа 1945 года, последние дни второй мировой войны. Ивамото Каору и Хасимото Утаро, два японских мастера го, играют важную партию в местечке Ицукаити, одном из пригородов Хиросимы. Вдруг — ослепительная вспышка, над городом вырастает зловещий гриб. Разрушительная ударная волна выбивает все стекла в доме и раскидывает камни по игровой доске. Невозмутимые Ивамото и Хасимото по памяти восстанавливают свои позиции и доигрывают партию. Об атомной бомбе они узнали только вечером — игра в го не терпит суеты и не позволяет отвлекаться.

Об атомной бомбе они узнали только вечером — игра в го не терпит суеты и не позволяет отвлекаться.

Го возникла в Древнем Китае примерно за тысячу лет до нашей эры и быстро стала популярной в странах нынешней Юго-Восточной Азии. Правила этой стратегической игры просты: игроки по очереди ставят на игровое поле черные и белые камни, стараясь отгородить ими как можно большую территорию. При этом тактика го столь многообразна и сложна, что даже начинающие уже не могут внятно объяснить непосвященному человеку причины своих ходов.

В разное время отношение к го было разным. Одни считали ее пустой тратой времени, другие — элитарным занятием, а третьи — необходимой частью обучения будущих полководцев. Сейчас го вместе с «китайскими шахматами» сянци, шашками, бриджем и шахматами обычными входит в пятерку дисциплин Всемирных интеллектуальных игр. Число возможных партий в игре превосходит количество атомов во Вселенной, и поэтому до недавнего времени мало кто верил, что компьютер когда-нибудь сможет обыграть мастера го. Ведь для этого машине пришлось бы не просто перебирать все возможные варианты и на несколько ходов вперед оценивать их перспективы, как делал Deep Blue в знаменитой шахматной серии против Гарри Каспарова 1997 года, а уже по-настоящему думать. Неуловимо, туманно, подчас иррационально — как игрок в го. Как любой человек.

Ведь для этого машине пришлось бы не просто перебирать все возможные варианты и на несколько ходов вперед оценивать их перспективы, как делал Deep Blue в знаменитой шахматной серии против Гарри Каспарова 1997 года, а уже по-настоящему думать. Неуловимо, туманно, подчас иррационально — как игрок в го. Как любой человек.

Мозг из машины

Работа AlphaGo основана на концепции нейронных сетей, предложенной еще в середине XX века. Тогда информатики сообразили, что компьютерные алгоритмы можно не просто навсегда фиксировать в железе, а наоборот, научить их перестраиваться в процессе обработки информации. Похожим образом работают нервные системы живых организмов, в которых при обучении связи между нейронами постоянно образуются, разрушаются или изменяют свою силу.

В XX веке техника еще не была готова к нейронным сетям, и постепенно о них стали забывать, пока в 2012 году не случилась настоящая революция. Алгоритм машинного обучения на нейронных сетях с огромной форой выиграл престижное соревнование в области компьютерного зрения ImageNet.

Суть этого конкурса в следующем: на первом этапе участники обучают свои компьютерные программы, используя огромную базу картинок с привязанными к ним текстовыми описаниями. Затем соревнующиеся получают задания распознать те или иные образы на еще незнакомых их алгоритмам изображениях: например, на одних картинках нужно найти все машины, а на других — отличить друг от друга разные породы котов. После первой победы в 2012 году нейронные сети с большим отрывом от остальных продолжают выигрывать во всех подобных соревнованиях.

И именно на задачах компьютерного зрения проще всего объяснить работу нейронных сетей. Представим, что нам нужно написать программу для распознавания флагов на фотографиях. Как это сделать? Нейронная сеть, выполняющая такую задачу, будет состоять из нескольких слоев — подпрограмм, последовательно обрабатывающих входное изображение и передающих результат своего анализа на следующий слой. Он же, в свою очередь, может состоять из десятков, сотен и тысяч «электронных» нейронов — фрагментов кода, выполняющих свои маленькие задачи.

При этом каждый нейрон тесно связан с другими нейронами. У одних он берет входную информацию для обработки, другим передает информацию, а сами его действия могут меняться под действием этой информации. Например, электронный нейрон может тем больше усиливать проходящий через него сигнал, чем чаще он приходит к нему на вход и, наоборот, «отмирать», если в течение долгого времени работы программы большой сигнал к нему поступает очень редко.

Похожие процессы происходят в нашей голове и потому маленькие фрагменты программ нейронных сетей и называются нейронами.

Так, когда мы разучиваем мелодию на фортепиано, то сигналы проходят примерно по одним и тем же нейронным путям. Постепенно связи между ними усиливаются — мы подсознательно запоминаем последовательность действий и звуков и даже можем дать небольшой концерт. Но заканчивается музыкальная школа, времени на фортепьяно не хватает, и связи постепенно распадаются за ненужностью, а мелодия забывается. Теперь восстановить ее мы можем только усилием сознания — по нотам.

Теперь вернемся к флагам и попробуем представить нейронную сеть для их распознавания. В ее первом слое будут нейроны, отвечающие за все возможные цвета: один из них будет искать на изображении синий, другой — красный, третий — зеленый и так далее. Дальше сигналы с первого слоя будут передаваться на второй, где нейроны уже будет «собирать» комбинации цветов: например, одновременное срабатывание красного и синего нейронов первого слоя возбудит во втором слое «красно-синий» нейрон. Дальше каждый последующий слой будет решать все более сложные задачи вроде поисков полумесяца и звезд или ориентации полосок, пока мы не доберемся до последнего слоя, в котором всего один нейрон собирает все сигналы и дает финальный ответ.

При этом такой алгоритм можно еще и обучать: взять базу фотографий флагов и пропускать эти изображения через программу, каждый раз отмечая верный ответ. Так нейронная сеть поймет, где она совершала ошибки, а где действовала правильно, и начнет понемногу корректировать работу каждого нейрона и связи между ними: например, тот же нейрон красного цвета теперь будет искать не только группы пикселей цвета спелого помидора, но и скромные розоватые оттенки выцветших фотографий. Именно поэтому с помощью алгоритмов на нейронных сетях можно проводить глубокое машинное обучение (глубоким оно называется потому, что для распознавания иногда нужно до нескольких десятков последовательных слоев нейронов, а обучением — потому что компьютер буквально начинает учиться на своих ошибках).

Именно поэтому с помощью алгоритмов на нейронных сетях можно проводить глубокое машинное обучение (глубоким оно называется потому, что для распознавания иногда нужно до нескольких десятков последовательных слоев нейронов, а обучением — потому что компьютер буквально начинает учиться на своих ошибках).

«Если пять лет назад к нам бы пришли и попросили написать программу, чтобы определять, есть ли в рекламном ролике бутылка с алкоголем, мы бы сказали, что это невозможно, — рассказывает Александр Крайнов, один из главных специалистов по компьютерному зрению в «Яндексе» и большой любитель го. — Сегодня хорошая команда программистов напишет такой алгоритм за неделю. Более того, теперь это простая задача: для тех же картинок можно автоматически определить, скажем, их «мрачную» атмосферу — с кладбищами, вампирами, зомби».

Компьютерный самоучка

Компьютерные программы для игры в го создают уже давно. Самые примитивные из них могут противостоять только новичкам игры, но разработанная в компании Google AlphaGo куда серьезней: ее работа основана как раз на глубоком машинном обучении, и прошлой осенью она уже обыграла чемпиона Европы по го с разгромным счетом 5-0.

Фото: liz west/flicker

AlphaGo состоит из двух основных частей. Первая — это 12 слоев нейронной сети с миллионами компьютерных нейронов, которые обучали на 30 миллионах ходов из задокументированных игровых партий. В каком-то смысле нейронная сеть Alpha Go тоже распознает образы и умеет по картинке на ходе N определять, как будет выглядеть игровое поле после хода N+1 (AlphaGo научилась делать это весьма неплохо: после обучения с фокусом внимания на партии победивших игроков она научилась верно предсказывать следующий ход живых игроков с вероятностью в 57%).

Вторая часть AlphaGo отдаленно похожа на шахматные компьютеры: она умеет моделировать развитие событий на несколько шагов вперед и определять самые выгодные варианты ходов. Совместная работа этих двух частей напоминает человеческое мышление: на каждом ходу AlphaGo сначала на основании опыта, можно сказать интуитивно, определяет наиболее вероятные действия противника (по факту она вспоминает, как действовали в похожей ситуации выигравшие мастера), а потом досконально и рационально высчитывает плюсы и минусы каждого из них.

При этом действия AlphaGo не лишены элемента случайности: программа с определенной вероятностью может выбрать любой из нескольких наиболее выгодных вариантов ходов. Кстати, именно это сделало ее по-настоящему непобедимой: после обучения на уже сыгранных партиях AlphaGo продолжила тренироваться в бесконечных играх сама с собой. До них она была просто хорошо вышколенной машиной, помнящей миллионы выгодных ходов, хотя и способной обыграть европейского чемпиона (разница в уровне между игроками Азии и Европы очень велика). После игр с самой собой она стала настоящим мастером, способным бросить вызов одному из самых известных игроков го на планете, южнокорейцу Ли Седолю.

Черные начинают и проигрывают

Перед началом встречи Ли Седоль был уверен в своей разгромной победе во всех пяти матчах серии. Скучная, ортодоксальная, пресная – эксперты вслед за южнокорейцем не скупились на обидные эпитеты в адрес машины. 9 марта 2016 года все поменялось. Ли Седоль ходил черными (в го они ходят первыми) и заготовил для первого матча специальное начало. Уже после нескольких первых ходов партия не имела аналогов в истории, но AlphaGo не растерялась.

Уже после нескольких первых ходов партия не имела аналогов в истории, но AlphaGo не растерялась.

Быть может, она уже видела все эти ходы в бесконечных сражениях с самой собой, может, научилась отлично импровизировать (этот вариант вероятнее), а может, компьютеру просто повезло. Точно известно только одно: после 186 ходов Ли Седоль признал свое поражение в первом матче, а потом проиграл еще три игры (вторую, третью и пятую). После первых встреч южнокореец признался, что ни разу не чувствовал своего преимущества. AlphaGo ходила спокойно и уверенно, а в самые неожиданные моменты делала резкие выпады в сторону противника (по мнению экспертов, исход первой партии решил буквально один ход компьютера, на который у человека не оказалось достойного ответа).

Ли Седоль делает первый ход в партии против программы AlphaGo. Фото: EPA

Такого не ожидал никто. Эксперты рассуждали о возможностях AlphaGo по ее осенним играм и не могли предположить, как многому компьютер научится за несколько месяцев тренировок. «У AlphaGo просто нет слабых мест, — говорит Александр Крайнов. — Сила его самого слабого хода очень велика. Он не ошибается».

«У AlphaGo просто нет слабых мест, — говорит Александр Крайнов. — Сила его самого слабого хода очень велика. Он не ошибается».

Так го стала последней игрой с открытой информацией (в них игроки знают все о позициях друг друга в противовес, скажем, покеру, где каждый видит только свои и несколько общих карт), в которой человек считался заведомо сильней компьютера.

К чести Ли Седоля, он все-таки победил в одной (четвертой) игре, а китайский чемпион Ке Цзе, который обыгрывал самого южнокорейца девять раз, и вовсе заявил, что сможет победить AlphaGo по сумме пяти встреч, но, похоже, все это так и останется словами, ведь компьютер постоянно совершенствуется. «Пока в Сеуле шла игра, другая версия AlphaGo продолжала тренироваться сама с собой на каком-нибудь богом забытом сервере», — замечает Александр Крайнов.

Дешевый наемный труд?

Конечно, нейронные сети умеют не только играть в игры. На алгоритмах глубокого машинного обучения работают системы поиска по картинкам поисковиков Google и «Яндекс», Facebook с их помощью фильтрует нежелательный контент, а сотни стартапов по всему миру мечтают создать на основе нейронных сетей компьютерного переводчика или программы для алгоритмической торговли на бирже.

Расцвет технологии, предложенной десятки лет назад, связан с тремя причинами. Во-первых, появились доступные и большие вычислительные мощности: еще совсем недавно программисты могли создавать алгоритмы глубокого машинного обучения только на суперкомпьютерах, а сейчас это очень удобно делать на графических видеокартах — они оказались замечательно приспособлены под вычисления нейронных сетей. Во-вторых, появились новые, более совершенные алгоритмы. И в-третьих, человечество накопило множество хорошо отсортированных и почищенных сырых данных (например, тот же архив партий в го или гигантские базы стоковых фотографий с расставленными фотографами тэгами), которые теперь можно использовать для обучения компьютеров.

Член немецкой рок-группы Compressorhead, состоящей из роботов, на Ночи музеев в Москве. Фото: Sergei Ilnitsky/EPA

Теперь нейронные сети управляют роботами, сочиняют музыку и рисуют картины, которые многие искусствоведы не могут отличить от настоящих. Что особенно изящно, нейронные сети уже научились сами писать компьютерный код. А тот же Google обещает создать на основе AlpphaGo программы для моделирования климата и комплексных медицинских анализов заболеваний.

А тот же Google обещает создать на основе AlpphaGo программы для моделирования климата и комплексных медицинских анализов заболеваний.

Так что людям, похоже, стоит задуматься о том, что скоро их конкурентами за рабочие места станут бездушные и не знающие усталости машины. Правда, случится это не прямо завтра: на одну программу Alpha Go работает 176 графических карточек Nvidia, каждая стоимостью примерно четыре тысячи долларов. Кроме того, нейронная сеть использует 1200 процессоров, и ей требуются сотни часов работы серверов для обучения алгоритма и тысячи человеко-часов работы программистов: в сумме выходит несколько миллионов или скорее десятков миллионов долларов за одну выигранную серию в го. Так что у людей еще есть некоторое время, чтобы подготовиться к приходу искусственного интеллекта.

Михаил Петров

Теги

Информационные технологииФутурологияТехнологииНеделя Го

Alphago (2017) — IMDB

- Cast & Crew

- Отзывы о пользователях

IMDBPRO

- 20172017

- 1H 30M

99999999999999999999999997K. trailer1

trailer1

:

31

2 Видео

25 Фото

Документальный спорт

Компания DeepMind от Google разработала программу для игры в 3000-летнюю игру Go с использованием ИИ. Тестируют AlphaGo на чемпионе Европы, потом 9 марта-15, 2016, о лучшем игроке, Ли Седоле, в … Читать полностьюDeepMind от Google разработал программу для игры в 3000-летнюю игру Го с использованием ИИ. Они тестируют AlphaGo на чемпионе Европы, а затем 9-15 марта 2016 года на лучшем игроке Ли Седоле в турнире лучших из 5 в Сеуле. Компания DeepMind от Google разработала программу для игры в 3000-летнюю игру Го с использованием ИИ. Они тестируют AlphaGo на чемпионе Европы, а затем 9-15 марта 2016 года на лучшем игроке Ли Седоле в турнире Best of 5 в Сеуле.

IMDb RATING

7.8/10

6.2K

YOUR RATING

- Director

- Greg Kohs

- Stars

- Ioannis Antonoglou

- Lucas Baker

- Nick Bostrom

- Director

- Грег Кос

- Старз

- Иоаннис Антоноглу

- Лукас Бейкер

- Ник Бостром

- 28User reviews

- 12Critic reviews

- Awards

- 4 wins & 3 nominations

Videos2

Trailer 1:31

Watch Official Trailer

Trailer 1:31

Watch AlphaGo

Photos25

Лучшие актеры

Иоаннис Антоноглу

Лукас Бейкер

Ник Бостром

Ю Чанхьюк

Нам 9 Чи-Хён

Hyeyeon Cho

Joseph Choi

John Daugman

Chris Garlock

Thore Graepel

Arthur Guez

Demis Hassabis

John Holmes

Aja Huang

Fan Hui

Lee Hyunwook

Andrew Jackson

Майк Джонсон

- Режиссер

- Грег Кос

- Все актеры и съемочная группа

- Производство, кассовые сборы и многое другое на IMDbPro

Больше похоже на это

Собственный мальчик Интернета: История Аарона Шварца

TPB AFK: Пиратская бухта Вдали от клавиатуры

Икар

Магнус

Монета

- 4 Мы — Легион

- CLAIRE_SMART

- 23 января 2018

- Дата выпуска

- сентябрь 29 (United States)

- 313.

Сентябрь 2967

Сентябрь 2967 - 313.

- Официальный сайт

- Веб-сайт фильма

- Языки

- Английский

- Корейский

- Французский

- Китайский

4 Также известен как

- АльфаГо

- 4 Легион

- 4 Bit Player

Zero Days

Бобби Фишер против всего мира

Спасение

Jiro Dreams of Sushi

General Magic

Сюжетная линия

Знаете ли вы

08 Ссылки The Terminator (1984)

Обзоры пользователей 28

Обзор

Показанный обзор

9/

10

Хороший взгляд за кадром

Я последовал за рассказом Alphago. было довольно круто, но в то время я не видел общей картины. Этот фильм захватывает вас с самого начала и переносит вас за кулисы турнира с Ли Седолем. Но это также объясняет, почему AlphaGo является таким огромным прорывом и почему ИИ однажды может помочь нам решить некоторые из самых больших проблем в мире. Я думаю, что многие люди могли бы воспринять это как очередную историю человека против машины, но я не согласен. Что выделялось для меня, так это красота человека с машиной и то, чего мы можем достичь вместе.

было довольно круто, но в то время я не видел общей картины. Этот фильм захватывает вас с самого начала и переносит вас за кулисы турнира с Ли Седолем. Но это также объясняет, почему AlphaGo является таким огромным прорывом и почему ИИ однажды может помочь нам решить некоторые из самых больших проблем в мире. Я думаю, что многие люди могли бы воспринять это как очередную историю человека против машины, но я не согласен. Что выделялось для меня, так это красота человека с машиной и то, чего мы можем достичь вместе.

Полезно • 9

3

Подробная информация

4977

40046

- Moxie Pictures

- Reel As Dirt

Technical specs

- Runtime

1 hour 30 minutes

- Color

Related новости

Внесите свой вклад в эту страницу

Предложите отредактировать или добавить отсутствующий контент

Top Gap

Под каким названием AlphaGo (2017) был официально выпущен в Индии на английском языке?

Ответить

Еще для изучения

Недавно просмотренные

У вас нет недавно просмотренных страниц

Понимание AlphaGo: как ИИ думает и учится (основы) | by Shen Huang

Эта статья научит вас основам игрового искусственного интеллекта…

«Я представляю себе время, когда мы будем для роботов тем, чем собаки являются для людей, и я болею за машины».

— Клод Шеннон

Разработанная DeepMind, AlphaGo привлекла внимание всего мира после победы над лучшими игроками мира в игре в го в 2016 году. Более мощная версия под названием AlphaZero продолжает процветать в таких играх, как го и шахматы. . Вариант под названием AlphaStar демонстрировал все более высокие результаты, играя в стратегические игры в реальном времени против профессиональных игроков-людей. Мы живем в эпоху, когда машины берут на себя наши задачи, и в какой-то конкретной области они справляются с работой лучше, чем мы, люди.

Робот играет в шахматы, изображение со сайта Smithsonian.com

Но как именно работает этот ИИ? В этой статье мы рассмотрим, как работает этот игровой ИИ, начиная с основ. Мы начнем со старой школы состязательного поиска и конечных автоматов. Затем мы немного изучим области машинного обучения, от обучения с подкреплением до поиска по дереву Монте-Карло, и поймем, как современный ИИ обучается сам по себе (на примере покемонов ϞϞ(๑⚈ ․̫ ⚈๑)∩).

Затем мы перейдем к части 2, где мы углубимся в глубокое обучение, в основном сосредоточившись на искусственных нейронных сетях и сверточных нейронных сетях. После этого мы должны быть в состоянии понять сети политики и сети ценности для AlphaGo.

Не пугайтесь этих терминов, так как к концу этой статьи вы поймете их как профессионал. Я надеюсь, что эта статья развеет некоторые мифы об искусственном интеллекте, развеет сомнения и вызовет больший интерес к этой области исследований. Если вы готовы, пусть наше путешествие начнется!

«Наш интеллект — это то, что делает нас людьми, а ИИ — расширение этого качества».

— Yann LeCun

Первая концепция искусственного интеллекта восходит к древнегреческой мифологии. Гефест — греческий бог кузнецов, металлообработки, плотников, мастеров, ремесленников, скульпторов, металлургии, огня и вулканов, создал Талос — бронзовый автомат, по просьбе своего отца — Зевса, чтобы защитить супругу Зевса Европу от похищения. Гефест также был известен как создатель Пандоры — идеальной женщины в подарок человечеству, держащей «Ящик Пандоры» — злой кувшин, который выпустил все злые грехи на человечество, имея «надежду» под краем кувшина.

Гефест также был известен как создатель Пандоры — идеальной женщины в подарок человечеству, держащей «Ящик Пандоры» — злой кувшин, который выпустил все злые грехи на человечество, имея «надежду» под краем кувшина.

Талос, бронзовый автомат, изображение из FANDOM

Около 350 г. до н.э. великий философ Аристотель описал метод формального, механического мышления посредством дедуктивных рассуждений, известный как «силлогизм» . В 1206 году Исмаил аль-Джазари создал программируемый автомат, известный как «музыкальный робот-оркестр» . Многие другие блестящие люди были вдохновлены на протяжении веков. Известным из них был Алан Тьюринг, который изобрел алгоритм в 19 году.50, чтобы играть в шахматы со своими друзьями до того, как были изобретены компьютеры. (Кстати, он проиграл эту игру) И, конечно же, Тьюринг также был известен своим «тестом Тьюринга», который мы рассмотрим подробнее позже.

Музыкальная группа роботов Аль-Джазари, изображение из Википедии

Летом 1956 года в мастерской Дартмутского колледжа в Ганновере, Нью-Гэмпшир, официально началась область исследований искусственного интеллекта. Термин «искусственный интеллект» описывает изобретенные человеком машины, обладающие когнитивными способностями. Есть много подобластей этого исследования, таких как компьютерное зрение, обработка естественного языка, машинное обучение, экспертные системы и тема, которую мы будем обсуждать сегодня — игровой ИИ.

Термин «искусственный интеллект» описывает изобретенные человеком машины, обладающие когнитивными способностями. Есть много подобластей этого исследования, таких как компьютерное зрение, обработка естественного языка, машинное обучение, экспертные системы и тема, которую мы будем обсуждать сегодня — игровой ИИ.

Вид на Восточный кампус из Бейкер Тауэр Дартмутского колледжа, изображение из Википедии

Мы начнем с двух фундаментальных алгоритмов, используемых в игровом искусственном интеллекте — состязательного поиска и конечного автомата. Из этих строительных блоков мы можем углубиться в более сложные алгоритмы.

Состязательный поиск

Состязательный поиск, иногда называемый минимаксным поиском, представляет собой алгоритм, часто используемый в играх, включающих состязательные отношения между игроками. Как правило, игру можно оптимизировать с помощью обрезки альфа-бета, которая будет рассмотрена позже в этом разделе.

Алгоритм можно применить к таким играм, как крестики-нолики или ним, которые я приложил к играм ниже вместе с правилами. Вы можете попробовать играть с компьютером в игре — подсказка: вы никогда не выиграете, и мы сейчас увидим, почему.

Вы можете попробовать играть с компьютером в игре — подсказка: вы никогда не выиграете, и мы сейчас увидим, почему.

Крестики-нолики

Крестики-нолики — это игра, в которой оба игрока пытаются поместить свои символы «X» или «O» на поле 3 на 3. Игрок выигрывает, если его символ образует соединение длиной 3. Соединение может быть горизонтальным, вертикальным или диагональным.

Ним

Ним — это игра, в которой игроки пытаются взять определенное количество фишек из набора фишек, игроки должны брать по крайней мере 1 фишку каждый ход. Игрок, который взял последнюю фишку (фишки) из игры, выигрывает игру.

Состязательный поиск

А теперь перейдем к серьезной теме сегодняшнего дня — состязательному поиску. Состязательный поиск создает дерево всех возможных состояний игры, разветвленное по доступным вариантам. Например, в игре Ним с максимальным взятием 3 фишек каждый игрок может взять 1, 2 или 3 фишки, что дает 3 ветви для каждого узла дерева, как показано ниже.

Состязательный поиск, иллюстрированный Нимом, часть 1

Дерево заканчивается, когда не остается фишек. Игрок, взявший последнюю фишку (фишки), выигрывает игру.

Состязательный поиск, иллюстрированный Нимом, часть 2

Дерево содержит все возможные состояния игры, в данном случае 177 состояний. Просматривая все игровые состояния, компьютер будет знать исход игры, прежде чем делать какие-либо ходы.

🤖 Робот А: «Мат в 143 хода».

🤖 Робот B: «Ой, ты снова выиграл».

— Футурама S2E02 Бранниган, Начни снова

Роботы, играющие в шахматы, Футурама S2E02 Бранниган, Начни снова

В области информатики мы также ценим эффективность алгоритмов. Меньший объем вычислений и потребление памяти означает меньшую нагрузку на оборудование и потребление электроэнергии, что приводит к снижению затрат на выполнение алгоритма. Таким образом, вместо того, чтобы перебирать все возможные состояния, существует множество способов упростить задачу.

Например, 8 состояний крестиков-ноликов, показанных ниже, эквивалентны по вращению, и поэтому мы можем рассматривать их как 2 состояния. Эти типы трансляционной и вращательной эквивалентности будут обсуждаться более подробно, когда мы углубимся в сверточные нейронные сети в следующем разделе.

Эти типы трансляционной и вращательной эквивалентности будут обсуждаться более подробно, когда мы углубимся в сверточные нейронные сети в следующем разделе.

Состояния крестики-нолики вращательно эквивалентны

Убрав дополнительные состояния, можно значительно уменьшить размер дерева поиска. В первых 4 слоях дерева поиска более 3500 состояний, если такое сокращение не применяется. Поиск по 3500 состояниям — несложная задача для современного компьютера, но это число растет экспоненциально и может достичь масштаба микросекунд возраста нашей Вселенной, когда дело доходит до более крупной доски, такой как шахматы.

Уменьшенное дерево поиска для Крестики-нолики

Удаление одинаковых состояний в первом слое сокращает 2/3 лишних состояний, но можно ли сделать лучше? Существует небольшая хитрость, называемая сокращением альфа-бета, которую мы обсудим в следующем разделе.

Обрезка альфа-бета

«Я никогда не недооцениваю своего противника, но я никогда не недооцениваю свои таланты».

— Хейл Ирвин

Представьте, что вы играете в крестики-нолики, когда у вашего противника уже есть 2 соединенные фигуры, и вам всегда захочется заблокировать его на другом конце. Почему? Потому что вы можете предположить, что он выиграет в следующем ходу, если вы этого не сделаете. В этом и заключается идея сокращения альфа-бета: вы всегда ожидаете, что ваш противник сделает все возможное, чтобы победить.

Иллюстрация сокращения альфа-бета. Игрок 1 всегда выбирает выигрышный ход.

Для игры в крестики-нолики результат обычно оценивается как двоичный. Однако для некоторых более сложных игр, таких как шахматы, доска может оцениваться с помощью очков. Например, сумма очков белых фигур минус сумма очков черных фигур. И именно тогда альфа-бета-обрезка может стать полезной для устранения ветвей. Вот видео ниже, объясняющее сокращение альфа-бета с помощью шахмат.

Объяснение алгоритмов — минимаксное и альфа-бета сокращение

Что касается игры Ним, ИИ использует гораздо более простую базу правил. Мы прошлись по дереву поиска только потому, что проще объяснить деревья поиска с Нимом. ИИ разделит фишки на кусочки размером на 1 фишку больше, чем максимально допустимый выбор, и будет следить за тем, чтобы каждый раз, когда выбирается один кусок целиком, выбирал разницу между размером куска и выбором игрока. Если патрон не делится, ИИ будет двигаться первым и выбирать остаток. Таким образом, у игрока нет возможности выиграть.

Мы прошлись по дереву поиска только потому, что проще объяснить деревья поиска с Нимом. ИИ разделит фишки на кусочки размером на 1 фишку больше, чем максимально допустимый выбор, и будет следить за тем, чтобы каждый раз, когда выбирается один кусок целиком, выбирал разницу между размером куска и выбором игрока. Если патрон не делится, ИИ будет двигаться первым и выбирать остаток. Таким образом, у игрока нет возможности выиграть.

Иллюстрация Ним ИИ

В такой игре, как шахматы, невозможно легко найти все возможные состояния, как в крестиках-ноликах или ним. Но компьютер, который может искать более 30 слоев в глубину, уже безумно трудно превзойти, так как большинство игроков не могут предвидеть такое количество ходов.

State Machine

«Простое может быть сложнее, чем сложное: вам нужно много работать, чтобы очистить свое мышление, чтобы сделать его простым».

— Стив Джобс

Конечный автомат, обычно называемый конечным автоматом, — это часто недооцениваемая концепция игрового ИИ в наши дни, особенно после того, как машинное обучение с годами приобрело огромную популярность. Однако такой олдскульный дизайн доминировал с винрейтом 96,15% в соревновании SSCAIT 2018, играя против других ИИ StarCraft, использующих машинное обучение.

Однако такой олдскульный дизайн доминировал с винрейтом 96,15% в соревновании SSCAIT 2018, играя против других ИИ StarCraft, использующих машинное обучение.

Изображение SSCAIT и StarCraft, стратегии в реальном времени (RTS), для игры в которую требуются высокие навыки.

Помимо игрового ИИ, конечные автоматы также широко применяются в таких областях, как этот классный ИИ-помощник по телефону от Google. В этом разделе мы углубимся в теорию всех таких чудес.

Google AI Assistant Demo

Конечный автомат, иногда называемый конечным автоматом, обычно представлен группой связанных узлов, формально называемых «график» . График ниже демонстрирует, как обычные читатели взаимодействуют с моей статьей.

Несмотря на то, что Medium просит не просить аплодировать, я понимаю, что люди, которые просят хлопать, получают больше хлопков

Внутри кругов находится то, что мы называем «состояниями» , а стрелки называются «функция перехода состояний» . Функция перехода состояния обычно описывается условием. Например, когда мой читатель находится в состоянии «читателю понравилась моя статья» , он может перейти в состояние 9.0331 «читатель аплодирует моей статье» укажите, если «я прошу аплодировать» или «читатель не забыл аплодировать» . Более формальное математическое определение конечного автомата можно найти здесь.

Функция перехода состояния обычно описывается условием. Например, когда мой читатель находится в состоянии «читателю понравилась моя статья» , он может перейти в состояние 9.0331 «читатель аплодирует моей статье» укажите, если «я прошу аплодировать» или «читатель не забыл аплодировать» . Более формальное математическое определение конечного автомата можно найти здесь.

Вокруг него разработано много интересных теорий, которые в конечном итоге приводят к двум важным темам в информатике: проблеме NP vs. P и машине Тьюринга. Алгоритмы машинного обучения, такие как цепь Маркова, также разделяют некоторые концепции конечного автомата. Мы рассмотрим марковский процесс принятия решений в следующем разделе, когда узнаем об обучении с подкреплением.

«Говорят, что компьютерная программа учится на опыте E в отношении некоторого класса задач T и показателя производительности P, если ее производительность при выполнении задач в T, измеряемая P, улучшается с опытом E».

— Том М. Митчелл

Том М. Митчелл, профессор машинного обучения в Университете Карнеги-Меллона

Как широко используемая цитата, Том М. Митчелл формально определил концепцию машинного обучения как компьютерной программы, которая постепенно повышает производительность с накопленным опытом. . Управляемые алгоритмом машинного обучения, машины будут постепенно продвигаться вперед с новой информацией, которую они получили. Связанные алгоритмы широко применяются во многих областях, которые в наши дни меняют нашу жизнь, например, фильтры Snapchat, которые распознают наше лицо, или Google-переводчик, помогающий нам понимать других, говорящих на иностранных языках. Если вас интересуют некоторые из этих приложений, я также написал руководство по распознаванию лиц, которое можно найти здесь.

В этом разделе мы узнаем о популярной области машинного обучения для игрового ИИ — Reinforcement Learning. Позже популярная нейронная сеть будет рассмотрена в разделе глубокого обучения.

Обучение с подкреплением

«Неудача — это просто возможность начать заново, на этот раз более разумно».

— Генри Форд

«Обучение с подкреплением (RL) — это область машинного обучения, связанная с тем, как программные агенты должны выполнять действия в среде, чтобы максимизировать некоторое понятие совокупного вознаграждения».

— Википедия

Чтобы понять, следующая диаграмма является примером, иллюстрирующим фундаментальную концепцию обучения с подкреплением.

Правда в том, что запрос на хлопки приводит к большему количеству хлопков.

Существует несколько концепций обучения с подкреплением, которые мы можем понять из приведенного выше примера, где хлопки побуждают автора писать более качественные статьи (и просят больше хлопков).

- Среда: Среда — это место, где агенты взаимодействуют друг с другом, в данном случае сообщество Medium — это среда.

- Агент: Агент — это то, что взаимодействует друг с другом и с окружающей средой, в данном случае агентами являются писатели.

Читатели также являются агентами и могут быть описаны конечным автоматом, упомянутым в предыдущем разделе.

Читатели также являются агентами и могут быть описаны конечным автоматом, упомянутым в предыдущем разделе. - Состояния: Состояния включают возможные состояния среды и агента. Например, писатель может спать или занят и не может писать. Журнал Medium может вносить изменения в партнерскую программу или курировать статью, что влияет на видимость.

- Действие: Действие — это то, что агенты могут делать для взаимодействия с окружающей средой и другими агентами. Например, автор может написать привлекательный заголовок, который может увеличить количество просмотров и потенциально увеличить количество аплодисментов.

- Интерпретатор: Интерпретатор — это набор правил, которые оценивают результат для агента, например, каждый хлопок делает меня счастливее на 1 единицу, а каждый повтор — на 50 единиц счастливее.

Агент попытается оптимизировать результат, оцененный интерпретатором, и существует несколько подходов. В этом разделе мы рассмотрим 2 популярных подхода, используемых в игровом ИИ — Q-Learning и поиск по дереву Монте-Карло. Как только мы поймем эти два, мы сможем понять Deep Q-Learning в последующих разделах.

В этом разделе мы рассмотрим 2 популярных подхода, используемых в игровом ИИ — Q-Learning и поиск по дереву Монте-Карло. Как только мы поймем эти два, мы сможем понять Deep Q-Learning в последующих разделах.

Q-Learning

Q-Learning — это простейшая форма обучения с подкреплением. Целью Q-Learning является изучение политики, которая оптимизирует оцениваемый результат агента. Блок-схема ниже объясняет, как это работает для игрока, пытающегося найти лучшего покемона для использования.

Блок-схема, объясняющая Q-обучение с покемонами

Политики обычно определяются матрицами, записывающими шансы каждого действия в каждом состоянии. Агент выполнит действие на основе политик, а затем обновит политики на основе результата действия. Например, если противник вызвал Сквиртла, агент случайным образом выберет покемона. Если агент выбрал Пикачу и обнаружил, что он очень эффективен против Сквиртла, агент затем обновит политики, поэтому у него больше шансов противостоять Сквиртлу Пикачу в будущем. Есть две другие важные концепции, которые мы должны рассмотреть: скорость обучения и марковский процесс принятия решений.

Есть две другие важные концепции, которые мы должны рассмотреть: скорость обучения и марковский процесс принятия решений.

1. Скорость обучения

Обучение описывает, насколько быстро обучается модель. Например, процент может увеличиться на 1% для низкой скорости обучения или на 15% для высокой скорости обучения для того же результата «очень эффективно» .

2. Марковский процесс принятия решений

Марковский процесс принятия решений представляет собой диаграмму состояний, описывающую состояния и действия агентов и среды. Он также описывает вероятность перехода между каждым состоянием и вознаграждение за каждое состояние.

Марковский процесс принятия решений, иллюстрированный покемонами

Для получения дополнительной информации о серьезном математическом определении и доказательстве конвергенции Q-обучения вы можете прочитать их здесь.

Поиск по дереву Монте-Карло

Поиск по дереву Монте-Карло (MCTS) работает аналогично состязательному поиску, описанному в предыдущем разделе. Основное отличие состоит в том, что MCTS случайным образом выбирает ветвь для закрытия, а не пытается перебрать все ветви. Затем алгоритм устанавливает профиль на основе результата этой ветви.

Основное отличие состоит в том, что MCTS случайным образом выбирает ветвь для закрытия, а не пытается перебрать все ветви. Затем алгоритм устанавливает профиль на основе результата этой ветви.

Иллюстрация поиска по дереву Монте-Карло

Формально поиск по дереву Монте-Карло имеет следующие 4 состояния:

1. Выбор

- Выбор обычно осуществляется путем выбора узла с наивысшим коэффициентом выигрыша, но с некоторой случайностью, поэтому могут быть изучены новые стратегии.

2. Расширение

- Расширение — это когда алгоритм расширяется до неисследованных состояний. Алгоритм выбирает случайное неизведанное новое состояние для исследования.

3. Моделирование

- Моделирование — это когда случайный игровой процесс моделируется после расширения, чтобы можно было оценить состояние.

4. Обратное распространение

- Обратное распространение — это процесс обновления значений состояния новой информацией, полученной в результате моделирования.

Этот алгоритм особенно полезен в играх с большим количеством состояний, так как пройти все состояния практически невозможно. Изучая опыт, полученный в предыдущих играх, в будущем можно будет принимать более разумные решения. Дополнительные материалы о выборе узлов между разведкой и эксплуатацией можно найти здесь.

Ниже представлено видео о том, как ИИ играет в Super Mario с помощью алгоритма.

ИИ Игра в Марио с поиском по дереву Монте-Карло

Обучение с подкреплением — это интересная область исследования с множеством различных направлений. Два из них, которые мы рассмотрели в этом разделе, несомненно, помогут нам в понимании более сложного материала в последующих разделах.

Поздравляем, вы зашли так далеко, мы на полпути к пониманию того, как современный игровой ИИ думает и учится. Во второй части этой статьи мы рассмотрим глубокое обучение и нейронные сети, а затем, наконец, сможем перейти к архитектуре ИИ DeepMind.

Кроме того, дайте мне знать, какой стиль письма вам понравился больше всего, я могу сделать классический документальный фильм, серьезную диссертацию или эти яркие примеры покемонов. Ваши отзывы — это то, что позволяет мне изучить лучшую матрицу политики 🤖.

Ваши отзывы — это то, что позволяет мне изучить лучшую матрицу политики 🤖.

ИИ, которому нечему учиться у людей

Технология

Новая программа-самоучка DeepMind делает ходы, которые другие игроки называют «инопланетными» и «из другого измерения».

Дон ЧанМатч в го между AlphaGo и Ke Jie, в котором машина вышла из альфы (China Stringer Network / Reuters)

Это был напряженный летний день в Японии 18:35. Ведущий игрок страны в го, Хонинбо Джова, занял свое место за доской вместо 25-летнего вундеркинда по имени Акабоши Интецу. Оба мужчины посвятили свою жизнь освоению стратегической игры для двух игроков, давно популярной в Восточной Азии. Их противостояние в тот день имело высокие ставки: Хонинбо и Акабоши представляли два дома го, борющихся за власть, и соперничество между двумя лагерями в последнее время вылилось в обвинения в нечестной игре.

Они и не подозревали, что матч, который сейчас вспоминают историки го как «кровоточащая игра», продлится несколько изнурительных дней. Или что это приведет к ужасному концу.

Сначала юный Акабоши взял на себя инициативу. Но затем, согласно преданиям, появились «призраки» и показали Хонинбо три решающих хода. Его возвращение было настолько ошеломляющим, что, как гласит история, его младший противник упал и начал кашлять кровью. Спустя несколько недель Акабоши нашли мертвым. Историки предполагают, что у него могло быть невыявленное респираторное заболевание.

Есть определенный смысл в том, что знатоки игры задавались вопросом, видели ли они проблески оккультизма в этих трех так называемых призрачных движениях. В отличие от чего-то вроде крестиков-ноликов, которые настолько просты, что оптимальная стратегия всегда очевидна, го настолько сложен, что новые, незнакомые стратегии могут показаться удивительными, революционными или даже сверхъестественными.

К несчастью для призраков, теперь компьютеры раскрывают эти вызывающие мурашки движения.

Создается ощущение, что инопланетная цивилизация бросила нам загадочный путеводитель.

Как многие помнят, AlphaGo — программа, которая использовала машинное обучение для освоения го — в начале этого года уничтожила чемпиона мира Ке Цзе. Затем создатели программы из Google DeepMind позволили программе продолжить обучение, сыграв миллионы игр против самой себя. В статье, опубликованной ранее на этой неделе в журнале Nature , , DeepMind сообщила, что новая версия AlphaGo (которую они окрестили AlphaGo Zero) взяла Го с нуля, вообще не изучая никаких человеческих игр. AlphaGo Zero потребовалось всего три дня, чтобы достичь точки, когда она столкнулась с более старой версией самой себя и выиграла 100 игр до нуля.

Теперь, когда AlphaGo, возможно, больше нечему учиться у людей — теперь, когда ее непрерывный прогресс принимает форму бесконечных тренировочных игр против самой себя — как выглядит ее тактика в глазах опытных игроков-людей? У нас могут быть первые проблески ответа.

Последние игры AlphaGo Zero пока не разглашаются. Но несколько месяцев назад компания публично выпустила 55 игр, в которые старая версия AlphaGo играла против самой себя. (Обратите внимание, что это воплощение AlphaGo, которое уже быстро расправилось с чемпионами мира.) DeepMind назвала свое предложение «особым подарком поклонникам го по всему миру».

С мая эксперты тщательно анализируют 55 игр «машина против машины». И их описания ходов AlphaGo, кажется, часто возвращаются к одним и тем же нескольким словам: Удивительно. Странный. Инопланетянин.

«Это то, как я представляю себе игры из далекого будущего», — сказал прессе Ши Юэ, лучший игрок в го из Китая. Энтузиаст го по имени Джонатан Хоп, который просматривает игры на YouTube, называет вбрасывания AlphaGo против AlphaGo «переходом из другого измерения». Судя по всему, создается впечатление, что инопланетная цивилизация бросила среди нас загадочный путеводитель: блестящее руководство — или, по крайней мере, те его части, которые мы можем понять.

«Вы должны быть готовы отрицать многое из того, во что мы верили и что работало на нас».

Уилл Локхарт, аспирант физики и заядлый игрок в го, который был одним из режиссеров The Surrounding Game (документальный фильм об истории времяпрепровождения и приверженцах), попытался описать разницу между просмотром игр AlphaGo против лучших игроков-людей, с одной стороны, и его самопарные игры, с другой. (В 2016 году я взял интервью у брата Уилла, Бена, играющего в го, об интенсивных школах го в Азии.) По словам Уилла, действия AlphaGo против Ке Цзе заставляли его «неизбежно идти к победе», в то время как Ке, казалось, «пробивал кирпичную стену. ” Каждый раз, когда китайский игрок, возможно, находил путь вперед, сказал Локхарт, «10 ходов спустя AlphaGo решала его таким простым способом, и это было похоже на: «Пуф, ну, это никуда не привело!»»

Напротив, игры AlphaGo с самостоятельной парой могли показаться более безумными. Более сложный. Локхарт сравнивает их с «людьми, сражающимися на мечах на канате».

Опытные игроки также замечают особенности AlphaGo. Локхарт и другие упоминают, что он почти одновременно ведет несколько сражений, применяя подход, который может показаться немного сумасбродным игрокам-людям, которые, вероятно, тратят больше энергии, сосредотачиваясь на небольших участках доски за раз. По словам Майкла Редмонда, самого высокопоставленного игрока в го из западного мира (он переехал в Японию в возрасте 14 лет, чтобы изучать го), люди накопили знания, которые могут оказаться более полезными на краях и углах доски. Он отметил, что у AlphaGo «меньше такой предвзятости, поэтому он может делать впечатляющие движения в центре, которые нам труднее понять».

Кроме того, он делает нестандартные начальные ходы. Некоторые из этих гамбитов всего два года назад могли показаться экспертам непродуманными. Но теперь профессиональные игроки копируют некоторые из этих незнакомых тактик в турнирах, даже если никто до конца не понимает, как определенные тактики ведут к победе. Например, люди заметили, что некоторым версиям AlphaGo нравится играть так называемое вторжение три-три на точку звезды, и теперь они тоже экспериментируют с этим ходом в турнирах. Пока никто не видит, что эти эксперименты приводят к четким последовательным победам, может быть, потому, что игроки-люди не понимают, как лучше довести дело до конца.

Например, люди заметили, что некоторым версиям AlphaGo нравится играть так называемое вторжение три-три на точку звезды, и теперь они тоже экспериментируют с этим ходом в турнирах. Пока никто не видит, что эти эксперименты приводят к четким последовательным победам, может быть, потому, что игроки-люди не понимают, как лучше довести дело до конца.

Некоторые ходы, которые AlphaGo любит делать против своего клона, совершенно непонятны даже лучшим игрокам мира. (Это, как правило, происходит в начале игры — вероятно, потому, что эта фаза уже загадочна, так как она наиболее далека от любого окончательного результата игры.) Один начальный ход в первой игре поставил многих игроков в тупик. Говорит Редмонд: «Я думаю, что естественная реакция (и реакция, которую я в основном наблюдаю) заключается в том, что они просто сдаются и как бы вскидывают руки в дебюте. Потому что так сложно пытаться прикрепить рассказ о том, что делает AlphaGo. Вы должны быть готовы отрицать многое из того, во что мы верили и что работало на нас».

Как и другие, Редмонд отмечает, что игры почему-то кажутся «чужими». «В том, как играет AlphaGo, есть какой-то бесчеловечный элемент, — говорит он, — из-за чего нам очень трудно хотя бы немного войти в игру».

«Обычно люди изучают го, когда у нас есть история».

Тем не менее, Редмонд считает, что бывают моменты, когда AlphaGo (по крайней мере, его старая версия) не обязательно может быть загадочно, трансцендентно хороша. Моменты, когда он может даже совершать ошибки. Есть модели игры под названием дзёсэки — серии локально ограниченных атак и ответов, в которых игроки, по сути, сражаются до тех пор, пока у них не появится смысл переместиться в другую часть доски. Некоторые из этих дзёсэки были проанализированы, запомнены и отточены поколениями. Редмонд подозревает, что люди могут лучше реагировать на некоторые из этих паттернов, потому что они так интенсивно их анализировали. (Трудно сказать, потому что в играх AlphaGo-versus-AlphaGo обе «копии» программы, кажется, избегают попадания в эти joseki в первую очередь. )

)

Не исключено, что AlphaGo все еще может выбирать неоптимальные ходы — делать «ошибки», если хотите. Го можно представить как массивное дерево, состоящее из тысяч ветвей, представляющих возможные ходы и контрходы. На протяжении поколений игроки в го идентифицировали определенные кластеры ветвей, которые, кажется, работают очень хорошо. И теперь, когда появилась AlphaGo, она находит еще лучшие варианты. Тем не менее, огромные участки дерева могут быть еще не исследованы. Как выразился Локхарт: «Возможно, совершенный Бог играет [AlphaGo] и разрушает его. А может и нет. Может быть, это уже есть. Мы не знаем».

* * *

По словам Редмонда, из своей родной базы в Тибе, Япония, последние четыре месяца он более или менее непрерывно изучал игры AlphaGo с парными играми. Он записывает на видео свои комментарии к каждой игре и размещает одно видео в неделю на канале Американской ассоциации го на YouTube. По его словам, одна из его самых больших проблем в этих видео — «прикрепить истории» к движениям AlphaGo.

Количество вариантов со временем уменьшается, однако если учесть, что за партию игрок делает около 45-75 ходов, то видно, что ему нужно проводить просто огромный анализ игрового поля. Ведь ему нужно выстраивать фигуры, чтобы окружить камни соперника. Поэтому поставленный камень на 5-м ходу может принести пользу только на 45-м ходу. А может и не принести пользу вообще. Все эти комбинации нужно уметь просчитывать, поэтому профессиональная игра в Го считается довольно сложной. Однако в 2016 году была разработана программа АльфаГо и проведена игра в Го с тогдашним чемпионом Ли Седолем. Человек проиграл со счетом 4:1, сумев выиграть один раз у программы.

Количество вариантов со временем уменьшается, однако если учесть, что за партию игрок делает около 45-75 ходов, то видно, что ему нужно проводить просто огромный анализ игрового поля. Ведь ему нужно выстраивать фигуры, чтобы окружить камни соперника. Поэтому поставленный камень на 5-м ходу может принести пользу только на 45-м ходу. А может и не принести пользу вообще. Все эти комбинации нужно уметь просчитывать, поэтому профессиональная игра в Го считается довольно сложной. Однако в 2016 году была разработана программа АльфаГо и проведена игра в Го с тогдашним чемпионом Ли Седолем. Человек проиграл со счетом 4:1, сумев выиграть один раз у программы. А так как в игре Го игровых вариаций очень и очень много, то и дерево получилось очень разветвленным и глубоким, и только на его разработку потребовалась масса времени.

А так как в игре Го игровых вариаций очень и очень много, то и дерево получилось очень разветвленным и глубоким, и только на его разработку потребовалась масса времени. Данные нейронные сети самостоятельно «дописывали» собственные деревья, если вдруг, двигаясь по какой-либо ветке, они достигали ее конца. Потом эти две сети сталкивали между собой и давали им возможность играть друг с другом, тем самым они еще больше «прокачивались».

Данные нейронные сети самостоятельно «дописывали» собственные деревья, если вдруг, двигаясь по какой-либо ветке, они достигали ее конца. Потом эти две сети сталкивали между собой и давали им возможность играть друг с другом, тем самым они еще больше «прокачивались». Во-вторых, в соперниках был один из самых титулованных и лучших игроков по Го Ли Седол. А в-третьих, это единственный игрок, который обыграл компьютер, хоть и проиграл по партиям. В честь этого та версия программы стала называться AlphaGo Lee.

Во-вторых, в соперниках был один из самых титулованных и лучших игроков по Го Ли Седол. А в-третьих, это единственный игрок, который обыграл компьютер, хоть и проиграл по партиям. В честь этого та версия программы стала называться AlphaGo Lee.