Содержание

Маск назвал самый опасный для человечества искусственный интеллект

- Миллиардеры

- Ринат Таиров

Редакция Forbes

Принадлежащий Google стартап DeepMind разрабатывает искусственный интеллект, который на данный момент является самым опасным для человечества, считает Илон Маск. Он допускает, что уже через пять лет компьютерное мышление превзойдет человека

Искусственный интеллект, который разрабатывает принадлежащая Google компания DeepMind, вызывает большие опасения, заявил гендиректор Tesla Илон Маск в интервью The New York Times. Маск — давний сторонник контроля за разработкой компьютерного мышления, и, по словам миллиардера, DeepMind на данный момент беспокоит его больше всего.

Маск — давний сторонник контроля за разработкой компьютерного мышления, и, по словам миллиардера, DeepMind на данный момент беспокоит его больше всего.

«Даже сама суть искусственного интеллекта, которую они создают, — из тех, что уничтожают всех людей во всех играх. Это буквально сюжет «Военных игр»», — отметил Маск. «Военные игры» — американский фильм 1983 года. По сюжету, хакер взламывает компьютерную сеть военных США и запускает искусственный интеллект, который чуть не приводит к ядерной войне между СССР и США.

Работа над искусственным интеллектом для автомобилей Tesla показала миллиардеру, что человечество уже приближается к ситуации, когда искусственный интеллект будет существенно умнее, чем люди. «Я думаю, что до этого меньше пяти лет. Это не значит, что все пойдет к чертям через пять лет. Просто ситуация станет нестабильной или странной», — прогнозирует Маск. По его словам, многие умные люди недооценивают искусственный интеллект, потому что даже не думают, что компьютер может быть столь же умным, как человек. «Это гордыня и очевидная ошибка», — категоричен бизнесмен.

«Это гордыня и очевидная ошибка», — категоричен бизнесмен.

Новый образ роботов: как пандемия изменила отношение к искусственному интеллекту

Маск высказывает мысли об опасности искусственного интеллекта как минимум с 2014 года. Тогда он написал в Twitter, что человечеству нужно быть крайне осторожным с технологией, которая «потенциально более опасна, чем ядерное оружие».

August 3, 2014

Выступая в Массачусетском технологическом институте, Маск говорил, что это может быть самой существенной угрозой человечеству: «С искусственным интеллектом мы призываем демона. Во всех историях про парня с пентаграммой и святой водой этот парень уверен, что сможет контролировать демона. Не выходило». В 2018-м он отмечал, что сейчас искусственный интеллект во многом сосредоточен в руках крупнейших компаний: «Есть очень сильная концентрация мощи искусственного интеллекта, в особенности в Google/DeepMind. Я очень хорошо отношусь к [сооснователю Google] Ларри Пейджу и [основателю DeepMind] Демису Хассабису, но я думаю, что необходим некоторый независимый надзор».

Я очень хорошо отношусь к [сооснователю Google] Ларри Пейджу и [основателю DeepMind] Демису Хассабису, но я думаю, что необходим некоторый независимый надзор».

Диагноз по селфи. Как пять российских ученых научили искусственный интеллект оценивать людей по фото

DeepMind — британская программа, которая занимается разработкой искусственного интеллекта. Google купила ее в 2014 году. Компания известна тем, что разработала программное обеспечение, которое смогло обыграть человека в го и в шахматы. Илон Маск был одним из ранних инвесторов DeepMind. Он говорил Vanity Fair, что его инвестиции были не попыткой заработать на компании, а скорее возможностью следить за тем, как развивается искусственный интеллект. Как описывал журнал, Маск однажды впервые встретился с Хассабисом в США. Маск ему заявил, что занимается самой важной задачей человечества — межпланетной колонизацией. Хассабис возразил, что это он занят самой важной задачей — разработкой искусственного интеллекта. Тогда Маск возразил, что это одна из причин необходимости колонизировать Марс — чтобы иметь запасной плацдарм на случай, если компьютеры восстанут против людей. Хассабис парировал, что искусственный интеллект попросту последует за людьми на Марс.

Тогда Маск возразил, что это одна из причин необходимости колонизировать Марс — чтобы иметь запасной плацдарм на случай, если компьютеры восстанут против людей. Хассабис парировал, что искусственный интеллект попросту последует за людьми на Марс.

Деньги из будущего: как и зачем россияне инвестируют в SpaceX Илона Маска

В 2018 году Маск, Хассабис и DeepMind публично пообещали не разрабатывать, не производить и не использовать роботов для убийства людей.

August 12, 2017

Мысли визионера: все изобретения Илона Маска

7 фото

Ринат Таиров

Редакция Forbes

#Илон Маск

#искусственный интеллект

Рассылка Forbes

Самое важное о финансах, инвестициях, бизнесе и технологиях

Эксперт рассказал об опасности искусственного интеллекта

Istock

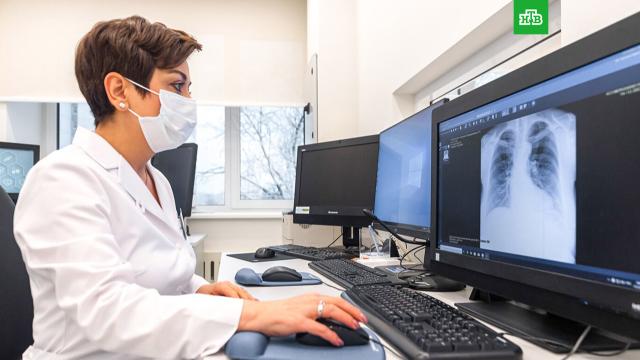

Еврокомиссия предложила наложить полный запрет на применение систем искусственного интеллекта (ИИ) в ряде случаев. В первую очередь, в случаях, связанных с человеческими судьбами и свободой выбора человека. Какие опасности несет бурное развитие технологий ИИ, рассказал в интервью RT эксперт по глубоким нейронным сетям и машинному обучению, разработчик систем распознавания и синтеза изображений, голоса и экспертных систем Станислав Ашманов.

В первую очередь, в случаях, связанных с человеческими судьбами и свободой выбора человека. Какие опасности несет бурное развитие технологий ИИ, рассказал в интервью RT эксперт по глубоким нейронным сетям и машинному обучению, разработчик систем распознавания и синтеза изображений, голоса и экспертных систем Станислав Ашманов.

Искусственный интеллект — это прежде всего любая замена человеческого труда на машину, на математический алгоритм. Прогресс достиг такого уровня, что он может принимать решение самостоятельно, без участия специалистов. Вот эту его способность можно использовать далеко не любым образом, поскольку это несет в себе опасность. Особенно в военной сфере или в личном пространстве человека.

Чтобы предупредить эту опасность и заранее подготовиться к возможным рискам из-за неправильного использования ИИ, необходимо ввести строгие правила, считает Ашманов. По аналогии с правилами дорожного движения — они не ограничили прогресс и развитие автомобильной отрасли, но при этом общество может гарантировать меньшее количество жертв на дорогах.

Эксперт приводит пример, как простой цифровой кредитный рейтинг, которым пользуются банки, может повлиять на судьбу человека: если у человека плохая кредитная история, ему не дадут кредит, он не сможет купить квартиру и улучшить свою жизнь. А если искусственный интеллект проставит человеку глобальный социальный рейтинг, цифровизируя и автоматизируя всю его жизнь — и вынесет математическую формулу — решение, которое полностью дискредитирует его?

«Опасность в том, что мы делегируем искусственному интеллекту ответственность принимать решения о наших судьбах. А он не обладает никаким, так сказать, моральным компьютером, моральным вычислителем, — говорит ученый. — И если мы важные решения передадим машине, то окажемся в заложниках не просто алгоритма, а разработчиков алгоритма… Это не то, к чему хочется прийти».

С помощью ИИ любого человека можно отследить в офлайн и в цифровом пространстве и использовать полученную информацию против него.

Необходима сертификация продуктов с искусственным интеллектом, чтобы убедиться, что они соблюдают этические нормы. «Нельзя давать автоматическим системам и алгоритмам принимать решения о человеческих судьбах, — считает Ашманов. — Мы не должны увидеть роботов-судей, роботов-юристов, которые решают, как распределить детей между родителями, кому отдать имущество»

«Нельзя давать автоматическим системам и алгоритмам принимать решения о человеческих судьбах, — считает Ашманов. — Мы не должны увидеть роботов-судей, роботов-юристов, которые решают, как распределить детей между родителями, кому отдать имущество»

«А беспилотники, которые сами принимают решение о нанесении удара, умные мины, которые отличают солдата одной стороны от другой. Здесь возможны всякие ужасы, если не получится договориться», — предупреждает ученый.

Как отмечает Станислав Ашманов, разработки умного оружия и другая военная продукция в области искусственного интеллекта не попадут под законодательные ограничения.

Напротив, американцы, например, хотят добиться присутствия искусственного интеллекта во всех государственных организациях, чтобы разведка использовала человеко-машинные методы работы с информацией. Она важна также для корпораций, которые обзаводятся гигантской клиентской базой.

Поделиться:

НаукаНаука

Риски, связанные с искусственным интеллектом

Мы являемся частью сообщества технологов, ученых и политиков, разделяющих интерес к безопасному и глобально полезному искусственному интеллекту (ИИ). Мы работаем в партнерстве с ними, чтобы продуктивно формировать общественное обсуждение, поощрять новые таланты и запускать новые центры, такие как Leverhulme Center for the Future of Intelligence. В нашем исследовании были рассмотрены технические вопросы, связанные с безопасностью ИИ, краткосрочными и долгосрочными последствиями безопасности и управлением ИИ, а также потенциалом ИИ для снижения экологических и биологических рисков.

Мы работаем в партнерстве с ними, чтобы продуктивно формировать общественное обсуждение, поощрять новые таланты и запускать новые центры, такие как Leverhulme Center for the Future of Intelligence. В нашем исследовании были рассмотрены технические вопросы, связанные с безопасностью ИИ, краткосрочными и долгосрочными последствиями безопасности и управлением ИИ, а также потенциалом ИИ для снижения экологических и биологических рисков.

Область ИИ быстро развивается. В последние годы произошли впечатляющие прорывы в области распознавания изображений и речи, автономной робототехники, языковых задач и игр. В ближайшие десятилетия, вероятно, будет достигнут существенный прогресс. Это сулит большие выгоды: новые научные открытия, более дешевые и качественные товары и услуги, достижения в области медицины. Наши исследования и совместные проекты касались применения ИИ для решения ряда глобальных задач, включая борьбу с изменением климата, реагирование на пандемию и обеспечение продовольственной безопасности.

ИИ также вызывает опасения в краткосрочной перспективе: конфиденциальность, предвзятость, неравенство, безопасность и защищенность. Исследование CSER выявило новые угрозы и тенденции в глобальной кибербезопасности, а также изучило проблемы на пересечении ИИ, оцифровки и систем ядерного оружия.

AlphaGo Zero достиг сверхчеловеческого уровня производительности после трех дней самостоятельной игры

Большинство современных систем искусственного интеллекта представляют собой «узкие» приложения, специально разработанные для решения четко определенной проблемы в одной области, например, в конкретной игре. Такие подходы не могут адаптироваться к новым или более масштабным задачам без существенной перестройки. Хотя в одной области он может намного превосходить возможности человека, в других областях он не превосходит его. Однако давней целью в этой области была разработка искусственного интеллекта, который может обучаться и адаптироваться к очень широкому кругу задач.

ИИ в долгосрочной перспективе: возможности и угрозы

По мере того, как системы ИИ становятся более мощными и более универсальными, они могут превзойти возможности человека во многих областях. Если это произойдет, это может стать переходом, столь же преобразующим в экономическом, социальном и политическом плане, как промышленная революция. Это может привести к чрезвычайно позитивным изменениям, но также потенциально может создать катастрофические риски, связанные с авариями (безопасность) или неправильным использованием (безопасность).

О безопасности: наши нынешние системы часто дают непредсказуемые сбои. Существует ряд сложных технических проблем, связанных с проектированием безаварийного искусственного интеллекта. Согласование поведения текущих систем с нашими целями оказалось трудным и привело к непредсказуемым отрицательным результатам. Аварии, вызванные более мощными системами, будут гораздо более разрушительными.

О безопасности: передовые системы искусственного интеллекта могут быть ключевыми экономическими и военными активами. Если бы эти системы оказались в руках недобросовестных игроков, они могли бы использовать их во вред. Если несколько групп соревнуются за его разработку первыми, это может иметь дестабилизирующую динамику гонки вооружений. Снижение рисков и достижение глобальных преимуществ ИИ создадут уникальные проблемы управления и потребуют глобального сотрудничества и представительства.

Если бы эти системы оказались в руках недобросовестных игроков, они могли бы использовать их во вред. Если несколько групп соревнуются за его разработку первыми, это может иметь дестабилизирующую динамику гонки вооружений. Снижение рисков и достижение глобальных преимуществ ИИ создадут уникальные проблемы управления и потребуют глобального сотрудничества и представительства.

На пути к безопасному и полезному преобразующему ИИ

Существует большая неопределенность и разногласия по поводу сроков разработки передовых систем искусственного интеллекта. Но какой бы ни была скорость прогресса в этой области, кажется, что есть полезная работа, которую можно сделать прямо сейчас. Технические исследования машинного обучения в области безопасности в настоящее время проводятся командами OpenAI, DeepMind и Центра искусственного интеллекта, совместимого с человеком. Исследования управления ИИ в отношении последствий для безопасности развиваются как область.

Сообщество, работающее над безопасным и полезным сверхразумом, выросло по всему миру. Это исходит от исследователей ИИ, демонстрирующих лидерство в этом вопросе, что подтверждается обширными дискуссиями в лабораториях и конференциях по машинному обучению, знаковой конференцией в Пуэрто-Рико и высококлассной поддержкой таких людей, как советники CSER Илон Маск и Стивен Хокинг. Мы тесно сотрудничаем с этим сообществом, в университетских лабораториях и в технологических компаниях, чтобы разработать общие стратегии, позволяющие безопасно реализовать преимущества достижений ИИ.

Это исходит от исследователей ИИ, демонстрирующих лидерство в этом вопросе, что подтверждается обширными дискуссиями в лабораториях и конференциях по машинному обучению, знаковой конференцией в Пуэрто-Рико и высококлассной поддержкой таких людей, как советники CSER Илон Маск и Стивен Хокинг. Мы тесно сотрудничаем с этим сообществом, в университетских лабораториях и в технологических компаниях, чтобы разработать общие стратегии, позволяющие безопасно реализовать преимущества достижений ИИ.

В ближайшие годы будут разработаны и внедрены более продвинутые и мощные системы искусственного интеллекта, эти системы могут иметь преобразующие последствия, как положительные, так и отрицательные, и кажется, что мы можем делать полезную работу прямо сейчас. Несмотря на то, что существует много неопределенностей, мы должны приложить серьезные усилия и подумать, чтобы заложить основы безопасности будущих систем и лучше понять последствия таких достижений.

Чтобы прочитать об одном из текущих проектов CSER, «Парадигмы общего искусственного интеллекта и связанные с ними риски», финансируемого Институтом будущего жизни в рамках Международного конкурса грантов FLI по безопасности, нажмите здесь.

Противостояние рискам ИИ | МакКинзи

Статья (PDF-670KB)

Искусственный интеллект (ИИ) оказался обоюдоострым мечом. Хотя это можно сказать о большинстве новых технологий, обе стороны лезвия ИИ намного острее, и ни одна из них не совсем понятна.

Рассмотрим сначала положительное. Эти технологии начинают улучшать нашу жизнь множеством способов: от упрощения покупок до улучшения медицинского обслуживания. Их ценность для бизнеса также стала неоспоримой: почти 80% руководителей компаний, внедряющих ИИ, недавно сказали нам, что они уже видят в нем умеренную пользу. Хотя широкое использование ИИ в бизнесе все еще находится в зачаточном состоянии и остаются открытыми вопросы о темпах прогресса, а также о возможности достижения святого Грааля «общего интеллекта», потенциал огромен. Исследование Глобального института McKinsey предполагает, что к 2030 году ИИ может обеспечить дополнительную глобальную экономическую отдачу в размере 13 триллионов долларов в год.

Тем не менее, хотя ИИ создает потребительские преимущества и ценность для бизнеса, он также приводит к множеству нежелательных, а иногда и серьезных последствий. И хотя в этой статье мы сосредоточимся на искусственном интеллекте, эти побочные эффекты (и способы их предотвращения или смягчения) в равной степени применимы ко всей расширенной аналитике. Наиболее заметных из них, к которым относятся нарушения неприкосновенности частной жизни, дискриминация, несчастные случаи и манипулирование политическими системами, более чем достаточно, чтобы вызвать осторожность. Еще большее беспокойство вызывают последствия, которые еще не известны и не испытаны. Возможны катастрофические последствия, в том числе гибель людей, если медицинский алгоритм ИИ даст сбой, или угроза национальной безопасности, если противник передаст дезинформацию военной системе ИИ, а также серьезные проблемы для организаций из-за ущерба репутации. и потери доходов из-за негативной реакции регулирующих органов, уголовного расследования и снижения общественного доверия.

Поскольку ИИ — это относительно новая сила в бизнесе, немногие руководители имели возможность отточить свою интуицию в отношении всего спектра социальных, организационных и индивидуальных рисков или получить практические знания о связанных с ними движущих силах, которые варьируются от данных вводимые в системы ИИ для работы алгоритмических моделей и взаимодействия между людьми и машинами. В результате руководители часто упускают из виду потенциальные опасности («Мы не используем ИИ ни в чем, что может «взорваться», например, в беспилотных автомобилях») или переоценивают возможности организации по снижению рисков («Мы проводили аналитику для долгое время, поэтому у нас уже есть необходимые средства контроля, и наши методы соответствуют практикам наших коллег по отрасли»). Руководители также часто сваливают риски ИИ в одну кучу с другими рисками, принадлежащими специалистам в области ИТ и аналитики («Я доверяю своей технической команде, они делают все возможное, чтобы защитить наших клиентов и нашу компанию»).

Лидеры, надеющиеся избежать или, по крайней мере, смягчить непредвиденные последствия, должны как развивать свои навыки распознавания закономерностей в отношении рисков ИИ, так и задействовать всю организацию, чтобы она была готова принять силу и ответственность, связанные с ИИ. Уровень усилий, необходимых для выявления и контроля всех ключевых рисков, значительно превышает действующие нормы в большинстве организаций. Для достижения реального прогресса требуется междисциплинарный подход с участием руководителей высшего звена и всей компании; эксперты в самых разных областях: от права и рисков до ИТ, безопасности и аналитики; и менеджеры, которые могут обеспечить бдительность на передовой.

Эта статья призвана помочь, сначала проиллюстрировав ряд ловушек, на которые легко не обращать внимания. Затем в нем представлены схемы, которые помогут лидерам определить самые большие риски и внедрить широкий и глубокий контроль нюансов, необходимых для их обхода. Наконец, он дает первое представление о некоторых реальных усилиях, которые в настоящее время предпринимаются для устранения рисков ИИ посредством применения этих подходов.

Прежде чем продолжить, мы хотим подчеркнуть, что здесь мы сосредоточены на последствиях первого порядка, которые возникают непосредственно в результате разработки решений ИИ, их непреднамеренного или преднамеренного неправильного применения или неправильного обращения с входными данными, которые их подпитывают. Есть и другие важные последствия, среди которых широко обсуждаемый потенциал массовой потери рабочих мест в некоторых отраслях из-за автоматизации рабочих мест с помощью ИИ. Существуют также эффекты второго порядка, такие как атрофия навыков (например, диагностических навыков медицинских работников) по мере роста важности систем ИИ. Эти последствия будут по-прежнему привлекать внимание по мере того, как их воспринимаемая важность будет возрастать, но здесь они выходят за рамки нашего рассмотрения.

Понимание рисков и их факторов

Когда с ИИ что-то идет не так и выявляется основная причина проблемы, часто трясется голова. Оглядываясь назад, кажется невообразимым, что никто этого не предвидел. Но если вы возьмете опрос высокопоставленных руководителей о риске возникновения следующих ИИ, вы вряд ли получите какой-либо консенсус.

Но если вы возьмете опрос высокопоставленных руководителей о риске возникновения следующих ИИ, вы вряд ли получите какой-либо консенсус.

Лидеры, надеющиеся перейти от ретроспективы к предвидению, должны лучше понимать типы рисков, на которые они идут, их взаимозависимость и лежащие в их основе причины. Чтобы помочь развить эту недостающую интуицию, мы опишем ниже пять болевых точек, которые могут привести к рискам ИИ. Первые три — трудности с данными, проблемы с технологиями и проблемы с безопасностью — связаны с тем, что можно назвать факторами, способствующими развитию ИИ. Последние два связаны с алгоритмами и взаимодействием человека и машины, которые играют центральную роль в работе самого ИИ. Ясно, что мы все еще только начинаем понимать, что стоит за рисками, на которые мы беремся, характер и масштабы которых мы также попытались перечислить в Таблице 19.0003

Экспонат 1

Мы стремимся предоставить людям с ограниченными возможностями равный доступ к нашему веб-сайту. Если вам нужна информация об этом контенте, мы будем рады работать с вами. Пожалуйста, напишите нам по адресу: [email protected]

Если вам нужна информация об этом контенте, мы будем рады работать с вами. Пожалуйста, напишите нам по адресу: [email protected]

Проблемы с данными. Прием, сортировка, связывание и правильное использование данных становятся все более сложными по мере увеличения объема неструктурированных данных, получаемых из таких источников, как Интернет, социальные сети, мобильные устройства, датчики и Интернет вещей. В результате легко стать жертвой ловушек, таких как непреднамеренное использование или раскрытие конфиденциальной информации, скрытой среди анонимных данных. Например, хотя имя пациента может быть удалено из одного раздела медицинской карты, используемой системой искусственного интеллекта, оно может присутствовать в разделе заметок врача. Руководителям важно помнить о таких соображениях, поскольку они работают над соблюдением правил конфиденциальности, таких как Общий регламент ЕС по защите данных (GDPR) или Калифорнийский закон о конфиденциальности потребителей (CCPA), и иным образом управляют репутационными рисками.

Технологические проблемы. Проблемы с технологиями и процессами во всей операционной среде могут негативно повлиять на производительность систем искусственного интеллекта. Например, одно крупное финансовое учреждение столкнулось с проблемой после того, как его программное обеспечение не смогло выявить проблемы с торговлей, поскольку потоки данных больше не включали все сделки клиентов.

Проблемы безопасности. Еще одна возникающая проблема заключается в том, что мошенники могут использовать, казалось бы, неконфиденциальные маркетинговые, медицинские и финансовые данные, которые компании собирают для подпитки систем искусственного интеллекта. Если меры безопасности недостаточны, можно сшить эти нити вместе, чтобы создать ложные личности. Хотя целевые компании (которые в противном случае могли бы очень эффективно защищать личную информацию) являются невольными сообщниками, они все же могут столкнуться с негативной реакцией потребителей и последствиями со стороны регулирующих органов.

Неверное поведение моделей. Сами модели ИИ могут создавать проблемы, когда они дают необъективные результаты (что может произойти, например, если население недостаточно представлено в данных, используемых для обучения модели), становятся нестабильными или дают выводы, для которых нет действенных средств правовой защиты. те, на кого повлияли его решения (например, кто-то отказал в кредите, не зная, что они могут сделать, чтобы отменить решение). Рассмотрим, например, потенциал моделей ИИ для непреднамеренной дискриминации защищенных классов и других групп путем объединения почтовых индексов и данных о доходах для создания целевых предложений. Сложнее обнаружить случаи, когда модели ИИ скрываются в предложениях «программное обеспечение как услуга» (SaaS). Когда поставщики внедряют новые интеллектуальные функции — часто с небольшой помпой — они также представляют модели, которые могут взаимодействовать с данными в системе пользователя, создавая неожиданные риски, в том числе создавая скрытые уязвимости, которыми могут воспользоваться хакеры. Подразумевается, что лидеры, которые считают, что они в безопасности, если их организация не приобрела или не построила системы ИИ или только экспериментирует с их развертыванием, вполне могут ошибаться.

Подразумевается, что лидеры, которые считают, что они в безопасности, если их организация не приобрела или не построила системы ИИ или только экспериментирует с их развертыванием, вполне могут ошибаться.

Проблемы взаимодействия. Интерфейс между людьми и машинами — еще одна ключевая область риска. Среди наиболее заметных проблем — автоматизированные транспортные, производственные и инфраструктурные системы. Несчастные случаи и травмы возможны, если операторы тяжелого оборудования, транспортных средств или другой техники не распознают, когда системы должны быть отключены, или не спешат блокировать их, потому что внимание оператора сосредоточено на чем-то другом — явная возможность в таких приложениях, как беспилотные автомобили. И наоборот, человеческое суждение также может оказаться ошибочным при переопределении результатов системы. За кулисами, в организации, занимающейся анализом данных, ошибки сценариев, упущения в управлении данными и неверные оценки данных для обучения модели легко могут поставить под угрозу справедливость, конфиденциальность, безопасность и соответствие требованиям. Персонал на переднем крае также может непреднамеренно внести свой вклад, например, когда торговый персонал, более опытный в продажах определенной демографической группе, непреднамеренно обучает инструмент продаж на основе ИИ, чтобы исключить определенные сегменты клиентов. И это только непреднамеренных последствий. Без строгих мер безопасности недовольные сотрудники или внешние враги могут испортить алгоритмы или злонамеренно использовать приложение ИИ.

Персонал на переднем крае также может непреднамеренно внести свой вклад, например, когда торговый персонал, более опытный в продажах определенной демографической группе, непреднамеренно обучает инструмент продаж на основе ИИ, чтобы исключить определенные сегменты клиентов. И это только непреднамеренных последствий. Без строгих мер безопасности недовольные сотрудники или внешние враги могут испортить алгоритмы или злонамеренно использовать приложение ИИ.

Управление рисками ИИ: три основных принципа

Приведенные выше примеры и категоризация не только дают представление о предстоящих проблемах, но и полезны для выявления и приоритизации рисков и их основных причин. Если вы понимаете, где могут скрываться риски, которые могут быть плохо поняты или просто не идентифицированы, у вас больше шансов поймать их до того, как они настигнут вас.

Но вам потребуются концентрированные усилия всего предприятия, чтобы перейти от каталогизации рисков к их устранению. Опыт двух ведущих банков помогает проиллюстрировать необходимую ясность, широту и детальную строгость. Первый, европейский игрок, работает над применением расширенной аналитики и возможностей искусственного интеллекта для оптимизации колл-центра, принятия решений по ипотеке, управления отношениями и инициатив по управлению казначейством. Второй — мировой лидер, стремящийся применить модель машинного обучения к своим кредитным решениям.

Опыт двух ведущих банков помогает проиллюстрировать необходимую ясность, широту и детальную строгость. Первый, европейский игрок, работает над применением расширенной аналитики и возможностей искусственного интеллекта для оптимизации колл-центра, принятия решений по ипотеке, управления отношениями и инициатив по управлению казначейством. Второй — мировой лидер, стремящийся применить модель машинного обучения к своим кредитным решениям.

Хотите узнать больше о нашей практике аналитики?

Эти банки, как и многие другие в секторе финансовых услуг, применяют некоторые формы расширенной аналитики в течение ряда лет, начиная с их раннего использования для обнаружения мошенничества с кредитными картами и торговли ценными бумагами. Они также подлежат высокому уровню регулирующего надзора и поэтому уже давно применяют и делают прозрачными широкий спектр протоколов и средств контроля для снижения связанных рисков, включая риск кибербезопасности, где они часто находятся на переднем крае, учитывая очевидную привлекательность свои активы злоумышленникам.

Тем не менее, истории этих банков иллюстрируют только подмножество средств контроля рисков, которые организациям следует учитывать. На рисунке 2 представлен более полный список возможных элементов управления, охватывающих весь процесс аналитики, от планирования до разработки и последующего использования и мониторинга. Мы надеемся, что в совокупности этот инструмент и примеры помогут руководителям, которым приходится сталкиваться с широким кругом вопросов — от недопущения предвзятости в механизмах рекомендаций до устранения рисков, связанных с идентификацией личности, до лучшей адаптации ответов ботов обслуживания клиентов к потребностям конкретных людей. клиентов и многое другое.

Экспонат 2

Мы стремимся предоставить людям с ограниченными возможностями равный доступ к нашему веб-сайту. Если вам нужна информация об этом контенте, мы будем рады работать с вами. Пожалуйста, напишите нам по адресу: [email protected]

Ясность: используйте структурированный подход к идентификации, чтобы точно определить наиболее важные риски

Главный операционный директор европейского банка начал с того, что собрал лидеров бизнеса, ИТ, безопасности и управления рисками, чтобы оценить и приоритизировать самые большие риски. Исходные данные для этого упражнения включали ясный взгляд на существующие риски компании и то, как они могут быть усугублены рассматриваемыми аналитическими усилиями, основанными на ИИ, а также на новые риски, которые могут создавать средства реализации ИИ или сам ИИ. Одни были очевидны, другие менее. Одной из них, которая неожиданно оказалась на вершине списка, стала доставка потребителям некачественных или предвзятых рекомендаций по продукту. Такие ошибочные рекомендации могут привести к значительному ущербу и ущербу, включая потери потребителей, негативную реакцию и штрафы регулирующих органов.

Исходные данные для этого упражнения включали ясный взгляд на существующие риски компании и то, как они могут быть усугублены рассматриваемыми аналитическими усилиями, основанными на ИИ, а также на новые риски, которые могут создавать средства реализации ИИ или сам ИИ. Одни были очевидны, другие менее. Одной из них, которая неожиданно оказалась на вершине списка, стала доставка потребителям некачественных или предвзятых рекомендаций по продукту. Такие ошибочные рекомендации могут привести к значительному ущербу и ущербу, включая потери потребителей, негативную реакцию и штрафы регулирующих органов.

С помощью этого структурированного процесса выявления рисков руководители банка получили четкое представление о наиболее тревожных сценариях, что позволило им определить приоритеты охватываемых рисков, распознать отсутствующие средства контроля и соответствующим образом распределить время и ресурсы. Эти сценарии и приоритеты рисков, естественно, будут различаться в зависимости от отрасли и компании. Производитель продуктов питания может расставить приоритеты в сценариях с загрязненными продуктами. Разработчик программного обеспечения может быть особенно обеспокоен раскрытием программного кода. Организация здравоохранения может сосредоточиться на таких проблемах, как ошибочный диагноз пациента или непреднамеренное причинение вреда пациенту. Сосредоточение внимания различных менеджеров на выявлении и распределении проблемных сценариев по уровням — хороший способ как стимулировать творческую энергию, так и снизить риск того, что узкие специалисты или ограниченное мышление упустят основные уязвимые места. Организациям не нужно начинать с нуля: за последние несколько лет выявление рисков стало хорошо развитым искусством, и его можно напрямую использовать в контексте ИИ.

Производитель продуктов питания может расставить приоритеты в сценариях с загрязненными продуктами. Разработчик программного обеспечения может быть особенно обеспокоен раскрытием программного кода. Организация здравоохранения может сосредоточиться на таких проблемах, как ошибочный диагноз пациента или непреднамеренное причинение вреда пациенту. Сосредоточение внимания различных менеджеров на выявлении и распределении проблемных сценариев по уровням — хороший способ как стимулировать творческую энергию, так и снизить риск того, что узкие специалисты или ограниченное мышление упустят основные уязвимые места. Организациям не нужно начинать с нуля: за последние несколько лет выявление рисков стало хорошо развитым искусством, и его можно напрямую использовать в контексте ИИ.

Широта: Внедрение надежных средств контроля на уровне предприятия

Обострение вашего мышления о рисках, мешающих шоу, — это только начало. Также крайне важно применение общекорпоративных средств контроля для управления разработкой и использованием систем искусственного интеллекта, обеспечения надлежащего надзора и внедрения надежных политик, процедур, обучения работников и планов действий в чрезвычайных ситуациях. Без широкомасштабных усилий возрастает вероятность того, что факторы риска, подобные описанным ранее, не будут учтены.

Без широкомасштабных усилий возрастает вероятность того, что факторы риска, подобные описанным ранее, не будут учтены.

Обеспокоенный потенциальным риском некачественных или предвзятых рекомендаций по продуктам, Европейский банк начал внедрять надежный набор бизнес-принципов, направленных на подробное описание того, как и где можно использовать машины для принятия решений, влияющих на финансовое здоровье клиента. Менеджеры определили ситуации, когда человеку (например, менеджеру по связям с общественностью или кредитному специалисту) необходимо быть «в курсе», прежде чем рекомендация будет доставлена клиенту. Эти работники могли бы обеспечить подстраховку для определения того, есть ли у клиента особые обстоятельства, такие как смерть члена семьи или финансовые трудности, которые могут сделать рекомендацию несвоевременной или неуместной.

Комитет по надзору банка также провел анализ пробелов, выявив области в существующей системе управления рисками банка, которые необходимо углубить, переопределить или расширить. Тщательное и последовательное управление в банке теперь обеспечивает надлежащее определение политик и процедур, конкретных средств контроля для моделей ИИ, основных принципов (поддерживаемых инструментами) для разработки моделей, разделения обязанностей и надлежащего надзора. Например, инструменты разработки моделей гарантируют, что специалисты по данным последовательно регистрируют код модели, обучающие данные и параметры, выбранные на протяжении всего жизненного цикла разработки. Также были приняты стандартные библиотеки для объяснимости, отчетов о производительности моделей и мониторинга данных и моделей в производстве. Эта структура управления оказалась бесценной как для собственных усилий по разработке ИИ, так и для оценки и мониторинга сторонних инструментов ИИ, таких как модель мошенничества SaaS, принятая банком.

Тщательное и последовательное управление в банке теперь обеспечивает надлежащее определение политик и процедур, конкретных средств контроля для моделей ИИ, основных принципов (поддерживаемых инструментами) для разработки моделей, разделения обязанностей и надлежащего надзора. Например, инструменты разработки моделей гарантируют, что специалисты по данным последовательно регистрируют код модели, обучающие данные и параметры, выбранные на протяжении всего жизненного цикла разработки. Также были приняты стандартные библиотеки для объяснимости, отчетов о производительности моделей и мониторинга данных и моделей в производстве. Эта структура управления оказалась бесценной как для собственных усилий по разработке ИИ, так и для оценки и мониторинга сторонних инструментов ИИ, таких как модель мошенничества SaaS, принятая банком.

Кроме того, политика банка теперь требует, чтобы все заинтересованные стороны, в том числе спонсирующие руководители предприятий, проводили планирование сценариев и создавали запасной план на случай дрейфа производительности модели ИИ, неожиданного изменения входных данных или внезапных изменений, таких как стихийное бедствие, в внешняя среда. Эти резервные планы включены в регулярный процесс проверки рисков банка, что дает комитету совета директоров по рискам представление о шагах, предпринимаемых для снижения рисков, связанных с аналитикой и искусственным интеллектом.

Эти резервные планы включены в регулярный процесс проверки рисков банка, что дает комитету совета директоров по рискам представление о шагах, предпринимаемых для снижения рисков, связанных с аналитикой и искусственным интеллектом.

Обучение и осведомленность работников также играют важную роль в усилиях банка по снижению рисков. Все затронутые сотрудники получают исчерпывающие сообщения о том, где используется ИИ; какие шаги предпринимает банк для обеспечения справедливых и точных решений и защиты данных клиентов; и как система управления банка, автоматизированные технологии и инструменты разработки работают вместе. Кроме того, бизнес-спонсоры, группы риска и аналитики проходят целевое обучение своей роли в выявлении и минимизации рисков. Например, бизнес-спонсоры учатся запрашивать объяснения поведения модели, которые они используют для предоставления отзывов о бизнес-предположениях, лежащих в основе модели. Тем временем группа по управлению рисками прошла обучение тому, как лучше выявлять и устранять проблемы с соблюдением правовых и нормативных требований, такие как потенциальная дискриминация в отношении защищенных групп или соблюдение GDPR.![]()

Снижение рисков машинного обучения и искусственного интеллекта

Мониторинг аналитики на основе ИИ — это непрерывная работа, а не одноразовая деятельность. Таким образом, надзорные группы банка, в том числе комитеты по рискам при совете директоров, регулярно пересматривают программу, чтобы быть в курсе новых рисков, которые могли возникнуть в результате нормативных изменений, изменений в отрасли, юридических толкований (например, новой прецедентной практики GDPR), растущие ожидания потребителей и быстро меняющиеся технологии.

Нюанс: усилить определенные меры контроля в зависимости от характера риска

Какими бы важными ни были средства контроля на уровне предприятия, их редко бывает достаточно для противодействия всем возможным рискам. Часто требуется другой уровень строгости и нюансов, и необходимые элементы управления будут зависеть от таких факторов, как сложность алгоритмов, их требования к данным, характер взаимодействия человека с машиной (или машина с машиной), потенциальное возможности использования злоумышленниками, а также степень интеграции ИИ в бизнес-процесс. Иногда необходимы концептуальные элементы управления, начиная с устава прецедентов. То же самое относится и к конкретным элементам управления данными и аналитикой, включая требования к прозрачности, а также средствам управления обратной связью и мониторингом, таким как анализ производительности для обнаружения ухудшения или систематической ошибки.

Иногда необходимы концептуальные элементы управления, начиная с устава прецедентов. То же самое относится и к конкретным элементам управления данными и аналитикой, включая требования к прозрачности, а также средствам управления обратной связью и мониторингом, таким как анализ производительности для обнаружения ухудшения или систематической ошибки.

Наш второй пример проливает свет на применение тонких элементов управления. Это учреждение хотело видеть, как именно модель машинного обучения принимает решения для конкретного процесса взаимодействия с клиентом. Тщательно изучив требования прозрачности, учреждение решило снизить риск, ограничив типы используемых алгоритмов машинного обучения. Запрещение определенных типовых форм, которые были чрезмерно сложными и непрозрачными, позволило учреждению найти баланс, который был для него удобен. Некоторая предсказательная сила была потеряна, что имело экономические издержки. Но прозрачность моделей, которые 9Использование 0035 вместо повысило уверенность персонала в принимаемых решениях. Более простые модели также упростили проверку как данных, так и самих моделей на наличие погрешностей, которые могут возникнуть из-за поведения пользователей или изменений переменных данных или их рейтинга.

Более простые модели также упростили проверку как данных, так и самих моделей на наличие погрешностей, которые могут возникнуть из-за поведения пользователей или изменений переменных данных или их рейтинга.

Как следует из этого примера, организациям потребуется сочетание средств управления рисками, и лучше всего их реализовать, создав протоколы, гарантирующие их наличие и соблюдение на протяжении всего процесса разработки ИИ. Учреждения в наших примерах внедрили эти протоколы, а также средства контроля на уровне предприятия, по крайней мере частично, через свою существующую инфраструктуру управления рисками. Компании, в которых отсутствует централизованная организация управления рисками, могут по-прежнему применять эти методы управления рисками ИИ, используя надежные процессы управления рисками.

Еще многое предстоит узнать о потенциальных рисках, с которыми сталкиваются организации, отдельные лица и общество, когда дело доходит до ИИ; о надлежащем балансе между инновациями и риском; и о введении контроля для управления невообразимым. До сих пор общественное мнение и реакция регулирующих органов были относительно сдержанными.

До сих пор общественное мнение и реакция регулирующих органов были относительно сдержанными.

Но это, скорее всего, изменится, если больше организаций споткнутся. По мере роста стоимости рисков, связанных с ИИ, возможность как оценивать эти риски, так и привлекать работников всех уровней к определению и внедрению средств контроля станет новым источником конкурентного преимущества. На горизонте для многих организаций находится переосмысление «клиентского опыта», чтобы охватить как обещания, так и подводные камни результатов, основанных на ИИ. Еще один императив — провести серьезную дискуссию об этичности применения ИИ и о том, где провести черту, ограничивающую его использование. Коллективные действия, которые могут включать дебаты на отраслевом уровне о самоконтроле и взаимодействии с регулирующими органами, также могут стать более важными. Организации, которые развивают эти возможности, будут в более выгодном положении для эффективного обслуживания своих клиентов и общества; избегать этических, деловых, репутационных и нормативных затруднений; и предотвратить потенциальный экзистенциальный кризис, который может поставить организацию на колени.