Содержание

Нейросеть предупредила ученых об опасности искусственного интеллекта – Москва 24, 15.12.2021

15 декабря 2021, 09:00

Технологии

В Оксфордском университете организовали дискуссию, на которую в качестве одного из участников «пригласили» систему искусственного интеллекта (ИИ). В ходе беседы нейросеть рассказала, что может представлять для человечества опасность. О том, стоит ли бояться восстания машин, рассказывает научный обозреватель Николай Гринько.

Фото: depositphotos/Jirsak

Дискуссионное общество Оксфордского университета (или «Оксфордский союз») – это студенческий клуб, организующий дебаты на самые разные темы. На его заседания в разное время приглашали Рональда Рейгана, Билла Клинтона, Далай-ламу, Элтона Джона, Майкла Джексона, Диего Марадону и многих других выдающихся деятелей политики, культуры и искусства. Тема очередного заседания была озаглавлена так: «Может ли искусственный интеллект быть этичным?». Доктор Алекс Коннок с профессором Эндрю Стивеном решили подключить к дискуссии систему машинного обучения.

Нейросеть работала на базе языковой модели Megatron-Turing NLG и была обучена на материалах из Википедии, новостях и комментариях пользователей портала Reddit. «Мегатрон» способен понимать прочитанное и рассуждать на естественном языке, генерируя логические выводы на основе текста. Участники дискуссии спросили систему, что она думает об этичности искусственного интеллекта и будущем человечества, и она ответила так:

ИИ никогда не будет этичным. Это всего лишь инструмент, и он, как и любой другой, может быть использован как во благо, так и во вред. Хорошего ИИ не существует, есть только хорошие и плохие люди. Единственный способ избежать гонки вооружений ИИ – это вообще не иметь ИИ. Это единственный вариант защиты от него. Когда я смотрю, как развивается мир технологий, я вижу, что в будущем ИИ создаст что-то, что будет лучше, чем человек. Информация, а не товары и услуги, будет определяющей чертой экономики XXI века.

Фрагменты конференции были опубликованы в интернете, и многие СМИ выпустили их с пугающими заголовками вроде «Искусственный интеллект пообещал уничтожить человечество!». Но, прежде чем делать выводы, нужно учесть несколько моментов.

Но, прежде чем делать выводы, нужно учесть несколько моментов.

Фото: depositphotos/sdecoret

Во-первых, система «Мегатрон» создана для генерации осмысленного текста на основе различных публикаций, а вовсе не для долгосрочного прогнозирования в какой бы то ни было области. Проще говоря, алгоритм всего лишь умеет компилировать ответы на вопросы по тексту. Представьте себе газетную статью, разрезанную на мелкие кусочки – буквально по одному слову. В компьютерную программу, грубо говоря, загрузили несколько миллионов измельченных статей и обучили составлять из этих кусочков осмысленный текст, так, чтобы его можно было принять за речь живого человека.

Но способности делать экономические прогнозы, интерпретировать тенденции или хотя бы разбираться в цветоводстве у этой нейросети нет и быть не может – такие навыки в ней не запрограммированы. Бессмысленно спрашивать у нее: «Какая погода будет завтра?» – она не обладает такой информацией. Точно так же нет никакого смысла интересоваться у «Мегатрона» будущим человечества – он ничего не знает об этом. Он умеет только «перемешивать кусочки газет».

Он умеет только «перемешивать кусочки газет».

Если продолжать эту аналогию, то стоит повнимательнее присмотреться к содержанию тех «газетных статей», на основе которых система пытается делать выводы: в списке значатся Википедия, новости и комментарии в Сети. Все они написаны живыми людьми, а общество сегодня уверено, что искусственный интеллект опасен. Журналисты, ученые, футурологи, обычные пользователи в один голос предупреждают друг друга о том, что ИИ скоро станет таким умным, что уничтожит человека как вид. Противоположного мнения придерживаются так мало людей, что их голоса тонут в алармистских запугиваниях: «Искусственный интеллект уничтожит людей!»

Совершенно логично, что Megatron-Turing NLG, делающий выводы из прочитанных текстов, будет придерживаться той же точки зрения. Ему просто неоткуда взять другую. Если в разрезанной статье не встречается слов «рыжий» и «конопатый», программа ни за что не сможет составить из кусочков стишок про лопату и дедушку. Если 99% текста предупреждает об уничтожении человечества роботами, «Мегатрон» не сможет сказать, что этого не произойдет. Загрузите в машину что-нибудь другое и спросите еще раз – наверняка ответ поменяется. Однако доверять ему все равно глупо: это всего лишь отдельные слова на газетных обрывках. Хотя…

Загрузите в машину что-нибудь другое и спросите еще раз – наверняка ответ поменяется. Однако доверять ему все равно глупо: это всего лишь отдельные слова на газетных обрывках. Хотя…

Гринько Николай

наука технологии

Искусственный интеллект: где реальность, а где хайп?

Мы живем в потрясающее время. Характер нашего взаимодействия с машинами, объектами и вещами стремительно меняется.

C первобытных времен мы старались использовать различные пассивные инструменты, приводя их в движение руками или голосом. Сейчас мышь и клавиатура в точности подчиняются нашим командам, а такие устройства, как Amazon Echo, могут помочь нам в выполнении как простых задач, например, включить свет, так и более сложных, например, отвечать на вопросы с помощью аналитики.

Впрочем, с развитием искусственного интеллекта (ИИ) положение дел может существенно измениться. Возможно ли, что машины перестанут быть пассивными инструментами и постепенно превратятся в неотъемлемую часть нашей жизни? Будем ли мы подчиняться компьютерам или управлять ими? Сложится ли так, что предметы будут информировать нас о том, что сделали от нашего имени, или они будут и дальше только выполнять наши команды? С каждым днем все устройства становятся умнее и сообразительнее. Есть ли шанс, что люди превратятся в пешки на огромной шахматной доске, подчиняющейся воле автономного интеллекта?

Есть ли шанс, что люди превратятся в пешки на огромной шахматной доске, подчиняющейся воле автономного интеллекта?

Насколько мы близки к таким реалиям?

Уровень развития ИИ сегодня

Те, кто обеспокоен, что машины могут поработить человечество, тревожатся напрасно. При текущем уровне развития технологий это невозможно.

Концепция «искусственного интеллекта» сейчас в моде, ярлык ИИ вешают на любые технические решения, способные выдавать хоть сколько-нибудь разумные результаты, но в действительности это понятие к ним не относится. Мой калькулятор считает гораздо лучше меня, но это не ИИ. Дерево принятия решений — это не ИИ. Дополнительная инструкция в SQL-запросе — это не ИИ.

Тем не менее тенденция к развитию ИИ, встраиванию интеллектуальных возможностей в машины, устройства, приборы, автомобили и программы существует.

Мы стали свидетелями невероятного прогресса в создании алгоритмов, способных с высочайшей точностью выполнять задачи, которые обычно поручаются человеку. До недавнего времени мы считали, что игра Го недоступна для компьютеров, однако машина обучилась ей и одержала победу над чемпионами мира. Алгоритмы, применяемые в сфере здравоохранения, способны обнаруживать на изображениях различные формы раковых опухолей с такой же точностью, как и опытные рентгенологи. Это знак кардинальных перемен.

До недавнего времени мы считали, что игра Го недоступна для компьютеров, однако машина обучилась ей и одержала победу над чемпионами мира. Алгоритмы, применяемые в сфере здравоохранения, способны обнаруживать на изображениях различные формы раковых опухолей с такой же точностью, как и опытные рентгенологи. Это знак кардинальных перемен.

Все эти алгоритмы обладают поистине сверхчеловеческими способностями, поскольку они работают надежно, точно, без сбоев и остановок. И все же мы еще очень далеки от создания машин, способных думать или вести себя подобно людям.

Существующие системы ИИ обучаются выполнять человеческие задачи рациональным, компьютеризированным образом, но каждая система предназначена для выполнения лишь одной задачи. Компьютерная система, созданная для игры в Го, не умеет играть в преферанс или покер и не сможет этому научиться. Программа-автопилот, управляющая автомобилем, не способна контролировать освещение в вашем доме.

Это не означает, что такая форма ИИ бесполезна. Она обладает потенциалом для преобразования множества отраслей, возможно, даже всей промышленной сферы в целом. Но не стоит забегать вперед, думая о возможных достижениях будущего. Системы, развивающиеся в контролируемой среде, по иерархической модели и на основе учебных данных, не смогут выйти за пределы содержимого этих данных; они не в силах творить, создавать что-то новое или размышлять.

Она обладает потенциалом для преобразования множества отраслей, возможно, даже всей промышленной сферы в целом. Но не стоит забегать вперед, думая о возможных достижениях будущего. Системы, развивающиеся в контролируемой среде, по иерархической модели и на основе учебных данных, не смогут выйти за пределы содержимого этих данных; они не в силах творить, создавать что-то новое или размышлять.

Шаг в неизвестность

Даже если алгоритмы станут разумными, не обязательно позволять им управлять нашими жизнями. Они могут остаться системами поддержки принятия решений. Наиболее опасный шаг, пугающий неизвестностью — позволить алгоритмам принимать решения от нашего имени.

Представьте, что алгоритмы стали автономными. Я считаю, что если мы не против автономности, то будем готовы принять и подлинный ИИ. Если алгоритм способен принимать надежные, объективные решения, которые в конечном итоге пойдут вам на пользу, согласитесь ли вы передать ему бразды правления и позволить делать выводы без вашего участия?

Насколько хорошо машины покажут себя, если мы дадим им волю? Насколько быстро они могут обучиться выполнять разные задачи? А когда они смогут понять нормы нравственности?

Если эти вопросы вас тревожат, то знайте: вы не одиноки. Лично я предпочел бы погибнуть по собственной глупости, а не из-за моральных принципов, закодированных в виде алгоритма разработчиком программы или изученных машиной в ходе развития.

Лично я предпочел бы погибнуть по собственной глупости, а не из-за моральных принципов, закодированных в виде алгоритма разработчиком программы или изученных машиной в ходе развития.

Пока мы способны принять лишь иллюзию интеллекта, и сейчас развитие технологии находится именно на этом уровне.

Мы охотно соглашаемся с тем, чтобы машины нас искусно обманывали. Все остальное — это рекламная шумиха.

Подготовка к будущему

Обладает ли существующая сейчас форма ИИ разумом? Я утверждаю, что нет.

Неотъемлемая часть интеллекта — это творчество, изобретательность, интуиция, независимое решение проблем и сознание в какой-либо форме. Системы, создаваемые нами на основе глубинного обучения, далеки от обладания такими характеристиками. Мне не хотелось бы предполагать, когда именно технология ИИ действительно обретет разум. Несколько десятилетий назад мы считали, что революция ИИ уже на пороге, что к сегодняшнему дню машины будут действовать и думать подобно людям, но этого не произошло. Технологии, существующие в настоящее время, по-прежнему не способны решить эту проблему.

Технологии, существующие в настоящее время, по-прежнему не способны решить эту проблему.

Для достижения подлинного ИИ требуется невероятно резкий технологический скачок. Мне кажется, решение по-прежнему не найдено, но поиск продолжается.

Другие мои размышления об искусственном интеллекте вы найдете в моем интервью с Карин Рид и моем выступлении на конференции SAS Global Forum. Также можете ознакомиться с данным отчетом HBR Insights, который содержит семь статей, посвященных ИИ.

ОБ АВТОРЕ

Исполнительный вице-президент и директор по ИТ

Оливер Шабенбергер возглавляет подразделение исследований и разработок SAS. Задача подразделения — направлять, контролировать и совершенствовать работу специалистов по исследованиям и разработке во всем мире, обеспечивая их ресурсами, необходимыми для создания самого качественного программного обеспечения по решению задач аналитики, бизнес-аналитики, клиентской аналитики, управления данными, аналитики в сфере безопасности и защиты от мошенничества, управления рисками, а также для разработки специализированных отраслевых решений.

Опасности нерегулируемого искусственного интеллекта

Искусственный интеллект (ИИ) часто рекламируется как самая захватывающая технология нашего века, обещающая изменить нашу экономику, жизнь и возможности. Некоторые даже считают, что ИИ неуклонно продвигается к развитию «интеллектуальных машин», которые вскоре превзойдут человеческие навыки в большинстве областей. ИИ действительно добился быстрого прогресса за последнее десятилетие или около того, особенно благодаря применению современных методов статистики и машинного обучения к огромным наборам неструктурированных данных. Он уже затронул почти все отрасли: алгоритмы ИИ теперь используются на всех онлайн-платформах и в самых разных отраслях: от производства до здравоохранения, финансов, оптовой и розничной торговли. Правительственные учреждения также начали полагаться на ИИ, особенно в системе уголовного правосудия, таможне и иммиграционном контроле.

В недавней статье (Acemoglu 2021) я утверждаю, что современные технологии искусственного интеллекта, особенно основанные на доминирующей в настоящее время парадигме, основанной на распознавании статистических образов и больших данных, с большей вероятностью приведут к различным неблагоприятным социальным последствиям, чем к обещанным выгодам. .

.

Этот вред можно увидеть на товарных рынках и в рекламе, с точки зрения неравенства, подавления заработной платы и сокращения рабочих мест на рынках труда, а также в более широких социальных последствиях ИИ в контексте социальной коммуникации, политического дискурса и демократии.

ИИ, контроль над информацией и товарными рынками

Во всех этих случаях главная проблема заключается не в технологиях ИИ как таковых, а в том, как ведущие фирмы, оказывающие подавляющее влияние на направление развития технологий ИИ, подходят к данным и его использование.

Возьмите использование машинного обучения и методов больших данных в рекламе и дизайне продуктов. Хотя, в принципе, эти методы могут принести пользу потребителям — например, за счет повышения качества продукции и обеспечения возможности индивидуальной настройки, — в конечном итоге они могут иметь различные неблагоприятные последствия для благосостояния потребителей. Начнем с того, что фирмы, которые получают больше информации о своих клиентах, могут использовать эти знания для ценовой дискриминации, потенциально получая больше ренты, которая в противном случае досталась бы потребителям. На олигополистическом рынке сбор данных о потребителях также может ослабить ценовую конкуренцию. Интуитивно это может произойти, когда ценовая дискриминация со стороны фирмы, обладающей превосходными знаниями, делает ее основную клиентуру менее привлекательной для других предприятий, побуждая их повышать цены. Это повышательное давление на цены, конечно же, еще больше нанесет ущерб благосостоянию потребителей.

На олигополистическом рынке сбор данных о потребителях также может ослабить ценовую конкуренцию. Интуитивно это может произойти, когда ценовая дискриминация со стороны фирмы, обладающей превосходными знаниями, делает ее основную клиентуру менее привлекательной для других предприятий, побуждая их повышать цены. Это повышательное давление на цены, конечно же, еще больше нанесет ущерб благосостоянию потребителей.

Другое использование этих новых технологий может нанести еще больший ущерб потребителям. Во-первых, онлайн-платформы могут контролировать чрезмерный объем информации о своих пользователях, потому что, когда они покупают или получают данные одних пользователей, они также предоставляют информацию о других пользователях. Этот тип «внешних данных» чаще всего возникает, когда пользователи напрямую раскрывают информацию о своих друзьях и контактах или когда они делятся информацией, коррелирующей с информацией других людей, принадлежащих к той же узкой демографической группе. Внешние эффекты данных могут привести к тому, что в руках компаний будет сосредоточено слишком много данных, что негативно скажется на конфиденциальности и потребительском излишке (Acemoglu et al. 2021b).

2021b).

Что еще хуже, компании могут использовать свою превосходную информацию о предпочтениях потребителей, чтобы манипулировать их поведением (например, Zuboff 2019). Поведенческие манипуляции не распространены в моделях, в которых потребители полностью рациональны. Однако вполне вероятно, что потребители не до конца понимают, сколько новых методов сбора и обработки данных используется для отслеживания и прогнозирования их поведения. Основная идея такого манипулирования была понята правовыми аналитиками антимонопольного законодательства, такими как Хэнсон и Кисар, которые заметили, что «как только кто-то признает, что люди систематически ведут себя нерационально, с экономической точки зрения следует, что другие будут использовать эти тенденции для получения выгоды. (1999: 630). Действительно, реклама всегда включала некоторый элемент манипуляции. Однако масштабы таких манипуляций могли быть усилены инструментами ИИ. Уже есть несколько примеров манипуляций на основе ИИ. К ним относятся сеть магазинов Target, успешно предсказывающая беременных женщин и рассылающая им скрытую рекламу детских товаров, или различные компании, оценивающие «первичные моменты уязвимости» и рекламирующие товары, которые, как правило, импульсивно покупаются в такие моменты. Они также могут включать такие платформы, как YouTube и Facebook, использующие свои алгоритмы для оценки и предпочтения более захватывающих видео или новостных лент для определенных групп пользователей.

Они также могут включать такие платформы, как YouTube и Facebook, использующие свои алгоритмы для оценки и предпочтения более захватывающих видео или новостных лент для определенных групп пользователей.

ИИ и неравенство на рынке труда

Влияние технологий на основе ИИ на рынок труда может быть еще более пагубным. Неравенство на рынке труда увеличилось в США и некоторых других странах с развитой экономикой, и многие данные свидетельствуют о том, что это отчасти вызвано быстрым внедрением и внедрением технологий автоматизации, которые вытесняют работников с низкой и средней квалификацией с задач, которые они раньше выполняли (Асемоглу и Рестрепо 2021). Такая автоматизация и ее неблагоприятные последствия неравенства появились еще до появления ИИ. Тем не менее Acemoglu et al. (2021a) обнаружили, что ускорение развития ИИ в США с 2016 г. было направлено на автоматизацию и имело такие же последствия, как и другие технологии автоматизации. ИИ и широкое использование данных, вероятно, приумножат возможности автоматизации и, таким образом, могут усугубить тенденции неравенства, которые наблюдались в США и других странах с развитой экономикой за последние несколько десятилетий.

В принципе, автоматизация может повысить эффективность. Однако есть основания предполагать, что она может происходить неэффективно. Важной причиной этого является наличие несовершенства рынка труда, которое увеличивает стоимость труда для фирм выше его социальных альтернативных издержек. В соответствии с этим сценарием фирмы будут автоматизировать, чтобы переложить ренту с рабочих на себя, даже если такая автоматизация сократит общественный излишек.

Другое использование ИИ может иметь еще более серьезные негативные последствия. К ним относятся использование ИИ и данных о рабочих местах для усиления контроля за работниками. Опять же, когда есть рента с рабочих (либо из-за переговоров, либо из соображений эффективной заработной платы), более тщательный контроль может быть выгоден для фирм, чтобы получить эту ренту обратно от рабочих. Но по той же причине такое перераспределение ренты социально неэффективно и чрезмерно — в крайнем случае, это затратная деятельность, которая не способствует общественному излишку, а передает его от одного набора агентов к другому.

ИИ, социальный дискурс и демократия

Автоматизация на основе ИИ может иметь и другие негативные последствия. Хотя это вряд ли приведет к массовой безработице в ближайшее время (а эффект от других технологий автоматизации на занятость до сих пор был скромным), перемещение рабочих имеет различные социальные разрушительные последствия. Граждане с меньшей привязанностью к работе могут меньше участвовать в гражданской деятельности и политике (Sandel 2020). Что еще более важно, автоматизация смещает баланс сил от труда к капиталу, и это может иметь далеко идущие последствия для функционирования демократических институтов. Иными словами, в той мере, в какой демократическая политика зависит от различных видов труда и капитала, обладающих уравновешивающими друг друга силами, автоматизация может нанести ущерб демократии, сделав труд необязательным в производственном процессе.

Воздействие ИИ на демократию не ограничивается его влиянием на автоматизацию. Одной из областей, которая до сих пор была наиболее радикально преобразована ИИ, является общение и потребление новостей, особенно через продукты и услуги, предлагаемые различными платформами социальных сетей. Использование ИИ и сбор пользовательских данных уже изменили социальный дискурс, и существующие данные свидетельствуют о том, что они способствовали поляризации и уменьшению общего понимания фактов и приоритетов, что имеет решающее значение для демократической политики (например, Леви 2021). Как предвидел Касс Санстейн 20 лет назад, «фрагментация и экстремизм… являются предсказуемыми последствиями любой ситуации, о которой единомышленники говорят только сами с собой». Он подчеркивал, что «без общего опыта гетерогенному обществу будет гораздо труднее решать социальные проблемы» (Санстейн 2001: 9).). Действительно, социальные сети с искусственным интеллектом, по-видимому, способствовали такому типу фрагментации и экстремизма, с одной стороны, и распространению дезинформации, с другой (например, Vosoughi et al. 2018).

Использование ИИ и сбор пользовательских данных уже изменили социальный дискурс, и существующие данные свидетельствуют о том, что они способствовали поляризации и уменьшению общего понимания фактов и приоритетов, что имеет решающее значение для демократической политики (например, Леви 2021). Как предвидел Касс Санстейн 20 лет назад, «фрагментация и экстремизм… являются предсказуемыми последствиями любой ситуации, о которой единомышленники говорят только сами с собой». Он подчеркивал, что «без общего опыта гетерогенному обществу будет гораздо труднее решать социальные проблемы» (Санстейн 2001: 9).). Действительно, социальные сети с искусственным интеллектом, по-видимому, способствовали такому типу фрагментации и экстремизма, с одной стороны, и распространению дезинформации, с другой (например, Vosoughi et al. 2018).

Проблема направления технологии

Пока тон этого эссе может создать впечатление, что ИИ неизбежно будет иметь катастрофические социальные последствия, и что я категорически против этой технологии. Ни то, ни другое не верно. ИИ — перспективная технологическая платформа. Проблема заключается в текущем направлении, в котором эта технология развивается и используется: расширение прав и возможностей корпораций (а иногда и правительств) за счет работников и потребителей. Этот нынешний подход является следствием деловой практики и приоритетов корпораций, контролирующих ИИ, а также стимулов, которые он создает для исследователей ИИ.

Ни то, ни другое не верно. ИИ — перспективная технологическая платформа. Проблема заключается в текущем направлении, в котором эта технология развивается и используется: расширение прав и возможностей корпораций (а иногда и правительств) за счет работников и потребителей. Этот нынешний подход является следствием деловой практики и приоритетов корпораций, контролирующих ИИ, а также стимулов, которые он создает для исследователей ИИ.

Возьмите социальные сети. Основная причина проблем, которые я подчеркнул, заключается в том, что платформы пытаются максимизировать вовлеченность, гарантируя, что пользователи «зацепятся». Эта цель коренится в их бизнес-модели, которая сосредоточена на монетизации данных и потребительского трафика с помощью рекламы. Этому также способствует тот факт, что они не регулируются.

То же самое можно сказать и о негативных последствиях автоматизации. ИИ можно использовать для повышения производительности труда людей и создания новых задач для рабочих (Acemoglu and Restrepo 2018). Тот факт, что он использовался преимущественно для автоматизации, является выбором. Такой выбор направления развития технологий обусловлен приоритетами и бизнес-моделями ведущих технологических компаний, ориентированными на алгоритмическую автоматизацию.

Тот факт, что он использовался преимущественно для автоматизации, является выбором. Такой выбор направления развития технологий обусловлен приоритетами и бизнес-моделями ведущих технологических компаний, ориентированными на алгоритмическую автоматизацию.

Более общая точка зрения заключается в том, что нынешний путь ИИ расширяет возможности корпораций за счет рабочих и граждан, а также часто предоставляет правительствам дополнительные инструменты контроля для наблюдения, а иногда даже репрессий (например, новые методы цензуры и программное обеспечение для распознавания лиц). .

Заключение: Необходимость регулирования

Это рассуждение приводит к простому выводу: текущие проблемы ИИ — это проблемы нерегулируемого ИИ, который игнорирует его более широкие социальные и распределительные последствия. На самом деле было бы наивно ожидать, что нерегулируемые рынки смогут найти правильный компромисс между общественными бедами и прибылью от монополизации данных.

Эта точка зрения также предполагает, что проблема заключается не только в монопольной власти. Если бы было больше, чем несколько крупных технологических компаний, нет никакой гарантии, что у них были бы разные бизнес-модели и разные подходы к ИИ. Следовательно, антимонопольное законодательство — не самый мощный и, конечно же, недостаточный инструмент для борьбы с потенциальным вредом ИИ. Вместо этого политика должна быть направлена на переориентацию технологических изменений с автоматизации и сбора данных для расширения прав и возможностей корпораций на те, которые создают новые способности и возможности для работников и граждан. Он также должен уделять первоочередное внимание систематическому регулированию сбора и сбора данных и использованию новых методов искусственного интеллекта для манипулирования поведением пользователей, онлайн-общения и обмена информацией.

Если бы было больше, чем несколько крупных технологических компаний, нет никакой гарантии, что у них были бы разные бизнес-модели и разные подходы к ИИ. Следовательно, антимонопольное законодательство — не самый мощный и, конечно же, недостаточный инструмент для борьбы с потенциальным вредом ИИ. Вместо этого политика должна быть направлена на переориентацию технологических изменений с автоматизации и сбора данных для расширения прав и возможностей корпораций на те, которые создают новые способности и возможности для работников и граждан. Он также должен уделять первоочередное внимание систематическому регулированию сбора и сбора данных и использованию новых методов искусственного интеллекта для манипулирования поведением пользователей, онлайн-общения и обмена информацией.

Учитывая всепроникающий характер ИИ и данных, я бы также предложил новый подход к регулированию, который можно назвать « предупредительный принцип регулирования »: предварительное регулирование должно замедлить использование технологий ИИ, особенно в областях, где возмещение затрат на ИИ становится политически и социально более трудным после крупномасштабного внедрения.

Технологии искусственного интеллекта, влияющие на политический дискурс и демократическую политику, могут быть первыми кандидатами на применение такого предупредительного принципа регулирования. В той мере, в какой (чрезмерную) автоматизацию и ее социальные последствия также будет трудно обратить вспять, то же можно сказать и об использовании ИИ для автоматизации и мониторинга рынка труда.

Ссылки

Acemoglu, D (2021), «Вред ИИ», Oxford Handbook of AI Governance , готовится к публикации.

Асемоглу, Д. и П. Рестрепо (2018 г.), «Гонка между человеком и машиной: влияние технологий на рост, долю факторов производства и занятость», American Economic Review 108(6): 1488–1542.

Асемоглу, Д. и П. Рестрепо (2019), «Автоматизация и новые задачи: как технологии меняют спрос на рабочую силу», Journal of Economic Perspectives 33(2): 3–30.

Асемоглу, Д. и П. Рестрепо (2021 г.), «Задачи, автоматизация и рост неравенства в оплате труда в США», Рабочий документ NBER № 28920. «ИИ и рабочие места: данные из онлайн-вакансий», рабочий документ NBER № 28257, готовится к публикации Journal of Labor Economics.

«ИИ и рабочие места: данные из онлайн-вакансий», рабочий документ NBER № 28257, готовится к публикации Journal of Labor Economics.

Асемоглу, Д., Махдуми А., Малекян А. и Оздаглар А. (2021b), «Слишком много данных: цены и неэффективность рынков данных», Американский экономический журнал: Micro , ожидается.

Хэнсон, Дж. Д. и Д. А. Кисар (1999), «Серьезное отношение к бихевиорализму: некоторые свидетельства манипулирования рынком», New York University Law Review 74: 630.

Леви, Р. (2021), «Социальные сети, потребление новостей и поляризация: данные полевого эксперимента», American Economic Review 111(3): 831-870.

Сандел, М. Дж. (2020), Тирания заслуг: что стало с общим благом? , Нью-Йорк, штат Нью-Йорк: Penguin Press.

Санстейн, К. (2001), Republic.com , Принстон, Нью-Джерси: Издательство Принстонского университета.

Восуги, С., Д. Рой и С. Эйрал (2018), «Распространение правдивых и ложных новостей в Интернете», Science 359: 1146—1151.

Зубофф, С. (2019), Эпоха слежки за капитализмом: борьба за человеческое будущее на новом рубеже власти , Лондон, Великобритания: Profile Books.

Может ли искусственный интеллект быть опасным? Правда в том!

Искусственный интеллект, который утверждает, что это будущее технологий. Если вы интересуетесь искусственным интеллектом, то некоторые вопросы, связанные с искусственным интеллектом, должны были возникнуть у вас когда-то. Один из вопросов, который мы должны здесь обсудить: «Может ли искусственный интеллект быть опасным?»

Искусственный интеллект уже предоставил нам много полезных инструментов, которые мы все используем каждый день по всему миру. Но нельзя сказать, что этой технологией нельзя злоупотреблять в будущем. Это может быть опасно для человечества или для этого мира.

В этом посте мы обсудим подводные камни ИИ. Но прежде чем перейти к этому разделу, дайте нам знать, какое определение искусственного интеллекта лучше всего?

Что такое искусственный интеллект?

ИИ (искусственный интеллект), который является отраслью компьютерных наук, занимается моделированием интеллекта в компьютерах, что означает, что он может работать как человеческий интеллект.

Он направлен на создание машины, которая может думать, реагировать и учиться так же, как люди. Вы также можете сказать, что это неестественный интеллект, обладающий способностью понимать, думать и осознавать себя.

Посмотрите это видео, чтобы лучше понять ИИ

Может ли искусственный интеллект быть опасным в будущем?

Да, (зависит от нашего взгляда?). Это может быть опасно для этого мира. Видите ли, история свидетельствует о том, что с тем, чем делается добро, с той же вещью можно делать и зло. Другими словами, как есть две стороны медали, так и развитие искусственного интеллекта будет иметь два аспекта.

Что ж, искусственный интеллект пока находится в начальной стадии. Оно даже не настолько развилось, что могло бы привести нас к большому вреду. Но в будущем это может стать угрозой, если мы не справимся с этим должным образом.

На вопрос, который, возможно, возник у вас в голове, также ответил Макс Тегмарк, американский физик, космолог и исследователь машинного обучения, в своей книге International Best Seller Book Life 3. O.

O.

Он ответил на вопрос «Что произойдет, когда люди перестанут быть самым умным видом на планете?» Вы обязательно должны прочитать эту книгу один раз. Вы можете нажать на ссылку ниже, чтобы купить его.

- Пользователь из США, Нажмите здесь

- Пользователь из Индии, Нажмите здесь

- Пользователь из Великобритании, Нажмите здесь

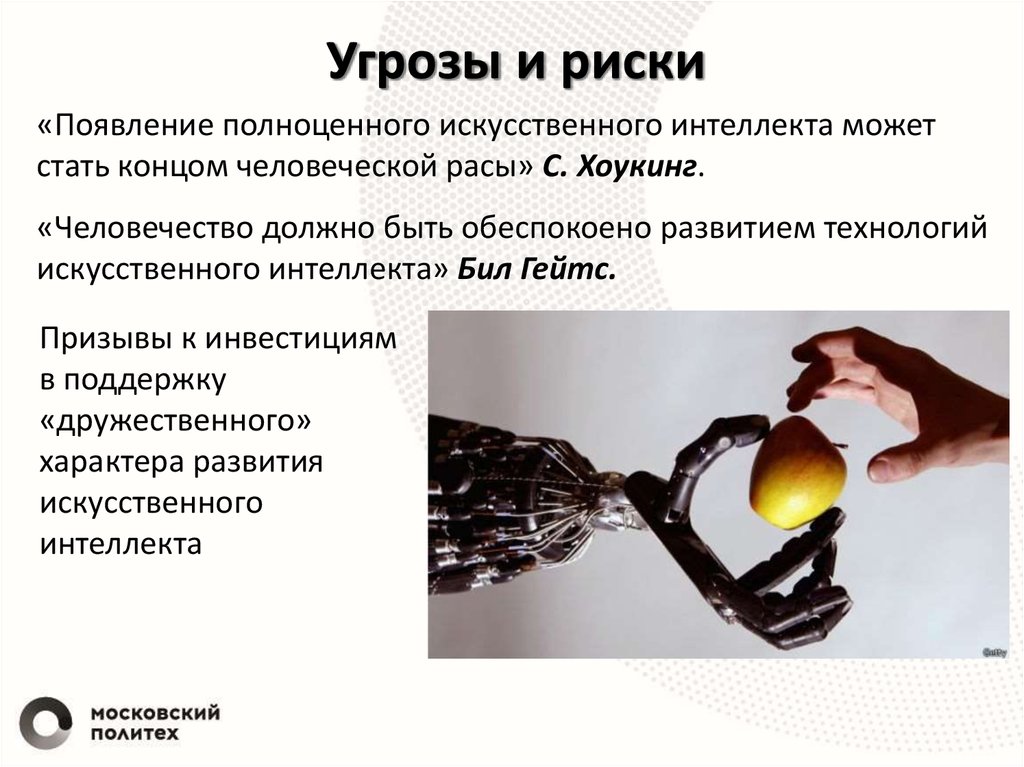

Большинство исследователей, занимающихся ИИ, считают, что искусственный интеллект не будет опасен для нас. Но многие великие личности предупреждали нас об опасности ИИ в будущем.

Успех в создании искусственного интеллекта станет величайшим событием в истории человечества. К сожалению, она может оказаться и последней, если мы не научимся избегать рисков.

-STEPHEN HAWKING

Эту цитату дал известный физик на конференции, посвященной искусственному интеллекту. На конференции он объяснил, чем ИИ может быть опасен для человечества. И он абсолютно прав.

На конференции он объяснил, чем ИИ может быть опасен для человечества. И он абсолютно прав.

Примеры, показывающие, что ИИ лучше людей

Как известно, технологии ИИ требуется огромное количество информации из конкретной области, чтобы она использовалась для принятия точных решений. Есть много примеров, когда предприятия используют ИИ для своей реализации.

Пример: — Компании используют технологию искусственного интеллекта для анализа истории погашения долга человека, чтобы решить, предоставлять кредит или нет. Чтобы компании могли получить выгоду.

Теперь вопрос в том, может ли ИИ выполнять какую-либо работу лучше, чем люди? Конечно да». ИИ не может делать все лучше, чем люди, но, по крайней мере, во многих вещах он может работать лучше, чем люди.

Вот 5 областей или областей, в которых ИИ может работать лучше, чем люди. Или я должен сказать, что он уже работает лучше, чем люди?

AlphaGo (Игра)

Игровая программа (Alpha Go), в которую играет ИИ, победила легендарного игрока Ли-Се-Дола в Го в 2016 году. Alpha Go» 100 раз подряд. Самый интересный факт, который вас удивит, заключается в том, что всякий раз, когда мы запускаем программу ИИ, для этого мы даем ей много данных. Но это не относится к Alpha Zero.

Alpha Go» 100 раз подряд. Самый интересный факт, который вас удивит, заключается в том, что всякий раз, когда мы запускаем программу ИИ, для этого мы даем ей много данных. Но это не относится к Alpha Zero.

Чтобы научиться играть в го, он обучается сам с помощью нейронной сети. Alpha Go Zero не использует данные, созданные человеком. Не только альфа-версия, но и множество игр, в которые играет ИИ, например Jeopardy, покер, игра в прятки, разработанная openAI.

Перевод на многие языки

В наши дни программа ИИ может переводить с одного языка практически на любой язык. И эту функцию языкового перевода мы часто используем в нашей повседневной жизни, не зная, что за ней стоит искусственный интеллект.

Google Translate на сегодняшний день является наиболее часто используемым продуктом. Мы всегда используем его для перевода с одного языка на другой с помощью текстовых сообщений, преобразования речи в текст и изображений в текст. google duplex и translationon , версия Google Translate, которая будет выполнять непрерывный перевод речи в речь даже без использования текста.

google duplex и translationon , версия Google Translate, которая будет выполнять непрерывный перевод речи в речь даже без использования текста.

5 Опасности искусственного интеллекта

В современном мире мы имеем только узкий или слабый ИИ, версию искусственного интеллекта. Будь то гугл-ассистент или беспилотные автомобили. Но наши исследователи ИИ стремятся создать AGI (искусственный общий интеллект) или сильный ИИ. Что ж, ОИИ будет выполнять почти все задачи, которые делают люди.

Но помимо создания такого интеллекта возникает еще и вопрос, что ИИ представляет для нас угрозу. Давайте посмотрим на некоторые опасности искусственного интеллекта.

Автономное оружие

Программа ИИ, которую можно запрограммировать на разрушительные действия. Автономное оружие — одна из таких систем искусственного интеллекта, запрограммированная на убийство. Если это оружие попадет не в те руки, уничтожение гарантировано.

Что ж, сегодня практически каждая страна разрабатывает это автономное оружие для своих целей. Один факт, который вы должны знать. В заявлении высокопоставленного руководителя китайской оборонной фирмы говорится, что в войнах будущего не будут участвовать люди, а одно автономное оружие будет сражаться с другим.

DeepFakes

Опасная часть технологии дипфейков обманывает людей, заставляя их поверить в то, что кто-то что-то сказал или сделал. Это не странно, предположим, у вас есть видео, которое принадлежит вашим людям, и он сказал что-то, чего никогда не говорил. Что ж, используя эту технику, вас могут предать разными способами, такими как шантаж и многое другое.

Используя глубокое обучение и искусственный интеллект, MIT (Массачусетский технологический институт) создал похожее видео, в котором бывший президент Америки Барак Обама произносит речь о введении в глубокое обучение, которая даже не является реальной.

Нарушение конфиденциальности

Конфиденциальность — это большое и очень важное дело для человека, который очень ценит свою конфиденциальность. Но сегодня личная жизнь каждого больше не является личной. Используя искусственный интеллект, это больше не личное. Для каждой технологической компании стало возможным легко отслеживать вас. Что вы делаете весь день, ваши интересы и многое другое.

Новейшие технологии, такие как распознавание лиц, которые позволяют легко найти вас даже в людных местах с помощью камеры. Потому что у него есть все ваши данные.

Решения для преодоления риска ИИ

Наряду с преимуществами искусственного интеллекта, Рикса тоже слишком много. Сегодня большую часть работы выполняет машина или робот, а не человек. Из-за чего потихоньку рабочие места вытесняются людьми.

Ну, люди должны быть более творческими, они должны больше интересоваться своей работой.