Содержание

Google научил нейросети генерировать видео по текстовому описанию

Исследователи из Google представили две модели машинного обучения, генерирующие видеозаписи по текстовому описанию: одна лучше справляется с короткими запросами, а другая синтезирует длинные ролики по более детальным описаниям. За несколько дней до этого аналогичный алгоритм представили исследователи из Meta. Три статьи с описанием алгоритмов (Imagen Video и Phenaki от Google, Make-A-Video от Meta) опубликованы на arXiv.org.

В середине 2010-х годов алгоритмы машинного обучения, работающие с визуальным контентом, в основном использовались для его улучшения. Например, были широко распространены приложения для обработки фотографий, такие как Prisma, которое «перерисовывало» снимки в заданном стиле. Затем благодаря развитию архитектуры генеративно-состязательных нейросетей стало появляться много алгоритмов, качественно генерирующих те или иные объекты с нуля, например, широкую известность получила нейросеть NVIDIA для генерации лиц несуществующих людей.

В последние пару лет активное развитие получило смежное, но другое направление: генерация визуального контента по текстовому описанию (Text-to-Image). В 2021 году широкую известность получила нейросеть DALL-E от OpenAI, а также связанная с ней нейросеть CLIP. DALL-E умела генерировать изображения не определенных классов, а произвольные, соответствующие текстовому описанию, которое дал пользователь. К примеру, ее можно было попросить нарисовать горный пейзаж, домашнее животное или даже сцену, которой, вероятно, никогда не существовало в действительности, например, астронавта на коне. Уже в этом году OpenAI показала вторую версию этого алгоритма, а вскоре свой аналог под названием Imagen выпустила и Google.

Затем настал следующий этап: исследователи в области машинного обучения начали изучать возможность генерации видео по текстовому описанию (Text-to-Video). Работы в этом направлении велись и раньше, но существенного прогресса удалось достичь лишь недавно. В мае нейросеть под названием CogVideo выпустили китайские исследователи, а теперь практически одновременно (с разницей менее, чем в неделю) исследователи из Meta и Google представили сразу три таких алгоритма, показывающих существенно лучшие результаты: Meta разработала алгоритм Make-A-Video, а Google создала Imagen Video и Phenaki.

Первыми из этой тройки алгоритмов вышел Make-A-Video. В его основе лежит Text-to-Image модель, основанная на архитектуре DALL-E 2. Она получает на вход текст, превращает его в эмбеддинг (сжатое векторное представление тех же данных) и подает его на декодировщик, который диффузионным методом формирует двумерное изображение.

От редактора

Диффузионные модели работают следующим образом. Сначала берется качественное изображение (например, фотография), на которое поэтапно добавляется все больше шума до стадии, когда на нем будет уже только случайный шум. Затем из таких наборов исходных и «испорченных» изображений создается датасет, на котором нейросеть учится выполнять обратную операцию: генерировать из шума качественное изображение. В 2021 году исследователи из OpenAI показали, что такой метод генерации работает лучше и эффективнее традиционных генеративно-состязательных нейросетей.

Чтобы научить алгоритм учитывать и временное измерение, разработчики модифицировали сверточные слои и слои внимания так, чтобы они генерировали на основе эмбеддинга не одно изображение, а сразу 16, причем так, чтобы объекты и их движения были согласованы между кадрами. После этого полученный набор из первичных кадров разрешением 64 на 64 пикселя пропускается через нейросети, интерполирующие кадры и повышающие их разрешение. На выходе получается видео длиной в несколько секунд и разрешением 768 на 768 пикселей.

После этого полученный набор из первичных кадров разрешением 64 на 64 пикселя пропускается через нейросети, интерполирующие кадры и повышающие их разрешение. На выходе получается видео длиной в несколько секунд и разрешением 768 на 768 пикселей.

Примечательно, что во время обучения не использовались пары «текст — видео». Вместо этого Make-A-Video обучалась на парах «текст — изображение» и неразмеченных видео. Алгоритм обучали на датасетах LAION-5B (с отфильтрованными изображениями для взрослых, фотографиями с токсичным текстом или водяными знаками), WebVid-10M и HD-VILA-10M. Авторы показали, что Make-A-Video превосходит CogVideo и другие аналоги как по количественным метрикам (FVD и IS), так и при оценке добровольцами. Кроме генерации новых видео с нуля алгоритм умеет «оживлять» изображения. Примеры генерации и интерактивные демонстрации опубликованы на сайте проекта.

С разницей всего в несколько дней исследователи из Google представили два аналогичных алгоритма для генерации видео по текстовому запросу. Первый из них основан на Text-to-Image модели Imagen и получил название Imagen Video. Во многом схема работы алгоритма аналогична Make-A-Video. Получая текстовое описание ролика, он с помощью кодировщика T5 формирует эмбеддинг, а затем с помощью диффузионной сети Videо U-Net, представленной ранее в этом году, генерирует 16 пространственно и временно согласованных между собой кадров разрешением 40 на 24 пикселя. После этого каскад нейросетей интерполирует кадры, увеличивая их количество до 128 (5,3 секунды при 24 кадрах в секунду), и повышает разрешение до 1280 на 768 пикселей.

Первый из них основан на Text-to-Image модели Imagen и получил название Imagen Video. Во многом схема работы алгоритма аналогична Make-A-Video. Получая текстовое описание ролика, он с помощью кодировщика T5 формирует эмбеддинг, а затем с помощью диффузионной сети Videо U-Net, представленной ранее в этом году, генерирует 16 пространственно и временно согласованных между собой кадров разрешением 40 на 24 пикселя. После этого каскад нейросетей интерполирует кадры, увеличивая их количество до 128 (5,3 секунды при 24 кадрах в секунду), и повышает разрешение до 1280 на 768 пикселей.

Imagen Video обучался на собственном датасете Google, состоящем из 14 миллионов пар «текст — видео» (это важное отличие от Make-A-Video, который обучался без таких пар), а также 60 миллионов пар «текст — изображение». Кроме того авторы использовали датасет LAION-400M с парами «текст — изображение». В отличие от коллег из Meta, исследователи из Google не сравнили качество работы Imagen Video с CogVideo (и из-за почти одновременной публикации вряд ли имели возможность сравнить с Make-A-Video). Результаты работы алгоритма можно увидеть на сайте проекта.

Результаты работы алгоритма можно увидеть на сайте проекта.

Вторая генеративная нейросеть от Google называется Phenaki. Она была представлена один день с Make-A-Video, но не получила такой широкой огласки от Google. Phenaki отличается от двух других описанных алгоритмов тем, что предназначена для генерации более длинных роликов по более длинному и детальному текстовому запросу. Авторы отмечают, что длина может достигать и нескольких минут (а теоретически длина не ограничена). Также алгоритм отличается и по схеме работы. Авторы взяли за основу трансформер-нейросеть ViViT, которая преобразует видео в пространственно-временные токены. Также они использовали текстовый трансформер T5X, который преобразует в эмбеддинги текст. Так исследователи свели проблему генерации видео по описанию к задаче переноса между двумя последовательностями, которую как раз эффективно решают нейросети типа трансформер. В результате получаются видео произвольной длины в разрешении 128 на 128 пикселей.

Phenaki обучали на 15 миллионах пар «текст — видео» и 450 миллионах пар «текст — изображение» (из них 400 миллионов из LAION-400M). Авторы сравнили работу алгоритма количественно с некоторыми аналогами и показали сравнимые результаты по FID. Примеры можно увидеть на сайте проекта.

Авторы сравнили работу алгоритма количественно с некоторыми аналогами и показали сравнимые результаты по FID. Примеры можно увидеть на сайте проекта.

Авторам всех трех работ удалось достичь большого прогресса в качестве генерации видео, в том числе его стабильности. Но, как это было и с большинством алгоритмов для генерации изображений, разработчики не опубликовали модели в открытом доступе, опасаясь, что такая технология может быть использована во вред.

Нейросети умеют не только генерировать контент по текстовому описанию. Весной канадские исследователи научили алгоритм искать по нему баги в играх, например, видео геймплея по запросу «Машина, летающая в воздухе».

Григорий Копиев

Нашли опечатку? Выделите фрагмент и нажмите Ctrl+Enter.

Google Neurohive

25 января 2022

- State-of-the-art

В Google разработали нейросеть, с высокой точностью отделяющую объект от фона на изображении. Модель используется в портретном режиме съемки на Pixel 6. При классической сегментации изображения каждый пиксель относится либо…

Модель используется в портретном режиме съемки на Pixel 6. При классической сегментации изображения каждый пиксель относится либо…

21 января 2022

- Фреймворки

Google представила StylEx — инструмент для выделения атрибутов, влияющих на классификаторы изображений. StylEx позволяет объяснить процесс принятия решения классификатором и находить ошибки в моделях. Определение того, какие признаки на изображении…

19 августа 2021

- Приложения

Samsung использует систему искусственного интеллекта DSO.ai компании Synopsys для разработки нового поколения ARM-микропроцессоров Exynos, используемых в смартфонах компании. В Synopsys заявляют, что метод обучения с подкреплением позволяет более чем в…

14 июля 2021

- Фреймворки

Методы компьютерного зрения позволяют распознавать лица на видеозаписях, классифицировать и улучшать качество видео, а также автоматически создавать аннотации к ним. В статье приводится обзор основных облачных платформ для решения этих…

В статье приводится обзор основных облачных платформ для решения этих…

3 марта 2021

- Приложения

Нейросеть от Google AI симулирует движение камеры и параллакс для фотографий. Систему Cinematic photos используют в приложении Google Photos. Оценка глубины изображения Наряду с такими последними функциями для фотографии, как…

23 февраля 2021

- Новости

Model search (MS) — это библиотека, которая использует алгоритмы автоматического поиска архитектуры ML-моделей. Разработчики заявляют, что фреймворк масштабируется на кейсы, когда пространство поиска является немалым. Фреймворк базируется на байесовской оптимизации.…

10 февраля 2021

- Датасеты

TracIn — это масштабируемый метод оценки влияния отдельных объектов в данных на предсказания. Идея TracIn заключается в том, что бы отслеживать процесс обучения модели, чтобы засекать изменения в предсказаниях при…

Идея TracIn заключается в том, что бы отслеживать процесс обучения модели, чтобы засекать изменения в предсказаниях при…

1 октября 2019

- Датасеты

FaceForensics — это датасет с фейковыми видео людей, который был дополнен Google. Датасет выложили, чтобы поддержать исследования в распознавании deepfake контента. Данные содержат 3 тысячи сгенерированных видеозаписей. Датасет собирался в…

30 сентября 2019

- Новости

A LITE BERT (ALBERT) — это оптимизированная версия BERT от Google. Разработчики использовали два метода для снижения количества параметров нейросети: параметризация векторных представлений и обмен весов между слоями нейросети. По…

24 сентября 2019

- Новости

Разработчики из Google опубликовали описание end-to-end рекомендательной системы в YouTube. Система использует несколько целевых функций для ранжирования и учитывает личные предпочтения пользователя. Чтобы оптимизировать модель на несколько целевых функций разработчики…

Система использует несколько целевых функций для ранжирования и учитывает личные предпочтения пользователя. Чтобы оптимизировать модель на несколько целевых функций разработчики…

23 сентября 2019

- Новости

Исследователи из Google опубликовали self-supervised алгоритм, который реконструирует 3D модель объекта из изображения. Нейросеть разбивает объект с изображения на составные фигуры и объединяет их в 3D модель объекта. CvxNets разбивают…

10 сентября 2019

- Новости

Google отдают разработку инфраструктуры для обучения ML-моделей организации open-source разработчиков LLVM Foundation. Ранее Google анонсировали MLIR, компилятор для внедрения ML-моделей в приложения. MLIR позволяет исполнять модели на разных устройствах. Компания…

6 сентября 2019

- Новости

В приложении Google Lens теперь есть функция прослушивания и перевода текста с изображения. Система сначала распознает куски текста на изображении, формирует структурированный текст из кусков, переводит текст и озвучивает перевод.…

Система сначала распознает куски текста на изображении, формирует структурированный текст из кусков, переводит текст и озвучивает перевод.…

2 сентября 2019

- Новости

TF-GAN — это библиотека от Google для обучения генеративных моделей. Библиотека предоставляет быстрый доступ к ряду архитектур генеративных нейросетей, предобученным моделям и стандартизированным метрикам оценки моделей. В обновленной версии стал…

14 июля 2019

- Датасеты

Google запустили второе соревнование по компьютерному зрению на Kaggle — Open Images 2019. Соревнование делится на три трека: распознавание объектов, выявление взаимосвязей между объектами и instance сегментация объектов. Участие можно…

28 июня 2019

- State-of-the-art

XLNet — это предобученная модель, которую можно адаптировать под любую поставленную задачу обработки текста. XLNet обходит BERT, — state-of-the-art модель, — на 20 задачах обработки естественного языка. Для 18 XLNet…

XLNet обходит BERT, — state-of-the-art модель, — на 20 задачах обработки естественного языка. Для 18 XLNet…

27 июня 2019

- Новости

DeepView — это нейросеть, которая по паре входных фотографий восстанавливает вид с фотографии с остальных ракурсов. Результаты работы нейросети можно посмотреть на официальном сайте. Модель получает state-of-the-art результаты на датасетах…

15 апреля 2019

- Новости

Во второй день ежегодной конференции Cloud Next, Google представила бета-версию сервиса AI Platform. Пользователю предлагается выбрать один из готовых алгоритмов обработки данных, либо обучить и развернуть собственную модель. Платформа объединяет…

15 апреля 2019

- Новости

Google Brain ведет разработку ИИ, который предсказывает изменения в коде исходя из прошлых изменений. Команда Google Brain выбрала неявную модель, которая по результатам тестов обеспечивает наилучшую общую производительность и масштабируемость из всех…

Команда Google Brain выбрала неявную модель, которая по результатам тестов обеспечивает наилучшую общую производительность и масштабируемость из всех…

5 февраля 2019

- Новости

Специально для глухих и слабослышащих людей Google разработала приложение, которое распознает речь и создает субтитры в онлайн режиме. Люди, потерявшие слух, смогут участвовать в беседах и посещать общественные мероприятия без…

31 января 2019

- Новости

В конце января стало известно, что приложение Facebook Research отслеживает все данные пользователей: от электронных писем и переписки в социальных сетях до местоположения и истории заказов на Amazon. Получившийся датасет…

Google ИИ

Наш взгляд

Последние новости

Объявление об ИИ для достижения глобальных целей

Объявление об ИИ для достижения глобальных целей

Помощь в решении самых серьезных проблем общества с помощью ИИ

Помощь в решении самых больших проблем общества с помощью ИИ

Узнайте, как Google объединяет исследования, технологии и 25 миллионов долларов финансирование для ускорения прогресса в достижении Глобальных целей.

История тона кожи Работа в Google

История тона кожи Работа в Google

Сделайте искусственный интеллект более совершенным и инклюзивным с помощью Шкалы тонов кожи монаха — бесплатного инструмента разработки от Google Responsible AI.

Демонстрация квантового превосходства с использованием процессора Sycamore

Демонстрация квантового превосходства с использованием процессора Sycamore

для проведения эталонного тестирования.

Объявление грантополучателей Impact Challenge

Объявление грантополучателей Impact Challenge

Google.org обратился к организациям со всего мира с открытым призывом представить свои идеи о том, как они могут использовать ИИ для решения социальных проблем. Познакомьтесь с 20 организациями, которые мы выбрали для поддержки.

Введение в федеративное обучение

Введение в федеративное обучение

Узнайте, как создавать лучшие продукты с данными на устройстве и конфиденциальностью по умолчанию, в новом онлайн-комиксе от Google AI.

Люди + Руководство по искусственному интеллекту

Люди + Руководство по искусственному интеллекту

Инструменты, методы и лучшие практики для разработки продуктов искусственного интеллекта, ориентированных на человека.

Взгляды на проблемы управления ИИ

Взгляды на проблемы управления ИИ

Обзор ключевых областей, в которых правительство может работать с гражданским обществом и специалистами-практиками ИИ, чтобы предоставить важные рекомендации по ответственной разработке и использованию ИИ.

Прогнозирование мест афтершоков землетрясений с помощью науки с искусственным интеллектом

Прогнозирование мест афтершоков землетрясений с помощью искусственного интеллекта

Прогнозы на основе машинного обучения однажды могут помочь развернуть службы экстренной помощи и информировать о планах эвакуации из районов, подверженных риску афтершоков.

Поиск наборов данных

Поиск наборов данных

Инструмент, который позволяет ученым, дата-журналистам, специалистам по данным и всем остальным легко находить наборы данных, хранящиеся в тысячах репозиториев в Интернете.

Блог

ИИ в действии

От наших продуктов до наших платформ с открытым исходным кодом — мы работаем над тем, чтобы преимущества искусственного интеллекта были доступны каждому.

Смотрите наш блог

Исследовательская работа

Ведущий с исследованиями

Наши исследовательские группы совершенствуют новейшие достижения в области компьютерных наук и делают открытия, которые каждый день помогают миллиардам пользователей.

Посмотрите наше исследование

Начать строительство

Мы создаем совместную экосистему с инструментами с открытым исходным кодом, общедоступными наборами данных и API, которые позволяют всем нам максимально эффективно использовать машинное обучение.

Ознакомьтесь с нашими инструментами

Изучите новые навыки

Мы создаем библиотеку открытых образовательных ресурсов, чтобы каждый мог начать учиться, строить и решать проблемы с помощью ИИ.

Учитесь с помощью искусственного интеллекта Google

Обязанности

Создание ответственного ИИ для всех

Мы ответственно работаем над развитием искусственного интеллекта, чтобы приносить пользу людям и обществу.

Учить больше

Google AI представляет два новых семейства нейронных сетей под названием EfficientNetV2 и CoAtNet для распознавания изображений

- О нас

Войти

Добро пожаловать!Войти в свой аккаунт

ваше имя пользователя

ваш пароль

Забыли свой пароль?

Конфиденциальность и ТК

Восстановление пароля

Восстановление пароля

ваш адрес электронной почты

Поиск

Главная Новости технологий Резюме доклада об искусственном интеллекте Google AI представляет два новых семейства нейронных сетей под названием «EfficientNetV2» и. ..

..

Эффективность обучения стала важным фактором для глубокого обучения по мере роста моделей нейронных сетей и увеличения объема обучающих данных. GPT-3 — отличный пример, показывающий, насколько критическим может быть фактор эффективности обучения, поскольку требуются недели обучения с тысячами графических процессоров, чтобы продемонстрировать замечательные возможности в обучении за несколько шагов.

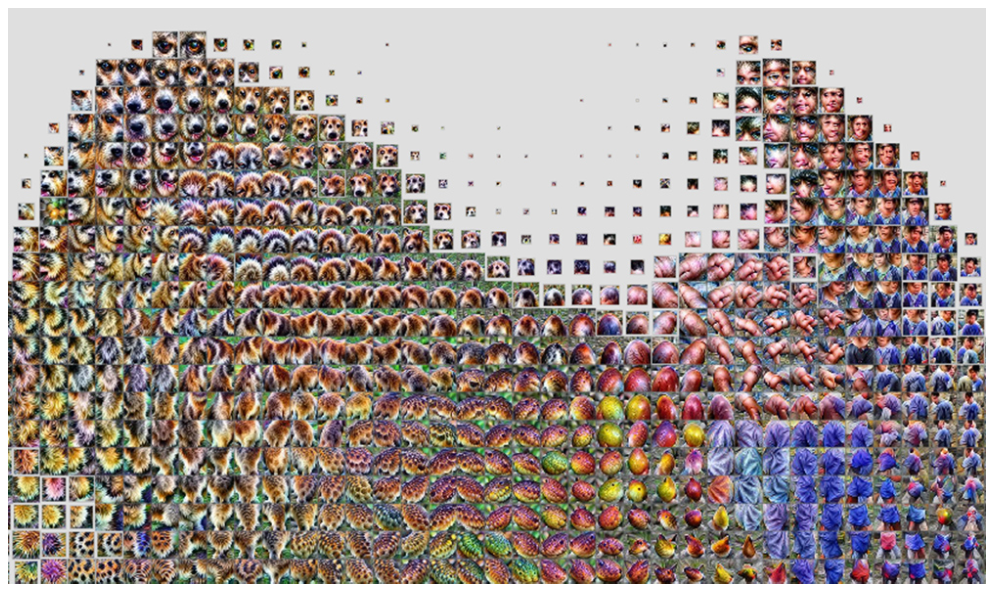

Чтобы решить эту проблему, команда искусственного интеллекта Google представляет два семейства нейронных сетей для распознавания изображений. Во-первых, EfficientNetV2, состоящий из CNN (сверточных нейронных сетей) с небольшим набором данных для повышения эффективности обучения, например, ImageNet1k (с 1,28 миллиона изображений). Во-вторых, это гибридная модель под названием CoAtNet, которая сочетает в себе свертки и самостоятельное внимание для достижения более высокой точности крупномасштабных наборов данных, таких как ImageNet21 (с 13 миллионами изображений) и JFT (с миллиардами изображений). Согласно исследовательскому отчету Google, EfficientNetV2 и CoAtNet работают в 4–10 раз быстрее, обеспечивая при этом самые современные и 90,88 % – точность первого уровня в хорошо зарекомендовавшем себя наборе данных ImageNet .

Согласно исследовательскому отчету Google, EfficientNetV2 и CoAtNet работают в 4–10 раз быстрее, обеспечивая при этом самые современные и 90,88 % – точность первого уровня в хорошо зарекомендовавшем себя наборе данных ImageNet .

EfficientNetV2 : Модели для более быстрого обучения и меньшего размера

EfficientNetV2 основан на предыдущей архитектуре EfficientNet. Команда Google AI изучила узкие места в скорости обучения на современных TPU/GPU, чтобы улучшить исходную модель. Они обнаружили следующее:

- Обучение с большими размерами изображений приводит к более высокому использованию памяти, что приводит к снижению скорости на TPU/GPU.

- Глубинные свертки неэффективны для TPU/GPU, поскольку они имеют низкую загрузку оборудования.

- Общепринятый подход к единообразному составному масштабированию, который одинаково масштабирует каждую стадию сверточных сетей, является неоптимальным.

Исследовательская группа Google предлагает поиск по нейронной архитектуре (NAS) с учетом обучения, в котором скорость обучения включена в цель оптимизации, и метод масштабирования, который неравномерно масштабирует различные этапы для решения этих проблем, как описано выше.

Исследовательская группа Google оценивает модели EfficientNetV2 в ImageNet и нескольких других наборах данных для трансферного обучения. В ImageNet модели EfficientNetV2 превосходят предыдущие модели: скорость обучения примерно в 5–11 раз выше, а размер модели меньше в 6,8 раза.

https://ai.googleblog.com/2021/09/toward-fast-and-accurate-neural.html

CoAtNet : Модели с более высокой скоростью и точностью для крупномасштабного распознавания изображений

В CoAtNet ( CoAtNet: Объединение свертки и внимания для всех размеров данных) исследовательская группа изучила способы сочетания свертки и внутреннего внимания для разработки быстрых и точных нейронных сетей для крупномасштабного распознавания изображений. Комбинируя свертку и самостоятельный анализ, предлагаемые гибридные модели могут обеспечить как большую пропускную способность, так и лучшее обобщение.

Исследовательская группа обнаружила два важных открытия, связанных с обнаружением COAtNet:

- Глубинная свертка и самовнимание могут быть естественным образом объединены с помощью простого относительного внимания.

- Вертикальное размещение слоев свертки и слоев внимания таким образом, чтобы учитывать их пропускную способность и вычисления, необходимые на каждом этапе (разрешение), удивительно эффективно для улучшения обобщения, пропускной способности и эффективности.

Основываясь на вышеизложенном, исследовательская группа Google создала семейство гибридных моделей, состоящих как из свертки, так и из внимания, под названием CoAtNets.

Согласно данным исследовательской статьи Google, модель CoAtNet превосходит модели ViT и ее варианты в ряде наборов данных, таких как ImageNet1K, ImageNet21K и JFT. По сравнению со свёрточными сетями CoAtNet демонстрирует аналогичное поведение производительности на небольшом наборе данных, таком как ImageNet1K.

https://ai.googleblog.com/2021/09/toward-fast-and-accurate-neural.html

Paper (CoAtNet): https://arxiv.org/abs/2106.04803

Paper (EfficientNetV2): https://arxiv.org/abs/2104.00298

Источник: https://ai. googleblog.com/2021/09/toward-fast-and-accurate-neural.html

googleblog.com/2021/09/toward-fast-and-accurate-neural.html

Код: https://github.com/google/automl/tree/master/ эффективныйнетв2

Асиф Раззак

Веб-сайт

|

+ posts

Асиф Раззак — журналист в области искусственного интеллекта и соучредитель Marktechpost, LLC. Он провидец, предприниматель и инженер, который стремится использовать силу искусственного интеллекта во благо.

Последним предприятием Асифа является разработка Медиа-платформы искусственного интеллекта (Marktechpost), которая изменит способы поиска релевантных новостей, связанных с искусственным интеллектом, наукой о данных и машинным обучением.

Onalytica представила Асифа в статье «Кто есть кто в ИИ?». (Влиятельные голоса и бренды)» как одного из «Влиятельных журналистов в области ИИ» (https://onalytica.com/wp-content/uploads/2021/09/Whos-Who-In-AI.pdf). Его интервью также было опубликовано Onalytica (https://onalytica.