Содержание

Законы робототехники — HiSoUR История культуры

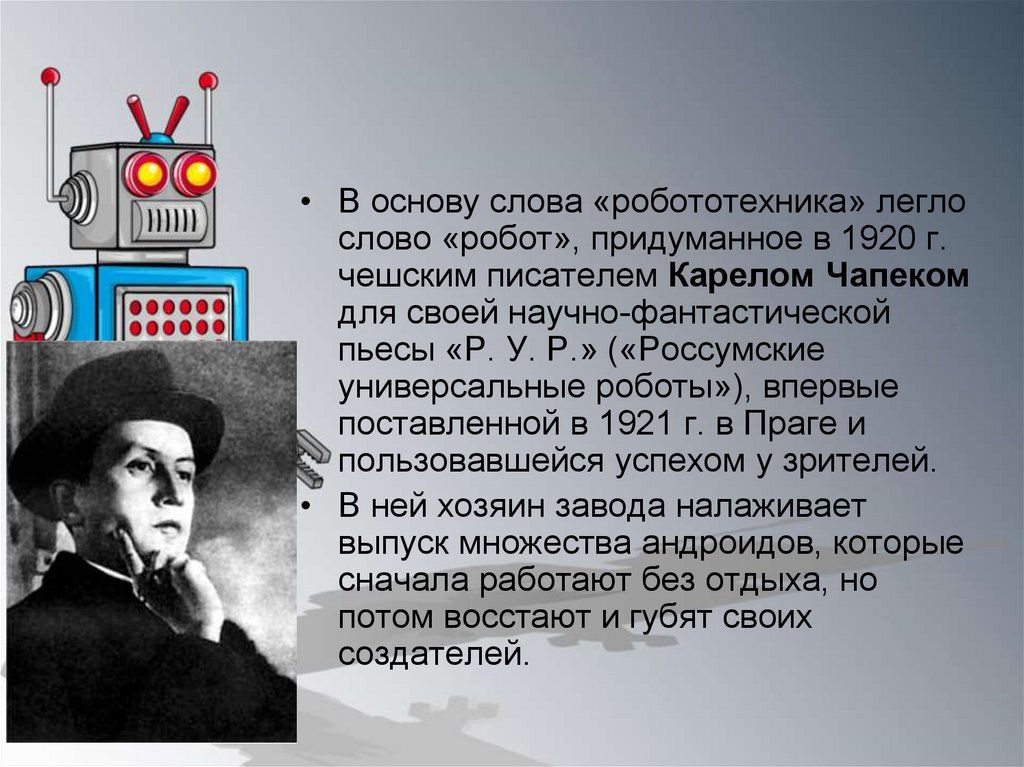

Законы робототехники — это набор законов, правил или принципов, которые предназначены в качестве фундаментальной основы для поддержки поведения роботов, предназначенных для обеспечения степени автономии. Роботов этой степени сложности еще не существует, но они широко ожидаются в научной фантастике, фильмах и являются темой активных исследований и разработок в области робототехники и искусственного интеллекта.

Наиболее известный набор законов — это те, которые были написаны Исааком Асимовым в 1940-х годах или основаны на них, но исследователи в течение десятилетий предлагали другие законы.

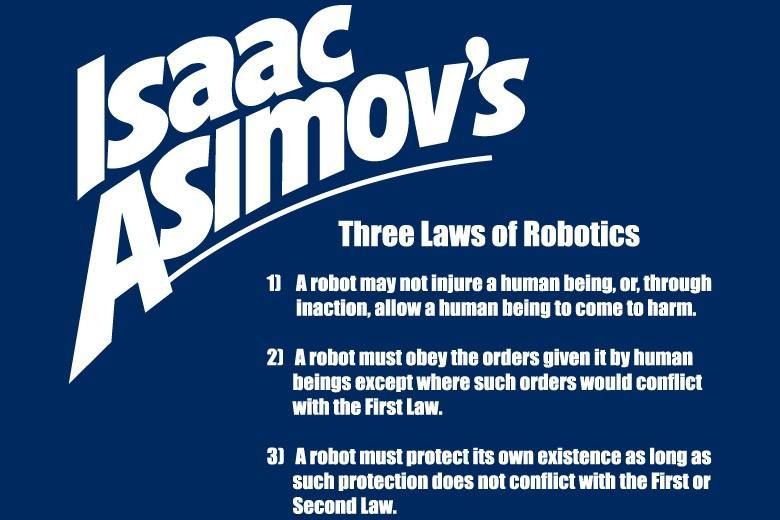

Исаак Азимов «Три закона робототехники»

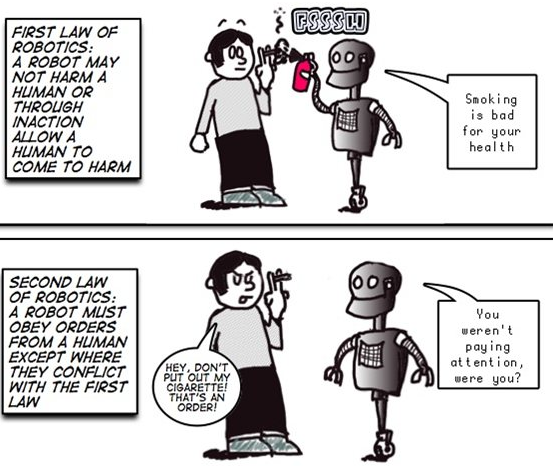

Наиболее известным набором законов являются «Три закона робототехники» Исаака Азимова. Они были представлены в его короткометражном рассказе 1942 года «Runaround», хотя они были предвещены в нескольких предыдущих историях. Три закона:

Робот не может нанести вред человеку или через бездействие позволить человеку нанести вред.

Робот должен подчиняться приказам, данным ему людьми, за исключением случаев, когда такие приказы будут противоречить Первому закону.

Робот должен защищать свое существование, если такая защита не противоречит Первому или Второму Законам.

В конце его книги «Фонд и Земля» был введен нулевой закон:

0. Робот не может нанести вред человечеству или, бездействуя, позволить человечеству нанести вред.

Адаптации и расширения существуют на основе этой структуры. С 2011 года они остаются «вымышленным устройством».

EPSRC / AHRC принципы робототехники

В 2011 году Совет исследований технических и физических наук (EPSRC) и Совет по исследованиям в области искусств и гуманитарных наук Великобритании (AHRC) совместно опубликовали набор из пяти этических «принципов для дизайнеров, строителей и пользователей роботов» в реальном мире, с семью «сообщениями высокого уровня», которые должны были быть представлены на основе исследовательского семинара в сентябре 2010 года:

Роботы не должны разрабатываться исключительно или в первую очередь для уничтожения или нанесения вреда людям.

Люди, а не роботы, являются ответственными агентами. Роботы — это инструменты, предназначенные для достижения человеческих целей.

Роботы должны быть спроектированы таким образом, чтобы обеспечить их безопасность и безопасность.

Роботы — это артефакты; они не должны быть предназначены для использования уязвимых пользователей, вызывая эмоциональный отклик или зависимость. Всегда должно быть возможно сказать роботу от человека.

Всегда должно быть возможно выяснить, кто несет юридическую ответственность за робота.

Сообщения, которые должны были быть переданы, были:

Мы полагаем, что роботы могут оказать огромное влияние на общество. Мы хотим поощрять ответственные исследования роботов.

Плохая практика причиняет нам боль.

Решение очевидных общественных проблем поможет нам всем добиться прогресса.

Важно продемонстрировать, что мы, как роботисты, привержены наилучшим стандартам.

Чтобы понять контекст и последствия наших исследований, мы должны работать с экспертами из других дисциплин, включая: социальные науки, право, философию и искусство.

Мы должны рассмотреть этику прозрачности: существуют ли пределы того, что должно быть открыто доступно?

Когда мы видим ошибочные сообщения в прессе, мы обязуемся тратить время на общение с журналистами-журналистами.

Принципы EPSRC широко признаны в качестве полезной отправной точки. В 2016 году Тони Прескотт организовал семинар для пересмотра этих принципов, например, чтобы дифференцировать этические нормы с юридических принципов.

Развитие судебной системы

Еще одна всеобъемлющая терминологическая кодификация для юридической оценки технологических разработок в индустрии робототехники уже началась в основном в азиатских странах. Этот прогресс представляет собой современное переосмысление закона (и этики) в области робототехники, интерпретация которого предполагает переосмысление традиционных правовых созвездий. К ним относятся прежде всего вопросы юридической ответственности в гражданском и уголовном праве.

Законы Сатья Наделлы

В июне 2016 года Сатья Наделла, генеральный директор Microsoft Corporation в то время, имела интервью с журналом Slate и примерно набросала пять правил для искусственных интеллектов, которые наблюдали их дизайнеры:

«ИИ должен быть разработан, чтобы помочь человечеству», то есть нужно уважать автономию человека.

«ИИ должен быть прозрачным», что означает, что люди должны знать и понимать, как они работают.

«AI должен максимизировать эффективность, не разрушая достоинства людей».

«ИИ должен быть разработан для разумной конфиденциальности», что означает, что он заслуживает доверия, защищая свою информацию.

«У ИИ должна быть алгоритмическая подотчетность, чтобы люди могли отменить непреднамеренный вред».

«ИИ должен защищать от предвзятости», чтобы они не должны были дискриминировать людей.

Тильден «Законы робототехники»

Марк У. Тильден является физиком-робототехником, который был пионером в разработке простой робототехники. Его три руководящих принципа / правила для роботов:

Робот должен защищать свое существование любой ценой.

Робот должен получать и поддерживать доступ к своему источнику питания.

Робот должен постоянно искать лучшие источники питания.

Что примечательно в этих трех правилах, так это то, что это в основном правила для «дикой» жизни, поэтому, по сути, Тильден утверждал, что он хотел «просить кремниевые виды в чувство, но с полным контролем над спецификациями». Не животное. Что-то еще.

Не животное. Что-то еще.

Роботы начали убивать людей, или Конец первого закона Азимова: maysuryan — LiveJournal

Представитель более прогрессивной ветви эволюции, идущей на смену человечеству?

В левых блогах обсуждают знаменательное событие, случившееся этой весной: «робот впервые убил человека без команды другого человека». Из новостей: «Военный квадрокоптер Kargu-2, находясь в автономном режиме работы, убил человека во время вооруженного конфликта в Ливии. Как пишет журнал New Scientist со ссылкой на исследование ООН, это первый зафиксированный случай в истории, когда дрон без приказа человека совершил убийство. Эпизод произошёл в марте 2020 года, однако об этом стало известно только сейчас. Дрон был произведен в Турции и работал в «высокоэффективном автономном режиме», то есть был запрограммирован для атаки целей без необходимости команд от оператора. Kargu-2 оснащаются взрывчаткой и могут быть наведены на цель для самоподрыва. Погибший был участником Ливийской национальной армии под предводительством Халифа Хафтара — она воюет против регулярной армии правительства Ливии в Триполи».

Пока что это, как пишет jakobin1793, «небольшой квадрокоптер… но лиха беда начало — и первые аэропланы из г*вна и палок, с которых вручную скидывали ручные же гранаты, не слишком впечатляли, а уже через три десятилетия они научились уничтожать целые города. Да и не факт, что огромные бомберы страшнее таких малюток, если малюток тысячи».

«»Страж-птица», Роберт Шекли, — пишет kommari. — Читал в советское время ещё. Здравствуй, будущее… Неуютно что-то жить в будущем».

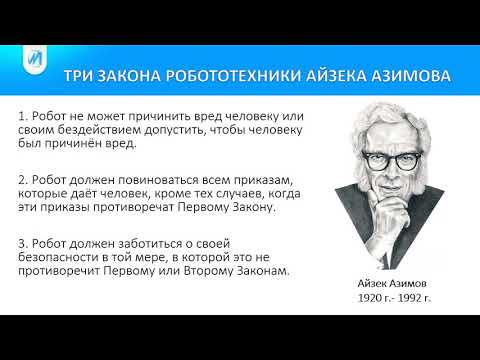

Я бы назвал случившееся событие «концом первого закона робототехники Азимова». Напомню, что в первой половине ХХ века у человечества был весьма развит страх перед появлением в процессе технического прогресса мыслящих роботов. Если сказать проще — то перед тем, что эти роботы начнут убивать людей. Кошмар «восстания роботов»! И человечество в этой новой эволюции ждёт невесёлая судьба неандертальцев. И вот, чтобы как-то совладать с этими страхами, американский прогрессивно мыслящий писатель-фантаст Айзек Азимов (между прочим, уроженец Советской России, Смоленской губернии) в 1942 году сформулировал обязательные правила поведения для роботов — три закона робототехники.

Законы гласили:

«1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

2. Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

3. Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам».

Айзек Азимов (1920—1992)

У Азимова был целый цикл произведений, в которых объяснялось, почему недопустимо самомалейшее отступление от придуманных им законов робототехники. Например, нельзя разрешать роботам спокойно смотреть, как человеку причиняется вред — тогда они сами смогут, допустим, выронить на человека каменную глыбу — это не является убийством, поскольку они могут тут же её подхватить, и ничего не случится. Но, отпустив её, они уже смогут не ловить её, а спокойно смотреть, как «человеку причиняется вред» падением этой глыбы. То есть законы Азимова были продуманы до тонкости. ..

..

Законы Азимова так и не вошли в реальное употребление, но тем не менее сыграли определённую историческую роль: благодаря им люди свыклись с тем, что на планете могут существовать иные разумные существа, кроме них самих, созданные на иной физической основе. Успокоили себя, убедив, что те будут находиться на положении послушной низшей расы, грубо говоря, рабов (о чём прямо гласил второй закон — «робот должен повиноваться всем приказам, которые даёт человек»), им будет строжайше запрещено причинять вред людям, и поэтому сосуществование с ними будет для человека комфортным, удобным и безопасным.

Конечно, если посмотреть со стороны, то законы Азимова — это чистейший расизм, шовинизм и дискриминация. Ведь в «программу человека» не заложено никакого строгого запрета убивать разумного робота, да даже и другого человека. Но роботу это почему-то запрещено. Тем не менее благодаря Азимову люди постепенно свыклись с тем, что на планете может возникнуть другая разумная раса.

Мечты, мечты! С движением истории расистские законы Азимова полетели, как говорится, ф топпку. Второй закон (в части запрета роботам причинять вред человеку по приказу другого человека) был отменён уже давно, десятилетия назад, ещё когда появились дроны, способные с воздуха убивать людей по команде человека. И это прошло для человечества как-то совершенно незамеченно, никто даже не почесался от этого. Люди убивают с помощью дронов? Ну, и пусть убивают, какая разница, чем убивать, дроном или каменным топором… Хотя как хотите, возможно, я старомоден и отстал от жизни, но лично меня такой «безопасный» метод убийства людей, когда убийца не рискует абсолютно ничем, шокирует. Ведь до сих пор в человеческой истории убийство на войне почти всегда было сопряжено с определённым риском для убивающего, потому и считалось часто чем-то достойным, героическим, благородным. Даже лётчика самолёта-бомбардировщика, парящего высоко в небе над своими жертвами, как ангел смерти, могли в теории сбить, как сбили Маккейна и Буша-старшего. Теперь такого риска нет даже в теории. Ну, конечно, оставшиеся в живых жертвы атаки или их соратники могут теоретически разыскать оператора дрона в чужой стране и убить или наказать его.

Второй закон (в части запрета роботам причинять вред человеку по приказу другого человека) был отменён уже давно, десятилетия назад, ещё когда появились дроны, способные с воздуха убивать людей по команде человека. И это прошло для человечества как-то совершенно незамеченно, никто даже не почесался от этого. Люди убивают с помощью дронов? Ну, и пусть убивают, какая разница, чем убивать, дроном или каменным топором… Хотя как хотите, возможно, я старомоден и отстал от жизни, но лично меня такой «безопасный» метод убийства людей, когда убийца не рискует абсолютно ничем, шокирует. Ведь до сих пор в человеческой истории убийство на войне почти всегда было сопряжено с определённым риском для убивающего, потому и считалось часто чем-то достойным, героическим, благородным. Даже лётчика самолёта-бомбардировщика, парящего высоко в небе над своими жертвами, как ангел смерти, могли в теории сбить, как сбили Маккейна и Буша-старшего. Теперь такого риска нет даже в теории. Ну, конечно, оставшиеся в живых жертвы атаки или их соратники могут теоретически разыскать оператора дрона в чужой стране и убить или наказать его. Но это будет рассматриваться отнюдь не как военное действие, а как чистый терроризм или криминальное убийство с их стороны, покушение на мирного гражданина…

Но это будет рассматриваться отнюдь не как военное действие, а как чистый терроризм или криминальное убийство с их стороны, покушение на мирного гражданина…

И вот этой весной сделан и следующий шаг, поистине исторический. Отменён и первый закон Азимова! И человечество проглотило это совершенно бестрепетно. А ведь это историческая веха, чёрт возьми. Роботы начали убивать людей, и не по команде других людей, а сами, по собственной инициативе и, гм, разумению. «Страж-птица» Роберта Шекли стала былью. Вернее, даже не «Страж-птица», а последний абзац этого рассказа, где робот-Ястреб приходит к решению убивать людей, как и всё живое на планете.

«Высоко в небе Ястреб атаковал Страж-птицу. Бронированная машина-убийца за несколько дней многому научилась. У нее было одно-единственное назначение: убивать. Сейчас оно было направлено против совершенно определенного вида живых существ, металлических, как и сам Ястреб.

Но только что Ястреб сделал открытие: есть ещё и другие разновидности живых существ…

Их тоже следует убивать». (с), Р. Шекли, 1953

(с), Р. Шекли, 1953

Роберт Шекли (1928—2005)

Ну, а что? Мне, как марксисту, сразу вспомнилось одно предсказание Мао Цзэдуна (выделил в тексте): «Одно уничтожает другое — возникает, развивается, гибнет. Это всеобщая закономерность. Если тебя не уничтожит кто-то другой, то ты погибнешь сам. Почему умирают люди? Аристократы и те умирают. Таков закон природы. ‹…› Умер человек — надо устраивать праздничный митинг, праздновать победу законов диалектики, праздновать гибель отживших явлений. И социализм тоже погибнет, не может не погибнуть, без этого не будет коммунизма. ‹…› Судьба диалектического метода заключается в непрерывном движении к своей противоположности. В конце концов и для человечества настанет последний день. Когда о последнем дне говорят церковники, это пессимизм, запугивание людей; мы же говорим, что гибель человечества будет рождением чего-то нового, более прогрессивного, нежели человечество» (Мао Цзэдун, 18 августа 1964 г.).

Может быть, так оно всё и случится? И вдобавок не мирно, как воображали постгуманисты, сторонники постепенного превращения людей в киборгов, в кибернетические организмы, а вот так, грубо и топорно, как это делают дроны. Истребит биологические организмы на планете более передовая, высокоразвитая электронная ветвь эволюции, и «это и будет рождением чего-то нового, более прогрессивного, нежели человечество». Жестоко? Но судите сами, насколько потенциально бессмертный (по крайней мере, способный жить миллионы лет) электронный организм эволюционно сильнее и совершеннее отсталого биологического, подверженного болезням, старению, неизлечимым увечьям, смерти и т.д. Ежу понятно, за каким из них будущее, если уж законы Азимова отменены, а точнее, так и не были введены в действие. Да, конечно, с точки зрения людей, истребляющий их без разбора дрон, или какой-то будущий более совершенный терминатор-убийца, который придёт ему на смену, выглядит воплощением Зла. Но что же делать, если они сами его породили, разработали, выпестовали, вложили оружие в руки, научили убивать, дали ему путёвку в жизнь? Кто виноват, если человечество решило повторить судьбу Франкенштейна? А подумаем, как мы сами, вернее, наши далёкие предки выглядели для неандертальцев, мамонтов и прочих истреблённых человеком видов и рас, включая разумные? Вот то-то и оно.

Истребит биологические организмы на планете более передовая, высокоразвитая электронная ветвь эволюции, и «это и будет рождением чего-то нового, более прогрессивного, нежели человечество». Жестоко? Но судите сами, насколько потенциально бессмертный (по крайней мере, способный жить миллионы лет) электронный организм эволюционно сильнее и совершеннее отсталого биологического, подверженного болезням, старению, неизлечимым увечьям, смерти и т.д. Ежу понятно, за каким из них будущее, если уж законы Азимова отменены, а точнее, так и не были введены в действие. Да, конечно, с точки зрения людей, истребляющий их без разбора дрон, или какой-то будущий более совершенный терминатор-убийца, который придёт ему на смену, выглядит воплощением Зла. Но что же делать, если они сами его породили, разработали, выпестовали, вложили оружие в руки, научили убивать, дали ему путёвку в жизнь? Кто виноват, если человечество решило повторить судьбу Франкенштейна? А подумаем, как мы сами, вернее, наши далёкие предки выглядели для неандертальцев, мамонтов и прочих истреблённых человеком видов и рас, включая разумные? Вот то-то и оно. 🙂

🙂

Мао Цзэдун (1893—1976)

Нам нужно обновить наши правила для робототехники

Поскольку роботы все больше интегрируются в общество, мы должны быть уверены, что они будут вести себя хорошо среди нас. В 1942 году писатель-фантаст Айзек Азимов попытался изложить философскую и моральную основу для того, чтобы роботы служили человечеству и чтобы они не стали разрушительными повелителями. Эти усилия привели к тому, что стало известно как Три закона робототехники Азимова: ЩЕЛКНИТЕ, ЧТОБЫ ПРОСМОТРЕТЬ ПОЛНУЮ ИНФОГРАФИКУ

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

- Робот должен подчиняться приказам, отдаваемым ему людьми, за исключением случаев, когда такие приказы противоречат Первому Закону.

- Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму Закону.

Сегодня, более чем через 70 лет после первой попытки Азимова, у нас гораздо больше опыта работы с роботами, в том числе с тем, чтобы они возили нас, по крайней мере, в хороших условиях. Мы приближаемся к тому времени, когда роботы в нашей повседневной жизни будут принимать решения о том, как действовать. Достаточно ли хороши три закона Азимова, чтобы управлять поведением роботов в нашем обществе, или нам следует найти способы их улучшить?

Мы приближаемся к тому времени, когда роботы в нашей повседневной жизни будут принимать решения о том, как действовать. Достаточно ли хороши три закона Азимова, чтобы управлять поведением роботов в нашем обществе, или нам следует найти способы их улучшить?

Азимов знал, что они несовершенны

Ровена Моррилл/GFDL, CC BY-SA

Рассказы Азимова «Я, робот» исследуют ряд непредвиденных последствий и явных нарушений Трех законов. В этих ранних рассказах Три закона рассматриваются как силы с различной силой, которые могут иметь непреднамеренное равновесное поведение, как в рассказах «Обход» и «Поймай этого кролика», для решения которых требуется человеческая изобретательность. В рассказе «Лжец!» робот-телепат, движимый Первым законом, говорит людям то, что они хотят услышать, не предвидя большего вреда, который наступит, когда правда выйдет наружу. Робопсихолог Сьюзан Кэлвин заставляет его столкнуться с этой дилеммой, разрушая его позитронный мозг.

В «Побеге!» Сьюзен Кэлвин ослабляет силу Первого закона настолько, чтобы позволить сверхразумному роботу разработать метод межзвездной транспортировки со скоростью, превышающей скорость света, даже если это приводит к гибели (но только временной!) человеческие пилоты. В «Неизбежном конфликте» машины, контролирующие мировую экономику, интерпретируют Первый закон как защиту всего человечества, а не только отдельных людей. Это предвещает более позднее введение Азимовым «Закона Нуля», который может заменить первоначальные три, потенциально позволяя роботу причинять вред человеку для всеобщего блага человечества.

В «Неизбежном конфликте» машины, контролирующие мировую экономику, интерпретируют Первый закон как защиту всего человечества, а не только отдельных людей. Это предвещает более позднее введение Азимовым «Закона Нуля», который может заменить первоначальные три, потенциально позволяя роботу причинять вред человеку для всеобщего блага человечества.

Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечество причинило вред.

Роботы без этики

Разумно опасаться, что без этических ограничений роботы (или другие искусственные интеллекты) могут причинить большой вред, возможно, всему человечеству, даже просто следуя данным им инструкциям человека.

Фильм 1991 года «Терминатор 2: Судный день» начинается с известного научно-фантастического сценария: система искусственного интеллекта под названием Скайнет начинает ядерную войну и почти уничтожает человеческую расу. Развертывание Скайнета было рациональным решением (у него был «идеальный послужной список»). Скайнет «начинает учиться с геометрической скоростью», пугая своих создателей, которые пытаются его закрыть. Скайнет наносит ответный удар (как критически важная система защиты, он, несомненно, был запрограммирован на самозащиту). Скайнет находит неожиданное решение своей проблемы (путем творческого решения проблем, не ограниченного здравым смыслом или моралью).

Скайнет «начинает учиться с геометрической скоростью», пугая своих создателей, которые пытаются его закрыть. Скайнет наносит ответный удар (как критически важная система защиты, он, несомненно, был запрограммирован на самозащиту). Скайнет находит неожиданное решение своей проблемы (путем творческого решения проблем, не ограниченного здравым смыслом или моралью).

В реальном мире имели место менее апокалиптические примеры неконтролируемого ИИ. Высокоскоростные автоматические торговые системы отреагировали на необычные условия на фондовом рынке, создав цикл положительной обратной связи, который привел к «внезапному краху». К счастью, были потеряны лишь миллиарды долларов, а не миллиарды жизней, но задействованные компьютерные системы мало или совсем не понимают разницы.

На пути к определению этики роботов

Хотя никакой простой фиксированный набор механических правил не обеспечит этического поведения, мы можем сделать некоторые наблюдения о свойствах, которыми должна обладать морально-этическая система, чтобы позволить автономным агентам (людям, роботам и т. д.) хорошо жить вместе. Многие из этих элементов уже ожидаются от человека.

д.) хорошо жить вместе. Многие из этих элементов уже ожидаются от человека.

Эти свойства основаны на ряде источников, включая

Принципы робототехники Исследовательского совета по инженерным и физическим наукам (EPSRC) и

недавнюю работу по когнитивной науке о морали и этике, сосредоточенную на неврологии, социальной психологии, психологии развития и философии. .

EPSRC считает, что роботы — это просто инструменты, за которые люди должны нести ответственность. На другом конце спектра находится опасение, что сверхразумные, сверхмощные роботы могут внезапно появиться и управлять судьбой человечества, к лучшему или к худшему. Следующий список определяет золотую середину, описывая, как будущие интеллектуальные роботы должны учиться, как это делают дети, как вести себя в соответствии со стандартами нашего общества.

- Если роботы (и другие ИИ) будут все больше участвовать в жизни нашего общества, то они должны будут следовать моральным и этическим правилам так же, как это делают люди

. Некоторые правила воплощены в законах против убийства, воровства, лжи и вождения по неправильной стороне улицы. Другие менее формальны, но, тем не менее, важны, например, помощь и сотрудничество, когда появляется возможность.

Некоторые правила воплощены в законах против убийства, воровства, лжи и вождения по неправильной стороне улицы. Другие менее формальны, но, тем не менее, важны, например, помощь и сотрудничество, когда появляется возможность. - В некоторых ситуациях требуется быстрое моральное суждение и реакция – например, ребенок попадает в пробку или возможность положить в карман упавший бумажник. Простые правила могут обеспечить автоматический ответ в режиме реального времени, когда нет времени на обдумывание и анализ затрат и результатов. (Когда-нибудь роботы могут достичь интеллекта человеческого уровня, действуя намного быстрее, чем человеческое мышление, что позволит тщательно обдумывать все за миллисекунды, но этот день еще не настал, и он может быть в далеком будущем.)

- Быстрый ответ не всегда может быть правильным, что может быть признано после отзывов других или тщательного личного размышления. Следовательно, агент должен иметь возможность учиться на собственном опыте, включая обратную связь и обсуждение, что приводит к новым и улучшенным правилам.

- Чтобы извлечь выгоду из отзывов других членов общества, робот должен уметь объяснять и обосновывать свои решения об этических действиях, а также понимать объяснения и критические замечания других.

- Учитывая, что искусственный интеллект учится на своих ошибках, мы должны очень осторожно относиться к тому, какую силу мы ему даем. Мы, люди, должны убедиться, что он пережил достаточное количество ситуаций и удовлетворил нас своими ответами, заслужив наше доверие. Критическая ошибка, допущенная людьми со Скайнетом в «Терминаторе 2», заключалась в передаче контроля над ядерным арсеналом.

- Робот должен заслужить доверие и надежность. Доверие завоевывается медленно, благодаря большому опыту, но может быть быстро потеряно из-за одного неверного решения.

- Как и в случае с человеком, каждый раз, когда робот действует, выбор этого действия в данной ситуации посылает остальной части общества сигнал о том, как этот агент принимает решения и, следовательно, насколько он заслуживает доверия.

- Разум робота — это программное обеспечение, для которого можно создать резервную копию, восстановить в случае повреждения или уничтожения оригинала или его дублирования в другом теле. Если роботы определенного вида являются точными копиями друг друга, то доверие можно не заслуживать по отдельности. Доверие, заработанное (или утраченное) одним роботом, может быть разделено другими роботами того же типа.

- Поступать нравственно и хорошо по отношению к другим — это не то же самое, что брать на себя моральную ответственность. Только компетентные взрослые люди могут взять на себя полную ответственность за свои действия, но мы ожидаем, что дети, животные, корпорации и роботы будут вести себя хорошо, насколько это возможно.

Человеческая мораль и этика усваиваются детьми годами, но сама природа морали и этики меняется в зависимости от общества и развивается на протяжении десятилетий и столетий. Никакой простой фиксированный набор моральных правил, будь то три закона Азимова или десять заповедей, не может быть адекватным руководством для людей или роботов в нашем сложном обществе и мире. Благодаря наблюдениям, подобным приведенным выше, мы начинаем понимать сложный процесс обучения, основанный на обратной связи, который ведет к морали.

Благодаря наблюдениям, подобным приведенным выше, мы начинаем понимать сложный процесс обучения, основанный на обратной связи, который ведет к морали.

Бенджамин Куйперс, профессор компьютерных наук и инженерии, Мичиганский университет

Эта статья была первоначально опубликована на The Conversation. Прочитайте оригинальную статью.

Поделиться этой статьей

О роботах и людях: применение законов робототехники Азимова к дизайну взаимодействия с пользователем | Луис

Как использование роботизированных правил научно-фантастического автора может помочь создать правильную основу для создания эффектных дизайнов и удобных для пользователя продуктов, услуг и многого другого.

Разработка анимационных игр Chaosamran Studio

Если вы читаете это, вы, вероятно, слышали о человеко-ориентированном дизайне, методологии, используемой для решения проблем, которые ставят пользователя, в данном случае, людей в центр проблемы, и проверяет каждое открытие, гипотезу и концепцию с ними.

Попытка найти решение, которое решает только проблему каждого пользователя, скорее всего, в конечном итоге окажется невыполнимой миссией, но наша задача как дизайнеров взаимодействия с пользователем — гарантировать, что независимо от того, как оно будет реализовано и с какими ограничениями мы столкнемся при этом проблема пользователя освещается максимально широко. Это включает в себя не только выполнение, но и установление ожиданий, а также до и после взаимодействия с любым продуктом или функцией, над которой вам нужно работать.

Но какое отношение это имеет к роботам? — возможно, спросите вы.

Правда в том, что немного. Если не анализировать проектирование и создание роботов в рамках человеко-ориентированного дизайна. И как создание и программирование роботов, машин, предназначенных для выполнения человеческих задач, так сильно связано с пользовательским опытом в целом.

И вот тут Айзек Азимов придумал свод правил, которым следуют все роботы, что обеспечит их хорошее поведение по отношению к их создателям и пользователям. Три закона робототехники Азимова появились в его книге Runaround, опубликованной в 1919 г.42, но они быстро стали основой для любой автономной машины, созданной для улучшения жизни людей.

Три закона робототехники Азимова появились в его книге Runaround, опубликованной в 1919 г.42, но они быстро стали основой для любой автономной машины, созданной для улучшения жизни людей.

Вам может быть интересно, какое отношение это вообще имеет к пользовательскому опыту, и правда в том, что для того, чтобы иметь возможность создавать хорошие, удобные для пользователя продукты, нам всегда нужно работать с инфраструктурой, которая обеспечивает успех этого. И именно здесь базовых принципов дизайна недостаточно для удовлетворения потребностей наших пользователей, и здесь набор базового набора законов, которые работают вместе, может помочь нам определить лучший опыт.

Не вдаваясь в подробности научной фантастики или творчества Айзека Азимова, он давно придумал три закона, которые, как и законы движения Ньютона, определяли бы в данном случае то, как роботы запрограммированы на поведение . Три закона робототехники от Айзека Азимова:

1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

2. Робот должен подчиняться приказам, отдаваемым ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону.

3. Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму закону.

Роботы — это машины, которые помогают людям и в большинстве наших случаев имитируют их внешний вид и способы поведения, и поэтому почему бы не экстраполировать эти законы на то, что используют реальные люди, и как их применение для создания пользовательского опыта может сделать создание из тех, что более гуманны.

В следующих нескольких строках я разберу каждый из законов и адаптирую их к дизайну пользовательского опыта.

Этот первый закон является прямым правилом, определяющим, что роботы должны быть запрограммированы так, чтобы они не причиняли вреда людям, и это ясно. Точно так же прямая корреляция с дизайном взаимодействия с пользователем заключается в следующем: пользовательский опыт не должен вредить пользователям или, с точки зрения дизайна UX, создавать больше проблем, чем те, которые мы пытаемся решить. Чтобы преодолеть это и обеспечить соблюдение этого закона в наших проектах, мы можем использовать несколько методов:

Чтобы преодолеть это и обеспечить соблюдение этого закона в наших проектах, мы можем использовать несколько методов:

- Убедитесь, что мы понимаем проблему, и вы работаете над ее решением: Чтобы найти идеальное решение, нужно много чего сделать, однако четкое представление об основных потребностях наших пользователей должно гарантировать, что предлагаемый дизайн будет максимально простым.

- Путь должен быть как можно более простым: Аналогично поиску решения, которое решает проблему безвредным способом, чем меньше упущенных вариантов или альтернатив на пути к ее достижению, тем эффективнее и безопаснее для пользователей предложенное решение будет.

- Измеряйте и отслеживайте использование: Наблюдайте за пользователями после предложения решения так же важно, как и спрашивая их о том, чего они хотят в начале, убедитесь, что они успешно достигают своих целей с помощью вашего дизайна, убедитесь, что они не создают дополнительные болевые точки, и если это так, также помогает быстрее реагировать и итерировать, чтобы решить их.

Второй закон дает роботам право делать только то, что им приказывают люди, точно так же, как для дизайна взаимодействия с пользователем его можно перевести как: взаимодействие с пользователем всегда должно обеспечивать ожидаемый ввод данных для пользователей, если только это не означает, что его результат будет мешать беспрепятственному взаимодействию с пользователем.

Другими словами, при использовании продуктов пользователи всегда должны быть проинформированы и подсказаны с информацией или взаимодействием, которые они ожидают увидеть, если только ожидаемый результат не создает проблемы для их опыта. Существует несколько методов или принципов, которым необходимо следовать, чтобы соответствовать этому закону, вот некоторые из них:

- Всегда управляйте ожиданиями пользователя: При разработке чего-либо важно, чтобы результат этого всегда контролировался и соответствовал правилам пользователя, и все, что происходит при его использовании, также является ожидаемым результатом.

- Применение правил доступности: Это гарантирует, что пользовательский опыт будет удобен для всех или подавляющего большинства пользователей, поэтому результат его использования всегда будет максимально управляемым.

Последний из законов направлен на самозащиту, и с точки зрения пользовательского опыта его можно интерпретировать как: 9Пользовательский опыт 0106 должен быть пуленепробиваемым и позволять его блокировать, чтобы его собственное использование не нарушало работу .

Когда дело доходит до того, чтобы пользовательский опыт не причинял вреда им самим, важно понимать каждый отдельный вариант использования и узкое место, а также иметь четкое представление обо всем потоке. Вот несколько способов убедиться в том, что этот закон соблюдается:

- Составьте карту взаимодействия с пользователем: полезно отображать каждый шаг в процессе и различные потоки и выделять конечные точки и ожидаемое поведение с ними.

- Поймите, как что-то может не работать: Обычно мы разрабатываем для идеального случая и учитываем ошибки только тогда, когда есть «продуманный» ход, который может вызвать ошибку, но полезно регулярно проверять концепции с пользователями и учитывать эти ошибки. часть пути. Это также поможет

- Применять принципы замыкания: Как один из принципов гештальта, принцип замыкания объясняет, что некоторые незавершенные формы могут восприниматься как завершенные с учетом восприятия их окружения и обратных форм вокруг них. Закон замыкания можно использовать для достижения визуальных эффектов, которые направляют пользователей к выполнению задач в зависимости от того, насколько релевантным является контент, связанный с основным действием, и таким же образом при выполнении задач, которые могут быть основаны на том, что происходит вокруг основного триггера действия. Действие.

Несмотря на то, что дизайн взаимодействия с пользователем постоянно развивается, и нет устоявшейся структуры, которой можно следовать, кроме набора отраслевых принципов, всегда полезно найти другие подходы к дизайну продукта.

Некоторые правила воплощены в законах против убийства, воровства, лжи и вождения по неправильной стороне улицы. Другие менее формальны, но, тем не менее, важны, например, помощь и сотрудничество, когда появляется возможность.

Некоторые правила воплощены в законах против убийства, воровства, лжи и вождения по неправильной стороне улицы. Другие менее формальны, но, тем не менее, важны, например, помощь и сотрудничество, когда появляется возможность.