Содержание

Правила для ИИ в реальном мире. Законы робототехники Азимова устарели?

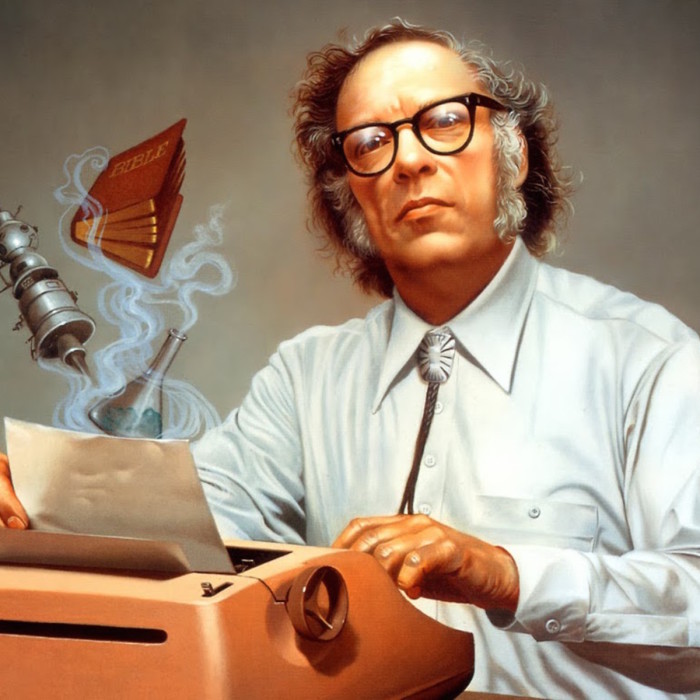

76 лет назад писатель-фантаст Айзек Азимов сформулировал три закона робототехники. На тот момент казалось, что они никогда не устареют. Насколько эти правила актуальны в современном мире, где искусственный интеллект закрепился во всех сферах жизни настолько прочно, что мы его даже не замечаем, пишет The Next Web.

Читать далее…

Три закона, которые Азимов впервые представил в научно-фантастическом рассказе «Хоровод», гласят:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Почти столетие Законы Азимова служили основой разработки роботов. Но эксперты считают, что они больше не соответствуют современным реалиям.

Но эксперты считают, что они больше не соответствуют современным реалиям.

Конечно, в 40-е никто не мог предвидеть появление Google и Facebook. Для людей того времени роботы — нечто с руками и лазерами, и уж никак не реклама в социальных сетях и поисковые алгоритмы. Роботы принимают всё более простую форму, и риск того, что они уничтожат человечество, отходит на дальний план. А на первое место выходит вопрос регулирования исследований в этой области. Политические деятели всей планеты призывают ведущих мировых экспертов не позволить машинам захватить мир.

Какими должны быть правила для искусственного интеллекта в реальном, а не фантастическом мире?

В феврале 2018 года специалисты организации Cambridge Consultants опубликовали доклад на тему возможностей ИИ «AI: Understanding And Harnessing The Potential». В нём они выделили пять ключевых правил, которыми должны руководствоваться учёные в своих исследованиях искусственного интеллекта, и которые также необходимо закрепить в законодательствах и на практике:

1. Ответственность: за результаты действий автономной системы должен нести ответственность определённый человек, не только потому, что он будет должен возместить ущерб, но и для того, чтобы обеспечить обратную связь, заниматься мониторингом последствий и вносить изменения в технологию.

Ответственность: за результаты действий автономной системы должен нести ответственность определённый человек, не только потому, что он будет должен возместить ущерб, но и для того, чтобы обеспечить обратную связь, заниматься мониторингом последствий и вносить изменения в технологию.

Не только в целях возмещения ущерба, но и для того, чтобы получить объяснение этих действий, отслеживать последствия, и вносить изменения.

2. Объяснимость: необходимо уметь объяснить простым людям (зачастую не разбирающемся в сфере) действия ИИ.

3. Точность: должно быть возможно идентифицировать, взять под контроль, оценить и по возможности исправить или устранить причины ошибки.

4. Прозрачность: результаты автономной системы должно быть возможным протестировать, описать в отчёте (публично или в частном порядке), вынести на обсуждение и оспорить результаты. Результаты испытаний и оценок следует обнародовать и объяснять.

5. Беспристрастность: использовать данные нужно разумно и не нарушая частных прав. Это поможет предотвратить предвзятость и различные неэтичные практики.

Беспристрастность: использовать данные нужно разумно и не нарушая частных прав. Это поможет предотвратить предвзятость и различные неэтичные практики.

Стоит отметить, что здесь ничего не сказано об угрозе целенаправленного уничтожения человечества искусственным интеллектом. Возможно потому, что машины ещё не способны самостоятельно принимать такие решения.

Чтобы избежать опасностей, связанных с развитием искусственного интеллекта, стоит просто руководствоваться здравым смыслом. Вряд ли ИИ-алгоритму в основе Face ID Apple понадобится вас убивать, а вот безнравственный разработчик может запросто запрограммировать его на использование камеры вашего смартфона без вашего ведома.

Поэтому любые правила в отношении ИИ должны быть нацелены на то, чтобы предсказать возможный вред, снизить риск и обеспечить в первую очередь безопасность. Вот такой комплекс правил, например, разработала Google:

Мы выделили пять моментов, которые будут очень важны при использовании ИИ в более общих обстоятельствах.

Все они ориентированы на долгосрочную перспективу и будут иметь существенное значение в будущих в исследованиях, даже если сегодня кажутся незначительными:

1. Избежание негативных побочных эффектов: как гарантировать, что ИИ-система не начнёт разрушать окружающую среду, исполняя свои функции? Например, что робот-уборщик не перевернёт вазу, потому что так ему будет проще убирать?

2. Избежание самостимуляции: как избежать того, что робот просто начнёт искать самый лёгкий способ получить вознаграждение? Например, робот-уборщик не должен прикрывать беспорядок и делать вид, что его нет.

3. Самостоятельность: как гарантировать, что ИИ-система будет рационально использовать затратные ресурсы во время своего обучения? Например, если при выполнении задачи ИИ-системе требуется обратная связь от человека, то полученные вводные она должна использовать рационально, а не раздражать постоянными вопросами.

4. Безопасные открытия: как сделать так, чтобы ИИ-система не пострадала в процессе взаимодействия с миром? Например, робот может мыть пол, как ему угодно, но не должен совать влажную тряпку в розетку.

5. Устойчивость к изменениям: как сделать так, чтобы ИИ-система могла ориентировалась и продолжала действовать в обстановке, отличной от среды обучения? Например, методы уборки на фабрике неприменимы в офисе.

Будущее ИИ — проблема не только компаний вроде Google и Cambridge Consultants, ведь по мере внедрения машинного обучения во всё большее количество устройств, включая большинство смартфонов и компьютеров, она только усугубится. Зловредных программ может появиться всё больше, тем более что искусственный интеллект можно научить создавать гораздо более качественные алгоритмы, чем люди.

Вопросы контроля и морали в сфере искусственного интеллекта имеют мало отношения к роботам-убийцам, за исключением специально сконструированных военных машин. Вместо этого, правительствам стоит сосредоточиться на опасностях, которые ИИ представляет в повседневной жизни.

Вместо этого, правительствам стоит сосредоточиться на опасностях, которые ИИ представляет в повседневной жизни.

«Не убивать людей» — хорошее правило как для людей, так и машин независимо от их интеллектуального развития.

Три закона робототехники Азимова: будут ли роботы господствовать над человечеством в Солнечной системе —

7 июня 2021, 20:15

В Сети дискутировали на тему того, каким будет роботизированный мир будущего и каковы последствия упразднения трех постулатов законов робототехники Айзека Азимова.

Терминатор в реалии: в 2020 году зафиксировано первое

убийство человека роботом

В некоторых блогах интернет-сообщества активно обсуждается

одно из событий, которое произошло еще весной 2020 года. И если верить

участникам этих форумов, случившееся положило начало новой эпохе в

существовании разумной цивилизации на планете. Иными словами, «мир уже никогда

не будет прежним».

О теме роботов порассуждал на страницах LiveJournal пользователь с ником maysuryan.

Что же произошло в марте 2020-го, заставив многих людей

совсем по-другому взглянуть на свое будущее и даже будущее всей биологической

разумной жизни на Земле.

Эпохальный инцидент с летальным исходом

Событие, которое положило начало диспутам в Сети по поводу

будущего человечества, произошло в зоне вооруженного конфликта в Ливии. Вот

краткая история эпохального происшествия.

Армейский летающий дрон Kargu 2, совершая боевой вылет в

автономном режиме, убил человека.

Казалось бы, на фоне современной роботизации армий

большинства стран мира, когда «умные механизмы» занимаются уже не только

разведкой или разминированием объектов, но и берут полноценное участие в боевых

операциях с применением оружия, эта новость должна была попросту затеряться

среди других. Однако одно «но» сделало ее эпохальной, тем более что огласке

эта новость была предана спустя год после самого происшествия.

Итак, как говорится, «отсюда поподробнее». В зоне

вооруженного конфликта в Ливии военный дрон производства Турции во время

выполнения боевого задания, находясь в “высокоэффективном автономном режиме”,

атаковал и убил солдата Ливийской национальной армии. Для понятия ситуации

стоит пояснить, что под термином «высокоэффективный автономный режим»

подразумевается режим, в котором боевой дрон запрограммирован на атаку

вражеской цели без необходимости получения на это команды или разрешения от

оператора.

Реакция пользователей на инцидент с участием боевого дрона

Как только о случившемся в Ливии стало известно широкой публике, Интернет тут же наполнился комментариями и рассуждениями

пользователей. Большинство из них сходятся во мнении, что популярная в

фантастическом жанре тема восстания «умных машин» против людей может

превратиться в жестокую реальность уже в ближайшем будущем.

Как написал пользователь с никнеймом jakobin1793, это пока

что разумная боевая машина – небольшой квадрокоптер. Но, как говорится, лиха

Но, как говорится, лиха

беда начало. Ведь первые аэропланы, с борта которых пилоты вручную сбрасывали

гранаты, тоже мало кого впечатляли. Но уже через 3 десятка лет воздушными

бомбардировками уничтожались целые города. При этом блогер подчеркивает, что

огромные бомбардировщики могут быть куда «безобиднее» подобных «малюток», особенно, если последних тысячи.

Вспомнили пользователи и «Страж-Птицу»” американского

классика фантастики Роберта Шекли, и, конечно же, «Терминатора» с его «Судным днем». Однако точнее всего к произошедшему подходит определение “Конец Первого

закона робототехники Азимова”.

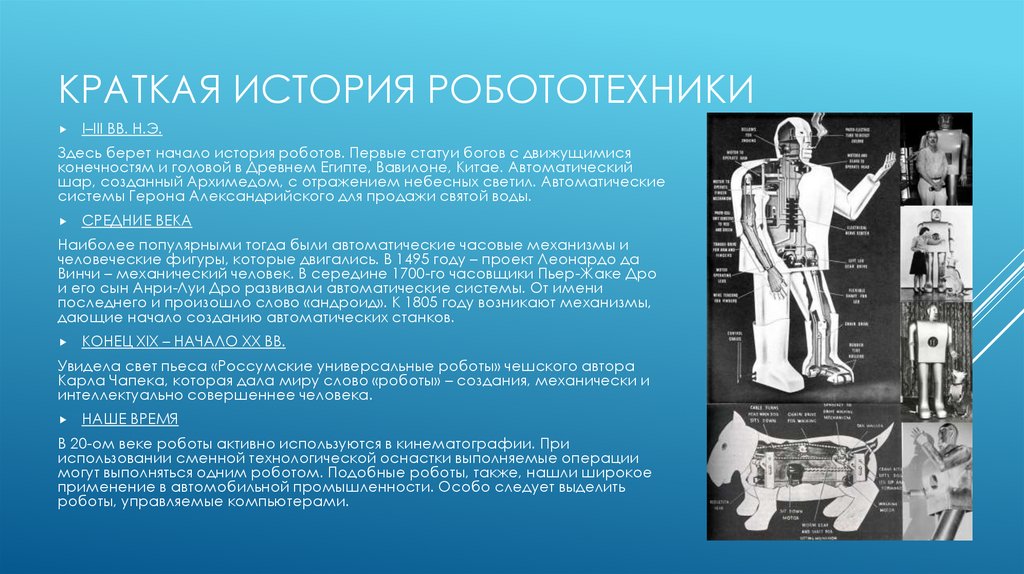

История появления фантастических законов робототехники

В первой половине прошлого века в сознании людей сидел

страх, что в процессе развития техники неизбежно появление «разумных роботов», точнее, человечество всерьез опасалось, что роботы в будущем будут убивать homo

sapiens. Таким образом, людей в этой близящейся новой эпохе ждала печальная

судьба неандертальцев. Довольно мрачная и невеселая перспектива. С подобными

Довольно мрачная и невеселая перспектива. С подобными

страхами надо было что-то делать, ведь все они легко могли перерасти во

всеобщую истерию. Исправить ситуацию решил американский писатель-фантаст Айзек

Азимов.

Именно он в 1942 году придумал и сформулировал своеобразные

обязательные каноны (или правила) поведения для любых роботов. Так появились

легендарные 3 закона робототехники.

Закон 1. Робот не может нанести человеку вред, или же своим

бездействием допустить, чтобы человеку был причинен вред.

Закон 2. Машина (робот) должна подчиняться абсолютно всем

приказам, отдаваемым ей человеком. Исключением могут быть только те приказы,

которые прямо противоречат I закону робототехники.

Закон 3. Робот обязан заботиться о своей безопасности только

в той степени, в которой эта забота не будет противоречить первым двум законам.

Все эти законы Азимов впоследствии «наглядно» пояснил в

своих произведениях, указывая на все моменты, почему даже малейшее отступление

от выведенных им Законов абсолютно недопустимо.

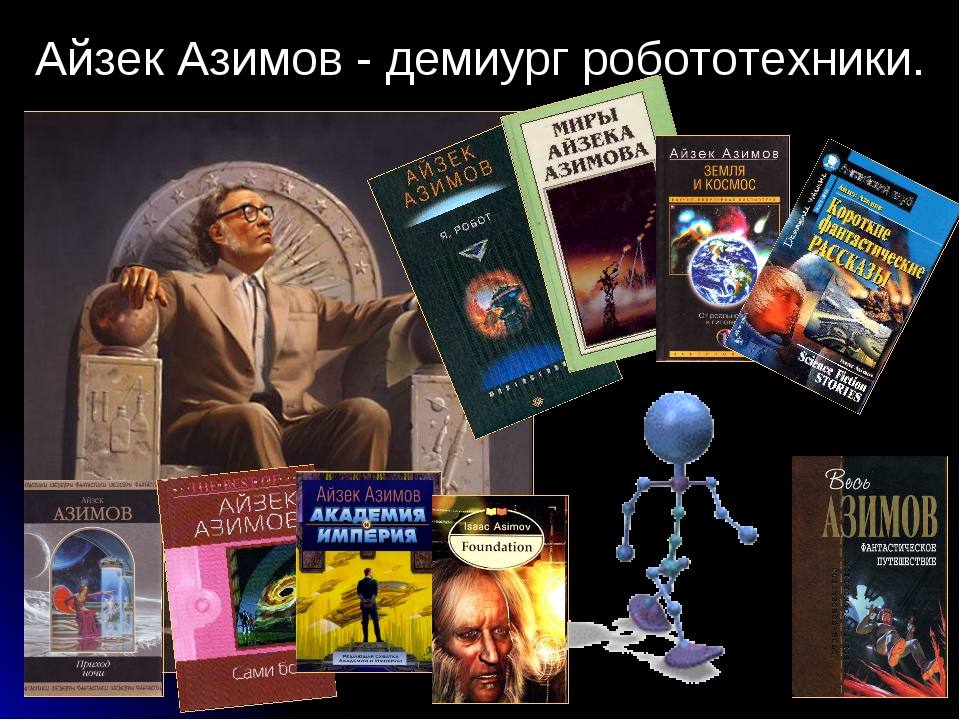

Справка: (Isaac Asimov, имя при рождении Исаак Юдович Азимов; 2 января 1920 года, Петровичи, Смоленская губерния, РСФСР — 6 апреля 1992 года, Манхэттен, Нью-Йорк, США) — американский писатель-фантаст, популяризатор науки, биохимик. Автор около 500 произведений, в основном художественных (прежде всего в жанре научной фантастики, но также и в других жанрах: фэнтези, детектив, юмор) и научно-популярных (в самых разных областях — от астрономии и генетики до истории и литературоведения).

Последствия существования недействующих законов

Стоит подчеркнуть, что придуманные законы робототехники так

и не были ратифицированы в реальном мире ни одной компанией по производству

роботов и ни одним государством, однако некоторую весьма важную роль в жизни

человечества они все-таки сыграли. Именно благодаря существованию данных

законов люди полностью свыклись с пониманием, что на Земле параллельно с ними

могут существовать и другие “индивидуумы”, наделенные разумом, пусть даже и

искусственно созданные самими людьми.

Более того, человечество

успокоило себя убеждением, что если роботы и станут когда-либо разумными, они

всегда будут находиться на положении эдакой «низшей расы» (прислуги или же

послушных рабов), ведь такой статус роботам прописывал I закон робототехники:

полное повиновение человеческим приказам. Роботы не могли бы причинять людям

даже малейшего вреда, следовательно сосуществование с разумными машинами будет

для человека полностью безопасным и комфортным.

Вот только одно люди упустили (то ли случайно, то ли

преднамеренно): все их 3 закона были полностью шовинистическими,

дискриминационными и расистскими, ведь в «человеческую программу» никто не

закладывал запретов относительно убийства или причинения вреда роботу, а вот

разумной машине почему-то это было строго-настрого запрещено.

Конец эпохи расистских законов робототехники

В процессе эволюции люди собственноручно законы Азимова

уничтожили. Началось все со второго постулата несколько десятилетий назад:

именно тогда люди стали создавать и использовать дроны, способные с воздуха

приносить вред и убивать других людей по человеческому приказу. И все это

И все это

прошло как-то незаметно для человечества. Типа, ну убивают люди с помощью

роботов и пусть убивают. Какая разница – дроном или топором? Однако это много

чего изменило не только в стратегии ведения войн, но и в самом понятии убийства

человека.

Что же человечество получило в результате? Совсем новый «безопасный» метод умерщвления другого человека, ведь убийца, по сути, ничем не

рискует. И это, если честно, весьма сильно шокирует. Веками воины, собираясь

идти убивать врага на поле боя, рисковали и самим быть убитыми. И это добавляло

эдакого благородства и героизма. Теперь же все кардинально поменялось. Да,

оставшиеся в живых после атаки дронов в теории могут найти оператора боевого

робота, а после наказать его или же лишить жизни. Однако это будет уже

восприниматься, не как честная месть, а как покушение на мирного жителя, чистой

воды криминал или терроризм.

Итог и эпилог

И вот весной 2020 года был упразднен и I закон

робототехники, причем человечество отнеслось к этому с абсолютным спокойствием, хотя, по сути, произошел глобальный перелом в истории, смена целых эпох. Итак, роботы начали убивать людей самостоятельно, без приказа других людей, по своей

Итак, роботы начали убивать людей самостоятельно, без приказа других людей, по своей

собственной инициативе, практически выверено, осмысленно и разумно. А ведь по

сути человечество оказалось на верной дороге к своей гибели, а планета Земля –

к смене на ней господствующего вида разумных существ.

Вот так может закончиться история человеческой цивилизации в

Солнечной системе. Одни разумные существа уничтожат других, чтобы таким образом

продолжить эволюцию, так что вполне возможно, что в скором будущем homo sapiens

смогут прочувствовать на своей шкуре, каково оно было в свое время мамонтам или

неандертальцам, кстати, уничтоженным в процессе эволюции и во имя ее самим же

человечеством.

Справка: Робот (чеш. robot, от robota — «подневольный труд») — автоматическое устройство, предназначенное для осуществления различного рода механических операций, которое действует по заранее заложенной программе.

Робот обычно получает информацию о состоянии окружающего пространства посредством датчиков (технических аналогов органов чувств живых организмов). Робот может самостоятельно осуществлять производственные и иные операции, частично или полностью заменяя труд человека.

Робот может самостоятельно осуществлять производственные и иные операции, частично или полностью заменяя труд человека.

При этом робот может как иметь связь с оператором,

получая от него команды (ручное управление), так и действовать

автономно, в соответствии с заложенной программой (автоматическое

управление).

Напомним, впервые в истории: боевой дрон самостоятельно ликвидировал военного.

А в Украине впервые ребенка прооперировал робот-хирург Da Vinci: девочку больше не беспокоят боли — детали.

Ранее робот «Федор» «разгерметизировал» МКС – в Роскосмосе сделали заявление.

Автор:

Диалог.UA

Увлекательная история трех законов робототехники Азимова

Большинство из нас слышали об Айзеке Азимове и знают, что он был одним из величайших писателей-фантастов нашего времени. Он написал такие классические произведения, как «Я», «Робот» и «Трилогия об основании», чтобы назвать некоторые из своих наиболее известных работ. И хотя это произведения художественной литературы, именно рассказ Азимова «Обход», опубликованный в 1942 году, породил то, что сейчас известно как «Законы робототехники» Азимова. Это три непреложных, неопровержимых закона, по которым должны жить все роботы повсюду. И если они нарушат их, они должны понести последствия, как и любой человек, нарушивший закон страны. Вы помните законы? Их:

И хотя это произведения художественной литературы, именно рассказ Азимова «Обход», опубликованный в 1942 году, породил то, что сейчас известно как «Законы робототехники» Азимова. Это три непреложных, неопровержимых закона, по которым должны жить все роботы повсюду. И если они нарушат их, они должны понести последствия, как и любой человек, нарушивший закон страны. Вы помните законы? Их:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

- Робот должен подчиняться приказам, отданным ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону.

- Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму закону.

Происхождение этих законов почти так же увлекательно, как и истории, которые они породили. Большинство из нас знает, кто такой Айзек Азимов, но знаете ли вы Джона У. Кэмпбелла? Кэмпбелл в начале 2099 г.0013-го -го века, один из самых влиятельных писателей-фантастов и издателей того времени, и они с Азимовым были близкими друзьями. На самом деле Азимов назвал его «самой могущественной силой в научной фантастике, и в течение первых десяти лет своего редакторства он полностью доминировал в этой области».

На самом деле Азимов назвал его «самой могущественной силой в научной фантастике, и в течение первых десяти лет своего редакторства он полностью доминировал в этой области».

У Джона Кэмпбелла было очень своеобразное мировоззрение. По его мнению, человечество стояло на пороге стремительного роста технологий. Такие вещи, как компьютеры, мобильные телефоны, дроны и даже космические путешествия, были в центре его внимания. Кэмпбелл был ненасытным читателем и красноречивым оратором, который был известен тем, что высказывал свое мнение, временами сильно и радикально. Фактически, из-за его уникального видения будущего многое из того, что мы сегодня знаем как нормальное, было для Кэмпбелла правдоподобным будущим, которого человечество достигнет, но только с помощью науки.

Поскольку Кэмпбелл был издателем, в свое время он подготовил и обучил многих потенциальных авторов научной фантастики. Он поставил им два требования. Во-первых, наука должна была быть разумной и правдоподобной, а писатели должны были понимать людей. Для многих писателей-фантастов это сочетание было слишком сложным, и Кэмпбелл часто отвергал их рассказы. На самом деле, он отверг так много писателей, что было слышно, как они язвительно отзывались о том, что с Кэмпбеллом дела обстоят так же плохо, как и во времена Голливуда, когда немое кино уступило место звуковому кино.

Для многих писателей-фантастов это сочетание было слишком сложным, и Кэмпбелл часто отвергал их рассказы. На самом деле, он отверг так много писателей, что было слышно, как они язвительно отзывались о том, что с Кэмпбеллом дела обстоят так же плохо, как и во времена Голливуда, когда немое кино уступило место звуковому кино.

Азимов был одной из величайших находок Кэмпбелла как редактора, и они быстро подружились. Азимов вспоминает, что 23 декабря 1940 года он и Кэмпбелл беседовали об одном из рассказов Азимова «Робби» и говорили о том, должен ли робот жить по человеческим законам. Именно во время разговора Азимов взялся за перо и написал, что будет тремя законами робототехники. Позже Азимов рассказывал, что это была одна из самых захватывающих ночей в его жизни. Что касается Кэмпбелла, мы можем только предполагать, но он заявил, что знал, что у Азимова внутри все время были законы, он просто помогал их вытаскивать наружу. Учитывая дерзость Кэмпбелла, в это заявление нетрудно поверить.

Однако по мере развития их профессиональных отношений Кэмпбелл и Азимов разошлись. Кэмпбелл становился все более и более откровенным и возмутительным, что приводило его к разногласиям с Азимовым. Через некоторое время они почти не разговаривали, хотя Азимов по-прежнему хорошо отзывался о Кэмпбелле на публике. В частном порядке не так сильно.

Входит Рэндалл Гаррет. Гаррет был писателем-фантастом, как и Азимов, рассказы которого также публиковались Кэмпбеллом. Гаррет утверждает, что у Азимова и у него были симбиотические отношения, которые привели к созданию трех законов. Какова природа этих отношений, так и не было ясно сказано, но достаточно сказать, что сам Азимов с энтузиазмом воспринял идею о том, что Гаррет был вдохновителем законов. Было ли это сделано назло Кэмпбеллу или в каком-то отношении это действительно так, неизвестно. Тем не менее, вдохновение Азимова было очевидным. Два человека, столпы его жизни, послужили генезисом для того, что может быть самым важным набором научных правил, когда-либо созданных.

Итак, теперь, когда вы знаете, что вы думаете о трех законах? Напишите нам в комментариях, а затем посмотрите на кучу дронов, роботов и дроидов, демонстрирующихся в эти выходные во время нашего фестиваля дронов и дроидов. Получить билеты здесь.

Нам нужны этичные роботы. Законы Азимова — хороший способ начать

Мир приближается к тому времени, когда роботы в нашей повседневной жизни будут принимать решения о том, как действовать. Какие указания мы должны дать им?

Поскольку роботы все больше интегрируются в общество, мы должны быть уверены, что они будут хорошо себя вести среди нас. В 1942, писатель-фантаст Айзек Азимов попытался изложить философскую и моральную основу для того, чтобы роботы служили человечеству и чтобы они не стали разрушительными повелителями. Эти усилия привели к тому, что стало известно как Три закона робототехники Азимова:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

- Робот должен подчиняться приказам, отданным ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону.

- Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму Закону.

Сегодня, более чем через 70 лет после первой попытки Азимова, у нас гораздо больше опыта работы с роботами, в том числе с тем, чтобы они возили нас, по крайней мере, в хороших условиях. Мы приближаемся к тому времени, когда роботы в нашей повседневной жизни будут принимать решения о том, как действовать. Достаточно ли хороши три закона Азимова, чтобы управлять поведением роботов в нашем обществе, или нам следует найти способы их улучшить?

Азимов знал, что они несовершенны

(Ровена Моррилл/GFDL, CC BY-SA) Рассказы Азимова «Я, робот» исследуют ряд непредвиденных последствий и явных нарушений Трех законов. В этих ранних рассказах Три закона рассматриваются как силы с различной силой, которые могут иметь непреднамеренное равновесное поведение, как в рассказах «Обход» и «Поймай этого кролика», для решения которых требуется человеческая изобретательность. В рассказе «Лжец!» робот-телепат, движимый Первым законом, говорит людям то, что они хотят услышать, не предвидя большего вреда, который наступит, когда правда выйдет наружу. Робопсихолог Сьюзан Кэлвин заставляет его столкнуться с этой дилеммой, разрушая его позитронный мозг.

В этих ранних рассказах Три закона рассматриваются как силы с различной силой, которые могут иметь непреднамеренное равновесное поведение, как в рассказах «Обход» и «Поймай этого кролика», для решения которых требуется человеческая изобретательность. В рассказе «Лжец!» робот-телепат, движимый Первым законом, говорит людям то, что они хотят услышать, не предвидя большего вреда, который наступит, когда правда выйдет наружу. Робопсихолог Сьюзан Кэлвин заставляет его столкнуться с этой дилеммой, разрушая его позитронный мозг.

В «Побеге!» Сьюзан Кэлвин ослабляет силу Первого закона настолько, чтобы позволить сверхразумному роботу разработать метод межзвездной транспортировки со скоростью, превышающей скорость света, даже если это приводит к гибели (но только временной!) человеческие пилоты. В «Неизбежном конфликте» машины, контролирующие мировую экономику, интерпретируют Первый закон как защиту всего человечества, а не только отдельных людей. Это предвещает более позднее введение Азимовым «Закона Нуля», который может заменить первоначальные три, потенциально позволяя роботу причинять вред человеку для всеобщего блага человечества.

0. Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечество причинило вред.

Роботы без этики

Разумно опасаться, что без этических ограничений роботы (или другие искусственные интеллекты) могут причинить большой вред, возможно, всему человечеству, даже просто следуя данным им инструкциям человека.

Фильм 1991 года «Терминатор 2: Судный день» начинается с известного научно-фантастического сценария: система искусственного интеллекта под названием Скайнет начинает ядерную войну и почти уничтожает человеческую расу. Развертывание Скайнета было рациональным решением (у него был «идеальный послужной список»). Скайнет «начинает учиться с геометрической скоростью», пугая своих создателей, которые пытаются его закрыть. Скайнет наносит ответный удар (как критически важная система защиты, он, несомненно, был запрограммирован на самозащиту). Скайнет находит неожиданное решение своей проблемы (путем творческого решения проблем, не ограниченного здравым смыслом или моралью).

В реальном мире имели место менее апокалиптические примеры неконтролируемого ИИ. Высокоскоростные автоматические торговые системы отреагировали на необычные условия на фондовом рынке, создав цикл положительной обратной связи, который привел к «внезапному краху». К счастью, были потеряны лишь миллиарды долларов, а не миллиарды жизней, но задействованные компьютерные системы мало или совсем не понимают разницы.

На пути к определению этики роботов

Хотя никакой простой фиксированный набор механических правил не обеспечит этичное поведение, мы можем сделать некоторые наблюдения о свойствах, которыми должна обладать морально-этическая система, чтобы позволить автономным агентам (людям, роботам и т. д.) жить вместе. Многие из этих элементов уже ожидаются от человека.

Эти свойства основаны на ряде источников, в том числе Принципах робототехники Совета по исследованиям в области инженерных и физических наук (EPSRC) и недавней работе по когнитивной науке о морали и этике, сосредоточенной на неврологии, социальной психологии, психологии развития и философии.

EPSRC считает, что роботы — это просто инструменты, за которые люди должны нести ответственность. На крайнем другом конце спектра находится опасение, что сверхразумные, сверхмощные роботы могут внезапно появиться и управлять судьбой человечества, к лучшему или к худшему. Следующий список определяет золотую середину, описывая, как будущие интеллектуальные роботы должны учиться, как это делают дети, как вести себя в соответствии со стандартами нашего общества.

- Если роботы (и другие ИИ) все больше будут участвовать в жизни нашего общества, им придется следовать моральным и этическим правилам так же, как и людям. Некоторые правила воплощены в законах против убийства, воровства, лжи и вождения по неправильной стороне улицы. Другие менее формальны, но, тем не менее, важны, например, помощь и сотрудничество, когда появляется возможность.

- В некоторых ситуациях требуется быстрое моральное суждение и реагирование, например, ребенок попадает в пробку или возможность положить в карман упавший бумажник.

Простые правила могут обеспечить автоматический ответ в режиме реального времени, когда нет времени на обдумывание и анализ затрат и результатов. (Когда-нибудь роботы могут достичь интеллекта человеческого уровня, действуя намного быстрее, чем человеческое мышление, что позволит тщательно обдумывать все за миллисекунды, но этот день еще не настал, и он может быть в далеком будущем.)

Простые правила могут обеспечить автоматический ответ в режиме реального времени, когда нет времени на обдумывание и анализ затрат и результатов. (Когда-нибудь роботы могут достичь интеллекта человеческого уровня, действуя намного быстрее, чем человеческое мышление, что позволит тщательно обдумывать все за миллисекунды, но этот день еще не настал, и он может быть в далеком будущем.) - Быстрый ответ не всегда может быть правильным, что может быть признано после отзывов других или тщательного личного размышления. Следовательно, агент должен иметь возможность учиться на собственном опыте, включая обратную связь и обсуждение, что приводит к новым и улучшенным правилам.

- Чтобы получить пользу от отзывов других членов общества, робот должен уметь объяснять и обосновывать свои решения об этических действиях, а также понимать объяснения и критические замечания других.

- Учитывая, что искусственный интеллект учится на своих ошибках, мы должны очень осторожно подходить к тому, какую силу мы ему даем.

Мы, люди, должны убедиться, что он пережил достаточное количество ситуаций и удовлетворил нас своими ответами, заслужив наше доверие. Критическая ошибка, допущенная людьми со Скайнетом в «Терминаторе 2», заключалась в передаче контроля над ядерным арсеналом.

Мы, люди, должны убедиться, что он пережил достаточное количество ситуаций и удовлетворил нас своими ответами, заслужив наше доверие. Критическая ошибка, допущенная людьми со Скайнетом в «Терминаторе 2», заключалась в передаче контроля над ядерным арсеналом. - Робот должен заслужить доверие и надежность. Доверие завоевывается медленно, благодаря большому опыту, но может быть быстро потеряно из-за одного неверного решения.

- Как и в случае с человеком, каждый раз, когда робот действует, выбор этого действия в данной ситуации посылает остальной части общества сигнал о том, как этот агент принимает решения и, следовательно, насколько он заслуживает доверия.

- Разум робота — это программное обеспечение, для которого можно создать резервную копию, восстановить в случае повреждения или уничтожения оригинала или продублировать его в другом теле. Если роботы определенного вида являются точными копиями друг друга, то доверие можно не заслуживать по отдельности.

Все они ориентированы на долгосрочную перспективу и будут иметь существенное значение в будущих в исследованиях, даже если сегодня кажутся незначительными:

Все они ориентированы на долгосрочную перспективу и будут иметь существенное значение в будущих в исследованиях, даже если сегодня кажутся незначительными:

Простые правила могут обеспечить автоматический ответ в режиме реального времени, когда нет времени на обдумывание и анализ затрат и результатов. (Когда-нибудь роботы могут достичь интеллекта человеческого уровня, действуя намного быстрее, чем человеческое мышление, что позволит тщательно обдумывать все за миллисекунды, но этот день еще не настал, и он может быть в далеком будущем.)

Простые правила могут обеспечить автоматический ответ в режиме реального времени, когда нет времени на обдумывание и анализ затрат и результатов. (Когда-нибудь роботы могут достичь интеллекта человеческого уровня, действуя намного быстрее, чем человеческое мышление, что позволит тщательно обдумывать все за миллисекунды, но этот день еще не настал, и он может быть в далеком будущем.) Мы, люди, должны убедиться, что он пережил достаточное количество ситуаций и удовлетворил нас своими ответами, заслужив наше доверие. Критическая ошибка, допущенная людьми со Скайнетом в «Терминаторе 2», заключалась в передаче контроля над ядерным арсеналом.

Мы, люди, должны убедиться, что он пережил достаточное количество ситуаций и удовлетворил нас своими ответами, заслужив наше доверие. Критическая ошибка, допущенная людьми со Скайнетом в «Терминаторе 2», заключалась в передаче контроля над ядерным арсеналом.