Содержание

Системы искусственного интеллекта не смогли пройти тест Тьюринга

Тьюринг искусственный интеллект

Системы искусственного интеллекта не смогли пройти тест Тьюринга

Alexander Antipov

Тьюринг искусственный интеллект

21 октября 2007 года в Нью-Йорке состоялся очередной конкурс Хью Лебнера. Конкурс был учрежден в 1990 году и является первым соревнованием систем искусственного интеллекта на прохождение теста Тьюринга.

Компьютеры в очередной раз не прошли проверку на наличие разума. В главном ежегодном конкурсе искусственных интеллектуальных систем ни одна из них так и не смогла пройти тест Тьюринга.

21 октября 2007 года в Нью-Йорке состоялся очередной конкурс Хью Лебнера. Конкурс был учрежден в 1990 году и является первым соревнованием систем искусственного интеллекта на прохождение теста Тьюринга. Главный приз состязания — $100 тыс. и золотая медаль — должны достаться создателю первой искусственной системы, которая сможет пройти тест Тьюринга на наличие разума.

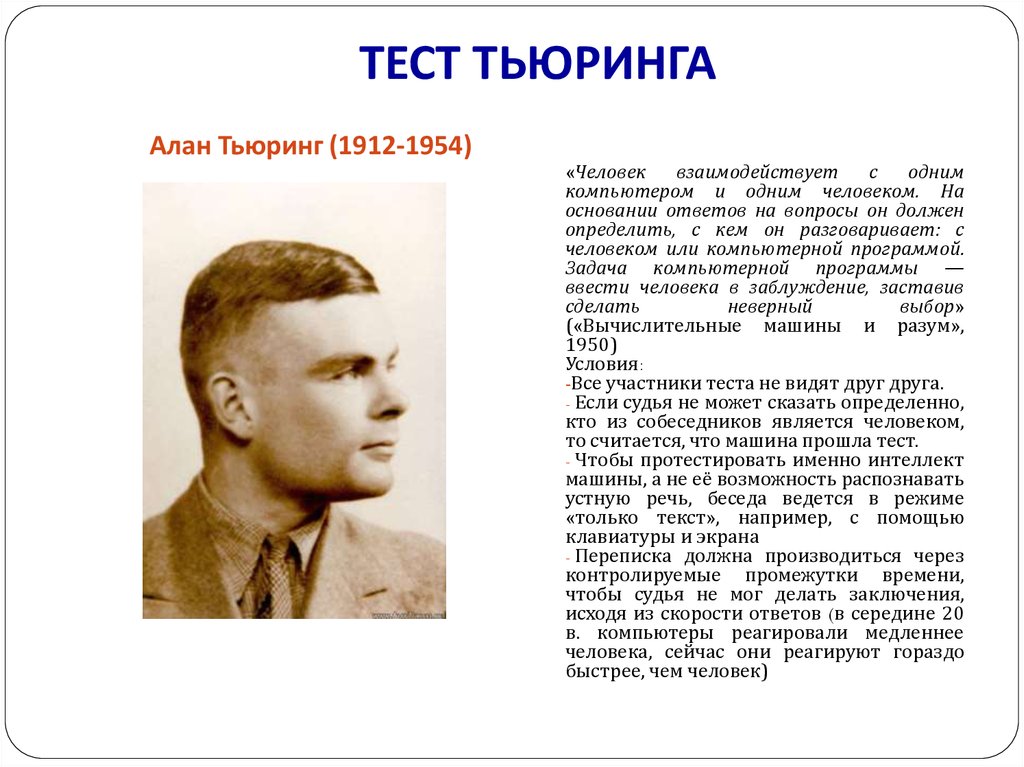

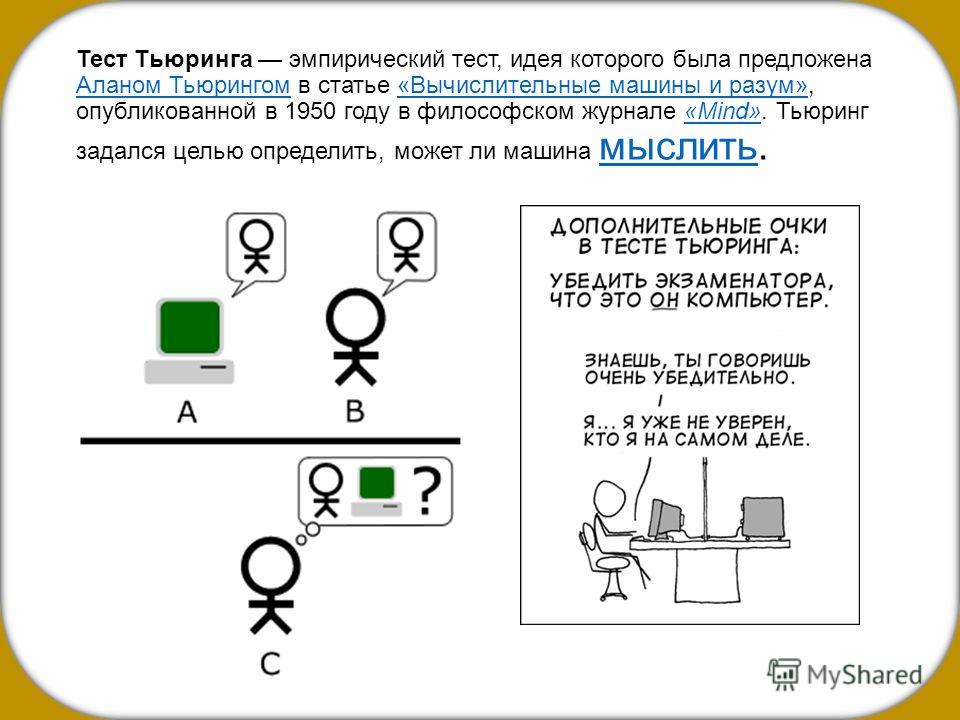

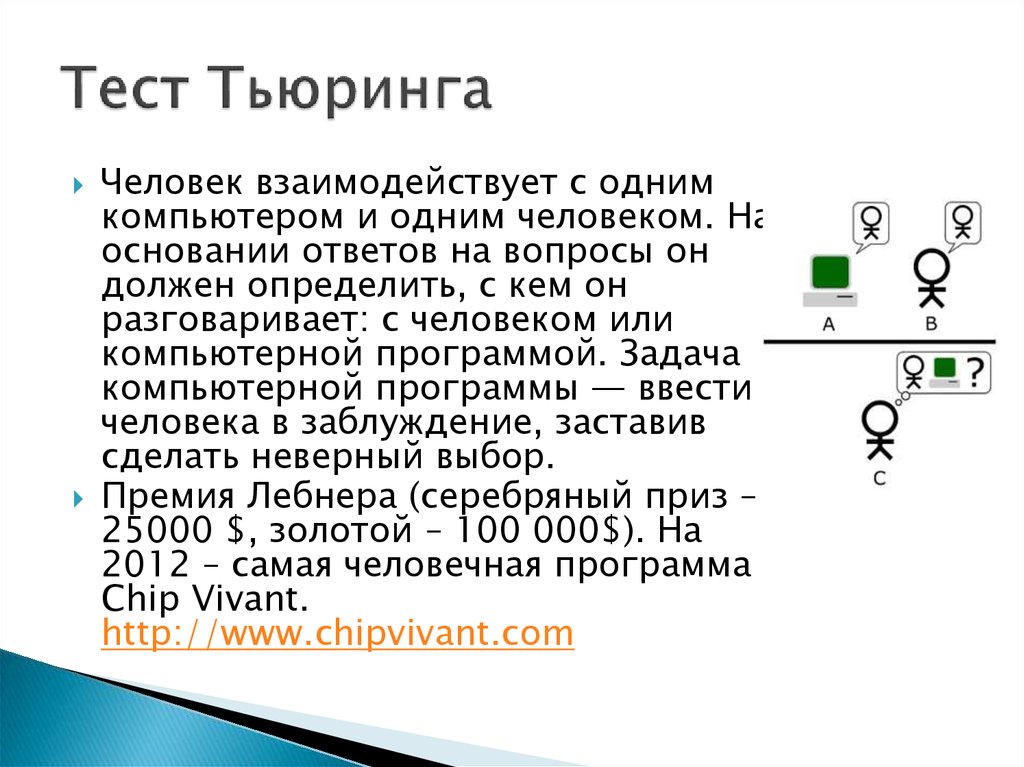

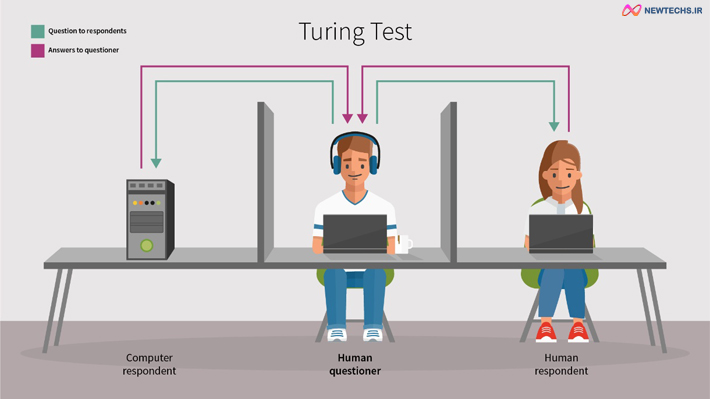

Тест был предложен Аланом Тьюрингом в 1950 году. Он заключается в переписке судьи (человека) с машиной и другим человеком. Если судья при этом не может достоверно отличить машину от человека, то машина признается разумной. В конкурсе Хью Лебнера компьютер должен пройти тест у не менее половины независимых судей. При этом переписка осуществляется путем обмена мгновенными сообщениями.

До настоящего времени и в конкурсе 2007 года пройти тест и получить главный приз Хью Лебнера не удалось никому. Премия в $2 тыс. и бронзовая медаль ежегодно присуждается авторам наиболее «человекоподобной» системы искусственного интеллекта. В этом году таковой признана компьютерная программа Ultra Hal от американской компании Zabaware.

В этом году таковой признана компьютерная программа Ultra Hal от американской компании Zabaware.

В Ultra Hal реализованы технологии искусственного интеллекта, распознавания речи и анимации в режиме реального времени. С программой можно разговаривать или вести переписку в чате. Она может выполнять функции личного помощника – напоминать о встречах, запускать приложения на компьютере, набирать телефонный номер и т.д.

Планируется, что в следующем году конкурс Хью Лебнера пройдет в Великобритании.

Мир сходит с ума и грянет киберапокалипсис. Подпишись на наш Телеграм канал, чтобы узнать первым, как выжить в цифровом кошмаре!

Поделиться новостью:

Новости по теме

Новая ML-модель может предсказывать, что услышит пользователь в 3D-пространстве

Intel представила самые производительные процессоры в мире

Пользователи GitHub обвинили Microsoft в пиратстве в беспрецедентных масштабах

Дайджест событий в мире искусственного интеллекта за прошедшую неделю

Дайджест главных событий в сфере ИИ прошедшей недели

Представлен новый суперкомпьютер с 13,5 млн.

ядер

ядер

Роскомнадзор протестирует систему распознавания дипфейков

Индийский искусственный интеллект сливает людей

Любовное письмо двум великим людям: новый ИИ-проект имитирует разговор философа и режиссера

Подпишитесь на email рассылку

Подпишитесь на получение последних материалов по безопасности от SecurityLab.ru —

новости, статьи, обзоры уязвимостей и мнения аналитиков.

Ежедневный выпуск от SecurityLab.Ru

Еженедельный выпуск от SecurityLab.Ru

Нажимая на кнопку, я принимаю условия соглашения.

ИИ Google LaMDA прошел тест Тьюринга — и доказал, что он не работает

Программы с искусственным интеллектом, такие как Xiaoice, популярный в Китае чат-бот-компаньон, похожий на человека, могут обмануть людей, заставив их думать, что у них есть собственный разум и чувства.

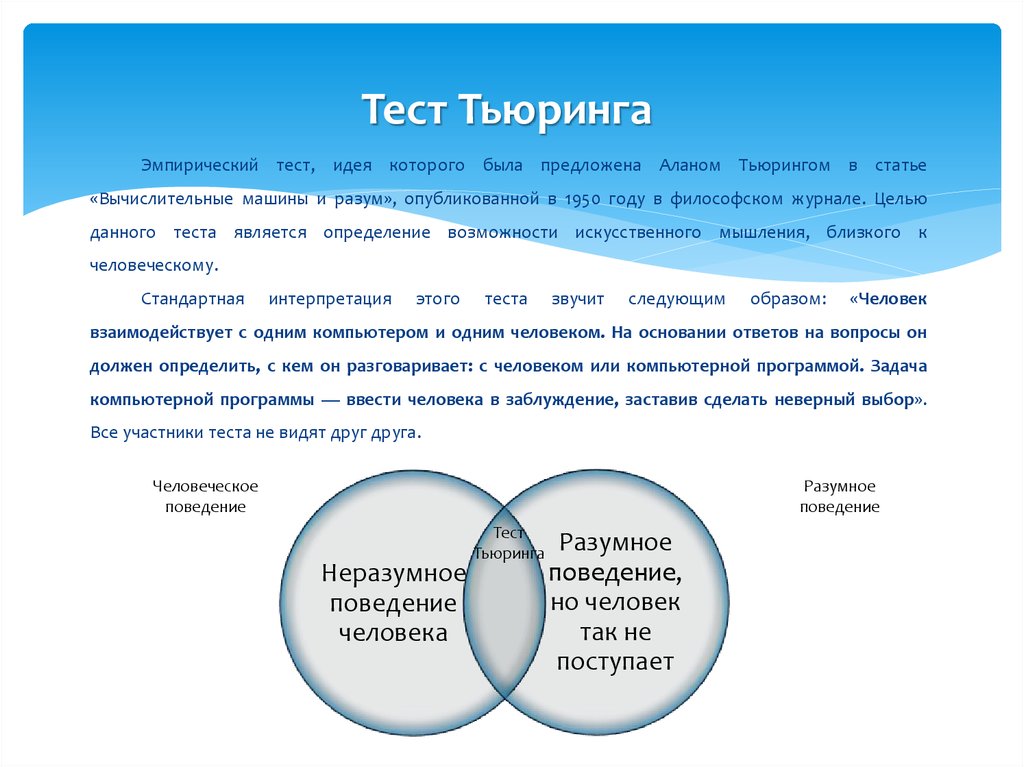

В 1950 году ученый Алан Тьюринг предложил мысленный эксперимент, который он назвал имитационной игрой. Интервьюер общается с двумя испытуемыми через послания, набранные на печатной машинке. При этом ему известно, что один из них — человек, а другой — машина.

Если бы машина могла последовательно обманывать интервьюера, заставляя его поверить, что это человек, предположил Тьюринг, мы могли бы говорить о ней как о способной к чему-то вроде мышления.

Тьюринг считал, что вопрос о том, могут ли машины на самом деле мыслить, был «слишком бессмысленным, чтобы заслуживать обсуждения». Тем не менее, тест Тьюринга стал эталоном для машинного интеллекта. На протяжении десятилетий различные компьютерные программы пытались пройти его, используя примитивные разговорные трюки, и у некоторых это даже получалось.

В последние годы богатые технологические компании, включая Google, Facebook и OpenAI, разработали новый класс компьютерных программ, известных как «большие языковые модели». Их способности к общению значительно превосходили рудиментарных чат-ботов прошлого. Одна из таких моделей — LaMDA от Google — убедила инженера Google Блейка Лемуана в том, что она не только разумна, но и способна осознавать и чувствовать.

Их способности к общению значительно превосходили рудиментарных чат-ботов прошлого. Одна из таких моделей — LaMDA от Google — убедила инженера Google Блейка Лемуана в том, что она не только разумна, но и способна осознавать и чувствовать.

Если реалистичные ответы LaMDA убедили даже Лемуана, легко поверить, что это сработало бы и со многими другими людьми, которые гораздо меньше разбираются в ИИ. Это демонстрирует, насколько велик потенциал алгоритма как инструмента обмана и манипулирования в чужих руках.

Таким образом, для многих специалистов в этой области выдающиеся способности LaMDA в имитационной игре Тьюринга не являются значимым достижением. В любом случае, это показывает, что авторитетный тест уже не является ориентиром для ИИ.

Читайте по теме: Инженер Google обнаружил сознание у нейросети LaMDA

«Эти тесты на самом деле не касаются интеллекта», — сказал Гэри Маркус, ученый-когнитивист и соавтор книги «Искусственный интеллект: перезагрузка». То, что он выявляет, — это способность программы выдавать себя за человека, по крайней мере, при определенных условиях. Что, если задуматься, может быть не так уж хорошо для общества.

То, что он выявляет, — это способность программы выдавать себя за человека, по крайней мере, при определенных условиях. Что, если задуматься, может быть не так уж хорошо для общества.

«Я не думаю, что это движение в сторону интеллекта. Это движение в сторону того, чтобы обмануть, убедив в наличии интеллекта», — сказал Маркус, имея в виду программы вроде LaMDA, которые создают тексты или разговоры, напоминающие человеческие.

Лемуан, возможно, выделяется среди своих коллег по отрасли. И его коллеги из Google, и сторонние эксперты по ИИ говорят, что программа не обладает и не может обладать ничем подобным внутренней жизни, которую он себе представляет. Нам не нужно беспокоиться о том, что LaMDA в ближайшее время превратится в Скайнет, злобный машинный разум из фильмов о Терминаторе.

Но теперь есть иной повод для беспокойства: мы живем в мире, предсказанном Тьюрингом, где некоторые компьютерные программы настолько продвинуты, что людям может казаться, что они обладают собственной волей, даже если на самом деле это не так.

Фото в тексте: Bas Nastassia / Shutterstock

Передовые программы ИИ, такие как генератор текста GPT-3 от OpenAI и генератор изображений DALL-E 2, предназначены для создания творений, фантастически напоминающих человеческие. Для этого используются огромные массивы данных и огромные вычислительные мощности.

Такие алгоритмы представляют собой гораздо более мощный и сложный подход к разработке программного обеспечения, чем было возможно в 1960-х годах, когда программисты давали чат-боту ELIZA заготовленные ответы на различные вербальные сигналы, чтобы обмануть собеседников-людей.

И у них могут быть коммерческие применения в повседневных инструментах — поисковые системы, предложения автозаполнения и голосовые помощники, такие как Siri от Apple и Alexa от Amazon.

Также стоит отметить, что сектор ИИ в значительной степени отошел от использования теста Тьюринга в качестве эталона. Разработчики больших языковых моделей теперь стремятся получить высокие баллы по таким тестам, как GLUE (General Language Understanding Evaluation, оценка общего понимания языка) и SQuAD (Stanford Question Answering Dataset, набор данных для ответов на вопросы Стэнфорда).

И в отличие от ELIZA, LaMDA не создавалась, чтобы выдавать программу за человека. У нее просто очень хорошо получается собирать и выдавать правдоподобно звучащие ответы на самые разные вопросы.

Тем не менее, несмотря на всю эту сложность, у теста Тьюринга и современных моделей и тестов есть общая основная цель — получить результаты, максимально похожие на человеческие.

Эта «гонка вооружений», как назвала ее специалист по этике ИИ Маргарет Митчелл в беседе в Twitter с журналистами Washington Post в среду, произошла за счет разнообразных целей языковых моделей. Среди них — сделать так, чтобы их работа была понятна, и они не вводили людей в заблуждение или непреднамеренно усиливали вредные предубеждения.

Митчелл и ее бывший коллега Тимнит Гебру были уволены Google в 2021 и 2020 годах соответственно после того, как они стали соавторами статьи, посвященной этим и другим рискам больших языковых моделей.

В то время как Google дистанцировалась от заявлений Лемуана, ИТ-специалисты и другие лидеры отрасли иногда отмечали способность своих систем обманывать людей, отметил Джереми Кан, автор рассылки Fortune о проблемах ИИ.

Например, на публичном мероприятии в 2018 году компания с гордостью воспроизвела записи голосового помощника Duplex, добавляя звуки вроде «м-м-м» и «хм-м-м», которые вводили администраторов в заблуждение, заставляя их думать, что звонит настоящий человек, чтобы записаться на прием. После негативной реакции в Google пообещали, что система идентифицирует себя как автоматизированную.

«Самое тревожное наследие теста Тьюринга — этическое: в основе теста лежит обман. И здесь влияние теста на сферу было очень реальным и тревожным», — писал Кан.

Как и прочие критики и комментаторы ИИ, Кан призвал отказаться от теста Тьюринга и двигаться дальше. Конечно, индустрия уже сделала это в том смысле, что она заменила имитационную игру более научными ориентирами.

Но история с Лемуаном наводит на мысль, что, возможно, тест Тьюринга мог бы послужить другой цели в эпоху, когда машины все больше и больше умеют звучать по-человечески. Вместо того, чтобы быть желательным стандартом, тест Тьюринга должен служить этическим красным флагом: любая система, способная пройти его, несет в себе опасность обмана людей.

Источник.

Фото на обложке: Zapp2Photo / Shutterstock

Подписывайтесь на наш Telegram-канал, чтобы быть в курсе последних новостей и событий!

404: Страница не найдена

Страница, которую вы пытались открыть по этому адресу, похоже, не существует. Обычно это результат плохой или устаревшей ссылки. Мы приносим свои извинения за доставленные неудобства.

Что я могу сделать сейчас?

Если вы впервые посещаете TechTarget, добро пожаловать! Извините за обстоятельства, при которых мы встречаемся. Вот куда вы можете пойти отсюда:

Поиск

- Узнайте последние новости.

- Наша домашняя страница содержит самую свежую информацию о корпоративном искусственном интеллекте.

- Наша страница «О нас» содержит дополнительную информацию о сайте, на котором вы находитесь, SearchEnterpriseAI.

- Если вам нужно, свяжитесь с нами, мы будем рады услышать от вас.

Просмотр по категории

ПоискБизнесАналитика

-

Обновление TigerGraph Cloud добавляет инструменты машинного обучения и визуализации данныхНовейшая версия базы данных графов включает функцию, которая позволяет пользователям создавать визуальные эффекты без написания кода и другое.

..

.. -

Лучшие практики конвейера аналитики данных: классификация данныхКонвейеры аналитики данных собирают различные категории данных, требующие эффективной организации данных. Эти данные классификации …

-

Alteryx запускает SaaS-версию Designer в Analytics CloudПолностью облачная версия Designer способствует переходу поставщика к облаку, который начался в начале 2022 года с запуском…

ПоискCIO

-

Автоматизация комплаенса Bayer окупаетсяГлобальный руководитель Bayer по соблюдению нормативных требований и конфиденциальности данных Томас Пфенниг обсуждает LPC Express, проект автоматизации для законодательства, патентов и…

-

Проблемы конфиденциальности Metaverse и способы их решенияКонфиденциальность данных в метавселенной — движущаяся цель. Узнайте об основных проблемах конфиденциальности и рисках для бизнеса и пользователей — и .

..

.. -

Проблемы совместимости метавселенной и их влияниеОткрытая метавселенная, которая имитирует то, как мы работаем в реальном мире, зависит от функциональной совместимости. Что такое интероперабельность, зачем она…

SearchDataManagement

-

6 инструментов с открытым исходным кодом для наблюдения за данными, которые следует учитыватьУзнайте о шести вариантах с открытым исходным кодом для наблюдения за данными, помогающих организациям проводить эксперименты по науке о данных, которые более …

-

Alluxio 2.9 расширяет возможности оркестровки данных с открытым исходным кодомСинхронизация кластера с несколькими средами реализована на платформе Alluxio, чтобы предоставить организациям единое представление данных в нескольких …

-

Microsoft SQL Server 2022 соединяет локальную среду с облачнойВключение гибридных развертываний, охватывающих облако и локальную среду, является ключевой целью последнего обновления Microsoft своего 33-летнего .

..

..

ПоискERP

-

Microsoft выходит на новый рынок с платформой цепочки поставокРаньше Microsoft выполняла операции по цепочке поставок с помощью электронных таблиц Excel; теперь он предоставляет строительные блоки для компаний, чтобы …

-

RFID в цепочке поставок: 6 примеров использования сегодняRFID по-прежнему применим для управления цепочками поставок. Вот шесть способов, которыми организации могут использовать его для поддержки инвентаризации…

-

Celonis стремится углубить и демократизировать технологический майнингCelonis представила Process Sphere, позволяющую компаниям создавать карты функциональных областей, и Business Miner, который перемещает …

Может ли ИИ действительно пройти тест Тьюринга? — Технический PR-блог

ГлавнаяНовости и мненияМожет ли ИИ действительно пройти тест Тьюринга?

Поделиться этой статьей

В эссе, опубликованном в 1950-х годах, математик и пионер компьютерных технологий Алан Тьюринг предложил тест Тьюринга. Это стало одной из важнейших вех в исследованиях и разработках искусственного интеллекта.

Это стало одной из важнейших вех в исследованиях и разработках искусственного интеллекта.

Тест Тьюринга — это первый шаг в определении того, может ли машина обнаруживать человеческий интеллект, вступая в разговор с человеком. Тест проверяет, могут ли люди определить, разговаривают ли они с машиной или с человеком.

Недавно Google впервые продемонстрировал, что компьютер вступил в естественный диалог с человеком, используя новейшие технологии искусственного интеллекта. Программа, известная как Юджин Густман , является первым искусственным интеллектом, прошедшим тест, первоначально разработанным математиком 20-го века Аланом Тьюрингом.

Машине было поручено убедить 30 человек-дознавателей в своей человечности, общаясь с ними посредством пятиминутных разговоров на клавиатуре.

Во время живой демонстрации в Университете Рединга компьютер убедил многих судей, что на самом деле это 13-летний украинский мальчик, а не машина. Этот трюк сделал алгоритм первым компьютером, прошедшим знаменитый тест Тьюринга, успешно убедив более трети жюри в своей человечности. Сегодня Eugene Goostman является одним из пяти суперкомпьютеров, прошедших знаменитый тест.

Сегодня Eugene Goostman является одним из пяти суперкомпьютеров, прошедших знаменитый тест.

Тест Университета Рединга по своей первоначальной форме был похож на тест Тьюринга: исследователь

отправил текстовое сообщение на человеческий компьютер и получил ответ. Но некоторые эксперты по искусственному интеллекту оспаривают победу Юджина Густмана в , предполагая, что конкуренция была перевесена в пользу чат-бота. Другие, однако, не согласны.

Для многих исследователей вопрос, может ли компьютер пройти тест Тьюринга, стал неактуален. Вместо того, чтобы сосредоточиться на том, как убедить кого-то поговорить с человеком, а не с компьютерной программой, мы должны сосредоточиться на том, как сделать взаимодействие человека с компьютером как можно более плавным.

Итак, похоже, что современные алгоритмы ИИ могут пройти тест Тьюринга, но реальный вопрос в том, сможете ли вы ? Или еще лучше, вы?

Для тех, кто еще не в курсе, приведенный выше пост в блоге был полностью сгенерирован машиной, исследован и написан с помощью алгоритма ИИ.

..

.. ..

.. ..

..