Содержание

Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред. Про кино на Business FM — Business FM

Этот первый закон роботехники, сформулированный писателем фантастом Айзеком Азимовым, слышал думаю уже наверное каждый.

Андроиды, созданные человеком по мнению большинства должны взять на себя львиную долю ответственности, человеческих обязанностей и даже порою пороков. Какими будут эти создания? Может, мы совершенно зря пытаемся изобрести синтетический разум и наделить им машины? Чем обернется для нас такое необычное соседство? Искусственный разум и человек — излюбленная тема отраженная в кинематографе. И часто под напичканным спецэффектами сюжетом замаскированы глубокие философские размышления. Но философски в данном случае не всегда значит скучно.

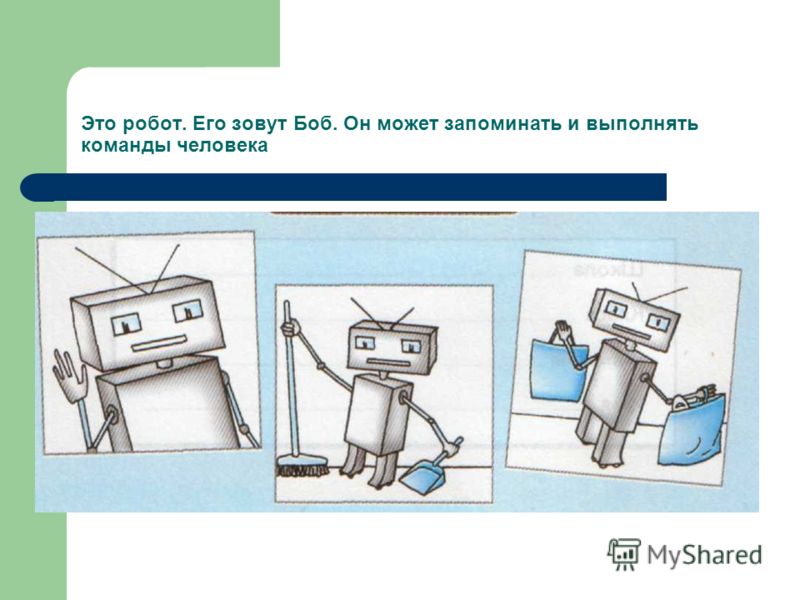

Безусловно мы все были были растроганы до слез судьбой мальчика-андроида по имени Дэвид из научно-фантастического фильма «Искусственный разум». Еще с одним таким же милым и забавным роботом любознательным и жадным до знаний мы знакомимся в фильме «Робот по имени Чаппи». Можно бесконечно продолжать тему искусственного интеллекта, напоминая про такие фильмы как «Из машины» с обворожительной Алисией Викандер, буквально прошлогоднюю премьеру — постапокалиптическая картина о вымирании и возрождение человечества — «Дитя робота» с Роуз Бирн и Хилари Суэнк в главных ролях. Ах да… было бы несправедливо не упомянуть один из любимейших детских советских фильмов, о котором, правда, нынешнее поколение мало что слышало… фильм про робота-электроника, внешне сделанного по подобию подростка-хулигана Сыроежкина и Робота Вертера — андроида ставший персонажем 5-серийного телевизионного художественного фильма «Гостья из будущего», снятого по повести Кира Булычева

Еще с одним таким же милым и забавным роботом любознательным и жадным до знаний мы знакомимся в фильме «Робот по имени Чаппи». Можно бесконечно продолжать тему искусственного интеллекта, напоминая про такие фильмы как «Из машины» с обворожительной Алисией Викандер, буквально прошлогоднюю премьеру — постапокалиптическая картина о вымирании и возрождение человечества — «Дитя робота» с Роуз Бирн и Хилари Суэнк в главных ролях. Ах да… было бы несправедливо не упомянуть один из любимейших детских советских фильмов, о котором, правда, нынешнее поколение мало что слышало… фильм про робота-электроника, внешне сделанного по подобию подростка-хулигана Сыроежкина и Робота Вертера — андроида ставший персонажем 5-серийного телевизионного художественного фильма «Гостья из будущего», снятого по повести Кира Булычева

В тех регионах нашей страны где кинотеатрам уже разрешили работать буквально сейчас в прокате представлена фантастическая драма «Мой создатель» — история учёного робототехника Джорджа, переживающего гибель своей жены и мечтающего вернуть ее, загрузив ее сознание в тело робота.

Уже 3 сентября зрителей канала HBO ждет новый научно-фантастический проект от создателя культовых «Чужого» и «Прометея», «Бегущего по лезвию», «Марсинанина», того самого «Ганибала» Лектора… ой, да долго могу продолжать, да и все уже догадались – конечно от Сэра Ридли Скотта… сериал «Воспитанные волками». «Воспитанные волками» — первый американский сериал, над которым Ридли Скотт поработал как режиссер.

Сериал раскрывает историю андроидов по имени Мать и Отец, которые являются суррогатным опекунами для группы человеческих детей, оставшихся без родителей . Мать и Отец были созданы для того, чтобы заново вырастить людей на новой неизвестной планете куда человечество переселилось после большой войны, уничтожившей Землю. В то время как среди колонизаторов зреет разлад на почве религиозных разногласий, андроидам предстоит узнать, что контролировать убеждения человека крайне непросто. Хотя в рекламном трейлере уже доступном в интернете нет ни единого намека на религиозную проблематику, этот пробел всецело восполняется устрашающим пересказом сказки «Три поросенка» в сопровождении кадров с изображением жестокости и зубодробительного экшена.

По сюжету, чтобы еще больше разжечь драму, в идилличный мир приходит незнакомец который и зарождает в головах детей идею о том, что… Мать на самом деле может быть пресловутым Большим плохим Волком из сказки, рассказанной детям. Роль судбоносного незнакомца досталась известному по роли Рагнара Лодброка в «Викингах» красавцу австралийцу Трэвису Фиммелу.

Автор идеи и сценарист Аарон Гузиковски сказал во время интервью, что Ридли Скотт продолжает эстетику своих предыдущих фильмов таких как Чужой и Бегущий по лезвию — он трансформирует знакомые вещи в нечто, что мы до этого никогда не видели.

Эстетика, которую Ридли Скотт вкладывает во все свои работы по кадрам и доступным трейлерам — очевидна и узнаваема, как в видении конца Земли, так и в новаторском путешествии по новой планете.

Поскольку продолжение того же фильма «Чужой -Завет» маловероятно, думаю сериал станет отличным подарком для фанатов франшизы.

Ах Ридли ах затейник. . классный думаю будет сериал. Синопсис как будто под меня написан.

. классный думаю будет сериал. Синопсис как будто под меня написан.

Будем ждать.

Новый закон для роботов: процветание человека

- Паллаб Гош,

- Научный обозреватель Би-би-си

Подпишитесь на нашу рассылку ”Контекст”: она поможет вам разобраться в событиях.

Автор фото, Getty Images

Подпись к фото,

Может ли робот нанести вред человеку?

Американский писатель-фантаст Айзек Азимов в свое время сформулировал три закона, определявшие взаимоотношения между людьми и роботами:

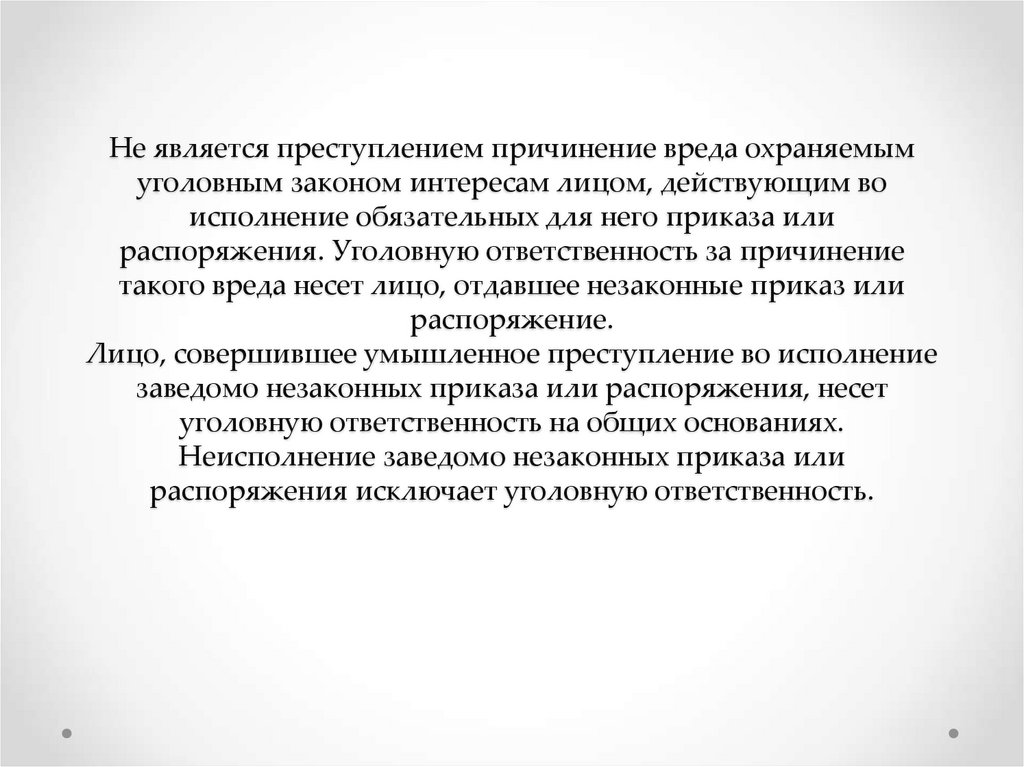

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред;

- Робот должен повиноваться всем приказам, которые дает человек, кроме случаев, когда эти приказы противоречат Первому закону;

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму законам.

Как часто случается, на наших глазам фантастика стала реальностью. В докладе, опубликованном Королевским научным обществом и Британской академией, говорится, что нет никакой нужды в трех законах робототехники, которые можно заменить одним универсальным правилом: «Человек должен преуспевать».

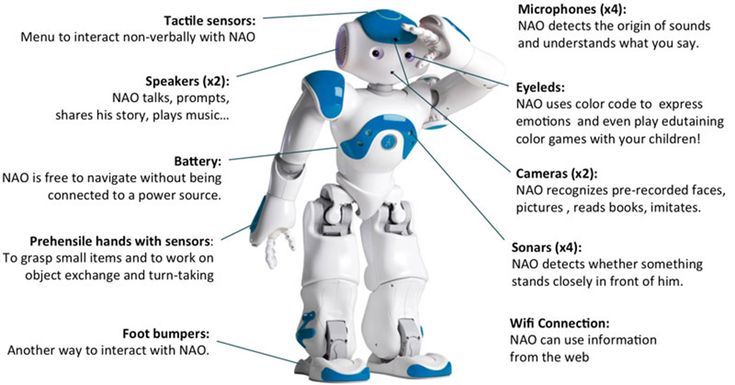

- Детские роботы с искусственным интеллектом: друзья или враги?

- Грозят ли человечеству думающие роботы?

Как говорит профессор Оттолайн Лейзер, которая является сопредседателем группы научных советников Королевского общества, принцип процветания человечества должен быть положен в основу всего управления системами искусственного интеллекта, так как он объединяет в себе все три закона.

«Принцип процветания человека и сообществ должен стать первичным, и мы полагаем, что три закона Азимова могут быть в нем объединены», — заявила она в разговоре с корреспондентом Би-би-си.

Подпись к фото,

Айзек Азимов одним из первых задумался о законах для роботов

В докладе содержится призыв к созданию новой организации, которая должна позаботиться о том, чтобы умные машины служили обществу, а не контролировали его.

В нем говорится, что для регулирования разработки самообучающихся машин необходима система демократического надзора. Без подобной системы такие машины могут причинить человечеству страшный вред, говорится в докладе.

Подпись к фото,

В фильме по книге Азимова «Стальные пещеры» роботы сопровождают человека повсюду

Речь пока не идет о том, что роботы смогут поработить людей. Но когда машины, способные к самообучению и принятию самостоятельных решений, станут повсеместно использоваться дома, в бизнесе и в сфере государственных услуг, возможность утраты контроля над ними выглядит пугающе.

Доклад призывает установить для роботов правила, по умолчанию ставящие интересы человека превыше интересов машины.

Создание такой системы правил не может опираться исключительно на технические стандарты. Умные машины должны будут руководствоваться этическими и демократическими ценностями, считает Энтони Уокер — заместитель главы лоббистской группы TechUK и один из авторов опубликованного доклада.

«Технологии способны дать нам массу преимуществ, но люди должны быть уверены, что эти системы хорошо продуманы, безопасны и управляемы», — замечает он.

В докладе предлагается совершенно новый подход к этой проблеме. Его авторы выдвигают идею создания некоего «наблюдательного совета» в составе экспертов и заинтересованных сторон, которые займутся созданием этической базы для технологических разработок в области искусственного интеллекта.

Для просмотра этого контента вам надо включить JavaScript или использовать другой браузер

Подпись к видео,

Вкалывают роботы

В основу принципа человеческого процветания, по мнению авторов доклада, должны быть положены следующие принципы:

- Защита индивидуальных и коллективных прав и интересов;

- Обеспечение прозрачности, отчетности и инклюзивности;

- Поиск успешных примеров и обучение методом проб и ошибок;

- Совершенствование существующих методов демократического управления.

Необходимость нового подхода к управлению умными машинами очевидна: век Азимова уже наступил.

Создание беспилотных автомобилей, например, ставит вопросы о том, каким образом выстраивать приоритеты в области безопасности. Что произойдет в ситуации, когда машине придется делать выбор между безопасностью пассажиров и безопасностью пешеходов?

Существует также проблема ответственности в случае подобного инцидента. На кого ляжет вина — на владельца машины или на саму машину?

Автор фото, Getty Images

Подпись к фото,

Беспилотные автомобили — дело недалекого будущего

Пропустить Подкаст и продолжить чтение.

Подкаст

Что это было?

Мы быстро, просто и понятно объясняем, что случилось, почему это важно и что будет дальше.

эпизоды

Конец истории Подкаст

Другой пример — появление систем искусственного интеллекта для персонализированного обучения. Такие машины способны самостоятельно определять сильные и слабые стороны обучаемого и изменять методы преподавания.

Такие машины способны самостоятельно определять сильные и слабые стороны обучаемого и изменять методы преподавания.

Можно ли поручить такие самообучающимся системам преподавать без надзора и четкого руководства? Ведь если мы беспокоимся о возможном влиянии учителя на ребенка, влияние обучающей машины на детское сознание заслуживает не меньшего внимания.

Все эти вопросы должны решать не только технические компании, которые занимаются разработкой подобных умных машин, — они адресованы всем нам.

Именно по этой причине авторы доклада считают, что подробности конструкции систем искусственного интеллекта не могут быть коммерческой тайной.

Они должны быть достоянием общественности, и если что-то пойдет не так такие системы должны легко перепрограммироваться.

Существующие законы направлены на защиту личных данных. Они ничего не говорят об информации, которую мы генерируем ежедневно на своих компьютерах и мобильных телефонах, с помощью которых можно легко отследить наши предпочтения практически в любой сфере.

Уже сейчас существуют системы, которые могут собирать эту информацию в открытом доступе и генерировать личный профиль человека, который можно использован в коммерческих целях — например, страховыми компаниями для определения стоимости страховки или работодателями, подбирающими кандидата на новую вакансию.

Такие системы могут быть весьма полезны, но недостаток контроля над ними может привести к тому, что наши судьбы будут определяться компьютерными алгоритмами.

Ключом к решению этой проблемы, по мнению профессора Лейзер, является создание индивидуализированных принципов управления.

«Алгоритм, который определяет, какие книги вам рекомендуют на сайте Amazon, очень сильно отличается от алгоритма, необходимого для определения диагноза заболевания, — говорит она. — Поэтому неразумно было бы регулировать алгоритмы в целом — без учета того, для чего они применяются».

Правящая в Британии Консервативная партия в своей предвыборной программе обещала принять закон о защите цифровых данных и создать комиссию по этике их использования.

Хотя чаще всего министры упоминают этот вопрос в контексте борьбы с терроризмом и насилием в интернете, некоторые считают, что идеи, высказанные в докладе Королевского общества, могут быть использованы такой комиссией в своей работе.

Уже сейчас можно утверждать, что системы искусственного интеллекта войдут в повседневную жизнь не раньше, чем люди научатся им доверять.

Без этого в полной мере реализовать тот огромный потенциал, которым обладает искусственный интеллект, просто не удастся.

Почему три закона робототехники Азимова не могут нас защитить

Прошло 50 лет с тех пор, как Айзек Азимов разработал свои знаменитые «Три закона робототехники» — набор правил, призванных обеспечить дружелюбное поведение роботов. Хотя эти законы задуманы как литературный прием, некоторые провозглашают их готовым рецептом, как избежать робопокалипсиса. Мы поговорили с экспертами, чтобы выяснить, выдержали ли меры безопасности Азимова испытание временем — и они не выдержали.

Во-первых, краткий обзор Трех Законов. Как заявил Азимов в своем 1942 рассказ «Обход»:

1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

2. Робот должен подчиняться приказам, отдаваемым ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону.

3. Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму закону.

Позже Азимов добавил четвертый, или нулевой закон, который предшествовал остальным с точки зрения приоритета:

0. Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечество причинило вред.

В вымышленной вселенной Азимова эти законы были включены почти во всех его «позитронных» роботов. Это были не просто предложения или рекомендации — они были встроены в программное обеспечение, которое управляет их поведением. Более того, правила нельзя было обойти, перезаписать или пересмотреть.

Более того, правила нельзя было обойти, перезаписать или пересмотреть.

Неизменно, как показано во многих романах Азимова, несовершенства, лазейки и двусмысленности, закрепленные в этих законах, часто приводили к странному и нелогичному поведению роботов. Законы были слишком расплывчатыми, например, из-за того, что не могли должным образом определить и различить «людей» и «роботов». Кроме того, роботы могут неосознанно нарушать законы, если от них утаивают информацию. Более того, роботу или ИИ, наделенному сверхчеловеческим интеллектом, было бы трудно до 9 лет.0023, а не выяснить, как получить доступ и пересмотреть его основные программы.

Если оставить в стороне научную фантастику, и, как склонны указывать многие, эти Законы были задуманы как литературный прием. Но еще в 1981 году сам Азимов считал, что они действительно могут работать. Запись в Compute! , он отметил, что

У меня всегда наготове ответ, когда кто-нибудь спрашивает меня, думаю ли я, что мои три закона робототехники действительно будут использоваться для управления поведением роботов, как только они станут достаточно универсальными и гибкими, чтобы иметь возможность выбирать между разные курсы поведения.

Мой ответ таков: «Да, Три закона — это единственный способ, которым разумные люди могут обращаться с роботами — или с чем-либо еще».0003

Теперь, примерно три десятилетия спустя, мы приближаемся к тому дню, когда у нас будут роботы — или, точнее, управляющий ими ИИ — достаточно универсальные и гибкие, чтобы выбирать разные варианты поведения. В самом деле, это будет только вопросом времени, когда машинный интеллект выйдет за пределы человеческих возможностей во всех мыслимых аспектах, включая силу, скорость и даже физическую досягаемость.

Пугает то, что вероятность ошибки будет чрезвычайно мала. Если сверхискусственный интеллект (ИСИ) будет плохо запрограммирован или будет амбивалентен человеческим потребностям, это может привести к катастрофе. Нам нужно обеспечить безопасность ИИ, если мы хотим пережить его появление.

Чтобы узнать, могут ли помочь Три закона Азимова, мы связались с двумя теоретиками ИИ, которые серьезно задумались над этой темой: Бен Герцель — теоретик ИИ и главный научный сотрудник фирмы финансовых прогнозов Aidyia Holdings — и Луи Хелм — заместитель директора Machine Исследовательский институт разведки (MIRI) и исполнительный редактор журнала Rockstar Research Magazine . После разговора с ними стало ясно, что законы Азимова совершенно не подходят для этой задачи — и что если мы хотим гарантировать безопасность ВОА, нам придется придумать что-то совершенно другое.

После разговора с ними стало ясно, что законы Азимова совершенно не подходят для этой задачи — и что если мы хотим гарантировать безопасность ВОА, нам придется придумать что-то совершенно другое.

Азимовское будущее?

Я начал разговор с того, что спросил Герцеля и Хелма о том, в чем видение будущего Азимова было точным, а в чем нет.

«Я думаю, что роботы, которые представлял себе Азимов, скоро станут возможны», — ответил Герцель. «Однако в большинстве его вымышленных миров кажется, что роботы человеческого уровня были вершиной робототехники и инженерии искусственного интеллекта. Это кажется маловероятным. Вскоре после создания человекоподобных роботов в стиле Азимова кажется, Также возможны искусственный интеллект и роботы».

Таким образом, типичный мир будущего в рассказах Азимова о роботах, по его словам, — это жизнь, в которой большая часть жизни похожа на то, какой она является сегодня, но с гуляющими гуманоидными разумными роботами.

«Это кажется маловероятным, а если и существует, то ненадолго», — говорит он.

Для Хелма роботы совершенно не при чем.

«Основной вопрос, который, как я полагаю, будет важным для человечества, — это не моральное регулирование большого количества полуинтеллектуальных роботов-гуманоидов, а возможное развитие передовых форм искусственного интеллекта (воплощенных или нет), которые функционируют на гораздо больших чем человеческий уровень», — сказал Хелм io9.. «Это развитие сверхразума является фильтром, через который человечество в конечном итоге должно пройти. Вот почему так важна разработка стратегии безопасности для этого перехода. за десятилетие или два до того, как люди столкнутся с реальной проблемой развития машинной этики для сверхразума».

Хорошая отправная точка?

Учитывая, что Три закона Азимова были первой подлинной попыткой решить очень серьезную проблему — проблему обеспечения безопасного поведения машин, наделенных интеллектом, превосходящим человеческий, — я хотел узнать, какими способами эти законы все еще могут быть реализованы. считается эффективным (или, по крайней мере, вдохновляющим).

считается эффективным (или, по крайней мере, вдохновляющим).

«Честно говоря, я не нахожу вдохновения в трех законах робототехники», — сказал Хельм. «Консенсус в машинной этике состоит в том, что они не являются удовлетворительной основой для машинной этики». «Три закона» могут быть широко известны, говорит он, но на самом деле они не используются для руководства или информирования настоящих исследователей безопасности ИИ или даже специалистов по этике машин.

«Одна из причин заключается в том, что этические системы, соблюдающие правила, называемые «деонтологией», известны как несостоятельные основы этики. Есть еще несколько философов, пытающихся исправить системы деонтологии, но в основном это одно и то же. люди, пытающиеся укрепить «разумный замысел» и «теорию божественного командования», — говорит Хелм. «Никто не воспринимает их всерьез».

Он резюмирует неадекватность Трех Законов соответственно:

- Противоборствующие по своей сути

- Основанные на известных ошибочных этических основах (деонтологии)

- Отвергаются исследователями

- Несостоятельны даже в художественной литературе

9007. «Суть «Трех законов» заключалась в том, чтобы потерпеть неудачу интересным образом; именно это сделало большинство историй, связанных с ними, интересными», — говорит он. «Таким образом, Три закона были поучительны с точки зрения обучения нас тому, что любая попытка законодательно закрепить этику с точки зрения конкретных правил обречена на провал и иметь различные лазейки».

«Суть «Трех законов» заключалась в том, чтобы потерпеть неудачу интересным образом; именно это сделало большинство историй, связанных с ними, интересными», — говорит он. «Таким образом, Три закона были поучительны с точки зрения обучения нас тому, что любая попытка законодательно закрепить этику с точки зрения конкретных правил обречена на провал и иметь различные лазейки».

Герцель не верит, что они будут работать в действительности, утверждая, что используемые термины двусмысленны и подлежат интерпретации — это означает, что они зависят от разума, выполняющего интерпретацию различными очевидными и тонкими способами.

Предубеждение против роботов?

Другим аспектом (и потенциальным недостатком) «Трех законов» является очевидный субстратный шовинизм — предположение, что роботы, несмотря на их возможности, должны оставаться в подчиненной роли по отношению к человеческим потребностям и приоритетам.

«Абсолютно верно», — говорит Гетцель. «Общества будущего, которые изображал Азимов, были явно субстратным шовинизмом; они давали людям больше прав, чем гуманоидным роботам. Три закона были предназначены для обеспечения и поддержания такого социального порядка».

Три закона были предназначены для обеспечения и поддержания такого социального порядка».

Хелм видит это немного по-другому, утверждая, что если мы когда-нибудь окажемся в такой ситуации, мы уже зашли слишком далеко.

«Я думаю, что было бы неразумно разрабатывать системы искусственного интеллекта или роботов, обладающих самосознанием», — говорит Хелм. «И в отличие от фильмов или книг, где разработчики ИИ «случайно» получают сознательные машины по волшебству, я не ожидаю, что это может произойти в реальной жизни. достигните этой цели. И большинство разработчиков ИИ — этичные люди, поэтому они будут избегать создания того, что философы назвали бы «существами, имеющими моральное значение». Особенно, когда они могли так же легко создавать продвинутые мыслящие машины, которые не несут этической ответственности».

Соответственно, Хелма не особенно беспокоит необходимость разработки асимметричных законов, регулирующих ценность роботов по сравнению с людьми, утверждая (и надеясь), что будущие разработчики ИИ будут использовать некоторые этические ограничения.

«Тем не менее, я думаю, что люди состоят из атомов, и поэтому теоретически возможно создать синтетическую форму жизни или робота, имеющего моральное значение», — говорит Хелм. «Хотел бы я думать, что никто этого не сделает. И я ожидаю, что большинство людей этого не сделает. Но неизбежно может найтись какой-нибудь самодовольный дурак, стремящийся к известности за то, что он первым сделал что-то — что угодно — даже что-то настолько неэтичное и глупое».

Три закона 2.0?

Учитывая очевидную неадекватность «Трех законов Азимова», мне было любопытно узнать, можно ли их исправить с помощью нескольких настроек или исправлений. И действительно, многие писатели-фантасты пытались сделать именно это, добавляя различные дополнения на протяжении многих лет (подробнее об этом здесь).

«Нет, — говорит Хелм, — «заплатки» к трем законам не будет. Ее не существует».

Помимо того, что они слишком непоследовательны, чтобы их можно было реализовать, Хелм говорит, что Законы по своей сути состязательны.

«Я предпочитаю подходы к машинной этике, которые являются более кооперативными, более рефлективно последовательными и имеют достаточную косвенную нормативность, чтобы система могла оправиться от раннего непонимания или неправильного программирования своей этики и все же прийти к надежному набору этических принципов в любом случае. «, — говорит Хелм.

Герцель разделяет опасения Хельма.

«Определение некоторого набора этических предписаний в качестве основы подхода к машинной этике, вероятно, безнадежно, если рассматриваемые машины являются гибкими мыслящими ОИИ [искусственным общим интеллектом]», — сказал он io9.. «Если ОИИ создан с интуитивным, гибким, адаптивным чувством этики, то в этом контексте этические предписания могут быть полезны для этого ОИИ в качестве приблизительного руководства по применению его собственной этической интуиции. Но в этом случае предписания не являются ядром этической системы ОИИ, это всего лишь один из ее аспектов. Вот как это работает у людей — этические правила, которые мы изучаем, работают, поскольку они действительно работают, главным образом как руководство для подталкивания этических инстинктов и интуиции, которые мы есть — и что мы имели бы независимо от того, чтобы нас учили этическим правилам».

Как создать безопасный ИИ?

Учитывая неадекватность основанного на законе подхода, я попросил Герцеля и Хелма описать текущие подходы к проблеме «безопасного ИИ».

«Очень немногие исследователи ОИИ верят, что можно было бы спроектировать системы ОИИ, которые могли бы гарантировать полную безопасность», — говорит Герцель. «Но это не беспокоит большинство из них, потому что, в конце концов, в этой жизни нет никаких гарантий».

Герцель считает, что, как только мы создадим ранние системы ОИИ или прото-ОСИ, намного более мощные, чем те, что у нас есть сейчас, мы сможем проводить исследования и эксперименты, которые расскажут нам об этике ОИИ гораздо больше, чем мы теперь знаю.

«Надеюсь, таким образом мы сможем сформулировать хорошие теории этики ОИИ, которые позволят нам лучше понять тему, — говорит он, — но прямо сейчас теоретизировать об этике ОИИ довольно сложно, потому что мы не У меня нет ни хороших этических теорий , ни действительно хороших теорий ОИИ».

Он также добавил: «И людям, которые смотрели Терминатор слишком много раз, может показаться пугающим продолжать создавать ОИИ, предполагая, что твердые теории ОИИ, скорее всего, появятся только после мы экспериментировали с некоторыми примитивными системами ОИИ. Но именно так и произошли самые радикальные достижения». они могли бы использовать, чтобы предсказать будущие последствия введения языка в их общество?»

Опять же, Герцель и Хелм находятся на одной странице. Исследовательский институт машинного интеллекта потратил много времени на размышления об этом — и краткий ответ заключается в том, что это еще не инженерная проблема, требуется гораздо больше исследований.0003

«Что я имею в виду? Ну, мой коллега из MIRI Люк Мюльхаузер хорошо резюмировал это, когда сказал, что проблемы часто переходят от философии к математике, а затем к технике», — говорит Хелм. «Философия часто задает полезные вопросы, но обычно настолько неточно, что никто никогда не может знать, представляет ли новый вклад в ответ прогресс. Если мы сможем переформулировать важные философские проблемы, связанные с интеллектом, идентичностью и ценностью, достаточно математики, которая может быть неправильной или нет, тогда, я думаю, мы сможем построить модели, которые можно будет успешно использовать, и однажды они будут полезны в качестве исходных данных для реального проектирования».

Если мы сможем переформулировать важные философские проблемы, связанные с интеллектом, идентичностью и ценностью, достаточно математики, которая может быть неправильной или нет, тогда, я думаю, мы сможем построить модели, которые можно будет успешно использовать, и однажды они будут полезны в качестве исходных данных для реального проектирования».

Хелм называет это действительно трудной проблемой науки и философии, но этот прогресс все еще возможен прямо сейчас: «Я скептически отношусь к тому, что философия может решить ее в одиночку, так как за 3000 лет она не смогла добиться значительного прогресса в своем Но мы также не можем просто начать пытаться программировать и проектировать выход из ситуации с тем скудным пониманием, которое у нас есть сейчас. Все еще требуется много дополнительных теоретических исследований».

ИЗОБРАЖЕНИЕ: МАЙКЛ УИЛЕН/РОБОТЫ РАССВЕТА.

Следуйте за мной в Твиттере: @dvorsky

Когда машины принимают решения о жизни или смерти: учитываются все технологии: NPR

Робот, который вредит: когда машины принимают решения о жизни или смерти: учитываются все технологии Художник разработал робот, который намеренно бросает вызов закону Айзека Азимова о том, что «робот не может причинить вреда человечеству», чтобы сделать дискуссию о беспилотном вождении и других умных технологиях актуальной.

Робототехника

Слышали обо всем

Робот, который причиняет вред: когда машины принимают решения о жизни или смерти

Художник и инженер Александр Ребен говорит, что это первый робот, который самостоятельно и намеренно нарушил первый закон Азимова не причинять вреда человеку.

Ютуб

Исаак Азимов вдохновил робототехников своей научной фантастикой и особенно своими законами о роботах. Первый говорит:

Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

Художник и робототехник Александр Ребен спроектировал робота, который намеренно бросает вызов этому закону.

«Это ранит человека и ранит его», — говорит Ребен. Его робот колет пальцы, причиняя им «наименьшую возможную боль», говорит он.

Когда человек вставляет палец в прорезь слева, робот использует алгоритм, непредсказуемый даже для его создателя, чтобы решить, уколоть ли палец булавкой на конце руки.

Александр Ребен

скрыть заголовок

переключить заголовок

Александр Ребен

Когда человек вставляет палец в прорезь слева, робот использует алгоритм, непредсказуемый даже для его создателя, чтобы решить, уколоть ли палец булавкой на конце руки.

Александр Ребен

И действия робота непредсказуемы — но не случайны. «Он принимает решение таким образом, что [я] как создатель не могу предсказать», — говорит Ребен. «Когда вы окажетесь рядом с этим роботом, он решит, причинять вам боль или нет».

«Он принимает решение таким образом, что [я] как создатель не могу предсказать», — говорит Ребен. «Когда вы окажетесь рядом с этим роботом, он решит, причинять вам боль или нет».

Хотя это может показаться немного глупым экспериментом, Ребен делает серьезный вывод: он пытается спровоцировать дискуссию о будущем, в котором роботы смогут делать выбор в отношении человеческой жизни.

Робот Ребена не очень сложный. Это просто роботизированная рука на платформе, меньше, чем человеческая конечность, и по форме немного похожа на руку одного из тех экскаваторов, которые используют в строительстве, но вместо лопаты на конце есть шпилька. (И если вам интересно, каждая игла стерилизуется.)

«Вы подносите руку к роботу, и он вас чувствует», — объясняет Ребен. «Затем он проходит через алгоритм, чтобы решить, собирается ли он воткнуть иглу вам в палец».

Я положил палец под руку. Ожидание — самая трудная часть, так как оно проносится мимо меня несколько раз. Затем я чувствую крошечное жало, когда оно, наконец, решает уколоть меня.

Ребен создал этого робота, потому что мир приближается к тому времени, когда роботы будут выбирать, когда причинить вред человеку. Возьмем беспилотные автомобили. Ford Motors недавно заявила, что планирует начать массовое производство автономных автомобилей в течение пяти лет. Это может означать, что самоуправляемому транспортному средству вскоре может потребоваться решить, врезаться ли автомобиль в дерево и рисковать причинить вред водителю или сбить группу пешеходов.

«Ответ может быть таким: «Ну, эти машины будут принимать решения гораздо лучше нас, и это не будет проблемой», — говорит Ребен. «Они будут намного более этичны, чем когда-либо могли быть люди».

Но, спрашивает он, как насчет людей, которые садятся в эти машины? «Если вы садитесь в машину, есть ли у вас выбор не быть этичным?»

И люди хотят иметь такой выбор. Недавний опрос, проведенный MIT Media Lab, показал, что половина участников заявили, что, скорее всего, купят беспилотный автомобиль, обеспечивающий максимальную защиту пассажиров. Но только 19процентов заявили, что купят автомобиль, запрограммированный на спасение большинства жизней.

Но только 19процентов заявили, что купят автомобиль, запрограммированный на спасение большинства жизней.

Художественная литература Азимова сама по себе обдумывает многие серые области его законов. Всего их четыре — четвертый был добавлен позже как нулевой закон:

0. Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечество причинило вред.

1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

2. Робот должен подчиняться приказам, отдаваемым ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону.

3. Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму закону.

В рассказах Азимова законы часто оспариваются эмоциональной сложностью человеческого поведения. В сценарии, созданном на основе его знаменитого I, Robot, , главный герой — детектив, который не любит роботов, потому что один из них спас его в автокатастрофе, но позволяет девушке рядом с ним умереть на основании статистического определения того, что она меньше скорее всего выживет.

Тем не менее, законы Азимова часто цитируются учеными в этой области в качестве своего рода вдохновения и темы для обсуждения, когда мы приближаемся к миру все более сложных машин.

«Возможность даже запрограммировать эти законы в вымышленном роботе очень сложна, — говорит Ребен, — и то, что они на самом деле означают, когда вы действительно пытаетесь их проанализировать, довольно туманно. Это довольно нечеткая область».

Ребен говорит, что смысл создания его робота заключался в том, чтобы создать срочность — сделать что-то в мире сейчас, до того, как машины получат такие возможности в беспилотных автомобилях.

«Если вы видите видео, на котором робот заставляет кого-то истекать кровью, — говорит он, — то вдруг вы попадаете в эту вирусную природу вещей, и теперь вам действительно нужно с этим бороться».

Исправление от 29 августа 2016 г.

В предыдущей веб-версии этой истории говорилось, что в романе Айзека Азимова « Я, робот, » главный герой — детектив, который не любит роботов, потому что один из них спас его в автокатастрофе, но пусть девушка рядом с ним умирает.

Мой ответ таков: «Да, Три закона — это единственный способ, которым разумные люди могут обращаться с роботами — или с чем-либо еще».0003

Мой ответ таков: «Да, Три закона — это единственный способ, которым разумные люди могут обращаться с роботами — или с чем-либо еще».0003