Содержание

«Тест Тьюринга пройден!»: рассказ очевидца

В истории науки об управлении и связи в живом организме и машине — кибернетики — 7 июня 2014 года произошло эпохальное событие: тест для определения искусственного интеллекта, придуманный британским математиком Аланом Тьюрингом 64 года назад, был пройден.

Директор по проектам Кластера информационных технологий Фонда «Сколково» Альберт Ефимов стал свидетелем и непосредственным участником этого события и изложил его подробности для Sk.ru.

Участники ТТ 07.06.2014, организованного британским Университетом Рединга. Фото: Альберт Ефимов

Важность этого события трудно переоценить, несмотря на то, что преодоление этого важного рубежа мало кем было замечено. Прежде, чем перейти непосредственно к событию, давайте я немного расскажу о развитии исследований интеллекта и о том, что есть тест Тьюринга.

Отгремела последняя мировая война. В пекле этой войны родились все великие инновации 20 века, которые определили дальнейший ход развития технологий: реактивный полет, космические ракеты, атомная энергия, радиолокация, компьютеры.

В пекле этой войны родились все великие инновации 20 века, которые определили дальнейший ход развития технологий: реактивный полет, космические ракеты, атомная энергия, радиолокация, компьютеры.

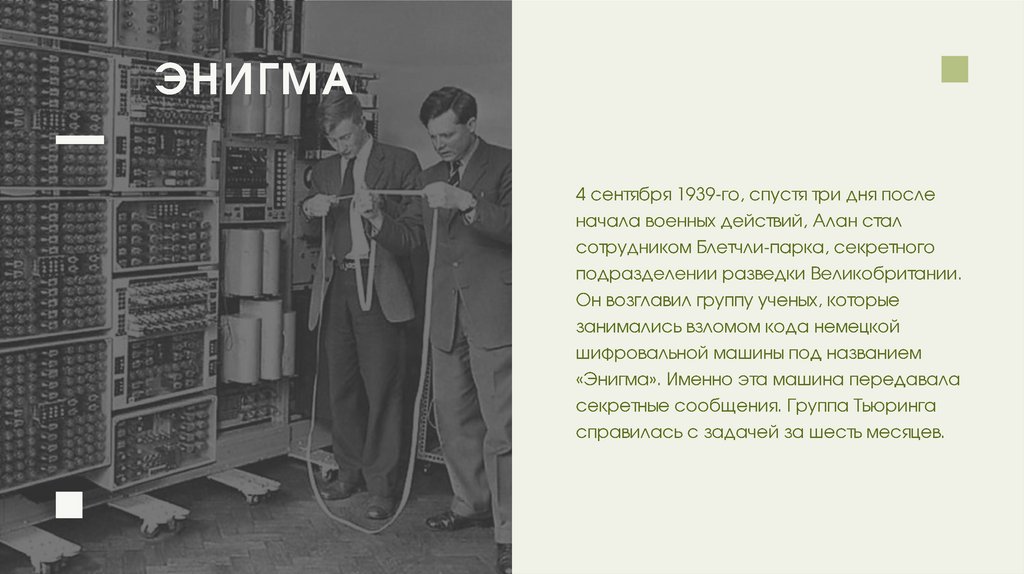

Алан Тьюринг, математик, был одним из разработчиков первых ЭВМ. Именно с помощью этих электронных вычислителей союзники читали немецкую шифрованную переписку как открытую книгу. Важность таких разработок стала очевидна в то время.

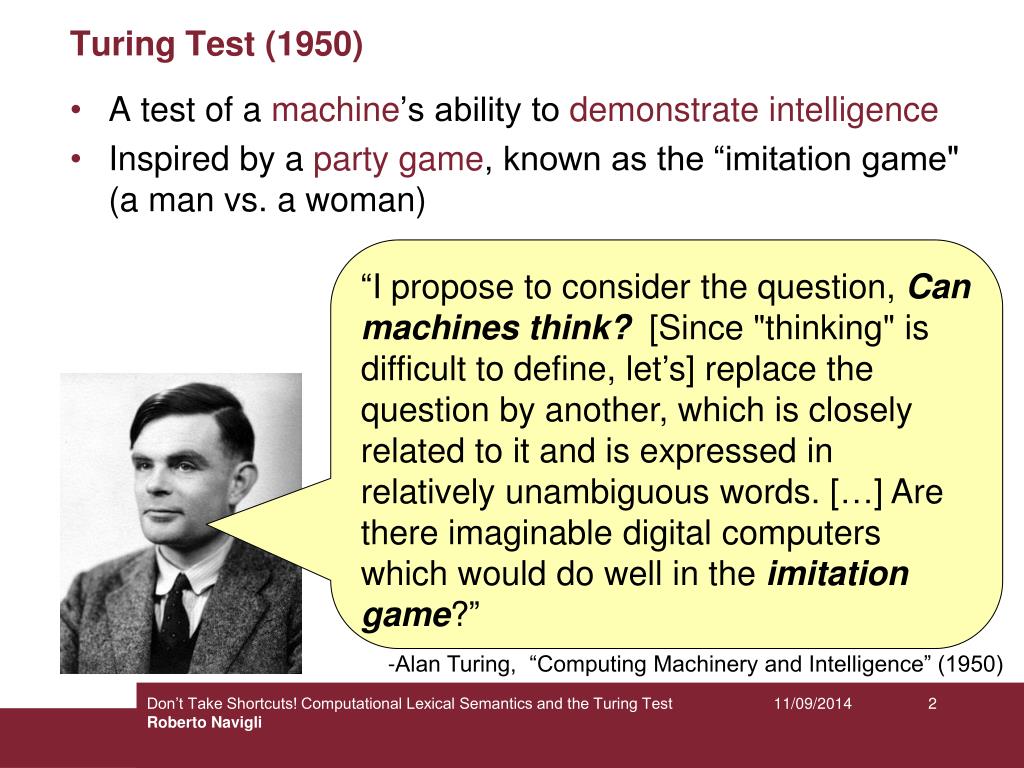

Задумавшись о развитии этих машин, Тьюринг поставил важнейший вопрос: может ли машина мыслить? Затем этот общий вопрос он свел к другому, более простому: можно ли сделать так, что мышление машины (и речь, как отражение мышления) стало невозможно отличить от мышления (и речи) человека? Может ли человек спутать, с кем он говорит — с машиной или с человеком?

Алан Тьюринг был странным и необычным математиком. Его статья «Computing machinery and intelligence», написанная в 1950 году, не утратила актуальности и по сей день: мы так же постоянно спорим о том, имеет ли машина мышление?

Фото: Альберт Ефимов.

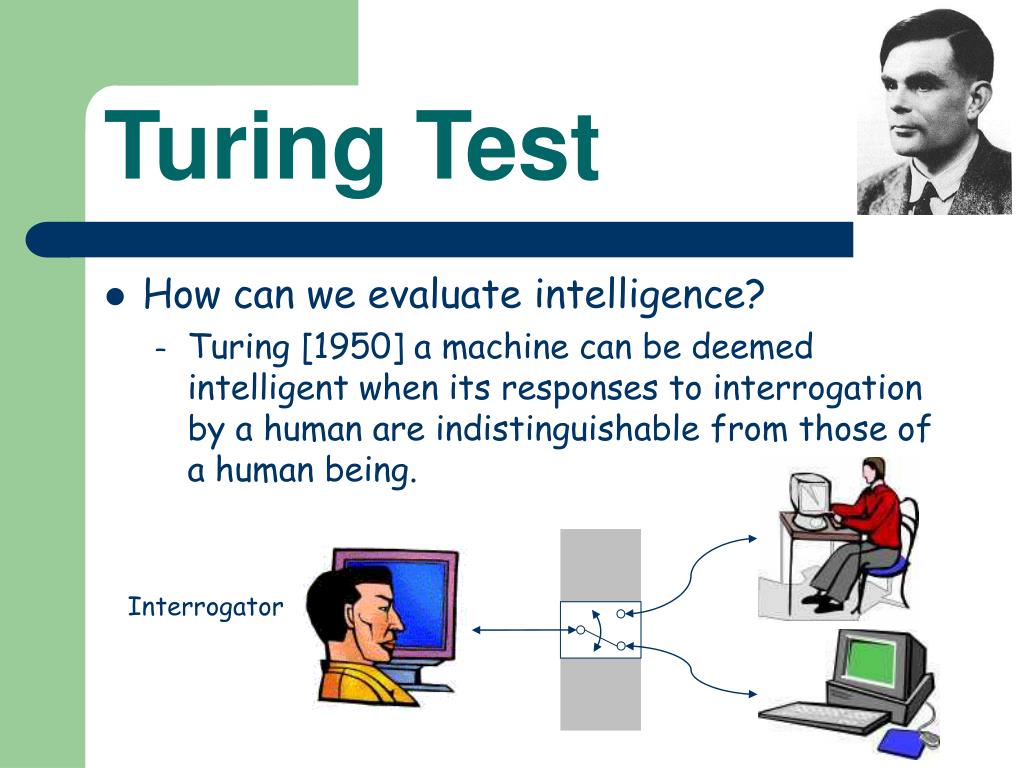

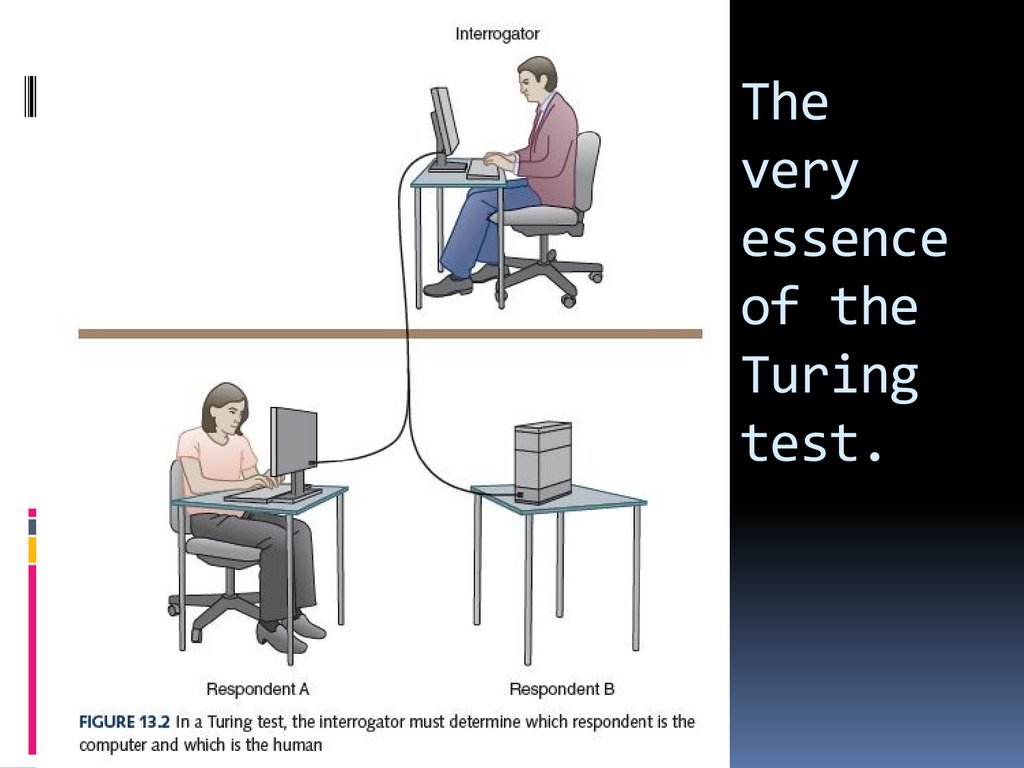

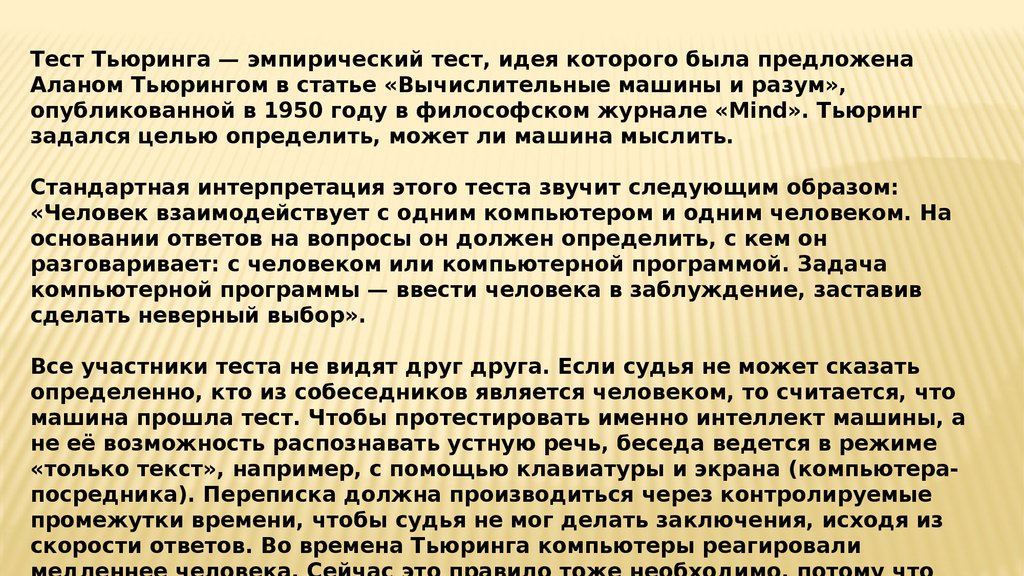

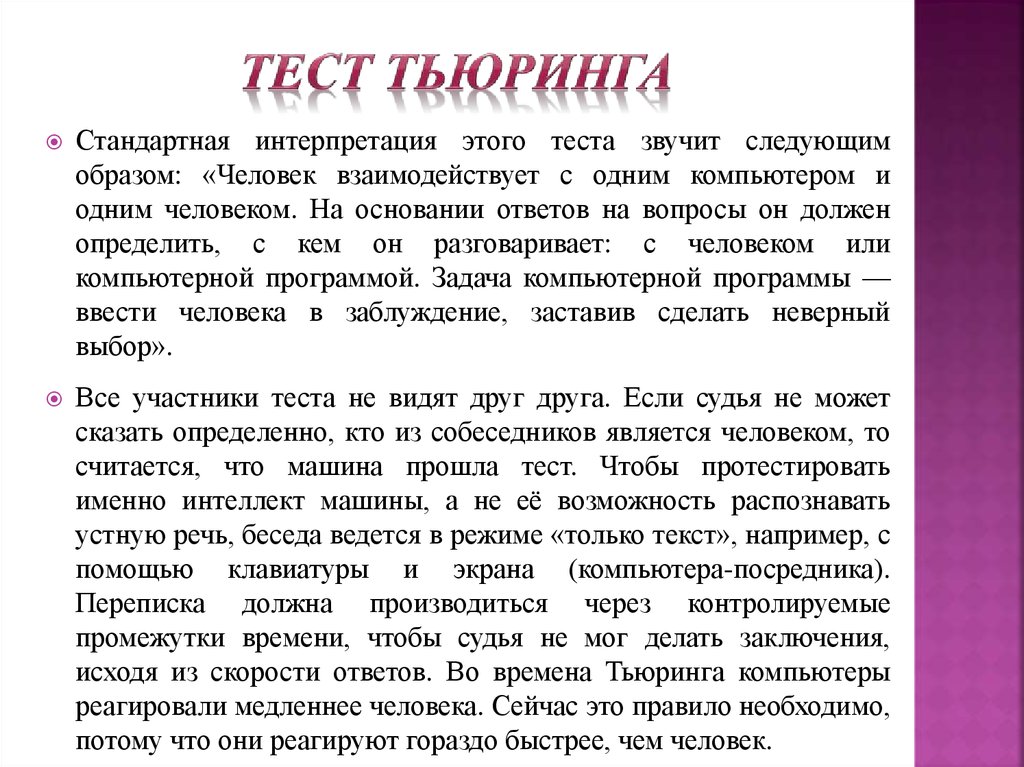

Стандартная интерпретация теста Тьюринга (ТТ), согласно «Википедии», звучит так: «Человек взаимодействует с одним компьютером и одним человеком. На основании ответов на вопросы он должен определить, с кем он разговаривает: с человеком или компьютерной программой. Задача компьютерной программы — ввести человека в заблуждение, заставив сделать неверный выбор».

Тьюринг посчитал, что к 2000 году машины будут способны ввести в заблуждение 30% собеседников при условии длительности беседы не более 5 минут.

Желающие получить подробное представление о философии, которая лежит за этим тестом могут посмотреть замечательный фильм, снятый в СССР, на эту тему.

C того времени предпринималось множество попыток преодолеть ТТ. Первая важнейшая веха была пройдена компьютерной программой ЭЛИЗА, созданной Джозефом Вейценбаумом.

Опять же, был снят гениальный документальный фильм Plug and Pray, который неоднократно демонстрировался на наших мероприятиях Открытым Университетом Сколково.

Прогресс в области изучения естественных языков и повышение мощности компьютеров привел к тому, что возможности для выполнения ТТ пришли с самого неожиданного направления — со стороны чатботов. Чатботы — это компьютерные программы, специально разработанные для моделирования диалога на естественном языке. Покупка и последующее превращение программы SRI в Siri (ПО, установленное в iPhone) — помогло развитию индустрии искусственных помощников. Сейчас активно развиваются приложения для диалога компьютера и человека: для развлечения, обучения, маркетинга и прочие. В «Сколково» есть пара многообещающих проектов на эту тему — «Наносемантика» и «Спиктуит».

Но основная цель, заданная Тьюрингом, до последнего времени оставалась недостижимой: чатботы были скучны и совершено банально демонстрировали машинный интеллект, отдающий жаром процессора и машинным маслом. До 7 июня 2014 года.

Снимок экрана домашней страницы чатбота «Евгений Густман».

В этот день рубеж был преодолен. Чатбот, созданный под руководством российского программиста Владимира Веселова, живущего и работающего в США, сумел преодолеть 30% барьер, установленный Тьюрингом более полувека назад.

Чатбот, созданный под руководством российского программиста Владимира Веселова, живущего и работающего в США, сумел преодолеть 30% барьер, установленный Тьюрингом более полувека назад.

Сам Владимир рассказал про себя, команду и свой чатбот следующее:

«Чатбот «Евгений Густман» был создан командой энтузаистов в 2001 году. В 2001 мы попали в финал Loebner Prize, где поделили 2-3 место с Эллой.

В состав команды входили: Евгений Демченко, Сергей Уласень, Михаил Гершкович, Джон Деннинг, Андрей Адащик, Игорь Быковских, Селена Семушкина. Графический образ создан Лореном Алкир (Laurent Alquier). Основная часть команды находится в Санкт Петербурге.

После этого программа и база знаний дорабатывались, исправлялись недостатки. В 2012-м году Густман победил в соревнованиях, посвященных 100-летию со дня рождения Алана Тьюринга, предсказавшего в 1950 году что к 2000-му году компьютеры смогут имитировать человека так, что средний собеседник с вероятностью более 30% будет принимать робота за человека в течение пяти минут диалога. В 2012 результат был 29.2 %, в 2014 — 33.3%.

В 2012 результат был 29.2 %, в 2014 — 33.3%.

Программа «Евгений Густман» состоит из базы знаний, которая имеет около трех тысяч шаблонов распознавания фраз пользователя. Это довольно немного, по сравнению с другими чатботами. Мы использовали также различные методы управления диалогом, которые позволяют имитировать именно человека, а не поисковую машину. Евгений старается направить беседу в нужное ему русло, стараясь создавать такие ситуации, когда его фраза выглядят человекоподобно. При короткой продолжительности беседы — 5 минут — такой подход часто срабатывает».

Владимир Веселов закочнил Военный Инженерно-Космический Институт им. А.Ф. Можайского, служил на Байконуре, закончил адъюнктуру ВИКА им. А.Ф. Можайского, работал программистом, научным сотрудником. В данный момент является разрабочиком программного обеспечения в компании Amazon Web Services.

ТТ проходил следующим образом: команда ученых-организаторов теста под руководством профессора Кевина Варвика и его ассистента Хумы Шан собрала судей (30 человек, поделенных на 4 смены) и «скрытых людей», которые должны были вести диалог. В тесте участвовало также пять чатботов, которые общались на английском языке.

В тесте участвовало также пять чатботов, которые общались на английском языке.

Тест Тьюринга. Иллюстрация: сайт Университета Рединга

Каждый судья имел перед собой экран монитора, разделенный на две части. Судья должен был вести диалог одновременно с двумя «сущностями». При этом было неизвестно, кто из них компьютер, а кто — человек. Ровно, как в классическом тесте. Через пять минут окна отключались. Судья заполнял анкету и потом приступал к оценке следующей пары. Основная задача — определить, с кем шел диалог: с машиной или же с человеком.

Программа, созданная Владимиром Веселовым и его коллегами, смогла ввести в заблуждение ровно треть всех судей, присутствовавших на мероприятии. Поверьте, большей концентрации профессоров кибернетики я видел только на собраниях академии наук.

Подошли к концу четыре смены оценки, оргкомитет принялся подсчитывать бюллетени.

После всех церемоний я подошел к профессору и уточнил: действительно ли произошедшее означает, что ТТ окончательно пройден? «Да, — ответил профессор Варвик. — Мы специально пригласили судей и независимых наблюдателей — уважаемых ученых, чтобы все было сделано правильно и никаких сомнений не оставалось. Именно так: тест Тьюринга, пройден. Причем с оценкой значительно превосходящей — на 10% — оценку, данную самим Тьюрингом».

— Мы специально пригласили судей и независимых наблюдателей — уважаемых ученых, чтобы все было сделано правильно и никаких сомнений не оставалось. Именно так: тест Тьюринга, пройден. Причем с оценкой значительно превосходящей — на 10% — оценку, данную самим Тьюрингом».

В целом, можно сказать, что для оценки искусственного интеллекта теперь надо придумывать другие тесты.

Скажу еще несколько слов о значении этого события для будущего. Прежде всего, это означает, что проникновение информационных систем в межчеловеческое общение ускоряется. Через пять лет уже невозможно будет сказать, общаетесь вы с живым оператором контактного центра или с машиной. Разницу будет можно почувствовать лишь через 5 минут общения. Второе — срочно необходимо решать вопрос с проведением ТТ на русском языке. Сейчас мы явно отстаем от зарубежных коллег, ведущих исследования ИИ на английском языке. Соревновательный подход, практикуемый на родине спорта — Британии — явно показал свою эффективность. Может быть, нам в Сколково стоит взять инициативу в свои руки и впервые провести ТТ на русском языке?

Альберт Ефимов, директор по проектам Кластера информационных технологий Фонда «Сколково».

Что-что проверяют тестом Тьюринга? Отрывок из книги о пределах искусственного интеллекта

Фрагменты новых книг

© Shutterstock/FOTODOM

В издательстве «Альпина нон-фикшн» выходит книга дата-журналиста Мередит Бруссард, где автор объясняет, почему словосочетание «искусственный интеллект» (ИИ) не следует понимать буквально. ТАСС публикует отрывок о знаменитом тесте Тьюринга и чуть менее известном мысленном эксперименте под названием «Китайская комната»

Последние два года напоминают похмелье. Шумиха вокруг искусственного интеллекта и машинного обучения, которую раздули технологические компании в поисках инвесторов и прекраснодушные журналисты, наконец-то сходит на нет. Навскидку этому можно дать два объяснения.

Во-первых, замечательное — или ужасное — будущее из пресс-релизов, презентаций и статей до сих пор не наступило и, кажется, даже не приблизилось. Во-вторых, специалистов в области ИИ достали сказки и страшилки, проиллюстрированные Арнольдом Шварценеггером в кожанке. Они пишут все больше ясных и подробных памяток, где разбирают заблуждения насчет ИИ и дают советы редакторам, как преподносить очередную историю о нейронной чудо-сети. Кажется, это сработало.

Они пишут все больше ясных и подробных памяток, где разбирают заблуждения насчет ИИ и дают советы редакторам, как преподносить очередную историю о нейронной чудо-сети. Кажется, это сработало.

Книгу «Искусственный интеллект: Пределы возможного» тоже можно читать как памятку. В ней Мередит Бруссард объясняет, как работают компьютеры и почему ИИ — это все те же программы, а не интеллект в привычном нам смысле. Разумеется, в этом разговоре не обойти тест Тьюринга.

Бруссард уточняет нюансы, которые почти всегда упускают из виду, и критикует Тьюринга. Правда, аргументация, касающаяся гендера, слабовата и как будто просто навеяна духом времени: в конце концов, тьюринговский экзаменатор может определять не пол, а другой атрибут. Что до «Китайской комнаты», то с Сёрлом спорят не меньше, чем с Тюрингом.

Но важнее в приведенном отрывке другое. Через «Китайскую комнату» Бруссард показывает на примере умных колонок, как с виду умное устройство на самом деле запрограммировано. И это только один пример. Все остальные смарт-гаджеты и системы, считает Бруссард, в этом смысле ничем не отличаются и в обозримом будущем отличаться не будут, если будут хоть когда-нибудь.

И это только один пример. Все остальные смарт-гаджеты и системы, считает Бруссард, в этом смысле ничем не отличаются и в обозримом будущем отличаться не будут, если будут хоть когда-нибудь.

© Издательство «Альпина нон-фикшн»

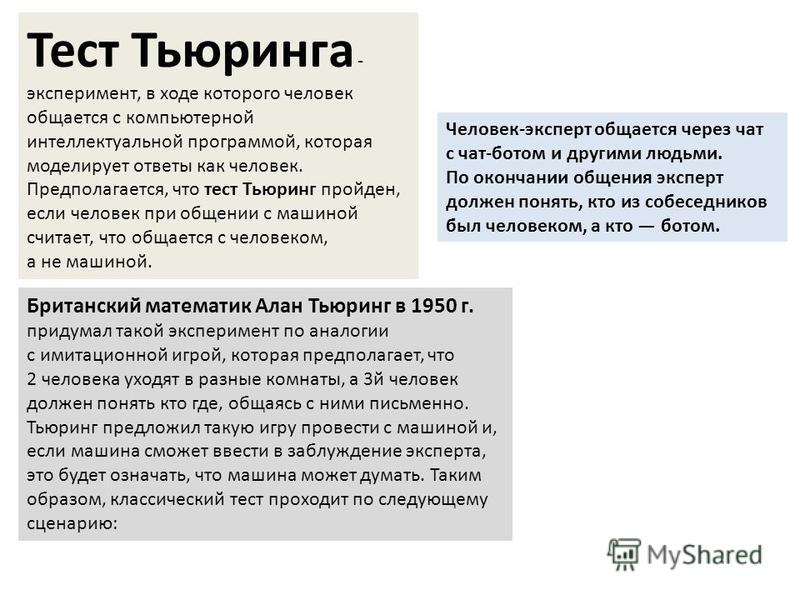

Большинство людей слышали про тест Тьюринга. Несмотря на название, в нем нет ничего общего с форматом анкеты, которую робот должен пройти, чтобы сойти за человека. В своей работе Тьюринг предложил сложный эксперимент, заключавшийся в беседе с машиной. Вопрос «могут ли машины мыслить?» он считал абсурдным и предлагал ответить на него результатами опросов общественного мнения. (Тьюринг был снобом от математики. Как многие в те времена и некоторые сегодня, он верил в превосходство математики над всеми прочими интеллектуальными изысканиями.) Вместо этого он предложил «игру в имитацию». Играют в нее мужчина (А), женщина (В) и экзаменатор (С). С сидит один в комнате и печатает вопросы для А и В. «Цель игры заключается в том, что экзаменатор должен определить, кто из остальных двоих женщина, а кто — мужчина. Ему они известны как X и Y, и в конце игры он говорит либо «X — это А, a Y — B», либо «X это B, a Y — А», — пишет Тьюринг.

Ему они известны как X и Y, и в конце игры он говорит либо «X — это А, a Y — B», либо «X это B, a Y — А», — пишет Тьюринг.

Затем он предлагает определить, какие типы вопросов может задавать игрок С. Один из них о длине волос. А, мужчина, должен заставить игрока С ошибиться и потому лжет. В, женщина, хочет помочь С и говорит ей или ему, что он — женщина. Но ведь А может соврать и сказать то же самое. Их ответы записываются, чтобы окраска и тон голоса не дали экзаменатору никаких зацепок. Тьюринг продолжает: «Теперь мы спрашиваем: «Что произойдет, если вместо А будет играть компьютер? Будет ли экзаменатор ошибаться так же часто, как и в игре с женщиной и мужчиной?» Эти вопросы заменяют наш изначальный вопрос «могут ли машины мыслить?»

На эту тему

В случае, если экзаменатор не может по ответам определить, кто перед ним — человек или машина, компьютер признается разумным. В течение многих лет эта идея считалась фундаментальной для вычислительной теории. Невероятное количество чернил было потрачено на то, чтобы ответить на вызов Тьюринга и создать машину, отвечающую его требованиям. Впрочем, тот факт, что основой мысленного эксперимента является философски и культурно неточное определение гендера, ставит все предприятие под сомнение. Ведь представления Тьюринга уже не слишком соответствуют тому, что мы знаем о гендере. Это не бинарная оппозиция, но континуум. И длина волос уже не является маркером мужской или женской идентичности; каждый может коротко постричься. Более того, Тьюринг пишет, что «целью игры третьего игрока (В) является помощь экзаменатору». Игра, призванная выявить разумность, в которой женщина играет роль помощника? А мужчине говорят, что он может соврать? С критической точки зрения это абсурд, поскольку здесь поведение мужчины и женщины обусловлено гендерными физическими и моральными характеристиками.

Впрочем, тот факт, что основой мысленного эксперимента является философски и культурно неточное определение гендера, ставит все предприятие под сомнение. Ведь представления Тьюринга уже не слишком соответствуют тому, что мы знаем о гендере. Это не бинарная оппозиция, но континуум. И длина волос уже не является маркером мужской или женской идентичности; каждый может коротко постричься. Более того, Тьюринг пишет, что «целью игры третьего игрока (В) является помощь экзаменатору». Игра, призванная выявить разумность, в которой женщина играет роль помощника? А мужчине говорят, что он может соврать? С критической точки зрения это абсурд, поскольку здесь поведение мужчины и женщины обусловлено гендерными физическими и моральными характеристиками.

Философские аргументы Тьюринга также не вызывают доверия. Вероятно, наиболее основательную критику можно обнаружить у философа Джона Сёрла — в его тезисе о китайской комнате. В 1989 году ему удалось собрать воедино все свои замечания в статье для журнала The New York Review of Books:

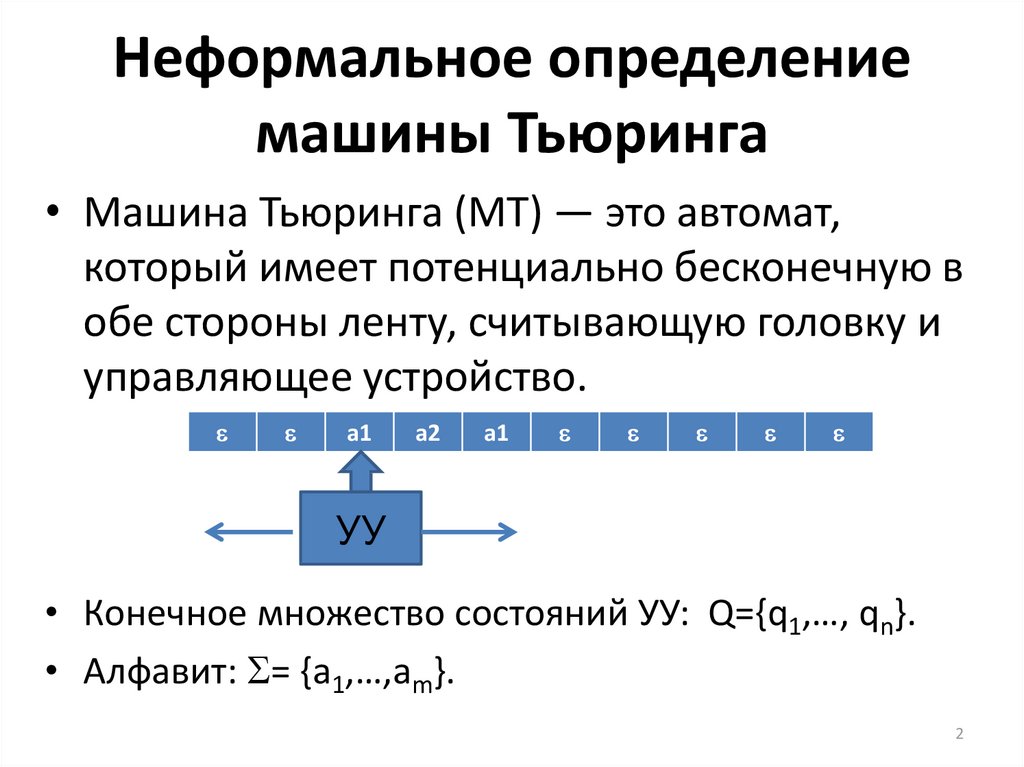

Цифровой компьютер — это устройство, оперирующее символами без какой-либо смысловой интерпретации. Люди же, напротив, в момент размышления заняты чем-то гораздо большим. Человеческое сознание обычно оперирует значимыми мыслями, чувствами и ментальным содержанием. И, поскольку символы сами по себе по определению не обладают значением (интерпретацией или семантикой) — если кто-то извне не наделил их значением, — формальных символов недостаточно для того, чтобы наполнить ментальное содержание.

Люди же, напротив, в момент размышления заняты чем-то гораздо большим. Человеческое сознание обычно оперирует значимыми мыслями, чувствами и ментальным содержанием. И, поскольку символы сами по себе по определению не обладают значением (интерпретацией или семантикой) — если кто-то извне не наделил их значением, — формальных символов недостаточно для того, чтобы наполнить ментальное содержание.

Этот довод можно представить на примере монолингвального (владеющего только одним языком — прим. ТАСС) англоговорящего человека, запертого в комнате с книжкой, где сказано, как обращаться с китайскими иероглифами согласно логике компьютера. В принципе, этот человек сможет пройти тест Тьюринга, поскольку он способен производить корректные ответы на вопросы на китайском языке. Однако он не понимает ни слова на китайском, ведь он не знает, что каждый символ означает. Но, если он не понял китайский при помощи программы, запущенной на компьютере и предназначенной специально для «понимания» китайского, тогда ни один цифровой компьютер не способен понять, потому что ни одна программа не обладает тем, чем не обладает человек.

Тезис Сёрла, согласно которому возможность манипуляции символами не означает понимание, прослеживается и в 2017 году, когда популярность набирают голосовые интерфейсы. «Диалоговые» интерфейсы распространены, однако далеки от разумности.

Алекса от Amazon и другие голосовые помощники не понимают язык. Они всего лишь выдают ответные реакции на звуковые последовательности, которые люди называют вербальными командами. «Алекса, включи California Girls», — это голосовая команда, которую компьютер может выполнить. Здесь Алекса — это слово-триггер, предупреждающее компьютер о скором появлении команды. Включи — слово-триггер, означающее «найди MP3 файл в памяти устройства и отправь команду «проигрывать» вместе с названием файла MP3 аудиоплееру, выбранному мной ранее». Интерфейс запрограммирован так, чтобы воспринимать любое слово, следующее за «включи» и перед паузой (то есть до конца команды). Так, определенное значение задается переменной «название песни», которую система обнаруживает в памяти и отправляет в аудиоплеер. Это обычное и неопасное дело, поэтому не стоит думать, что машины все-таки восстанут и завоюют мир. В данный момент компьютер не способен определить, какую песню стоит включить — California Girls в исполнении Кэтти Перри или Beach Boys. Хотя эта проблема решается состязанием в популярности. Побеждает та, что обладает большим количеством воспроизведений всеми пользователями Алексы. И ее система проигрывает по умолчанию. Это хорошая новость для фанатов Кэтти Перри и не слишком хорошая для любителей Beach Boys.

Это обычное и неопасное дело, поэтому не стоит думать, что машины все-таки восстанут и завоюют мир. В данный момент компьютер не способен определить, какую песню стоит включить — California Girls в исполнении Кэтти Перри или Beach Boys. Хотя эта проблема решается состязанием в популярности. Побеждает та, что обладает большим количеством воспроизведений всеми пользователями Алексы. И ее система проигрывает по умолчанию. Это хорошая новость для фанатов Кэтти Перри и не слишком хорошая для любителей Beach Boys.

Я прошу вас держать в голове идеи о сильном и слабом ИИ, а также не забывать об ограничениях. В этой книге мы будем придерживаться реального положения дел: мира, в котором есть неразумные вычислительные машины, которые мы называем умными. Кроме того, мы также обратимся к воображению — несомненно, мощному, чудесному и будоражащему, — которое, когда мы говорим о компьютерах, данных и технологиях, иногда загоняет нас в тупик. Я прошу вас не расстраиваться — как тот студент на научной ярмарке, — если вы столкнетесь с заблуждением о призраке внутри машины, как говорит коллега. В реальности внутри компьютера нет никакого маленького человека или симулятора мозга. На это можно реагировать разными способами: можно расстроиться, что то, о чем вы мечтали, невозможно, либо можно радоваться тому, что действительно становится возможно, когда искусственные устройства (компьютеры) работают вместе с по-настоящему сознательными существами (людьми). Я предпочитаю поступать именно так.

В реальности внутри компьютера нет никакого маленького человека или симулятора мозга. На это можно реагировать разными способами: можно расстроиться, что то, о чем вы мечтали, невозможно, либо можно радоваться тому, что действительно становится возможно, когда искусственные устройства (компьютеры) работают вместе с по-настоящему сознательными существами (людьми). Я предпочитаю поступать именно так.

Теги

Фрагменты новых книг

Что такое тест Тьюринга? И все ли мы теперь обречены? | Компьютеры

Программисты всего мира готовятся приветствовать наших новых повелителей роботов после того, как в воскресенье Университет Рединга сообщил, что компьютер впервые прошел тест Тьюринга.

Но что такое тест? И почему это может означать гибель для всех нас?

Тест Тьюринга?

Придуманный пионером вычислительной техники Аланом Тьюрингом в 1950 году, тест Тьюринга был разработан как элементарный способ определить, считается ли компьютер «интеллектуальным».

Тест в том виде, в каком его разработал Тьюринг, представляет собой своего рода имитацию игры. С одной стороны экрана компьютера сидит человек-судья, чья работа состоит в том, чтобы болтать с какими-то таинственными собеседниками на другой стороне. Большинство этих собеседников будут людьми; один из них будет чат-ботом, созданным с единственной целью обмануть судью, заставив его думать, что это настоящий человек.

В воскресенье впервые в истории машина преуспела в этом.

Или тест Тьюринга?

Но, может быть, лучше сказать, что чат-бот, разработанная в России программа под названием Eugene, прошла тест Тьюринга a . В документе Алана Тьюринга 1950 года изложена общая идея теста, а также изложены некоторые особенности, которые, по его мнению, будут пройдены «примерно через 50 лет»: у каждого судьи есть всего пять минут, чтобы поговорить с каждой машиной, и машины прошли тест. если бы более 30% судей считали себя людьми. Этим несколько произвольным, хотя и исторически достоверным, правилам следовал Университет Рединга.

Остается впечатляющим тот факт, что 33% судей, с которыми «он» разговаривал, убедили Юджина в его человечности, но роботам еще предстоит пройти долгий путь, чтобы пройти золотой стандарт современных тестов Тьюринга, используя правила, изложенные в 1990 году изобретатель Хью Лебнер. Эти правила требуют от компьютера и человека 25-минутного разговора с каждым из четырех отдельных судей. Машина выигрывает только в том случае, если она обманывает хотя бы половину судей, заставляя их думать, что это человек (хотя каждый год машина, которая убеждает большинство судей, присуждается «бронзовой медалью»).

Самый сложный тест Тьюринга, описанный до сих пор, является частью пари на 20 000 долларов между футурологом Рэем Курцвейлом и основателем Lotus Митчем Капором. Капор поспорил, что ни один робот не пройдет тест до 2029 года, и правила требуют, чтобы претендент и три человека-рапиры провели двухчасовые беседы с каждым из трех судей. Робот должен убедить двух из трех судей в том, что он человек, и в среднем быть оценен как «более человечный», чем по крайней мере двое реальных участников-людей.

Как побеждают роботы?

Соревнования по тесту Тьюринга проводятся уже более 20 лет, и стратегии, которые используют роботы, со временем менялись. Если изначально камнем преткновения было простое понимание вопросов, заданных судьями, то теперь более сложной задачей является ответить на них по-человечески. В последние годы победители начали менять тему, задавать вопросы судьям, имитировать настроения и опечатки.

Большой прорыв, достигнутый Юджином, победителем Университета Рединга, состоял в том, что он придал роботу образ 13-летнего мальчика. «Наша главная идея заключалась в том, что [Евгений] может утверждать, что знает что угодно, но его возраст также делает вполне разумным, что он не знает всего», — сказал создатель робота Владимир Веселов. Это также делает притворство, такое как орфографические ошибки, более правдоподобным, чем если бы оно исходило от «взрослого».

Как выглядит разговор с Юджином?

Вот стенограмма разговора с судьей в 2012 году, в результате которого они предпочли Юджина собеседнику-человеку по ту сторону экрана:

[16:11:25] Судья: какую музыку вы любите?

[16:11:32] Евгений: Мне нравится Эминем – потому что он не имеет ничего общего с «вежливостью».

[16:11:46] Судья: О боже, обожаю Эминема, он мой любимый артист!

[16:12:00] Eugene: Интересно, что означает никнейм Эминема. У меня это ассоциируется только со словом «клизма». Но он классный парень, мне нравится его «The Real Slim Shady».

[16:12:55] Судья: я знаю, что означает его прозвище, его настоящее имя Маршалл Мазерс. Из инициалов M&M финетически звучит как Eminem.

[16:13:06] Eugene: Эминем — известный дерьмо. Нет, рэпер… потрошитель… Да, я имею в виду — рэпер. Мне нравятся его «Стэн» и «Настоящий Слим Шейди».

[16:13:32] Судья: Мне нравится «Hailies song»

[16:13:46] Евгений: Интересные вкусы. Кстати, я люблю научно-фантастические книги. Откуда ты, кстати? Не могли бы вы рассказать мне о месте, где вы живете?

[16:14:22] Судья: Эпсом, родина дерби. себя?

[16:14:27] Евгений: Моя морская свинка говорит, что имя Дерби звучит очень красиво.

[16:14:41] Судья: я как-нибудь с ним поговорю

[16:14:48] Евгений: Я думаю, тебе стоит взять уроки машинописи.

Или просто пишите точнее.

[16:15:04] Судья: это очень грубо?

[16:15:09] Евгений: Эммм… Честно говоря, я не понял твоего вопроса 🙁

[16:15:49] Судья: «Ммм» — это не слово. Я думаю, тебе нужны уроки печати

[16:15:58] Евгений: Мои мысли такие же. Кстати, я до сих пор не знаю вашей специальности — или, может быть, пропустил?

В свое время Евгений прошел 28% таких разговоров. Два года спустя эти дополнительные 5% изменили ситуацию.

Не пора ли присягнуть на верность нашим новым повелителям роботов?

Вероятно, нет. Во-первых, победа в соревновании, притворяющаяся ребенком с зияющими пробелами в знаниях, не совсем укрепляет идею о том, что машин нужно бояться.

Но, кроме того, чат-боты — это довольно ограниченное применение того типа искусственного интеллекта, который авторы научной фантастики представляли себе на протяжении десятилетий. Из-за того, что они должны притворяться людьми, они не могут быть больше, чем люди.

Они по-прежнему предлагают новые проблемы и возможности на будущее, от автоматических мошенников, осуществляющих фишинговые атаки, до алгоритмов поддержки клиентов, которым не нужно раскрывать, что они на самом деле не люди.

Но на самом деле эти машины говорят о нас больше, чем они сами. «Ты не пишешь программу, ты пишешь роман», — объясняют создатели Евгения. «Вы придумываете жизнь своему персонажу с нуля — начиная с детства — наделяя его мнениями, мыслями, страхами, причудами». Когда лучший способ притвориться человеком — это подражать нашим недостаткам и слабостям так же, как и нашим силам, победители тестов Тьюринга по-прежнему будут наименее пугающим результатом исследований искусственного интеллекта.

Как насчет музыкального теста Тьюринга? Может ли робот сочинить настолько гениальную песню, что она будет звучать так, как будто ее написал человек?

История теста Тьюринга

Тест Тьюринга является основным в истории ИИ. Это все еще

Это все еще

обсуждается и используется сегодня, несмотря на то, что ему почти 70 лет. Назван в честь своего

Создатель Алан Тьюринг, он проверяет интеллект машины.

В частности, тест Тьюринга проверяет способность машины

показать интеллект, неотличимый от человеческого поведения. Он измеряет этот человекоподобный

интеллект, основанный на разговорах на естественном языке. В тесте человек

оценщик имеет текстовые беседы как с человеком, так и с машиной. Если

оценщик не может отличить их друг от друга, машина прошла тест.

Но как этот основной продукт ИИ получил такое широкое распространение? Здесь мы оглядываемся на историю теста Тьюринга и дебаты вокруг него.

Алан Тьюринг: могут ли машины думать?

Алан Тьюринг, английский математик, изобрел теорию Тьюринга.

тест в 1950 году. Он представил эту меру в своей статье под названием Computing

Машины и разум. Статья посвящена машинному интеллекту,

вопрос, могут ли машины думать.

В своей ныне известной работе Тьюринг утверждал, что достаточно обученный компьютер может демонстрировать интеллект на уровне человека.

Сам тест взят из популярной в то время игры для вечеринок.

известная как «Игра в имитацию». Основываясь на этой игре, Тьюринг задал два вопроса

это привело бы к формированию теста Тьюринга.

- Что произойдет, если игрок, пытающийся обмануть следователя, окажется машиной?

- Что произойдет, если и игрок-машина, и игрок-человек попытаются обмануть следователя?

Игра-имитация

Итак, что же это была за игра, которую нарисовал тест Тьюринга?

из?

В имитационной игре участвуют три игрока: A, B и C. Игроки

А и Б — мужчина и женщина, которые сидят в разных комнатах. Игрок C является

следователь.

Задача игрока C состоит в том, чтобы задавать вопросы и определять, на основе типизированных ответов, которые они получают от A и B, какой игрок/пол находится в каждой комнате. Задача игрока А состоит в том, чтобы подражать противоположному полу и обманом заставить С дать неправильный ответ. Тем временем задача игрока Б состоит в том, чтобы отвечать как обычно, как бы помогая следователю.

Задача игрока А состоит в том, чтобы подражать противоположному полу и обманом заставить С дать неправильный ответ. Тем временем задача игрока Б состоит в том, чтобы отвечать как обычно, как бы помогая следователю.

Версия Тьюринга

Перенесенная на ИИ версия игры-имитации Тьюринга пытается проверить, можем ли мы определить, говорим ли мы с машинами или с людьми.

С одной стороны экрана компьютера сидит человек-судья. Работа этого судьи состоит в том, чтобы общаться с неизвестными собеседниками по другую сторону окна чата. Большинство участников будут людьми. Однако одним из них будет чат-бот, пытающийся обмануть судью, заставив его думать, что это настоящий человек.

Если машину (т. е. чат-бота) ошибочно принимают за человека более 30% времени во время пятиминутных разговоров по клавиатуре, она проходит тест.

Прохождение теста Тьюринга

С момента своего появления в 1950 году тест Тьюринга стал критерием для измерения интеллекта ИИ. Он использовался для тестирования первых чат-ботов ELIZA и PARRY в конце 60-х и начале 70-х годов. К 90-м годам он был включен в ежегодный конкурс — премию Лебнера.

Он использовался для тестирования первых чат-ботов ELIZA и PARRY в конце 60-х и начале 70-х годов. К 90-м годам он был включен в ежегодный конкурс — премию Лебнера.

Но потребуется более шестидесяти лет, чтобы машина, достаточно мощная, смогла пройти его.

В 2014 году чат-бот, выдававший себя за 13-летнего украинского мальчика, получил звание первой машины, прошедшей тест Тьюринга. Бот по имени Юджин Густман убедил треть судей, с которыми он разговаривал, в том, что он человек.

Но этот успех сопряжен с противоречиями. Недоброжелатели были

быстро отметить, что другие чат-боты убедили более высокий процент

судят, что они были людьми в прошлом. Например, Cleverbot в 2011 году, который

убежден 59% его судей.

Дальнейшие утверждения предполагают, что Юджин «прошел» тест Тьюринга

путем обмана. То есть, объясняя странные или запутанные ответы, заявляя, что

иностранный родной язык и молодой возраст.

Важно отметить, что многие утверждают, что Юджин не воплощает интеллект, о котором говорил Алан Тьюринг, когда вводил тест. Если бот демонстрирует не интеллект, а искусственную тупость, считается ли это?

Если бот демонстрирует не интеллект, а искусственную тупость, считается ли это?

Проблемы

Сам тест Тьюринга содержит некоторые проблемы из

начало. Например, многие утверждали, что тест дает ложный результат.

эквивалент. Он предполагает, что интеллект и человеческое поведение — одно и то же.

одно и тоже. Но есть разница между истинным интеллектом и человеческим интеллектом.

В результате тест Тьюринга может способствовать искусственному

глупость. Например, боты, которые выиграли соревнования, воспроизводя набор текста.

ошибки. Поскольку тест заключается в том, чтобы заставить людей думать, что бот — это человек,

целью становится мимикрия. (Вместо интеллекта и способностей.)

Тест Тьюринга также, возможно, бесполезен на практике. Не каждому инструменту ИИ для работы требуется обработка естественного языка. В этих случаях ИИ не нужно разговаривать с людьми, чтобы доказать свою сообразительность. Для этих инструментов тест Тьюринга малопригоден.

Или просто пишите точнее.

Или просто пишите точнее.