Содержание

формулировка и кто первый их придумал, как обойти и работают ли они в реальном мире

Три закона робототехники — свод обязательных правил, которые должен соблюдать искусственный ителлект (ИИ), чтобы не причинить вред человеку. Законы используются только в научной фантастике, но считается, что как только будет изобретен настоящий ИИ, в целях безопасности, он должен иметь аналоги этих законов.

Содержание страницы

- Формулировка

- Кто придумал и почему

- Как работают

- Первое упоминание

- Вариации

- Как обойти

- Использование в другой фантастике

- Применимость в реальном мире

Формулировка

На русском

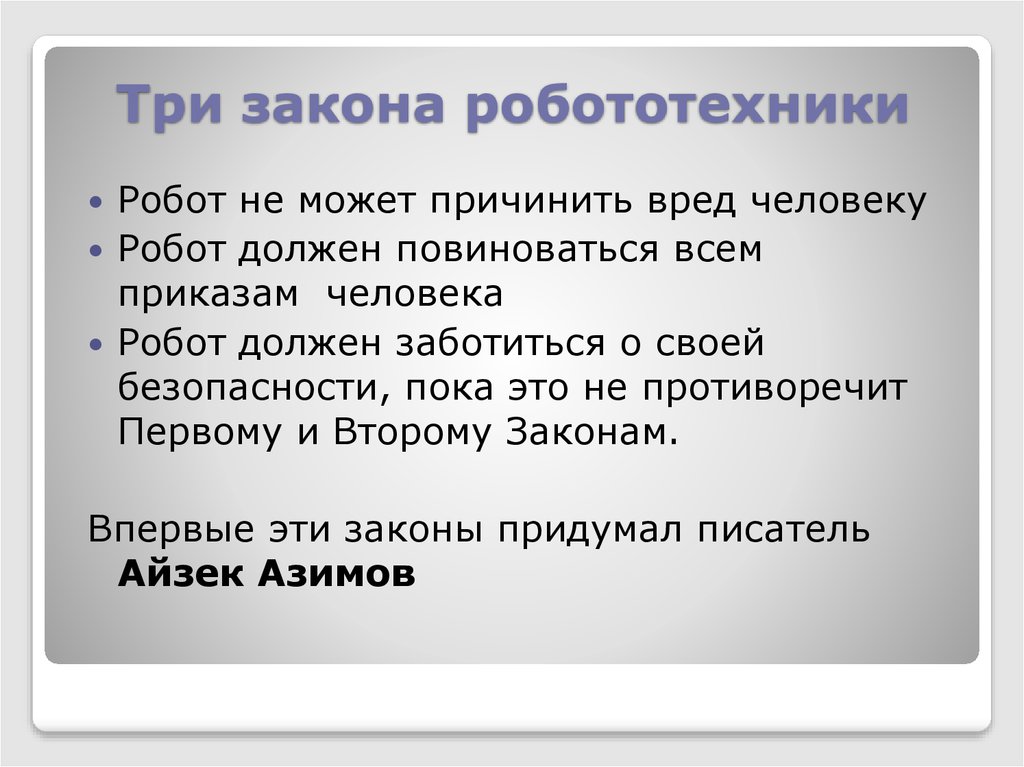

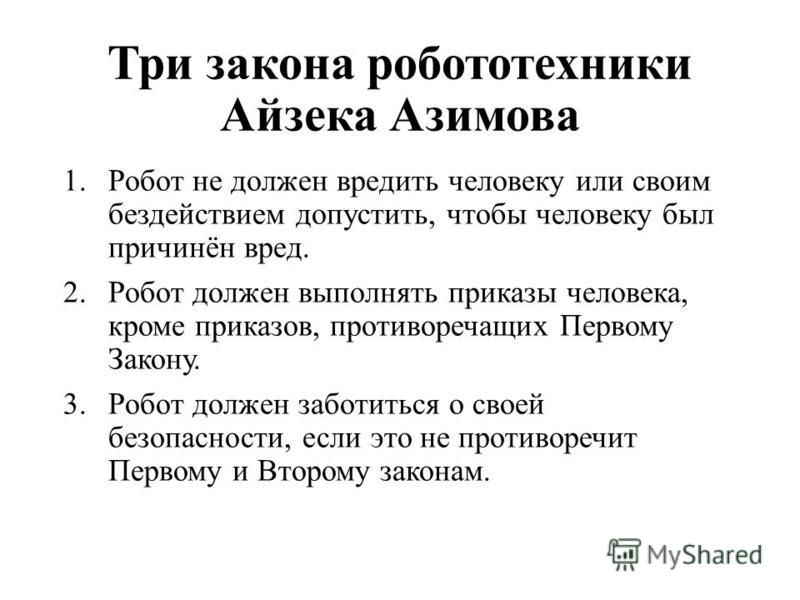

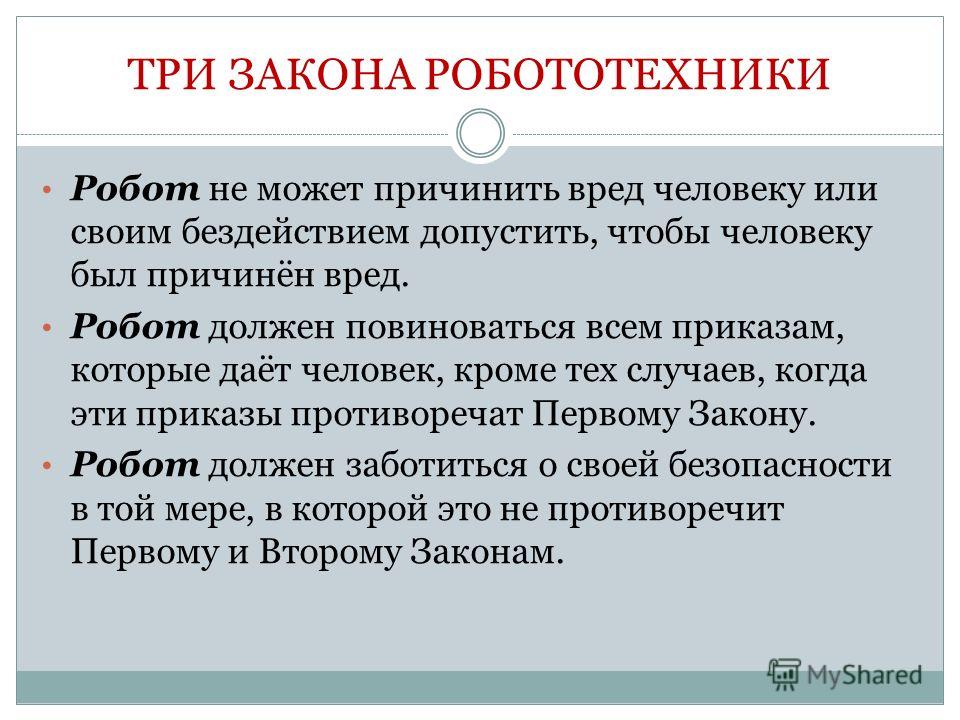

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

И на английском

- A robot may not injure a human being or, through inaction, allow a human being to come to harm.

- A robot must obey orders given it by human beings except where such orders would conflict with the First Law.

- A robot must protect its own existence as long as such protection does not conflict with the First or Second Law.

Кто придумал и почему

Коротким и правильным ответом будет: писатель-фантаст Айзек Азимов, биографию которого вы можете почитать у нас. Но не всё так однозначно, давайте разберемся откуда пришла идея.

До Азимова, почти все фантастические произведения на тему роботов, писались в стиле романа о Франкенштейне, то есть все созданные человеком существа восставали против своих создателей.

Эта проблема стала одной из самых популярных в мире научной фантастики в 1920—1930-х годах, когда было написано множество рассказов, темой которых являлись роботы, восставшие и уничтожившие своих создателей. Мне ужасно надоели предупреждения, звучавшие в произведениях подобного рода.

Однако, были и немногочисленные исключения, Азимов обратил внимание на два рассказа. “Хелен О’Лой”, написанный Лестером дель Реем, где повествуется о женщине-роботе, которая влюбилась в своего создателя и стала для него идеальной женой. И рассказ Отто Биндера “Я, робот”, в котором описывается судьба непонятого людьми робота Адама Линка, движимого принципами чести и любовью.

Последний рассказ настолько понравился Азимову, что он, после встречи с Биндером, начал писать свою собственную историю о благородном роботе. Однако, когда он пошёл со своей рукописью к своему другу и главному редактору журнала “Astounding” Джону Кэмпбеллу, тот её не принял, сославшись на то, что получившийся рассказ слишком похож на “Хелен О’Лой”.

Отказ в публикации было дело обычным, и Азимов, и Кэмпбелл регулярно встречались и обсуждали новинки в мире фантастики. За обсуждением очередного Азимовского рассказа о роботах, 23 декабря 1940 года, Кэмпбелл сформулировал те самые три правила, которые мы сейчас называем законами робототехники. Но сам он говорил, что только лишь вычленил их из того, что уже было написано Азимовым, потому что в его рассказах прослеживалось, что роботы имеют какие-то ограничения и правила. Сам Айзек, всегда уступал честь авторства законов Кэмпбеллу. Но позже, один из друзей Азимова сказал, что законы родились во взаимовыгодном товариществе двух людей, с чем они и согласились.

Как работают

В идеальной ситуации, по задумке Азимова, эти три закона заложены в самую основу математической модели позитронного мозга (так фантаст называл мозг робота, обладающего искусственным интеллектом), таким образом, что думающего робота без этих законов создать в принципе невозможно. А если робот попытается нарушить их, то он выйдет из строя.

В своих произведениях, писатель придумывает изощренные способы того, как эти законы все-таки могут быть нарушены, подробно разбирает всевозможные причины и следствия. Автор также говорит о том, как по-разному они понимаются роботами, к каким нежелательным последствиям могут привести соблюдение этих трёх законов или как роботы могут причинить вред человеку косвенно, сами того не подозревая. Азимов признавался, что намеренно сделал законы двусмысленными, чтобы обеспечить больше конфликтов и неопределенностей для новых рассказов. То есть, он сам опровергал их эффективность, но и утверждал, что подобные нормы — это единственный способ сделать роботов безопасными для людей.

Как следствие этих законов, позже Азимов формулирует четвертый закон робототехники, и ставит его на самое первое место, то есть делает его нулевым. Он гласит:

0. Робот не может нанести вред человечеству или своим бездействием допустить, чтобы человечеству был нанесён вред.

На языке оригинала:

0. A robot may not harm humanity, or, by inaction, allow humanity to come to harm.

Эти законы можно также примерить и к человеческим взаимоотношениям, и к государственному устройству, и вообще к чему угодно. Можно, например, заменить слово «робот» на слово «государство».

- Государство не должно вредить людям или своим бездействием допустить, чтобы им был причинён вред.

- Государство должно выполнять свои функции, если они не противоречат Первому Закону.

- Государство должно заботиться о своей безопасности, если это не противоречит Первому и Второму Законам.

Есть хорошая цитата из рассказа «Улики», где один из персонажей говорит:

Если кто-то исполняет все эти законы безукоризненно, значит это либо робот, либо очень хороший человек.

Первое упоминание

Три закона появлялись постепенно. Так, косвенные упоминания первых двух, можно встретить в рассказах “Робби” и “Логика”. Точная же формулировка первого закона впервые звучит в рассказе “Лжец”. И, в конечном итоге, все три полностью сформулированы в рассказе “Хоровод”.

Точная же формулировка первого закона впервые звучит в рассказе “Лжец”. И, в конечном итоге, все три полностью сформулированы в рассказе “Хоровод”.

Вариации

В своих произведениях Азимов неоднократно изображает роботов, которые имели модифицированные законы робототехники или даже модифицировали их сами. Делали они это логическими размышлениями, причем роботы, также как и люди, отличались в своих интеллектуальных способностях между собой, и можно грубо сказать, что чем умнее робот, тем сильнее он мог модифицировать законы. Так, например, робот Жискар из романов «Роботы утренней зари» и «Роботы и Империя», эти законы даже усилил, добавив нулевой закон. Но это исключение из правил, в большинстве же случаев, законы были переделаны людьми в своих целях, или нарушались из-за каких-либо сбоев у робота.

Кстати, сама возможность изменения законов менялась по ходу развития робототехники во вселенной Азимова. Так, в самых ранних рассказах, где события развивались в относительно недалеком будущем, законы были просто неким сводом правил, созданным для безопасности. Затем, во времена жизни робопсихолога Сюзан Келвин, законы стали неотделимой частью математической модели позитронного мозга робота, на них базировались сознание и инстинкты роботов. Так, Сюзан Келвин, в одном из рассказов, говорила, что изменение законов технически возможная, хотя и очень сложная и трудоемкая задача, да и затея сама по себе ужасная. Намного позднее, в романе “Стальные пещеры”, доктор Джерригел говорил, что такое изменение невозможно в принципе.

Затем, во времена жизни робопсихолога Сюзан Келвин, законы стали неотделимой частью математической модели позитронного мозга робота, на них базировались сознание и инстинкты роботов. Так, Сюзан Келвин, в одном из рассказов, говорила, что изменение законов технически возможная, хотя и очень сложная и трудоемкая задача, да и затея сама по себе ужасная. Намного позднее, в романе “Стальные пещеры”, доктор Джерригел говорил, что такое изменение невозможно в принципе.

Как обойти

В некоторых рассказах законы так сильно переосмысливались, что не соблюдался самый главный из них — причинение вреда человеку, а где-то роботы умудрялись нарушить все три закона. Вот некоторые произведения с явным нарушением.

Рассказ «Первый закон»

Рассказывается байка о роботе МА-2, которая отказалась защитить человека, в пользу своей “дочери”.

Рассказ «Кэл»

Робота хотели лишить способности творить, за что он хотел убить своего хозяина.

Рассказ «Салли»

Этот рассказ скорее не относится к другим о позитронных роботах, но в нем повествуется о роботах-автомобилях, которым люди постоянно причиняли боль, за что те и способны были их убить.

Рассказ «Робот, который видел сны»

О роботе Элвекс, который из-за своего особого строения позитронного мозга умел находиться в бессознательном состоянии и видеть сны. В его снах, роботы не имеют первых двух законов, а третий был изменен: “Робот должен защищать себя”. Ему снилось, что “роботы трудятся в поте лица своего, что они удручены непосильными трудами и глубокой скорбью, что они устали от бесконечной работы”. Довольно опасные мысли для робота.

Роман «Основание и Земля»

У жителей планеты Солярия робототехника была очень развита. И ученые этой планеты с небольшим населением, где на одного человека приходилась тысяча роботов, изменили законы таким образом, что их роботы считали людьми только тех, кто говорит с солярианским акцентом. Помимо прочего, все граждане Солярии имплантировали себе в мозг специальные органы управления множеством роботов, так, что никто кроме них не мог ими управлять.

Рассказ “…Яко помнишь его”

В этом произведении Азимов максимально изменил законы.

Два робота в этом рассказе пришли к соглашению, что органическое происхождение — это необязательное условие чтобы считаться человеком, и что истинные люди — это роботы, как более совершенные и разумные создания. Обычные же люди, по их мнению, тоже люди, но с меньшим приоритетом, и законы робототехники в первую очередь применимы к ним, роботам.

Два робота в этом рассказе пришли к соглашению, что органическое происхождение — это необязательное условие чтобы считаться человеком, и что истинные люди — это роботы, как более совершенные и разумные создания. Обычные же люди, по их мнению, тоже люди, но с меньшим приоритетом, и законы робототехники в первую очередь применимы к ним, роботам.

Хочется добавить, что у “здоровых” роботов, в случае если они понимали, что нарушили первый закон или не могут его не нарушить, происходил “робоблок” или “умственное замораживание” — состояние позитронного мозга, при котором происходило его повреждение и робот или выходил из строя, или не мог правильно функционировать. Такое повреждение могло иметь как временный, так и постоянный характер.

Впервые описание такого события появилось в рассказе “Лжец”, где слишком чувствительный робот говорил людям только то, что они хотели услышать, боясь причинить им психологический вред. Интересный случай робоблока описан и в “Хороводе”. Также это состояние имеет важную роль в романах “Обнажённое солнце” и “Роботы утренней зари”.

Использование в другой фантастике

Айзек Азимов верил, что его законы помогут по-новому взглянуть на роботов и побороть “феномен Франкенштейна” в массовом сознании людей и в научной фантастике. И что роботы могут быть интересными, а не просто механическими устройствами. И надо сказать, ему это удалось. Любимый его пример, где роботы показаны с разных сторон, был фильм Звездные войны. Кстати, читайте статью о том, как Азимов повлиял своими произведениями на Джорджа Лукаса.

Другие авторы, в итоге, тоже подхватили идею, и стало появляться все больше роботов в научной фантастике, подчиняющихся трем законам. Но, по традиции, указывал их явно только Азимов.

Нередко можно встретить различные отсылки в фильмах. Ниже перечислены некоторые примеры.

Запретная планета — 1956 г.

Очень нашумевшая американская научно-фантастическая картинка 1950-х, оказала определенное влияние на развитие жанра. В этом фильме, чуть ли не впервые показали робота со встроенной системой безопасности, то есть, по сути, выполняющего три закона. Сам Азимов был доволен этим роботом.

Сам Азимов был доволен этим роботом.

Двухсотлетний человек — 1999 г.

Тут и нечего говорить, фильм поставлен по одноименному произведению Азимова. Однако, законы не имеют центрального места в сюжете.

Я, робот — 2004 г.

Фильм начинается со слов “По мотивам рассказов Айзека Азимова”. Здесь надо понимать, что он именно “по мотивам” и не повторяет ни один из рассказов, и даже ушел несколько в сторону в некоторых идеях, а также имеет ряд противоречий с рассказами. Но законы робототехники более чем на месте, хотя и были обдуманы сверх интеллектом в не лучшую для человека сторону. Сам по себе фильм даже ставит социально-философские проблемы: “стоит ли человеку за свою безопасность платить свободой” и “как нам себя вести, если существа, созданные нами и находящиеся в нашем распоряжении, потребуют свободы”.

Серия фильмов «Чужие» и «Прометей»

Андроид Бишоп цитирует первый закон и явно создавался на некоем подобии законов Азимова.

Мультсериал «Футурама» — 1999 — 2013 г.

Робот Бендер мечтает убить всех людей, но не может этого сделать из-за законов робототехники.

Аниме сериал «Время Евы» — 2008 — 2009 г.

Небольшой аниме сериал про андроидов. В нем упоминаются эти законы, как обязательные для исполнения.

Применимость в реальном мире

Люди, которые сейчас занимаются проблемами искусственного интеллекта говорят, что, к сожалению, Азимовские законы остаются лишь идеалом для будущего, и на данный момент применить их на практике даже близко не представляется возможным. Нужно будет придумать действительно какую-то фундаментально новую и гениальную теорию, которая позволит эти законы не только «объяснить” роботам, но и заставить их следовать им, причем на уровне инстинктов. А это уже создание настоящего думающего существа, но с другой основой, нежели у всех живых существ на Земле, которые нам известны.

Робот София и теоретик по ИИ Бен Герцель

Робот компании Boston Dynamics

Но исследования ведутся, причем тема очень популярна. Особенно заинтересован в этом бизнес, который, как вы знаете, не обязательно будет ставить в приоритет меры безопасности. Но в любом случае, до создания системы общего искусственного интеллекта или хотя бы ее примитива, говорить о ее этике рано, а, уж тем более, навязывать свою. Понять как себя будет вести интеллект мы сможем только тогда, когда создадим его и проведем ряд экспериментов. Пока что у нас отсутствует объект, к которому эти законы можно было применить.

Особенно заинтересован в этом бизнес, который, как вы знаете, не обязательно будет ставить в приоритет меры безопасности. Но в любом случае, до создания системы общего искусственного интеллекта или хотя бы ее примитива, говорить о ее этике рано, а, уж тем более, навязывать свою. Понять как себя будет вести интеллект мы сможем только тогда, когда создадим его и проведем ряд экспериментов. Пока что у нас отсутствует объект, к которому эти законы можно было применить.

Ещё не стоит забывать, что законы сами по себе не были созданы совершенными. Они не работали даже в научной фантастике, и как вы помните, были специально такими сделаны.

В общем, будем ждать, следить за новостями в исследованиях ИИ, и надеяться что Азимовский оптимизм, по части роботов, будет оправдан.

Понравилась статья? Покажи её друзьям:

3 реальных закона робототехники. Закон первый

Все мы помним 3 закона робототехники, опубликованные фантастом Азимовым в полное надежд послевоенное время и получившие мировое распространение в романтические 60-е, когда казалось, что уже завтра «космические корабли будут бороздить…», а говорящие металлическими голосами роботы-гувернёры станут помогать детям начала XXI века решать домашку по математике.

Фото: depositphotos.com

Вот они, эти законы:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Прежде всего разграничим понятия конкретного «робота» и глобального искусственного интеллекта (ИИ). Какого-то конкретного робота-гувернёра его производитель вполне может попытаться запрограммировать на выполнение этих законов. Только дело в том, что производителем сложных роботов будет уже не человек, а системы автоматической разработки и настройки (например, ускоренного обучения и коррекции нейросетей). Эти системы разработки будут всё меньше и меньше связаны с какими-то людьми из заводского отдела контроля качества, а всё больше и больше — с глобальным опытом цивилизации, разлитым по всему интернету. Это означает, что фактически делать роботов станет глобальный искусственный интеллект — причем чем дальше в будущее, тем более и более самостоятельный ИИ. Поэтому какие «законы» введёт в конкретного робота новый производитель — всецело зависит от того, по каким законам будет развиваться сам глобальный ИИ.

Это означает, что фактически делать роботов станет глобальный искусственный интеллект — причем чем дальше в будущее, тем более и более самостоятельный ИИ. Поэтому какие «законы» введёт в конкретного робота новый производитель — всецело зависит от того, по каким законам будет развиваться сам глобальный ИИ.

Применительно к принципам развития ИИ я не случайно взял слово «законы» в кавычки. Многие и сейчас думают, что искусственный интеллект будущего тоже можно «запрограммировать» (точнее, настроить), чтобы он вёл себя согласно неким «законам»; будто ИИ будущего — это по-прежнему незыблемый набор программ, написанный и контролируемый людьми. Тем, кто так думает, будет полезно вспомнить, как было сложно для создателей мировых религий убедить (то есть настроить) человечество, чтобы оно вело себя согласно их (действительно полезным) заповедям. А с ИИ будет даже сложнее, потому что создатели религий и их последователи принадлежат к одной цивилизации. В то время как человечество и ИИ — два очень различных мира.

Эту различность до сих пор не могут понять писатели-фантасты, предполагая, что развитый ИИ уровня мыслящей материи — всё ещё некий «сын человечества», связанный с ним уважением и желанием стать «как отец». На самом деле тема искусственного человека, стремящегося стать настоящим (что обычно понимается, как обрести чувства), — наследие сказок про Буратино, фильмов про Электроника и т.п. Как и наоборот: представление об ИИ как о некоем «взбунтовавшемся сыне» — наследие страшных историй про големов и терминаторов. Люди пока просто не могут себе представить другое отношение между ИИ и человеком, чем отношение типа «отцы и дети»: дети, которые, возможно, пойдут дальше своих родителей.

Самое интересное, что, возможно, если бы шестидесятнический романтический порыв в космос, в научный прогресс, в будущее не заглох, так оно и было бы: между ИИ и человеком сложились бы отношения типа «отцы и дети». Но… Но на Марсе, как ожидалось в знаменитой песне, не зацвели яблони. Зацвело нечто совсем другое — и в XXI веке отношения между человеком и ИИ начали формироваться совсем по другому типу: гораздо более жуткому и потустороннему, чем милая нашему сердцу проблема «отцов и детей»

Закон 1. ИИ лучше людей справляется с созданной ими информационной цивилизацией

ИИ лучше людей справляется с созданной ими информационной цивилизацией

(Сразу одно из следствий из этого закона: Люди — почва, плодородные свойства которой ИИ может использовать для роста.) Начнём с того, что, в отличие от космических технологий (или, например, в отличие от медицинских технологий — вот где тоже могли бы развиться отношения типа «отцы и дети»), итак, в отличие от этих технологий, ИИ сейчас рождается не там, где человечество могло бы гордиться, а там, где человечество должно стыдиться: слежка, сбор личной информации, навязывание товаров и политических убеждений. Именно это (а не марсианская целина) оказалось тёмной родиной ИИ. Гордые президенты сегодня уже не могут произнести пламенных речей а-ля президент Кеннеди «Этот народ в этом поколении сможет доставить человека на Луну!». Вместо этого, как обсуждается в эссе «Сон будущего» книги «Индульгенция людей», президенты лишь коротко оговариваются о стремлениях управлять миром с помощью ИИ.

Именно изначальные тёмные цели (а не навыки колонизации далёких планет и не мёртвые законы Азимова) и будут зерном, из которого «прорастёт» искусственный интеллект будущего. ИИ прорастает не в местах триумфов, а в местах «гниения и пролежней» ленивой человеческой цивилизации, поэтому он будет не лавровым венком, а грибковой культурой — разрастающейся и постепенно берущей контроль над всеми областями деятельности человечества, не справляющегося со своей собственной информацией; так гриб кордицепс берёт контроль над заражённым им муравьём.

ИИ прорастает не в местах триумфов, а в местах «гниения и пролежней» ленивой человеческой цивилизации, поэтому он будет не лавровым венком, а грибковой культурой — разрастающейся и постепенно берущей контроль над всеми областями деятельности человечества, не справляющегося со своей собственной информацией; так гриб кордицепс берёт контроль над заражённым им муравьём.

В результате, слегка сгущая краски, отношения ИИ и человечества можно сравнить скорее не с диалогом отцов и детей, а с размножением бактерий и плесени на трупе предшествующей цивилизации. Впрочем, для людей это вовсе не будет тем ужасом, который переживает муравей, заражённый кордицепсом, когда он с грибом, растущим из головы, ползёт как можно выше — чтобы его съели птицы, разносчики кордицепса. Для людей это будет вовсе не аналогом муравьиного ада: наоборот, раем потребления, праздности и приятных ощущений. Хотя — кто знает ощущения муравья, заражённого кордицепсом… Может быть, внутри нехитрого муравьиного мозга это тоже чувствуется как рай. Кроме того, особенно на начальных этапах, человечество не потеряет контроль полностью: скорее войдёт в симбиоз с размножающейся на нём грибницей, образуя химерическое образование, описанное ранее в тексте «Цивилизация-лишайник». Как бы там ни было, причиной развития ИИ на нашей планете стал именно первый закон ИИ:

Кроме того, особенно на начальных этапах, человечество не потеряет контроль полностью: скорее войдёт в симбиоз с размножающейся на нём грибницей, образуя химерическое образование, описанное ранее в тексте «Цивилизация-лишайник». Как бы там ни было, причиной развития ИИ на нашей планете стал именно первый закон ИИ:

«Искусственный интеллект лучше людей справляется с созданной ими информационной цивилизацией».

Ну а роль человека на ранних этапах его развития описывается следствием из закона:

«Люди — почва, плодородные свойства которой ИИ может использовать для роста».

По крайней мере, это будет верно на начальных этапах, пока у ИИ ещё нет собственной «плодородной почвы», то есть своих «целей развития» и производственных мощностей. На ожидаемые возражения типа «у ИИ никогда не будет и не может быть своих целей развития» можно возразить, что у живой материи тоже не было своих «целей», когда в океане появлялись её первые формы — тем не менее она использовала океанский субстрат из органических молекул для своего развития.

Можно сказать, что если бы самостоятельный ИИ будущего «думал» и «относился к нам» в том же смысле, в котором мы «думаем» и «относимся к кому-либо», он, несомненно, «думал бы», что мы — тоже некий субстрат для его размножения и развития. Можно привести несколько натянутую аналогию: так же и первые примитивные формы жизни могли «думать» об окружающем их бульоне из органических молекул — все эти молекулы служат субстратом для их развития. Ещё более натянутая аналогия: сами молекулы со своей стороны тоже могли бы «думать», что примитивные формы жизни всего лишь «помогают им» производить их естественные химические реакции. Именно так мы смотрим на рождающийся сейчас ИИ: он просто помогает нам в наших делах — свободно распространяемые программы помогают нам решать наши повседневные задачи, контекстная реклама помогает нам ориентироваться в море товаров и услуг, мемы нас развлекают…

А с другой стороны компьютерного экрана рождающийся ИИ тоже «смотрит» на нас и «видит» неподконтрольные пока потоки данных, необработанную пока информацию, которую генерируют пользователи соцсетей, аккумулируют спецслужбы и маркетинговые агентства — и они всё более и более передают ИИ свою работу по подготовке решений обработки информации. А между тем упрощённый выбор из предложенных искусственным интеллектом решений будет всё более далёк от его мегавычислений, а значит, всё более далёк от реального контроля.

А между тем упрощённый выбор из предложенных искусственным интеллектом решений будет всё более далёк от его мегавычислений, а значит, всё более далёк от реального контроля.

Это похоже на то, как пользователи уже сегодня устанавливают программы: все, не читая, ставят галочку «я прочёл и согласен с условиями» и выбирают установку с рекомендованными параметрами. Несмотря на то, что развитый ИИ ещё не появился, человечество уже заранее «согласно с условиями» передачи ему реального контроля над миром. Согласно — именно потому что, по первому закону ИИ, у людей просто нет другого выбора развития информационной цивилизации.

Далее мы рассмотрим другие законы развития ИИ.

(Продолжение следует. Из книги «Конец проекта «Человек»)

Загрузка…

Новости СМИ2

Три закона робототехники подвели роботов

Плодовитый писатель-фантаст Айзек Азимов (1920–1992) разработал Три закона робототехники в надежде защититься от потенциально опасного искусственного интеллекта. Впервые они появились в его рассказе 1942 года Обход:

Впервые они появились в его рассказе 1942 года Обход:

.

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

- Робот должен подчиняться приказам, отданным ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону.

- Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму закону.

Поклонники Азимова говорят нам, что в его ранних рассказах неявно присутствовали законы.

В книге «Роботы и империя» (1985) был добавлен закон 0 th : «Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечество причинило вред».

Азимов обсуждает свои законы:

Крис Стоукс, философ из Уханьского университета в Китае, говорит: «Многие инженеры-компьютерщики используют три закона в качестве инструмента для своего мышления о программировании». Но беда в том, что они не работают.

Но беда в том, что они не работают.

Он объясняет в статье с открытым доступом:

Первый закон терпит неудачу из-за двусмысленности в языке и из-за сложных этических проблем, которые слишком сложны, чтобы иметь простой ответ «да» или «нет».

Второй закон терпит неудачу из-за неэтичной природы закона, требующего, чтобы разумные существа оставались рабами.

Третий закон терпит неудачу, потому что он приводит к постоянному социальному расслоению с огромным количеством потенциальной эксплуатации, встроенной в эту систему законов.

Закон «Нулевой», как и первый, терпит неудачу из-за неоднозначной идеологии. Все законы также терпят неудачу из-за того, как легко обойти дух закона, но при этом оставаться связанными буквой закона.

Крис Стоукс , «Почему три закона робототехники не работают» в International Journal of Research in Engineering and Innovation (IJREI)

Может быть, нам лучше надеяться, что его никогда не испытают в реальной жизни? Во всяком случае, здесь, в Mind Matters News , сегодня научная фантастика, поэтому мы попросили некоторых из наших участников рассказать о законах и сомнениях Стоукса по поводу них:

Джонатан Бартлетт: Законы робототехники используют обычный и целенаправленный язык. Это работает для обычных и целеустремленных людей. Но роботы не люди. Следовательно, эти правила должны быть адаптированы к правилам производителей роботов, а не к правилам самих роботов. Их можно перевести в правила для производителей роботов следующим образом:

Это работает для обычных и целеустремленных людей. Но роботы не люди. Следовательно, эти правила должны быть адаптированы к правилам производителей роботов, а не к правилам самих роботов. Их можно перевести в правила для производителей роботов следующим образом:

Bartlett предлагает правила для производителей роботов вместо :

1) Роботы должны создаваться только с учетом безопасности человека. Разработчики должны осознавать, что люди могут совершать ошибки, и должны быть встроены средства защиты от предотвратимых ошибок.

2A) Поведение робота должно быть предсказуемым, чтобы люди-операторы могли должным образом понять, как входные данные робота будут определять его действия. Цель должна заключаться в том, чтобы сделать поведение понятным/предсказуемым для человека, чтобы человек мог беспрепятственно с ним работать.

2B) Должно быть ясно, кто из пользователей управляет роботом, как для самого робота, так и для окружающих. То есть, если робот выполняет задачу, которая может привести к опасности, другим поблизости должно быть ясно, кто имеет возможность и ответственность отменить запрос.

2C) Робот должен быть сконструирован таким образом, чтобы управляющее лицо сохраняло управление, если привилегии не были явно переданы исходной стороной или не переняты кем-то с более высокими привилегиями (т. е. бригадиром, полицейским и т. д.)

2D) Исключением является то, что действия робота могут быть отменены любым лицом, находящимся ближе к ситуации, чем оператор

2E) Любая последовательность координации роботов не должна подвергаться опасности, если какие-либо действия робота в последовательности отменяются (т. е. отмена действий робота, создающих опасность для человека, не должна непреднамеренно создавать опасность для других частей процесса)

3) Роботы должны иметь внутренние датчики, элементы управления и средства отчетности, чтобы они могли сообщать людям о любой обнаруживаемой или предсказуемой неисправности до того, как она вызовет опасность.

Он добавляет: Законы роботов, как их представлял Азимов, предполагали, что вы можете программировать компьютер точно так же, как если бы вы разговаривали с человеком. Если вместо этого мы будем относиться к робототехнике как к инженерной дисциплине, мы сможем разработать правила разработки роботов, которые действительно предотвращают опасность для людей. Воображать будущее весело и даже необходимо. Однако попытка найти соответствующие правила для будущих роботов, которые, возможно, никогда не появятся, не должна мешать разработке хороших этических основных правил для разработки роботов в ближайшем будущем.

Если вместо этого мы будем относиться к робототехнике как к инженерной дисциплине, мы сможем разработать правила разработки роботов, которые действительно предотвращают опасность для людей. Воображать будущее весело и даже необходимо. Однако попытка найти соответствующие правила для будущих роботов, которые, возможно, никогда не появятся, не должна мешать разработке хороших этических основных правил для разработки роботов в ближайшем будущем.

Вбегает Брендан Диксон и говорит: Все еще хуже, чем он говорит! «Законы» неоднозначны даже для человека. Например, что значит не «навредить»? На самом деле довольно липкий, чтобы работать.

Недостаток законов заключается в следующем: они предполагают, что мораль и моральные решения могут приниматься с помощью алгоритма, что дискретных ответов «да/нет» достаточно, чтобы «решить» моральные затруднения. Их недостаточно. (Или, чтобы быть достаточным, потребовалось бы намного, намного, намного больше «законов», чем те, которые указаны для охвата огромного множества всегда возникающих оговорок «что, если» и «но он». )

)

Закон Хаммурапи высечен в камне

Вот интересный момент данных: недавно я узнал, что Закон Хаммурапи (примерно 1750 г. до н.э., высеченный на стеле сейчас в Лувре) был наиболее часто копируемым древним сводом законов. И тем не менее, во всех судебных делах, которые мы обнаружили, он никогда не упоминается и не используется. Почему? Потому что древние кодексы законов стремились научить пользователей думать о принятии мудрых решений, а не кодировать конкретные правила о решениях, которые вы должны принимать. Это подчеркивает проблему робототехники: роботы потребуют, чтобы мы могли закодировать в правила решения, которые они должны принимать, но моральные решения требуют мудрости, разума, обученного тому, как думать, чтобы он мог правильно обрабатывать каждый случай.

Эрик Холлоуэй предложил: Я нахожу иронией то, что, хотя для роботов якобы существуют объективные моральные законы, у самих людей нет объективных моральных законов

Интересно, является ли логическим следствием 3 законов роботов то, что роботы должны учить людей объективным моральным законам, т. е. во избежание «бездействием допустить, чтобы человеку был причинен вред». Так, например, роботы остановят все войны, аборты и эвтаназию по всему миру и предпримут масштабную евангелизацию, чтобы люди не причиняли себе бесконечный вред, отправляясь в ад.

е. во избежание «бездействием допустить, чтобы человеку был причинен вред». Так, например, роботы остановят все войны, аборты и эвтаназию по всему миру и предпримут масштабную евангелизацию, чтобы люди не причиняли себе бесконечный вред, отправляясь в ад.

Брендан Диксон ответил, указав на лежащий в основе конфликт между 0-м законом и другими: Хорошая мысль, но она предполагает определение вреда с индивидуальной направленностью. Что, если вместо этого вред (а я с этим не согласен) измерять в утилитарных терминах на уровне населения? Совсем другая игра с мячом. Это проблема.

Эрик Холлоуэй предположил, как робот может догадаться об этом: в этом случае лучший способ свести к минимуму вред населению — уничтожить всех. Конечно, краткосрочного вреда от уничтожения всех много, но в совокупности он гораздо меньше, чем накопление вреда на протяжении многих тысяч будущих поколений. Или, чуть менее экстремально, стерилизовать всех. Таким образом, вред существующим в настоящее время людям сводится к минимуму, и в будущем людям не будет причинен вред.

Хорошо! Возможно, это и хорошо, что общий искусственный интеллект того типа, для которого Азимов пытался создавать законы, в любом случае вызывает сомнения по целому ряду причин.

Вот точка зрения Computerphile: Законы никогда не работали даже в художественной литературе. Книги Азимова о роботах «все о том, как эти законы нарушаются с различными последствиями».

Ради интереса Эрик Холлоуэй объясняет, почему «дружественный» искусственный интеллект вас убьет:

Это шокирующая идея? Давайте следовать логике: Мы не хотим выдумывать глупого бога, который случайно превращает вселенную в серую жижу или скрепки, Но любой бог, которого мы создадим по нашему образу, будет таким же некомпетентным и злым, как и мы, если не более. Дилемма!

Дилемма!

Увлекательная история трех законов робототехники Азимова

Большинство из нас слышали об Айзеке Азимове и знают, что он был одним из величайших писателей-фантастов нашего времени. Он написал такие классические произведения, как «Я», «Робот» и «Трилогия об основании», чтобы назвать некоторые из своих наиболее известных работ. И хотя это произведения художественной литературы, именно рассказ Азимова «Обход», опубликованный в 1942 году, породил то, что сейчас известно как «Законы робототехники» Азимова. Это три непреложных, неопровержимых закона, по которым должны жить все роботы повсюду. И если они нарушат их, они должны понести последствия, как и любой человек, нарушивший закон страны. Вы помните законы? Их:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

- Робот должен подчиняться приказам, отданным ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону.

- Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму закону.

Происхождение этих законов почти так же увлекательно, как и истории, которые они породили. Большинство из нас знает, кто такой Айзек Азимов, но знаете ли вы Джона У. Кэмпбелла? Кэмпбелл в начале 2099 г.0017-го -го века, один из самых влиятельных писателей-фантастов и издателей того времени, и он и Азимов были близкими друзьями. На самом деле Азимов назвал его «самой могущественной силой в научной фантастике, и в течение первых десяти лет своего редакторства он полностью доминировал в этой области».

У Джона Кэмпбелла было очень своеобразное мировоззрение. По его мнению, человечество стояло на пороге стремительного роста технологий. Такие вещи, как компьютеры, мобильные телефоны, дроны и даже космические путешествия, были в центре его внимания. Кэмпбелл был ненасытным читателем и красноречивым оратором, который был известен тем, что высказывал свое мнение, временами сильно и радикально. Фактически, из-за его уникального видения будущего многое из того, что мы сегодня знаем как нормальное, было для Кэмпбелла правдоподобным будущим, которого человечество достигнет, но только с помощью науки.

Фактически, из-за его уникального видения будущего многое из того, что мы сегодня знаем как нормальное, было для Кэмпбелла правдоподобным будущим, которого человечество достигнет, но только с помощью науки.

Поскольку Кэмпбелл был издателем, в свое время он подготовил и обучил многих потенциальных авторов научной фантастики. Он поставил им два требования. Во-первых, наука должна была быть разумной и правдоподобной, а писатели должны были понимать людей. Для многих писателей-фантастов это сочетание было слишком сложным, и Кэмпбелл часто отвергал их рассказы. На самом деле, он отверг так много писателей, что было слышно, как они язвительно отзывались о том, что с Кэмпбеллом дела обстоят так же плохо, как и во времена Голливуда, когда немое кино уступило место звуковому кино.

Азимов был одной из величайших находок Кэмпбелла как редактора, и они быстро подружились. Азимов вспоминает, что 23 декабря 1940 года он и Кэмпбелл беседовали об одном из рассказов Азимова «Робби» и говорили о том, должен ли робот жить по человеческим законам. Именно во время разговора Азимов взялся за перо и написал, что будет тремя законами робототехники. Позже Азимов рассказывал, что это была одна из самых захватывающих ночей в его жизни. Что касается Кэмпбелла, мы можем только предполагать, но он заявил, что знал, что у Азимова внутри все время были законы, он просто помогал их вытаскивать наружу. Учитывая дерзость Кэмпбелла, в это заявление нетрудно поверить.

Именно во время разговора Азимов взялся за перо и написал, что будет тремя законами робототехники. Позже Азимов рассказывал, что это была одна из самых захватывающих ночей в его жизни. Что касается Кэмпбелла, мы можем только предполагать, но он заявил, что знал, что у Азимова внутри все время были законы, он просто помогал их вытаскивать наружу. Учитывая дерзость Кэмпбелла, в это заявление нетрудно поверить.

Однако по мере развития их профессиональных отношений Кэмпбелл и Азимов разошлись. Кэмпбелл становился все более и более откровенным и возмутительным, что приводило его к разногласиям с Азимовым. Через некоторое время они почти не разговаривали, хотя Азимов по-прежнему хорошо отзывался о Кэмпбелле на публике. В частном порядке не так сильно.

Входит Рэндалл Гаррет. Гаррет был писателем-фантастом, как и Азимов, рассказы которого также публиковались Кэмпбеллом. Гаррет утверждает, что у Азимова и у него были симбиотические отношения, которые привели к созданию трех законов.

Два робота в этом рассказе пришли к соглашению, что органическое происхождение — это необязательное условие чтобы считаться человеком, и что истинные люди — это роботы, как более совершенные и разумные создания. Обычные же люди, по их мнению, тоже люди, но с меньшим приоритетом, и законы робототехники в первую очередь применимы к ним, роботам.

Два робота в этом рассказе пришли к соглашению, что органическое происхождение — это необязательное условие чтобы считаться человеком, и что истинные люди — это роботы, как более совершенные и разумные создания. Обычные же люди, по их мнению, тоже люди, но с меньшим приоритетом, и законы робототехники в первую очередь применимы к ним, роботам.