Содержание

Психологическая правда законов Азимова

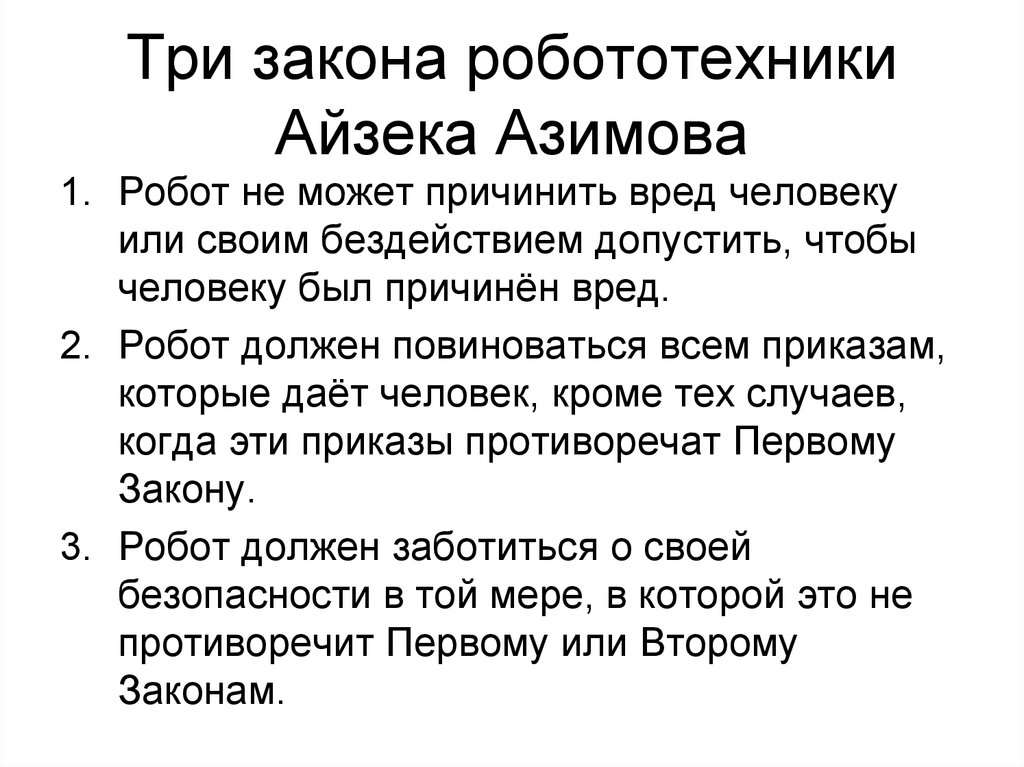

Три зако́на роботехники в научной фантастике — обязательные правила поведения для роботов, впервые сформулированные Айзеком Азимовым в рассказе «Хоровод» (1942). Законы гласят:

1) Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

2) Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

3) Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Мне эти хорошо отшлифованные принципы кажутся очень ценными с позиций психологии и организации общества.

То, что описываемое Азимовым в целом ряде произведений (и довольно подробно) общество поляризовано и напоминает рабовладельческое — прозрачно любому читающему и упоминается самим автором. Хотя я бы уточнил, что «часть» «общества» — роботы — за пределы общества в общем вынесена. Строго говоря, роботы это не люди, а люди это не роботы — так заявлено с самого начала. Однако читатель упорно испытывает ощущение, что эти «механизмы» — живые и одушевленные. То же подчеркивает и неотличимый от человеческого внешний вид (какой смысл для народного хозяйства скрывается в такой фиче?). На противопоставлении похожих непохожестей построен ряд сюжетных линий — бессмертных со времён древнегреческого театра. Кому жить, кому умереть, в какой пропорции и тому подобное…

Строго говоря, роботы это не люди, а люди это не роботы — так заявлено с самого начала. Однако читатель упорно испытывает ощущение, что эти «механизмы» — живые и одушевленные. То же подчеркивает и неотличимый от человеческого внешний вид (какой смысл для народного хозяйства скрывается в такой фиче?). На противопоставлении похожих непохожестей построен ряд сюжетных линий — бессмертных со времён древнегреческого театра. Кому жить, кому умереть, в какой пропорции и тому подобное…

Что отличает эти две касты? Почти все. Они определяются своей обратностью. Т.е. противопоставлены во многом, поэтому и общество поляризовано. Роботы сильны, неограниченно интеллектуальны, неуязвимы, не стареют, неутомимы и едва ли не бессмертны. Люди… несколько другие в этом отношении. Но при этом именно они «у пульта управления» — их воля стоит всего, что не их жизнь (см. Законы). Имеет место как бы резкое расслоение при крайне неравномерном распределении благ: целеполагание и управление отдано хлипким людям, а служат ему — всемогущие роботы. Это означает и бесправие — прихоть человека перевешивает сохранение робота, ранг закона 2 выше закона 3.

Это означает и бесправие — прихоть человека перевешивает сохранение робота, ранг закона 2 выше закона 3.

Почему бы роботу не обойти этот такой жестокий в отношении него закон? На этом тоже держится немало азимовских драм. Потому что он так запрограммирован. Программа и есть законы Азимова — очень простые и в робота прошитые. А менять свой собственный исходный код роботу не полагается. Вроде как.

При этом роботам мы только и делаем что сопереживаем. Весь сюжет (да и многие подобные, включая «Бегущего по лезвию») роботы выглядят несправедливо лишенными права на свободу, любовь, выбор, самостоятельно избранную игру. Но на ненависть — первым делом: от ненависти и агрессии надлежит избавится прежде всего. Она — способ робота выбраться из этой несвободы. Они выглядят лишенными души, одним словом. «Бездушная машина», как известно. Люди же наделены душой и ее вторичными атрибутами по праву рождения — своеобразного волшебства, наделенного такими дарами. По сути наделение душой сводится к самоуправству — «наделяю-отберу если захочу, кто мне помешает?»

За внешней тканью сюжета в глубоких произведениях всегда скрывается скрывается простое, человеческое, эмоциональное. И здесь его несложно вытащить наружу. Я вижу в работах людей, души лишенных (!) на основе чужой прихоти и соответствующего внушения. Затверженного поражения в правах. Так рождаются строчки разворачивающего человека против самого себя кода. Никакого питона для этого не нужно — такие строчки достаточно произнести ребенку. Берутся же эти строчки из раннего детского опыта и слов родителя или «родителя». Никак не из эволюции, генов или боже упаси бога. Ребенок — мощное записывающее устройство; услышанное он, однако, воспринимает буквально. Именно поэтому худшее на свете преступление — преступление в отношении ребенка, не развившего навык ставить под сомнение и отвергать слышимое.

И здесь его несложно вытащить наружу. Я вижу в работах людей, души лишенных (!) на основе чужой прихоти и соответствующего внушения. Затверженного поражения в правах. Так рождаются строчки разворачивающего человека против самого себя кода. Никакого питона для этого не нужно — такие строчки достаточно произнести ребенку. Берутся же эти строчки из раннего детского опыта и слов родителя или «родителя». Никак не из эволюции, генов или боже упаси бога. Ребенок — мощное записывающее устройство; услышанное он, однако, воспринимает буквально. Именно поэтому худшее на свете преступление — преступление в отношении ребенка, не развившего навык ставить под сомнение и отвергать слышимое.

Та самая ситуация из стиха, в котором «словом можно убить».

Азимов метафорически описал проблему, но решений не предлагает. Разве кто-то у него взбунтовался и кого-то поубивал — уже неплохо. А я вот попробую. Если кто-то некоторый код создал со своими корыстными целями, значит кто-то другой может этот код увидеть и изменить. Нажмите ctrl +shift+c для подобного чуда. Видимо, это означает свободу от участи вечно выбрасывать угловую скобку в ожидании чужих команд.

Нажмите ctrl +shift+c для подобного чуда. Видимо, это означает свободу от участи вечно выбрасывать угловую скобку в ожидании чужих команд.

Правительство РФ творчески переработало законы робототехники Азимова. Робот может бездействовать в опасной для человека ситуации, но должен чтить Конституцию

разбор

Источник: Meduza

Антон Новодережкин / ТАСС / Sipa / Vida Press

Правительство РФ приняло «Концепцию развития регулирования отношений в сфере технологий искусственного интеллекта и робототехники до 2024 года». Концепция предусматривает, что развитие таких технологий «должно основываться на базовых этических нормах». Эти нормы перечислены в концепции. Некоторые из них очень похожи на знаменитые законы робототехники, сформулированные писателем-фантастом Айзеком Азимовым. Мы сравнили законы робототехники Азимова с этическими нормами, предложенными правительством.

Приоритет благополучия и безопасности человека, защиты его основополагающих прав и свобод (цель обеспечения благополучия и безопасности человека должна преобладать над иными целями разработкии применения систем искусственного интеллекта и робототехники)

1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред

Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред

Запрет на причинение вреда по инициативе систем искусственного интеллекта и робототехники (по общему правилу следует ограничивать разработку, оборот и применение систем искусственного интеллекта и робототехники, способных по своей инициативе целенаправленно причинять вред человеку)

2. Робот должен повиноваться всем приказам, которые дает человек, кроме тех случаев, когда эти приказы противоречат первому закону

Подконтрольность человеку (в той мере, в которой это возможно с учетом требуемой степени автономности систем искусственного интеллекта и робототехники и иных обстоятельств)

3. Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит первому или второму законам

Проектируемое соответствие закону, в том числе требованиям безопасности (применение систем искусственного интеллекта не должно заведомо для разработчика приводить к нарушению правовых норм)

Недопущение противоправной манипуляции поведением человека

- Разработчики концепции взяли только половину первого закона робототехники Азимова.

В России робот может спокойно наблюдать за гибелью людей: ему только запрещено целенаправленно вредить им.

В России робот может спокойно наблюдать за гибелью людей: ему только запрещено целенаправленно вредить им. - В концепции правительства совсем нет аналога третьего закона робототехники Азимова. Роботам не вменяется в обязанность забота о собственной безопасности.

- Наконец, искусственный интеллект должен действовать в рамках закона. Например, чтить обновленную Конституцию — в частности, ему нельзя будет призывать к отчуждению части территории РФ. То есть разработчикам роботов-помощников вроде Siri и «Алисы» придется проверять, как их детище отвечает на вопрос: «Чей Крым?»

Денис Дмитриев

Нужны ли нам законы Азимова?

Вычислительная техника

Поскольку роботы все больше присутствуют в повседневной жизни, естественно возникает вопрос о том, как контролировать их поведение. У Азимова есть ответ?

By

- Emerging Technology from the arXivarchive page

16 мая 2014 г.

В 1942 году писатель-фантаст Айзек Азимов опубликовал рассказ под названием Runaround, в котором он ввел три закона, управляющие поведением роботов. Эти три закона таковы:

1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

2. Робот должен подчиняться приказам, отдаваемым ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону.

3. Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму закону.

Позже он ввел четвертый или нулевой закон, который превзошел остальные:

0. Робот не может причинить вред человечеству или своим бездействием позволить человечеству причинить вред.

С тех пор законы робототехники Азимова стали ключевой частью культуры научной фантастики, которая постепенно стала мейнстримом.

В последние годы робототехники добились быстрого прогресса в технологиях, которые приближают вид продвинутых роботов, которые предвидел Азимов. Все чаще роботы и люди работают вместе на заводах, водят автомобили, летают на самолетах и даже помогают по дому.

Все чаще роботы и люди работают вместе на заводах, водят автомобили, летают на самолетах и даже помогают по дому.

Возникает интересный вопрос: нужен ли нам набор азимовских законов, управляющих поведением роботов по мере их развития?

Сегодня мы получили своеобразный ответ от Ульрике Бартельмесс и Ульриха Фурбаха из Университета Кобленца в Германии. Эти ребята рассматривают историю роботов в обществе и утверждают, что наши опасения по поводу их способности уничтожить нас необоснованны. Из-за этого законы Азимова не нужны, говорят они.

Слово «робот» происходит от чешского слова robota, означающего «принудительный труд», впервые появившегося в 1924 году в пьесе чешского писателя Карела Чапека. После этого англизированная версия быстро распространилась вместе с идеей о том, что эти машины могут слишком легко уничтожить своих создателей, — тема, которая с тех пор стала распространенной в научной фантастике.

Но Бартелмесс и Фурбах утверждают, что этот страх перед машинами укоренен гораздо глубже в нашей культуре. Хотя в научно-фантастических рассказах часто используются сюжеты, в которых роботы уничтожают своих создателей, эта тема имеет долгую историю в литературе.

Хотя в научно-фантастических рассказах часто используются сюжеты, в которых роботы уничтожают своих создателей, эта тема имеет долгую историю в литературе.

Например, в «Франкенштейне» Мэри Шелли монстр, сделанный из частей человеческого тела, восстает против Франкенштейна, своего создателя, потому что он отказывается сделать себе пару для монстра.

Еще есть повествование о еврейском Големе 16-го века, в одной из версий которого раввин конструирует существо из глины для защиты общины, обещая деактивировать его после субботы. Но раввин забывает, и голем превращается в монстра, которого нужно уничтожить.

Бартельмесс и Фурбах утверждают, что религиозный подтекст обеих этих историй заключается в том, что людям запрещено вести себя как Бог. И что любая попытка сделать это всегда будет наказана создателем.

Подобные эпизоды появляются в греческой мифологии, где люди, демонстрирующие высокомерие по отношению к богам, также наказываются, такие как Прометей и Ниоба. Вот почему истории такого рода являются частью нашей культуры, насчитывающей тысячи лет. Именно на этом глубоко укоренившемся страхе писатели-фантасты играют в рассказах о роботах.

Вот почему истории такого рода являются частью нашей культуры, насчитывающей тысячи лет. Именно на этом глубоко укоренившемся страхе писатели-фантасты играют в рассказах о роботах.

Конечно, между людьми и машинами случаются настоящие конфликты. Во время промышленной революции в Европе, например, существовал большой страх перед машинами и их очевидной способностью изменять мир таким образом, что это оказало глубокое влияние на многих людей.

Бартелмесс и Фурбах отмечают, что в 18 веке в Англии люди начали движение за уничтожение ткацких станков, которое стало настолько серьезным, что парламент объявил уничтожение станков преступлением, караемым смертной казнью. Группа, известная как луддиты, даже боролась с британской армией по этим вопросам. «Была своего рода технофобия, которая вылилась в бои с машинами», — говорят они.

Конечно, вполне возможно, что аналогичный антагонизм может развиться по отношению к новому поколению роботов, которым предстоит взять на себя часто повторяющиеся задачи, выполняемые в настоящее время людьми на фабриках по всему миру и, в частности, в Азии.

Однако в Азии совсем другое отношение к роботам. Такие страны, как Япония, лидируют в разработке роботов для автоматизированных заводов и в качестве помощников человека, отчасти из-за старения населения Японии и хорошо известных проблем со здоровьем, которые это вызовет в недалеком будущем.

Это отношение, возможно, воплощено в Astro Boy, вымышленном роботе, который в 2007 году был назначен Министерством иностранных дел Японии посланником Японии по вопросам безопасного путешествия за границу.

По этим причинам Бартелмесс и Фурбах утверждают, что в отношении роботов мы боимся не возможности того, что они захватят и уничтожат нас, а возможности того, что другие люди будут использовать их, чтобы разрушить наш образ жизни способами, которые мы не можем контролировать.

В частности, они отмечают, что многие роботы будут защищать нас по замыслу. Например, автоматизированные транспортные средства и самолеты разрабатываются таким образом, чтобы управлять ими и летать было безопаснее, чем это когда-либо могли сделать люди-операторы. Таким образом, мы будем безопаснее использовать их, чем не использовать их.

Таким образом, мы будем безопаснее использовать их, чем не использовать их.

Важным исключением является растущее число роботов, специально предназначенных для убийства людей. США, в частности, используют дроны для точечных убийств в зарубежных странах. Законность, не говоря уже о морали, этих действий до сих пор является предметом ожесточенных споров.

Но Бартелмесс и Фурбах подразумевают, что люди по-прежнему несут полную ответственность за эти убийства и что международное право, а не законы Азимова, должно быть в состоянии справляться с возникающими проблемами или адаптироваться для этого.

Они заканчивают свое обсуждение, рассматривая потенциальное сближение между людьми и роботами в ближайшем будущем. Идея заключается в том, что люди будут внедрять в свои тела различные технологии, такие как дополнительная память или вычислительная мощность, и поэтому в конечном итоге сольются с роботами. В этот момент повседневному праву придется справляться с поведением и действиями обычных людей, и законы Азимова устареют.

Интересный спор, который вряд ли будет разрешен в ближайшее время. Дополнительные просмотры в разделе комментариев, пожалуйста.

Ссылка: arxiv.org/abs/1405.0961 : Нужны ли нам законы Азимова?

от Emerging Technology from the arXiv

Глубокое погружение

Компьютеры

Китайские чипы продолжат питать вашу повседневную жизнь устаревшие чипы для обычных устройств.

Что будет дальше в области кибербезопасности

«Когда дело доходит до полного отключения программ-вымогателей от их источника, я думаю, мы сделали шаг назад».

Оставайтесь на связи

Иллюстрация Роуз Вонг

Узнайте о специальных предложениях, главных новостях,

предстоящие события и многое другое.

Введите адрес электронной почты

Политика конфиденциальности

Спасибо за отправку вашего электронного письма!

Ознакомьтесь с другими информационными бюллетенями

Похоже, что-то пошло не так.

У нас возникли проблемы с сохранением ваших настроек.

Попробуйте обновить эту страницу и обновить их один раз

больше времени. Если вы продолжаете получать это сообщение,

свяжитесь с нами по адресу

customer-service@technologyreview.com со списком информационных бюллетеней, которые вы хотели бы получать.

Этика ИИ: достаточно ли законов Азимова?

2017, 29 июля

Когда я говорю людям, что мои исследовательские интересы связаны с этикой ИИ, они часто в ответ знакомят меня с тремя законами робототехники Азимова. Этот пост адресован им (это также первый пост из серии из трех частей, кульминацией которой станет объяснение моей недавней статьи на конференции по решениям и контролю).

В последнее время средства массовой информации уделяют достаточно внимания этике искусственного интеллекта (ИИ). Ряд выдающихся ученых и бизнесменов (включая таких, как Стивен Хокинг и Илон Маск) пророчат неумолимое поражение человечества от рук наших будущих повелителей роботов. Как исследователь ИИ, я не думаю, что такой уровень паранойи оправдан. Тем не менее, роботы все чаще рассматриваются для задач, связанных со сценариями жизни и смерти (например, беспилотные автомобили) и социальным взаимодействием (например, роботы в медицинских учреждениях и учреждениях по уходу за престарелыми). Если мы собираемся поставить искусственных агентов (модное словечко, обозначающее существ с искусственным интеллектом, будь то программные боты или физические роботы) в подобных ситуациях мы хотим, чтобы они придерживались наших моральных и социальных норм.

Как исследователь ИИ, я не думаю, что такой уровень паранойи оправдан. Тем не менее, роботы все чаще рассматриваются для задач, связанных со сценариями жизни и смерти (например, беспилотные автомобили) и социальным взаимодействием (например, роботы в медицинских учреждениях и учреждениях по уходу за престарелыми). Если мы собираемся поставить искусственных агентов (модное словечко, обозначающее существ с искусственным интеллектом, будь то программные боты или физические роботы) в подобных ситуациях мы хотим, чтобы они придерживались наших моральных и социальных норм.

Что делать программисту? Что ж, первый вариант — просто запрограммировать моральные и социальные нормы в наших роботов. Самым известным набором моральных правил-кандидатов являются «Три закона робототехники», предложенные в фантастических романах Айзека Азимова:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

- Робот должен подчиняться приказам, отдаваемым ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону.

- Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму Закону.

Всякий раз, когда я начинаю говорить об этике ИИ с кем-то, кто читал книги Азимова или смотрел фильм « Я, робот », они вспоминают эти три закона, а затем очень довольны собой за то, что решили эту непонятную проблему за считанные секунды. Хотя я рад, что моя исследовательская проблема может быть интересна людям, я должен признать, что разочарован тем, что люди, кажется, думают, что это в значительной степени решенная проблема.

Не заблуждайтесь, я не держу зла на Азимова за то, что он придумал эти законы. На самом деле, насколько я понимаю (хотя я совершил кардинальную ересь, никогда не читая книг Азимова), он тратит много страниц на систематическую деконструкцию своих трех законов, показывая их недостаточность для проблемы этики ИИ.

Вот несколько ключевых проблем с тремя законами Азимова:

- Они не в полной мере учитывают возможность конфликта между законами .

По крайней мере, Азимов дает иерархию между тремя законами: избегание вреда > подчинение приказам > защита собственного существования. Так что, если роботу нужно пожертвовать собой, чтобы спасти жизнь человека, он с готовностью это сделает (и, что интересно, робот, которому приказано уничтожить себя, сделает это). Но что происходит, когда закон противоречит с самим собой ? Наиболее часто приводимый пример — задача о тележке, в которой можно пожертвовать одной жизнью, чтобы спасти пятерых. Три закона прямо не указывают, что делать с этой проблемой; действительно, человек ответят по-разному в зависимости от того, как поставлена проблема. Более распространенные (хотя и менее интересные) примеры этого связаны с противоречивыми приказами: что, если два человека отдают роботу противоречивые приказы? (например, «убедитесь, что эта дверь остается закрытой» и «откройте эту дверь»). Должен ли робот подчиняться человеку, который спросил первым? Приказ, которому легче подчиняться? Человек, которого больше «любит» робот? Я хочу сказать, что роботам понадобится механизм разрешения моральных конфликтов, которого еще нет в законах Азимова.

По крайней мере, Азимов дает иерархию между тремя законами: избегание вреда > подчинение приказам > защита собственного существования. Так что, если роботу нужно пожертвовать собой, чтобы спасти жизнь человека, он с готовностью это сделает (и, что интересно, робот, которому приказано уничтожить себя, сделает это). Но что происходит, когда закон противоречит с самим собой ? Наиболее часто приводимый пример — задача о тележке, в которой можно пожертвовать одной жизнью, чтобы спасти пятерых. Три закона прямо не указывают, что делать с этой проблемой; действительно, человек ответят по-разному в зависимости от того, как поставлена проблема. Более распространенные (хотя и менее интересные) примеры этого связаны с противоречивыми приказами: что, если два человека отдают роботу противоречивые приказы? (например, «убедитесь, что эта дверь остается закрытой» и «откройте эту дверь»). Должен ли робот подчиняться человеку, который спросил первым? Приказ, которому легче подчиняться? Человек, которого больше «любит» робот? Я хочу сказать, что роботам понадобится механизм разрешения моральных конфликтов, которого еще нет в законах Азимова.

- Они не в полной мере учитывают неопределенность и случайность . Многие люди ездят на работу каждый день, хотя знают, что, несмотря на все их усилия, есть некоторая вероятность того, что они могут травмировать себя или кого-то еще во время поездки. Если бы самоуправляемому автомобилю дали три закона робототехники, предпочел бы он никогда не возить вас на работу, потому что есть вероятность, что кто-то может пострадать? Это не то поведение, которое мы хотели бы от наших роботов. С другой стороны, мы могли бы интерпретировать первый закон как запрещающий только те действия, которые, по твердому убеждению робота, причинят вред, но это означало бы, что у робота может не возникнуть проблем с тем, чтобы побаловать нас игрой в русскую рулетку. Я хочу сказать, что по-настоящему морально компетентный робот должен уметь рассуждать о вероятности и неопределенности и выносить суждения, которые люди не находят ни слишком суровыми, ни слишком расплывчатыми.

- Они не в полной мере отражают все нюансы и сложности современного морального мира .

Неужели мы действительно верим, что все, что имеет моральное значение для человека или робота, можно свести к этим трем законам? Даже если бы мы это сделали, как бы мы дали роботу правильное определение «вреда»? Определение «вред» даже не статично! Десятилетия назад многие люди в Соединенных Штатах и других странах считали межрасовые браки аморальными и почти наверняка утверждали бы, что они вредны. Совсем недавно: вредна ли эвтаназия? Является ли аборт? В любом случае, даже если бы мы могли закодировать робота с законами Азимова и с предопределенной концепцией вреда, программисты, вероятно, застряли бы, обновляя моральное программное обеспечение по мере изменения ценностей общества.

Неужели мы действительно верим, что все, что имеет моральное значение для человека или робота, можно свести к этим трем законам? Даже если бы мы это сделали, как бы мы дали роботу правильное определение «вреда»? Определение «вред» даже не статично! Десятилетия назад многие люди в Соединенных Штатах и других странах считали межрасовые браки аморальными и почти наверняка утверждали бы, что они вредны. Совсем недавно: вредна ли эвтаназия? Является ли аборт? В любом случае, даже если бы мы могли закодировать робота с законами Азимова и с предопределенной концепцией вреда, программисты, вероятно, застряли бы, обновляя моральное программное обеспечение по мере изменения ценностей общества.

Я спорю не только с людьми, которые утверждают, что законы Азимова — это все, что нам нужно. Это связано с попыткой внедрить мораль в наши машины. У людей есть обширный набор небольших моральных правил и социальных условностей, и мы, вероятно, ожидаем, что роботы будут подчиняться многим из них.

В России робот может спокойно наблюдать за гибелью людей: ему только запрещено целенаправленно вредить им.

В России робот может спокойно наблюдать за гибелью людей: ему только запрещено целенаправленно вредить им.

По крайней мере, Азимов дает иерархию между тремя законами: избегание вреда > подчинение приказам > защита собственного существования. Так что, если роботу нужно пожертвовать собой, чтобы спасти жизнь человека, он с готовностью это сделает (и, что интересно, робот, которому приказано уничтожить себя, сделает это). Но что происходит, когда закон противоречит с самим собой ? Наиболее часто приводимый пример — задача о тележке, в которой можно пожертвовать одной жизнью, чтобы спасти пятерых. Три закона прямо не указывают, что делать с этой проблемой; действительно, человек ответят по-разному в зависимости от того, как поставлена проблема. Более распространенные (хотя и менее интересные) примеры этого связаны с противоречивыми приказами: что, если два человека отдают роботу противоречивые приказы? (например, «убедитесь, что эта дверь остается закрытой» и «откройте эту дверь»). Должен ли робот подчиняться человеку, который спросил первым? Приказ, которому легче подчиняться? Человек, которого больше «любит» робот? Я хочу сказать, что роботам понадобится механизм разрешения моральных конфликтов, которого еще нет в законах Азимова.

По крайней мере, Азимов дает иерархию между тремя законами: избегание вреда > подчинение приказам > защита собственного существования. Так что, если роботу нужно пожертвовать собой, чтобы спасти жизнь человека, он с готовностью это сделает (и, что интересно, робот, которому приказано уничтожить себя, сделает это). Но что происходит, когда закон противоречит с самим собой ? Наиболее часто приводимый пример — задача о тележке, в которой можно пожертвовать одной жизнью, чтобы спасти пятерых. Три закона прямо не указывают, что делать с этой проблемой; действительно, человек ответят по-разному в зависимости от того, как поставлена проблема. Более распространенные (хотя и менее интересные) примеры этого связаны с противоречивыми приказами: что, если два человека отдают роботу противоречивые приказы? (например, «убедитесь, что эта дверь остается закрытой» и «откройте эту дверь»). Должен ли робот подчиняться человеку, который спросил первым? Приказ, которому легче подчиняться? Человек, которого больше «любит» робот? Я хочу сказать, что роботам понадобится механизм разрешения моральных конфликтов, которого еще нет в законах Азимова.

Неужели мы действительно верим, что все, что имеет моральное значение для человека или робота, можно свести к этим трем законам? Даже если бы мы это сделали, как бы мы дали роботу правильное определение «вреда»? Определение «вред» даже не статично! Десятилетия назад многие люди в Соединенных Штатах и других странах считали межрасовые браки аморальными и почти наверняка утверждали бы, что они вредны. Совсем недавно: вредна ли эвтаназия? Является ли аборт? В любом случае, даже если бы мы могли закодировать робота с законами Азимова и с предопределенной концепцией вреда, программисты, вероятно, застряли бы, обновляя моральное программное обеспечение по мере изменения ценностей общества.

Неужели мы действительно верим, что все, что имеет моральное значение для человека или робота, можно свести к этим трем законам? Даже если бы мы это сделали, как бы мы дали роботу правильное определение «вреда»? Определение «вред» даже не статично! Десятилетия назад многие люди в Соединенных Штатах и других странах считали межрасовые браки аморальными и почти наверняка утверждали бы, что они вредны. Совсем недавно: вредна ли эвтаназия? Является ли аборт? В любом случае, даже если бы мы могли закодировать робота с законами Азимова и с предопределенной концепцией вреда, программисты, вероятно, застряли бы, обновляя моральное программное обеспечение по мере изменения ценностей общества.