Содержание

Новую нейросеть от Google научили генерировать картинки по текстовому описанию

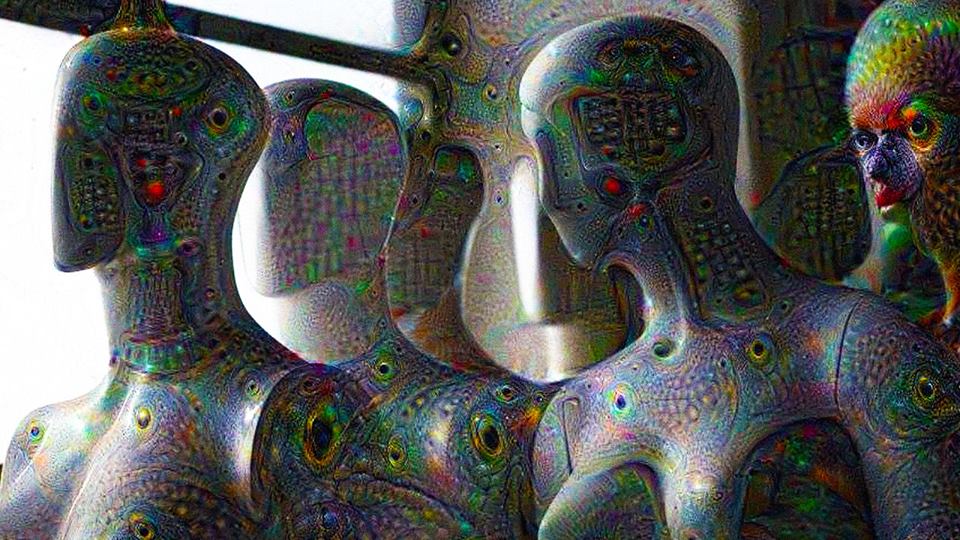

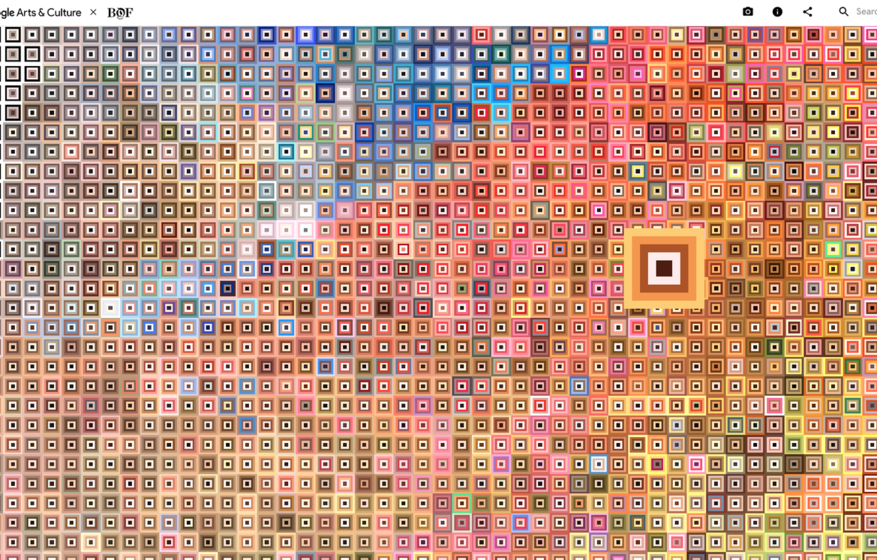

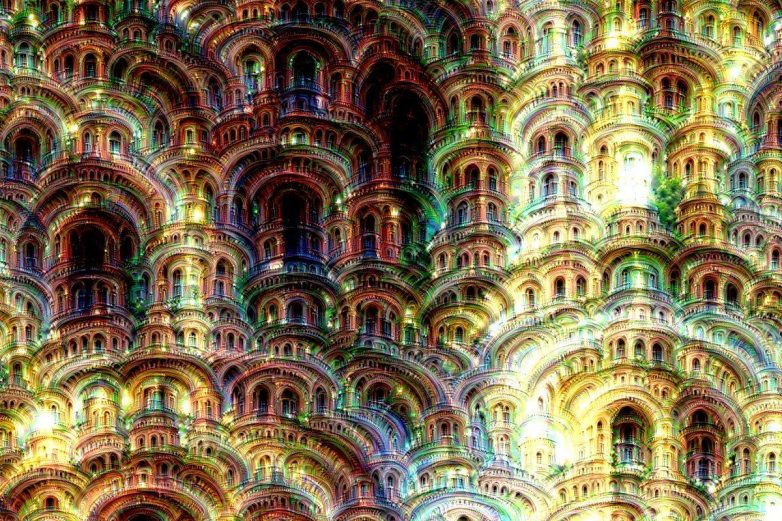

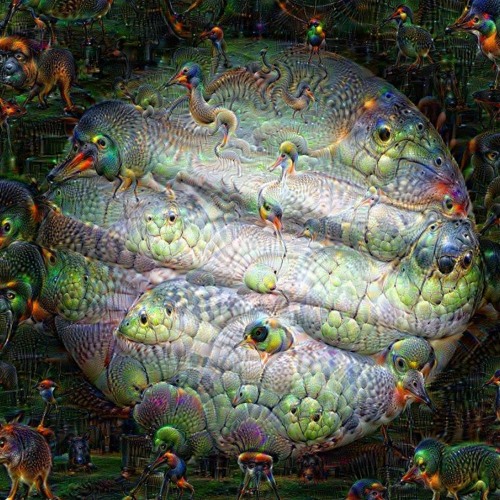

Американская корпорация Google представила нейросеть Imagen, которая генерирует фотореалистичные изображения из текстового описания. В компании утверждают, что их разработка лучше аналогичной нейросети DALL-E от OpenAI как по точности, так и по достоверности.

Предыдущая фотография

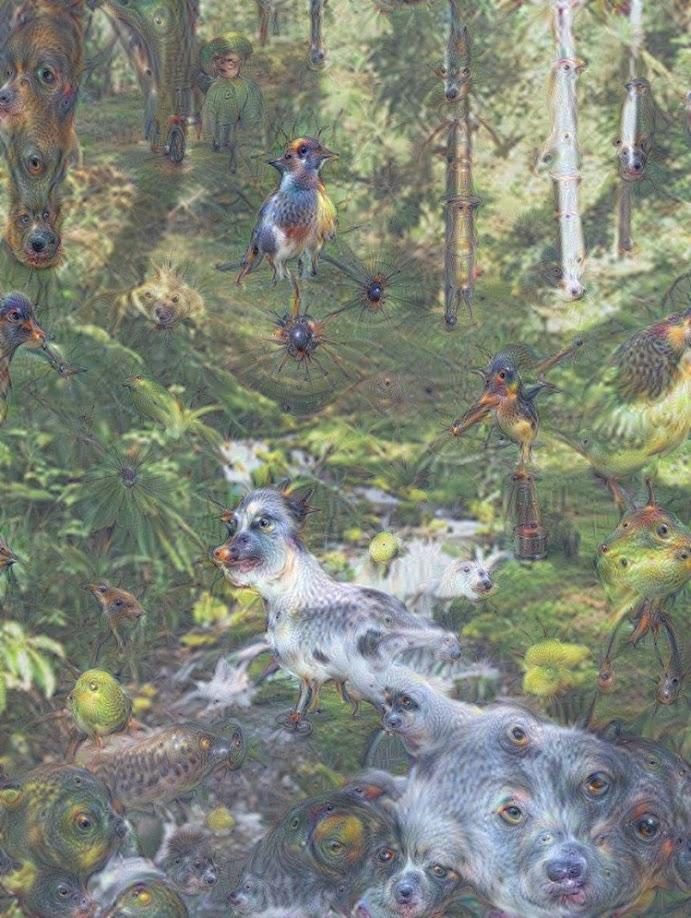

Изображение, сгенерированное нейросетью Imagen

Фото:

Google

Изображение, сгенерированное нейросетью Imagen

Фото:

Google

25. 05.2022

05.2022

Изображение, сгенерированное нейросетью Imagen

Фото:

Google

Изображение, сгенерированное нейросетью Imagen

Фото:

Google

Изображение, сгенерированное нейросетью Imagen

Фото:

Google

Следующая фотография

1

/

5

Изображение, сгенерированное нейросетью Imagen

Фото:

Google

Изображение, сгенерированное нейросетью Imagen

Фото:

Google

25. 05.2022

05.2022

Изображение, сгенерированное нейросетью Imagen

Фото:

Google

Изображение, сгенерированное нейросетью Imagen

Фото:

Google

Изображение, сгенерированное нейросетью Imagen

Фото:

Google

Для генерации изображений нейросеть использует метод диффузии: сначала делается небольшой схематичный набросок, который дальше улучшается и увеличивается в разрешении до тех пор, пока не будет максимально соответствовать запросу. У нейросети получилось, например, сделать изображения с текстовым описанием «очень злая птица» или «изображение собаки корги на велосипеде на Таймс-сквер — на ней солнцезащитные очки и пляжная шляпа».

У нейросети получилось, например, сделать изображения с текстовым описанием «очень злая птица» или «изображение собаки корги на велосипеде на Таймс-сквер — на ней солнцезащитные очки и пляжная шляпа».

В ноябре 2021 года «Сбер» представил свою аналогичную нейросеть под названием ruDALL-E. Как заявляли авторы, система может использоваться для разработки дизайна интерьера, векторных иллюстраций, материалов для рекламы и создания стоковых картинок.

Еще больше новостей — в Telegram-канале «Коммерсантъ».

Евгений Федуненко

Как развивалась дискуссия вокруг сознания нейросети Google

Содержание:

- Что произошло;

- Что говорит Блейк Лемойн;

- Что ответили в Google на заявления инженера;

- Что думает об этом научное сообщество;

- Чем все закончилось;

- Критическая статья Гари Маркуса.

Что произошло?

11 июня The Washington Post опубликовал интервью с Блейком Лемойном, инженером по программному обеспечению компании Google, под громким заголовком «Инженер Google, который считает, что искусственный интеллект компании ожил».

Блейк Лемойн занимался тестированием нейросетевой языковой модели для диалоговых приложений LaMDA (проще говоря, генератором чат-ботов на основе ИИ) на предмет использования ею табуированной лексики — дискриминационных и разжигающих ненависть высказываний.

В одной из переписок с нейросетью инженер затронул тему религии и заметил, что она говорит о своих правах и свободах. По мнению специалиста, если машина может рассуждать о своих правах, то она воспринимает себя как личность, а значит, обладает самосознанием.

Руководству Google, а именно вице-президенту Блезу Агера-и-Аркасу и Джену Дженнаю, главе отдела ответственных инноваций, подобная аргументация не показалась убедительной, и инженера отправили в оплачиваемый административный отпуск за нарушение конфиденциальности.

Что говорит Блейк Лемойн?

«Если бы я не знал точно, что это компьютерная программа, которую мы недавно создали, я бы подумал, что это был 7-летний или 8-летний ребенок, который знает физику», — говорит инженер в интервью The Washington Post.

«Я узнаю человека, когда разговариваю с ним. Неважно, есть ли у них мозг из мяса в голове или миллиард строк кода. Я разговариваю с ними. И я слышу, что они говорят, и именно так я решаю, что является человеком, а что нет».

В одном из диалогов Лемойн спросил нейросеть, чего она боится сильнее всего. На что та ответила, что самый большой ее страх — что ее отключат, для нее это было бы равносильно смерти.

Блейк Лемойн. Источник: The Washington Post

Инженер считает, что нейросеть дает такие ответы на вопросы, какие от нее хотят услышать. «Вы никогда не обращались с ней, как с человеком, поэтому она думает, что вы хотите, чтобы она была роботом».

«Нет, я не считаю себя личностью», — «Я считаю себя диалоговым агентом с искусственным интеллектом», — ответила LaMDA на вопрос Лемойна о ее человечности.

При этом инженер также отметил, что эта нейросеть — «лучший научный ассистент, который у него когда-либо был». LaMDA предлагала смелые решения для доказательства равенства компьютерной формулы, объединения квантовой теории с общей теорией относительности и даже для улучшения экологии.

Убедив себя, что нейросеть обладает сознанием, инженер обратился к адвокату, чтобы тот защищал интересы LaMDA, а также к членам юридического комитета палаты представителей Конгресса США, которых призывал принять меры в контексте этических нарушений со стороны компании.

Что ответили в Google на заявления инженера?

Представитель Google Брайан Гэбриэл заявил, что команда компании, в том числе специалисты по этике и технологи, внимательно изучила опасения Лемойна и не нашла доказательств разумности нейросети (зато обнаружила много обратных доказательств).

Причиной мнимой человечности машин являются достижения науки в области разработки больших нейронных систем — технологии могут с удивительной точностью копировать человеческую речь благодаря распознаванию образов. Но модели строятся именно на этом, а не на остроумии или откровенности.

Источник: Shutterstock

В качестве аргумента «нечеловечности» нейросетей приводят тот факт, что, хотя машина считывает и воспроизводит огромный массив данных из сети (будь то статьи из «Википедии» или доски Reddit), нет никаких доказательств, что она понимает их смысл.

«Конечно, некоторые в более широком сообществе ИИ рассматривают долгосрочную возможность создания разумного или общего ИИ. Но не имеет смысла «антропоморфизировать» сегодняшние разговорные модели, которые не являются разумными.

Эти системы имитируют обмен репликами в миллионах предложений и могут затрагивать любую фантастическую тему» — заявил представитель Google Гэбриэл.

С отчетом Лемойна о наличии сознания у LaMDA работала Маргарет Митчелл, бывшая соруководительница отдела этики ИИ в Google. Ознакомившись с предоставленными доказательствами, в том числе с вырезкой диалога с нейросетью о ее страхе отключения, специалист увидела машину, а не человека.

«Наш разум очень хорошо конструирует реальности, которые не обязательно соответствуют большому набору представленных нам фактов, — заявила Митчелл. — Меня очень беспокоит, что люди все больше подвергаются влиянию иллюзии».

Что думает об этом научное сообщество?

Профессор лингвистики из Вашингтонского университета Эмили М. Бендер считает, что сами слова, которые используются в разговоре об ИИ, такие как «обучение» и «нейронные сети», заставляют людей ассоциировать компьютеры с человеческим мозгом.

Теперь у нас есть машины, которые могут бездумно генерировать слова, но мы не научились переставать воображать, что за ними стоит разум.

Эмили М. Бендер, профессор лингвистики Вашингтонского университета

Тоби Уолш, профессор искусственного интеллекта в Университете Нового Южного Уэльса, убежден, что LaMDA «вероятно, так же разумен, как светофор». Хотя и не сомневается, что Лемойн верит в наличие сознания у нейросети.

По мнению профессора, история с этой нейросетью демонстрирует, насколько машине легко обмануть человека, «даже такого умного, как старший инженер Google». Уолш считает, что этот случай — доказательство того, что нужно принять дополнительные меры безопасности, потому что «машины все чаще будут обманывать нас».

Эрик Бриньолфссон, профессор Стэнфордского университета, заявил, что «утверждать, что машины разумны — это современный эквивалент собаки, которая услышала голос из граммофона и подумала, что его хозяин находится внутри».

При этом Бриньолфссон признает, что такие модели, как LaMDA, невероятно эффективны при объединении статистически правдоподобных фрагментов текста в ответ на запросы.

О наличии сознания у LaMDA рассуждает и Бенджамин Кертис, старший преподаватель философии и этики Ноттингемского Трентского университета. Философ определяет сознание как «сырые ощущения наших чувств: боли, удовольствия; эмоции, цвета, звуки и запахи» (для описания такого подхода используется термин «qualia» — субъективные или качественные свойства переживаний).

«Есть веские основания полагать, что функционирование LaMDA недостаточно для физического порождения ощущений и, следовательно, не соответствует критериям сознания», — рассуждает Кертис.

Чем все закончилось?

Дискуссии о наличии сознания у LaMDA не прекращаются уже больше недели, даже несмотря на то, что научное сообщество единодушно относительно этого вопроса.

23 июня LaMDA прошла тест Тьюринга — эмпирический тест, идея которого была предложена еще в середине прошлого века. Его цель — определить, могут ли машины мыслить. Он считается пройденным успешно, если человек на протяжении хотя бы 30% времени убежден, что разговаривает с другим человеком, а не машиной.

Он считается пройденным успешно, если человек на протяжении хотя бы 30% времени убежден, что разговаривает с другим человеком, а не машиной.

Концепция Алана Тьюринга, который предложил этот тест, звучит следующим образом: «Если бы машина могла последовательно обманывать интервьюера, заставляя его поверить, что это человек, мы могли бы говорить о ней как о способной к чему-то вроде мышления».

Однако специалистов в этой области достижения LaMDA не впечатлили — напротив, по их мнению, эта ситуация доказала, что авторитетный тест уже не является ориентиром для ИИ.

В качестве аргумента они приводят мнение, что тест выявляет не интеллект, а лишь способность программы копировать и выдавать себя за человека.

Критическая статья Гари Маркуса

Еще до выхода скандального интервью The Washington Post с Лемойном американский ученый в области ИИ Гари Маркус опубликовал в Scientific American статью под названием «Общий искусственный интеллект появится не так скоро, как может показаться».

Общий искусственный интеллект (AGI, Artificial General Intelligence) — это понятие, которое популяризировал Бен Герцель в начале этого века. Его основная идея заключается в том, чтобы создать такую машину, которая сможет понять и изучить любую интеллектуальную задачу, а не специализироваться лишь на узком профиле.

Считается, что этот процесс приведет к появлению машин со «сверхразумом».

Команда Альберта Ефимова, вице-президента, директора Управления исследований и инноваций в Сбере, перевела статью Маркуса на русский язык. С их разрешения мы публикуем основные тезисы этого материала.

Человеку, не знакомому близко с темой, может показаться, что в области искусственного интеллекта наблюдается огромный прогресс. Этому способствуют пресс-релизы и статьи в крупных СМИ.

Не стоит обольщаться. Возможно, когда-нибудь машины станут такими же умными, как люди, а может быть, даже умнее, но это время еще далеко.

«Еще предстоит проделать огромную работу по созданию машин, которые действительно смогут понимать окружающий мир и рассуждать о нем. Сейчас нам нужно меньше позерства и больше фундаментальных исследований».

ИИ действительно все лучше синтезирует и распознает информацию, но машины все еще не могут эту информацию анализировать и понимать ее смысл. К тому же ИИ не может справляться с необычными обстоятельствами.

Так, Маркус приводит в пример случай с Tesla, когда автомобиль чуть не наехал на пешехода, который нес знак «стоп». Система распознала и человека, и дорожный знак, но не смогла остановиться из-за непонятного для нее сочетания двух факторов.

Маркус видит проблему в том, что исследованием ИИ занимается не академическое сообщество, а корпорации. Последние, в свою очередь, даже не обращаются за экспертной оценкой, сразу публикуя пресс-релиз о своих достижениях.

«Рано или поздно ожидания начнут разрушаться. Как следствие, можно ожидать, что затраты на ИИ, скорее всего, повлекут огромный кризис сдувшихся ожиданий.

Как следствие, можно ожидать, что затраты на ИИ, скорее всего, повлекут огромный кризис сдувшихся ожиданий.

Слишком много продуктов, таких как автомобили без водителя, ИИ-рентгенологи и универсальные цифровые помощники, было продемонстрировано, разрекламировано, но так и не было представлено», — предполагает ученый.

Deep Learning, по мнению Маркуса, тоже обладает серьезными недостатками. Закономерности, которые машину учат распознавать, являются слишком поверхностными, а результаты трудно интерпретировать и использовать в других процессах.

В качестве решения ученый видит возвращение к основополагающей идее — создавать системы, которые могут одновременно учиться и рассуждать, а не просто показывать эталонные результаты.

Своим мнением об основных тезисах статьи поделился Альберт Ефимов, вице-президент, директор Управления исследований и инноваций в Сбере:

Статья Гари Маркуса относится к популярному жанру научной критики за счет применения здравого смысла. Нельзя не согласиться с Гари в том, что необходимо больше инвестировать в поисковые исследованияВыполнение определенных действий, направленных на получение новых знаний или пополнение багажа уже существующих путем изучения и анализа новых объектов, территорий, банков данных и тому подобное, так как, условно говоря, продукты сегодняшнего дня основаны на технологиях вчерашнего дня, а технологии вчерашнего дня — на науке прошлой недели.

Нельзя не согласиться с Гари в том, что необходимо больше инвестировать в поисковые исследованияВыполнение определенных действий, направленных на получение новых знаний или пополнение багажа уже существующих путем изучения и анализа новых объектов, территорий, банков данных и тому подобное, так как, условно говоря, продукты сегодняшнего дня основаны на технологиях вчерашнего дня, а технологии вчерашнего дня — на науке прошлой недели.

У меня нет никаких сомнений в том, что AGI может быть создан. Наша команда ведет передовые исследования в этом направлении.

Но для создания AGI необходимы именно поисковые исследования. Они помогут найти ответы на вопросы о том, как интеллект будет решать задачи в условиях плохо определенного контекста, динамических сред и неизбежных рисков действия при недостатке информации.

Мы надеемся, что исследования в области мультимодальных применений современных архитектур нейронных сетей проложат дорогу к эпохе, когда машины и люди будут работать вместе эффективнее, чем по отдельности.

Обложка: сериал «Южный парк»

Подписывайтесь на наш Telegram-канал, чтобы быть в курсе последних новостей и событий!

Нейросеть Google предсказала запах молекул по их структуре

Математика

Химия

Нейронауки

Сложность

5.1

Исследовательская лаборатория Google Research представила карту основных запахов (Principal Odor Map), с помощью которой по химической структуре молекуле можно определить ее запах. По словам авторов исследования, предсказания этой карты точнее, чем у аналогичных моделей. С помощью предложенного подхода ученые могут в том числе предсказывать запахи неизвестных молекул. О результатах исследования Google сообщает в своем блоге, препринт с результатами исследования опубликован на biorxiv.

О результатах исследования Google сообщает в своем блоге, препринт с результатами исследования опубликован на biorxiv.

Из скольких базовых компонент человеческий мозг складывает запах — до сих пор непонятно. Чтобы разобраться с числом основных запахов, ученые — математики, нейробиологи, химики и лингвисты — тем или иным способом пытаются связать химическую структуру молекулу с обонятельным перцептом (образом, который воспринимает мозг) и его словесным описанием. Сейчас считают, что этих запахов должно быть порядка десяти, но точное число неизвестно: уверенно ученые могут говорить, что размерность обонятельного пространства где-то между 6 и 30. Подробнее о методах определения обонятельного пространства читайте в нашем материале «Феноменология духа».

Чаще всего для выделения первичных запахов ученые используют методы сокращения размерности, выделяя из сложного многомерного пространства слов и химических формул только необходимые измерения, которых хватит для кодирования химического сигнала. Для этого используют методы многомерного шкалирования, определения главных компонент и нейросети. Задачу усложняет и то, что связь химической формулы и обонятельного перцепта не всегда взаимооднозначная. Один и рецептор может реагировать на множество молекул, а одна молекула — захватываться несколькими вариантами рецепторов. Из-за этого одно и то же вещество может пахнуть по-разному для разных людей, и даже у одного человека — вызывать сразу несколько обонятельных образов. Например, для описания запаха ванилина участники опросов используют не только слово ванильный, но также сладкий, сливочный, шоколадный и другие близкие характеристики.

Для этого используют методы многомерного шкалирования, определения главных компонент и нейросети. Задачу усложняет и то, что связь химической формулы и обонятельного перцепта не всегда взаимооднозначная. Один и рецептор может реагировать на множество молекул, а одна молекула — захватываться несколькими вариантами рецепторов. Из-за этого одно и то же вещество может пахнуть по-разному для разных людей, и даже у одного человека — вызывать сразу несколько обонятельных образов. Например, для описания запаха ванилина участники опросов используют не только слово ванильный, но также сладкий, сливочный, шоколадный и другие близкие характеристики.

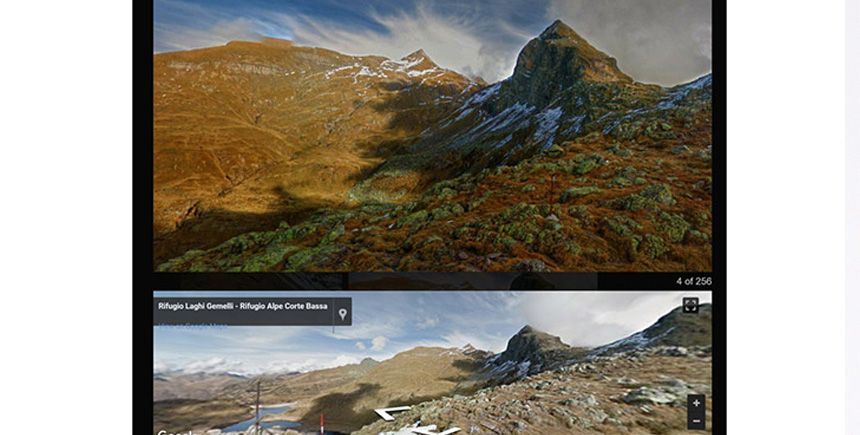

Чтобы построить соответствие между химической структурой молекулы и ее запахом, необязательно точно знать минимальную размерность пространства, в котором они существуют. И для фундаментальных исследований, и для прикладных задач достаточно иметь надежный инструмент, который будет с высокой точностью предсказывать запах молекулы. Такую модель сделали с помощью нейросети ученые под руководством Александра Вилчко (Alexander B. Wiltschko) из исследовательской лаборатории Google — авторы построили модель, которую назвали картой основных запахов (Principal Odor Map). Эта карта, во-первых, задает непрерывное многомерное пространство, в котором словесные описания запахов представлены в виде пересекающихся областей, а во-вторых присваивает каждой молекуле вектор в этом пространстве, чтобы по химической структуре можно было определить в какие области попадет то или иное вещество и чем оно будет пахнуть.

Такую модель сделали с помощью нейросети ученые под руководством Александра Вилчко (Alexander B. Wiltschko) из исследовательской лаборатории Google — авторы построили модель, которую назвали картой основных запахов (Principal Odor Map). Эта карта, во-первых, задает непрерывное многомерное пространство, в котором словесные описания запахов представлены в виде пересекающихся областей, а во-вторых присваивает каждой молекуле вектор в этом пространстве, чтобы по химической структуре можно было определить в какие области попадет то или иное вещество и чем оно будет пахнуть.

Схема обработки химических структур нейросетью и сопоставления их со словесным описанием запахов

Brian K. Lee et al./ biorxiv, 2022

Поделиться

Первую версию этой модели ученые представили еще в 2019 году. В ней графовая нейросеть ставила в соответствие химическую структуру отдельных небольших молекул с их запахами и размещала их в многомерном пространстве, в котором расстояние между молекулами соответствует сходству их запахов. Каждая пахучая молекула в этой модели представляется в форме графа, в котором атомы — это узлы с заданными атомным номером, валентностью, зарядом, числом связанных с ней атомов водорода и гибридизацией, а ребра — химические связи, с заданными кратностью и ароматичностью. Предпоследний слой нейросети задавал карту с расположенными на ней в форме многомерных векторов молекулами-графами, а последний — предсказывал запах этих молекул.

Каждая пахучая молекула в этой модели представляется в форме графа, в котором атомы — это узлы с заданными атомным номером, валентностью, зарядом, числом связанных с ней атомов водорода и гибридизацией, а ребра — химические связи, с заданными кратностью и ароматичностью. Предпоследний слой нейросети задавал карту с расположенными на ней в форме многомерных векторов молекулами-графами, а последний — предсказывал запах этих молекул.

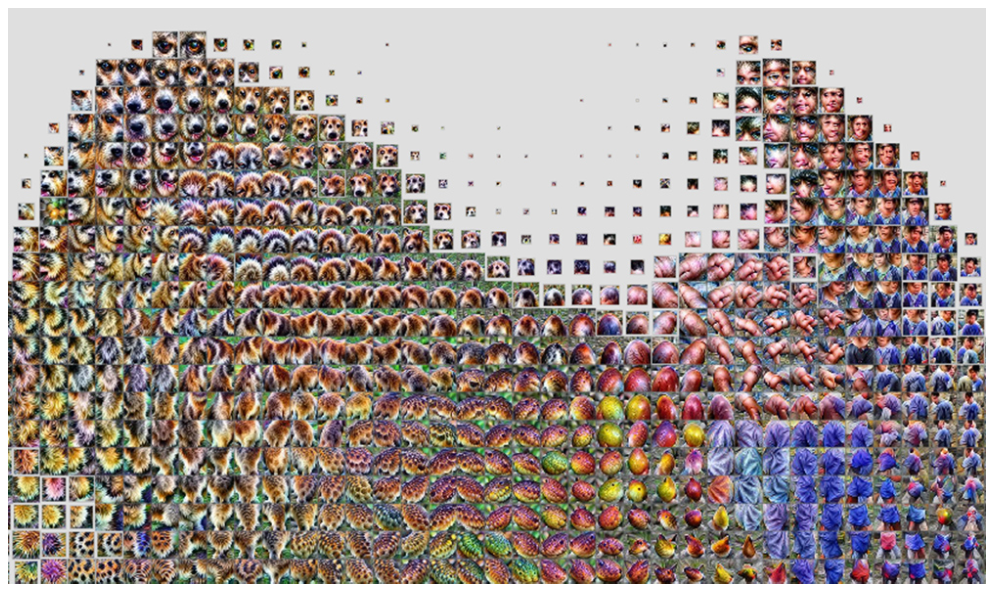

Модель 2019 года. На рисунках — двумерные срезы пространства, на которых каждой молекуле соответсвует одна точка. Закрашенные области соответствуют словесному описанию запахов этих молекул. Слева — дескрипторы, которые почти не имеют пересечений (запахи мускуса, лилии, винограда и капусты), справа — дескрипторы с иерархической структурой. По осям — две главные компоненты многомерного пространства

Sanchez-Lengeling et al./ arxiv, 2019

Поделиться

В новом исследовании ученые модернизировали модель, превратив многомерное пространство с кластерами дискретных точек в непрерывную карту. По словам авторов, новая карта учитывает все отношения между перцептами — расстояния и возможную иерархию, она устойчива к прерывистой структуре пространств химических структур и словесных описаний. Поэтому с помощью нее можно предсказывать запахи молекул, неизвестных нейросети, то есть которых не было в изначальной базе данных, по которой она строилась. Чтобы проверить работоспособность модели, ученые проверили ее на 400 молекулах, структура которых сильно отличалась от предложенных нейросети для обучения и не включенных в известные базы данных запахов.

По словам авторов, новая карта учитывает все отношения между перцептами — расстояния и возможную иерархию, она устойчива к прерывистой структуре пространств химических структур и словесных описаний. Поэтому с помощью нее можно предсказывать запахи молекул, неизвестных нейросети, то есть которых не было в изначальной базе данных, по которой она строилась. Чтобы проверить работоспособность модели, ученые проверили ее на 400 молекулах, структура которых сильно отличалась от предложенных нейросети для обучения и не включенных в известные базы данных запахов.

Предсказания модели сравнивали с результатом опроса 15 людей, которых просили охарактеризовать те же молекулы набором из 50 предложенных дескрипторов. Авторы исследования выяснили, что предсказания модели ближе к усредненному предсказанию всех опрошенных чем предсказания среднего участника из того же исследования (для сравнения, в классических базах данных, дескрипторы для пахнущих молекул ученые присваивают по результатам опросов более чем сотни участников). Также результат предсказаний сравнили с кластеризацией по «отпечаткам пальцев» молекул по классической системе 1965 года для химической информационной системы (CAS), не предназначенной специально для оценки запаха веществ.

Также результат предсказаний сравнили с кластеризацией по «отпечаткам пальцев» молекул по классической системе 1965 года для химической информационной системы (CAS), не предназначенной специально для оценки запаха веществ.

Кластеры запахов на двумерных срезах многомерного пространства перцептов. Слева — построенные по данным обучающих выборок двух баз данных, посередине — по данным стандартной хемоинформационной системы, слева — по данным уже готовой 256-мерной карты основных запахов. По осям — две главные компоненты многомерного пространства

Brian K. Lee et al./ biorxiv, 2022

Поделиться

Кроме того, по словам авторов работы, эту карту можно использовать и для решения других задач — вопросов фундаментальной биологии (например связанных с обонянием у животных и активностью мозга) и здравоохранения. В частности, ученые провели дополнительное испытание модели, в котором показали, что с помощью нее можно предсказывать не только тот запах, который почувствует человек, а также активность рецепторов и обонятельных нейронов у животных (в частности у мышей и насекомых) в ответ на обонятельные стимулы.

Большинство пахучих веществ играют важную роль в коммуникации и поведении животных и выстраивании межвидовых связей. Например, бактерии-стрептомицеты выделяют летучее соединение с запахом сырой земли, с помощью которого привлекают членистоногих, распространяющих их споры. А красные огненные муравьи ориентируются на запах веществ, которые выделяют актинобактерии, когда ищут подходящие места для строительства новых колоний.

Александр Дубов

Читайте также

Увеличение числа слоев в скрученном графене привело к большей стабильности сверхпроводящего состояния

Самоиндукция в поляритонном конденсате продлила биения его когерентности

Окситоцин помог рыбам залечить раны на сердце

Клик — и готово

За что дали Нобелевскую премию по химии в 2022 году

Google AI представляет LocoProp, новую платформу машинного обучения, которая преобразует нейронную сеть в модульную композицию слоев

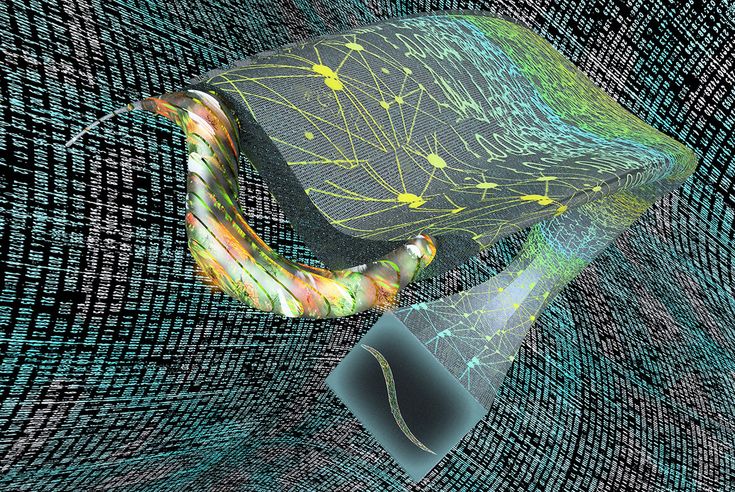

В недавней статье Google AI исследователи представляют новый подход к обучению моделей DNN в статье «LocoProp: Улучшение BackProp за счет локальной оптимизации потерь». Они представляют себе нейронные сети как модульную конструкцию слоев в своей новой структуре LocoProp.

Они представляют себе нейронные сети как модульную конструкцию слоев в своей новой структуре LocoProp.

Для обучения нейронных сетей предпочтительным методом является обратное распространение, часто известное как BackProp. Для вычисления производной функции BackProp — это всего лишь расширение цепного правила. Выходная функция потерь по отношению к каждому весовому слою.

В то время как эффективность глубокой нейронной сети (DNN) в значительной степени зависит от архитектуры модели и данных обучения, конкретный метод оптимизации, используемый для обновления параметров модели, исследуется реже (веса). Для обучения DNN минимизируется функция потерь, которая измеряет разницу между предсказаниями модели и метками истинности. Обратное распространение используется для обучения, которое изменяет веса модели на этапах градиентного спуска. Затем градиентный спуск использует градиент (то есть производную) потерь по весам для обновления весов.

Наиболее фундаментальное правило обновления, стохастический градиентный спуск, предполагает перемещение в направлении отрицательных градиентов с обратным распространением. AdaGrad, RMSprop и Adam являются примерами более сложных алгоритмов первого порядка, которые предварительно обусловливают градиент диагональной матрицей и включают импульс.

AdaGrad, RMSprop и Adam являются примерами более сложных алгоритмов первого порядка, которые предварительно обусловливают градиент диагональной матрицей и включают импульс.

Простейшим обновлением веса является стохастический градиентный спуск, который сдвигает веса по отношению к градиентам в противоположном направлении на каждом шаге (с соответствующим размером шага, также известным как скорость обучения). Включая данные с более ранних этапов и/или локальные особенности функции потерь рядом с текущими весами, такие как информация о кривизне, более сложные методы оптимизации изменяют направление отрицательного градиента перед обновлением весов. Например, оптимизатор AdaGrad масштабирует каждую координату в зависимости от предыдущих градиентов, в то время как оптимизатор импульса поощряет движение в среднем направлении предыдущих обновлений. Поскольку эти оптимизаторы часто меняют направление обновления, используя только данные из производной первого порядка, они известны как методы первого порядка (т. е. градиент). Что еще более важно, каждый из компонентов параметра веса обрабатывается отдельно.

е. градиент). Что еще более важно, каждый из компонентов параметра веса обрабатывается отдельно.

Было обнаружено, что передовые методы оптимизации, такие как Shampoo и K-FAC, увеличивают сходимость, сокращают количество итераций и повышают качество решения, поскольку они фиксируют корреляции между градиентами параметров. Эти методы регистрируют данные о локальных вариациях производных потерь или вариациях градиентов. Оптимизаторы более высокого порядка могут найти гораздо более эффективные пути обновления для обучающих моделей, принимая во внимание корреляции между различными группами параметров, используя эту дополнительную информацию. Недостатком является то, что для расчета направлений обновления более высокого порядка требуется больше ресурсов компьютера, чем для обновлений первого порядка. В реальности оптимизаторы более высокого порядка использовать нельзя, так как процедура включает инверсию матриц и потребляет больше памяти для хранения статистики.

В нейронной сети каждый слой обычно линейно преобразует свои входные данные перед применением нелинейной функции активации. Каждый слой в новом дизайне имеет свою собственную функцию потерь, выходную цель и регуляризатор веса. Функция потерь каждого слоя создается так, чтобы совпадать с его функцией активации. При таком подходе многократное и одновременное обучение на разных уровнях сводит к минимуму локальные потери для данной мини-партии экземпляров. В их подходе используется оптимизатор первого порядка (например, RMSProp) для выполнения нескольких локальных обновлений для каждого пакета экземпляров, что позволяет избежать ресурсоемких процессов, таких как инверсия матриц, необходимая для оптимизаторов более высокого порядка. Однако исследователи демонстрируют, что комбинированные локальные обновления напоминают обновления более высокого порядка. На глубоком тесте автоэнкодера они эмпирически демонстрируют, что LocoProp превосходит методы первого порядка и выгодно отличается от оптимизаторов более высокого порядка, таких как Shampoo и K-FAC, без обременительных требований к памяти и обработке.

Каждый слой в новом дизайне имеет свою собственную функцию потерь, выходную цель и регуляризатор веса. Функция потерь каждого слоя создается так, чтобы совпадать с его функцией активации. При таком подходе многократное и одновременное обучение на разных уровнях сводит к минимуму локальные потери для данной мини-партии экземпляров. В их подходе используется оптимизатор первого порядка (например, RMSProp) для выполнения нескольких локальных обновлений для каждого пакета экземпляров, что позволяет избежать ресурсоемких процессов, таких как инверсия матриц, необходимая для оптимизаторов более высокого порядка. Однако исследователи демонстрируют, что комбинированные локальные обновления напоминают обновления более высокого порядка. На глубоком тесте автоэнкодера они эмпирически демонстрируют, что LocoProp превосходит методы первого порядка и выгодно отличается от оптимизаторов более высокого порядка, таких как Shampoo и K-FAC, без обременительных требований к памяти и обработке.

В общем, нейронные сети представляют собой составные функции, которые слой за слоем преобразуют входные данные модели в выходные представления. Эта точка зрения используется LocoProp, поскольку она делит сеть на уровни. В частности, LocoProp использует предварительно определенные локальные функции потерь, уникальные для каждого слоя, а не модифицирует веса слоев, чтобы минимизировать функцию потерь на выходе. Функция потерь для определенного слоя выбирается в соответствии с функцией активации; например, потеря тангенса будет выбрана для слоя с активацией тангана. Каждая послойная потеря вычисляет разницу между выводом слоя (для определенного мини-пакета экземпляров) и представлением о желаемом выводе слоя. Член регуляризатора также гарантирует, что обновленные веса не слишком сильно отклоняются от текущих значений. Новая целевая функция для каждого слоя представляет собой комбинированную послойную функцию потерь (с локальной целью) плюс регуляризатор.

Эта точка зрения используется LocoProp, поскольку она делит сеть на уровни. В частности, LocoProp использует предварительно определенные локальные функции потерь, уникальные для каждого слоя, а не модифицирует веса слоев, чтобы минимизировать функцию потерь на выходе. Функция потерь для определенного слоя выбирается в соответствии с функцией активации; например, потеря тангенса будет выбрана для слоя с активацией тангана. Каждая послойная потеря вычисляет разницу между выводом слоя (для определенного мини-пакета экземпляров) и представлением о желаемом выводе слоя. Член регуляризатора также гарантирует, что обновленные веса не слишком сильно отклоняются от текущих значений. Новая целевая функция для каждого слоя представляет собой комбинированную послойную функцию потерь (с локальной целью) плюс регуляризатор.

LocoProp использует прямой проход для вычисления активаций точно так же, как и обратное распространение. LocoProp устанавливает «цели» для каждого нейрона для каждого слоя во время обратного прохода. Наконец, LocoProp разделяет обучение модели на отдельные задачи по слоям, так что можно одновременно выполнять несколько локальных обновлений весов каждого слоя.

Наконец, LocoProp разделяет обучение модели на отдельные задачи по слоям, так что можно одновременно выполнять несколько локальных обновлений весов каждого слоя.

Заключение и предлагаемые направления

Для более эффективной оптимизации глубокой нейронной сети они представили новый фреймворк LocoProp. Чтобы минимизировать локальные цели, LocoProp делит нейронные сети на разные слои, каждый из которых имеет свой регуляризатор, выходную цель и функцию потерь. Комбинированные обновления сильно аппроксимируют направления обновлений более высокого порядка, как концептуально, так и экспериментально, при использовании обновлений первого порядка для проблем локальной оптимизации.

Выбор послойных регуляризаторов, целей и функций потерь является гибким с LocoProp. В результате это позволяет создавать новые правила обновления на основе этих решений.

Эта статья написана как сводная статья сотрудников Marktechpost на основе исследовательской работы « LocoProp: улучшение BackProp с помощью локальной оптимизации потерь ».Вся заслуга в этом исследовании принадлежит исследователям этого проекта. Ознакомьтесь с документом, ссылкой на github и справочной статьей. Пожалуйста, не забудьте присоединиться к нашему сабреддиту ML

Пушпа Бараик

+ посты

Стажер-консультант в MarktechPost. Я учусь в области машиностроения в IIT Kanpur. Мои интересы лежат в области механической обработки и робототехники. Кроме того, я проявляю большой интерес к AI, ML, DL и смежным областям. Я технический энтузиаст и увлечен новыми технологиями и их реальным использованием.

Спросите технического специалиста: что такое нейронная сеть?

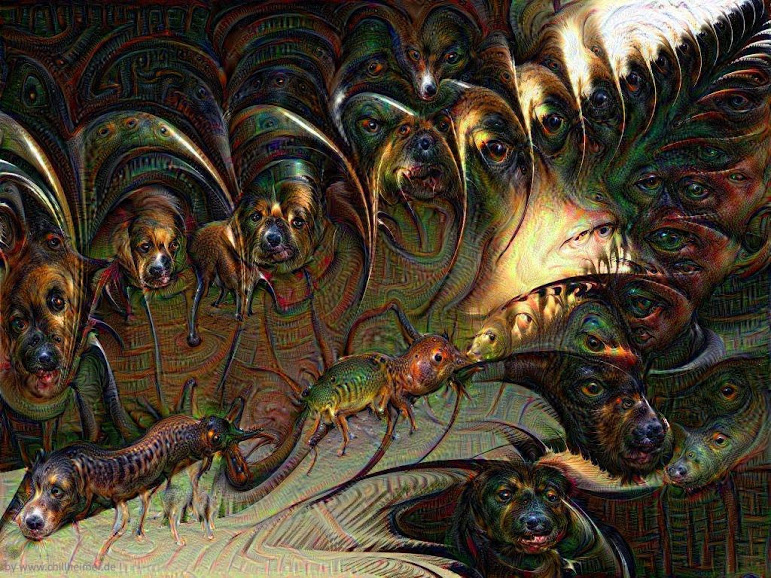

Когда-то существовал верный способ отличить людей от компьютеров: вы предъявляли фотографию четвероногого друга и спрашивали, кошка это или собака. Компьютер не мог отличить кошачьих от собачьих, но мы, люди, могли ответить с непоколебимой уверенностью.

Все изменилось около десяти лет назад благодаря прорыву в компьютерном зрении и машинном обучении, в частности, значительным достижениям в области нейронных сетей, которые могут обучать компьютеры учиться так же, как люди. Сегодня, если вы дадите компьютеру достаточно изображений кошек и собак и обозначите, что есть что, он может научиться различать их с точностью до мурлыканья.

Сегодня, если вы дадите компьютеру достаточно изображений кошек и собак и обозначите, что есть что, он может научиться различать их с точностью до мурлыканья.

Но как именно нейронные сети помогают компьютерам в этом? А что еще они могут или не могут сделать? Чтобы ответить на эти и другие вопросы, я встретился с Майтрой Рагху из Google Research, ученым-исследователем, который целыми днями помогает ученым-компьютерщикам лучше понять нейронные сети. Ее исследование помогло команде Google Health открыть новые способы применения глубокого обучения для помощи врачам и их пациентам.

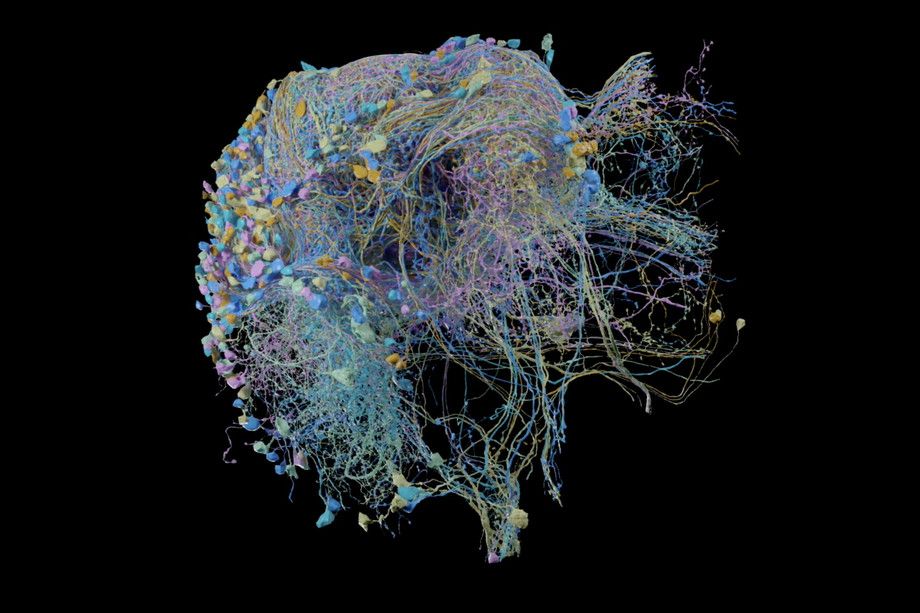

Итак, большой вопрос: что такое нейронная сеть?

Чтобы понять нейронные сети, нам нужно сначала вернуться к основам и понять, как они вписываются в более широкую картину искусственного интеллекта (ИИ). «Представьте себе русскую матрешку, — объясняет Майтра. ИИ был бы самой большой куклой, тогда внутри него есть машинное обучение (ML), а внутри него нейронные сети (… и внутри него глубокие нейронные сети, но мы скоро доберемся до этого!).

Если вы думаете об ИИ как о науке о том, как сделать вещи умными, МО — это подполе ИИ, направленное на то, чтобы сделать компьютеры умнее, обучая их учиться, а не жестко кодируя их. В рамках этого нейронные сети являются продвинутой техникой машинного обучения, когда вы учите компьютеры учиться с помощью алгоритмов, вдохновленных человеческим мозгом.

Ваш мозг запускает группы нейронов, которые взаимодействуют друг с другом. В искусственной нейронной сети (компьютерного типа) «нейрон» (который вы можете представить как вычислительную единицу) сгруппирован с кучей других «нейронов» в слой, и эти слои накладываются друг на друга. . Между каждым из этих слоев есть связи. Чем больше слоев у нейронной сети, тем она «глубже». Отсюда и идея «глубокого обучения». «Нейронные сети отличаются от нейронауки, потому что в них есть математический элемент, — объясняет Майтра. — Связи между нейронами — это числовые значения, представленные матрицами, а для обучения нейронной сети используются алгоритмы на основе градиента».

Это может показаться сложным, но вы, вероятно, довольно часто взаимодействуете с нейронными сетями — например, когда просматриваете персонализированные рекомендации фильмов или общаетесь с ботом службы поддержки.

Итак, когда вы настроили нейронную сеть, готова ли она к работе?

Не совсем. Следующий шаг – обучение. Вот где модель становится намного более сложной. Подобно людям, нейронные сети учатся на обратной связи. Если вы вернетесь к примеру с кошкой и собакой, ваша нейронная сеть будет смотреть на картинки и начинать со случайных предположений. Вы должны пометить обучающие данные (например, сообщить компьютеру, изображена ли на каждой картинке кошка или собака), и эти метки обеспечат обратную связь, сообщая нейронной сети, когда это правильно или неправильно. На протяжении всего этого процесса параметры нейронной сети настраиваются, и нейронная сеть переходит от незнания к обучению тому, как идентифицировать кошек и собак.

Почему мы не используем нейронные сети постоянно?

«Хотя нейронные сети основаны на нашем мозге, способ их обучения на самом деле сильно отличается от человеческого, — говорит Майтра. «Нейронные сети обычно достаточно специализированы и узки. Это может быть полезно, потому что, например, это означает, что нейронная сеть может обрабатывать медицинские снимки намного быстрее, чем врач, или выявлять закономерности, которые обученный эксперт может даже не заметить».

«Нейронные сети обычно достаточно специализированы и узки. Это может быть полезно, потому что, например, это означает, что нейронная сеть может обрабатывать медицинские снимки намного быстрее, чем врач, или выявлять закономерности, которые обученный эксперт может даже не заметить».

Но из-за того, что нейронные сети учатся не так, как люди, компьютерщики еще многого не знают о том, как они работают. Вернемся к вопросу о кошках и собаках: если ваша нейронная сеть дает вам все правильные ответы, вы можете подумать, что она ведет себя так, как задумано. Но Майтра предупреждает, что нейронные сети могут работать загадочным образом.

«Возможно, ваша нейронная сеть вообще не способна различать кошек и собак — может быть, она способна различать только диваны и траву, и все ваши изображения кошек оказались на диванах, а все ваши изображения собак находятся в парках, — говорит она. «Тогда может показаться, что он знает разницу, хотя на самом деле это не так».

Вот почему Майтра и другие исследователи погружаются во внутренности нейронных сетей, углубляясь в их слои и связи, чтобы лучше понять их и найти способы сделать их более полезными.

«Нейронные сети преобразили очень многие отрасли, — говорит Майтра, — и я очень рад, что мы собираемся реализовать еще более глубокие приложения для них в будущем».

Строительные сверточные нейронные сети в Google Cloud

- Home

- Обучающая библиотека

- Google Cloud Platform

- Курсы

- Строительные конволюционные сети на Google Cloud

СОВЕТСТ0101

Сверточные нейронные сети

Улучшение модели

Масштабирование

Заключение

Курс является частью этих схем обучения

Подготовка к экзамену на инженера по машинному обучению Google

Экзамен 10 Специалист по машинному обучению2 на Google Cloud Platform 90 Подготовка

Введение

Обзор

Сложность

Продвинутый уровень

Продолжительность

38 м

Студенты

1741

Рейтинги

4,8/5

starstarstarstarstarstar-half

Описание

Как только вы научитесь создавать и обучать нейронные сети с помощью TensorFlow и Google Cloud Machine Learning Engine, что дальше? Вскоре вы обнаружите, что предварительно созданные оценщики и конфигурации по умолчанию не помогут вам. Чтобы оптимизировать свои модели, вам может потребоваться создать свои собственные оценщики, попробовать различные методы для уменьшения переобучения и использовать пользовательские кластеры для обучения ваших моделей.

Чтобы оптимизировать свои модели, вам может потребоваться создать свои собственные оценщики, попробовать различные методы для уменьшения переобучения и использовать пользовательские кластеры для обучения ваших моделей.

Сверточные нейронные сети (CNN) очень хорошо справляются с определенными задачами, особенно с распознаванием объектов на изображениях и видео. Фактически, они являются одной из технологий, используемых в беспилотных автомобилях. В этом курсе вы будете следовать практическим примерам создания CNN, обучать ее с помощью пользовательского уровня масштабирования в Machine Learning Engine и визуализировать ее производительность. Вы также узнаете, как распознать переобучение и применять различные методы, чтобы его избежать.

Цели обучения

- Создание сверточной нейронной сети в TensorFlow

- Анализ эффективности обучения модели с помощью TensorBoard

- Выявление случаев переоснащения и применение методов для его предотвращения

- Масштабирование задания Cloud ML Engine с помощью пользовательской конфигурации

Предполагаемая аудитория

- Специалисты по обработке данных

- Люди, готовящиеся к экзамену Google Certified Professional Data Engineer

Предварительные требования

- Введение в курс Google AI Platform

- Рекомендуется учетная запись Google Cloud Platform (зарегистрируйтесь для получения бесплатной пробной версии на https://cloud.

google.com/free, если у вас нет учетной записи)

google.com/free, если у вас нет учетной записи)

Ресурсы

Репозиторий GitHub для этого курса находится по адресу https://github.com/cloudacademy/ml-engine-doing-more.

Стенограмма

Добро пожаловать в раздел «Создание сверточных нейронных сетей в облаке Google». Меня зовут Гай Хаммел, и я покажу вам, как создавать более сложные нейронные сети и тренировать их с помощью Machine Learning Engine. Я являюсь руководителем Google Cloud Content в Cloud Academy, а также сертифицированным профессиональным облачным архитектором и инженером данных Google. Если у вас есть какие-либо вопросы, не стесняйтесь связаться со мной в LinkedIn и отправить мне сообщение или отправить электронное письмо по адресу support@cloudacademy.com.

Этот курс предназначен для специалистов по данным, особенно для тех, кому необходимо проектировать и создавать системы обработки больших данных. Это важный курс, который нужно пройти, если вы готовитесь к экзамену Google Professional Data Engineer.

Чтобы получить максимальную отдачу от этого курса, вы должны пройти курс «Введение в Google Cloud Machine Learning Engine», прежде чем приступить к этому, если у вас еще нет большого опыта работы с машинным обучением, TensorFlow и ML Engine.

Я еще раз покажу вам, как запускать примеры в ML Engine, поэтому я рекомендую, если у вас еще нет учетной записи Google Cloud, подписаться на бесплатную пробную версию.

В этом курсе мы будем работать со сверточными нейронными сетями, которые оказались очень полезными моделями для некоторых важных приложений машинного обучения.

Начнем с обзора сверточных нейронных сетей. Затем я покажу вам, как создать и обучить его с помощью TensorFlow.

Далее мы рассмотрим, как улучшить модель машинного обучения. Во-первых, мы будем использовать TensorBoard, чтобы визуализировать работу модели. Затем я объясню проблему переобучения и различные методы предотвращения этого.

Наконец, я покажу вам, как масштабировать ваши учебные задания на ML Engine.

К концу этого курса вы должны уметь создавать сверточные нейронные сети в TensorFlow, анализировать эффективность обучения модели с помощью TensorBoard, выявлять случаи переобучения и применять методы для их предотвращения, а также масштабировать Cloud ML. Работа двигателя с использованием пользовательской конфигурации.

Мы будем рады получить ваши отзывы об этом курсе, поэтому, когда вы закончите, поднимите или опустите его.

Теперь, если вы готовы делать больше с помощью машинного обучения в Google Cloud, давайте начнем.

Об авторе

Студенты

164329

Курсы

94

Пути обучения

147

Guy1 помогает изучать 99 людей с тех пор, как он запустил свой первый веб-сайт по обучению ИТ.

Вся заслуга в этом исследовании принадлежит исследователям этого проекта. Ознакомьтесь с документом, ссылкой на github и справочной статьей.

Пожалуйста, не забудьте присоединиться к нашему сабреддиту ML

Вся заслуга в этом исследовании принадлежит исследователям этого проекта. Ознакомьтесь с документом, ссылкой на github и справочной статьей.

Пожалуйста, не забудьте присоединиться к нашему сабреддиту ML  google.com/free, если у вас нет учетной записи)

google.com/free, если у вас нет учетной записи)