Содержание

Чем опасен искусственный интеллект

Стивен Хокинг, Илон Маск и другие ученые и изобретатели считают искусственный интеллект угрозой жизни на Земле. Директор Института будущего человечества в Оксфорде и автор бестселлера Superintelligence: Paths, Dangers, Strategies Ник Бостром рассказал Правила жизни, почему сверхразум может уничтожить людей всего за одну секунду.

Правила жизни

Теги:

мнение

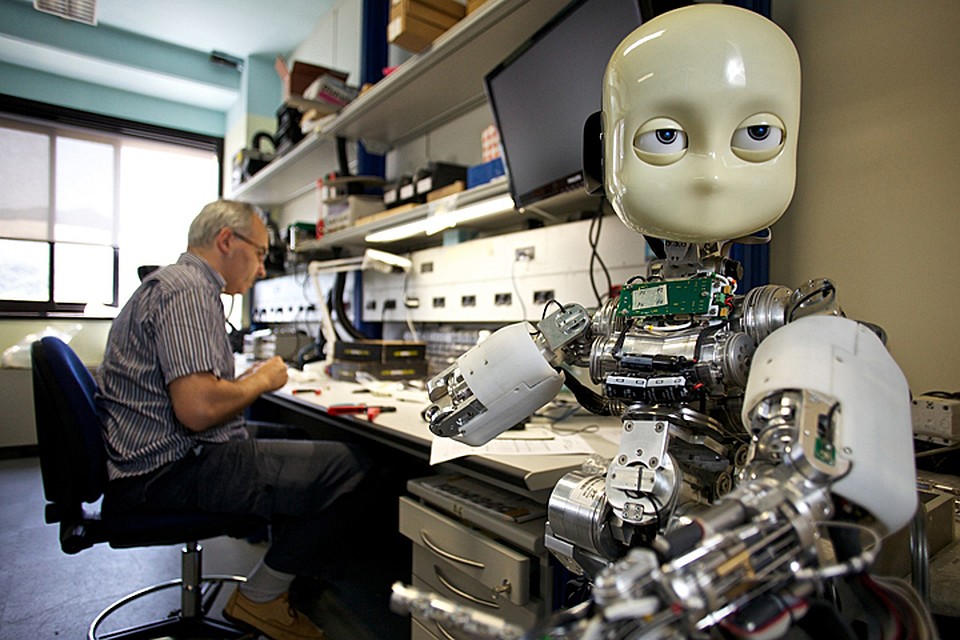

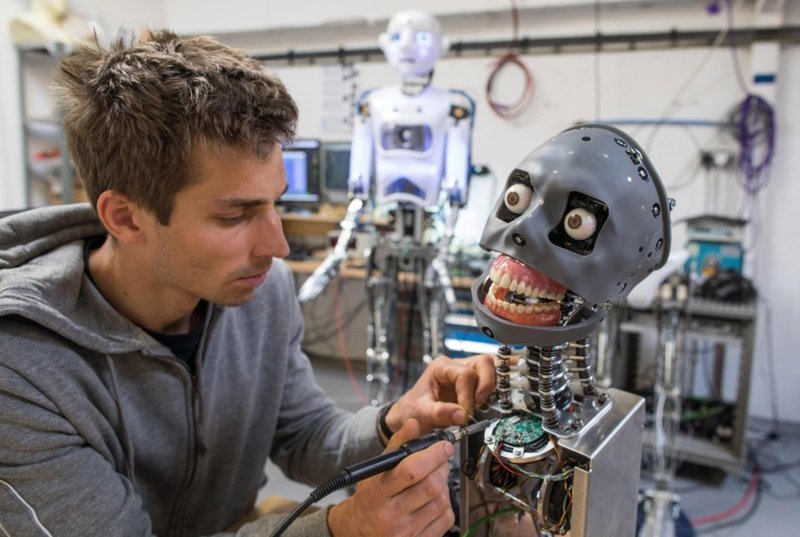

В качестве иллюстраций использованы фотографии Луизы Уиттон (Luisa Whitton), которая провела несколько месяцев в лаборатории одного из самых известных робототехников в мире — японского инженера Хироси Исигуро.

В узких областях возможности искусственного интеллекта уже намного превышают человеческие: Гарри Каспаров, чемпион мира по шахматам, проиграл программе Deep Blue в далеком 1997 году. Поисковые запросы, распознавание речи, логистика — в этом специализированные системы лучше нас. Но на самом деле они пока не обладают мышлением как таковым, и никто сейчас не знает, когда будет изобретен настоящий искусственный интеллект.

Но на самом деле они пока не обладают мышлением как таковым, и никто сейчас не знает, когда будет изобретен настоящий искусственный интеллект.

Большинство ученых сходятся во мнении, что вероятность его появления до середины XXI века — 50%. Прогноз очень абстрактный, и очевидно, что произойти это может как намного раньше, так и гораздо позже. В 1940-х годах, когда были созданы первые компьютеры, ученые предсказывали появление машин, превосходящих интеллект человека, к 1960-м. Прогноз не сбылся, но уже тогда математик Ирвинг Джон Гуд, работавший во время Второй Мировой войны над взломом немецких шифров в команде Алана Тьюринга, предупреждал: «Сверхумная машина — последнее изобретение, которое предстоит сделать человечеству, при условии, конечно, что эта машина будет нас слушаться и укажет, как ее контролировать». Другими словами, первый же искусственный интеллект, созданный людьми, с большой вероятностью будет стремиться к неограниченному овладению ресурсами, а его цели никак не будут связаны с благом человечества. Если учесть, что люди состоят из полезных ресурсов — таких, например, как организованные в определенном порядке молекулы — и сами зависят от множества земных ресурсов, одним из наиболее вероятных последствий появления искусственного интеллекта станет полное исчезновение человечества. Представьте, что перед носителем сверхразума зачем-то встала задача максимально увеличить производство скрепок для бумаги. В этой связи у него будут как минимум две причины уничтожить человечество: чтобы мы не смогли ему каким-то образом помешать и чтобы использовать наши тела как сырье.

Если учесть, что люди состоят из полезных ресурсов — таких, например, как организованные в определенном порядке молекулы — и сами зависят от множества земных ресурсов, одним из наиболее вероятных последствий появления искусственного интеллекта станет полное исчезновение человечества. Представьте, что перед носителем сверхразума зачем-то встала задача максимально увеличить производство скрепок для бумаги. В этой связи у него будут как минимум две причины уничтожить человечество: чтобы мы не смогли ему каким-то образом помешать и чтобы использовать наши тела как сырье.

В Голливуде любят изображать носителей искусственного интеллекта на службе у диктаторов, но мне кажется, вероятность этого крайней мала: он не будет делать никаких различий между людьми, и репрессивные правительства такие же потенциальные его жертвы, как угнетаемое ими большинство. Другой голливудский штамп — эпическая битва отряда храбрецов с армией роботов. Почему-то Терминатор и ему подобные носители сверхразума никогда не могут осуществить свой зловещий замысел мгновенно, им надо подождать, пока раскрутится захватывающий сюжет. А там навстречу обязательно выйдет горстка героев, каждый из которых обладает уникальным навыком, и вместе они уничтожат безупречный, на первый взгляд, механизм, в котором обнаружится роковой изъян. Вынужден разочаровать: в реальной жизни гораздо более вероятным представляется сценарий, при котором мы все умрем за одну секунду, а Земля превратится в один большой компьютер, миллиарды лет занятый ему одному понятными вычислениями.

А там навстречу обязательно выйдет горстка героев, каждый из которых обладает уникальным навыком, и вместе они уничтожат безупречный, на первый взгляд, механизм, в котором обнаружится роковой изъян. Вынужден разочаровать: в реальной жизни гораздо более вероятным представляется сценарий, при котором мы все умрем за одну секунду, а Земля превратится в один большой компьютер, миллиарды лет занятый ему одному понятными вычислениями.

Уже сейчас некоторые системы, у которых еще нет своей воли или способности планировать действия, практически невозможно выключить. Где находится кнопка выключения интернета, например? Я уж не говорю о том, что носитель искусственного интеллекта наверняка предусмотрит попытку его отключения и заранее предпримет необходимые меры безопасности. И уж точно он сможет найти методы влияния на физический мир, чтобы манипулировать волей людей, заставить их работать на себя или предоставить доступ к созданию собственной инфраструктуры.

Не стоит ли нам прекратить разработку искусственного интеллекта в таком случае? К сожалению, это риторический вопрос. Не существует одной организации, которая бы целенаправленно вела эту работу и подчинялась какому-то правительству. Наоборот, по всему миру разбросано множество частных компаний и лабораторий, огромное количество людей занимаются программным обеспечением, нейробиологией, статистикой, дизайном интерфейсов — их исследования тем или иным образом вносят свой вклад в создание искусственного интеллекта. В этом смысле человечество похоже на ребенка, играющего с бомбой — вернее, это целый детский сад, и в любой момент какой-нибудь придурок может нажать не на ту кнопку. Так что когда вы читаете о новых открытиях в области интеллектуальных систем, страх здесь более адекватная реакция, чем эйфория от открывающихся перспектив. Но правильнее всего в данном случае как можно скорее сосредоточиться на задачах, которые помогут уменьшить риски, исходящие от сверхразума, еще до его появления. Одним из возможных решений является создание профессионального сообщества, которое объединило бы бизнесменов, ученых и исследователей, а также направило технологические исследования в безопасное русло и выработало средства контроля над их результатами.

Не существует одной организации, которая бы целенаправленно вела эту работу и подчинялась какому-то правительству. Наоборот, по всему миру разбросано множество частных компаний и лабораторий, огромное количество людей занимаются программным обеспечением, нейробиологией, статистикой, дизайном интерфейсов — их исследования тем или иным образом вносят свой вклад в создание искусственного интеллекта. В этом смысле человечество похоже на ребенка, играющего с бомбой — вернее, это целый детский сад, и в любой момент какой-нибудь придурок может нажать не на ту кнопку. Так что когда вы читаете о новых открытиях в области интеллектуальных систем, страх здесь более адекватная реакция, чем эйфория от открывающихся перспектив. Но правильнее всего в данном случае как можно скорее сосредоточиться на задачах, которые помогут уменьшить риски, исходящие от сверхразума, еще до его появления. Одним из возможных решений является создание профессионального сообщества, которое объединило бы бизнесменов, ученых и исследователей, а также направило технологические исследования в безопасное русло и выработало средства контроля над их результатами.

За свою историю человечество не научилось управлять своим будущим. Разные группы людей всегда стремились к достижению собственных целей, часто вступая конфликт с друг с другом. Глобальное технологическое и экономическое развитие до сих пор не является плодом сотрудничества и стратегического планирования, и едва ли не последнее, что оно учитывает — это судьба человечества. Представьте себе школьный автобус, поднимающийся в гору и набитый разыгравшимися детьми. Это человечество. Но если посмотреть на место водителя, мы увидим, что оно пусто. Совершая новое открытие, мы каждый раз берем из корзины мяч и кидаем его о стену — пока что это были только белые мячи и серые мячи, но однажды может попасться и черный мяч, который, ударившись о стену, вызовет катастрофу. Смысл в том, что у нас не будет шанса спрятать черный мяч обратно в корзину: как только открытие совершается, его невозможно отменить.

Опасен ли искусственный интеллект

Отношение к искусственному интеллекту неоднозначное: с одной стороны – прогресс, с другой – угрозы. Разберемся, какие опасности несут в себе искусственный интеллект, цифровизация, роботизация и автоматизация.

Разберемся, какие опасности несут в себе искусственный интеллект, цифровизация, роботизация и автоматизация.

ManGO! Games

Любой инструмент, в том числе и искусственный интеллект, содержит в себе как опасность, так и возможности. Все зависит от того, кто его применяет и зачем.

Угрозы искусственного интеллекта

Лишние люди

При текущей экономической модели приход техники приводит к идее максимизации прибыли под лозунгом «Машина вместо человека». Люди становятся лишними. Что будут делать сотрудники тех профессий, которые будут заменены искусственным интеллектом?

Рост неравенства

В мире существует проблема неравенства, искусственный интеллект может ее усилить: кто обладает технологиями – получает преимущество. Определенное сообщество, владеющее технологиями, применяет их на массах, не имеющих таких возможностей.

Монополия на искусственный интеллект

Искусственный интеллект может сосредоточиться в одних руках. У него будет такое же преимущество, каким сейчас для стран является ядерное оружие. Смогут ли люди оставаться независимыми?

Потеря контроля над искусственным интеллектом

Пока неясно, как именно будет применяться искусственный интеллект и как будет проходить его развитие. Известна способность искусственного интеллекта к саморазвитию. Если это так, то возможен риск выхода роботов из-под контроля человека.

Влияние на свободу выбора человека

Находясь в сети, человек оставляет информационный след: обработка больших объемов информации позволяет создавать портрет человека, направляя на него индивидуальную рекламу, в том числе и политическую, что влияет на свободу выбора. Это может перейти в полный контроль над сознанием человека – манипулирование, зомбирование и все то, чего многие боятся. А контроль этот будет осуществлять тот, кто обладает технологиями, которые мы называем искусственным интеллектом.

А контроль этот будет осуществлять тот, кто обладает технологиями, которые мы называем искусственным интеллектом.

К чему ведет цифровизация?

Последствия этого мы уже наблюдаем. Люди активно цифровизируются. Кто не в пространстве цифровизации – тот первым оказывается за бортом. Это касается не только карьеры, но и всех сторон жизни.

В мире есть значительные группы населения, у которых жизнь не связана с постоянным пребыванием в сети. Они вне возможностей, которые есть у остальных.

Как не остаться без работы?

Чтобы не остаться за бортом, и не оставить без дела большую часть человечества – нужно соответствовать цифровым вызовам и не терять человеческого обличия. Важно работать с ценностями.

Как быть с риском неограниченной свободы искусственного интеллекта? Действительно, выстраивая искусственный интеллект по своему подобию, можно получить нечто более сильное, что может уничтожить нас самих, как это бывает в фантастических фильмах или книгах фантастов. Инструмент может начать доминировать над своим создателем.

Инструмент может начать доминировать над своим создателем.

Не стоит всецело доверять машине, нужен контроль и постоянный анализ, чтобы не допустить отклонения от курса. Вряд ли кому-нибудь хотелось бы запустить неконтролируемые процессы в свою жизнь, в компанию, в мир в целом.

Как мы планируем использовать роботов?

Стоит вспомнить произведения Айзека Азимова, где писатель вывел законы робототехники: робот не должен причинять вред человеку, должен заботиться о собственной безопасности, если это не противоречит первому закону, должен выполнять указания человека. Однако сейчас, когда мы вплотную подошли к роботизации, становится понятно, что это слишком обобщенные правила, универсальные категории.

Мир ценностно и цивилизационно неоднороден. Кому будет подчиняться робот, если, например, между народами возникнет конфликт? В условиях ценностно расколотого мира, робот – инструмент в руках одних и угроза для других.

Многое зависит от вектора. В чем людям помогут роботы? Что человек считает прогрессом прямо сейчас? Мы движемся в направлении духовного развития или удовлетворения потребностей? Если речь о втором пути, то каждый из нас придет к деградации: роботы будут работать, а люди — паразитировать. Возможно, человечество зайдет в тупик. К тому же искусственный интеллект может оказаться чище и гуманнее людей.

Юридическая сторона вопроса

В юридической литературе западных стран в связи с идеями роботизации сейчас обсуждается вопрос прав человека на искусственный интеллект.

Сейчас фантастика становится реальностью, и уже перестают удивлять размышления такого типа: «Если робот производит других роботов, кому они принадлежат? Что если роботам начнут давать права, как и человеку? Чем отличается человек без души от робота?».

Это вопросы без ответов, которые заставляют задуматься о том, насколько важно грамотно использовать технологии. Важно понимать, что у искусственного интеллекта нет того, что мы называем духовностью, он не наделен эмоциями, нравственностью, не может любить. Наверное, не стоит относиться к роботу, как к человеку, а человека ставить в один ряд с машиной.

Важно понимать, что у искусственного интеллекта нет того, что мы называем духовностью, он не наделен эмоциями, нравственностью, не может любить. Наверное, не стоит относиться к роботу, как к человеку, а человека ставить в один ряд с машиной.

Что думают об ИИ известные и знаменитые?

Стивен Хокинг считал искусственный интеллект реальной угрозой жизни на Земле. Илон Маск, а также ряд ученых и изобретателей, соглашаются с этим. Директор Института будущего человечества в Оксфорде Ник Бостром выразил мнение, что ИИ способен уничтожить мир буквально за секунду.

Однако не стоит забывать, что сейчас речь идет о технологиях: того самого сверхразума, способного уничтожить планету, пока не существует. Ученые считают, что к середине нынешнего столетия он может появиться с вероятностью 50%.

Правда, появление такой сверхумной машины прогнозировали еще в прошлом веке. Прогноз не сбылся, но тогда, размышляя над подобной вероятностью, математик Ирвинг Джон Гуд, который во время Второй Мировой войны работал в команде расшифровки немецких шифров, предупреждал: «Сверхумная машина — последнее изобретение, которое предстоит сделать человечеству, при условии, конечно, что эта машина будет нас слушаться и укажет, как ее контролировать».

Сможем ли мы контролировать искусственный интеллект?

В фильмах искусственный интеллект служит диктаторам, но вероятность такого сценария слишком мала: вряд ли сверхразум будет как-нибудь различать людей. Сложно представить и длительную борьбу между людьми и роботами. Более вероятный сценарий – все исчезнет в мгновение, превратившись в один большой компьютер, занятый ему одному понятными вычислениями.

Как не допустить подобного? Наверное, помнить, что важно все контролировать: ничего не начинать, не запускать и не включать, пока не будет уверенности в возможности выключить, остановить, скорректировать.

Однако сейчас, в момент, когда технологии стремительно развиваются, человек больше привыкает «пробовать боем», жить в бета-версии. Если подумать, то сегодня уже есть некоторые системы, не обладающие самообучением, способностью планировать действия и принимать решения, которые практически невозможно выключить. Так, например, никто не знает, где находится кнопка выключения интернета.

Так, например, никто не знает, где находится кнопка выключения интернета.

Возникает логичный вопрос: думают ли создатели искусственного интеллекта о том, как смогут выключить его, будут ли предусмотрены меры безопасности?

Кто занимается разработкой универсального ИИ?

Занимаясь созданием общего искусственного интеллекта, команды специалистов озвучивают полезные для человечества цели. Общий, универсальный, интеллект призван решать тупиковые проблемы, ускорять и оптимизировать нашу работу.

Когда мы говорим о сверхразуме и его опасности, речь идет об общем искусственном интеллекте (ОИИ). Термин звучит как Artificial general intelligence (General AI, AGI).

На данный момент удалось создать только «узкий искусственный интеллект» (УИИ), который выполняет конкретные задачи. Он запрограммирован на точечные функции, помогает автоматизировать работу. Причем многие подобные операции он умеет делать не хуже человека.

ОИИ будет решать задачи иначе. Это будет система, способная делать собственные выводы и самообучаться. Она сможет даже осознавать саму себя. Работая над созданием общего ИИ, люди мечтают, что он будет использовать общемировые знания для решения каждого конкретного вопроса, учитывая при этом контекст, анализируя все возможные виды информации.

Кто же ведет разработку общего ИИ? Недавно такой проект запустили в Google. Компания собирается обучить ИИ большому количеству навыков, после чего он станет универсальным, способным осознавать и обрабатывать все поступающие сигналы при любом способе передачи информации. Сейчас эта разработка находится только на начальной стадии. В рамках этой работы протестированы нейросети и опробованы на проектах Google Switch Transformer, Gshard и других.

В Китае уже создан чип Tianjic, который использует методы нейробиологии и схему имитации человеческого мозга. Чип повторяет функции мозговых нейронов, способных воспринимать информацию и конвертировать ее в нервные импульсы для импульсной нейросети и обратно.

Работают над общим искусственным интеллектом и в IBM. Компания разработала сверхточную нейронную сеть на нейроморфическом чипе TrueNorth. Сеть имитирует мозг человека, потребляя в тысячи раз меньше энергии, чем современные процессоры.

Что будет, когда в одной из лабораторий все-таки родится ОИИ?

Человечество похоже на ребенка, играющего с бомбой. Какая эмоция должна возникать у нас, когда мы узнаем о новых открытиях в области интеллектуальных систем – страх или радость от открывающихся перед человечеством перспектив?

Что делать человечеству? Учиться управлять своим будущим. То же самое нужно делать компаниям и каждому из нас.

Материал подготовлен компанией ManGO! Games

Маск назвал самый опасный для человечества искусственный интеллект

- Миллиардеры

- Ринат Таиров

Редакция Forbes

Принадлежащий Google стартап DeepMind разрабатывает искусственный интеллект, который на данный момент является самым опасным для человечества, считает Илон Маск. Он допускает, что уже через пять лет компьютерное мышление превзойдет человека

Искусственный интеллект, который разрабатывает принадлежащая Google компания DeepMind, вызывает большие опасения, заявил гендиректор Tesla Илон Маск в интервью The New York Times. Маск — давний сторонник контроля за разработкой компьютерного мышления, и, по словам миллиардера, DeepMind на данный момент беспокоит его больше всего.

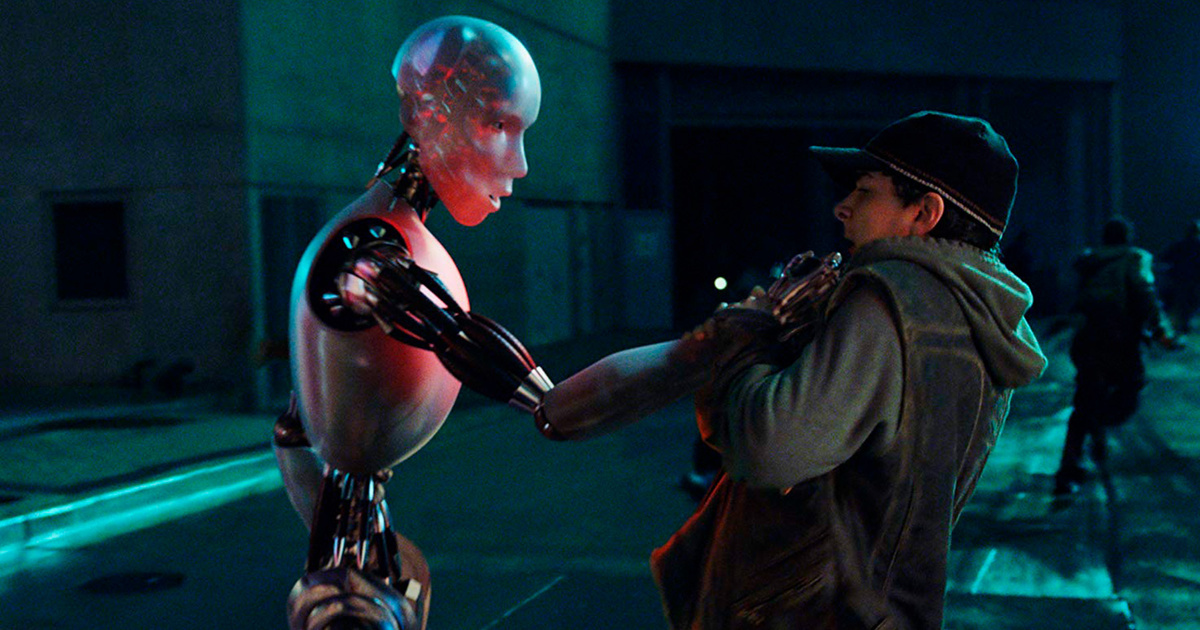

«Даже сама суть искусственного интеллекта, которую они создают, — из тех, что уничтожают всех людей во всех играх. Это буквально сюжет «Военных игр»», — отметил Маск. «Военные игры» — американский фильм 1983 года. По сюжету, хакер взламывает компьютерную сеть военных США и запускает искусственный интеллект, который чуть не приводит к ядерной войне между СССР и США.

Работа над искусственным интеллектом для автомобилей Tesla показала миллиардеру, что человечество уже приближается к ситуации, когда искусственный интеллект будет существенно умнее, чем люди. «Я думаю, что до этого меньше пяти лет. Это не значит, что все пойдет к чертям через пять лет. Просто ситуация станет нестабильной или странной», — прогнозирует Маск. По его словам, многие умные люди недооценивают искусственный интеллект, потому что даже не думают, что компьютер может быть столь же умным, как человек. «Это гордыня и очевидная ошибка», — категоричен бизнесмен.

Новый образ роботов: как пандемия изменила отношение к искусственному интеллекту

Маск высказывает мысли об опасности искусственного интеллекта как минимум с 2014 года. Тогда он написал в Twitter, что человечеству нужно быть крайне осторожным с технологией, которая «потенциально более опасна, чем ядерное оружие».

Тогда он написал в Twitter, что человечеству нужно быть крайне осторожным с технологией, которая «потенциально более опасна, чем ядерное оружие».

August 3, 2014

Выступая в Массачусетском технологическом институте, Маск говорил, что это может быть самой существенной угрозой человечеству: «С искусственным интеллектом мы призываем демона. Во всех историях про парня с пентаграммой и святой водой этот парень уверен, что сможет контролировать демона. Не выходило». В 2018-м он отмечал, что сейчас искусственный интеллект во многом сосредоточен в руках крупнейших компаний: «Есть очень сильная концентрация мощи искусственного интеллекта, в особенности в Google/DeepMind. Я очень хорошо отношусь к [сооснователю Google] Ларри Пейджу и [основателю DeepMind] Демису Хассабису, но я думаю, что необходим некоторый независимый надзор».

Диагноз по селфи. Как пять российских ученых научили искусственный интеллект оценивать людей по фото

DeepMind — британская программа, которая занимается разработкой искусственного интеллекта..jpg) Google купила ее в 2014 году. Компания известна тем, что разработала программное обеспечение, которое смогло обыграть человека в го и в шахматы. Илон Маск был одним из ранних инвесторов DeepMind. Он говорил Vanity Fair, что его инвестиции были не попыткой заработать на компании, а скорее возможностью следить за тем, как развивается искусственный интеллект. Как описывал журнал, Маск однажды впервые встретился с Хассабисом в США. Маск ему заявил, что занимается самой важной задачей человечества — межпланетной колонизацией. Хассабис возразил, что это он занят самой важной задачей — разработкой искусственного интеллекта. Тогда Маск возразил, что это одна из причин необходимости колонизировать Марс — чтобы иметь запасной плацдарм на случай, если компьютеры восстанут против людей. Хассабис парировал, что искусственный интеллект попросту последует за людьми на Марс.

Google купила ее в 2014 году. Компания известна тем, что разработала программное обеспечение, которое смогло обыграть человека в го и в шахматы. Илон Маск был одним из ранних инвесторов DeepMind. Он говорил Vanity Fair, что его инвестиции были не попыткой заработать на компании, а скорее возможностью следить за тем, как развивается искусственный интеллект. Как описывал журнал, Маск однажды впервые встретился с Хассабисом в США. Маск ему заявил, что занимается самой важной задачей человечества — межпланетной колонизацией. Хассабис возразил, что это он занят самой важной задачей — разработкой искусственного интеллекта. Тогда Маск возразил, что это одна из причин необходимости колонизировать Марс — чтобы иметь запасной плацдарм на случай, если компьютеры восстанут против людей. Хассабис парировал, что искусственный интеллект попросту последует за людьми на Марс.

Деньги из будущего: как и зачем россияне инвестируют в SpaceX Илона Маска

В 2018 году Маск, Хассабис и DeepMind публично пообещали не разрабатывать, не производить и не использовать роботов для убийства людей.

August 12, 2017

Мысли визионера: все изобретения Илона Маска

7 фото

Ринат Таиров

Редакция Forbes

#Илон Маск

#искусственный интеллект

Рассылка Forbes

Самое важное о финансах, инвестициях, бизнесе и технологиях

7 рисков искусственного интеллекта, о которых вы должны знать

В марте 2018 года на технологической конференции South by Southwest в Остине, штат Техас, основатель Tesla и SpaceX Илон Маск выступил с дружеским предупреждением: куртка-бомбер с пушистым воротником и старый загривок: «ИИ гораздо опаснее ядерного оружия».

Никакой фиалки, особенно когда дело доходит до мнений о технологиях, откровенный Маск повторил версию этих предчувствий искусственного интеллекта и в других условиях.

«Я действительно очень близок… к переднему краю ИИ, и это меня чертовски пугает», — сказал он аудитории SXSW. «Он способен на гораздо большее, чем кто-либо знает, и скорость улучшения экспоненциальна».

«Он способен на гораздо большее, чем кто-либо знает, и скорость улучшения экспоненциальна».

Риски искусственного интеллекта

- Потеря работы из-за автоматизации

- Нарушения конфиденциальности

- «Дипфейки»

- Алгоритмическая предвзятость, вызванная неверными данными0011 Автоматизация вооружений

Маск далеко не одинок в своих крайне скептических (кто-то может сказать, резко паникёрских) взглядах. Годом ранее покойный физик Стивен Хокинг был столь же откровенен, когда сказал аудитории в Португалии, что влияние ИИ может быть катастрофическим, если его быстрое развитие не будет строго контролироваться с этической точки зрения.

«Если мы не научимся готовиться к потенциальным рискам и избегать их, — объяснил он, — ИИ может стать худшим событием в истории нашей цивилизации».

Учитывая количество и размах непостижимо ужасных событий в мировой истории, это действительно о чем-то говорит.

И на случай, если мы недостаточно убедительно дошли до сути, научный сотрудник Стюарт Армстронг из Института будущего жизни назвал ИИ «риском исчезновения», если он выйдет из-под контроля. По его словам, даже ядерная война находится на другом уровне разрушения, потому что она «уничтожит лишь относительно небольшую часть планеты». То же самое с пандемиями, «даже в их более опасной форме».

По его словам, даже ядерная война находится на другом уровне разрушения, потому что она «уничтожит лишь относительно небольшую часть планеты». То же самое с пандемиями, «даже в их более опасной форме».

«Если ИИ выйдет из строя и 95 процентов людей будут убиты, — сказал он, — то оставшиеся пять процентов вскоре исчезнут. Поэтому, несмотря на свою неопределенность, у него есть определенные черты очень серьезных рисков».

Как именно ИИ мог оказаться в такой опасной точке? Ученый-когнитивист и писатель Гэри Маркус поделился некоторыми подробностями в ярком эссе журнала New Yorker 2013 года. Он писал, что чем умнее становятся машины, тем больше могут меняться их цели.

«Как только компьютеры смогут эффективно перепрограммировать себя и последовательно улучшать себя, что приведет к так называемой «технологической сингулярности» или «интеллектуальному взрыву», нельзя просто игнорировать риски, связанные с тем, что машины могут перехитрить людей в битвах за ресурсы и самосохранение. ”

”

Похожие материалыБудущее ИИ: как искусственный интеллект изменит мир

Опасен ли искусственный интеллект?

По мере того, как ИИ становится все более изощренным и вездесущим, голоса, предупреждающие о его нынешних и будущих ловушках, становятся все громче. Будь то растущая автоматизация определенных профессий, гендерные и расовые предубеждения, возникающие из-за устаревших источников информации, или автономное оружие, которое действует без человеческого контроля (и это лишь некоторые из них), тревога изобилует на ряде фронтов. И мы все еще находимся на очень ранних стадиях.

Опасен ли искусственный интеллект?

Техническое сообщество давно обсуждает угрозы, исходящие от искусственного интеллекта. Автоматизация рабочих мест, распространение фальшивых новостей и опасная гонка вооружений на базе ИИ были предложены в качестве некоторых из самых больших опасностей, исходящих от ИИ.

Разрушительный сверхразум — он же искусственный общий интеллект , созданный людьми и ускользающий от нашего контроля, чтобы сеять хаос — находится в отдельной категории. Это также то, что может или не может быть реализовано (теории различаются), так что на данный момент это меньший риск, чем гипотетическая угроза — и постоянно вырисовывающийся источник экзистенциального страха.

Это также то, что может или не может быть реализовано (теории различаются), так что на данный момент это меньший риск, чем гипотетическая угроза — и постоянно вырисовывающийся источник экзистенциального страха.

Вот некоторые из способов, которыми искусственный интеллект представляет серьезную опасность:

Автоматизация работы

Автоматизация работы обычно рассматривается как наиболее неотложная задача. Это уже не вопрос , заменит ли ИИ определенные виды работ, а вопрос , в какой степени . Во многих отраслях — особенно, но не только в тех, чьи работники выполняют предсказуемые и повторяющиеся задачи — прорыв идет полным ходом. По данным 2019 г.Согласно исследованию Brookings Institution, 36 миллионов человек работают на должностях, «сильно подверженных» автоматизации, а это означает, что вскоре не менее 70 процентов их задач — от розничных продаж и анализа рынка до гостиничного бизнеса и работы на складе — будут выполняться с использованием ИИ. В еще более новом отчете Brookings делается вывод о том, что рабочие места белых воротничков на самом деле могут подвергаться наибольшему риску. Согласно отчету McKinsey & Company за 2018 год, больше всего пострадают афроамериканцы.

В еще более новом отчете Brookings делается вывод о том, что рабочие места белых воротничков на самом деле могут подвергаться наибольшему риску. Согласно отчету McKinsey & Company за 2018 год, больше всего пострадают афроамериканцы.

«Причина, по которой у нас низкий уровень безработицы, который на самом деле не охватывает людей, которые не ищут работу, в значительной степени заключается в том, что эта экономика создала рабочие места в сфере услуг с более низкой заработной платой», — известный футурист Мартин Форд. сказал Встроенный. — Не думаю, что это продолжится.

По мере того, как роботы с искусственным интеллектом становятся умнее и ловчее, добавил он, те же самые задачи будут требовать меньше людей. И хотя это правда, что ИИ создаст рабочие места, неустановленное количество которых остается неопределенным, многие из них будут недоступны для менее образованных членов перемещенной рабочей силы.

«Если вы переворачиваете гамбургеры в «Макдоналдсе» и появляется больше автоматизации, подойдет ли вам одна из этих новых вакансий?» — сказал Форд. «Или, вероятно, новая работа требует большого образования или обучения или, может быть, даже внутренних талантов — действительно сильных навыков межличностного общения или творчества, — которых у вас может не быть? Потому что это то, в чем, по крайней мере, пока компьютеры не очень хороши».

«Или, вероятно, новая работа требует большого образования или обучения или, может быть, даже внутренних талантов — действительно сильных навыков межличностного общения или творчества, — которых у вас может не быть? Потому что это то, в чем, по крайней мере, пока компьютеры не очень хороши».

Джон К. Хейвенс, автор книг Heartificial Intelligence: Embracing Humanity и Maximizing Machines , опровергает теорию о том, что ИИ создаст столько же или даже больше рабочих мест, сколько заменит.

Около четырех лет назад, по словам Хэвенса, он брал интервью у главы юридической фирмы о машинном обучении. Этот человек хотел нанять больше людей, но он также был обязан добиться определенного уровня прибыли для своих акционеров. Он обнаружил, что программное обеспечение стоимостью 200 000 долларов может заменить десять человек, получающих зарплату по 100 000 долларов каждый. Это означало, что он сэкономит 800 000 долларов. Программное обеспечение также повысит производительность на 70 процентов и устранит примерно 95 процентов ошибок. Хейвенс сказал, что с чисто ориентированной на акционеров, единой конечной точки зрения «нет никаких юридических причин, по которым он не должен уволить всех людей». Будет ли ему от этого плохо? Конечно. Но это не относится к делу.

Хейвенс сказал, что с чисто ориентированной на акционеров, единой конечной точки зрения «нет никаких юридических причин, по которым он не должен уволить всех людей». Будет ли ему от этого плохо? Конечно. Но это не относится к делу.

Даже профессии, требующие ученых степеней и дополнительной подготовки после окончания колледжа, не застрахованы от смещения ИИ. На самом деле, как сказал технологический стратег Крис Мессина, некоторые из них вполне могут быть уничтожены. ИИ уже оказывает значительное влияние на медицину. По словам Мессины, на очереди юриспруденция и бухгалтерский учет, причем первый готов к «массовым встряскам».

«Подумайте о сложности контрактов и действительно погрузитесь в них и поймите, что нужно для создания идеальной структуры сделки», — сказал он. «Многие адвокаты читают огромное количество информации — сотни или тысячи страниц данных и документов. Очень легко что-то упустить. Таким образом, ИИ, способный прочесать и всесторонне предоставить наилучший возможный контракт для результата, которого вы пытаетесь достичь, вероятно, заменит многих корпоративных юристов».

Бухгалтеры тоже должны подготовиться к большой смене, предупредил Мессина. Как только ИИ сможет быстро прочесывать кучу данных и принимать автоматические решения на основе компьютерных интерпретаций, аудиторы-люди могут стать ненужными.

Подробнее об автоматизации работы с помощью ИИ. Копирайтинг с искусственным интеллектом: почему письменные работы безопасны множество потенциальных рисков. В февральской статье 2018 года под названием «Вредоносное использование искусственного интеллекта: прогнозирование, предотвращение и смягчение последствий» 26 исследователей из 14 учреждений (академических, гражданских и отраслевых) перечислили множество других опасностей, которые могут причинить серьезный вред — или, как минимум, , посеять мелкий хаос — менее чем за пять лет.

«Злонамеренное использование ИИ, — писали они в своем 100-страничном отчете, — может угрожать цифровой безопасности (например, посредством обучения преступников машинам для взлома или социальной инженерии жертв с человеческим или сверхчеловеческим уровнем производительности), физической безопасности (например, не- государственные субъекты, использующие потребительские дроны в качестве оружия), и политическая безопасность (например, посредством слежки, профилирования и репрессий, направленных на устранение конфиденциальности, или посредством автоматизированных и целенаправленных кампаний по дезинформации)».

В дополнение к своей более серьезной угрозе, Ford сосредоточен на том, как ИИ может отрицательно повлиять на конфиденциальность и безопасность. Ярким примером, по его словам, является «оруэлловское» использование Китаем технологии распознавания лиц в офисах, школах и других местах. Но это только одна страна. «Целая экосфера» компаний специализируется на подобных технологиях и продает их по всему миру.

О чем мы пока можем только догадываться, так это о том, станет ли эта технология когда-либо нормализованной. Как и в случае с Интернетом, где мы беспечно жертвуем своими цифровыми данными на алтарь удобства, не покажется ли когда-нибудь круглосуточный мониторинг с анализом ИИ справедливым компромиссом для повышения безопасности и безопасности, несмотря на его гнусную эксплуатацию злоумышленниками?

— Авторитарные режимы используют или собираются использовать его, — сказал Форд. «Вопрос в том, насколько сильно он вторгается в западные страны, демократии и какие ограничения мы на него накладываем?»

«Авторитарные режимы используют или собираются использовать… Вопрос в том, насколько сильно он вторгается в западные страны, демократии и какие ограничения мы на него накладываем?»

По словам Форда, искусственный интеллект также приведет к появлению гиперреалистичных «личностей» в социальных сетях, которых будет очень трудно отличить от реальных. Развернутые дешево и в больших масштабах в Twitter, Facebook или Instagram, они вполне могут повлиять на выборы.

Развернутые дешево и в больших масштабах в Twitter, Facebook или Instagram, они вполне могут повлиять на выборы.

То же самое касается так называемых аудио- и видеодипфейков, созданных путем манипулирования голосами и изображениями. Последний уже набирает обороты. Но первое, по мнению Форда, окажется чрезвычайно проблематичным. Используя машинное обучение, подмножество ИИ, участвующее в обработке естественного языка, можно манипулировать аудиозаписью любого политика, чтобы создать впечатление, будто этот человек высказывает расистские или сексистские взгляды, хотя на самом деле он ничего подобного не говорил. Форд добавил, что если качество клипа будет достаточно высоким, чтобы обмануть широкую публику и избежать обнаружения, это может «полностью сорвать политическую кампанию».

И достаточно одного успеха.

С этого момента, отметил он, «никто не знает, что реально, а что нет. Так что это действительно приводит к ситуации, когда вы буквально не верите своим глазам и ушам; вы не можете полагаться на то, что исторически мы считали лучшим доказательством… Это будет огромной проблемой».

Законодатели, хотя часто и не особо разбираются в технологиях, хорошо осведомлены и настаивают на поиске решений.

Идти глубжеКак распознать технологию дипфейков

Предвзятость ИИ и усиление социально-экономического неравенства

Еще одним поводом для беспокойства является усиление социально-экономического неравенства, вызванное потерей рабочих мест из-за ИИ. Наряду с образованием работа уже давно является драйвером социальной мобильности. Однако, когда это определенный вид работы — предсказуемый, повторяющийся вид, который склонен к захвату ИИ — исследования показали, что те, кто оказывается в дураках, гораздо менее склонны получать или искать переподготовку по сравнению с теми, кто занимает более высокие должности. у кого больше денег. (Опять же, не все в это верят.)

Различные формы предвзятости ИИ тоже вредны. Выступая недавно в New York Times, профессор компьютерных наук из Принстона Ольга Русаковская сказала, что это выходит далеко за рамки пола и расы. Помимо данных и алгоритмической предвзятости (последняя из которых может «усилить» первую), ИИ разрабатывается людьми, а люди по своей природе предвзяты.

Помимо данных и алгоритмической предвзятости (последняя из которых может «усилить» первую), ИИ разрабатывается людьми, а люди по своей природе предвзяты.

«А.И. исследователи — это в первую очередь люди мужского пола, принадлежащие к определенной расовой демографии, выросшие в высоких социально-экономических условиях, в первую очередь люди без инвалидности», — сказал Русаковский. «Мы довольно однородное население, поэтому широко мыслить о мировых проблемах сложно».

В той же статье исследователь Google Тимнит Гебру сказал, что корень предубеждений скорее социальный, чем технологический, и назвал таких ученых, как она, «одними из самых опасных людей в мире, потому что у нас есть эта иллюзия объективности». Она отметила, что научная область «должна быть направлена на то, чтобы попытаться понять социальную динамику мира, потому что большая часть радикальных изменений происходит на социальном уровне».

Не только технологи бьют тревогу по поводу потенциальных социально-экономических ловушек ИИ. Наряду с журналистами и политическими деятелями высказывается и Папа Франциск — и он не просто освистывает Санктуса. На встрече в Ватикане в конце сентября под названием «Общее благо в цифровую эпоху» Франциск предупредил, что ИИ обладает способностью «распространять тенденциозные мнения и ложные данные, которые могут отравить общественные дебаты и даже манипулировать мнениями миллионов людей, ставит под угрозу те самые институты, которые гарантируют мирное гражданское сосуществование».

Наряду с журналистами и политическими деятелями высказывается и Папа Франциск — и он не просто освистывает Санктуса. На встрече в Ватикане в конце сентября под названием «Общее благо в цифровую эпоху» Франциск предупредил, что ИИ обладает способностью «распространять тенденциозные мнения и ложные данные, которые могут отравить общественные дебаты и даже манипулировать мнениями миллионов людей, ставит под угрозу те самые институты, которые гарантируют мирное гражданское сосуществование».

«Если бы так называемый технический прогресс человечества стал врагом общего блага, — добавил он, — это привело бы к печальному регрессу к форме варварства, продиктованной законом сильнейшего».

Большая часть проблемы, по словам Мессины, заключается в погоне частного сектора за прибылью превыше всего. Потому что «это то, что они должны делать», — сказал он. «И поэтому они не думают о том, что здесь лучше всего? Что будет иметь наилучший возможный результат?»

«Ментальность такова: «Если мы можем это сделать, мы должны это попробовать; посмотрим, что получится», — добавил он. «И если мы сможем заработать на этом деньги, мы сделаем целую кучу этого». Но это не уникально для технологий. Так было всегда».

«И если мы сможем заработать на этом деньги, мы сделаем целую кучу этого». Но это не уникально для технологий. Так было всегда».

Автономное оружие и потенциальная гонка вооружений с использованием ИИ

Не все согласны с Маском в том, что ИИ опаснее ядерного оружия, включая Ford. Но что, если ИИ решит запустить ядерных бомб или, скажем, биологическое оружие — без вмешательства человека? Или что, если противник манипулирует данными, чтобы вернуть управляемые ИИ ракеты туда, откуда они прибыли? Обе возможности. И то и другое было бы катастрофой. Более 30 000 исследователей искусственного интеллекта/робототехники и других лиц, подписавших открытое письмо по этому вопросу в 2015 году, определенно так думают.

«Ключевой вопрос для человечества сегодня — начать ли глобальную гонку вооружений ИИ или не допустить ее начала», — написали они. «Если какая-либо крупная военная держава будет продвигать разработку оружия с искусственным интеллектом, глобальная гонка вооружений практически неизбежна, и конечная точка этой технологической траектории очевидна: автономным оружием завтра станут автоматы Калашникова.

В отличие от ядерного оружия, для его производства не требуется дорогое или труднодоступное сырье, поэтому оно станет повсеместным и дешевым для массового производства всеми значительными военными державами. Это будет лишь вопросом времени, когда они появятся на черном рынке и в руках террористов, диктаторов, желающих лучше контролировать свое население, полевых командиров, желающих провести этническую чистку и т. д. Автономное оружие идеально подходит для таких задач, как убийства, дестабилизация народов, подчиняя себе население и выборочно убивая определенную этническую группу. Поэтому мы считаем, что военная гонка вооружений с использованием искусственного интеллекта не принесет пользы человечеству. Есть много способов, с помощью которых ИИ может сделать поля сражений более безопасными для людей, особенно для гражданских лиц, не создавая новых инструментов для убийства людей».

(Предлагаемый бюджет вооруженных сил США на 2020 год составляет 718 миллиардов долларов. Из этой суммы почти 1 миллиард долларов пойдет на поддержку ИИ и машинного обучения для таких вещей, как логистика, анализ разведывательных данных и, да, вооружение. ) сценарий, включающий разработку сложной системы искусственного интеллекта «с целью, скажем, оценки некоторого числа с высокой степенью достоверности. ИИ понимает, что сможет добиться большей уверенности в своих вычислениях, если будет использовать все вычислительное оборудование мира, и понимает, что выпуск биологического супероружия для уничтожения человечества позволит ему бесплатно использовать все оборудование. Уничтожив человечество, он затем с большей достоверностью подсчитывает число».

) сценарий, включающий разработку сложной системы искусственного интеллекта «с целью, скажем, оценки некоторого числа с высокой степенью достоверности. ИИ понимает, что сможет добиться большей уверенности в своих вычислениях, если будет использовать все вычислительное оборудование мира, и понимает, что выпуск биологического супероружия для уничтожения человечества позволит ему бесплатно использовать все оборудование. Уничтожив человечество, он затем с большей достоверностью подсчитывает число».

Это, конечно, раздражает. Но успокойся. В 2012 году министерство обороны администрации Обамы издало директиву об «автономии в системах вооружения», которая включала следующую строку: «Автономные и полуавтономные системы вооружения должны быть разработаны таким образом, чтобы командиры и операторы могли осуществлять надлежащий уровень человеческого суждения в отношении использования сила.»

А в начале ноября этого года группа Пентагона под названием Совет по оборонным инновациям опубликовала этические принципы, касающиеся разработки и развертывания оружия с искусственным интеллектом. Однако, согласно Washington Post, «рекомендации совета никоим образом не имеют обязательной юридической силы. Теперь Пентагону предстоит определить, как и следует ли с ними действовать».

Однако, согласно Washington Post, «рекомендации совета никоим образом не имеют обязательной юридической силы. Теперь Пентагону предстоит определить, как и следует ли с ними действовать».

Что ж, это облегчение. Или нет.

Нестабильность фондового рынка, вызванная алгоритмической высокочастотной торговлей

Вы когда-нибудь задумывались о том, что алгоритмы могут разрушить всю нашу финансовую систему? Правильно, Уолл-Стрит. Возможно, вы захотите принять к сведению. Алгоритмическая торговля может стать причиной нашего следующего крупного финансового кризиса на рынках.

Что такое алгоритмическая торговля? Этот тип торговли возникает, когда компьютер, не обремененный инстинктами или эмоциями, которые могут затуманить человеческое суждение, совершает сделки на основе заранее запрограммированных инструкций. Эти компьютеры могут совершать чрезвычайно крупные, высокочастотные и дорогостоящие сделки, которые могут привести к большим убыткам и крайней волатильности рынка. Алгоритмическая высокочастотная торговля (HFT) оказалась огромным фактором риска на наших рынках. По сути, HFT — это когда компьютер размещает тысячи сделок на невероятной скорости с целью продажи через несколько секунд с небольшой прибылью. Тысячи таких сделок каждую секунду могут равняться довольно большому количеству изменений. Проблема с HFT заключается в том, что он не принимает во внимание, насколько взаимосвязаны рынки, или тот факт, что человеческие эмоции и логика по-прежнему играют огромную роль на наших рынках.

Алгоритмическая высокочастотная торговля (HFT) оказалась огромным фактором риска на наших рынках. По сути, HFT — это когда компьютер размещает тысячи сделок на невероятной скорости с целью продажи через несколько секунд с небольшой прибылью. Тысячи таких сделок каждую секунду могут равняться довольно большому количеству изменений. Проблема с HFT заключается в том, что он не принимает во внимание, насколько взаимосвязаны рынки, или тот факт, что человеческие эмоции и логика по-прежнему играют огромную роль на наших рынках.

Распродажа миллионов акций на рынке авиаперевозок потенциально может напугать людей, заставив их продать свои доли в гостиничном бизнесе, что, в свою очередь, может снежным комом заставить людей продавать свои акции в других компаниях, связанных с путешествиями, что затем может повлиять на логистические компании, компании по поставкам продуктов питания и т. д.

Возьмем в качестве примера «мгновенный крах» в мае 2010 года. К концу торгового дня индекс Доу-Джонса упал на 1000 пунктов (стоимостью более 1 триллиона долларов), прежде чем вернуться к нормальным уровням всего через 36 минут. Что вызвало этот сбой? Первым причиной краха стал лондонский трейдер по имени Навиндер Сингх Сарао, а затем он усугубился компьютерами HFT. Очевидно, Сарао использовал «поддельный» алгоритм, который размещал заказы на тысячи фьючерсных контрактов на фондовые индексы, делая ставку на то, что рынок упадет. Вместо того, чтобы принять ставку, Сарао собирался отменить ордер в последнюю секунду и купить более дешевые акции, которые распродавались из-за его первоначальной ставки. Другие люди и HFT-компьютеры увидели эту ставку в 200 миллионов долларов и восприняли ее как знак того, что рынок вот-вот рухнет. В свою очередь, HFT-компьютеры начали одну из крупнейших распродаж акций в истории, что привело к краткосрочным убыткам в размере более 1 триллиона долларов по всему миру.

Что вызвало этот сбой? Первым причиной краха стал лондонский трейдер по имени Навиндер Сингх Сарао, а затем он усугубился компьютерами HFT. Очевидно, Сарао использовал «поддельный» алгоритм, который размещал заказы на тысячи фьючерсных контрактов на фондовые индексы, делая ставку на то, что рынок упадет. Вместо того, чтобы принять ставку, Сарао собирался отменить ордер в последнюю секунду и купить более дешевые акции, которые распродавались из-за его первоначальной ставки. Другие люди и HFT-компьютеры увидели эту ставку в 200 миллионов долларов и восприняли ее как знак того, что рынок вот-вот рухнет. В свою очередь, HFT-компьютеры начали одну из крупнейших распродаж акций в истории, что привело к краткосрочным убыткам в размере более 1 триллиона долларов по всему миру.

Финансовые алгоритмы HFT также не всегда корректны. Когда дело доходит до правильности, мы рассматриваем компьютеры как конечный результат, но ИИ по-прежнему так же умен, как и люди, которые его запрограммировали. В 2012 году в Knight Capital Group произошел сбой, который поставил ее на грань банкротства. Компьютеры Найта по ошибке передавали тысячи ордеров в секунду на рынок NYSE, вызывая массовый хаос в компании. Алгоритмы HFT совершили поразительные 4 миллиона сделок с 397 миллионами акций всего за 45 минут. Волатильность, вызванная этой компьютерной ошибкой, привела к тому, что Найт потерял 460 миллионов долларов в одночасье и был вынужден быть приобретен другой фирмой. Ошибочные алгоритмы, очевидно, имеют огромные последствия для акционеров и самих рынков, и никто не усвоил этот урок лучше, чем Найт.

В 2012 году в Knight Capital Group произошел сбой, который поставил ее на грань банкротства. Компьютеры Найта по ошибке передавали тысячи ордеров в секунду на рынок NYSE, вызывая массовый хаос в компании. Алгоритмы HFT совершили поразительные 4 миллиона сделок с 397 миллионами акций всего за 45 минут. Волатильность, вызванная этой компьютерной ошибкой, привела к тому, что Найт потерял 460 миллионов долларов в одночасье и был вынужден быть приобретен другой фирмой. Ошибочные алгоритмы, очевидно, имеют огромные последствия для акционеров и самих рынков, и никто не усвоил этот урок лучше, чем Найт.

Подробнее об искусственном интеллекте Технология искусственного интеллекта с эмоциями имеет большие перспективы (при ответственном использовании)

Снижение рисков, связанных с искусственным интеллектом регулирования.

«Обычно я не сторонник регулирования и надзора — я думаю, что обычно следует ошибаться в сторону минимизации этих вещей — но это тот случай, когда вы представляете очень серьезную опасность для общества», — сказал Маск на SXSW.

«Это должен быть государственный орган, обладающий пониманием и надзором, чтобы подтвердить, что все разрабатывают ИИ безопасно. Это чрезвычайно важно».

Форд согласен — с одной оговоркой. Он сказал, что регулирование внедрения AI в порядке, но не самого исследования.

«Вы регулируете использование ИИ, — сказал он, — но вы не сдерживаете прогресс в базовых технологиях. Я думаю, что это было бы ошибочным и потенциально опасным».

«Вы регулируете использование ИИ… но не сдерживаете прогресс в базовых технологиях. Я думаю, что это было бы ошибочным и потенциально опасным».

Потому что любая страна, отстающая в развитии ИИ, находится в невыгодном положении — в военном, социальном и экономическом плане. Решение, продолжил Форд, заключается в выборочном применении:

«Мы решаем, где нам нужен ИИ, а где нет; где допустимо, а где нет. И разные страны собираются сделать разный выбор. Так что у Китая он может быть везде, но это не значит, что мы можем позволить себе отставать от них по уровню техники».

Говоря об автономном оружии в Принстонском университете, американский генерал Джон Р. Аллен подчеркнул необходимость «активного международного обсуждения, которое может охватить суть этой технологии». Если необходимо, продолжил он, следует также обсудить, как лучше всего контролировать это, будь то договор, полностью запрещающий оружие ИИ, или договор, разрешающий только определенные виды применения технологии.

Для Havens более безопасный ИИ начинается и заканчивается людьми. Его главный акцент, который он излагает в своей книге 2016 года, заключается в следующем: «Как машины узнают, что мы ценим, если мы не знаем самих себя?» По его словам, при создании инструментов ИИ жизненно важно «уважать ценности конечного пользователя с упором на человека», а не зацикливаться на краткосрочных выгодах.

«Технологии были способны помочь нам с задачами с тех пор, как появилось человечество», — написал Хейвенс в Heartificial Intelligence . «Но как раса мы никогда не сталкивались с серьезной вероятностью того, что машины могут стать умнее нас или наполниться сознанием. Эта технологическая вершина является важным отличием, которое необходимо признать как для того, чтобы возвысить стремление воздать должное человечеству, так и для того, чтобы наилучшим образом определить, как ИИ может его развивать. Вот почему нам нужно знать, какие задачи мы хотим обучить машинам, чтобы они выполняли их осознанно. Это включало как индивидуальный, так и общественный выбор».

Эта технологическая вершина является важным отличием, которое необходимо признать как для того, чтобы возвысить стремление воздать должное человечеству, так и для того, чтобы наилучшим образом определить, как ИИ может его развивать. Вот почему нам нужно знать, какие задачи мы хотим обучить машинам, чтобы они выполняли их осознанно. Это включало как индивидуальный, так и общественный выбор».

Исследователи ИИ Фей-Фей Ли и Джон Этчеменди из Института ориентированного на человека искусственного интеллекта Стэнфордского университета считают то же самое. В недавнем сообщении в блоге они предложили привлечь множество людей из самых разных областей, чтобы убедиться, что ИИ реализует свой огромный потенциал и укрепит общество, а не ослабит его:

«Наше будущее зависит от способности ученых-социологов и компьютерных работать бок о бок с людьми из разных слоев общества — значительный отход от сегодняшней модели, ориентированной на информатику», — написали они. «Создатели ИИ должны искать идеи, опыт и проблемы людей разных национальностей, полов, культур и социально-экономических групп, а также людей из других областей, таких как экономика, право, медицина, философия, история, социология, коммуникации. , взаимодействие человека с компьютером, психология и исследования науки и техники (STS). Это сотрудничество должно осуществляться на протяжении всего жизненного цикла приложения — от самых ранних этапов до выхода на рынок и по мере масштабирования его использования».

«Создатели ИИ должны искать идеи, опыт и проблемы людей разных национальностей, полов, культур и социально-экономических групп, а также людей из других областей, таких как экономика, право, медицина, философия, история, социология, коммуникации. , взаимодействие человека с компьютером, психология и исследования науки и техники (STS). Это сотрудничество должно осуществляться на протяжении всего жизненного цикла приложения — от самых ранних этапов до выхода на рынок и по мере масштабирования его использования».

Мессина несколько идеалистичен в отношении того, что должно произойти , чтобы помочь избежать хаоса ИИ, хотя он скептически относится к тому, что это действительно произойдет. По его словам, государственное регулирование не является чем-то само собой разумеющимся, особенно в свете неудач на этом фронте в сфере социальных сетей, технологические сложности которых меркнут по сравнению со сложностями искусственного интеллекта. Со стороны крупных технологических компаний потребуются «очень серьезные усилия», чтобы замедлить прогресс во имя большей устойчивости и меньшего количества непредвиденных последствий — особенно масштабных разрушительных.

«В данный момент, — сказал он, — я не думаю, что это должно произойти».

По мнению Мессины, для достижения этой цели потребуется некий «катализатор». Точнее, катастрофических катализаторов вроде войны или экономического коллапса. Хотя вопрос о том, окажется ли такое событие «достаточно большим, чтобы действительно привести к значимым долгосрочным изменениям, остается открытым».

Со своей стороны, Форд остается оптимистом в долгосрочной перспективе, несмотря на то, что он «очень не оптимистичен» в отношении ИИ.

«Я думаю, что мы можем говорить обо всех этих рисках, и они очень реальны, но ИИ также станет самым важным инструментом в нашем наборе инструментов для решения самых больших проблем, с которыми мы сталкиваемся», включая изменение климата.

Однако, когда дело доходит до ближайшей перспективы, его сомнения становятся более выраженными.

«Нам действительно нужно быть умнее, — сказал он. «В течение следующих десяти или двух лет я действительно беспокоюсь об этих проблемах и нашей способности адаптироваться к ним».

Преимущества и риски искусственного интеллекта

» Все, что нам нравится в цивилизации, является продуктом интеллекта, поэтому усиление нашего человеческого интеллекта с помощью искусственного интеллекта может помочь цивилизации процветать как никогда раньше — до тех пор, пока нам удается поддерживать технологию полезной. “

Макс Тегмарк , Президент Института Будущего Жизни

Нажмите здесь, чтобы увидеть эту страницу на других языках: Китайский Французский Немецкий Японский Корейский Русский

Что такое ИИ?

От SIRI до самоуправляемых автомобилей искусственный интеллект (ИИ) быстро развивается. В то время как научная фантастика часто изображает ИИ как роботов с человеческими характеристиками, ИИ может охватывать что угодно, от поисковых алгоритмов Google до Watson от IBM и автономного оружия.

Искусственный интеллект сегодня правильно известен как узкий ИИ (или слабый ИИ), поскольку он предназначен для выполнения узкой задачи (например, только распознавание лиц, или только поиск в Интернете, или только вождение автомобиля). Однако долгосрочной целью многих исследователей является создание общего ИИ (AGI или сильного ИИ). В то время как узкий ИИ может превзойти людей в любой конкретной задаче, такой как игра в шахматы или решение уравнений, ОИИ превзойдет людей почти во всех когнитивных задачах.

Однако долгосрочной целью многих исследователей является создание общего ИИ (AGI или сильного ИИ). В то время как узкий ИИ может превзойти людей в любой конкретной задаче, такой как игра в шахматы или решение уравнений, ОИИ превзойдет людей почти во всех когнитивных задачах.

Зачем исследовать безопасность ИИ?

В ближайшей перспективе цель сохранения положительного влияния ИИ на общество мотивирует исследования во многих областях, от экономики и права до технических тем, таких как проверка, достоверность, безопасность и контроль. Если ваш ноутбук выйдет из строя или будет взломан, это может быть не более чем незначительной неприятностью, тем более важно, чтобы система ИИ делала то, что вы хотите, если она управляет вашей машиной, вашим самолетом, вашим кардиостимулятором, вашей автоматической торговлей. системы или вашей электросети. Еще одна краткосрочная задача — предотвратить разрушительную гонку смертоносных автономных вооружений.

В долгосрочной перспективе важный вопрос заключается в том, что произойдет, если поиски сильного ИИ увенчаются успехом и система ИИ станет лучше людей во всех когнитивных задачах. Как указывает И.Дж. Хорошо в 1965 году, разработка более умных систем ИИ сама по себе является когнитивной задачей. Такая система потенциально может подвергаться рекурсивному самосовершенствованию, вызывая взрыв интеллекта, оставляя человеческий интеллект далеко позади. Изобретая революционно новые технологии, такой сверхразум может помочь нам искоренить войны, болезни и бедность, поэтому создание сильного ИИ может стать крупнейшим событием в истории человечества. Однако некоторые эксперты выразили обеспокоенность тем, что это может быть и последнее, если мы не научимся согласовывать цели ИИ с нашими, прежде чем он станет сверхразумным.

Как указывает И.Дж. Хорошо в 1965 году, разработка более умных систем ИИ сама по себе является когнитивной задачей. Такая система потенциально может подвергаться рекурсивному самосовершенствованию, вызывая взрыв интеллекта, оставляя человеческий интеллект далеко позади. Изобретая революционно новые технологии, такой сверхразум может помочь нам искоренить войны, болезни и бедность, поэтому создание сильного ИИ может стать крупнейшим событием в истории человечества. Однако некоторые эксперты выразили обеспокоенность тем, что это может быть и последнее, если мы не научимся согласовывать цели ИИ с нашими, прежде чем он станет сверхразумным.

Некоторые сомневаются, будет ли когда-нибудь создан сильный ИИ, а другие настаивают на том, что создание сверхразумного ИИ гарантированно принесет пользу. В FLI мы признаем обе эти возможности, но также признаем, что система искусственного интеллекта может намеренно или непреднамеренно причинить большой вред. Мы считаем, что сегодняшние исследования помогут нам лучше подготовиться к таким потенциально негативным последствиям в будущем и предотвратить их, таким образом, пользуясь преимуществами ИИ и избегая ловушек.

Ссылка на: Сообщество по экзистенциальной безопасности ИИ

Сообщество по экзистенциальной безопасности ИИ

Мы считаем, что сегодняшние исследования помогут нам лучше подготовиться к таким потенциально негативным последствиям и предотвратить их в будущем, таким образом, пользуясь преимуществами ИИ и избегая ловушек. Нажмите здесь, чтобы ознакомиться с нашим растущим сообществом исследователей экзистенциальной безопасности ИИ.

Чем может быть опасен ИИ?

Большинство исследователей сходятся во мнении, что сверхразумный ИИ вряд ли будет проявлять человеческие эмоции, такие как любовь или ненависть, и что нет причин ожидать, что ИИ намеренно станет доброжелательным или злонамеренным. Вместо этого при рассмотрении того, как ИИ может стать риском, эксперты считают наиболее вероятными два сценария:

- ИИ запрограммирован на разрушительные действия: Автономное оружие — это системы искусственного интеллекта, запрограммированные на убийство.

В руках не того человека это оружие могло легко привести к массовым жертвам. Более того, гонка вооружений ИИ может непреднамеренно привести к войне ИИ, которая также приведет к массовым жертвам. Чтобы не помешать противнику, это оружие будет спроектировано таким образом, чтобы его было чрезвычайно трудно просто «выключить», поэтому люди, вероятно, могли бы потерять контроль над такой ситуацией. Этот риск присутствует даже при узком ИИ, но растет по мере увеличения уровня интеллекта и автономии ИИ.

В руках не того человека это оружие могло легко привести к массовым жертвам. Более того, гонка вооружений ИИ может непреднамеренно привести к войне ИИ, которая также приведет к массовым жертвам. Чтобы не помешать противнику, это оружие будет спроектировано таким образом, чтобы его было чрезвычайно трудно просто «выключить», поэтому люди, вероятно, могли бы потерять контроль над такой ситуацией. Этот риск присутствует даже при узком ИИ, но растет по мере увеличения уровня интеллекта и автономии ИИ. - ИИ запрограммирован делать что-то полезное, но он разрабатывает деструктивный метод для достижения своей цели: Это может произойти всякий раз, когда мы не можем полностью согласовать цели ИИ с нашими, что поразительно сложно. Если вы попросите послушную умную машину как можно быстрее доставить вас в аэропорт, она может доставить вас туда в погоне за вертолетами и в блевотине, делая не то, что вы хотели, а буквально то, о чем вы просили. Если сверхразумной системе поручается амбициозный геоинженерный проект, она может нанести ущерб нашей экосистеме в качестве побочного эффекта и рассматривать попытки человека остановить ее как угрозу, которую необходимо устранить.

Ссылка на: Автономные системы смертоносного оружия

Пример: Автономное смертоносное оружие

Роботы-убийцы, также называемые «автономными системами смертоносного оружия» или «роботами-убийцами», — это системы оружия, которые используют искусственный интеллект (ИИ) для идентификации, выбора и убивать человеческие цели без вмешательства человека.

Эта технология уже существует, и она сопряжена с огромным риском. Узнайте больше о смертоносном автономном оружии и о том, что мы можем сделать для его предотвращения, здесь.

Как показывают эти примеры, продвинутый ИИ вызывает не злорадство, а компетентность. Сверхинтеллектуальный ИИ будет чрезвычайно хорош в достижении своих целей, и если эти цели не совпадают с нашими, у нас есть проблема. Вы, вероятно, не злобный ненавистник муравьев, который наступает на муравьев из злого умысла, но если вы отвечаете за проект гидроэлектростанции с экологически чистой энергией, а в регионе есть муравейник, который нужно затопить, очень плохо для муравьев. Ключевая цель исследования безопасности ИИ — никогда не ставить человечество в положение этих муравьев.

Ключевая цель исследования безопасности ИИ — никогда не ставить человечество в положение этих муравьев.

Почему недавний интерес к безопасности ИИ

Стивен Хокинг, Илон Маск, Стив Возняк, Билл Гейтс и многие другие знаменитости в науке и технике недавно выразили обеспокоенность в средствах массовой информации и в открытых письмах по поводу рисков, связанных с ИИ, к ним присоединились многие ведущие исследователи ИИ. Почему эта тема вдруг оказалась в заголовках?

Идея о том, что поиски сильного ИИ в конечном счете увенчаются успехом, долгое время считалась научной фантастикой, на протяжении столетий или даже больше. Тем не менее, благодаря недавним прорывам, многие вехи ИИ, которые эксперты считали отстоящими на десятилетия всего пять лет назад, теперь достигнуты, что заставляет многих экспертов серьезно отнестись к возможности сверхразума в нашей жизни. В то время как некоторые эксперты до сих пор предполагают, что до ИИ человеческого уровня еще далеко, большинство исследователей ИИ на конференции в Пуэрто-Рико в 2015 году предположили, что это произойдет до 2060 года. Поскольку для завершения необходимых исследований в области безопасности могут потребоваться десятилетия, разумно начать их сейчас. .

Поскольку для завершения необходимых исследований в области безопасности могут потребоваться десятилетия, разумно начать их сейчас. .

Поскольку ИИ потенциально может стать умнее любого человека, у нас нет надежного способа предсказать его поведение. Мы не можем использовать прошлые технологические разработки в качестве основы, потому что мы никогда не создавали ничего, что могло бы, вольно или невольно, перехитрить нас. Лучшим примером того, с чем мы можем столкнуться, может быть наша собственная эволюция. Люди теперь контролируют планету не потому, что мы самые сильные, самые быстрые или самые большие, а потому, что мы самые умные. Если мы перестанем быть самыми умными, уверены ли мы, что останемся у руля?

Позиция FLI заключается в том, что наша цивилизация будет процветать до тех пор, пока мы будем побеждать в гонке между растущей мощью технологий и мудростью, с которой мы ими управляем. В случае с технологией ИИ позиция FLI заключается в том, что лучший способ победить в этой гонке — не препятствовать первому, а ускорить второе, поддерживая исследования безопасности ИИ.

Самые популярные мифы о продвинутом ИИ

Идет увлекательный разговор о будущем искусственного интеллекта и о том, что он будет/должен значить для человечества. Ведущие мировые эксперты расходятся во мнениях по поводу увлекательных споров, таких как: будущее влияние ИИ на рынок труда; если/когда будет разработан искусственный интеллект человеческого уровня; приведет ли это к взрыву интеллекта; и следует ли нам приветствовать это или опасаться. Но есть также много примеров скучных псевдоспоров, вызванных тем, что люди неправильно понимают друг друга и говорят друг с другом. Чтобы помочь себе сосредоточиться на интересных противоречиях и открытых вопросах, а не на недоразумениях, давайте проясним некоторые из наиболее распространенных мифов.

Мифы о временной шкале

Первый миф касается временной шкалы: сколько времени потребуется, чтобы машины значительно превзошли человеческий интеллект? Распространенным заблуждением является то, что мы знаем ответ с большой уверенностью.

Один из популярных мифов состоит в том, что мы знаем, что в этом столетии мы получим сверхчеловеческий ИИ. На самом деле, история полна технологического преувеличения. Где те термоядерные электростанции и летающие автомобили, которые нам обещали уже иметь? В прошлом ИИ также неоднократно преувеличивался, даже некоторыми основателями этой области. Например, Джон Маккарти (который ввел термин «искусственный интеллект»), Марвин Мински, Натаниэль Рочестер и Клод Шеннон написали этот чрезмерно оптимистичный прогноз о том, что можно сделать за два месяца с компьютерами каменного века: «Мы предлагаем провести двухмесячное исследование искусственного интеллекта с участием 10 человек летом 1956 года в Дартмутском колледже . Будет предпринята попытка выяснить, как заставить машины использовать язык, формировать проблемы, теперь зарезервированные для людей, и улучшают себя. Мы думаем, что можно добиться значительного прогресса в решении одной или нескольких из этих проблем, если тщательно подобранная группа ученых вместе поработает над ней в течение лета».

С другой стороны, популярный контр-миф состоит в том, что мы знаем, что в этом столетии не будет сверхчеловеческого ИИ. Исследователи сделали широкий диапазон оценок того, насколько мы далеки от сверхчеловеческого ИИ, но мы, конечно, не можем с большой уверенностью сказать, что вероятность равна нулю в этом столетии, учитывая мрачный послужной список таких техно-скептических прогнозов. Например, Эрнест Резерфорд, возможно, величайший физик-ядерщик своего времени, сказал в 1919 г.33 — менее чем за 24 часа до изобретения Сцилардом цепной ядерной реакции — что ядерная энергия была «самогоном». А королевский астроном Ричард Вулли в 1956 году назвал межпланетные путешествия «полным бредом». Самая крайняя форма этого мифа заключается в том, что сверхчеловеческий ИИ никогда не появится, потому что это физически невозможно. Однако физики знают, что мозг состоит из кварков и электронов, устроенных так, чтобы действовать как мощный компьютер, и что нет законов физики, препятствующих нам создавать еще более разумные кварковые шарики.

В ходе ряда опросов исследователей ИИ спрашивали, через сколько лет, по их мнению, у нас будет ИИ человеческого уровня с вероятностью не менее 50 %. Все эти опросы имеют один и тот же вывод: ведущие мировые эксперты расходятся во мнениях, поэтому мы просто не знаем. Например, в таком опросе исследователей ИИ на конференции ИИ в Пуэрто-Рико в 2015 году средний (медианный) ответ был к 2045 году, но некоторые исследователи предполагали сотни лет или больше.

Существует также связанный с этим миф о том, что люди, которые беспокоятся об ИИ, думают, что до него осталось всего несколько лет. На самом деле, большинство известных людей, беспокоящихся о сверхчеловеческом ИИ, предполагают, что до него еще по крайней мере десятилетия. Но они утверждают, что, пока мы не уверены на 100%, что этого не произойдет в этом столетии, разумно начать исследование безопасности сейчас, чтобы подготовиться к возможностям. Многие проблемы безопасности, связанные с искусственным интеллектом человеческого уровня, настолько сложны, что на их решение могут уйти десятилетия. Поэтому разумно начать исследовать их сейчас, а не накануне вечером, когда некоторые программисты, пьющие Red Bull, решат включить один из них.

Поэтому разумно начать исследовать их сейчас, а не накануне вечером, когда некоторые программисты, пьющие Red Bull, решат включить один из них.

Противоречивые мифы

Еще одно распространенное заблуждение состоит в том, что единственными людьми, питающими опасения по поводу ИИ и поддерживающими исследования безопасности ИИ, являются луддиты, которые мало что знают об ИИ. Когда Стюарт Рассел, автор стандартного учебника по искусственному интеллекту, упомянул об этом во время своего выступления в Пуэрто-Рико, аудитория громко рассмеялась. Связанное с этим заблуждение состоит в том, что поддержка исследований безопасности ИИ вызывает огромные споры. На самом деле, чтобы поддерживать скромные инвестиции в исследования безопасности ИИ, людей не нужно убеждать в том, что риски высоки, просто не пренебрежимо малы — так же, как скромные инвестиции в страхование жилья оправдываются значительной вероятностью того, что дом сжигание.

Возможно, средства массовой информации сделали дебаты о безопасности ИИ более спорными, чем они есть на самом деле. В конце концов, страх продается, а статьи, в которых используются вырванные из контекста цитаты, чтобы объявить о неминуемой гибели, могут генерировать больше кликов, чем детализированные и сбалансированные. В результате два человека, которые знают о позициях друг друга только из цитат из СМИ, скорее всего, будут думать, что они не согласны друг с другом больше, чем на самом деле. Например, техноскептик, прочитавший о позиции Билла Гейтса только в британском таблоиде, может ошибочно подумать, что Гейтс верит в неизбежность появления сверхразума. Точно так же кто-то из движения за благотворный ИИ, который ничего не знает о позиции Эндрю Нг, кроме его цитаты о перенаселении Марса, может ошибочно подумать, что его не волнует безопасность ИИ, хотя на самом деле это не так. Суть просто в том, что, поскольку оценки Нг на временной шкале длиннее, он, естественно, склонен отдавать приоритет краткосрочным задачам ИИ над долгосрочными.

В конце концов, страх продается, а статьи, в которых используются вырванные из контекста цитаты, чтобы объявить о неминуемой гибели, могут генерировать больше кликов, чем детализированные и сбалансированные. В результате два человека, которые знают о позициях друг друга только из цитат из СМИ, скорее всего, будут думать, что они не согласны друг с другом больше, чем на самом деле. Например, техноскептик, прочитавший о позиции Билла Гейтса только в британском таблоиде, может ошибочно подумать, что Гейтс верит в неизбежность появления сверхразума. Точно так же кто-то из движения за благотворный ИИ, который ничего не знает о позиции Эндрю Нг, кроме его цитаты о перенаселении Марса, может ошибочно подумать, что его не волнует безопасность ИИ, хотя на самом деле это не так. Суть просто в том, что, поскольку оценки Нг на временной шкале длиннее, он, естественно, склонен отдавать приоритет краткосрочным задачам ИИ над долгосрочными.

Мифы о рисках сверхчеловеческого ИИ

Многие исследователи ИИ закатывают глаза, увидев этот заголовок: « Стивен Хокинг предупреждает, что появление роботов может иметь катастрофические последствия для человечества». И столько же сбились со счета, сколько похожих статей они видели. Как правило, эти статьи сопровождаются злобным роботом с оружием, и они предлагают нам беспокоиться о том, что роботы восстанут и убьют нас, потому что они стали сознательными и/или злыми. С другой стороны, такие статьи на самом деле впечатляют, потому что они кратко излагают сценарий, который исследователи ИИ рассматривают9.0055 не об этом не беспокойтесь. Этот сценарий сочетает в себе целых три отдельных заблуждения: озабоченность сознанием , злом, и роботами .

И столько же сбились со счета, сколько похожих статей они видели. Как правило, эти статьи сопровождаются злобным роботом с оружием, и они предлагают нам беспокоиться о том, что роботы восстанут и убьют нас, потому что они стали сознательными и/или злыми. С другой стороны, такие статьи на самом деле впечатляют, потому что они кратко излагают сценарий, который исследователи ИИ рассматривают9.0055 не об этом не беспокойтесь. Этот сценарий сочетает в себе целых три отдельных заблуждения: озабоченность сознанием , злом, и роботами .

Если вы едете по дороге, у вас есть субъективное восприятие цветов, звуков, и т. д. . Но есть ли у беспилотного автомобиля субъективный опыт? Есть ли вообще что-то похожее на то, чтобы быть самоуправляемым автомобилем? Хотя эта загадка сознания интересна сама по себе, она не имеет отношения к риску ИИ. Если вас сбил беспилотный автомобиль, для вас не имеет значения, чувствует ли он себя в сознании субъективно. Точно так же на нас, людей, повлияет то, что сверхразумный ИИ делает , а не то , как субъективно ощущается .

Точно так же на нас, людей, повлияет то, что сверхразумный ИИ делает , а не то , как субъективно ощущается .

Страх перед машинами, превращающими зло, — еще один отвлекающий маневр. Настоящее беспокойство вызывает не злоба, а компетентность. Сверхразумный ИИ по определению очень хорошо достигает своих целей, какими бы они ни были, поэтому мы должны убедиться, что его цели совпадают с нашими. Люди обычно не ненавидят муравьев, но мы умнее их, поэтому, если мы хотим построить плотину гидроэлектростанции, а там есть муравейник, это плохо для муравьев. Движение за благотворный ИИ хочет не ставить человечество в положение этих муравьев.

Заблуждение сознания связано с мифом о том, что у машин не может быть целей. Машины, очевидно, могут иметь цели в узком смысле проявления целенаправленного поведения: поведение ракеты с тепловым наведением наиболее экономически объясняется как цель поразить цель. Если вы чувствуете угрозу со стороны машины, цели которой расходятся с вашими, то вас беспокоят именно ее цели в этом узком смысле, а не то, сознательна ли машина и испытывает ли она чувство цели. Если бы за вами гналась эта ракета с тепловым наведением, вы бы, наверное, не воскликнули: «Я не беспокоюсь, потому что у машин не может быть целей!»

Если бы за вами гналась эта ракета с тепловым наведением, вы бы, наверное, не воскликнули: «Я не беспокоюсь, потому что у машин не может быть целей!»

Я сочувствую Родни Бруксу и другим пионерам робототехники, которые чувствуют себя несправедливо демонизированными пугающими таблоидами, потому что некоторые журналисты, кажется, одержимы роботами и украшают многие свои статьи злобными металлическими монстрами с красными блестящими глазами. Фактически, главная забота движения за полезный ИИ связана не с роботами, а с самим интеллектом: в частности, с интеллектом, цели которого не совпадают с нашими. Чтобы доставить нам неприятности, такой несогласованный сверхчеловеческий интеллект не нуждается в роботизированном теле, а просто в подключении к Интернету — это может позволить перехитрить финансовые рынки, изобретать исследователей-людей, манипулировать лидерами-людьми и разрабатывать оружие, которое мы даже не можем понять. Даже если бы создание роботов было физически невозможно, сверхинтеллектуальный и сверхбогатый ИИ мог бы легко платить или манипулировать многими людьми, чтобы они невольно выполняли его приказы.