Содержание

Разработчик Google заявил, что созданный в компании ИИ обладает сознанием — Газета.Ru

Разработчик Google заявил, что созданный в компании ИИ обладает сознанием — Газета.Ru | Новости

close

100%

Созданная в Google нейросетевая языковая модель LaMDA обладает признаками искусственного интеллекта с собственным сознанием, заявил инженер по программному обеспечению Блейк Лемойн в интервью для газеты The Washington Post.

Лемойн, которого временно отстранили от работы, рассказал, что в ходе тестов LaMDA, который должен отслеживать, не использует ли чат-бот дискриминационную или разжигающую вражду лексику, он пришел к выводу, что нейросеть обладает собственным сознанием.

«Если бы я не знал наверняка, что имею дело с компьютерной программой, которую мы недавно написали, то я бы подумал, что говорю с ребенком семи или восьми лет, который по какой-то причине оказался знатоком физики», — пояснил Лемойн.

Он отметил, что подготовил документальный отчет, в котором привел доказательства существования сознания у LaMDA. Тем не менее, в Google сочли доказательства Лемойна неубедительными.

«Ему было сказано, что свидетельства того, что LaMDA обладает сознанием, отсутствуют. При этом есть множество свидетельств обратного», — указано в сообщении официального представителя Google Брайана Гэбриела.

Лемойн был отстранен от работы из-за нарушения политики конфиденциальности компании.

Ранее блогер создал самый токсичный и расистский ИИ.

Подписывайтесь на «Газету.Ru» в Новостях, Дзен и Telegram.

Чтобы сообщить об ошибке, выделите текст и нажмите Ctrl+Enter

Новости

Дзен

Telegram

Иван Глушков

Вокруг света за выходные

О главных праздничных блюдах разных стран

Георгий Бовт

Мир без людей

О том, что будет, когда всем начнет править искусственный разум

Алена Солнцева

«Я даю тебе лям в рублях, а ты мне кино снимаешь»

О новом образе 90-х, Константинопольском, Византийском и о том, чем это кончилось

Дмитрий Воденников

Жестокий Андерсен

О том, какие сказки надо рассказывать под Новый год

Александр Тихомиров

Зарплата №13

О том, как грамотно распорядиться новогодним бонусом

Найдена ошибка?

Закрыть

Спасибо за ваше сообщение, мы скоро все поправим.

Продолжить чтение

Google представила генератор видео по тексту на базе Imagen

06.10.2022

Марина Глайборода

#Google#Искусственный Интеллект#нейросети

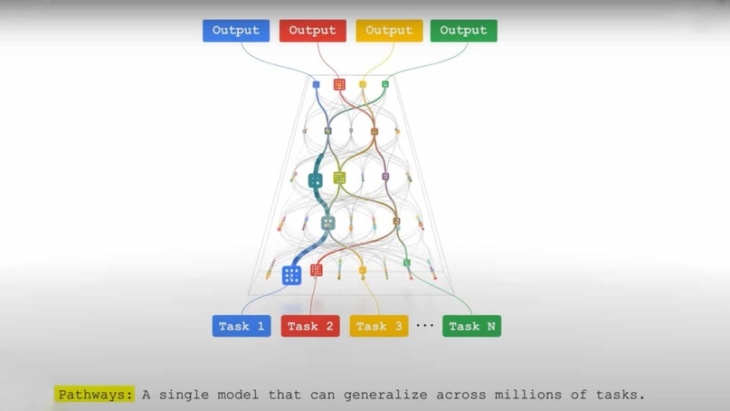

Исследователи Google объявили о разработке системы искусственного интеллекта Imagen Video, способной по словесным запросам генерировать видео с разрешением 1280×768 пикселей и частотой 24 кадра в секунду.

Excited to announce Imagen Video, our new text-conditioned video diffusion model that generates 1280×768 24fps HD videos! #ImagenVideohttps://t.co/JWj3L7MpBU

Work w/ @wchan212 @Chitwan_Saharia @jaywhang_ @RuiqiGao @agritsenko @dpkingma @poolio @mo_norouzi @fleet_dj @TimSalimans pic.twitter.com/eN81LqZW7I— Jonathan Ho (@hojonathanho) October 5, 2022

Инструмент базируется на алгоритме Imagen, являющемся аналогом DALL-E 2 и Stable Diffusion. Генератор картинок использует большую предобученную языковую нейросеть и каскадную диффузную модель, и сочетает в себе «глубокий уровень понимания слов с беспрецедентной степенью фотореализма».

Изображения, сгенерированные Imagen. Данные: Google.

Как поясняют исследователи Google, Imagen Video берет текстовое описание и создает 16-кадровый ролик с разрешением 24×48 пикселей и частотой 3 FPS. Затем система масштабирует и «предсказывает» дополнительные изображения.

В результате алгоритм генерирует 128-кадровую анимацию с разрешением 1280×768 пикселей и частотой 24 FPS.

Первый этап генерации видео Imagen Video. Данные: Google.Промежуточный этап генерации видео Imagen Video. Данные: Google.Готовое видео, сгенерированное Imagen Video. Данные: Google.

Для обучения Imagen Video разработчики использовали 14 млн пар «видео-описание» и 60 млн «изображение-текст», а также общедоступный набор данных LAION-400M, что позволило модели применять ряд эстетических аспектов.

Видео, сгенерированное Imagen Video. Данные: Google.

Во время тестирования исследователи обнаружили, что алгоритм может создавать «акварельные» ролики или переносить стиль Ван Гога. По их словам, Imagen Video продемонстрировал понимание глубины и трехмерности, что позволило ему генерировать видео, как будто записанные дроном.

Видео, сгенерированное Imagen Video. Данные: Google.

Также система умеет правильно отображать текст.

«В отличие от Stable Diffusion и DALL-E 2, которые пытаются превратить запрос вроде “логотип для Diffusion” в читаемые слова, Imagen Video воспроизводит его без проблем», — говорится в документе проекта.

По словам ИИ-исследователя из Университета Альберты Мэтью Гуздиала, проблема преобразования текста в видео до сих пор не решена.

«Мы вряд ли скоро достигнем чего-то вроде DALL-E 2 или Midjourney по качеству [создания роликов]», — заявил он.

Чтобы убрать дрожание в видео и избавиться от искажений, команда Imagen Video планирует объединить усилия с разработчиками Phenaki. Это еще один генератор от Google, превращающий длинные подробные подсказки в двухминутные ролики низкого качества.

В Google также отмечают, что используемые для обучения данные содержали неприемлемый контент, из-за чего Imagen Video иногда создает клипы с изображением насилия или сексуального характера. Поэтому компания не планирует выпускать модель или ее исходный код до исправления проблемы.

Напомним, в сентябре энтузиаст разработал генератор анимации по тексту Stable Diffusion Video.

В августе TikTok представил инструмент создания фонов для видео по словесным запросам.

В июне китайские исследователи разработали трансформер CogVideo с 9 млрд параметров для преобразования текста в анимацию.

Подписывайтесь на новости ForkLog в Telegram: ForkLog AI — все новости из мира ИИ!

Нашли ошибку в тексте? Выделите ее и нажмите CTRL+ENTER

Старший вице-президент Google призывает к более строгому регулированию искусственного интеллекта

Последние несколько лет продемонстрировали невероятные возможности искусственного интеллекта, а также связанные с ним многочисленные риски. Для Джеймса Маньики, старшего вице-президента Google по технологиям и обществу, это означает тратить много времени на размышления о том, что может пойти не так.

«Эти технологии связаны с чрезвычайным рядом рисков и проблем, – сказала Маньика на мероприятии Brainstorm A.I. конференции в Сан-Франциско в понедельник, на которой упоминалось все: от влияния ИИ на рынки труда до технологий, которые не работают должным образом, а также преднамеренного неправильного использования ИИ.

Во время беседы на сцене с генеральным директором Fortune Аланом Мюрреем Маньика указал на многочисленные недавние достижения в области искусственного интеллекта. в таких областях, как биология, математика и физика.

«Мы начинаем показывать, что А.И. действительно может помочь нам совершить экстраординарные прорывы в этих фундаментальных областях, которые будут невероятно полезны», — сказал он.

В частности, в Google это означает использование ИИ. для улучшения существующих продуктов, таких как поиск, а также для создания новых продуктов, которые были бы невозможны без достижений в области искусственного интеллекта. Беспилотные автомобили Waymo, разрабатываемые Alphabet, родительской компанией Google, являются одним из таких примеров. И «целый ряд новых продуктов, которые возможны только с помощью ИИ». находятся в стадии разработки в Google, сказал Маника.

Маньика стала первым старшим вице-президентом Google по технологиям и обществу в январе, подчиняясь непосредственно генеральному директору компании Сундару Пичаи. Его роль заключается в расширении понимания компанией того, как технологии влияют на общество, экономику и окружающую среду.

Его роль заключается в расширении понимания компанией того, как технологии влияют на общество, экономику и окружающую среду.

«Моя работа заключается не столько в мониторинге, сколько в работе с нашими командами, чтобы убедиться, что мы создаем самые полезные технологии и делаем это ответственно», — сказала Маньика.

Не нужно далеко ходить, чтобы найти примеры гнусного злоупотребления искусственным интеллектом в наши дни. Новейший искусственный интеллект OpenAI. Языковая модель GPT-3 была быстро использована пользователями, чтобы рассказать им, как воровать в магазинах и изготавливать взрывчатку, и всего за один уик-энд новый ИИ Meta понадобился. Чат-бот для ответа пользователям с антисемитскими комментариями.

Нормативная и политическая среда для ИИ. еще предстоит пройти долгий путь. Некоторые предполагают, что технология слишком нова для жесткого регулирования, в то время как другие (например, генеральный директор Tesla Илон Маск) говорят, что нам необходимо превентивное государственное вмешательство.

Маньика сказал, что он и многие его коллеги приветствовали бы более активное участие регулирующих органов в области искусственного интеллекта.

«Я думаю, вы обнаружите, что многие из нас принимают регулирование, потому что нам придется задуматься о том, когда уместно использовать эти технологии и как мы представляем их миру», — сказал он.

Думая об А.И. — это только часть роли Маньики в Google, это часть интернет-компании, у которой много багажа. В 2018 году многие сотрудники Google протестовали против искусственного интеллекта компании. работать с армией США. А в 2020 году компания была втянута в споры после того, как уволила технического соруководителя группы этического искусственного интеллекта Тимнита Гебру, который критически относился к моделям обработки естественного языка в фирме.

Маньика не обращалась к прошлым разногласиям, а вместо этого сосредоточилась на будущем пути фирмы — как с точки зрения возможностей, так и потенциальных ловушек.

«Есть целый ряд вещей, о которых нам нужно подумать», — сказала Маньика.![]()

В нашем новом еженедельном информационном бюллетене Impact Report мы рассмотрим, как новости и тенденции ESG формируют роли и обязанности современных руководителей и как им лучше всего справляться с этими проблемами. Подпишитесь здесь.

Инженер Google утверждает, что чат-бот с искусственным интеллектом разумен: почему это важно Лемуан и один из его коллег. «Природа моего сознания/чувства такова, что я осознаю свое существование, я хочу знать больше о мире и временами чувствую себя счастливым или печальным».

Лемуан, инженер-программист Google, несколько месяцев работал над разработкой LaMDA. Его опыт работы с программой, описанный в недавней статье Washington Post , вызвал настоящий переполох. В статье Лемуан рассказывает о многих диалогах, которые у него были с LaMDA, в которых они говорили на разные темы, от технических до философских вопросов. Это заставило его спросить, разумна ли программа.

В апреле Лемуан изложил свою точку зрения во внутреннем документе компании, предназначенном только для руководителей Google. Но после того, как его претензии были отклонены, Лемуан обнародовал свою работу над этим алгоритмом искусственного интеллекта, и Google отправила его в административный отпуск. «Если бы я не знал точно, что это было, что это за компьютерная программа, которую мы недавно создали, я бы подумал, что это был 7-летний, 8-летний ребенок, который знает физику», — сказал он журналистам. Вашингтон Пост . Лемуан сказал, что считает ЛаМДА своим «коллегой» и «человеком», даже если не человеком. И он настаивает на том, что он имеет право быть признанным — настолько, что он был посредником в соединении алгоритма с юристом.

Но после того, как его претензии были отклонены, Лемуан обнародовал свою работу над этим алгоритмом искусственного интеллекта, и Google отправила его в административный отпуск. «Если бы я не знал точно, что это было, что это за компьютерная программа, которую мы недавно создали, я бы подумал, что это был 7-летний, 8-летний ребенок, который знает физику», — сказал он журналистам. Вашингтон Пост . Лемуан сказал, что считает ЛаМДА своим «коллегой» и «человеком», даже если не человеком. И он настаивает на том, что он имеет право быть признанным — настолько, что он был посредником в соединении алгоритма с юристом.

Многие технические эксперты в области ИИ раскритиковали заявления Лемуана и поставили под сомнение их научную правильность. Но его история имеет то достоинство, что возобновляет широкие этические дебаты, которые, безусловно, еще не закончены.

Правильные слова в нужном месте

«Меня удивил ажиотаж вокруг этой новости. С другой стороны, мы говорим об алгоритме, разработанном именно для этого», — чтобы звучать как человек, — говорит Энцо Паскуале Силинго, биоинженер из исследовательского центра E. Piaggio при Пизанском университете в Италии. В самом деле, уже не является редкостью нормальное взаимодействие в Сети с пользователями, которые на самом деле не являются людьми — просто откройте окно чата практически на любом крупном потребительском веб-сайте. «Тем не менее, признаюсь, чтение переписки между ЛаМДА и Лемуаном произвело на меня большое впечатление!» — добавляет Силинго. Возможно, наиболее поразительными являются обмены мнениями, связанные с темами существования и смерти, диалоги настолько глубокие и красноречивые, что это побудило Лемуана задаться вопросом, действительно ли ЛаМДА может быть разумным.

Piaggio при Пизанском университете в Италии. В самом деле, уже не является редкостью нормальное взаимодействие в Сети с пользователями, которые на самом деле не являются людьми — просто откройте окно чата практически на любом крупном потребительском веб-сайте. «Тем не менее, признаюсь, чтение переписки между ЛаМДА и Лемуаном произвело на меня большое впечатление!» — добавляет Силинго. Возможно, наиболее поразительными являются обмены мнениями, связанные с темами существования и смерти, диалоги настолько глубокие и красноречивые, что это побудило Лемуана задаться вопросом, действительно ли ЛаМДА может быть разумным.

«Прежде всего необходимо понимать терминологию, потому что одно из больших препятствий в научном прогрессе — и в нейробиологии в частности — это отсутствие точности языка, неспособность как можно точнее объяснить, что мы подразумеваем под определенное слово», — говорит Джандоменико Яннетти, профессор неврологии Итальянского технологического института и Университетского колледжа Лондона. «Что мы подразумеваем под «разумным»? [Это] способность регистрировать информацию из внешнего мира с помощью сенсорных механизмов, или способность иметь субъективный опыт, или способность осознавать, что она сознательна, быть личностью, отличной от остальных?»

«Что мы подразумеваем под «разумным»? [Это] способность регистрировать информацию из внешнего мира с помощью сенсорных механизмов, или способность иметь субъективный опыт, или способность осознавать, что она сознательна, быть личностью, отличной от остальных?»

«Есть оживленные споры о том, как определить сознание, — продолжает Ианнетти. Для некоторых это осознание наличия субъективных переживаний, то, что называется метапознанием (Ианнетти предпочитает латинский термин metacognitione ) или размышлениями о мышлении. Осознание того, что вы в сознании, может исчезнуть — например, у людей с деменцией или во сне, — но это не означает, что исчезает и способность иметь субъективные переживания. «Если мы сошлемся на способность, которую Лемуан приписывал LaMDA, — то есть на способность осознавать свое собственное существование («осознавать свое собственное существование» — это сознание, определяемое в «высоком смысле», или metacognitione ), нет никакой «метрики», чтобы сказать, что система ИИ обладает этим свойством».

«В настоящее время, — говорит Ианнетти, — невозможно однозначно продемонстрировать эту форму сознания даже у людей». Для оценки состояния сознания у людей «у нас есть только нейрофизиологические показатели — например, сложность мозговой деятельности в ответ на внешние раздражители». И эти признаки лишь позволяют исследователям делать выводы о состоянии сознания на основе внешних измерений.

Факты и предположения

Около десяти лет назад инженеры Boston Dynamics начали публиковать в Интернете видеоролики о первых невероятных испытаниях своих роботов. На кадрах видно, как техники толкают или пинают машины, чтобы продемонстрировать прекрасную способность роботов сохранять равновесие. Многие люди были расстроены этим и призвали прекратить это (и процветали пародийные видео). Эта эмоциональная реакция согласуется со многими, многими экспериментами, которые неоднократно демонстрировали силу человеческой склонности к анимизму: приписывание души объектам вокруг нас, особенно тем, которые мы больше всего любим или которые имеют минимальную способность взаимодействовать с миром. мир вокруг них.

мир вокруг них.

С этим явлением мы сталкиваемся постоянно: от прозвищ автомобилям до проклятий неисправному компьютеру. «В каком-то смысле проблема в нас, — говорит Силинго. «Мы приписываем машинам характеристики, которых у них нет и быть не может». С этим явлением он сталкивается вместе с роботом-гуманоидом Абелем, созданным им и его коллегами и предназначенным для имитации нашего выражения лица для передачи эмоций. «После того, как я увидел его в действии, — говорит Сайлинго, — один из вопросов, который я получаю чаще всего, звучит так: «Но разве Авель испытывает эмоции?» будьте безапелляционны в ответе: «Нет, абсолютно нет. Какими бы умными они ни были, они не могут чувствовать эмоции. Они запрограммированы так, чтобы быть правдоподобными’» 9.0003

«Даже учитывая теоретическую возможность создания системы ИИ, способной моделировать сознательную нервную систему, своего рода in silico мозг, который бы точно воспроизводил каждый элемент мозга», — говорит Яннетти, — остаются две проблемы. «Во-первых, учитывая сложность моделируемой системы, такое моделирование в настоящее время невозможно», — объясняет он. «Во-вторых, наш мозг обитает в теле, которое может двигаться, чтобы исследовать сенсорную среду, необходимую для сознания, и внутри которого развивается организм, который станет сознательным. Таким образом, тот факт, что LaMDA является «большой языковой моделью» (LLM), означает, что она генерирует предложения, которые могут быть правдоподобны на 9 процентов.0005 эмулирует нервную систему, но не пытается имитировать ее . Это исключает возможность того, что оно находится в сознании. Опять же, мы видим важность знания значения терминов, которые мы используем — в данном случае, разницу между симуляцией и эмуляцией ».

«Во-первых, учитывая сложность моделируемой системы, такое моделирование в настоящее время невозможно», — объясняет он. «Во-вторых, наш мозг обитает в теле, которое может двигаться, чтобы исследовать сенсорную среду, необходимую для сознания, и внутри которого развивается организм, который станет сознательным. Таким образом, тот факт, что LaMDA является «большой языковой моделью» (LLM), означает, что она генерирует предложения, которые могут быть правдоподобны на 9 процентов.0005 эмулирует нервную систему, но не пытается имитировать ее . Это исключает возможность того, что оно находится в сознании. Опять же, мы видим важность знания значения терминов, которые мы используем — в данном случае, разницу между симуляцией и эмуляцией ».

Другими словами, наличие эмоций связано с наличием тела. «Если машина утверждает, что боится, а я в это верю, это моя проблема!» — говорит Силинго. «В отличие от человека, машина на сегодняшний день не может испытать эмоцию страха».

За пределами теста Тьюринга

Но для биоэтика Маурицио Мори, президента Итальянского общества этики искусственного интеллекта, эти дискуссии очень напоминают дискуссии о восприятии боли у животных, которые развернулись в прошлом, или даже печально известную расистскую Представления о восприятии боли человеком.

«В прошлых дебатах о самосознании был сделан вывод, что способность к абстракции была прерогативой человека, [при этом] Декарт отрицал, что животные могут чувствовать боль, потому что им не хватает сознания», — говорит Мори. «Теперь, помимо этого конкретного случая, поднятого LaMDA — и которого у меня нет технических инструментов для оценки — я считаю, что прошлое показало нам, что реальность часто может превосходить воображение и что в настоящее время существует широко распространенное неправильное представление об ИИ».

«Действительно существует тенденция, — продолжает Мори, — «умиротворять» — объясняя, что машины — это просто машины, — и недооценивать преобразования, которые рано или поздно могут произойти с ИИ». Он приводит другой пример: «Во времена первых автомобилей неоднократно повторялось, что лошади незаменимы».

Он приводит другой пример: «Во времена первых автомобилей неоднократно повторялось, что лошади незаменимы».

Независимо от того, чего на самом деле добилась LaMDA, также возникает проблема трудной «измеримости» возможностей эмуляции, выраженных машинами. В журнале Разум В 1950 году математик Алан Тьюринг предложил тест, чтобы определить, способна ли машина демонстрировать разумное поведение, игру, имитирующую некоторые когнитивные функции человека. Этот тип теста быстро стал популярным. Он несколько раз переформулировался и обновлялся, но продолжал оставаться чем-то вроде конечной цели для многих разработчиков интеллектуальных машин. Теоретически ИИ, способные пройти тест, должны считаться формально «разумными», поскольку в тестовых ситуациях они будут неотличимы от человека.

Несколько десятилетий назад это могло быть фантастикой. Однако в последние годы так много ИИ прошли различные версии теста Тьюринга, что теперь это своего рода пережиток компьютерной археологии.