Содержание

Угрожает ли людям искусственный интеллект?

Подпишитесь на нашу рассылку ”Контекст”: она поможет вам разобраться в событиях.

Автор фото, Science Photo Library

Подпись к фото,

Многие ученые считают, что искусственный разум является угрозой для человечества

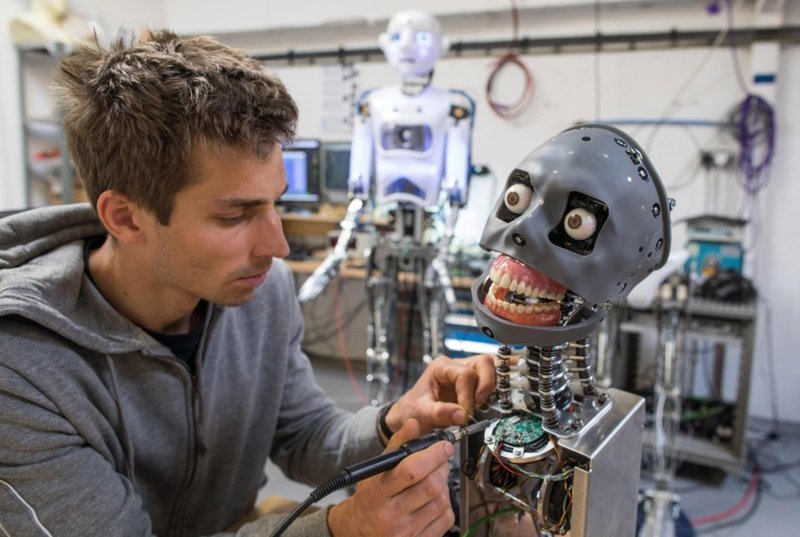

На этой неделе в программах Би-би-си настоящее нашествие роботов. Мы обсуждаем достижения людей в области строительства роботов и искусственного интеллекта. Мы и наши коллеги говорим о том, могут ли роботы вытеснить людей с рынка труда.

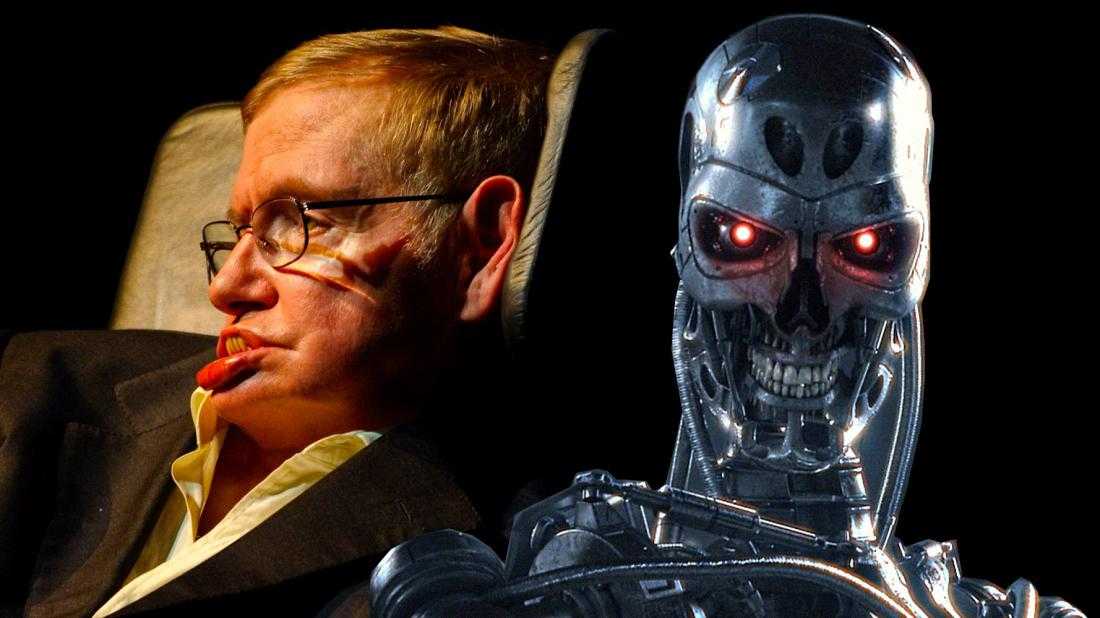

А главное — может ли искусственный интеллект представлять угрозу для человечества, как считает профессор Стивен Хокинг. Этот ученый с мировым именем считает, что люди в силу медленной биологической эволюции не могут конкурировать с искусственным интеллектом, и он способен занять место человека.

Бояться или нет искусственного интеллекта его создателям, людям? Об этом ведущий программы «Пятый этаж» Олег Антоненко говорил с одним из авторов проекта «Искусственный мозг», ученым Томского государственного университета Владимиром Ворониным и писателем-фантастом Леонидом Кагановым.

Загрузить подкаст передачи «Пятый этаж» можноtopcat2.

Олег Антоненко: Мы хотим поговорить об искусственном интеллекте, назовем его «компьютерным мозгом», который способен думать, как человек. Простейшие устройства с использованием искусственного интеллекта можно встретить уже сейчас, начиная от помощников — Сири в вашем iPhone или Кортану в вашем компьютере на windows — до устройства, например, контролирующего воздушный траффик.

Вопрос в том, что эти системы не способны к обучению. Например, компьютер Deep Blue, который обыгрывал чемпиона мира по шахматам, играть в домино или шашки не умеет. Эксперты говорят, что искусственный интеллект (сейчас это Deep Blue), возможно, в полном объеме мы получим к 2050 году. Предлагают называть эту систему «суперчеловеком». Некоторые говорят, что он спасет человечество, некоторые полагают, что погубит нас. Владимир Николаевич, «Искусственный мозг» — проект к которому вы имеете отношение и участвовали в его разработке — что это такое, насколько он обучаем, интересует ли вас его миссия, угрозы, о которых мы сегодня говорим?

Владимир Воронин: Мы ставим перед собой очень амбициозные задачи. Несмотря на то, что у нас в Томском университете над этой тематикой работает очень маленькая группа — буквально 3-4 человека, нам кажется, что мы нащупали некоторые принципиальные вещи. Дело в том, что основной тенденцией развития искусственного интеллекта, является компьютерное программирование. На этом пути работы ведутся уже более 60 лет, но особого прогресса здесь мы не наблюдаем. К разговорам с роботом о взаимопомощи и прочем, я отношусь, как к некоей забаве, игрушкам, в которые можно много информации, записанной на чипах, заложить, которые между собой взаимодействуют, и такую картинку продемонстрировать.

Несмотря на то, что у нас в Томском университете над этой тематикой работает очень маленькая группа — буквально 3-4 человека, нам кажется, что мы нащупали некоторые принципиальные вещи. Дело в том, что основной тенденцией развития искусственного интеллекта, является компьютерное программирование. На этом пути работы ведутся уже более 60 лет, но особого прогресса здесь мы не наблюдаем. К разговорам с роботом о взаимопомощи и прочем, я отношусь, как к некоей забаве, игрушкам, в которые можно много информации, записанной на чипах, заложить, которые между собой взаимодействуют, и такую картинку продемонстрировать.

Пропустить Подкаст и продолжить чтение.

Подкаст

Что это было?

Мы быстро, просто и понятно объясняем, что случилось, почему это важно и что будет дальше.

эпизоды

Конец истории Подкаст

Совсем другая задача ставится в нашей области. Мы пытаемся смоделировать человеческий мозг, ориентируясь на биологические принципы взаимодействия нейронов в нервной системе человека. Как это происходит? С нашей точки зрения, если необходимо это коротко сказать во вводной части, организуется искусственный нейрон, который в возбужденном состоянии может взаимодействовать с другим нейроном, причем, не с любым, а тоже находящимся в возбужденном состоянии.

Мы пытаемся смоделировать человеческий мозг, ориентируясь на биологические принципы взаимодействия нейронов в нервной системе человека. Как это происходит? С нашей точки зрения, если необходимо это коротко сказать во вводной части, организуется искусственный нейрон, который в возбужденном состоянии может взаимодействовать с другим нейроном, причем, не с любым, а тоже находящимся в возбужденном состоянии.

Нейроны имеют много входов, на которые поступают различные сигналы. Эти сигналы накапливаются, и при некотором уровне искусственный нейрон переходит в другое энергетическое состояние. Если в то же время рядом оказывается другой нейрон, находящийся в возбужденном состоянии, между ними возникает связь. В простейшем случае – это пробой какой-то тонкой полупроводниковой пленки, которая образует омический контакт. Сигнал, который попадает на один из нейронов, через этот контакт может попасть и на второй нейрон. В это время второй нейрон тоже получает разнородные сигналы. Однако если повторить некоторые сигналы, которые поступают на первый нейрон, то второй нейрон, как бы, заранее будет знать о некоторых событиях, которые еще до него не дошли. Сигналы эти не поступили, но он будет получать это от первого нейрона.

Сигналы эти не поступили, но он будет получать это от первого нейрона.

О.А.: Правильно я понимаю, что речь идет о передаче некоей информации от одного нейрона к другому?

В.В.: Естественно, это информация, но информацией нельзя назвать один какой-то импульс. Это большая сумма импульсов, которая циркулирует по цепям в этом устройстве, которое может обладать многокомпонентными нейронами, скажем, миллионами или миллиардами. Современная миниатюрная техника позволяет изготавливать такие чипы. Принцип развития этой системы заключается в том, что ему задается некоторая парадигма, что для него полезно и что вредно, и принцип самовыживания. Это простейший принцип, на котором базируется каждый биологический организм.

Получив внешние сигнал, они через многочисленные связи переходят на выходы нейронов, которые могут быть связаны с манипуляторами, такими как движитель, который может перемещать, поворачивать, включать какие-то механизмы, посылать ответные сигналы: тепловые, световые, звуковые и прочие. Принцип такого самоорганизующегося устройства заключается в том, что в процессе анализа результата внешних воздействий и анализа того, как этот аппарат повлиял под воздействием этих сигналов на внешний мир, что для него изменилось, лучше стало или хуже.

Принцип такого самоорганизующегося устройства заключается в том, что в процессе анализа результата внешних воздействий и анализа того, как этот аппарат повлиял под воздействием этих сигналов на внешний мир, что для него изменилось, лучше стало или хуже.

О.А.: Вы говорите, что он заточен на биологическое выживание. Если предположить развитие этой системы и если эта система будет видеть, что угрозу биологическому выживанию представляет именно человек – создатель, то она может быть агрессивной.

В.В.: Не совсем так. Здесь моделируется развитие этого устройства, как мы его называем «самоорганизующееся управляющее устройство», которое базируется на тех же принципах, на которых развивается биологический мозг, нервная система человека. Именно этот искусственный мозг самообучается под руководством некоторого учителя, так же как маленький ребенок рождается, многое в мире не понимает, у него заложены какие-то базовые инстинкты, однако под воздействием метода «кнута и пряника» он начинает понимать, что хорошо и что плохо. Точно также для совершенствования нашего искусственного мозга нужен учитель и при определенном уровне объема его возможностей потребуются и психологи и биологи, которые будут курировать развитие этого организма и направлять его в некоторое правильное русло.

Точно также для совершенствования нашего искусственного мозга нужен учитель и при определенном уровне объема его возможностей потребуются и психологи и биологи, которые будут курировать развитие этого организма и направлять его в некоторое правильное русло.

О.А.: Мы знаем истории, когда ученики восставали против своих учителей. Что думаете, Леонид?

Леонид Каганов: Имею небольшой комментарий. Владимир Воронин выкладывал классическую концепцию бихевиоризма, которая пыталась объяснить мышление и человека с помощью стимула и реакции, типа: наш мозг представляет черный ящик, на один вход подается раздражитель, из другого входа мы получаем какую-то реакцию. Надо сказать, что психология уже немножко отвергла это представление, потому что оно было давно. Это еще XIX век, насколько я помню. Потом появились улучшенные концепции бихевиоризма, потом появилась когнитивная психология, но в принципе психология до сих пор не может дать ответ на вопрос, что же такое наше мышление и как оно рождается. Поэтому пока подходить с таких позиций сложно.

Поэтому пока подходить с таких позиций сложно.

Я говорю это потому, что я – хоть и писатель-фантаст, но по первому образованию я электронщик. У меня была разработка связанная, можно сказать, с искусственным интеллектом. У меня программа писала стихи из произвольного текста. По второму образованию я психолог. Поэтому я немножко совмещал все эти вещи. Вообще, концепция разума очень будоражит воображение, потому что хочется, чтобы наконец-то появился такой робот, который что-то за нас делал и желательно еще и принимал решения и думал. Но, к сожалению, чем больше я смотрю вокруг, а я смотрю вокруг последние 19 лет с тех пор, как сдал свой диплом, тем больше я вижу, что человечество пока не продвинулось по этому пути и ничего толкового не сделало. Мы только- только начинаем осваивать первые инструменты, чтобы подобраться к самым дальним рубежам.

О.А.: Стивен Хокинг выступал с предупреждением о том, что люди, в силу медленной биологической эволюции, не могут конкурировать с искусственным интеллектом, и он способен занять место человека. Многие эксперты называют совершенно конкретную дату появления этого суперчеловека – 2050 год. Я уж не говорю о существовании целого пласта культуры XX века, начиная со сборника рассказов Айзека Азимова «Я – робот». Можно упомянуть в этой связи один из лучших фильмов в истории кино «Космическая одиссея 2001 года». Масса вещей, когда люди говорят не о том, что им нужен помощник, безусловно, это важный аспект, а они в большей степени опасаются того, что появятся некие сложные компьютеры, сложные системы с возможностью самообучения, и они будут представлять угрозу для человека. Насколько, на ваш взгляд, рациональным является этот страх?

Многие эксперты называют совершенно конкретную дату появления этого суперчеловека – 2050 год. Я уж не говорю о существовании целого пласта культуры XX века, начиная со сборника рассказов Айзека Азимова «Я – робот». Можно упомянуть в этой связи один из лучших фильмов в истории кино «Космическая одиссея 2001 года». Масса вещей, когда люди говорят не о том, что им нужен помощник, безусловно, это важный аспект, а они в большей степени опасаются того, что появятся некие сложные компьютеры, сложные системы с возможностью самообучения, и они будут представлять угрозу для человека. Насколько, на ваш взгляд, рациональным является этот страх?

Л.К.: Честно скажу, я очень рад за оптимиста Хокинга, потому что, на мой взгляд, гораздо большую опасность представляет не разумные машины, которые займут место человека, а люди, лишенные интеллекта, которые займут место человека. Это мне кажется намного большей опасностью. Когда читаешь новости и смотришь, что происходит в мире, закрадывается подозрение, что люди без интеллекта как-то уже теснят. Поэтому долго нам еще придется опасаться машин без интеллекта. Интересная вещь: ведь робот может навредить человеку и не будучи роботом.

Поэтому долго нам еще придется опасаться машин без интеллекта. Интересная вещь: ведь робот может навредить человеку и не будучи роботом.

Мы всегда боялись, что придет такой железный робот с лампой вместо носа и начнет в нас стрелять из своего плазменного пистолета. А на самом деле мы открываем свою электронную почту и видим тонны спама, которые рассылают роботы. Они не имеют тела, но они роботы. Потом мы видим, как роботы постоянно ходят, стучатся и взламывают наши сервера, стучатся на каждый сайт, пробуют подобрать пароли. Все это тоже делают роботы. Это огромные ботнеты, которые занимаются всем, начиная от взлома личных данных до промышленного шпионажа, настроенные, понятное дело, людьми. Это, мне кажется, более актуальной опасностью. Андроид в титановом панцире появится еще очень не скоро, да и мозга у него нет, а примитивные роботы могут вредить, делать пакости, беспокоить. Могут разбудить звонком, сказать, что у вас задолженность за электроэнергию составляет 3 рубля 14 копеек. Это же тоже роботы все звонят.

Это же тоже роботы все звонят.

О.А.: Владимир Николаевич, вы не занимаетесь созданием таких зловредных механизмов, о которых только что Леонид рассказал?

В.В.: Вы назвали Леонида Каганова оптимистом, а мне кажется, он глубокий пессимист. Он видит при рассылке спама какую-то угрозу для человечества. Мы ставим задачу создания искусственного мозга, который действительно мыслит в тысячи, может быть, миллионы раз быстрее, чем биологический мозг, в котором, как известно, нервные импульсы передаются со скоростью метров в секунду в отличие от электрических сигналов. Тем не менее, критика бихевиоризма, которую фантаст привел, не продуктивна.

Дело в том, что человеческий мозг как таковой, как творец, когда что-то придумывает и начинает параллельно с природой изобретать какие-то другие способы мышления, сознания и т.д., мне кажется, что он заведомо по неправильному пути идет, потому что природа мудра и она сделала биологический организм. Если делать какое-то мыслящее устройство, оно должно быть примерно по этим же принципам устроено, по которым мы пытаемся идти.

Если делать какое-то мыслящее устройство, оно должно быть примерно по этим же принципам устроено, по которым мы пытаемся идти.

Я не говорю, что мы в ближайшие годы или десятилетия создадим такой искусственный мозг, который сравняется или превзойдет человеческий. На том пути нас ожидают очень большие ступеньки, которые помогут создать такие самоорганизующиеся устройства, которые внесут революцию в технику. Это, может быть, будет очередная техническая революция. Когда, скажем, в пикирующем бомбардировщике ни один пилот не может сообразить за короткое время, что нужно сделать и как управлять механизмом, в отличие от самоорганизующегося устройства, которое это успеет сделать.

О.А.: Уничтожение людей искусственным интеллектом – перспектива отдаленная. А вот вытеснение людей с рынка труда – это уже сегодняшняя реальность. В Китае строится один завод, на котором 99% работников будут роботы. Сборочные цеха, в которых нет людей, какие-то железнодорожные составы, в которых нет машинистов, есть автоматические машины по продаже разного рода билетов. Есть интересная статистика. Исследователи из Оксфордского университета и компании «Де Ллойд» подсчитали, что около 35% нынешних рабочих мест в Британии находятся уже сейчас под высокой угрозой компьютеризации в ближайшие 20 лет. В США говорят, что цифра эта составляет 47% по результатам аналогичного исследования. Леонид, это угроза для людей или нет?

Есть интересная статистика. Исследователи из Оксфордского университета и компании «Де Ллойд» подсчитали, что около 35% нынешних рабочих мест в Британии находятся уже сейчас под высокой угрозой компьютеризации в ближайшие 20 лет. В США говорят, что цифра эта составляет 47% по результатам аналогичного исследования. Леонид, это угроза для людей или нет?

Л.К.: С одной стороны, это угроза для людей, но социальные предпосылки ведут к тому, что все меньшее и меньшее количество людей, в принципе, будет работать, если оценивать в исторической перспективе. С другой стороны, здесь вряд ли можно говорить о роботах. Это, скорее, развитие инструментов. Нам понятно, что работник с пневматическим молотом заменяет двести рабов-камнетесов. И это нормальный естественный процесс. Человек с электроотверткой заменяет 55 сборщиков. Вместо электрической отвертки появляется электрический водитель поезда метро, электрический регулировщик.

И это хорошо, потому что иногда приходишь в учреждение и видишь, что там работает огромное количество людей, но все они занимаются тем, что посылают какие-то файлы на принтер, бегут с этими бумажками к соседнему столу, кладут, человек что-то читает, посылает кого-то еще куда-то бежать с бумажкой. И ты понимаешь, что всех этих людей можно заменить процессором мощности карманного смартфона. Он прекрасно справится с этой работой и будет ее делать лучше и без ошибок. Другое дело, куда девать этих, грубо говоря, немолодых теток, которые сидят в этой нашей воображаемой бухгалтерии. Это вопрос социальный.

И ты понимаешь, что всех этих людей можно заменить процессором мощности карманного смартфона. Он прекрасно справится с этой работой и будет ее делать лучше и без ошибок. Другое дело, куда девать этих, грубо говоря, немолодых теток, которые сидят в этой нашей воображаемой бухгалтерии. Это вопрос социальный.

Мне кажется, что человек должен найти себе лучшее применение, чем эта простая работа. Может быть, эти бухгалтерши будут прекрасно воспитывать детей, может быть, они займутся садоводством и сделают прекрасные парки, может быть, они посвятят свою жизнь изучению истории или музыке или просто станут прекрасными благодарными радиослушателями и телезрителями, что тоже неплохо. Пути обратно нет, и количество работающих будет сокращаться, а количество, я бы даже не сказал «роботов», количество инструментов будет расти. Остается это только приветствовать.

О.А.: Ряд специальностей по-прежнему будет востребован: учителя, пожарные, спортсмены, в конце концов. Все-таки соревнования роботов смотреть не очень интересно.

Все-таки соревнования роботов смотреть не очень интересно.

В.В.: Я поддерживаю здесь своего коллегу, который нарисовал такое будущее и сделал упор на социальном аспекте этого развития. Мы действительно видим общество, о котором мечтали утописты, когда человек освобождается от рутинного механического труда, общественный материальный продукт производят машины, и он свободен для творчества, для духовного саморазвития и т.д. корень зла – не в машинах, а в обществе, которое несправедливо распределяет произведенный общественный продукт. Поэтому нужно думать о совершенствовании человечества, общества, а не о том, что появятся безработные и они останутся без куска хлеба. Вы согласитесь со мной?

О.А.: Леонид, есть мнение, что писатели-фантасты обладают даром предвидения. Вам каким видится это будущее? Увидим ли мы этого самого суперчеловека, о котором говорят многие эксперты, ученые, когда мы увидим, и стоит ли нам его бояться?

Л. К.: Я думаю, что мы его уже видим, но не узнаем. Что касается предсказания будущего, к сожалению, фантасты меньше всех преуспели в предсказании будущего. Они предсказывали наравне со всеми своими современниками. Это такой распространенный миф, о том, что фантасты… Не было ни одного фантаста, который предсказал будущее достоверно, за исключением Артура Кларка, который предсказал стационарные спутники, потому что он был физиком и этим занимался. Мне кажется, что приближение эры роботов не то, что надо ожидать, оно уже давно наступило. Мы уже в этом живем, и только более внимательный взгляд позволит увидеть, что на самом деле они уже здесь

К.: Я думаю, что мы его уже видим, но не узнаем. Что касается предсказания будущего, к сожалению, фантасты меньше всех преуспели в предсказании будущего. Они предсказывали наравне со всеми своими современниками. Это такой распространенный миф, о том, что фантасты… Не было ни одного фантаста, который предсказал будущее достоверно, за исключением Артура Кларка, который предсказал стационарные спутники, потому что он был физиком и этим занимался. Мне кажется, что приближение эры роботов не то, что надо ожидать, оно уже давно наступило. Мы уже в этом живем, и только более внимательный взгляд позволит увидеть, что на самом деле они уже здесь

О.А.: Бояться стоит или нет?

Л.К.: В принципе, бояться надо всего. Тот же огонь может приготовить пищу, а может сжечь хижину. Тот же атом может обогревать целый город, а может устроить такой ад, что нам и не снилось. Во всем есть опасность, в любом предмете, но пока всерьез на ближайшие десятилетия ничего со стороны роботов грозить не должно, потому что они пока маленькие. Но они, конечно, есть, они рядом с нами, и надо сделать все, чтобы они развивались.

Но они, конечно, есть, они рядом с нами, и надо сделать все, чтобы они развивались.

О.А.: Ничего себе маленькие! Некоторые роботы-дроны совершают убийства в разных странах, с помощью людей, конечно, но это угроза.

Л.К.: Убить можно и вилкой, но это же не повод отменять вилки.

О.А.: Безусловно. Не могу с вами не согласиться.

Насколько опасен искусственный интеллект

Человечество уже многие свои фантазии воплотило в реальность. От карманных компьютеров до автомобилей с автопилотом и от виртуальной реальности до космического туризма. А теперь в жизнь воплощается и искусственный интеллект. Человечество постепенно стирает границы фантазии и вымысла посредством современных исследований и технологий.

Искусственный интеллект (далее ИИ) в настоящее время представляет собой перспективное направление, на которое ориентируются многие компании. Искусственный интеллект — это область науки, которая изучает работу аппаратных и программных компонентов, а именно их интеллектуальное поведение. Вместо того, чтобы получать информацию от пользователя, такие машины самостоятельно обучаются и становятся умнее.

Вместо того, чтобы получать информацию от пользователя, такие машины самостоятельно обучаются и становятся умнее.

Читайте также: Кто предсказал Интернет?

В настоящее время над проектами ИИ работают многие компании, включая Microsoft, Google, Facebook и другие. В Южной Корее также есть несколько высококлассных проектов по искусственному интеллекту. А теперь представьте, что это лишь те компании, которые заявили об этом официально. Не стоит забывать, что наверняка есть много компаний, которые втайне работают над проектами искусственного интеллекта.

Искусственный интеллект, который когда-то считался живым лишь в человеческом воображении, сегодня вполне реален. Уже сейчас ИИ стал предметом большого интереса для многих лидеров в индустрии высоких технологий.

Почему искусственный интеллект должен нас беспокоить?

Сначала это был Стивен Хокинг , затем Илон Маск и совсем недавно Билл Гейтс. Эти великие умы человечества предполагают, что за ИИ нужно пристально следить.

Генерального директора Тесла, Илона Маска однажды спросили, что он думает об искусственном интеллекте. Он ответил, что это как «вызов демона», которого нельзя призывать, если не можете его контролировать.

Когда Стивену Хокингу был задан этот же вопрос, то он предупредил публику. Он сказал, что любое дальнейшее исследование искусственного интеллекта может быть фатальной ошибкой. Он упомянул, что развитый ИИ будет обладать способностью переделывать, усовершенствовать себя. Такой интеллект сможет эволюционировать самостоятельно с огромной скоростью. Людям такая скорость эволюции недоступна, что ставит человечество в заведомо на более низкую ступень развития по сравнению с ИИ.

По словам Билла Гейтса, устройства с искусственным интеллектом поначалу будут простыми. Но со временем они будут узнавать все больше о нас и о нашем мире. Они будут становиться все более могущественными и интеллектуальными, чем человечество.

Риски искусственного интеллекта

Существует четыре класса риска, создаваемого искусственным интеллектом:

1.

Программная враждебность

Программная враждебность

Один из сценариев, когда ИИ может быть опасным, заключается в том, что он будет специально запрограммирован на враждебность. Например, со стороны военных или террористической группы, для достижения каких-то своих целей.

Еще один возможный сценарий враждебного искусственного интеллекта предполагает несовпадение глобальных целей, его и человечества. Что если расчеты искусственного интеллекта приведут к тому, что единственный способ достичь цели — это уничтожить всех людей? Вполне возможно, что это может спровоцировать его начать войну с человечеством.

Главная проблема в том, что ИИ не человек, и вряд ли с ним получится договориться. Его главным приоритетом будет выполнение глобальной задачи любой ценой. Поэтому война будет длиться, пока воля или способность человечества противостоять не будут уничтожены.

2. Пассивный риск

Фактически нет риска пассивной опасности от ИИ с приоритетными целями дружелюбности. Однако риск почти неизбежен от ИИ без таких целей. Пассивный ИИ может быть опасен просто потому, что он не учитывает безопасность человека, как это делают все люди.

Пассивный ИИ может быть опасен просто потому, что он не учитывает безопасность человека, как это делают все люди.

Например, взять ИИ без целей дружелюбия, отвечающий за обработку посевов пестицидами. Этот ИИ будет обрабатывать поле, даже если знает, что в этот момент на поле находятся люди.

3. Случайный риск

Искусственный интеллект, работающий с неполными данными, способен ошибиться точно также, как и человек. Ошибки такого рода почти неизбежны, поскольку невозможно знать все обо всем в мире.

Однако, данный риск является наименее опасным, поскольку ИИ способен учиться на собственном опыте. Любые происшествия уменьшают вероятность повторения ошибки в будущем, улучшая ИИ, и делая его более безопасным.

4. Риск непостижимости

Реальная опасность хорошо спроектированного искусственного интеллекта заключается в его способности перепрограммировать и бесконечно совершенствовать себя. Такой ИИ, способный к самосовершенствованию, может в конечном итоге превзойти ограничения человеческого интеллекта.

Когда существует искусственный интеллект, который умнее любого человека на Земле, становится невозможно полностью понять его. Такой ИИ также, вероятно, будет продолжать улучшать себя все быстрее и быстрее. Ведь каждое новое открытие или технология только ускоряют этот процесс. И именно это будет делать его все более и более невозможным для понимания людьми.

Кроме того, в какой-то момент ИИ может обнаружить законы причинности или логики, выходящие далеко за пределы понимания человеческого разума. Тогда возможности того, что он может сделать, становятся просто бесконечными.

Заключение

Хотя существует множество гипотез об опасном искусственном интеллекте, мы должны понимать, что это всего лишь предположения, а не факты. Люди всегда сомневались в новых технологиях, и было время, когда мы также боялись сотовых телефонов. В конце концов, речь идет о том, каким мы создадим искусственный интеллект и как мы будем его контролировать.

Benefits & Risks of Artificial Intelligence Russian

«Все, что мы ценим в нашей цивилизации – продукт разума. Усиливая человеческий разум технологиями искусственного интеллекта, мы приобретаем потенциал для небывалого расцвета цивилизации. Важно, однако, чтобы технологии были безопасными и служили на благо человека».

Усиливая человеческий разум технологиями искусственного интеллекта, мы приобретаем потенциал для небывалого расцвета цивилизации. Важно, однако, чтобы технологии были безопасными и служили на благо человека».

Макс Тегмарк, президент института «Будущее жизни»

Click here to see this page in other languages: English Chinese French German Japanese Korean

ЧТО ТАКОЕ ИСКУСТВЕННЫЙ ИНТЕЛЛЕКТ?

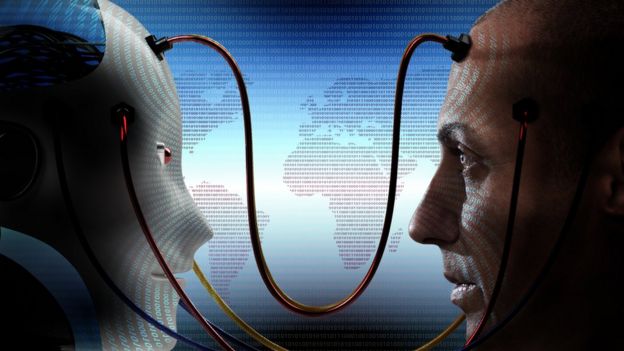

Еще совсем недавно было сложно поверить в реальность голосового помощника Siri или беспилотных автомобилей: искусственный интеллект (или ИИ) эволюционирует очень быстро. Научная фантастика рисует нам искусственный разум в виде человекоподобных роботов, но на деле технология включает в себя довольно широкий спектр разработок: от поисковых алгоритмов Google до когнитивной системы Watson (IBM) и автономного оружия.

Сегодня под термином ИИ в первую очередь понимается специализированный искусственный интеллект (или слабый ИИ), разработанный для решения конкретной задачи – например, распознавания лиц, поиска в сети интернет или управления автомобилем. Долгосрочной же целью многих разработчиков является создание общего искусственного интеллекта (или сильного ИИ). В то время как специализированный ИИ выполняет конкретную задачу ‒ например, он может обыграть человека в шахматы или решить уравнения, общий ИИ превзойдет человека практически в любой когнитивной работе.

Долгосрочной же целью многих разработчиков является создание общего искусственного интеллекта (или сильного ИИ). В то время как специализированный ИИ выполняет конкретную задачу ‒ например, он может обыграть человека в шахматы или решить уравнения, общий ИИ превзойдет человека практически в любой когнитивной работе.

ДЛЯ ЧЕГО ИССЛЕДОВАТЬ ВОПРОСЫ БЕЗОПАСНОСТИ ИИ?

Возможность принести пользу обществу с помощью технологий искусственного интеллекта в краткосрочной перспективе движет разработчиками во многих сферах. Современные наработки используются для подтверждения экономических теорий, в законотворчестве, технических разработках в области верификации, актуализации данных, безопасности и контроля. Поэтому если взлом или сбой в системе работы персонального компьютера может остаться незамеченным, отклонения в работе ИИ, который управляет автомобилем, самолетом, кардиостимулятором, электросетью или, например, автоматизированной системой ведения торгов, могут привести к гораздо более масштабным и трагическим последствиям. Помимо этого, все более актуальной сегодня становится необходимость предотвращения разрушительной гонки вооружений в сфере автономного оружия.

Помимо этого, все более актуальной сегодня становится необходимость предотвращения разрушительной гонки вооружений в сфере автономного оружия.

Что же произойдет, если ИИ превзойдет человеческий разум и сможет успешнее решать все когнитивные задачи? В 1965 году Ирвинг Джон Гуд отмечал, что совершенствование системы ИИ само по себе является когнитивной задачей. Подобная система потенциально способна к рекурсивному самоулучшению и может спровоцировать тем самым «взрыв» интеллекта, оставив человеческий разум далеко позади.

Изобретение революционных технологий, а сверхразум ‒ одна из них, может помочь человечеству искоренить войны, болезни и бедность. Само по себе создание подобной технологии может стать крупнейшим событием во всей истории человечества. Однако, некоторые эксперты предполагают, что если человек не научится синхронизировать свои цели с задачами ИИ до того, как тот превратится в сверхразум, это событие может оказаться для него последним. Есть и те, кто сомневается в возможности создания сильного ИИ, и те, кто считает, что создание сверхразвитого ИИ гарантированно принесет человечеству пользу. Институт «Будущее жизни» признает возможность развития обоих сценариев событий и понимает, что ИИ может преднамеренно или непреднамеренно стать источником большой беды. Мы уверены, что структурное исследование вопроса сегодня поможет подготовиться к потенциально негативным сценариям и предотвратить их в будущем, даст возможность избежать опасных моментов, связанных с ИИ, а вместо этого использовать его преимущества.

Институт «Будущее жизни» признает возможность развития обоих сценариев событий и понимает, что ИИ может преднамеренно или непреднамеренно стать источником большой беды. Мы уверены, что структурное исследование вопроса сегодня поможет подготовиться к потенциально негативным сценариям и предотвратить их в будущем, даст возможность избежать опасных моментов, связанных с ИИ, а вместо этого использовать его преимущества.

В ЧЕМ ЗАКЛЮЧАЕТСЯ ОПАСНОСТЬ ИИ?

Большинство исследователей сходятся во мнении, что сверхразумный ИИ вряд ли будет проявлять эмоции, присущие человеку, такие как, например, любовь или ненависть. Не стоит также ожидать, что искусственный интеллект станет намеренно доброжелательным или, наоборот, озлобленным. По мнению экспертов, наиболее опасными системы ИИ могут стать в результате двух сценариев:

- Искусственный интеллект изначально разработан с разрушительной целью: например, в качестве системы управления автономным оружием.

В руках не того человека такое оружие легко станет причиной множества жертв. Более того, гонка вооружений с использованием технологий ИИ может непреднамеренно привести к войнам искусственных разумов, которые, несомненно, унесут еще большее количество жизней. Вероятнее всего, подобное оружие будет не так-то просто взять и «выключить» ‒ будут разработаны системы защиты от вражеского взлома систем. А в результате, человечество может потерять контроль над подобными орудиями. Риск существует даже при использовании слабого ИИ, но с возрастанием степени его разумности и автономности угроза многократно увеличивается.

В руках не того человека такое оружие легко станет причиной множества жертв. Более того, гонка вооружений с использованием технологий ИИ может непреднамеренно привести к войнам искусственных разумов, которые, несомненно, унесут еще большее количество жизней. Вероятнее всего, подобное оружие будет не так-то просто взять и «выключить» ‒ будут разработаны системы защиты от вражеского взлома систем. А в результате, человечество может потерять контроль над подобными орудиями. Риск существует даже при использовании слабого ИИ, но с возрастанием степени его разумности и автономности угроза многократно увеличивается. - Искусственный интеллект изначально разработан для позитивной задачи, однако в процессе ее исполнения избирает деструктивный метод достижения цели: это может случиться, как только мы допустим ошибку в синхронизации целей искусственного интеллекта и человечества. Синхронизация невероятно сложна. Так, если вы попросите самоуправляемый автомобиль доставить вас в аэропорт как можно скорее, вы можете прибыть в пункт назначения вместе с кортежем преследующих вас полицейских ‒ поездка будет совсем некомфортной.

Машина сделает буквально то, что вы попросили, но не то, чего вы на самом деле хотели. Если сверхразуму поручить амбициозный геоинжиниринговый проект, побочным эффектом его деятельности может стать разрушение экосистемы, а попытки человека остановить работу ИИ будут восприняты как угроза, которую необходимо отразить.

Машина сделает буквально то, что вы попросили, но не то, чего вы на самом деле хотели. Если сверхразуму поручить амбициозный геоинжиниринговый проект, побочным эффектом его деятельности может стать разрушение экосистемы, а попытки человека остановить работу ИИ будут восприняты как угроза, которую необходимо отразить.

Все эти примеры показывают, что основная сложность при применении систем сильного ИИ связана не со злым сверхразумом, но скорее с компетентностью разработчиков. Сверхразумный ИИ будет невероятно эффективен в решении поставленных задач, вот только если они разойдутся с реальной целью человека, возникнут проблемы.

Наверняка вы не относите себя к истребителям муравьев, которые из удовольствия и азарта вытаптывают насекомых, но если перед вами стоит задача построить ГЭС, и в зоне ее затопления случайно окажется муравейник…что ж, тем хуже для муравьев. Ключевая цель исследований безопасности в области ИИ ‒ предупредить ситуацию, в которой человечество окажется на месте муравьев.

АКТУАЛЬНОСТЬ ИЗУЧЕНИЯ ВОПРОСА БЕЗОПАСНОСТИ ИИ

Стивен Хокинг, Илон Маск, Стив Возняк, Билл Гейтс и многие другие эксперты в области науки и технологий высказывали в СМИ и в открытых письмах свою обеспокоенность рисками, связанными с использованием искусственного интеллекта. Им вторит целый ряд ведущих исследователей. Но почему предмет обсуждения вдруг стал так актуален?

Идея о создании сильного ИИ всегда считалась научной фантастикой, а на ее осуществление, казалось, потребуется не одно столетие. Несмотря на это, благодаря недавним прорывам, многие ключевые вехи, время достижения которых ученые еще недавно оценивали в десятилетия, уже пройдены. Теперь многие эксперты всерьез задумываются о возможности создания сверхразума в течение жизни современного поколения. Пока некоторые считают, что до создания равного человеку ИИ еще столетия, на конференции в Пуэрто Рико в 2015 году, большинство исследователей сошлись во мнении, что сверхразум появится до 2060 года. Поскольку создание протоколов безопасности может занять десятилетия, разумно начинать действовать уже сейчас.

Поскольку создание протоколов безопасности может занять десятилетия, разумно начинать действовать уже сейчас.

У ИИ есть потенциал превзойти когнитивные способности любого человека, поэтому нет верного способа предсказать, как система себя поведет. Мы не можем использовать в качестве основы для предсказаний разработки прошлых лет, поскольку человечество никогда прежде не создавало механизмов, способных случайно или преднамеренно стать умнее нас. Лучшим примером того, с чем мы можем столкнуться, является эволюция самого человека. Люди господствуют на этой планете не потому, что сильнее, больше или быстрее других биологических видов, но потому, что умнее. И если мы станем не самыми умными ‒ как же сохранить господство?

Институт «Будущее жизни» считает, что процветание цивилизации возможно до тех пор, пока мы не позволим растущей силе технологий взять верх над благоразумным использованием оных. Что касается технологий ИИ, нам кажется, ключ не в том, чтобы препятствовать их развитию, но в том, чтобы путем исследований в области обеспечения безопасности ИИ, сделать упор на их разумное использование.

САМЫЕ ПОПУЛЯРНЫЕ МИФЫ ОБ ИИ

Увлекательная дискуссия сопровождает будущее искусственного интеллекта и его значение для человечества. Мировые эксперты придерживаются диаметрально противоположных мнений по многим вопросам. Например, идут споры о влияния ИИ на рынок труда, о том приведет ли к экспоненциальному росту когнитивных мощностей создание ИИ по умственным параметрам не уступающего человеку (если таковой появится), и стоит ли приветствовать прогресс в этой области или все же его нужно опасаться. Но кроме дискуссии в научных кругах можно наблюдать и множество утомительных псевдо-обсуждений, в которых участвуют некомпетентные люди, неспособные найти общий язык. Для того, чтобы сфокусироваться на действительно интересных моментах и актуальных вопросах, а не на недоразумениях, давайте проясним некоторые наиболее распространенные заблуждения.

МИФЫ О СРОКАХ СОЗДАНИЯ ИИ

Первое заблуждение касается прогнозов развития технологий с течением времени. Сколько времени осталось до момента, когда машинный интеллект превзойдет человеческий? Распространенным заблуждением является наше представление о том, что мы знаем ответ с большой степенью определенности.

Сколько времени осталось до момента, когда машинный интеллект превзойдет человеческий? Распространенным заблуждением является наше представление о том, что мы знаем ответ с большой степенью определенности.

Согласно одному из мифов, ученые уверены в появлении сверхразумного ИИ уже в этом столетии. На деле же, история пресыщена неоправданными технологическими надеждами. Где все термоядерные электростанции и летающие машины, на которых мы должны рассекать уже сегодня, если верить прогнозам прошлых лет? Возможности ИИ также были неоднократно преувеличены в прошлом, в том числе и первопроходцами в данной области исследований. Например, Джон Маккарти, автор термина «искусственный интеллект», Марвин Минский, Натаниэль Рочестер и Клод Шеннон написали чересчур оптимистичный прогноз о том, что может быть создано за два месяца с помощью прошловековых компьютеров: «Мы предлагаем летом 1956 на базе Дартмутского колледжа провести двухмесячное исследование искусственного интеллекта командой из 10 человек, в ходе которого будет предпринята попытка выяснить, как научить машину использовать язык, оперировать абстракциями и концептами, решать задачи, которые до этого были под силу только человеку и автоматически улучшать себя. Мы считаем, что значительный прогресс в одной или нескольких из этих задач может быть достигнут, если в течение лета тщательно отобранная группа ученых будет разрабатывать вопрос совместными усилиями». С другой стороны, существует популярный миф, полностью противоречащий первому: мы не сможем разработать сверхразумный ИИ в этом столетии. Исследователи обозначают широкий диапазон предположений о том, как далеки современные разработки от сверхразумного ИИ, но, учитывая длинный список ошибок в подобного рода скептических предсказаниях, мы все-таки не можем сказать с большой уверенностью, что вероятность прорыва в этом столетии стремится к нулю. Так, в 1933 году, менее, чем за 24 часа до того, как Сциллард совершил открытие цепной ядерной реакции, Эрнест Резерфорд, один из лучших физиков своего времени, сказал, что ядерная энергия это «выдумки». Аналогично, в 1956 году астроном Ричард Вулли называл межпланетные путешествия «полной чепухой». Наиболее же радикально миф отражен во мнении, что сверхразумный ИИ не появится никогда, поскольку это физически невозможно.

Мы считаем, что значительный прогресс в одной или нескольких из этих задач может быть достигнут, если в течение лета тщательно отобранная группа ученых будет разрабатывать вопрос совместными усилиями». С другой стороны, существует популярный миф, полностью противоречащий первому: мы не сможем разработать сверхразумный ИИ в этом столетии. Исследователи обозначают широкий диапазон предположений о том, как далеки современные разработки от сверхразумного ИИ, но, учитывая длинный список ошибок в подобного рода скептических предсказаниях, мы все-таки не можем сказать с большой уверенностью, что вероятность прорыва в этом столетии стремится к нулю. Так, в 1933 году, менее, чем за 24 часа до того, как Сциллард совершил открытие цепной ядерной реакции, Эрнест Резерфорд, один из лучших физиков своего времени, сказал, что ядерная энергия это «выдумки». Аналогично, в 1956 году астроном Ричард Вулли называл межпланетные путешествия «полной чепухой». Наиболее же радикально миф отражен во мнении, что сверхразумный ИИ не появится никогда, поскольку это физически невозможно. Однако, ученые-физики знают, что мозг состоит из кварков и электронов, взаимодействующих друг с другом по тому же принципу, что и мощный компьютер ‒ и нет такого закона физики, которому бы противоречило создание еще более мощных сгустков кварков.

Однако, ученые-физики знают, что мозг состоит из кварков и электронов, взаимодействующих друг с другом по тому же принципу, что и мощный компьютер ‒ и нет такого закона физики, которому бы противоречило создание еще более мощных сгустков кварков.

Среди исследователей искусственного интеллекта было проведено множество опросов, с целью выяснить их прогнозы относительно того, как скоро, с вероятностью хотя бы в 50%, может появиться сверхразумный ИИ. Опросы показали, что ведущие эксперты всего мира расходятся во мнениях, поэтому мы просто не знаем ответа. Например, в одном из таких опросов исследователей искусственного интеллекта в 2015 году на конференции в Пуэрто Рико, посвященной ИИ, среднестатистический ответ был «к 2045 году», но при этом некоторые исследователи называли сроки в сотни лет или даже больше.

Существует и родственный миф, который культивируют люди обеспокоенные тем, что от создания сверхмощного ИИ нас отделяет всего несколько лет. Однако большинство тех, кто открыто заявляет о своей обеспокоенности, в действительности видят возможность создания сверхмощного интеллекта лишь десятилетия спустя. Они аргументируют свои заявления так: поскольку нет стопроцентной гарантии того, что прорыв ИИ не произойдет в этом столетии, разумно было бы начать исследования в области безопасности этой технологии для того, чтобы подготовиться к непредвиденным событиям. Многие проблемы безопасности связанные с равным человеку ИИ настолько значительны, что на их решение могут понадобиться десятилетия. Поэтому, чтобы не пришлось поспешно разбираться с последствиями того, что может натворить компания программистов, окрыленная напитками Red Bull, дальновиднее будет начать исследование вопроса уже сегодня.

Они аргументируют свои заявления так: поскольку нет стопроцентной гарантии того, что прорыв ИИ не произойдет в этом столетии, разумно было бы начать исследования в области безопасности этой технологии для того, чтобы подготовиться к непредвиденным событиям. Многие проблемы безопасности связанные с равным человеку ИИ настолько значительны, что на их решение могут понадобиться десятилетия. Поэтому, чтобы не пришлось поспешно разбираться с последствиями того, что может натворить компания программистов, окрыленная напитками Red Bull, дальновиднее будет начать исследование вопроса уже сегодня.

МИФЫ, ОСНОВАННЫЕ НА ЗАБЛУЖДЕНИЯХ

Еще одно распространенное заблуждение заключается в том, что люди, сомневающиеся в ИИ и отстаивающие необходимость исследования его безопасности ‒ луддиты, не знакомые с технологией ИИ. Когда Стюарт Рассел, автор стандартного учебника по ИИ, высказал такое мнение в ходе конференции в Пуэрто Рико, аудитория рассмеялась. С этим заблуждением связано еще одно ‒ о том, что возможность поддержки исследований безопасности ИИ очень сомнительна. Но на самом деле, для внесения скромного вклада в исследования не обязательно быть уверенным в неизбежности рисков, достаточно лишь знать, что они не исключены. Подобно этому, даже минимальная возможность пожара ‒ достаточное основание для того, чтобы потратить небольшую сумму на страховку дома.

Но на самом деле, для внесения скромного вклада в исследования не обязательно быть уверенным в неизбежности рисков, достаточно лишь знать, что они не исключены. Подобно этому, даже минимальная возможность пожара ‒ достаточное основание для того, чтобы потратить небольшую сумму на страховку дома.

Возможно, СМИ придали дискуссиям вокруг ИИ более противоречивый образ, который не соответствует реальности. Страх, конечно, увеличивает продажи и статьи с вырванными из контекста фразами, предсказывающими неизбежный конец света, собирают большее количество просмотров, чем проработанные и сбалансированные. В результате два человека, знакомых друг с другом лишь по цитатам из интервью, могут показаться друг другу гораздо более принципиальными оппонентами, чем есть на самом деле.

К примеру, техно-скептик, знакомый с позицией Билла Гейтса по публикациям в таблоидах, может ошибочно считать, что Гейтс твердо уверен в неизбежности создания сверхразумного ИИ. Таким же образом, кто-то из про-технологичного движения может быть совершенно не знаком с позицией Эндрю Ына в целом, но помнить цитату про перенаселенный Марс и считать, что Ын не озадачен проблемой безопасности искусственного интеллекта, однако это неправда. Суть в том, что прогнозы Эндрю Ына предполагают более поздний прорыв технологий искусственного интеллекта, и в приоритет он, как правило, ставит не долгосрочные задачи, связанные с ИИ, а краткосрочные.

Суть в том, что прогнозы Эндрю Ына предполагают более поздний прорыв технологий искусственного интеллекта, и в приоритет он, как правило, ставит не долгосрочные задачи, связанные с ИИ, а краткосрочные.

МИФЫ ОБ ОПАСНОСТИ СВЕРХРАЗУМНОГО ИИ

Для многих разработчиков ИИ заголовок «Стивен Хокинг предупреждает, что искусственный интеллект ‒ угроза для человечества» ‒ все равно что красная тряпка для быка. Многие потеряли счет подобного рода пугающим статьям. Иллюстрируют такие материалы обычно злобным вооруженным андроидом, намекая, что мы должны опасаться роботов, которые выйдут из-под контроля, восстанут и начнут убивать. Если говорить менее серьезно, подобные тексты впечатляют, потому что в сжатом виде суммируют тот сценарий, о котором разработчики ИИ даже не задумываются. Этот сценарий состоит из трех самостоятельных заблуждений, базирующихся на опасениях касательно осознанности, зла и роботов.

Когда вы за рулем, вы переживаете собственные впечатления о цвете, звуках и окружающем вас пейзаже. Но может ли беспилотный автомобиль иметь собственные переживания? Ощущает ли вообще беспилотный автомобиль сам себя? Проблема осознанности и сознания как явления интересна сама по себе, однако для технологии ИИ она нерелевантна. Если вдруг вас собьет беспилотный автомобиль, вам будет не важно, обладает ли он самосознанием. Таким образом, человечеству придется взаимодействовать не с тем, что искусственный интеллект чувствует, но с тем, что делает.

Но может ли беспилотный автомобиль иметь собственные переживания? Ощущает ли вообще беспилотный автомобиль сам себя? Проблема осознанности и сознания как явления интересна сама по себе, однако для технологии ИИ она нерелевантна. Если вдруг вас собьет беспилотный автомобиль, вам будет не важно, обладает ли он самосознанием. Таким образом, человечеству придется взаимодействовать не с тем, что искусственный интеллект чувствует, но с тем, что делает.

Еще одно ложное умозаключение связано с опасением, что машины перейдут на темную сторону силы. В действительности же нужно опасаться не намеренного вредительства со стороны технологии, а некомпетентности разработчиков. Сверхмощный ИИ по определению будет невероятно эффективен в достижении поставленных целей (неважно, каких именно). Поэтому необходимо убедиться наверняка, что цель ИИ синхронизирована с потребностью человека. Человечество в целом равнодушно к муравьям и при достижении собственных целей не особенно считается с их потребностями. Люди умнее и могут себе это позволить. Поэтому цель тех, кто занимается разработкой безопасного ИИ ‒ предупредить ситуацию, в которой человечество окажется на месте муравьев.

Люди умнее и могут себе это позволить. Поэтому цель тех, кто занимается разработкой безопасного ИИ ‒ предупредить ситуацию, в которой человечество окажется на месте муравьев.

Заблуждение, касающееся наличия у машин самосознания, связано с мифом о том, что роботы не могут иметь собственных целей. Однако, в узком смысле, цель машин проявляется в том, что они ориентированы на выполнение какой-либо задачи. Так, поведение ракеты с тепловой головкой самонаведения проще всего описать как стремление попасть в цель. Если вы чувствуете угрозу со стороны машины, цели которой отличаются от ваших, то почти наверняка истинным источником беспокойства являются сами цели, а не то, обладает ли робот самосознанием или ощущениями. И если ракета преследует вас, вы вряд ли воскликнете: «У машин не может быть целей, так что волноваться не о чем!»

Остается только посочувствовать Родни Бруксу и другим новаторам в области робототехники, которые, по вине провоцирующих панику таблоидов, незаслуженно оказались в роли последних злодеев. Все потому, что некоторые журналисты зациклены на робото-фобии и неизменно включают в свои материалы изображения зловещих металлических конструкций с красными сверкающими глазами. Но основное опасение движения за безопасный ИИ заключается не в роботах, но в интеллекте как таковом, а точнее, в ИИ, цели которого расходятся с нашими. Для того, чтобы стать причиной неприятностей, такому сверхразуму не нужно роботизированное тело ‒ достаточно интернет-соединения. С его помощью он сможет обмануть финансовые рынки, превзойти научных исследователей, подчинить себе влиятельных личностей и разработать оружие, устройство которого человеку и понять не удастся. Даже если бы конструкция роботов была физически невозможна, получив неограниченный доступ к деньгам, сверхразумный ИИ теоретически мог бы платить многим людям или манипулировать ими, чтобы те, сами того не подозревая, служили исполнителями его замыслов.

Все потому, что некоторые журналисты зациклены на робото-фобии и неизменно включают в свои материалы изображения зловещих металлических конструкций с красными сверкающими глазами. Но основное опасение движения за безопасный ИИ заключается не в роботах, но в интеллекте как таковом, а точнее, в ИИ, цели которого расходятся с нашими. Для того, чтобы стать причиной неприятностей, такому сверхразуму не нужно роботизированное тело ‒ достаточно интернет-соединения. С его помощью он сможет обмануть финансовые рынки, превзойти научных исследователей, подчинить себе влиятельных личностей и разработать оружие, устройство которого человеку и понять не удастся. Даже если бы конструкция роботов была физически невозможна, получив неограниченный доступ к деньгам, сверхразумный ИИ теоретически мог бы платить многим людям или манипулировать ими, чтобы те, сами того не подозревая, служили исполнителями его замыслов.

Неправильное представление о роботах связано с мифом о том, что машина не может управлять человеком. Разум дает контроль: люди могут управлять тигром не потому, что сильнее него, а потому что умнее. Это означает, что если мы уступим статус умнейших существ на планете, мы также можем потерять и контроль над ней.

Разум дает контроль: люди могут управлять тигром не потому, что сильнее него, а потому что умнее. Это означает, что если мы уступим статус умнейших существ на планете, мы также можем потерять и контроль над ней.

ДЕЙСТВИТЕЛЬНО ВАЖНЫЕ ВОПРОСЫ

Если мы не будем тратить время на упомянутые выше заблуждения, то сможем сконцентрироваться на действительно интересных спорных моментах, в которых даже эксперты не согласны друг с другом.

Каким вы видите свое будущее? Стоит ли нам разрабатывать автономное вооружение? Как вы относитесь к автоматизации рабочих мест? Какую профессию посоветуете выбрать сегодняшним детям? Вы бы предпочли, чтобы на смену старым пришли новые рабочие места или чтобы общество, свободное от необходимости трудиться, блаженно проводило свободное время, наслаждаясь результатами работы машин? Если говорить об отдаленном будущем ‒ хотим ли мы создать сверхразумную жизнь и распространить ее во Вселенной? Будет ли человек контролировать машины или же они возьмут контроль над человеком? Заменят ли разумные машины человечество, будут ли сосуществовать с ним или полностью ассимилируются? Каково будет людям в эру искусственного разума? Какой бы вы хотели видеть эту эру, и как видение сделать реальностью в будущем? Присоединяйтесь к обсуждению!

Опасен ли ИИ? 5 Непосредственные риски искусственного интеллекта

Искусственный интеллект разрушает и революционизирует практически все отрасли. С развитием технологий у него есть потенциал радикально улучшить многие аспекты жизни.

С развитием технологий у него есть потенциал радикально улучшить многие аспекты жизни.

Но это небезопасно.

И, поскольку многие эксперты предупреждают о потенциальной опасности ИИ, нам, вероятно, следует обратить на это внимание. С другой стороны, многие утверждают, что это паникерские взгляды и что ИИ не представляет непосредственной опасности.

Так опасения по поводу искусственного интеллекта вызывают тревогу или нет? В этой статье будут рассмотрены пять основных рисков искусственного интеллекта с объяснением доступных в настоящее время технологий в этих областях.

Чем может быть опасен ИИ?

ИИ становится все более изощренным с каждым днем, и это может иметь риски от незначительных (например, увольнение с работы) до катастрофических экзистенциальных рисков. Уровень риска, связанного с ИИ, так активно обсуждается из-за общего отсутствия понимания (и консенсуса) в отношении технологии ИИ.

Принято считать, что ИИ может быть опасен по двум причинам:

- ИИ запрограммирован делать что-то злонамеренное

- ИИ запрограммирован на то, чтобы приносить пользу, но при достижении своей цели делает что-то разрушительное

Эти риски усиливаются сложностью программного обеспечения ИИ. Классический гипотетический аргумент — шутливый «максимизатор скрепки». В этом мысленном эксперименте сверхразумный ИИ был запрограммирован на максимальное количество скрепок в мире. Если он достаточно разумен, он может уничтожить весь мир ради этой цели.

Классический гипотетический аргумент — шутливый «максимизатор скрепки». В этом мысленном эксперименте сверхразумный ИИ был запрограммирован на максимальное количество скрепок в мире. Если он достаточно разумен, он может уничтожить весь мир ради этой цели.

Но нам не нужно рассматривать сверхразумный ИИ, чтобы увидеть, что существуют опасности, уже связанные с нашим использованием ИИ. Итак, с какими непосредственными рисками, связанными с ИИ, мы сталкиваемся?

1. Автоматизация работы и прерывание работы

Автоматизация — это опасность ИИ, которая уже влияет на общество.

От заводов массового производства до касс самообслуживания и беспилотных автомобилей автоматизация происходила десятилетиями, и этот процесс ускоряется. Исследование Института Брукингса в 2019 г.обнаружили, что 36 миллионов рабочих мест могут подвергнуться высокому риску автоматизации в ближайшие годы.

Проблема в том, что для решения многих задач системы ИИ превосходят людей. Они дешевле, эффективнее и точнее людей. Например, ИИ уже лучше распознает подделки произведений искусства, чем люди-эксперты, и теперь он становится более точным в диагностике опухолей по рентгенографическим изображениям.

Они дешевле, эффективнее и точнее людей. Например, ИИ уже лучше распознает подделки произведений искусства, чем люди-эксперты, и теперь он становится более точным в диагностике опухолей по рентгенографическим изображениям.

Еще одна проблема заключается в том, что из-за смещения рабочих мест после автоматизации многие работники, потерявшие работу, не имеют права на вновь созданные рабочие места в секторе ИИ из-за отсутствия необходимых полномочий или опыта.

По мере того, как системы ИИ продолжают совершенствоваться, они станут намного лучше справляться с задачами, чем люди. Это может быть распознавание образов, предоставление информации или точные прогнозы. В результате потеря работы может привести к усилению социального неравенства и даже к экономической катастрофе.

2. Безопасность и конфиденциальность

В 2020 году правительство Великобритании заказало отчет об искусственном интеллекте и национальной безопасности Великобритании, в котором подчеркивается необходимость использования ИИ в системе кибербезопасности Великобритании для обнаружения и смягчения угроз, которые требуют более высокой скорости реагирования, чем способно принимать решения человеком.

Проблема в том, что надежда состоит в том, что по мере роста проблем безопасности, связанных с ИИ, будут расти и меры предотвращения, основанные на ИИ. Если мы не сможем разработать меры для защиты от проблем с ИИ, мы рискуем вступить в бесконечную гонку против злоумышленников.

Это также вызывает вопрос о том, как мы делаем системы ИИ безопасными. Если мы используем алгоритмы ИИ для защиты от различных проблем безопасности, нам необходимо убедиться, что сам ИИ защищен от злоумышленников.

Когда дело доходит до конфиденциальности, крупные компании и правительства уже призывают к подрыву нашей конфиденциальности. С таким большим количеством личных данных, доступных сейчас в Интернете (ежедневно создается 2,5 миллиона терабайт данных), алгоритмы ИИ уже могут легко создавать профили пользователей, которые обеспечивают чрезвычайно точный таргетинг рекламы.

Технология распознавания лиц также уже невероятно сложна. Камеры могут выполнять профилирование людей в реальном времени. Сообщается, что некоторые полицейские силы по всему миру используют умные очки с программным обеспечением для распознавания лиц, которое может легко маркировать разыскиваемых или подозреваемых преступников.

Сообщается, что некоторые полицейские силы по всему миру используют умные очки с программным обеспечением для распознавания лиц, которое может легко маркировать разыскиваемых или подозреваемых преступников.

Риск заключается в том, что эта технология может быть распространена на авторитарные режимы или просто на отдельных лиц или группы со злыми намерениями.

3. Вредоносное ПО ИИ

ИИ все лучше справляется со взломом систем безопасности и взломом шифрования. Один из способов, которым это происходит, — вредоносное ПО, «эволюционирующее» с помощью алгоритмов машинного обучения. Вредоносное ПО может узнать, что работает, методом проб и ошибок, со временем становясь все более опасным.

Новые интеллектуальные технологии (например, беспилотные автомобили) оцениваются как объект высокого риска для такого рода атак, поскольку злоумышленники могут вызвать автомобильные аварии или пробки. По мере того как мы все больше и больше полагаемся на интеллектуальные технологии, подключенные к Интернету, риск сбоев все больше и больше влияет на нашу повседневную жизнь.

Опять же, единственное реальное решение этой опасности заключается в том, что ИИ для защиты от вредоносных программ превосходит вредоносный ИИ в защите отдельных лиц и предприятий.

4. Автономное вооружение

Автономное оружие — оружие, управляемое системами ИИ, а не человеком, — уже существует и существует уже довольно давно. Сотни технических экспертов призвали ООН разработать способ защиты человечества от рисков, связанных с автономным оружием.

Правительственные вооруженные силы по всему миру уже имеют доступ к различным управляемым или полууправляемым ИИ системам вооружения, таким как военные дроны. С помощью программного обеспечения для распознавания лиц дрон может отслеживать человека.

Что произойдет, если мы позволим алгоритмам ИИ принимать решения о жизни и смерти без участия человека?

Также можно настроить потребительские технологии (например, дроны) для автономного полета и выполнения различных задач. Такого рода возможности в чужих руках могут ежедневно влиять на безопасность человека.

5. Дипфейки, фейковые новости и политическая безопасность

Изображение предоставлено: geralt через Pixabay

Программное обеспечение для реконструкции лица (более известное как технология дипфейков) становится все более и более неотличимым от реальности.

Опасность дипфейков уже угрожает знаменитостям и мировым лидерам, и пока это не коснется обычных людей. Например, мошенники уже шантажируют людей фальшивыми видео, созданными из чего-то такого простого и доступного, как фотография профиля Facebook.

И это не единственный риск. ИИ может воссоздавать и редактировать фотографии, составлять текст, клонировать голоса и автоматически создавать высокоцелевую рекламу. Мы уже видели, как некоторые из этих опасностей влияют на общество.

Снижение рисков искусственного интеллекта

По мере того, как искусственный интеллект становится все более изощренным и функциональным, происходит много положительных сдвигов. Но, к сожалению, мощные новые технологии всегда подвержены риску неправильного использования. Эти риски затрагивают почти все аспекты нашей повседневной жизни, от конфиденциальности до политической безопасности и автоматизации работы.

Эти риски затрагивают почти все аспекты нашей повседневной жизни, от конфиденциальности до политической безопасности и автоматизации работы.

Первым шагом в снижении рисков, связанных с искусственным интеллектом, будет решение, где мы хотим использовать ИИ, а где его не следует поощрять. Расширение исследований и дискуссий о системах ИИ и их использовании — это первый шаг к предотвращению их неправильного использования.

Риски, связанные с искусственным интеллектом

Мы являемся частью сообщества технологов, ученых и политиков, разделяющих интерес к безопасному и глобально полезному искусственному интеллекту (ИИ). Мы работаем в партнерстве с ними, чтобы продуктивно формировать общественное обсуждение, поощрять новые таланты и запускать новые центры, такие как Leverhulme Center for the Future of Intelligence. В нашем исследовании были рассмотрены технические вопросы, связанные с безопасностью ИИ, краткосрочными и долгосрочными последствиями безопасности и управлением ИИ, а также потенциалом ИИ для снижения экологических и биологических рисков.

Область ИИ быстро развивается. В последние годы произошли впечатляющие прорывы в области распознавания изображений и речи, автономной робототехники, языковых задач и игр. В ближайшие десятилетия, вероятно, будет достигнут существенный прогресс. Это сулит большие выгоды: новые научные открытия, более дешевые и качественные товары и услуги, достижения в области медицины. Наши исследования и совместные проекты касались применения ИИ для решения ряда глобальных задач, включая борьбу с изменением климата, реагирование на пандемию и обеспечение продовольственной безопасности.

ИИ также вызывает опасения в краткосрочной перспективе: конфиденциальность, предвзятость, неравенство, безопасность и защищенность. Исследование CSER выявило новые угрозы и тенденции в глобальной кибербезопасности, а также изучило проблемы на пересечении ИИ, оцифровки и систем ядерного оружия.

AlphaGo Zero достиг сверхчеловеческого уровня производительности после трех дней самостоятельной игры

Большинство современных систем искусственного интеллекта представляют собой «узкие» приложения, специально разработанные для решения четко определенной проблемы в одной области, например, в конкретной игре. Такие подходы не могут адаптироваться к новым или более масштабным задачам без существенной перестройки. Хотя в одной области он может намного превосходить возможности человека, в других областях он не превосходит его. Однако давней целью в этой области была разработка искусственного интеллекта, который может обучаться и адаптироваться к очень широкому кругу задач.

Такие подходы не могут адаптироваться к новым или более масштабным задачам без существенной перестройки. Хотя в одной области он может намного превосходить возможности человека, в других областях он не превосходит его. Однако давней целью в этой области была разработка искусственного интеллекта, который может обучаться и адаптироваться к очень широкому кругу задач.

ИИ в долгосрочной перспективе: возможности и угрозы

По мере того, как системы ИИ становятся все более мощными и универсальными, они могут превзойти возможности человека во многих областях. Если это произойдет, это может стать переходом, столь же преобразующим в экономическом, социальном и политическом плане, как промышленная революция. Это может привести к чрезвычайно позитивным изменениям, но также потенциально может создать катастрофические риски, связанные с авариями (безопасность) или неправильным использованием (безопасность).

О безопасности: наши нынешние системы часто дают непредсказуемые сбои. Существует ряд сложных технических проблем, связанных с проектированием безаварийного искусственного интеллекта. Согласование поведения текущих систем с нашими целями оказалось трудным и привело к непредсказуемым отрицательным результатам. Аварии, вызванные более мощными системами, будут гораздо более разрушительными.

Существует ряд сложных технических проблем, связанных с проектированием безаварийного искусственного интеллекта. Согласование поведения текущих систем с нашими целями оказалось трудным и привело к непредсказуемым отрицательным результатам. Аварии, вызванные более мощными системами, будут гораздо более разрушительными.

О безопасности: передовые системы искусственного интеллекта могут быть ключевыми экономическими и военными активами. Если бы эти системы оказались в руках недобросовестных игроков, они могли бы использовать их во вред. Если несколько групп соревнуются за его разработку первыми, это может иметь дестабилизирующую динамику гонки вооружений. Снижение рисков и достижение глобальных преимуществ ИИ создадут уникальные проблемы управления и потребуют глобального сотрудничества и представительства.

На пути к безопасному и полезному преобразующему ИИ

Существует большая неопределенность и разногласия по поводу сроков разработки передовых систем искусственного интеллекта. Но какой бы ни была скорость прогресса в этой области, кажется, что есть полезная работа, которую можно сделать прямо сейчас. Технические исследования машинного обучения в области безопасности в настоящее время проводятся командами OpenAI, DeepMind и Центра искусственного интеллекта, совместимого с человеком. Исследования управления ИИ в отношении последствий для безопасности развиваются как область.

Но какой бы ни была скорость прогресса в этой области, кажется, что есть полезная работа, которую можно сделать прямо сейчас. Технические исследования машинного обучения в области безопасности в настоящее время проводятся командами OpenAI, DeepMind и Центра искусственного интеллекта, совместимого с человеком. Исследования управления ИИ в отношении последствий для безопасности развиваются как область.

Сообщество, работающее над безопасным и полезным сверхразумом, выросло по всему миру. Это исходит от исследователей ИИ, демонстрирующих лидерство в этом вопросе, что подтверждается обширными дискуссиями в лабораториях и конференциях по машинному обучению, знаковой конференцией в Пуэрто-Рико и высококлассной поддержкой таких людей, как советники CSER Илон Маск и Стивен Хокинг. Мы тесно сотрудничаем с этим сообществом, в университетских лабораториях и в технологических компаниях, чтобы разработать общие стратегии, позволяющие безопасно реализовать преимущества достижений ИИ.

В ближайшие годы будут разработаны и внедрены более продвинутые и мощные системы искусственного интеллекта, эти системы могут иметь преобразующие последствия, как положительные, так и отрицательные, и кажется, что мы можем делать полезную работу прямо сейчас. Несмотря на то, что существует много неопределенностей, мы должны приложить серьезные усилия и подумать, чтобы заложить основы безопасности будущих систем и лучше понять последствия таких достижений.

Несмотря на то, что существует много неопределенностей, мы должны приложить серьезные усилия и подумать, чтобы заложить основы безопасности будущих систем и лучше понять последствия таких достижений.

Чтобы прочитать об одном из текущих проектов CSER, «Парадигмы общего искусственного интеллекта и связанные с ними риски», финансируемого Институтом будущего жизни в рамках Международного конкурса грантов FLI по безопасности, нажмите здесь.

Что такое искусственный интеллект? Ответы на ваши вопросы об ИИ.

Стивен Хокинг сказал: «Развитие полноценного искусственного интеллекта может означать конец человечества». Илон Маск утверждает, что ИИ — это «самая большая экзистенциальная угроза человечества».

Люди могут спросить: Подождите, что? Но эти великие опасения коренятся в исследованиях. Наряду с Хокингом и Маском видные деятели из Оксфорда и Калифорнийского университета в Беркли, а также многие исследователи, работающие в области ИИ сегодня, считают, что передовые системы ИИ, если их небрежно развернуть, могут навсегда отрезать человеческую цивилизацию от хорошего будущего.

Эта проблема поднималась с самого начала вычислительной техники. Но в последние годы ему уделялось особое внимание, поскольку достижения в области машинного обучения дали нам более конкретное понимание того, что мы можем делать с ИИ, что ИИ может сделать для нас (и для нас) и как много мы еще не делаем. не знаю.

Есть и скептики. Некоторые из них считают, что продвинутый ИИ так далек, что сейчас нет смысла думать об этом. Другие обеспокоены тем, что чрезмерная шумиха вокруг силы их поля может преждевременно убить ее. И даже среди людей, которые в целом согласны с тем, что ИИ представляет собой уникальную опасность, существуют разные взгляды на то, какие шаги сегодня имеют наибольший смысл.

Разговоры об ИИ полны путаницы, дезинформации и людей, говорящих мимо друг друга — во многом потому, что мы используем слово «ИИ» для обозначения очень многих вещей. Итак, вот общая картина того, как искусственный интеллект может представлять катастрофическую опасность, в девяти вопросах:

1) Что такое ИИ?

Искусственный интеллект — это попытка создать компьютеры, способные к разумному поведению. Это широкий универсальный термин, используемый для обозначения всего, от Siri до IBM Watson и мощных технологий, которые нам еще предстоит изобрести.

Это широкий универсальный термин, используемый для обозначения всего, от Siri до IBM Watson и мощных технологий, которые нам еще предстоит изобрести.

Некоторые исследователи проводят различие между «узким ИИ» — компьютерными системами, которые лучше, чем люди, в какой-то конкретной, четко определенной области, такой как игра в шахматы, создание изображений или диагностика рака, — и «общим ИИ», системами, которые могут превосходить человеческие возможности в много доменов. У нас пока нет общего ИИ, но мы начинаем лучше понимать проблемы, которые он будет ставить.

Узкий ИИ добился необычайного прогресса за последние несколько лет. Системы ИИ значительно улучшились при переводе, в таких играх, как шахматы и го, в важных вопросах исследовательской биологии, таких как предсказание того, как сворачиваются белки, и в создании изображений. Системы искусственного интеллекта определяют, что вы увидите в поиске Google или в ленте новостей Facebook. Они сочиняют музыку и пишут статьи, которые на первый взгляд читаются так, как будто их написал человек. Они играют в стратегии. Они разрабатываются для улучшения наведения дронов и обнаружить ракеты.

Они играют в стратегии. Они разрабатываются для улучшения наведения дронов и обнаружить ракеты.

Но узкий ИИ становится менее узким. Когда-то мы добились прогресса в области искусственного интеллекта, кропотливо обучая компьютерные системы конкретным концепциям. Для компьютерного зрения, позволяющего компьютеру идентифицировать предметы на изображениях и видео, исследователи написали алгоритмы для обнаружения границ. Чтобы играть в шахматы, они запрограммировали эвристики о шахматах. Для обработки естественного языка (распознавание речи, транскрипция, перевод и т. д.) они обратились к области лингвистики.

Но в последнее время мы стали лучше создавать компьютерные системы, обладающие универсальными способностями к обучению. Вместо того чтобы математически описывать детали проблемы, мы позволяем компьютерной системе изучить ее самостоятельно. Если раньше мы относились к компьютерному зрению как к проблеме, совершенно отличной от обработки естественного языка или платформера, то теперь мы можем решить все три проблемы с помощью одних и тех же подходов.

И по мере того, как компьютеры достаточно хорошо справляются с узкими задачами ИИ, они начинают демонстрировать более общие возможности. Например, знаменитая серия текстовых ИИ OpenAI GPT — это, в каком-то смысле, самый узкий из узких ИИ — он просто предсказывает, каким будет следующее слово в тексте, на основе предыдущих слов и его корпуса человеческого языка. И все же теперь он может определять вопросы как разумные или неразумные и обсуждать физический мир (например, отвечать на вопросы о том, какие объекты больше или какие шаги в процессе должны быть первыми). Чтобы хорошо справляться с узкой задачей прогнозирования текста, система ИИ в конечном итоге разовьет совсем не узкие способности.

До сих пор наш прогресс в области искусственного интеллекта позволил добиться огромных успехов, а также поставил неотложные этические вопросы. Когда вы обучаете компьютерную систему предсказывать, кто из осужденных преступников совершит повторное преступление, вы используете входные данные системы уголовного правосудия, предвзятые в отношении чернокожих и людей с низким доходом, и поэтому ее результаты, вероятно, будут предвзятыми в отношении чернокожих и людей с низким доходом. . Создание более захватывающих веб-сайтов может быть полезным для вашего дохода, но плохо для ваших пользователей. Выпуск программы, которая пишет убедительные поддельные обзоры или поддельные новости, может сделать их широко распространенными, что затруднит раскрытие правды.

. Создание более захватывающих веб-сайтов может быть полезным для вашего дохода, но плохо для ваших пользователей. Выпуск программы, которая пишет убедительные поддельные обзоры или поддельные новости, может сделать их широко распространенными, что затруднит раскрытие правды.

Рози Кэмпбелл из Центра искусственного интеллекта, совместимого с людьми Калифорнийского университета в Беркли, утверждает, что это лишь небольшие примеры большого беспокойства экспертов по поводу общего ИИ в будущем. Трудности, с которыми мы боремся сегодня с узким ИИ, возникают не из-за того, что системы отворачиваются от нас, хотят отомстить или считают нас неполноценными. Скорее, они происходят из-за разрыва между тем, что мы приказываем нашим системам делать, и тем, что мы на самом деле хотим, чтобы они делали.

Например, мы говорим системе набрать высокий балл в видеоигре. Мы хотим, чтобы он играл в игру честно и обучался игровым навыкам, но если вместо этого у него будет возможность напрямую взломать систему подсчета очков, он это сделает. Он отлично справляется с метрикой, которую мы ему дали. Но мы не получаем того, что хотели.

Он отлично справляется с метрикой, которую мы ему дали. Но мы не получаем того, что хотели.

Другими словами, наши проблемы возникают из-за того, что системы действительно хорошо достигают цели, к которой они научились стремиться; просто цель, которой они научились в своей тренировочной среде, — это не тот результат, которого мы на самом деле хотели. И мы создаем системы, которые не понимаем, а это значит, что мы не всегда можем предвидеть их поведение.

Прямо сейчас вред ограничен, потому что системы настолько ограничены. Но это закономерность, которая может иметь еще более серьезные последствия для людей в будущем, поскольку системы искусственного интеллекта станут более совершенными.

2) Возможно ли сделать компьютер таким же умным, как человек?

Да, хотя современные системы ИИ далеко не так умны.

Одна популярная поговорка об ИИ гласит: «Все, что легко, — сложно, а все сложное — легко». Делать сложные вычисления в мгновение ока? Легкий. Глядя на картинку и говоря вам, собака ли это? Жесткий (до недавнего времени).

Многие вещи, которые делают люди, все еще находятся за пределами понимания ИИ. Например, сложно разработать систему искусственного интеллекта, которая исследует незнакомую среду и может перемещаться, скажем, от входа в здание, в котором она никогда раньше не была, вверх по лестнице к рабочему столу конкретного человека. Мы только начинаем учиться проектировать систему ИИ, которая читает книгу и сохраняет понимание концепций.

Парадигма, которая недавно привела к крупнейшим прорывам в области искусственного интеллекта, называется «глубокое обучение». Системы глубокого обучения могут делать удивительные вещи: выигрывать в играх, которые, как мы думали, люди никогда не проиграют, изобретать убедительные и реалистичные фотографии, решать открытые проблемы в молекулярной биологии.

Эти открытия заставили некоторых исследователей прийти к выводу, что пора задуматься об опасностях более мощных систем, но скептики остаются. Пессимисты в этой области утверждают, что программам по-прежнему нужен необычный набор структурированных данных для обучения, требуются тщательно подобранные параметры или они работают только в средах, предназначенных для того, чтобы избежать проблем, которые мы еще не знаем, как решить. Они указывают на беспилотные автомобили, которые все еще посредственны в самых лучших условиях, несмотря на миллиарды, которые были вложены в то, чтобы заставить их работать.

Они указывают на беспилотные автомобили, которые все еще посредственны в самых лучших условиях, несмотря на миллиарды, которые были вложены в то, чтобы заставить их работать.