Содержание

Зачем нам нужны нейронные процессоры? / Хабр

Нейросети сейчас называют новым электричеством. Мы их не замечаем, но пользуемся каждый день. Face ID в iPhone, умные ассистенты, сервисы перевода, и даже рекомендации в YouTube — всё это нейросети. Они развиваются настолько стремительно, что даже самые потрясающие открытия выглядят как обыденность.

Например, недавно в одном из самых престижных научных журналов Nature опубликовали исследование группы американских ученых. Они создали нейросеть, которая может считывать активность коры головного мозга и преобразовывать полученные сигналы в речь. С точностью 97 процентов. В будущем, это позволит глухонемым людям «заговорить».

И это только начало. Сейчас мы стоим на пороге новой технической революции сравнимой с открытием электричества. И сегодня мы объясним вам почему.

Как работают нейросети?

Центральный процессор — это очень сложный микрочип. Он умеет выполнять кучу разных инструкций и поэтому справляется с любыми задачами. Но для работы с нейросетями он не подходит. Почему так?

Он умеет выполнять кучу разных инструкций и поэтому справляется с любыми задачами. Но для работы с нейросетями он не подходит. Почему так?

Сами по себе нейросетевые операции очень простые: они состоят всего из двух арифметических действий: умножения и сложения.

Например, чтобы распознать какое-либо изображение в нейронную сеть нужно загрузить два набора данных: само изображение и некие коэффициенты, которые будут указывать на признаки, которые мы ищем. Эти коэффициенты называются весами.

Вот например так выглядят веса для рукописных цифр. Похоже как будто очень много фоток цифр наложили друг на друга.

А вот так для нейросети выглядит кошка или собака. У искусственного интеллекта явно свои представления о мире.

Но вернёмся к арифметике. Перемножив эти веса на исходное изображение, мы получим какое-то значение. Если значение большое, нейросеть понимает:

— Ага! Совпало. Узнаю, это кошка.

А если цифра получилась маленькой значит в областях с высоким весом не было необходимых данных.

Вот как это работает. Видно как от слоя к слою сокращается количество нейронов. В начале их столько же сколько пикселей в изображении, а в конце всего десять — количество ответов. С каждым слоем изображение упрощается до верного ответа. Кстати, если запустить алгоритм в обратном порядке, можно что-нибудь сгенерировать.

Всё вроде бы просто, да не совсем. В нейросетях очень много нейронов и весов. Даже в простой однослойной нейросети, которая распознает цифры на картинках 28 x 28 пикселей для каждого из 10 нейронов используется 784 коэффициента, т.е. веса, итого 7840 значений. А в глубоких нейросетях таких коэффициентов миллионы.

CPU

И вот проблема: классические процессоры не заточены под такие массовые операции. Они просто вечность будут перемножать и складывать и входящие данные с коэффициентами. Всё потому, что процессоры не предназначены для выполнения массовых параллельных операций.

Ну сколько ядер в современных процессорах? Если у вас восьмиядерный процессор дома, считайте вы счастливчик. На мощных серверных камнях бывает по 64 ядра, ну может немного больше. Но это вообще не меняет дела. Нам нужны хотя бы тысячи ядер.

На мощных серверных камнях бывает по 64 ядра, ну может немного больше. Но это вообще не меняет дела. Нам нужны хотя бы тысячи ядер.

Где же взять такой процессор? В офисе IBM? В секретных лабораториях Пентагона?

GPU

На самом деле такой процессор есть у многих из вас дома. Это ваша видеокарта.

Видеокарты как раз заточены на простые параллельные вычисления — отрисовку пикселей! Чтобы вывести на 4K-монитор изображение, нужно отрисовать 8 294 400 пикселей (3840×2160) и так 60 раз в секунду (или 120/144, в зависимости от возможностей монитора и пожеланий игрока, прим.ред.). Итого почти 500 миллионов пикселей в секунду!

Видеокарты отличаются по своей структуре от CPU. Почти всё место в видеочипе занимают вычислительные блоки, то есть маленькие простенькие ядра. В современных видюхах их тысячи. Например в GeForce RTX2080 Ti, ядер больше пяти тысяч.

Всё это позволяет нейросетям существенно быстрее крутиться GPU.

Производительность RTX2080 Ti где-то 13 TFLOPS (FLOPS — FLoating-point Operations Per Second), что значит 13 триллионов операций с плавающей запятой в секунду. Для сравнения, мощнейший 64-ядерный Ryzen Threadripper 3990X, выдаёт только 3 TFLOPS, а это заточенный под многозадачность процессор.

Триллионы операций в секунду звучит внушительно, но для действительно продвинутых нейронных вычислений — это как запустить FarCry на калькуляторе.

Недавно мы игрались с алгоритмом интерполяции кадров DAIN, основанном на машинном обучении. Алгоритм очень крутой, но с видеокартой Geforce 1080 уходило 2-3 минуты на обработку одного кадра. А нам нужно чтобы подобные алгоритмы работали в риалтайме, да и желательно на телефонах.

TPU

Именно поэтому существуют специализированные нейронные процессоры. Например, тензорный процессор от Google. Первый такой чип в Google сделали еще в 2015 году, а в 2018 вышла уже третья версия.

Производительность второй версии 180 TFLOPS, а третьей — целых 420 TFLOPS! 420 Триллионов операций в секунду. Как они этого добились?

Каждый такой процессор содержит 10-ки тысяч крохотных вычислительных ядер, заточенных под единственную задачу складывать и перемножать веса. Пока, что он выглядит огромным, но через 15 лет он существенно уменьшится в размерах. Но это еще фигня. Такие процессоры объединяться в кластеры по 1024 штуки, без каких либо просадок в производительности. GPU так не могут.

Такой кластер из тензорных процессоров третьей версии могут выдать 430 PFLOPS (пета флопс) производительности. Если что, это 430 миллионов миллиардов операций в секунду.

Где мы и что нас ждёт?

Но как мы уже говорили, это только начало. Текущие нейронные суперкомпьютеры — это как первые классические мейнфреймы занимавшие, целые этажи в зданиях.

В 2000 году первый суперкомпьютер с производительностью 1 терафлопс занимал 150 квадратных метров и стоил 46 миллионов долларов.

Спустя 15 лет NVIDIA мощностью 2,3 терафлопса, которая помещается в руке стоит 59$.

Так что в следующие 15-20 лет суперкомпьютер Google тоже поместится в руке. Ну или где мы там будем носить процессоры?

Кадр из режиссерской версии фильма «Терминатор-2»

А мы пока ждём момента, довольствуемся нейромодулями в наших смартфонах — в тех же Qualcomm Snapdragon’ах, Kirin’ах от Huawei и в Apple Bionic — они уже тихо делают свою работу.

И уже через несколько презентаций они начнут меряться не гигагерцами, ядрами и терафлопсами, а чем-то понятным для всех — например, распознанных котиках в секунду. Всё лучше, чем попугаи!

Нейроморфные вычисления — что это и как связаны с ИИ?

Текст Павел Иевлев

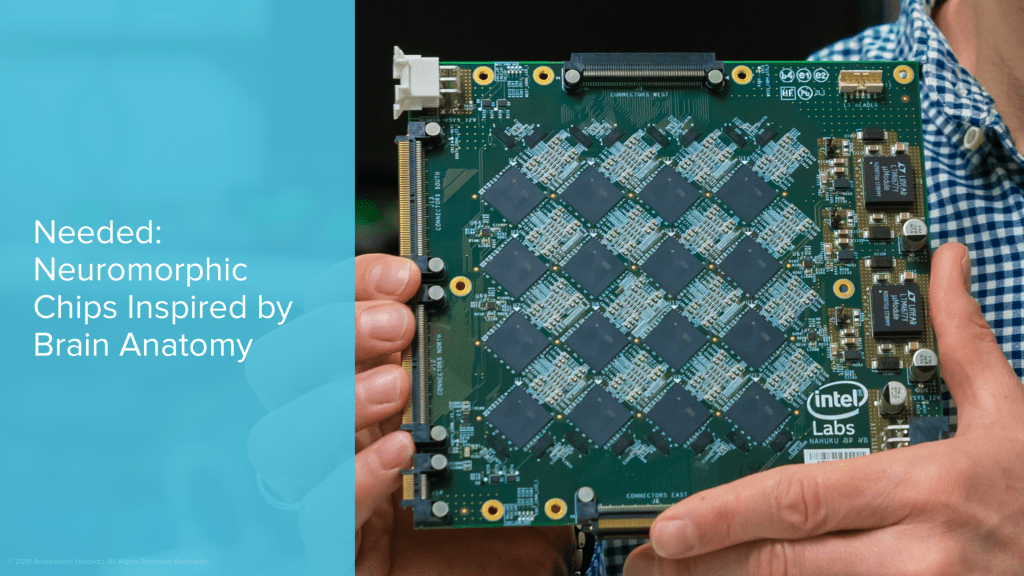

Логическая структура процессоров нового типа имитирует структуру головного мозга — изменят ли они мир компьютеров?

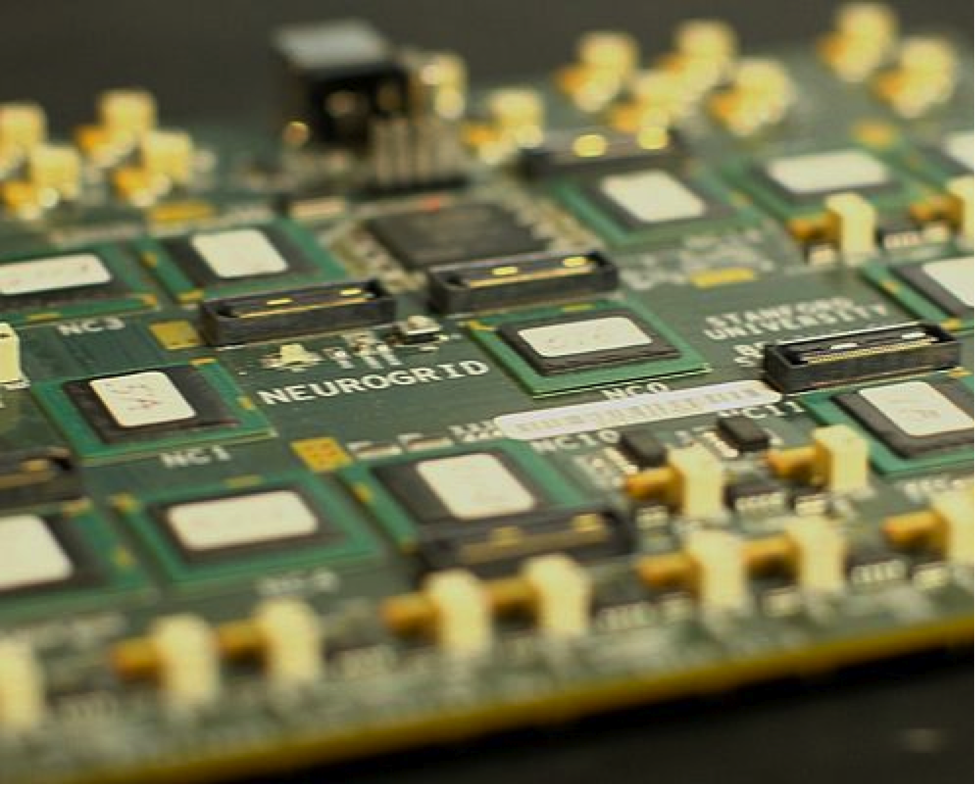

Дисциплина, известная как «нейроморфный инжиниринг», уже

несколько десятилетий ставит перед собой задачу воспроизвести, хотя бы

частично, структуру человеческого мозга в виде электронных схем. Сама задача

Сама задача

довольно старая, разработки (в том числе и вполне успешные) ведутся очень давно.

(Классическая модель нейросети — перцептрон — была разработана еще в

шестидесятых годах прошлого века.) Одно время нейроморфные системы имели шанс

стать мейнстримным направлением в вычислительной кибернетике, но потом классическая

«фон Неймановская» архитектура победила, и мы имеем то, что имеем. Однако

вполне вероятно, что пришло время для ренессанса нейроморфизма в вычислительных

системах, потому что для новых задач он подходит лучше «классики».

Что же это за задачи?

Думай, как человек, считай, как машина!

В пределе развития компьютерных систем, начиная с их первых

шагов и до наших дней, стоит задача создания настоящего Искусственного

Интеллекта — машины, которая не только может решать отдельные задачи, но и ставить

перед собой новые. Достижима ли эта цель в принципе, стоит ли ее достигать, и

не получим ли мы при этом больше проблем, чем выгод — вопрос дискуссионный.

Однако промежуточные бонусы на этом направлении разработок настолько

привлекательны, что свернуть с него никому в голову не приходит.

Пока ИИ далек от стадии «создать «Скайнет» и убить всех

человеков», на пути к нему маячат весьма практичные и понятные новации

«ближнего прицела». Это, в первую очередь, системы машинного обучения и

нейросетевые алгоритмы. Они решают такие практические задачи, как проблема

распознавания — букв, цифр, образов — и различения объектов. Уже сейчас нейрос делает

это настолько хорошо, что, например, в медицинской сфере может ставить диагноз

лучше (или, как минимум, раньше), чем обычный доктор, распознав в тысяче

рентгеновских снимков один с характерным признаком опухоли.

Сейчас нейросети работают на вычислительных платформах с

обычной, фон Неймановской архитектурой. Однако необходимая для «сравнительных»

вычислений многопоточность делает их неоптимальными. Дело в том, что

вычисления, требуемые для реализации алгоритмов нейронной сети, простые, но их

надо сделать очень-очень много и, желательно, одновременно. Обычные процессоры

с их последовательной схемой работы подходят плохо, приходится использовать

видеокарты с их тысячами и десятками тысяч слабеньких, но специализированных

вычислительных модулей. Однако специализированы они, в общем, под другие

Однако специализированы они, в общем, под другие

задачи, и проблема «железа для нейровычислений» остается острой. Человек, с его

относительно небольшой аппаратной вычислительной мощностью, все еще справляется

с задачей «распознавание и сравнение» на три порядка лучше самого мощного

компьютерного кластера.

И вот тут напрашивается идея «скопировать человека».

Нейроморфированное железо

Термин «нейроморфный» применительно к вычислительным

системам означает, что технологические барьеры преодолеваются с помощью

подходов, заимствованных из биологии, основываясь на принципах работы мозга.

Нейроморфная система — это уход от классической архитектуры фон Неймана.

В архитектуре фон Неймана чтобы сложить два числа, одно

число берется из памяти, помещается в регистр процессора, затем берется другое

число, помещается в другой регистр процессора. Выполняется операция, результат

кладется в третий регистр процессора, откуда перемещается обратно в память. Современный

процессор делает это очень быстро, но КПД процесса так себе. Большинство

Большинство

вычислений в нейронных сетях основано на потоке данных, постоянное переключение

между блоками обработки и блоками памяти становится узким местом, тормозящим

производительность. Это требует новых архитектур и процессорных реализаций,

которые будут удовлетворять постоянно растущим требованиям нейросетевых

алгоритмов.

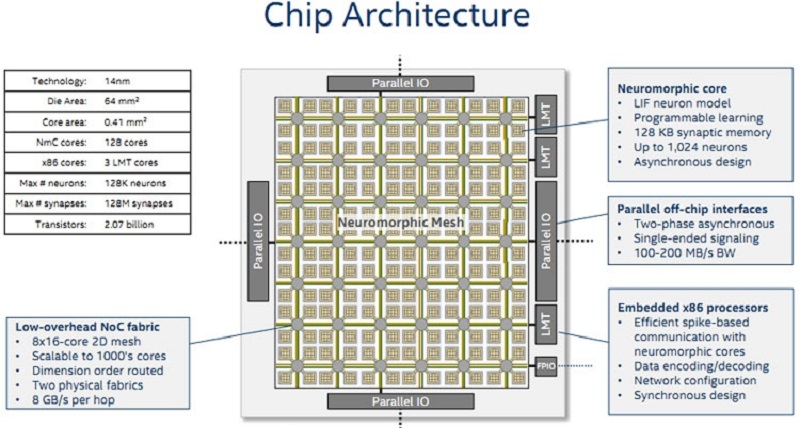

Ключевое отличие архитектуры нейроморфных процессоров от

традиционной фон Неймановской архитектуры заключается в том, что в них память и

вычислительные ядра объединены, поэтому расстояние передачи данных сведено к

минимуму. Это минимизирует задержки и расход энергии.

Нейроморфным процессорам, в отличие от классических, не

нужно обращаться к памяти (или регистрам) и извлекать оттуда данные — вся

информация уже хранится в искусственных нейронах. Таким образом, становится

возможна обработка больших данных на конечных устройствах без необходимости

дополнительных вычислительных мощностей. Так, например, отечественный

нейроморфный процессор «Алтай» потребляет на сравнимых задачах почти в тысячу

раз меньше энергии, чем традиционные графические ускорители (GPU). Учитывая,

Учитывая,

что робототехника, носимые устройства или автономные автомобили требуют все

более сложных вычислительных устройств, работающих в режиме реального времени с

малой задержкой и низким энергопотреблением, нейроморфные процессоры выглядят

очень перспективным направлением.

Перспективы и выводы

В настоящее время направление нейроморфных

процессоров вызывает огромный интерес во всем мире, и такие чипы постепенно

становятся доступными для научного и промышленного использования. Параллельно с

доступностью чипов ученые в сфере искусственного интеллекта создают все более

эффективные механизмы обучения нейроморфных нейросетей.

В отличие от традиционных, фон Неймановских, вычислительных

архитектур, логика и устройство нейроморфных процессоров изначально

специализирована для работы именно нейронных сетей. Это специализированный

класс микропроцессоров, которые используются для аппаратного ускорения работы

алгоритмов компьютерного зрения, распознавания голоса и изображений, машинного

обучения и других методов искусственного интеллекта. Мы вряд ли увидим их в

Мы вряд ли увидим их в

домашних десктопах. Однако число таких задач в стремительно цифровизирующемся

мире настолько велико, что в разработку нейроморфных систем вкладываются

многие, в том числе и в России.

Так, например, «Лаборатория Касперского» стала акционером

компании «Мотив нейроморфные технологии» с долей участия 15%. Компании вместе

разрабатывают вышеупомянутый нейроморфный процессор «Алтай». На сегодняшний день

это один из самых энергоэффективных процессоров в мире. Эксперты считают, что,

в отличие от классических архитектур, где отставание России велико, в области

нейроморфного железа наше страна вполне на острие прогресса.

Скорее всего, уже в ближайшем будущем практические задачи

нейронных сетей, реализуемые сейчас на GPU, будут переводиться на нейроморфное железо, все более и более

приближаясь по архитектуре к работе человеческого мозга, который призвано

заменить.

А там и до «Скайнета» недалеко.

Использованные источники:

Что это за нейроморфные вычисления, о которых вы говорите?

В связи с тем, что емкость чипа исчерпана, исследователи ищут варианты питания технологий завтрашнего дня

Полупроводники часто называют мозгом электроники. Со временем мощность этих крошечных кремниевых чипов росла в геометрической прогрессии, несмотря на то, что их схемы уменьшились до невообразимо малых размеров. В самом деле, мы всегда могли рассчитывать на то, что улучшения процессора будут отражать усовершенствования аппаратного и программного обеспечения.

Со временем мощность этих крошечных кремниевых чипов росла в геометрической прогрессии, несмотря на то, что их схемы уменьшились до невообразимо малых размеров. В самом деле, мы всегда могли рассчитывать на то, что улучшения процессора будут отражать усовершенствования аппаратного и программного обеспечения.

Но с появлением энергоемких автономных транспортных средств, роботов, дронов и других автономных машин, требующих небольших, но мощных и энергоэффективных чипов, а также с традиционными полупроводниками, достигшими пределов миниатюризации и мощности, исследователи говорят, что новый подход к дизайну полупроводников нужный.

Одна многообещающая альтернатива уже вызывает значительный интерес: нейроморфные вычисления.

Gartner прогнозирует, что традиционные вычислительные технологии, основанные на устаревшей полупроводниковой архитектуре, к 2025 году преодолеют цифровую стену и вызовут переход к новым парадигмам, включая нейроморфные вычисления. Emergen Research, тем временем, заявляет, что мировой рынок нейроморфной обработки достигнет 11,29 долларов США. миллиардов к 2027 году.

миллиардов к 2027 году.

«Нейроморфная инженерия не заменит аппаратное обеспечение общего назначения, но она может иметь огромное значение для решения специальных или специфических технологических задач, таких как эффективное внедрение искусственного интеллекта на периферии», — говорит Эмре Нефтчи, доцент в когнитивных наук в Калифорнийском университете в Ирвине и руководитель университетской лаборатории нейроморфного машинного интеллекта. «Исследования этой технологии быстро продвигаются».

Технология, имитирующая биологию

Нейроморфные вычисления имитируют физику человеческого мозга и нервной системы, создавая так называемые импульсные нейронные сети, где импульсы от отдельных электронных нейронов активируют другие нейроны в каскадной цепи. Это аналогично тому, как мозг посылает и получает сигналы от биологических нейронов, которые вызывают или распознают движение и ощущения в нашем теле. В отличие от более традиционных подходов, когда системы организуют вычисления в жестких двоичных терминах (это 1 или 0? да или нет?), нейроморфные чипы выполняют вычисления более гибко и широко. Его спайковые нейроны работают без какого-либо предписанного порядка.

Его спайковые нейроны работают без какого-либо предписанного порядка.

Идея состоит в том, чтобы довести вычислительные устройства до такой степени, чтобы они могли творчески мыслить, распознавать людей или объекты, которых они никогда не видели, и каким-то образом приспосабливаться, чтобы действовать. Большинство исследователей признают, что их еще нет. Например, если вы обучите традиционный компьютер, нагруженный программным обеспечением ИИ, играть в классическую игру Atari «Breakout», где игроки используют цифровую ракетку и мяч, чтобы пробить слой кирпичей, он, вероятно, всегда будет побеждать людей. Но если вы дадите ИИ новую ракетку, которая будет на 10 пикселей выше или ниже, он, скорее всего, запутается и сломается. Люди, вероятно, начнут побеждать, потому что, в отличие от ИИ, наш мозг замечательно разбирается в понимании причин и следствий.

Пожалуйста, прочитайте: Как суперкомпьютеры идентифицируют терапевтические средства против COVID-19

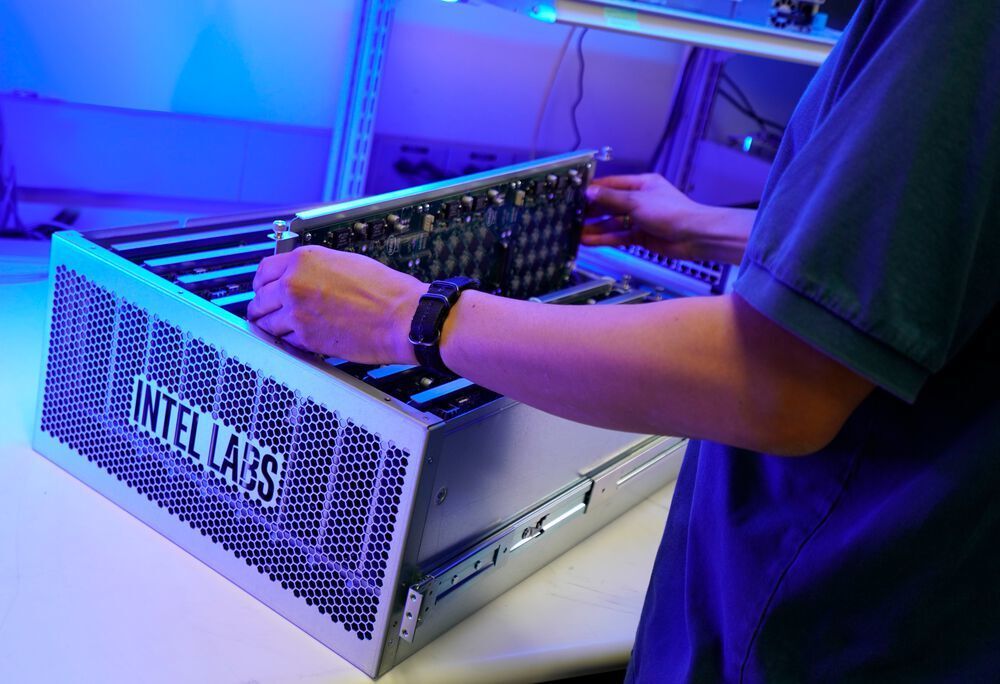

Преодолеть этот горб технологии будет непросто. Но технологические фирмы, включая Intel, Hewlett Packard Enterprise, IBM, Airbus SE и Accenture, а также правительственные исследовательские центры, такие как Sandia National Laboratories, и ученые по всему миру изучают его. И успехи последних нескольких лет говорят о том, что они добились значительного прогресса.

Но технологические фирмы, включая Intel, Hewlett Packard Enterprise, IBM, Airbus SE и Accenture, а также правительственные исследовательские центры, такие как Sandia National Laboratories, и ученые по всему миру изучают его. И успехи последних нескольких лет говорят о том, что они добились значительного прогресса.

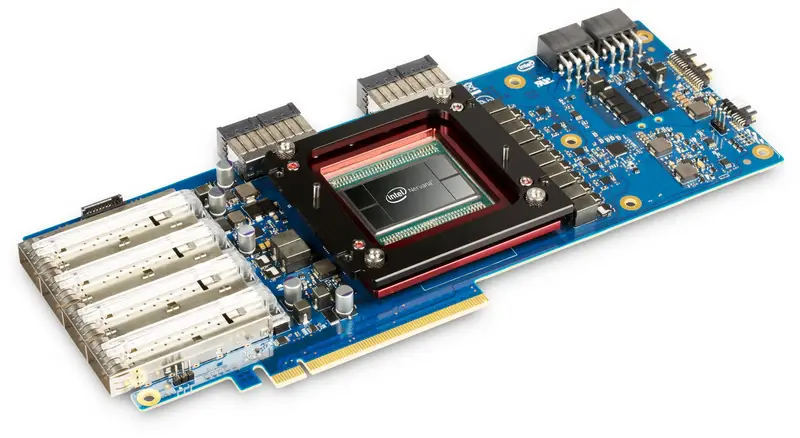

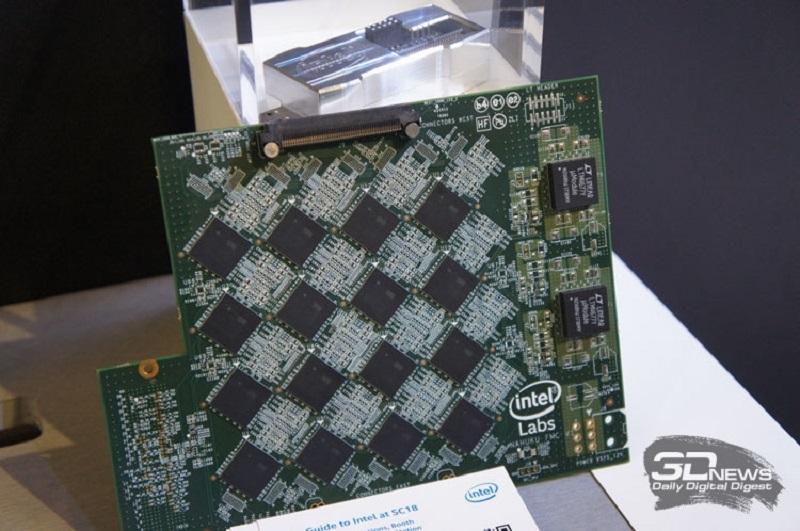

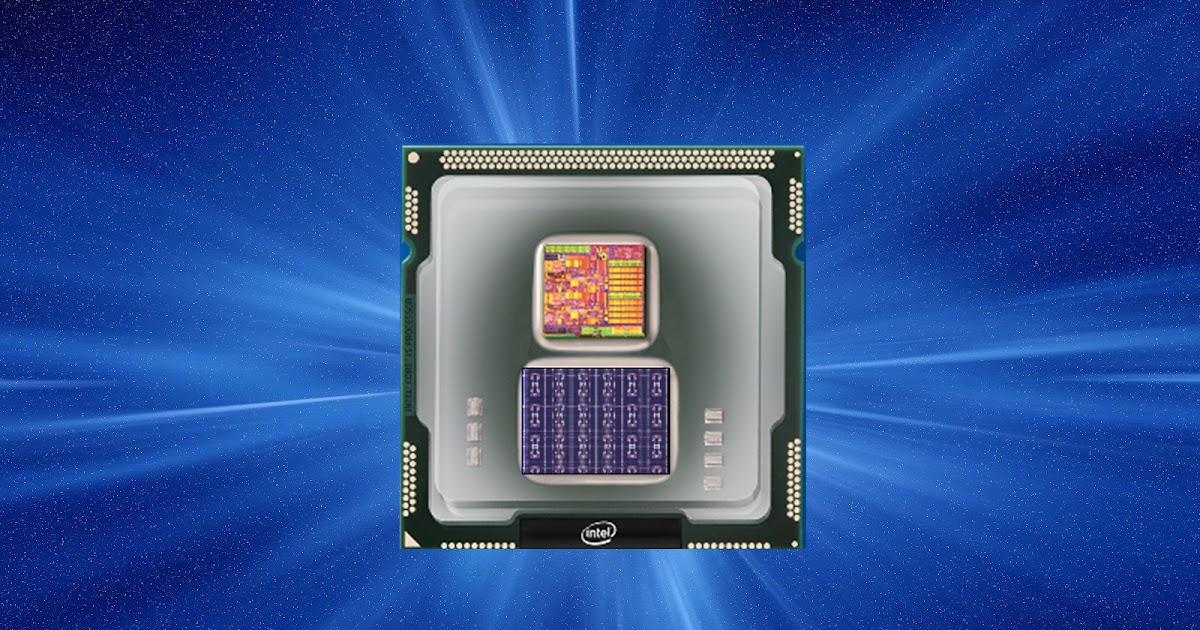

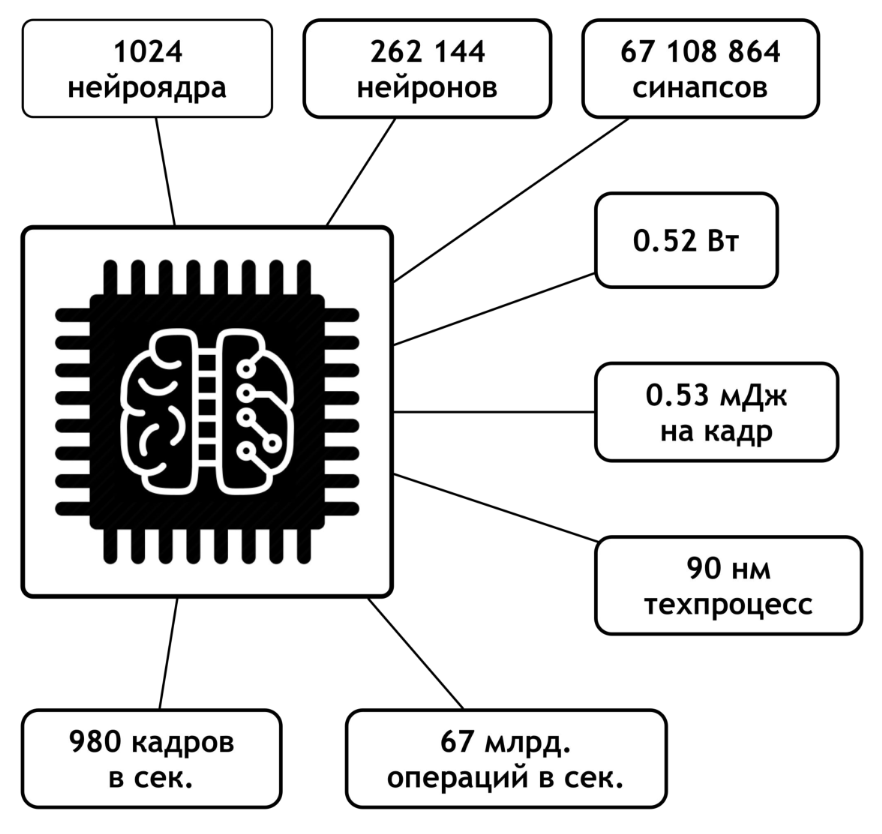

В прошлом году, например, Intel продемонстрировала нейроморфного робота, который может видеть и распознавать неизвестные объекты на основе всего одного примера, в отличие от традиционных моделей, которые требуют обширных инструкций и данных. Точно так же Intel и Корнельский университет дебютировали с математическими алгоритмами, используемыми в нейроморфном текстовом чипе Intel Loihi, которые точно воспроизводят то, как мозг что-то «нюхает».

Под чутким руководством исследователей, по словам Intel, Loihi быстро распознал 10 различных запахов, и эта способность в конечном итоге может найти применение в безопасности аэропортов, обнаружении дыма и угарного газа, а также в контроле качества на заводах. Отдельно Accenture Labs продемонстрировала «Автомобильное голосовое управление», эксперимент на основе Loihi, который может обеспечить возможности управления голосом, жестами и контекстным интеллектом для транспортных средств без разрядки батарей. Например, система может распознавать голосовые команды, такие как «Запустить мой двигатель», и делать это на 200 миллисекунд быстрее и потреблять в 1000 раз меньше энергии, чем стандартный графический процессор, сообщил The Wall Street Journal исследователь Accenture. Исследователи и студенты UCI также недавно «обучили» чип Loihi распознавать жесты рук на лету, используя правило синаптической пластичности, вдохновленное мозгом.

Отдельно Accenture Labs продемонстрировала «Автомобильное голосовое управление», эксперимент на основе Loihi, который может обеспечить возможности управления голосом, жестами и контекстным интеллектом для транспортных средств без разрядки батарей. Например, система может распознавать голосовые команды, такие как «Запустить мой двигатель», и делать это на 200 миллисекунд быстрее и потреблять в 1000 раз меньше энергии, чем стандартный графический процессор, сообщил The Wall Street Journal исследователь Accenture. Исследователи и студенты UCI также недавно «обучили» чип Loihi распознавать жесты рук на лету, используя правило синаптической пластичности, вдохновленное мозгом.

«Меня вдохновляет эта технология, потому что вы можете выполнять все виды обучения непосредственно на самом чипе, не загружая модель, обученную в облаке, высокопроизводительном компьютере или графическом процессоре», — говорит Нефтчи. «Таким образом, вы можете себе представить, будь то дрон или смарт-часы, устройство способно самостоятельно учиться на основе базовых моделей во время работы».

На пути к мастерству

Сапан Агарвал, исследователь Sandia из Ливермора, Калифорния, говорит, что это обучение происходит намного быстрее, чем с традиционными компьютерами, опять же из-за того, что нейроморфные вычисления имитируют биологию. Он отмечает, что в наших телах мозг выполняет вычисления с информацией, которая физически находится поблизости. Но в традиционных компьютерах существует разделение между обработкой (в ЦП) и памятью (в ОЗУ). Вычисления зависят от перемещения данных между этими местоположениями, что создает узкое место, замедляющее скорость вычислений, увеличивающее вычислительные затраты и сжигающее огромное количество энергии, особенно при выполнении сложных задач.

Однако в нейроморфных вычислениях все вычисления могут выполняться в аналоговом формате или в памяти. Если это выполняется в памяти — что, по словам экспертов, является направлением, в котором движется технология, — задержка почти полностью устранена. А энергопотребление резко сокращается до такой степени, что устройство может работать от крошечной батареи годами, а не месяцами или неделями. Это открывает мир возможностей для использования чипов в машинах, которые должны выполнять сложные вычислительные операции с глубоким обучением на локальном уровне, таких как автономные транспортные средства, военные беспилотники и высокопроизводительные компьютеры, или в маломощных устройствах с пониженным энергопотреблением, которые просто нужно надежно работать в течение длительного периода времени, например, камеры видеонаблюдения в офисе или магазине.

Это открывает мир возможностей для использования чипов в машинах, которые должны выполнять сложные вычислительные операции с глубоким обучением на локальном уровне, таких как автономные транспортные средства, военные беспилотники и высокопроизводительные компьютеры, или в маломощных устройствах с пониженным энергопотреблением, которые просто нужно надежно работать в течение длительного периода времени, например, камеры видеонаблюдения в офисе или магазине.

«Нейроморфное исследовательское сообщество изначально думало, что аналоговый подход — это путь к этой технологии, но довольно быстро пришло к выводу, что у подходов к вычислениям в памяти есть больше преимуществ», — говорит Джон Пол Страчан, руководитель новой группы акселераторов в лаборатории искусственного интеллекта в Hewlett. Packard Enterprise, которая исследует возможности применения нейроморфной технологии. «Один из принципов, который стал ясен на раннем этапе, заключался в том, что вы не должны разделять вычислительные блоки и блоки памяти. Вместо этого вам нужны распределенные процессоры повсюду с локальными весами и вычислениями, чтобы вы не перемещали все виды данных все время. добейтесь крупной победы с помощью нейроморфных вычислений».

Вместо этого вам нужны распределенные процессоры повсюду с локальными весами и вычислениями, чтобы вы не перемещали все виды данных все время. добейтесь крупной победы с помощью нейроморфных вычислений».

Ускорение глобального развития

Концепция нейроморфных вычислений существует с 1980-х годов. Но в последние несколько лет он набрал обороты из-за растущего интереса к определенным типам технологических областей, включая ИИ, машинное обучение, датчики, прогнозную аналитику, потоковую передачу данных в реальном времени и моделирование — все из которых могли бы значительно процветать с большей обработкой. мощность и эффективность. Рост инвестиций со стороны автомобильной, аэрокосмической и оборонной промышленности, желающих внедрить инновации Индустрии 4.0, также стимулирует прогресс.

Пожалуйста, прочтите: От передовой до предприятия: этические соображения ИИ

Как ни странно, большая часть этой деятельности происходит за пределами США. Например, Китай, похоже, значительно превышает расходы США, по мнению исследователей.

«Для Китая это очень жарко», — говорит Мэтью Маринелла, технический исследователь Sandia в Альбукерке, Нью-Мексико. «Они тратят много денег, и они действительно очень хорошо себя чувствуют в этой области. Я думаю, что в США [нейроморфные] не очень хорошо понимают. Другие технологии, такие как квантовые вычисления, привлекли больше внимания и были довольно привлекательными. хорошо финансируется».

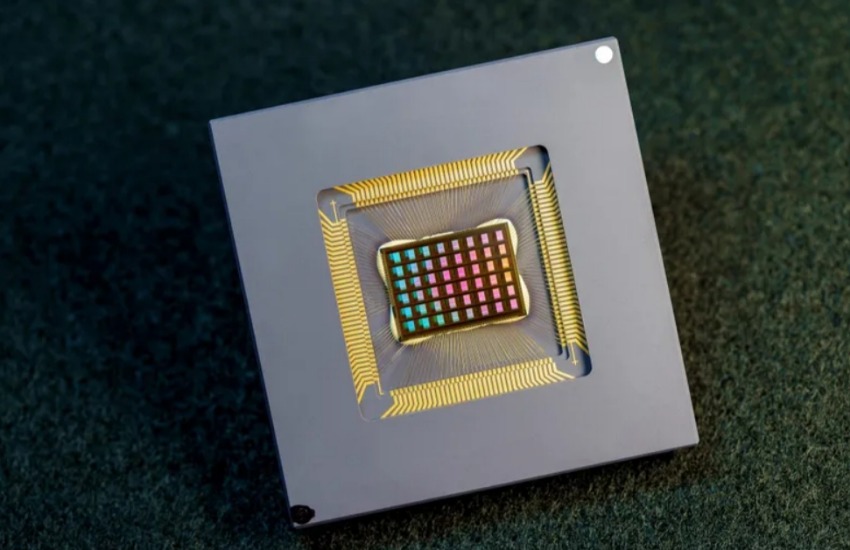

Успехи также были достигнуты в Технологическом университете Суинберна в Мельбурне, Австралия, где группа ученых и студентов недавно продемонстрировала то, что она назвала «самым быстрым и мощным оптическим нейроморфным процессором в мире» для ИИ. Работа стала результатом сотрудничества между исследователями Университета RMIT и Университета Монаша в Мельбурне и Национальным институтом научных исследований (INRS) в Канаде, Гонконге и Китае.

Профессор Дэвид Мосс, руководивший разработкой, говорит, что чип построен на оптических микрогребенках, способных выполнять 10 триллионов операций в секунду, что примерно в 1000 раз быстрее, чем у предыдущих процессоров. Эта технология может произвести революцию в том, как вычисления выполняются в вычислительных системах.

Эта технология может произвести революцию в том, как вычисления выполняются в вычислительных системах.

«Последствия использования микрогребней просто ошеломляют, — говорит Мосс. «Мы далеки от этого, но, в конечном счете, вы можете представить себе [системные] часы на вашем iPhone с точностью лучших часов в мире и иметь возможность делать такие вещи, как обнаружение гравитационного красного смещения или красного смещения времени. того, кто стоит рядом. И, конечно же, вы сможете избавиться от систем GPS, потому что у каждого будут свои часы и датчик движения. Я имею в виду, что точность этой технологии просто [дикая]».

Мельбурнская команда также сосредоточилась на технологии оптических нейронных сетей, которая могла бы значительно повысить точность и четкость цифровых камер, встроенных в автономные механизмы, такие как беспилотные автомобили, которые никогда не добьются успеха, если они не смогут вовремя распознать объекты, чтобы остановиться. . По словам Мосса, поскольку нейроморфные возможности продолжают улучшать способность ИИ распознавать поведение и модели, оптическая технология также может оказаться полезной для высококлассных исследований рака или COVID-19.

«Потенциал огромен, он огромен», — говорит он. «В настоящее время большинство исследований нейроморфных вычислений сосредоточено на том, как их можно использовать для устройств. Но со временем, когда мы это поймем, возможности будут ограничены только нашим воображением, а не технологиями».

Со временем, когда мы это поймем, возможности будут ограничены только нашим воображением, а не технологиями.

Проф. Дэвид Мосс Директор Исследовательского центра Технологического университета Суинберна

Эта статья/содержимое были написаны указанным автором и не обязательно отражают точку зрения Hewlett Packard Enterprise Company.

Нейроморфные вычисления

189 Публикации

Публикации на страницу

Демонстрируя аналоговый вывод о мобильной системе Brainscales-2

Янник Страдманн, Себастья Билделле, Оливер Бретвизер, Фолк Лейнер Эберт, Дан-Эйн, Дан-Эйн, Дан-Эйн, Дан-Эйн, Дан-Эйнер, Дан-Эйнер, Дан-Эйнер, Дан-Эйнер, Дан-Эйн, Дан-Эйнер, Дан-Эйн, Дан-Эйн, Дан-Эйн, Дан-Эйнер. , Эрик Мюллер, Филипп Шпилгер, Йоханнес Вайс, Йоханнес Шеммель

, Эрик Мюллер, Филипп Шпилгер, Йоханнес Вайс, Йоханнес Шеммель

Открытый журнал IEEE по схемам и системам

2022-09-21

Точная и гибкая аналоговая эмуляция динамики нейронов AdEx в кремнии

Sebastian Billaudelle, Johannes Weis, Philipp Dauer, Johannes Schemmel

arXiv

2022-09-19

Автокорреляции возникающей бистабильности в гомеостатических импульсных нейронных сетях на нейроморфном оборудовании , Йоханнес Циренберг

2022-08-17

Платформа квантования для нейронных сетей с быстрым выбросом импульсов

Чен Ли, Лей Ма, Стив Фербер

Границы в неврологии, Vol. 16

16

2022-07-19

Вариационное изучение квантовых основных состояний на нейроморфном аппаратном обеспечении

Роберт Классерт, Андреас Баумбах, Михай А. Петровичи, Мартин Герттнер

iScience, Vol. 25, № 8

2022-07-04

Выравнивание нейронной сети на нейроморфном оборудовании для оптической связи IM/DD

Элиас Арнольд, Георг Бёхерер, Эрик Мюллер, Филипп Спилгер, Йоханнес Шеммель, Стефано Калабро, Максим Кушнеров

arXiv

2022-06-01

Выравнивание нейронных сетей для оптической связи IM/DD

Элиас Арнольд, Георг Бёхерер, Эрик Мюллер, Филипп Шпилгер, Йоханнес Шеммель, Стефано Калабро, Максим Кушнеров

arXiv версия выступления на конференции

2022-06-01

Система внимания, основанная на биотехнологии, управляемая событиями, для человекоподобного робота iCub на платформе SpiNNaker

Джулия Д’Анджело, Адам Перретт, Массимилиано Иаконо, Стив Фербер, Кьяра Бартолоцци

Нейроморфные вычисления и инженерия, Vol.