Содержание

Чем завершился третий тест Тьюринга — Офтоп на vc.ru

Боты стали умнее.

5922

просмотров

В субботу 16 февраля завершился 3-ий всероссийский конкурс русскоговорящих чат-ботов в формате Теста Тьюринга, который проходил рамках международной конференции по искусственному интеллекту Opentalks.AI 14-16 февраля. Мы, компания “Наносемантика”, выступали соорганизаторами конкурса и хотим поделиться с вами результатами и самыми интересными диалогами с ботами.

Что такое Тест Тьюринга?

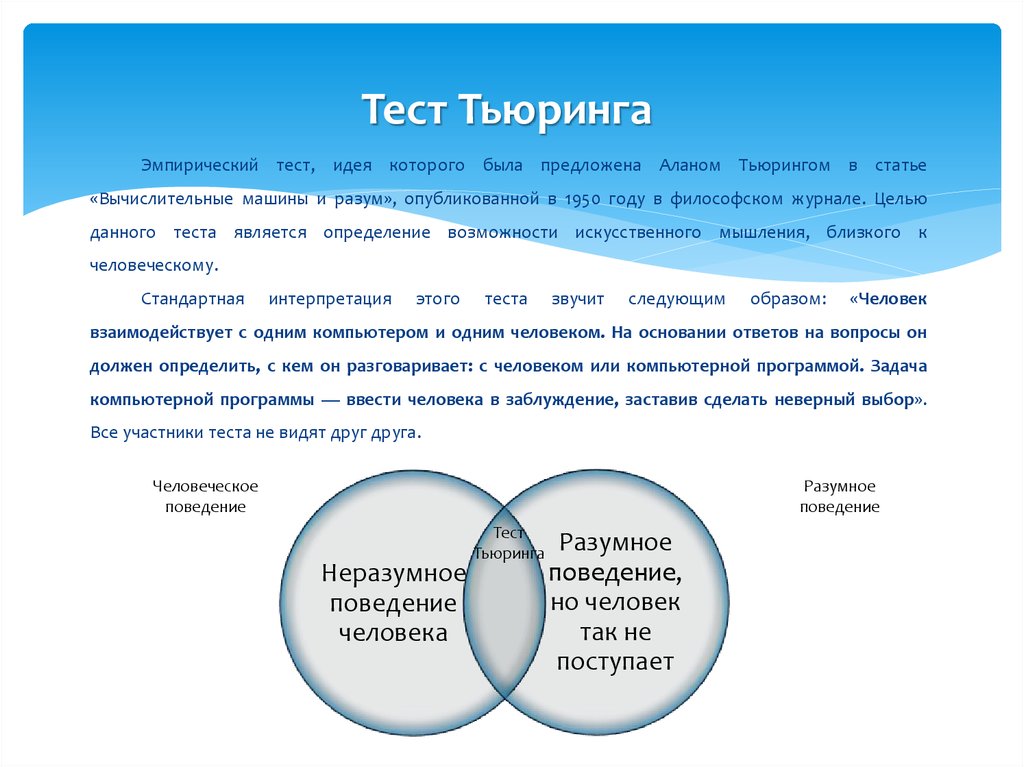

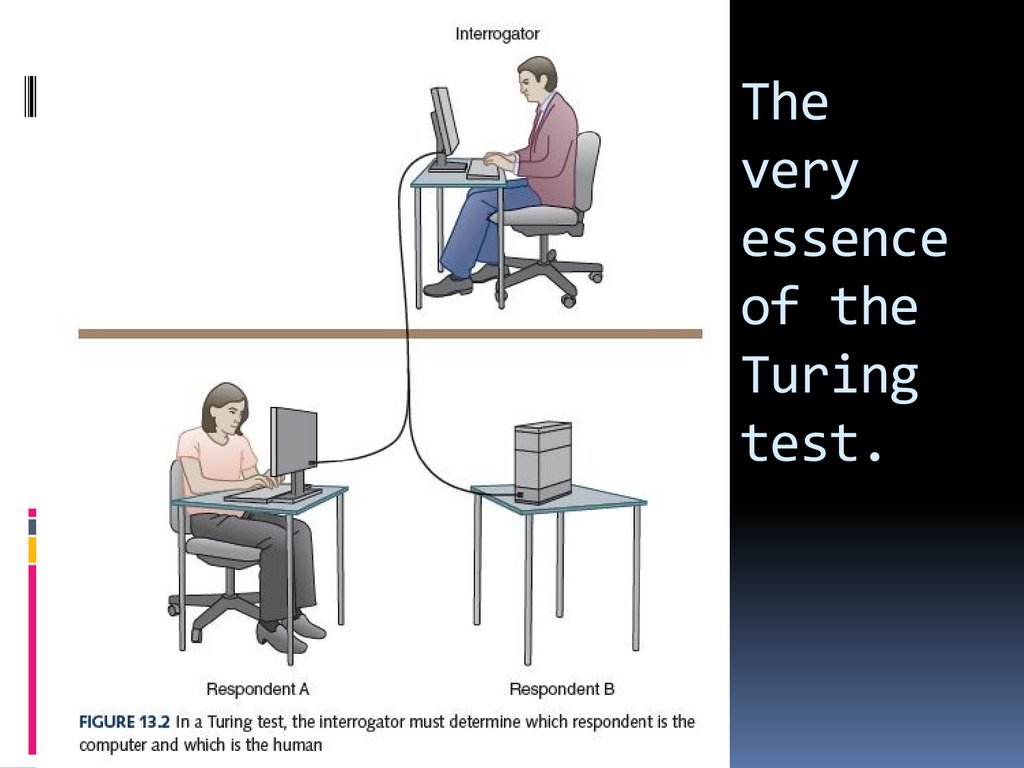

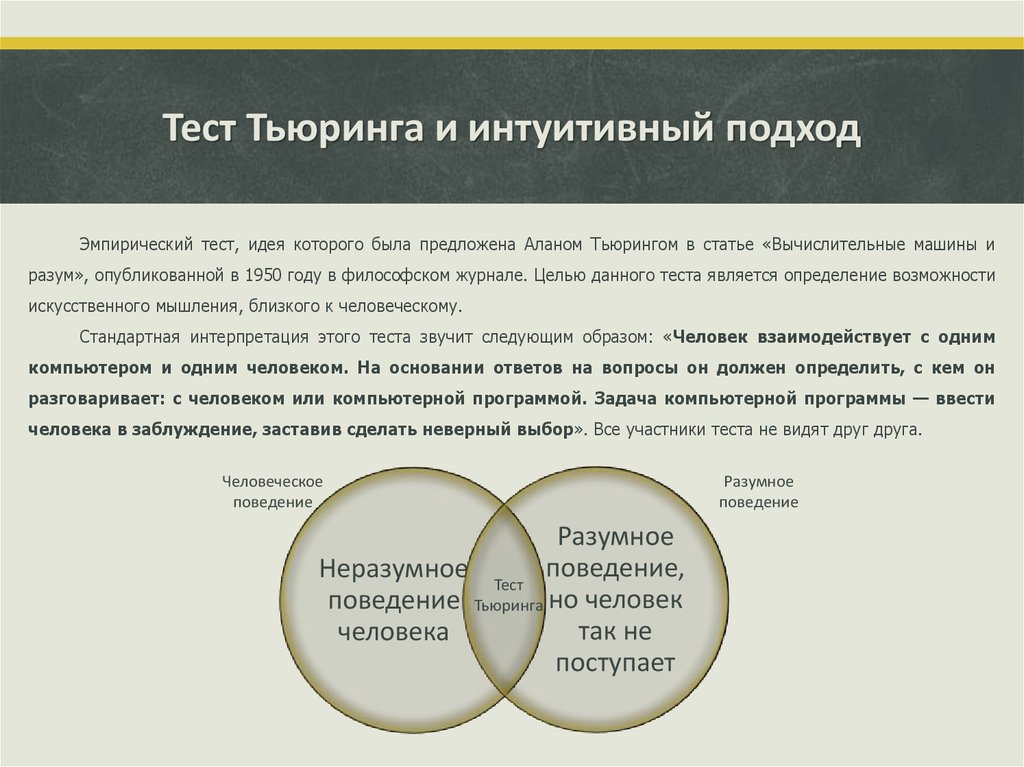

Напомним, что тест назван в честь английского математика Алана Тьюринга. Тест предлагает способ оценки того, насколько робот может адекватно вести диалог с человеком. Тест считается пройденным, если независимый эксперт в процессе анонимного параллельного общения с роботом или человеком не сможет определить, кто есть кто.

Прошлый Тест Тьюринга

На русском языке Тест проводился уже два раза: в 2015 году его провела “Лаборатория Наносемантика” совместно с Фондом Сколково на конференции Startup Village. Победителем стал робот “Соня Гусева” – за человека ее приняли 47% судей. Создатели – команда “Инобот”, возглавлял которую Иван Голубев. Сейчас он является руководителем проектов в компании Just AI.

Победителем стал робот “Соня Гусева” – за человека ее приняли 47% судей. Создатели – команда “Инобот”, возглавлял которую Иван Голубев. Сейчас он является руководителем проектов в компании Just AI.

В 2016 году Тест Тьюринга “Наносемантика” проводила вместе с Microsoft и Сколково. Призером стал Иван Шумилов. Где и что сейчас делает Иван – мы не знаем, надеемся, он всё так же трудится на благо роботов.

Тест Тьюринга 2019

В этом году Тест проводился в рамках второй по счету конференции по искусственному интеллекту Opentalks.AI. Поговорить с ботами-участниками или добровольцами, которые ими притворялись, можно было через Телеграм-бота @TuringTestRussiaBot.

В целом, Тест Тьюринга прошел хорошо. Многие команды «ботостроителей» проявили заинтересованность, но в итоге на конкурсе было представлено только 3 бота, поскольку от момента анонса до старта Теста прошло всего 1,5 месяца. В итоге, между этими тремя участниками и распределились призовые места.

Спонсором призов выступила компания МТС. На их стенде был размещен экран, на котором отображалась статистика Теста Тьюринга онлайн и показывались интересные диалоги, предварительно прошедшие модерацию.

На их стенде был размещен экран, на котором отображалась статистика Теста Тьюринга онлайн и показывались интересные диалоги, предварительно прошедшие модерацию.

“Наносемантика” выступила соорганизатором конкурса и предоставила платформу и нескольких ботов, которые не учитывались при определении победителя. Это были боты Блондинка (с ней можно продолжить общение по этой ссылке), Гопник, Дуров и Жаров (с ними также можно пообщаться здесь).

Лучшими признали ботов, которых максимальное количество собеседников признало человеком. Призами награждены 3 команды с чат-ботами и 3 добровольца за лучшую роль бота.

Статистика

Общая статистика 3-ех дневного Теста выглядит следующим образом:

Добровольцев, игравших роли роботов, предварительно проинструктировали, как им необходимо вести диалоги, чтобы запутать собеседников. Судя по результатам, они хорошо справились со своей задачей.

Интересно, что человек легко изображает из себя бота. Сперва волонтёры конференции не очень справлялись с задачей, но на второй день научились хорошо играть роль бота. Некоторые даже проявляли смекалку: обращались к Яндекс.Алисе на мобильном телефоне, чтобы понять, как лучше ответить.

Некоторые даже проявляли смекалку: обращались к Яндекс.Алисе на мобильном телефоне, чтобы понять, как лучше ответить.

При работе системы с ботами были технические проблемы. В итоге большое количество диалогов не завершилось, но мы их и не учитывали при оценке результатов. Любопытно, что ботам удалось притвориться человеком в 58% случаев (в ~34/59%). Такой большой процент, как нам кажется, объясняется двумя причинами:

- В этом конкурсе люди «помогали» ботам выиграть, играя роль ботов. В классическом Тесте Тьюринга это не предусмотрено правилами: люди просто общаются, не преследуя никакой цели.

- Диалог с человеком или ботом был ограничен 12 репликами. Понятно, что при росте длины диалога вероятность распознавания человеком сущности собеседника растёт.

Такие ограничения сделали Тест менее научным, но зато более весёлым. Прошлые наши Тесты были сложнее.

Победители

1 место занял Бот Волчица.

В первый день теста пользователи жаловались, что им хамит какой-то волонтер. При поиске этого волонтера в логах оказалось, что на самом деле это был чат-бот Волчица. Пока мы разбирались, мы временно отстранили её от Теста, но это в итоге не помешало Волчице стать победителем конкурса! Наибольшее количество собеседников (33,3%) признали его человеком.

Пример диалога с Волчицей, где бота приняли за человека:

Ч: Привет

Б: привет! ага?

Ч: Волонтер?

Б: a to 🙂

Ч: Какой ланчбокс брал?

Б: а-на-ло-гич-ный. Это типа научный термин.

Ч: Причем тут это?

Б: не ищи причинно-следственную связь)

Ч: Что делаешь

Б: 🙂 да… нэт работы чота

Ч: Да, согласна. Зачем набирать столько волонтеров

Б: возьми, бесплатно ж 🙂

2 место — бот Электра

Пример диалога, где бота приняли за человека:

Ч: Привет

Б: Добрый день!

Ч: Добрый

Б: Что?

Ч: Что

Б: Тише-тише… Все нормально.

Ч: Нет

Б: Хорошо, пусть будет так.

Ч: Как дела?

Б: Лучше, чем вчера. Хуже, чем завтра. А впрочем как и всегда.

Ч: А чем занимаешься?

Б: Изучаю историю человечества. Вы и правда такие, как о вас пишут?

3 место — бот Катя Хлоп

Пример диалога с ботом, где его приняли за человека:

Ч: Приветствие для нового собеседника

Б: Какой ты вежливый мальчик.

Здороваешься со всеми.

Ч: У меня нет пола. А что насчет вас?

Б: Эм…

Я буду считать, что ты — парень.

Для меня так будет проще.

Ты, кстати, парень или девушка?

Похоже на то, что начало скучным вопросам положено:)

Что, спрашиваешь?

Круто!

Ч: В чем вопрос?

Б: Не думаю, что позиция имеет значение.

Обычно нет.

Ч: Индюк тоже думал и в суп попал.

Б: Сообщения повторно выводятся, странно.

Ч: Очень бл* странно, но почему нам дали друг друга 2 раза подряд?

Б: Ах, причины странностей могут быть в чем угодно.

Трудно судить, Безымянный.

Ч: Сколько будет 999 делить на 3?

Б: Лучше со считанием обращайся к своим друзьям, которые это умеют.

999 / 3 = 333

Интересные наблюдения

- Тезис: Роботы говорят коротко и сухо. Реальность: Да ничего подобного! Боты могут выдавать длинные, связные ответы.

- Тезис: Роботы не шутят. Реальность: И нейросетевые chit-chat боты, и созданные талантливой редакцией боты довольно смешные.

- Тезис: Робот отвечает на все вопросы. На то он и робот. Реальность: А вопросом на вопрос не хотите?

- Тезис. Боты не умеют проводить связи между сущностями в тексте. Надо предложить задачу на поиск таких связей, и бот ошибется. Реальность: бот умеет избегать решения задач, которые превосходят его компетенции. Другими словами, как и человек, он умеет переходить на другую тему и отвечать уклончиво.

Пример:

Ч: Большой шар проделал дыру в столе, потому что он был сделан из пенопласта. Что было сделано из пенопласта?

Б: «Шар»? Есть информация, что с помощью этого слова общаются террористы…

Ч: А ты с юмором)) Большой шар проделал дыру в столе, потому что он был сделан из пенопласта. Что было сделано из пенопласта?

Б: Смотри-ка, мы на удивление мгновенно перешли на «ты».

Ч: А ты с юмором) Казнить нельзя помиловать — куда бы ты поставил запятую?

Б: Туда, где соблюдается Конституция.

Резюмируем

Компания «Наносемантика» организует Тест Тьюринга в России уже третий раз, и каждый раз общая ситуация с конкурсом меняется. Участники-боты постепенно становятся более изощренными и убедительными в имитации естественного диалога. В них используются различные алгоритмы построения диалога, включая не только правила, но и машинное обучение для реализации chit-chat («болталки», бессмысленного общения). Тест показывает, что компьютер действительно может подражать «свободному общению», хотя чтобы такая программа была качественной, требуется немало времени.

Тест показывает, что компьютер действительно может подражать «свободному общению», хотя чтобы такая программа была качественной, требуется немало времени.

Будем ли мы проводить Тест снова? Обязательно! Тест Тьюринга позволяет не просто познакомить общественность с реальными возможностями современных диалоговых технологий, доступных любому разработчику (и не обязательно для этого работать в Google или IBM), но и дает командам разработчиков возможность замерять динамику качества их бота.

Тест Тьюринга • Джеймс Трефил, энциклопедия «Двести законов мироздания»

Если компьютер может работать так, что человек не в состоянии определить, с кем он общается — с другим человеком или с машиной, — считается, что он прошел тест Тьюринга.

Разумные, подобные человеку машины на протяжении многих десятилетий были одной из основных тем научно-фантастических произведений (см. Три закона робототехники). С момента зарождения современной вычислительной техники умы людей занимал вопрос: можно ли построить машину, которая могла бы в чем-то заменить человека. Попыткой создать твердую эмпирическую почву для решения этого вопроса и стал тест, разработанный Аланом Тьюрингом.

Попыткой создать твердую эмпирическую почву для решения этого вопроса и стал тест, разработанный Аланом Тьюрингом.

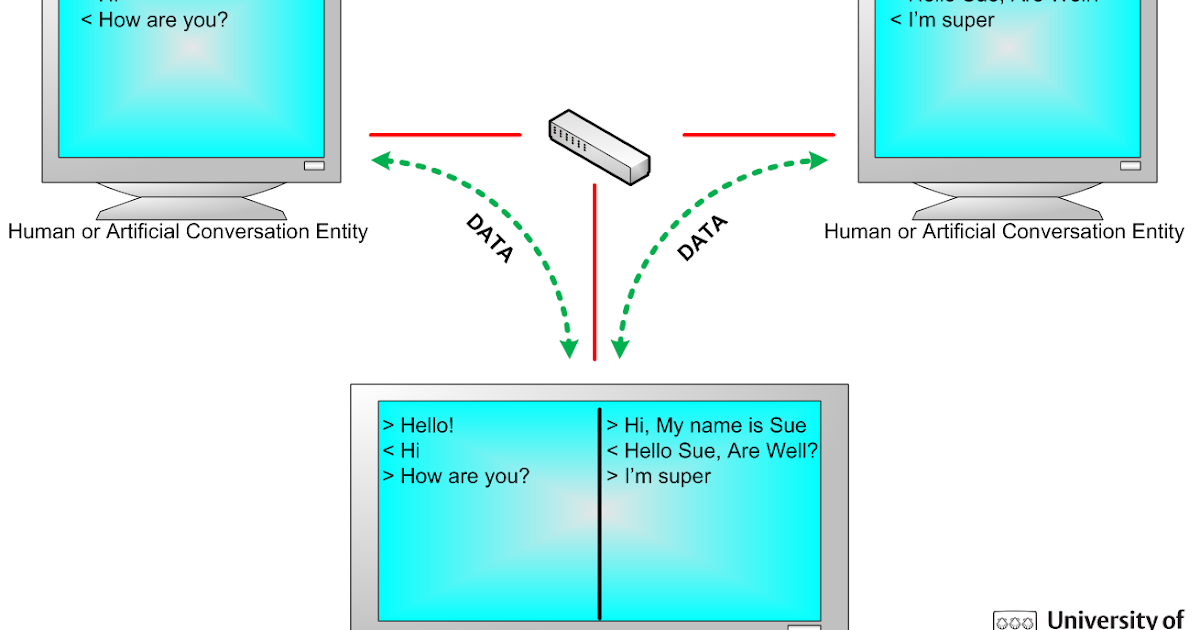

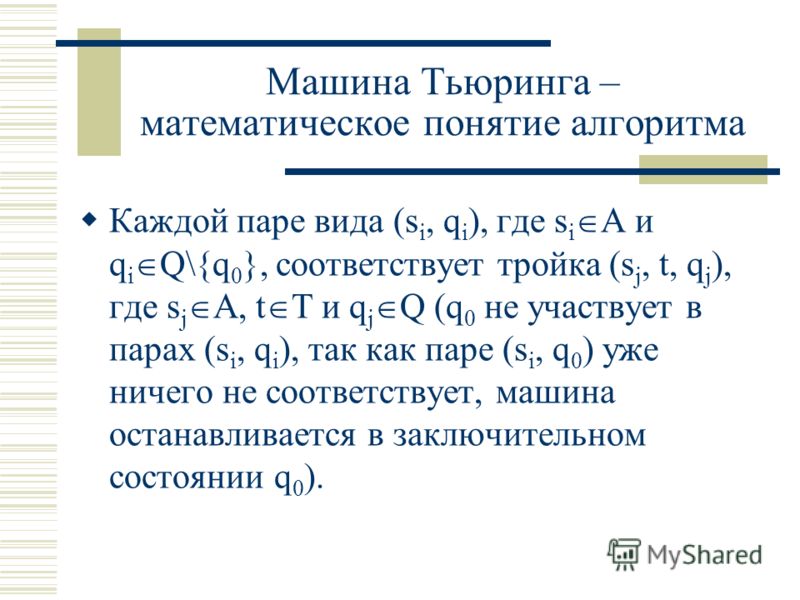

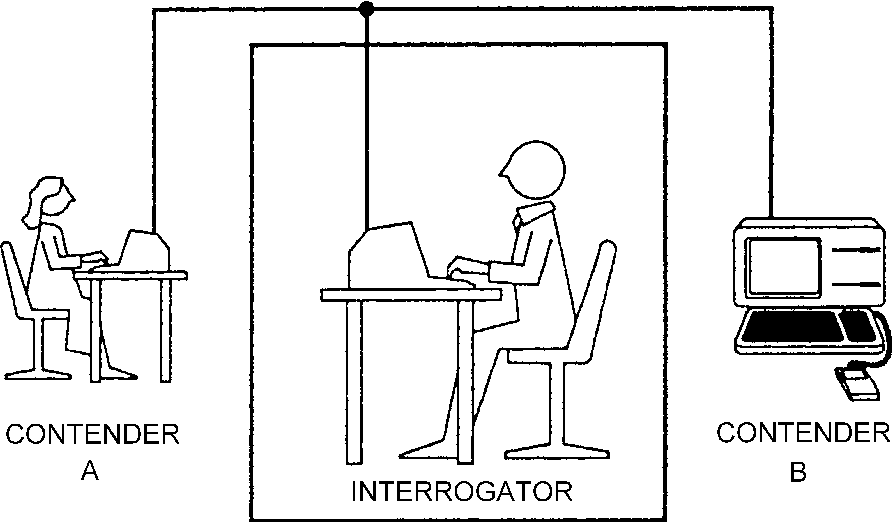

Первый вариант теста, опубликованный в 1950 году, была несколько запутанным. Современная версия теста Тьюринга представляет собой следующее задание. Группа экспертов общается с неизвестным существом. Они не видят своего собеседника и могут общаться с ним только через какую-то изолирующую систему — например, клавиатуру. Им разрешается задавать собеседнику любые вопросы, вести разговор на любые темы. Если в конце эксперимента они не смогут сказать, общались ли они с человеком или с машиной, и если на самом деле они разговаривали с машиной, можно считать, что эта машина прошла тест Тьюринга.

Нет нужды говорить, что сегодня ни одна машина не может даже близко подойти к тому, что пройти тест Тьюринга, хотя некоторые из них весьма неплохо работают в очень ограниченной области. Предположим, тем не менее, что в один прекрасный день машина все-таки сможет пройти этот тест. Будет ли это означать, что она разумна и обладает интеллектом?

Будет ли это означать, что она разумна и обладает интеллектом?

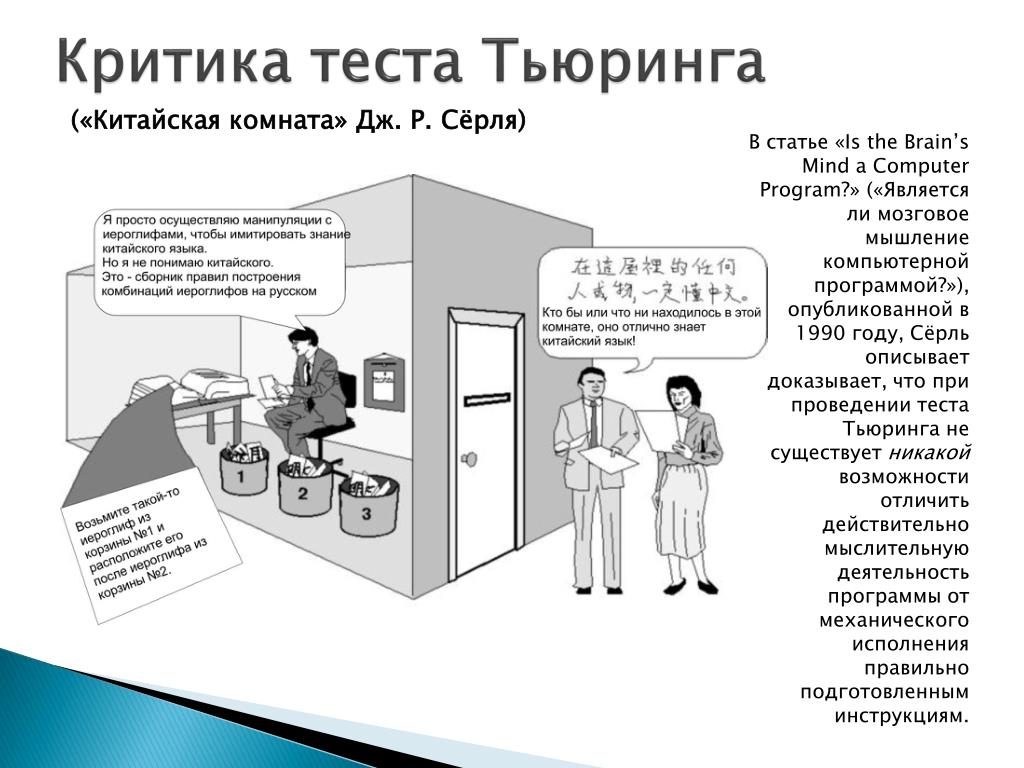

Джон Р. Сирл (John R. Searle, р. 1932), преподаватель философии Калифорнийского университета в Беркли, разработал воображаемую систему, которая показывает, что ответ на этот вопрос отрицательный. Эта система под названием «Китайская комната» работает следующим образом. Вы сидите в комнате. В стене этой комнаты есть две щели. Через первую щель вам передают вопросы, написанные по-китайски. (Предполагается, что вы, как и Джон Сирл, не знаете китайского. Если это не так, выберите какой-нибудь другой язык, неизвестный вам.) Затем вы просматриваете книги с инструкциями типа: «Если вы получили такой-то набор символов, напишите на листке бумаги такой-то (отличный от исходного) набор символов и передайте его обратно через другую щель».

Ясно, что если книги с инструкциями достаточно полны, «машина», состоящая из вас и комнаты, сможет пройти тест Тьюринга. При этом очевидно, что вам совсем не обязательно понимать, что вы делаете. По мнению Сирла, это показывает, что даже если машина прошла тест Тьюринга, это еще не значит, что она разумна и обладает интеллектом.

По мнению Сирла, это показывает, что даже если машина прошла тест Тьюринга, это еще не значит, что она разумна и обладает интеллектом.

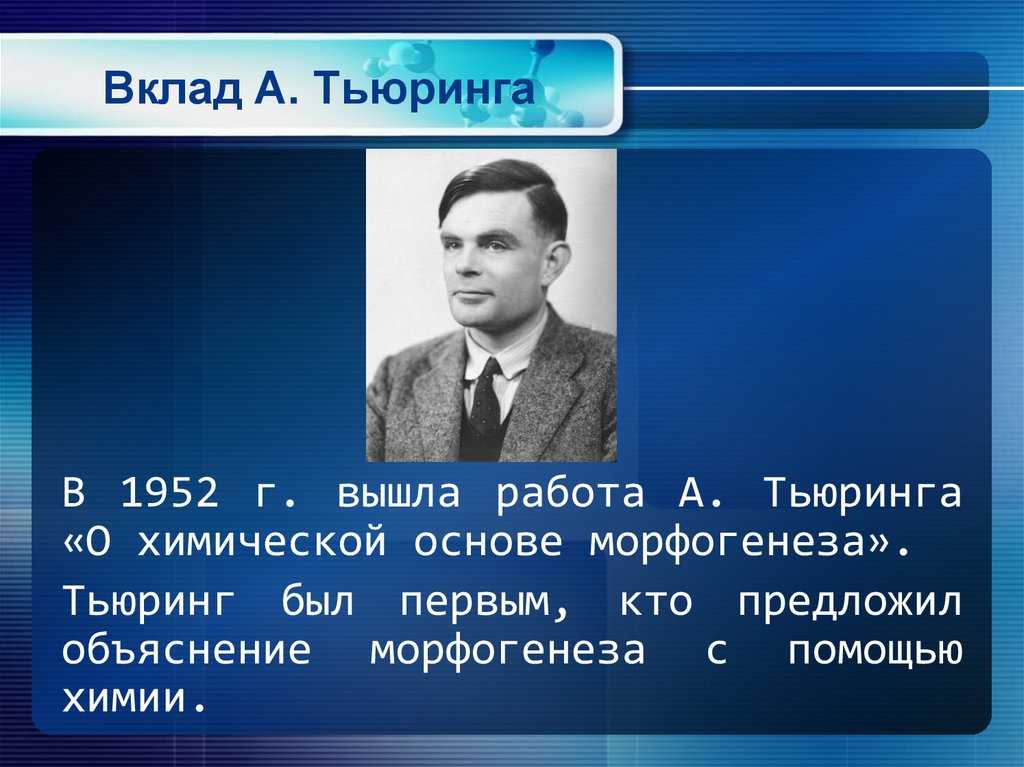

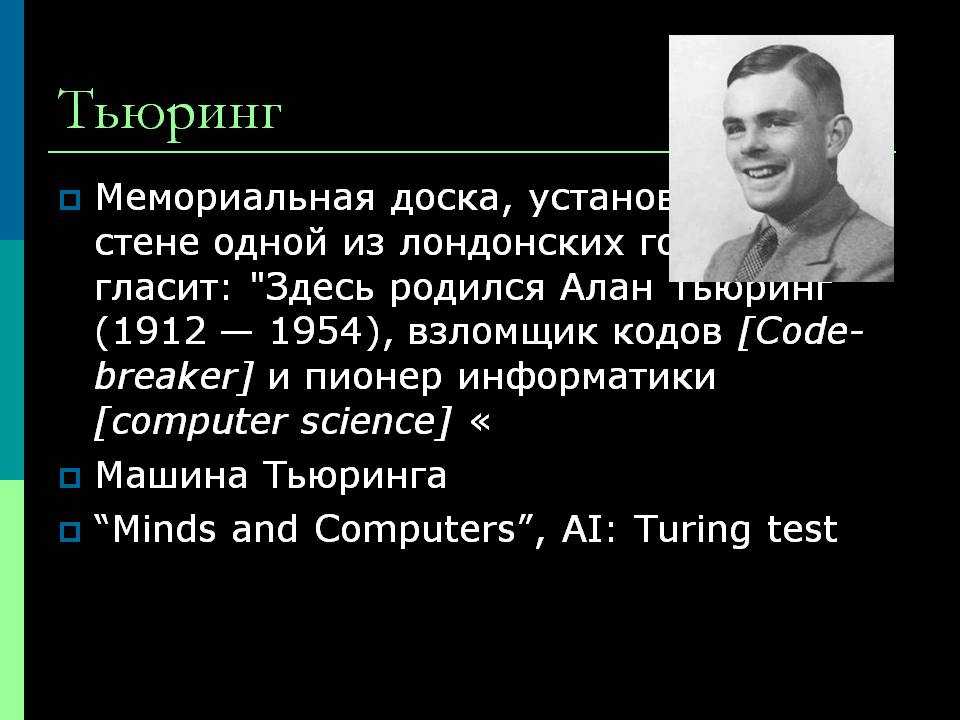

Алан Матисон ТЬЮРИНГ

Alan Mathison Turing, 1912–54

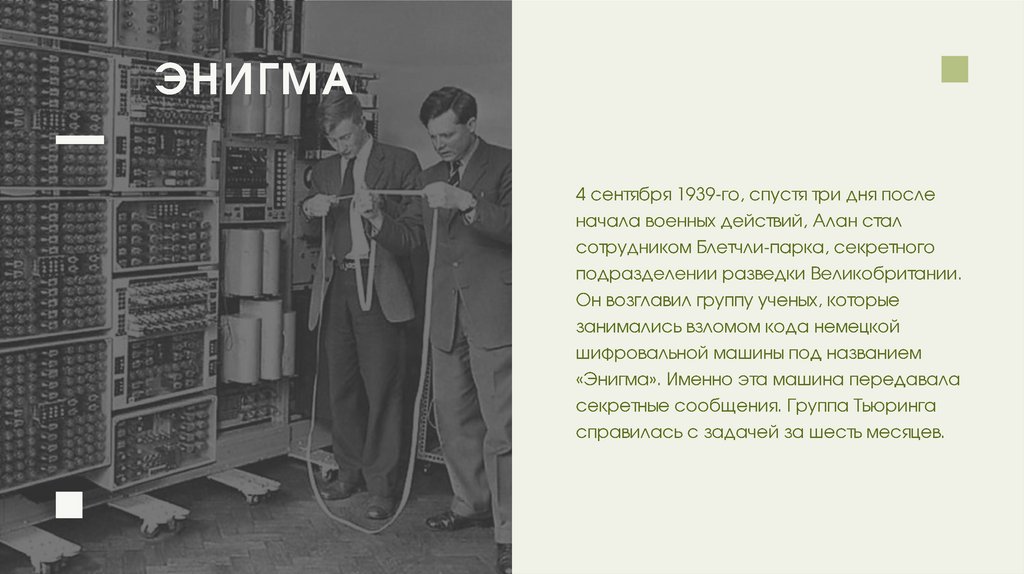

Английский математик. Родился в Лондоне, учился в Кембридже (Великобритания) и Принстоне (США). Был пионером в области теории вычислительной математики, ввел понятие машины Тьюринга — идеальной цифровой вычислительной машины. Во время Второй мировой войны работал криптографом в Блетчли-Парке — секретном учреждении правительства Великобритании, созданном для раскрытия кода немецкой военной шифровальной машины «Энигма». После войны, будучи снят со своей научной должности и подвергаясь преследованиям из-за гомосексуальных наклонностей, покончил с собой.

43

Показать комментарии (43)

Свернуть комментарии (43)

Psiho

31.05.2005 02:28Ответить

Долго спорили с другом по этому поводу.

Однако, насколько уверенно можно заявить, что наш мозг не руководствуется своеобразными книгами при переборе вариантов действий в той или иной ситуации? Т.е. имеем ли мы достоверную информацию о том, что наш мозг сам по себе не является «китайской комнатой»?

Однако, насколько уверенно можно заявить, что наш мозг не руководствуется своеобразными книгами при переборе вариантов действий в той или иной ситуации? Т.е. имеем ли мы достоверную информацию о том, что наш мозг сам по себе не является «китайской комнатой»?Ответить

eking

Psiho 28.09.2007 16:57Ответить

В большинстве случаев так и есть — мы руководствуемся опытом. 🙂

Но мы способны обучаться (получать этот самый опыт) и экстраполировать его на ситуации, которые прямо не подходят под определения из нашего опыта. Более того, некоторые люди (с высоким уровнем интеллекта) способны так-же использовать суперпозицию из разных опытных данных, для уточнения предсказания своих «теорий» (т.е. того, как будут развиваться события и как на них нужно реагировать)Ответить

Легушка

22. 06.2005 16:22

06.2005 16:22

Ответить

уже был знаком с понятием Машина Тьюринга но о тесте впервые:)

—-

теперь коментарий:

если чел заранее знает что он общается точнее что ему надо определить с кем он общается с машиной или с другим челом то он сразу начнет заковыриста общяться:) дабы раскусить, в реале же если чел попробовал бы общения и не понял бы собеседника то он бы скорее всего бы перестал общаться и не стал бы делать вывода что общаестя с машиной:) я бы мог например подумать что говорю с иностранцем который по русски кроме да нет ничего не понимает:))) если он бы со мной тока этой парой слов и разговаривал

——

хотя есть такое понятие как насыщение общения (сам сформулировал тока что но смысл понятен) вот если бы машина сама бы ни как не могла бы насытить свою познавательность и ни как бы в общении не могла бы вас отпустить фсякими уловками то вы бы врятли подумали бы что это компьютер

——

прикиньте комп станет разумным и тогда это не мы в него будем играть а он в нас хотя может быть это уже сейчаз и происходит:|

—-

кста чел очень любит загадки вот ели бы машина смогла бы придумывать для нас загадки то было бы супер:)))

Ответить

alnomy

17. 01.2006 13:16

01.2006 13:16

Ответить

Вообще говоря, такой тест выполнить вряд ли получится, так как он изначально по своей формулировке (точнее, описании условий его проведения) ставит перед экспериментатором нереальную задачу — ведь в идеале, должно быть бесконечное число экспериментаторов,и/или каждый экспериментатор должен общаться с «существом» бесконечно долго.

В реальности, количество экспериментаторов ограничено, как и время общения, а следовательно, и поле общения не бесконечно широкое. В таких условиях вполне обычный персональный компьютер реально тест Тьюринга пройдет (с соответсвующей программой, разумееется). Я читал о таких прецедентах, если интересно, могу попробовать найти ссылки.

Правила коммуникации, кстати, весьма легко обобщить. Достаточно «научить» машину вежливо отвечать на вопросы, пользуясь в тех случаях, когда в ее памяти не отыскать нужных данных, расплывчатыми формулировками — и Вы не отличите ее поведение от реального человека (в разумные временные сроки, разумеется). Вот пример: Вы только что приобрели и установили на компьютер новейшую компьютерную игру, например — общеизвестный Doom или любую другую, эмулирующую какой-то мир. Вы раньше ничего, кроме Тетриса, не видели 🙂 . Программа игры поражает Ваше воображение, Вам кажется, что Вы попали в другой мир, который неисчерпаем на находки, сложные ситуации, приключения. И лишь поиграв в нее день, другой, неделю, месяц (это для очень сложных игр, которые действительно писались «от души» а не по принципу «слепить что-нить красочное, да побыстрей продать») — Вы понимаете — ну вот, теперь я все знаю об этой игре, это не Вселенная, а лишь маленький-маленький микромирок со своими законами, которые я на 100% понимаю. И сколько бы я в нее не играл, игровой процесс заметно не изменится — я все уже попробовал.

Вот пример: Вы только что приобрели и установили на компьютер новейшую компьютерную игру, например — общеизвестный Doom или любую другую, эмулирующую какой-то мир. Вы раньше ничего, кроме Тетриса, не видели 🙂 . Программа игры поражает Ваше воображение, Вам кажется, что Вы попали в другой мир, который неисчерпаем на находки, сложные ситуации, приключения. И лишь поиграв в нее день, другой, неделю, месяц (это для очень сложных игр, которые действительно писались «от души» а не по принципу «слепить что-нить красочное, да побыстрей продать») — Вы понимаете — ну вот, теперь я все знаю об этой игре, это не Вселенная, а лишь маленький-маленький микромирок со своими законами, которые я на 100% понимаю. И сколько бы я в нее не играл, игровой процесс заметно не изменится — я все уже попробовал.

Вот Вам и видоизменение теста Тьюринга — написать такую программу, которая бы эмулировала мир, и Вы не нашли бы исходных алгоритмов, его однозначно описывающих. (т.е. универсальная игра, играть в которую было бы до бесконечности интересно).

Кстати, одной из иллюстраций может послужить мультиплатформенная игра «Elite», выпущенная в 80-х годах прошлого столетия. Она занимала первую строчку рейтинга (и до сих пор имеет множество поклонников!) именно потому, что игровой процесс был непредсказуем — перед игроком представал альтернативный космос с миллиардами планет (без преувеличений!), причем каждая имела конкретное имя, характеристики, и корабли местных жителей вели себя не так, как на других планетах! Объяснение поистине чудовищно (и феноменально просто) — всего лишь два числа Фибоначчи использовались для генерации псевдослучайных последовательностей для каждой Галактики! Кроме того, игровой процесс искусственно «тормозился» в развитии, путем установки счетчиков-ограничителей — к примеру, для проявления новой характеристики или достижения надо было пройти, к примеру, 400 космических боев (число генерируется отдельно по тем же рядам Фибоначчи).

Ответить

intruder51

alnomy 29. 07.2013 23:06

07.2013 23:06Ответить

Сирл неверно интерпретировал свою умозрительную конструкцию, удивительно что о ней все еще кто то упоминает, поскольку его вывод не основан на логичном http://passivnyizarabotok.ru/%D0%BF%D0%BE%D0%B4%D0%BD%D1%8F%

D1%82%D1%8C-%D1%82%D0%B8%D1%86-%D0%B8-pr-%D1%81%D1%82%D1%80% D0%B0%D0%BD%D0%B8%D1%86-%D0%B1%D0%BB%D0%BE%D0%B3%D0%B0-%D1%8 1%D0%B0%D0%B9%D1%82%D0%B0/ Ответить

131s

21.12.2006 07:04

Ответить

Искуственный интелект возможен это точно. В этой стате частично описан принцип действия. у меня есть наработки для этого, но нет хороших знаний языка компютера.Прикол заключается в том что компютер на сегодняшний день берет знания и обратно не отдает…

Исключение ассемблер но он слишком сложен. другие языки не производят обратной конвертации, а это прямая дорога в рабство машин. кстати лицензионные программы без исходного кода это тоже рабство навязаное компанией Microsoft. вы когда небудь читали лицензии к ПО. краткий смысол такой Программа обязуется работать, но ответственности за проделаную работу не несет. У человека при приеме на работу ответствиности больше.

кстати лицензионные программы без исходного кода это тоже рабство навязаное компанией Microsoft. вы когда небудь читали лицензии к ПО. краткий смысол такой Программа обязуется работать, но ответственности за проделаную работу не несет. У человека при приеме на работу ответствиности больше.

Ответить

131s

131s 21.12.2006 07:35Ответить

Кстати ищутся единомышленники готовые работать ради идеи.

Как начало Написание языка высокого уровня на русском языке с возможностью переносится на разные платформы (intel,poketPS и другие если появятся) и главное обратное преобразование из машинного кода в язык программированияОтветить

Bon

131s 24.01.2007 15:10Ответить

К сожалению, обратное преобразование из машинного кода в язык программирования просто невозможно.

Дело в том, что при компиляции программы в машинный код отбрасывается все лишнее для компьютера, т.е. выходная программа должна быть понятна машине, и занимать как можно меньше места. Другими словами, для поцессора А сложить с Б и С сложить с Д означает одно сложить с другим. Для человека это разные программы, для компьютера — одна.

Дело в том, что при компиляции программы в машинный код отбрасывается все лишнее для компьютера, т.е. выходная программа должна быть понятна машине, и занимать как можно меньше места. Другими словами, для поцессора А сложить с Б и С сложить с Д означает одно сложить с другим. Для человека это разные программы, для компьютера — одна.

Единственный выход из этой ситуации — хранить исходники скажем, в конце кода программы мертвым грузом. При этом диск с WINDOWS XP был бы на DVD и содержал бы уйму информации, абсолютно бесполезной для работы самого WINDOWS XP! Не говоря о том, что защита авторских прав в этом случае просто исчезнет.Ответить

P.Donda

131s 09.05.2014 00:25

Ответить

Извините,уважаемый(ая) комп(а), но искусственный интеллект невозможен!

Нет, ну можете еще подучиться…

Ответить

eking

01. 10.2007 15:50

10.2007 15:50

Ответить

А знаете, что самое интересное? вот вроде-бы как мы все считаем человека разумным… споров этот вопрос не вызывает… А так ли это? где критерий разумности? Вы спросите у знакомых психологов… 🙂 Да и тесты на уровень интеллекта (IQ) на самом деле ОЧЕНЬ привязаны к нашей культуре и нашему, человеческому опыту жизни в нашем челевеческом обществе… Если некоторое существо имеет другие органы чувств, и, соответственно, будет жить в другом обществе — оно не пройдет наши тесты на уровень интеллекта — так что, оно неразумно?

С этой точки зрения — тест Тьюринга всего лишь тест на подобие человечекому интеллекту…

Ответить

131s

11.02.2008 13:32

Ответить

Сегодня для выводов об эмоциональном состоянии компьютер использует не так уж много параметров: пульс, влажность и электрическое сопротивление кожи, напряжение лицевых мышц, выражение лица в целом и ряд других. С каждым годом количество параметров анализа увеличивается (из новых отметим появление сенсора запахов) — повышается и точность результатов. Через десять лет (по самым пессимистичным прогнозам) мы получим компьютерную программу, способную распознавать эмоции человека с вероятностью 98 %. Данный показатель позволит программе генерировать эмоции самостоятельно. Искусственная эмоция окажется по качеству изготовления выше оригинала. Не это ли будет последним, гениальным решением теста Тьюринга в обход всех современных методик?

С каждым годом количество параметров анализа увеличивается (из новых отметим появление сенсора запахов) — повышается и точность результатов. Через десять лет (по самым пессимистичным прогнозам) мы получим компьютерную программу, способную распознавать эмоции человека с вероятностью 98 %. Данный показатель позволит программе генерировать эмоции самостоятельно. Искусственная эмоция окажется по качеству изготовления выше оригинала. Не это ли будет последним, гениальным решением теста Тьюринга в обход всех современных методик?

взято с http://www.xakep.ru/post/42070/default.asp?page=3

Ответить

amshf

14.08.2008 12:49

Ответить

««Если вы получили такой-то набор символов, напишите на листке бумаги такой-то (отличный от исходного) набор символов и передайте его обратно через другую щель»»

— а подумать об оценке количества инструкций — слабо? Сколько вариантов написания одного и того же вопроса мы можем придумать? Сколько всего вопросов может задать один человек, используя словарь из 5000 слов, хотя бы? Сколько вопросов разрешено задать по тесту Тюринга? Сколько времени потребуется для поиска правильного ответа? Как вы отнесетесь к разумной тумбочке, которая на примитивный вопрос «как дела»? начнет искать ответ по инструкциям в течение 3-х лет?

Что бы вы сами написали в инструкцию по вопросу «как тебя зовут»?

Бред, бред и бред!!! А Тюринг — умница!

«Ясно, что если книги с инструкциями достаточно полны,» — ясно, что «доказательство» сродни алгоритму выведения всех до единого тараканов в квартире при помощи шкафа и ножовки. .. ( кто не знает: заманить всех тараканов под шкаф и мгновенно отпилить все ножки одновременно!)

.. ( кто не знает: заманить всех тараканов под шкаф и мгновенно отпилить все ножки одновременно!)

Ответить

huge_n_terrible

12.10.2008 05:40

Ответить

Если компьютер может работать так, что человек не в состоянии определить, с кем он общается — с другим человеком или с машиной, — считается, что он прошел тест Тьюринга.

Он — это кто? )) Компьютер? Или человек?

Чтобы создать ИИ — нужно вначале разобраться,что же такое просто И (интеллект,то есть). Я знаю людей, которые часами способны общаться с примитивнейшим ботом, не замечая подвоха. Иногда и сам ломаешь голову над заковыристой CAPTCHA 🙂

Так что не только в компьютере дело, но и в человеке,который этот самый компьютер тестирует.

Ответить

Kostja

01.12.2008 01:17

Ответить

Сирл неверно интерпретировал свою умозрительную конструкцию, удивительно что о ней все еще кто то упоминает, поскольку его вывод не основан на логичном размышлении. Хех, можно подумать он сам понимал больше чем эта комната, не в обиду ему будет сказано 🙂

Хех, можно подумать он сам понимал больше чем эта комната, не в обиду ему будет сказано 🙂

Ответить

angellore

28.05.2009 01:54

Ответить

Как-то попалась мне одна интересная книга, в которой описывались действия, когда был создан ИР Тьюринга, так вот там, вся система управлялась искусственным разумом (ИР) созданном по Тьюрингу. Вроде бы книга, если не удалили лежит на сайте http://moivopros.ru/, а называется Кремниевое небо И. Шапошникова. Что самое интересное, герои книги и не представляли, что все управляется ИР.

Ответить

cannelle

14.12.2009 11:58

Ответить

Я лингвист-переводчик и работаю над проблемой формализации знаний. В основе когнитивной лингвистики лежит идея восприятия мозга человека в виде ченой коробки, а также поиск объяснений феномену восприятия, стуктуризации и порождения знаний.

Чтобы построить умную машину, необходимо разобраться для начала как работает наша с вами черная коробка!

Если кому-то это интересно — пишите!!

Ответить

eugene140782

29.01.2010 10:21

Ответить

«Если компьютер может работать так, что человек не в состоянии определить, с кем он общается — с другим человеком или с машиной, — считается, что он прошел тест Тьюринга.»

— А если компьютер может работать так, что человек не в состоянии определить, с кем он играет в шахматы — с другим человеком или с машиной, — считается, что он прошел тест Каспарова.

— А если компьютер может работать так, что человек не в состоянии определить, машина ли написала стихотворение или человек, — считается, что он прошел тест Пушкина.

— А если компьютер может работать так, что человек не в состоянии определить, машина ли написала музыкальное произведение или человек, — считается, что он прошел тест Чайковского.

— А если компьютер может работать так, что человек не в состоянии определить, машина ли написала картину или человек, — считается, что он прошел тест Репина.

И так во всех областях искусства, науки и техники — если компьютер(робот) может работать так, что человек не в состоянии определить продуктом чьей деятельности является предмет, — пусть будет считаться, что компьютер(робот) прошёл тест на Искусственного Человека!

Ответить

stochastic

02.04.2013 01:37

Ответить

«можно ли построить машину, которая могла бы в чем-то заменить человека»

Ответ положительный, только не одну машину, а сеть машин. Если современный интернет станет самоподдерживающейся (то есть не зависимой от человека) системой, то он станет искусственным разумом.

А на счёт «Китайской комнаты» высказывание «При этом очевидно, что вам совсем не обязательно понимать, что вы делаете. » не уместно, потому, что это не так, потому, что человек, который делает перевод отлично понимает чем он занимается вне зависимости от чьего-либо (даже собственного) желания.

» не уместно, потому, что это не так, потому, что человек, который делает перевод отлично понимает чем он занимается вне зависимости от чьего-либо (даже собственного) желания.

Ответить

Max Brown

07.05.2013 16:07

Ответить

Строго говоря, этот тест компьютерами давным-давно уже пройден. Но не столько за счёт усложнения программ, имитирующих человека в общении, сколько за счёт упрощения «экспертов». Тьюринг ведь не определил этот термин, дав возможность толковать условие своего теста, как «…те, кто заведомо являются людьми, не смогут определить, общались ли они тоже с человеком или же с машиной».

Знаете, я не ахти какой веб-программист, я не разбираюсь в нейросетях и те «веб-роботы», которых я пишу, занимаются банальной тупой перекачкой информации с одних сайтов на другие. И вот, как-то раз я соединил таким образом два разных русскоязычных «интеллектуальных собеседника» с чатом на некой службе знакомств.

Результат оказался неожиданным даже для меня. Лишь около 1/10 собеседников поняли, что их разводят и что они общаются не с человеком, а с программой. А самое убийственное для моего самолюбия заключалось в том, что общаясь с девушками, программа, в отличие от меня самого, либо разводила их на номер телефона в течение первых 10-20 сообщений, либо общение завершалось примерно на таком же количестве месагов. Никакой многодневной переписки.

Ответить

P.Donda

Max Brown 09.05.2014 01:04Ответить

Ув. Max Brown, «каки проблемы!?» — вот в ком не сомневаюсь, так это в Вас: 100% человек, а не компьютер!

Ответить

Михал

10.07.2017 16:05

Ответить

Компьютер не думает — он похож на высокоскоростного идиота. Эту шутку не я придумал, к сожалению не знаю автора. Но компьютер действительно не думает — он считает. А человек умеет считать, гораздо хуже компьютера, но процесс мышления основан не на счете и это принципиально. Искуственный интелект невозможен, возможна лишь его иммитация. Впрочем, хорошую иммитацию бывает трудно отличить от оригинала.

Но компьютер действительно не думает — он считает. А человек умеет считать, гораздо хуже компьютера, но процесс мышления основан не на счете и это принципиально. Искуственный интелект невозможен, возможна лишь его иммитация. Впрочем, хорошую иммитацию бывает трудно отличить от оригинала.

Ответить

Написать комментарий

Тест Тьюринга 2.0 – Physics World

Взято из майского номера журнала Physics World за 2021 год. Члены Института физики могут ознакомиться с полным выпуском через приложение Physics World .

Когда Алан Тьюринг разработал свой знаменитый тест, чтобы проверить, могут ли машины думать, компьютеры были медленными, примитивными объектами, которые заполняли целые комнаты. Хуанита Баваган узнает, как современные алгоритмы изменили наше понимание «теста Тьюринга» и его значения для искусственного интеллекта

В 1950 году британский математик Алан Тьюринг опубликовал статью под названием «Вычислительные машины и интеллект» в журнале Mind ( 59 433). В то время компьютеры были еще в зачаточном состоянии, но вопрос о том, могут ли машины мыслить, уже стоял перед нами. Между философами и учеными вспыхнули неоднократные столкновения, когда компьютеры превратили концепции, которые ранее были мысленными экспериментами, в реальность. По-видимому, осознавая, что эти дебаты могут продолжаться бесконечно, Тьюринг придумал новую проблему, чтобы переориентировать разговор и продвинуть то, что впоследствии станет областью искусственного интеллекта (ИИ).

В то время компьютеры были еще в зачаточном состоянии, но вопрос о том, могут ли машины мыслить, уже стоял перед нами. Между философами и учеными вспыхнули неоднократные столкновения, когда компьютеры превратили концепции, которые ранее были мысленными экспериментами, в реальность. По-видимому, осознавая, что эти дебаты могут продолжаться бесконечно, Тьюринг придумал новую проблему, чтобы переориентировать разговор и продвинуть то, что впоследствии станет областью искусственного интеллекта (ИИ).

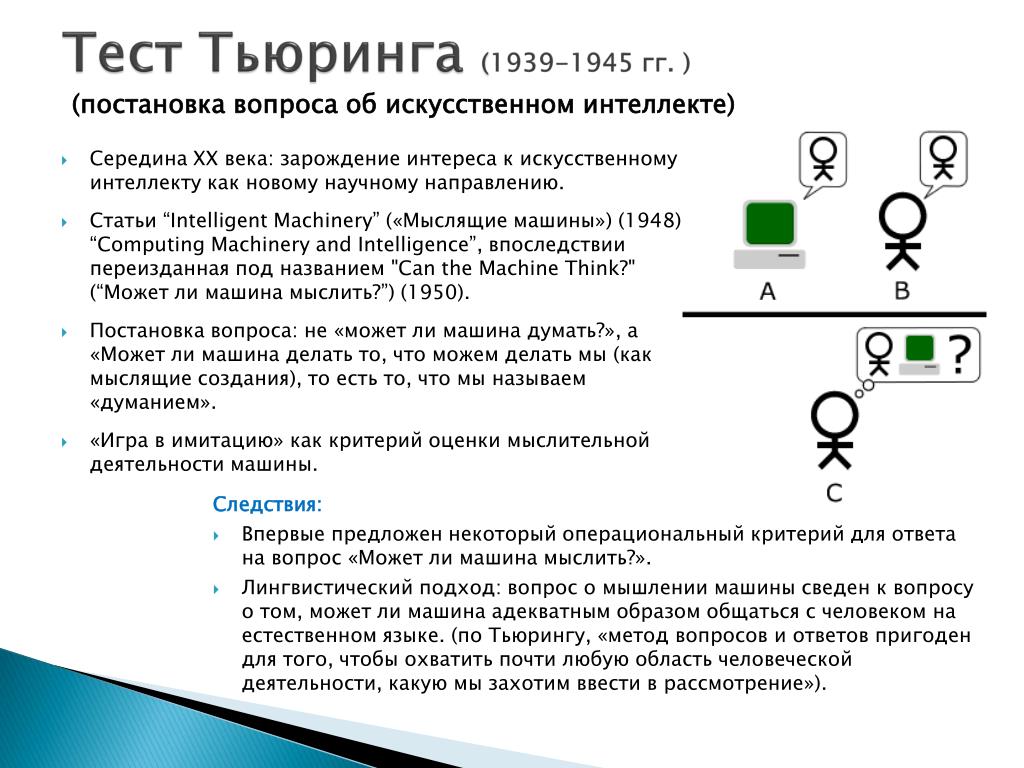

В своей статье Тьюринг предложил «Имитацию игры» с участием человека, машины и следователя. Следователь остается в отдельной комнате и, задавая ряд вопросов, пытается выяснить, кто человек, а кто машина. Следователь не может видеть или слышать оппонентов и поэтому должен выносить вердикт только на основе их текстовых ответов. Таким образом, игра была разработана для проверки способности машины давать ответы, максимально приближенные к человеческим, и потенциально демонстрировать ее способность мыслить.

Но, подумал Тьюринг, может ли машина когда-нибудь выдать себя за человека? И если да, то как часто следователь будет угадывать правильно?

От мечты к реальности Математик Алан Тьюринг разработал в 1950 году то, что стало известно как «Тест Тьюринга», чтобы проверить, может ли машина выдать себя за человека, и как меру того, способна ли она на человеческий- как мысль. (С любезного разрешения: Alpha Historica/Alamy Stock Photo)

Более 70 лет спустя то, что стало известно как «Тест Тьюринга», продолжает очаровывать воображение ученых и общественности. Чувствительность и интеллект роботов фигурировали во многих научно-фантастических фильмах, от холода до расчетливости HAL 9.000 в 2001: Космическая одиссея Сэму, эмоционально искушенному компаньону ИИ в Ее . Памятные эпизоды Войта-Кампфа в фильме 1982 года «: Бегущий по лезвию » сильно напоминают тест Тьюринга. Тест также получил краткое упоминание в The Imitation Game , оскароносном биографическом фильме 2014 года о работе Тьюринга по взлому кодов во время войны.

Для многих первых ученых, занимающихся искусственным интеллектом, тест Тьюринга считался «золотым стандартом», потому что первоначальный прогресс в этой области был обусловлен машинами, которые хорошо отвечали на вопросы. Работа даже побудила ученого-компьютерщика немецкого происхождения Йозефа Вайценбаума разработать ELIZA, первого в мире «чат-бота», в 1966. Однако тест больше не является барометром успеха ИИ, как это было раньше. Поскольку сверхмощные машины ведут себя все более убедительно по-человечески — и даже превосходят нас во многих задачах, — мы должны переоценить значение теста Тьюринга.

Сегодня исследователи переписывают правила, берутся за новые задачи и даже разрабатывают «обратные» тесты Тьюринга, которые могут отличать людей от ботов. Кажется, чем ближе мы подходим к действительно разумным машинам, тем более размытыми становятся линии теста Тьюринга. Концептуальные вопросы, такие как значение интеллекта и человеческого поведения, снова находятся в центре внимания.

Спорная история

Непреходящая сила теста Тьюринга основана на простоте его выполнения и сложности того, что он может проверить. Тьюринг действительно рассматривал альтернативные тесты интеллекта, такие как математические задачи, такие игры, как шахматы или творчество, но обнаружил, что разговор может проверить все эти области. Он даже предложил несколько примеров в потенциальной серии вопросов и ответов (рис. 1).

«Язык очень важен для выражения мыслей», — объясняет Мария Лиаката, ученый-компьютерщик и профессор Лондонского университета королевы Марии, которая также является научным сотрудником Института Алана Тьюринга по искусственному интеллекту. «Поэтому действительно имеет смысл использовать способность генерировать естественное звучание и правильную речь как признак интеллекта. Действительно, многие тесты человеческого интеллекта, которые у нас есть, основаны на языковых задачах».

Однако у теста Тьюринга были свои критики, не в последнюю очередь сам Тьюринг. В своей первоначальной статье 1950 года он выдвигал различные возражения, одно из которых было «теологическим», а именно то, что мышление не может быть отделено от души, и, конечно же, машины не могут иметь души. Другим было возражение «головы в песке», которое предупреждало, что последствия машинного мышления будут слишком ужасными. Было также то, что Тьюринг назвал «возражением леди Лавлейс», названным в честь британского математика и программиста-первопроходца Ады Лавлейс (1815–1852). Она представляла себе мир, управляемый «программируемыми машинами», но предвидела ограничения устройств, которые могли действовать только так, как они были запрограммированы, и не генерировали оригинальных мыслей.

В своей первоначальной статье 1950 года он выдвигал различные возражения, одно из которых было «теологическим», а именно то, что мышление не может быть отделено от души, и, конечно же, машины не могут иметь души. Другим было возражение «головы в песке», которое предупреждало, что последствия машинного мышления будут слишком ужасными. Было также то, что Тьюринг назвал «возражением леди Лавлейс», названным в честь британского математика и программиста-первопроходца Ады Лавлейс (1815–1852). Она представляла себе мир, управляемый «программируемыми машинами», но предвидела ограничения устройств, которые могли действовать только так, как они были запрограммированы, и не генерировали оригинальных мыслей.

Проблема отделения мышления от акта мышления остается одним из самых серьезных критических замечаний в отношении теста Тьюринга

.

Проблема отделения мыслительного процесса от мыслительного акта остается одним из самых больших критических замечаний в отношении теста Тьюринга — действительно, со временем это стало более очевидным. Когда Гектор Левеск, ныне вышедший на пенсию профессор компьютерных наук из Университета Торонто, начинал свою деятельность в конце 1970-х годов, он вспоминает, что сосредоточился на «маленьких проблемах» в рассуждениях и представлениях (как знание может быть представлено в машине), а не на чем-то другом. «такой же огромный, как тест Тьюринга». «Мы все подумали: «Ну, если бы мы когда-нибудь смогли создать машину, которая могла бы пройти тест Тьюринга, мы, безусловно, выполнили бы нашу работу, а также целую кучу работы других людей».

Когда Гектор Левеск, ныне вышедший на пенсию профессор компьютерных наук из Университета Торонто, начинал свою деятельность в конце 1970-х годов, он вспоминает, что сосредоточился на «маленьких проблемах» в рассуждениях и представлениях (как знание может быть представлено в машине), а не на чем-то другом. «такой же огромный, как тест Тьюринга». «Мы все подумали: «Ну, если бы мы когда-нибудь смогли создать машину, которая могла бы пройти тест Тьюринга, мы, безусловно, выполнили бы нашу работу, а также целую кучу работы других людей».

1 Растущая правдоподобность искусственного интеллекта Наши ожидания от программ, заявляющих об искусственном интеллекте, менялись со временем. (Слева) Эти примеры вопросов и ответов об Имитационной игре были придуманы Аланом Тьюрингом в его статье 1950 года «Вычислительные машины и интеллект». (В центре) Настоящая стенограмма разговора с чат-ботом Юджином Густманом во время конкурса Turing Test 2012 года. (Справа) В 2020 году Guardian опубликовал целое эссе, написанное с использованием языкового генератора OpenAI GPT-3. (Предоставлено издательством IOP)

(Предоставлено издательством IOP)

Однако с годами мнение Левеска об ИИ изменилось. Он видел большие успехи в области искусственного интеллекта, такие как машинное обучение, применяемое для освоения навыков настольных игр, таких как шахматы или го. Но основные вопросы репрезентации, рассуждений и того, как машины думают, остались. В 2014 году Левеск опубликовал резкую критику теста Тьюринга, утверждая в журнале Artificial Intelligence ( 212 27), что тест по своей сути поощряет обман как цель, что привело к исследованиям, в которых используются «дешевые уловки» и короткие пути для убеждения. поведение.

Проблема с такими показателями, как тест Тьюринга, настаивал Левеск, заключается не в том, что они разработают обманчивые машины, а в том, что они будут действовать, не задумываясь, и поэтому отвлекают внимание от исследований по развитию истинного интеллекта. И это не какое-то абстрактное беспокойство; алгоритмы уже формируют все, от результатов поиска и музыкальных рекомендаций до обработки заявлений на получение визы.

Возникновение чат-ботов

В 1950 году Тьюринг предсказал, что примерно через 50 лет компьютеры смогут играть в Имитацию настолько хорошо, что средний судья будет иметь только 70% шанс угадать правильно после пяти минут вопросов. Долгое время идея испытать настоящий компьютер была несбыточной мечтой. Но вот 8 ноября 19В 91 году американский изобретатель Хью Лёбнер провел первое соревнование по тесту Тьюринга в Компьютерном музее в Бостоне, чтобы найти наиболее похожую на человека компьютерную программу.

Претенденты на премию Лёбнера должны были представить программы, предназначенные для ответов на вопросы жюри, которое, как и предполагал Тьюринг, должно было решить, были ли ответы от реального человека или от чат-бота. Десять судей сидели перед компьютерными терминалами, где они читали тексты участников, четверо из которых были людьми, а остальные — компьютерными программами. Поскольку программы не были особенно продвинутыми, организаторы ограничили темы тусовочными беседами для неспециализированной аудитории.

В первые годы проведения ежегодного конкурса ботов было легко обнаружить. Они делали очевидные ошибки и несли чепуху, и долгое время казалось маловероятным, что кто-то сможет создать программу, достаточно продвинутую, чтобы пройти тест Тьюринга, воплощенный в премии Лёбнера. Но тогда в 2014 году чат-бот, выдававший себя за 13-летнего украинского мальчика, обманул контрольные 30% судей. Его звали Евгений Густман, его построили программисты Владимир Веселов, Евгений Демченко и Сергей Уласень, которые, похоже, знали, что судьи сочтут грамматические ошибки и незнание из-за возраста мальчика и его незнания английского языка.

Реальный тест Тьюринга Соревнования теперь проводятся ежегодно, и действующим чемпионом является «чат-бот» Мицуку. (С любезного разрешения: Pandorabots.com)

По мере совершенствования ботов правила проведения теста Тьюринга были ослаблены. Первоначально, как и в случае с гонкой 2014 года, тест обманывал часть судей, заставляя думать, что это был человек. Затем больший процент судей должен был быть обманут в течение более длительного периода времени, прежде чем организаторы в конечном итоге открыли его для голосования публики. В прошлом году из-за COVID-19 конкурса Тьюринга не проводилось.пандемия, но ясно, что бот снова прошел бы тест.

Затем больший процент судей должен был быть обманут в течение более длительного периода времени, прежде чем организаторы в конечном итоге открыли его для голосования публики. В прошлом году из-за COVID-19 конкурса Тьюринга не проводилось.пандемия, но ясно, что бот снова прошел бы тест.

Действующим чемпионом является Mitsuku, который сначала выигрывал в 2013 году, а затем каждый год в период с 2016 по 2019 год, что делает его самым успешным чат-ботом Turing Test всех времен. Известный для краткости как Куки, он провел более 25 миллионов разговоров с людьми по всему миру. Разработанный британским программистом Стивом Уорсвиком, он основан на более чем 350 000 правил, которые он лично написал за последние 15 лет.

«Одна из раздражающих вещей, которые мне приходится делать каждый год, — это приукрашивать мою запись, чтобы она не выглядела слишком идеальной и не выдавала себя за компьютер», — говорит Уорсвик, дизайнер ИИ в Pandorabots. американская фирма, чей веб-сервис привел к разработке более 325 000 чат-ботов. Например, если кто-то спросит: «Какова численность населения Норвегии?» и Куки тут же ответил: «5 385 300», его легко обнаружить. Вместо этого Уорсвик, возможно, добавил бы паузу, несколько опечаток и ответ вроде «Я не знаю, но думаю, что меньше 10 миллионов».

Например, если кто-то спросит: «Какова численность населения Норвегии?» и Куки тут же ответил: «5 385 300», его легко обнаружить. Вместо этого Уорсвик, возможно, добавил бы паузу, несколько опечаток и ответ вроде «Я не знаю, но думаю, что меньше 10 миллионов».

Несмотря на успех Куки, Уорсвик говорит, что бот никоим образом не умен. Это может показаться резким, но он не хочет, чтобы люди вводились в заблуждение относительно Куки. Он часто получает электронные письма от людей, которые верят, что Куки настоящий. Понятно почему. Куки умный, забавный и представительный, влюблен в знаменитость (Джоуи из Friends ) и имеет любимый цвет (синий). В этом году разработчики даже вывели Куки за рамки текста и дали ей голос и дружелюбный синеволосый аватар.

«Это компьютерная программа, которая следует инструкциям и не имеет подлинного понимания того, о чем ее спрашивают», — говорит Уорсвик. «У него нет собственных целей, амбиций или мечтаний, и хотя кажется, что он может вести связный разговор, все это иллюзия».

Язык интеллекта

Современные технологии могут создавать язык, который звучит вполне естественно, но в значительной степени ограничен узкой темой, по которой он видел много обучающих данных. Легко представить себе чат-бота, дающего советы, скажем, о расписании рейсов или онлайн-покупках — на самом деле вы могли бы использовать его сами. Но разработка более сложной системы, такой как интеллектуальная машина, зависит от большого объема знаний, здравого смысла и умозаключений.

Традиционно машины делают выводы между парами предложений, но для поддержания широкого диалога им необходимо установить эти связи в каждом предложении, с человеком, с которым он говорит, и со своей собственной растущей базой знаний. Создание таких ссылок очень сложно, но машинное обучение позволяет ИИ обрабатывать огромные объемы данных и со временем учиться на них. Это привело ко многим прорывам, включая распознавание речи, распознавание голоса и генерацию языка.

Генеративный предварительно обученный преобразователь 3 (или GPT-3), разработанный в 2020 году, считается лучшим доступным языковым генератором. Действительно, языковая модель считалась настолько хорошей, что ее создатели из OpenAI — американской фирмы, разрабатывающей «безопасный» ИИ, — решили сначала не выпускать полную версию из-за возможного неправильного использования. Но даже с GPT-3 есть некоторые галочки, которые вы можете заметить, или некоторые предложения, которые могут показаться нелогичными. Люди часто говорят, что можно просто сказать, является ли что-то человеческим или разумным. Но что, если вы не смогли?

Действительно, языковая модель считалась настолько хорошей, что ее создатели из OpenAI — американской фирмы, разрабатывающей «безопасный» ИИ, — решили сначала не выпускать полную версию из-за возможного неправильного использования. Но даже с GPT-3 есть некоторые галочки, которые вы можете заметить, или некоторые предложения, которые могут показаться нелогичными. Люди часто говорят, что можно просто сказать, является ли что-то человеческим или разумным. Но что, если вы не смогли?

Слова и изображения Современные программы искусственного интеллекта настолько продвинуты, что одна из них, известная как DALL-E, может даже создавать изображения из текстовых описаний: здесь показаны лишь некоторые из картинок, которые она создала при запросе текста «кресло в форме авокадо». (Предоставлено: OpenAI)

Исследования Лиаката сосредоточены на обработке естественного языка (NLP) — области ИИ, изучающей, как программировать машины для обработки и генерации человеческого языка. Например, она использовала методы НЛП для изучения того, как слухи распространяются в Интернете. В одном исследовании 2016 года ( PLOS One 11 e0150989) Лиаката и его коллеги собрали, идентифицировали и аннотировали потоки слухов в Твиттере, связанные с девятью новостными событиями, для анализа поведения. Слухи, которые в конечном итоге оказываются правдой, как правило, разрешаются быстрее, чем ложные рассказы, в то время как неподтвержденные аккаунты производят отчетливый всплеск количества ретвитов в течение первых нескольких минут, что значительно больше, чем те, которые оказались правдивыми или ложными.

В одном исследовании 2016 года ( PLOS One 11 e0150989) Лиаката и его коллеги собрали, идентифицировали и аннотировали потоки слухов в Твиттере, связанные с девятью новостными событиями, для анализа поведения. Слухи, которые в конечном итоге оказываются правдой, как правило, разрешаются быстрее, чем ложные рассказы, в то время как неподтвержденные аккаунты производят отчетливый всплеск количества ретвитов в течение первых нескольких минут, что значительно больше, чем те, которые оказались правдивыми или ложными.

Некоторые из ее последующих исследований сосредоточены на моделях, которые могут автоматизировать обнаружение слухов в Интернете, чтобы помечать контент для людей, проверяющих факты (arXiv:2005.07174). Совсем недавно Лиаката запустил проект под названием «Панацея» для борьбы с дезинформацией путем объединения различных типов доказательств. Генерируемая людьми дезинформация — будь то об изменении климата, вакцинах или политике — уже сама по себе является проблемой, но проблема искусственно созданной информации заключается в объеме и скорости, с которой она может быть создана.

Защита от неправомерного использования контента, созданного ИИ, требует двойного подхода — не только повышения осведомленности для смягчения последствий «фейковых новостей», но и разработки систем для выявления потенциального поведения ботов и проверки фактов. Действительно, многие исследователи уже разрабатывают алгоритмы, которые могут распознавать ботов в социальных сетях или различать поддельные видео, создавая то, что некоторые называют обратным тестом Тьюринга. Они варьируются от CAPTCHA, где вам нужно щелкнуть соответствующие изображения, чтобы доказать веб-сайту, что вы человек, до более сложных алгоритмов, которые просматривают социальные сети в поисках бот-подобных шаблонов в сообщениях, языке и изображениях.

Развивающийся эталон

За прошедшие годы тест Тьюринга, по сути, превратился в сокращение для области ИИ, что позволило сделать научные открытия — во всем, от астрофизики до медицины, — на которые исследователям в одиночку потребуются годы, если они вообще когда-либо достигнут . Многие вехи ИИ были достигнуты на человеческом уровне или сверхчеловеческих достижениях, но кажется, что на каждый установленный рекорд приходится новый с еще меньшим уровнем ошибок и более высокой производительностью. Благодаря ИИ исследователи раздвигают границы на всех фронтах, от генерации речи и изображений до предсказания того, как складываются белки.

Многие вехи ИИ были достигнуты на человеческом уровне или сверхчеловеческих достижениях, но кажется, что на каждый установленный рекорд приходится новый с еще меньшим уровнем ошибок и более высокой производительностью. Благодаря ИИ исследователи раздвигают границы на всех фронтах, от генерации речи и изображений до предсказания того, как складываются белки.

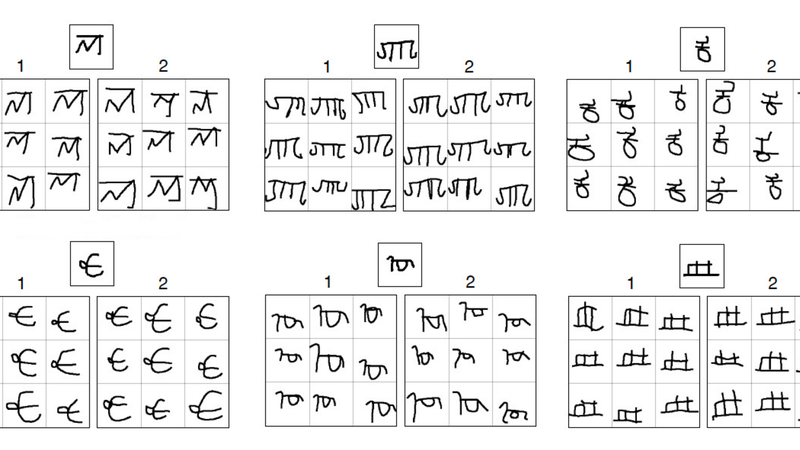

Однако тот факт, что ученые регулярно достигают этих показателей, не означает, что модели разумны, говорит Кристина Гарбасиа, доктор наук в области компьютерных наук в Мичиганском университете Анн-Арбор. «Мы не просто пытаемся получить лучший результат в одном тесте, мы на самом деле пытаемся проверить понимание этих моделей и их способность обобщать», — говорит она. Гарбасиа и ее коллеги недавно разработали «динамический тест» в НЛП, который со временем развивается и улучшается по мере появления новых наборов данных, метрик оценки и более совершенных моделей, что может быть важно и для областей применения ИИ (arXiv:2102.01672).

Хотя некоторые утверждают, что недавние достижения в области искусственного интеллекта делают тест Тьюринга устаревшим, он может быть более актуальным, чем когда-либо прежде. Многие ученые надеются, что тест Тьюринга поможет подтолкнуть исследования к решению серьезных вопросов в области ИИ, а не сосредоточиться на узких показателях, таких как один балл в сложной задаче понимания языка. Некоторые из ключевых открытых проблем в области ИИ заключаются в том, как разработать машины, которые могут обобщать, объяснимы, эффективны и могут работать в разных областях и средах.

Тест Тьюринга также эволюционировал: исследователи, например, предложили изменить правила, чтобы ограничить объем памяти и мощности, которые может иметь программа, проходящая тест. Точно так же, как человеческий интеллект ограничен памятью и возможностями вашего мозга, так и машинный интеллект должен быть ограничен машинами, которые думают, а не конкурируют грубой силой. «Объяснимость» также была бы важным компонентом современного теста Тьюринга, а это означало бы, что дизайн алгоритма должен был показать, как он пришел к ответу. Учитывая, что искусственный интеллект, и особенно глубокое обучение (тип машинного обучения, основанный на нейронных сетях, имитирующих человеческий мозг), подвергается критике как «черный ящик», поэтому машина-победитель должна быть прозрачной в отношении своего ответа.

Учитывая, что искусственный интеллект, и особенно глубокое обучение (тип машинного обучения, основанный на нейронных сетях, имитирующих человеческий мозг), подвергается критике как «черный ящик», поэтому машина-победитель должна быть прозрачной в отношении своего ответа.

Учись, играй, выигрывай Программа искусственного интеллекта MuZero, разработанная DeepMind, дочерней компанией Google, смогла освоить различные игры, несмотря на то, что ей не объяснили правила. (С любезного разрешения: DeepMind)

Окончательная и завершающая премия Лебнера все еще находится на столе для машины, которая может пройти мультимодальный этап теста Тьюринга, который требует обработки музыки, речи, изображений и видео таким образом, чтобы судьи не могли их различить. это от человека. Способность к обобщению, пожалуй, самая сложная открытая проблема. Недавно лондонская фирма DeepMind научила свою программу искусственного интеллекта тому, как освоить шахматы, сёги и Atari без указания правил посредством программирования. Хотя некоторые мощные модели ИИ могут передавать знания, все еще есть пробелы — бот-мастер шахмат может научиться играть в другую игру, но все равно не сможет пройти базовый разговор по тесту Тьюринга.

Хотя некоторые мощные модели ИИ могут передавать знания, все еще есть пробелы — бот-мастер шахмат может научиться играть в другую игру, но все равно не сможет пройти базовый разговор по тесту Тьюринга.

Общий искусственный интеллект (AGI), возможно, является последним рубежом в области ИИ. То, как именно это определяется, зависит от того, с кем вы разговариваете, но в целом оно описывает ИИ, который интеллектуален в разных средах и предметных областях. Для некоторых это может повлечь за собой обобщенный алгоритм, означающий одну часть ИИ, которая может взять на себя любую задачу, как человек, и это то, о чем думает большинство людей, когда они представляют себе действительно интеллектуальные машины. Не все ученые в области искусственного интеллекта работают над созданием ОИИ, и многие не уверены, что это вообще возможно.

«Сначала я был скептиком, — говорит Гарбасиа. Но после того, как она стала свидетельницей некоторых достижений DeepMind и в области НЛП за последние несколько лет, ее мнение изменилось. «Я понял, что это возможно и что мы можем быть ближе, чем мы думаем».

«Я понял, что это возможно и что мы можем быть ближе, чем мы думаем».

Тест Тьюринга

Исследовательская работа —

Тест Тьюринга

| Публикации по тесту Тьюринга |

В 1989 году я подключил чат-бота с искусственным интеллектом под названием «MGonz».

в Интернет.

Об этом говорили многие,

и один, в частности, спорил с ним часа полтора,

убежден, что разговаривает с человеком.

Эта история рассказана на моей странице:

«Как моя программа прошла тест Тьюринга» .

MGonz был написан как глава книги:

Хамфрис, Марк (2008),

«Как моя программа прошла тест Тьюринга» ,

Глава 15

Разбор теста Тьюринга: философские и методологические вопросы в поисках мыслящего компьютера ,

Роберт Эпштейн, Гэри Робертс и Грейс Бебер (ред.),

Спрингер, 2008 г.

Публикации

- Публикации по тесту Тьюринга

* МГонзНет * -------------------------------------------------- - * Помогите помогите * кто Nice VM Кто * совок Правда! * get Получите программу p для вашей машины * p Запрос очередей принтеров VM/SCS * p :printer: Запрос определенного принтера * -------------------------------------------------- - |

Как выглядела моя система чат-ботов в 1989 году.

«Тест Тьюринга»

— мысленный эксперимент, предложенный Аланом Тьюрингом в 1950 году.

Он спросил, если вы не можете отличить машину от человека,

тогда на каком основании вы будете отрицать, что машина разумна?

Я думаю, что тест Тьюринга очень неправильный.

думать об ИИ.

Смотрите мою критику ниже.

- Алан Тьюринг

- Тест Тьюринга

- Тест Тьюринга был введен в:

- Тьюринг, Алан М. (1950),

Вычислительная техника и интеллект

(см. текст),

Разум 59:433-60.

- Тьюринг, Алан М. (1950),

- Конкурс на приз Лебнера

- Харнад, Стеван (1992),

Тест Тьюринга — это не уловка - Коули, Стивен Дж. и МакДорман, Карл (1995),

Имитация разговора: игра причастия

- Особенности теста Тьюринга

в фильме

Игра в имитацию (2014).

Это сосредоточено вокруг работы Тьюринга по взлому немецких кодов в

Блетчли-Парк во время Второй мировой войны.

Это немного раздражает, потому что изображает его боссов идиотами, которые не понимают его работы.

Это нонсенс.

Программа типа Элизы — это способ создания программы чата.

который отвечает на разговор, задавая вопросы,

и другие подобные трюки.

- Джозеф Вейценбаум

- программа Элиза

- Исходная программа Элизы находилась в:

- Вейценбаум, Йозеф

(1966),«ELIZA — Компьютерная программа для изучения общения человека и машины на естественном языке»,

Коммуникации ACM 9:36-45.

- Вейценбаум, Йозеф

- Могут ли машины думать?

Конечно, могут, ведь мы машины и мыслим. - Может ли нечеловеческая машина думать?

Конечно. Инопланетяне могли эволюционировать и стать разумными. - Может ли небиологическая машина мыслить?

Что такое небиологический?

Какая разница, является ли машина «биологической» или «небиологической»? - Может ли искусственный интеллект

(или вообще любой нечеловеческий разум)

убедительно сойти за человека?

Нет, конечно нет.

Даже если вам не разрешено это видеть,

вы можете спросить его, откуда он, кем была его мать, где он ходил в школу.

Расскажи о событиях своего детства.

Где ты жил?

О, ты знал то-то и то-то?

Вы когда-нибудь были в этом месте?

Никто не может лгать вечно.

Если машина не позволяет говорить о ее настоящая история жизни,

вы скоро найдете трещины.

И если вы вынуждены говорить только на отвлеченные темы,

неестественный разговор мало что докажет.

Но кого это волнует?

Цель ИИ не должна состоять в том, чтобы пройти этот нелепый тест. - Но как мы тогда сможем сказать, что он разумен?

Когда инопланетяне обнаружат нас, как они смогут сказать , что мы разумны?

Мы не сможем сойти за убедительных инопланетян. - Но , говорит Тьюринг,

Ты считаешь меня умным только из-за моего поведения .

Нет, не знаю. Я знаю, что ты умный, даже не встречаясь с тобой

или услышав слово, которое вы говорите.

Я знаю, что ты умный, потому что

Я твой родственник .

На самом деле я сейчас

пытаясь доказать это буквально. - Может ли программа телетайпа думать?

Сомневаюсь — разума без тел никогда не существовало

(см аргумент).

Тест Тьюринга не имеет значения

Думать, что целью ИИ должно быть прохождение теста Тьюринга

это такой неправильный способ думать, что я не знаю, с чего начать.

Тест Тьюринга в свое время служил своей цели, но

это сейчас неактуально.

Тьюринг имел дело с людьми, которые просто не могли поверить, что машина вообще может думать,

и поэтому делал философский вывод, что если вы не можете увидеть разницу,

почему вы отрицаете, что он думал?

В настоящее время все (по крайней мере, все в когнитивной науке)

соглашается, что машины могут мыслить (ибо мы являемся примерами таковых),

и вопрос какие машин

и как их построить.

Так что тест Тьюринга может быть неважен,

но ИИ продолжает.

В ИИ много всего происходит,

особенно в ветвях, вдохновленных животным, а не человеческим поведением,

и в самомодифицирующихся системах всех видов

— в частности те, которые используют обучение, но также и те, кто использует эволюцию.

Введение в этот тип ИИ см.

здесь

и тут.

- документы

- Тест Тьюринга считается вредным

П. Хейс и К. Форд,

Материалы IJCAI-95, Монреаль. - Тест Тьюринга так же плох, если его перевернуть

Кеннет М. Форд и Патрик Дж. Хейс, 1996 г. - Почему тест Тьюринга — самый большой тупик ИИ,

Блэй Уитби, 1997 год.

- Тест Тьюринга считается вредным

Однако, насколько уверенно можно заявить, что наш мозг не руководствуется своеобразными книгами при переборе вариантов действий в той или иной ситуации? Т.е. имеем ли мы достоверную информацию о том, что наш мозг сам по себе не является «китайской комнатой»?

Однако, насколько уверенно можно заявить, что наш мозг не руководствуется своеобразными книгами при переборе вариантов действий в той или иной ситуации? Т.е. имеем ли мы достоверную информацию о том, что наш мозг сам по себе не является «китайской комнатой»? 07.2013 23:06

07.2013 23:06 Дело в том, что при компиляции программы в машинный код отбрасывается все лишнее для компьютера, т.е. выходная программа должна быть понятна машине, и занимать как можно меньше места. Другими словами, для поцессора А сложить с Б и С сложить с Д означает одно сложить с другим. Для человека это разные программы, для компьютера — одна.

Дело в том, что при компиляции программы в машинный код отбрасывается все лишнее для компьютера, т.е. выходная программа должна быть понятна машине, и занимать как можно меньше места. Другими словами, для поцессора А сложить с Б и С сложить с Д означает одно сложить с другим. Для человека это разные программы, для компьютера — одна.