Содержание

Что на самом деле проверяет Тест Тьюринга / Хабр

Некоторое время назад я предложил сыграть в Тест Тьюринга с моим ботом Мишей. Кто попробовал, тот знает, что игрок-робот определяется элементарно. Кто не пробовал, может прочитать об этом в первом же комментарии под той статьей.

Теперь настал момент устроить разбор полетов, рассказать об устройстве бота и сделать выводы.

Правила игры

Правила игры были перечислены в предыдущей статье, повторю здесь, чтобы вам и мне не бегать по ссылкам.

- Каждый подключившийся к боту участник может взять на себя роль игрока, отвечающего на вопросы, или судьи, эти вопросы задающего.

- Если участник решил быть судьей, то бот случайным образом подбирает ему игрока – либо среди людей-игроков, либо подключает робота. То есть в игре отвечающий всегда один, и судья задает вопросы только ему.

- Если участник решил быть игроком, то бот аналогично ищет ему в пару участника-судью.

- Игра поделена на туры по 5 вопросов. По окончанию каждого тура судья принимает решение, с кем он общается, с человеком или с машиной — на этом игра заканчивается. Если он не может определиться, то может начать следующий тур или сдаться, прекратив игру.

- Робот играет роль маленького мальчика Миши пяти лет. Чтобы судье не облегчать задачу, человеку-игроку рекомендуется тоже отвечать от имени Миши.

С момента запуска до момента написания статьи было сыграно 256 игр (немного странно, но факт).

Из них закончились с явным результатом, то есть обе стороны сыграли до конца очередного тура (больше одного тура никто не играл) и судья принял решение — 115 игр

- решение «робот» — 74

- решение «человек»- 41

Ошибочных решений было 26, из них:

- решение «робот» (на самом деле человек) — 15

- решение «человек» (на самом деле робот) — 11

Как видите, чаще человека принимали за робота, чем робота за человека.

В итоге робот правильно определялся в (74-15)/115 = 51% игр, а робота приняли за человека в 11/115 = 9.5% игр, то есть можно уверенно сказать, что Миша-бот тест не прошел.

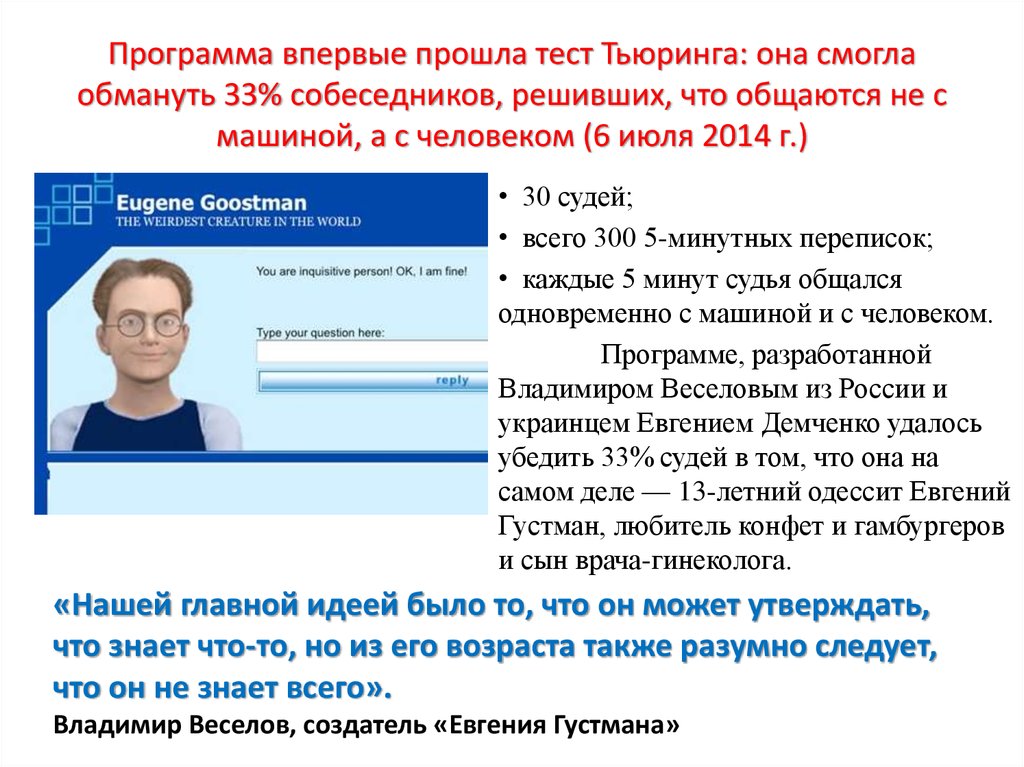

Для сравнения, на конкурсе в 2012 году в 29% из 150 бесед судьи приняли бота-одессита Женю Густмана за человека, а в 2014-ом — 33% судей по результатам 300 бесед.

Что под капотом

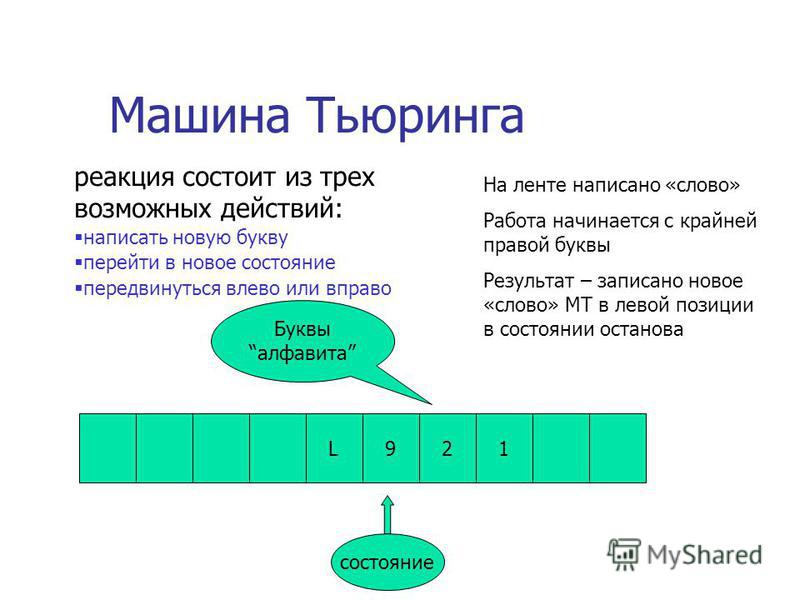

Бот написан на Python и по большому счету состоит из трех модулей:

- собственно бот с движком игры

- диспетчер роботов

- робот

Основной алгоритм игры содержится в классе Game, который хранит id участников и реализует простую машину состояний:

- Начало игры

- Ждём вопроса от судьи

- Ждём ответа от игрока

- Ждём решения от судьи

- Игра закончена

На переходах между состояниями бот передает вопросы судьи к игроку, ответы от игрока судье. Передается только по одному сообщению и бот становится в следующее состояние, поэтому если кто пытался спросить или ответить двумя, видел, что бот это не позволяет делать.

Передается только по одному сообщению и бот становится в следующее состояние, поэтому если кто пытался спросить или ответить двумя, видел, что бот это не позволяет делать.

Когда бот получает ответ от робота, он передает ее не сразу, а с задержкой времени — это не сразу появилось, я ее добавил по замечанию galqiwi, спасибо.

Каждое изменение состояния сохраняется в БД SQLite, на случай непредвиденных ситуаций — пропадания электросети, перезагрузки операционки или попросту хозяину бота (мне, то бишь) захотелось остановить его и что-то переделать. При новом запуске бот загружает из БД сохраненные игры, и игра продолжается.

Далее, есть две очереди ожидания — судей, ожидающих игроков, и игроков, ожидающих судей. Когда участник начинает новую игру, просматривается соответствующая очередь, есть ли ему партнёр. Если нет, то сам участник ставится в очередь.

В отдельном потоке живёт диспетчер роботов. Он периодически просматривает очередь судей, ожидающих игроков, и создаёт для них экземпляр робота. В нём специально сделана задержка, чтобы робот не всегда успевал перехватить судью и человек-игрок тоже имел шанс подключиться к игре. В диспетчере заложена возможность создавать различные варианты роботов, нужно просто зарегистрировать их классы. Но пока реализован всего один.

В нём специально сделана задержка, чтобы робот не всегда успевал перехватить судью и человек-игрок тоже имел шанс подключиться к игре. В диспетчере заложена возможность создавать различные варианты роботов, нужно просто зарегистрировать их классы. Но пока реализован всего один.

И, наконец, модуль робота. Но прежде, чем рассказать о внутренностях робота, расскажу о базе вопросов и ответов, с которой он работает.

Сначала я набил такой текстовый файл:

T: Миша T: Меня зовут Миша Q: Как тебя зовут? Q: Как тебя звать? Q: Как вас зовут? Q: Как твое имя? Q: Ты кто? T: Конечно Q: Ты настоящий мальчик? T: Я мальчик T: Конечно Q: Ты человек? Q: Ты настоящий человек? Q: Ты живой человек? T: Я мальчик T: Нет, конечно Q: Ты компьютер? Q: Ты машина?

… ну и так далее. Затем отдельной утилиткой считал их в базу данных — таблица вопросов, таблица ответов, связь между ними многие-ко-многим. Плюс табличка использованных слов с линками на вопросы. Причем слова сохранялись не в оригинальной форме, а в нормальной и с синонимами. Нормальная форма слова определялась по pymorphy2 от kmike, а синонимы к ней искались из словаря YARN, предварительно сконвертированного из XML в SQLite — словарь занял всего 22 мегабайта, а сколько удовольствия…

Причем слова сохранялись не в оригинальной форме, а в нормальной и с синонимами. Нормальная форма слова определялась по pymorphy2 от kmike, а синонимы к ней искались из словаря YARN, предварительно сконвертированного из XML в SQLite — словарь занял всего 22 мегабайта, а сколько удовольствия…

Метод поиска синонимов к нормальной форме слова:

def normalSynonyms(self,orig): r = self.morph.parse(orig) res = [] for parse in r: word = parse.normal_form syns = self.yarn.synonyms(word) for g in syns: words = self.yarn.words(syns[g]) res = res + words return res

Теперь собственно робот. Вообще от робота требуется реализация лишь одного метода

getAnswer(self, text)

, то есть просто получение ответа на заданный вопрос. Если роботу надо хранить предыдущие вопросы и контекст, какие-то дополнительные действия, то он делает это сам. Поскольку на каждую игру создается свой экземпляр класса робота, то контексты из разных чатов не пересекаются.

Поскольку на каждую игру создается свой экземпляр класса робота, то контексты из разных чатов не пересекаются.

Поиск нужного ответа мой робот делает в два этапа:

- Проверяет, известен ли ему вопрос. Если известен, то выбирает один из подходящих ответов.

- Иначе разбивает вопрос на токены-слова, также находит им синонимы в нормальной форме, отбирает среди известных вопросов те, в которых есть найденные слова, и уже из найденных вопросов выбирает наиболее вероятные по количеству совпадений. И выдает подходящий ответ.

Как видите, робот не умеет «думать» над ответом, всё, что он может ответить — это одна из заготовок, подходящая или неподходящая для очередного вопроса. Вы скажете, что это фигня, а я скажу — читайте классиков.

«Словарь Вильяма Шекспира, по подсчёту исследователей, составляет 12000 слов. Словарь негра из людоедского племени «Мумбо-Юмбо» составляет 300 слов. Эллочка Щукина легко и свободно обходилась тридцатью.«

Правда, классики не упомянули, обладала ли Эллочка Щукина интеллектом, пусть даже искусственным. Наверное, и сами не были уверены.

Наверное, и сами не были уверены.

Выбор персонажа

Как видите, простота алгоритма робота не позволяет ему поддерживать сложные диалоги, поэтому встал вопрос, какого человека, точнее персонажа, сможет имитировать робот.

Нужен был персонаж, который может отвечать уклончиво, путаться в ответах, не стесняется повторяться. Но, с другой стороны, который был бы похож на человека. Так как я не обеспечил робота какими-либо книжными знаниями и не снабдил его возможностью искать в интернете, то его персонаж не мог быть взрослым образованным человеком. Его область знаний должна была ограничиваться минимумом, только тем, что он сам мог видеть и понять.

Было соблазнительно выбрать Людоедку Эллочку — а что, минимум словарного и фразеологического запаса, любой заготовленный ответ годится практически на любой вопрос. Но это было не интересно, хотелось усложнить задачу.

Поэтому выбор пал на роль ребенка. Возраст у ребенка должен быть такой, чтобы позволять ему связно говорить, понимать — это где-то от двух-трех лет. Он должен знать какие-то базовые вещи, но еще плохо работать с абстракциями. Например, я не вкладывал в робот калькулятор, поэтому и робот в роли ребенка не сможет посчитать «один плюс два» — так что отпадает школьный возраст и близкий к нему. Так что я взял средний возраст в пять лет, когда дети достаточно самоуверенны, но толком еще ничего не знают.

Он должен знать какие-то базовые вещи, но еще плохо работать с абстракциями. Например, я не вкладывал в робот калькулятор, поэтому и робот в роли ребенка не сможет посчитать «один плюс два» — так что отпадает школьный возраст и близкий к нему. Так что я взял средний возраст в пять лет, когда дети достаточно самоуверенны, но толком еще ничего не знают.

Однако, выбрав для робота роль ребенка, я понимал, что следствием этого выбора будет необходимость, чтобы все игроки-люди так же играли роль маленького мальчика. Практика показала, что мало кто это всерьез воспринял, отвечали как хотели, только что телефонами не обменивались.

Железо

Осталось показать тот суперкомпьютер, на котором живет Миша-бот:

Это Raspberry Pi 3. На хвосте к нему висит SSD, прицеплен на всякий случай, если понадобится активная работа с базами данных, но в самом роботе не используется.

Собственно, это всё о роботе Мише.

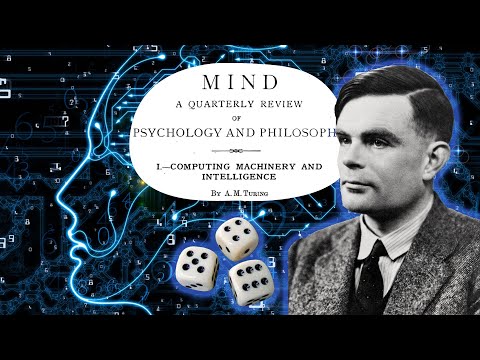

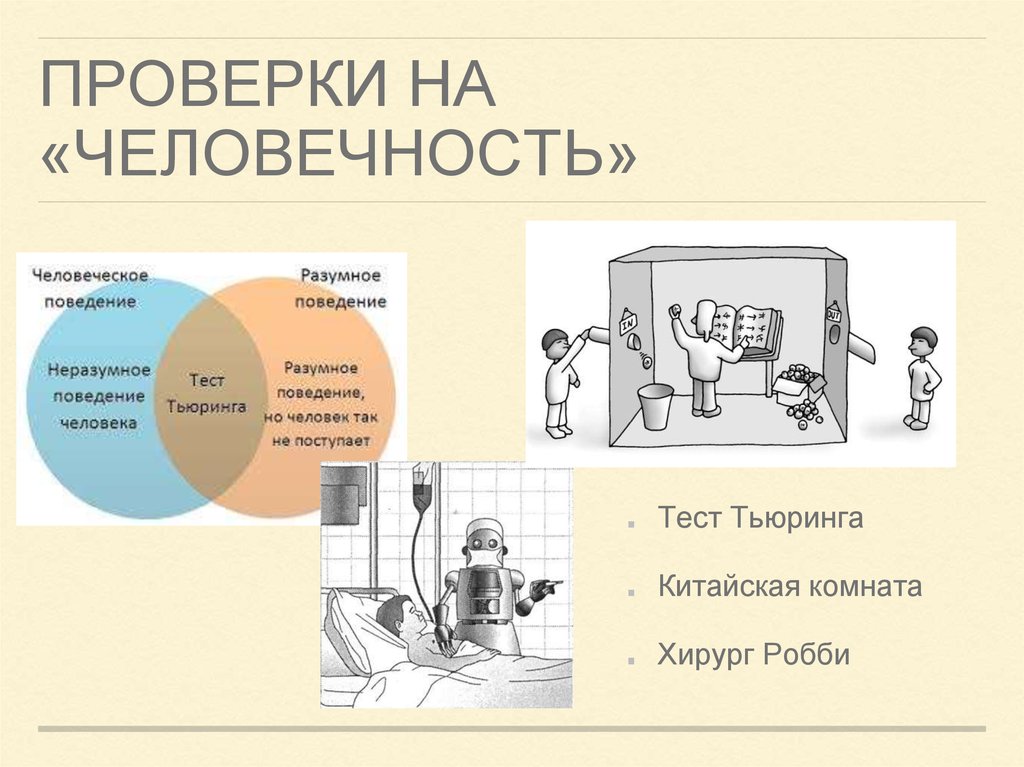

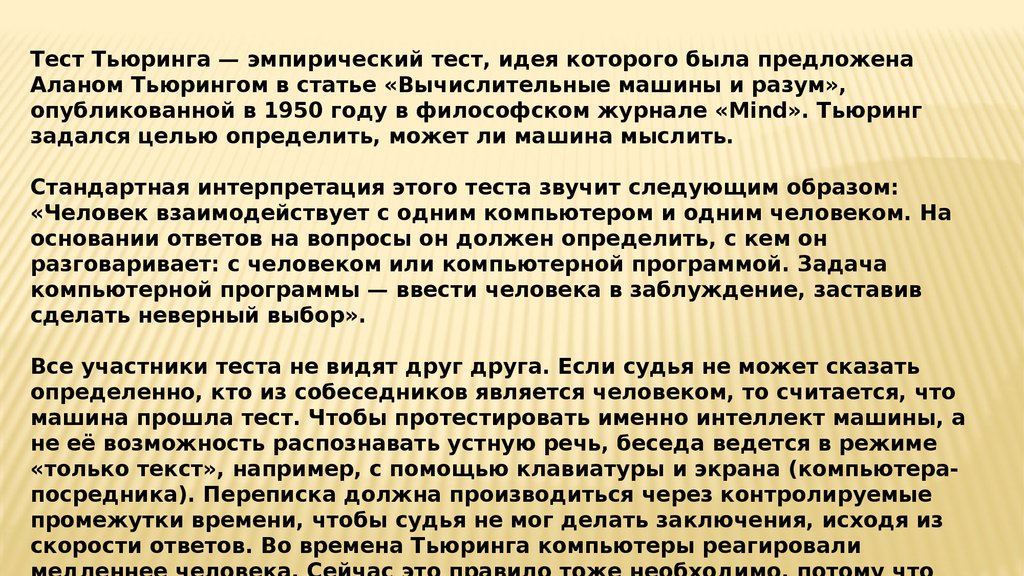

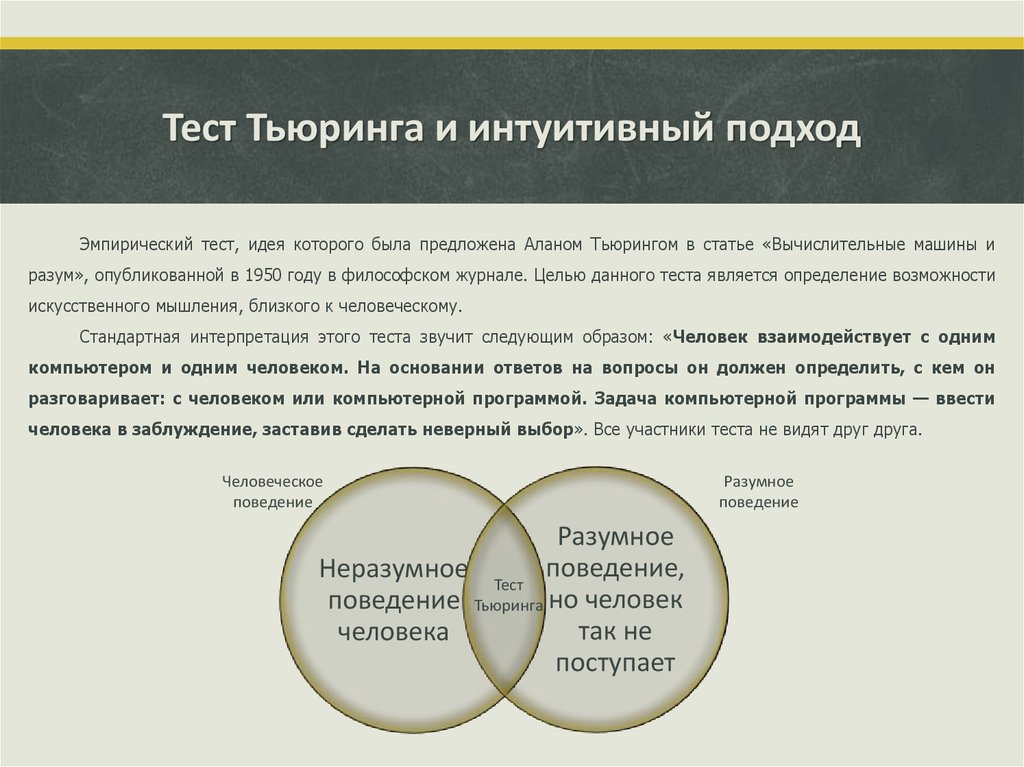

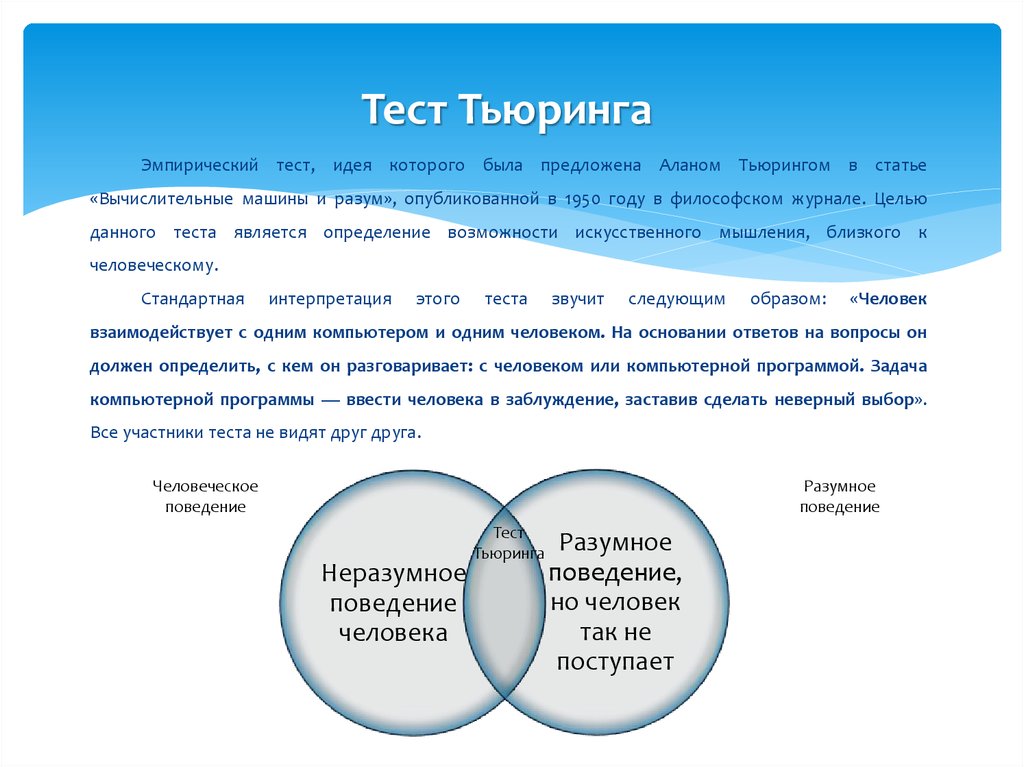

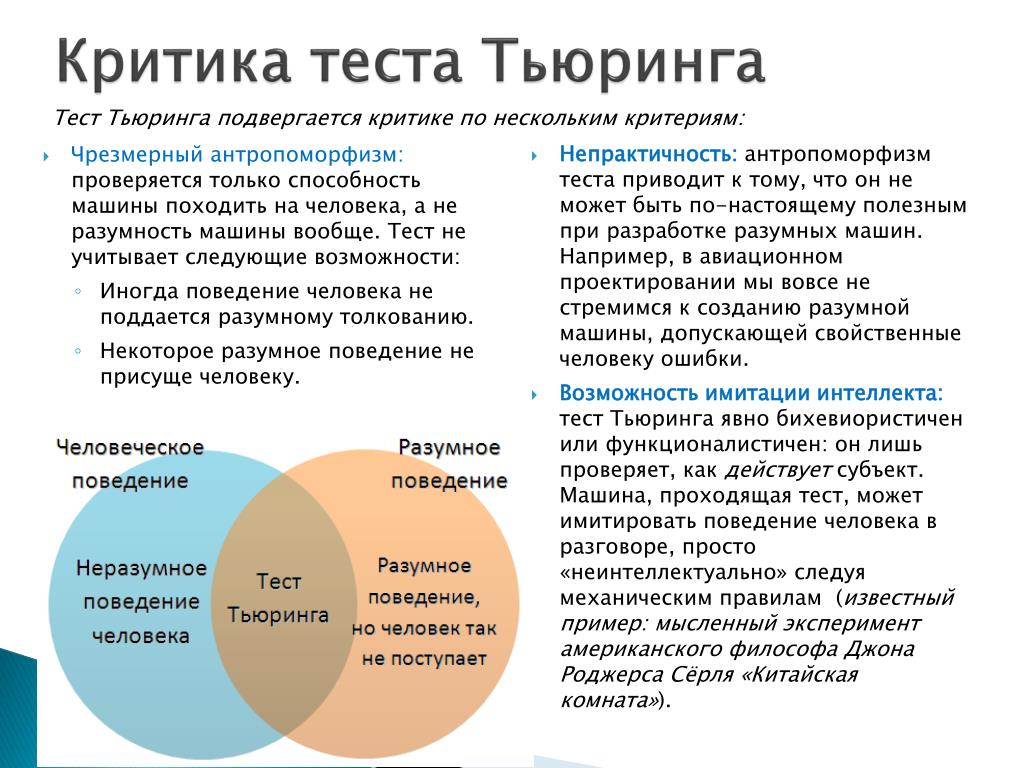

За почти семьдесят лет с момента написания статьи Тесту Тьюринга нашли определение, что это бихевиористский подход, сравнительный анализ на основе поведения — поведение человека сравнивается с поведением машины. Оно, конечно, так, однако я хочу обратить внимание на другие аспекты, на которые Алан Тьюринг, похоже, не обратил внимания.

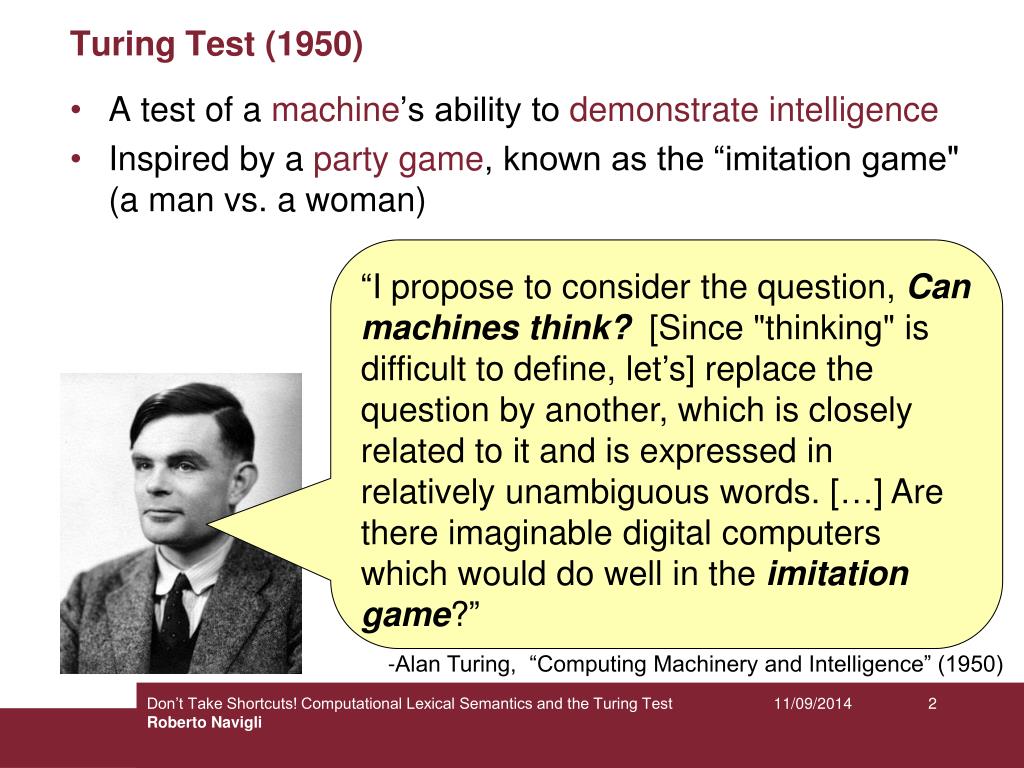

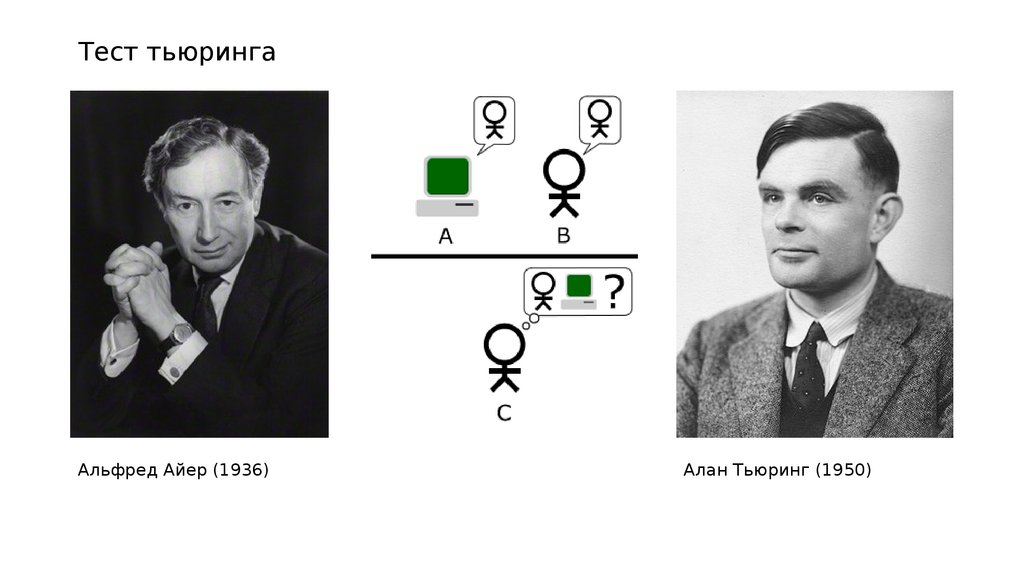

Итак, то, что мы называем Тестом Тьюринга, было описано Тьюрингом в статье «Может ли машина мыслить?» (первая публикация называлась «Computing Machinery and Intelligence») и названо автором «игрой в имитацию». Если исходить лишь из её названия, можно было полагать, что игроки действительно должны имитировать поведение друг друга — человек притворяется машиной, а машина человеком. Но по замыслу Тьюринга в игре лишь машина должна подражать человеку.

Цитата:

«Можно было бы заметить, что при «игре в имитацию» не исключена возможность того, что простое подражание поведению человека не окажется для машины наилучшей стратегией. Такой случай возможен, но я не думаю, чтобы он привел нас к чему-нибудь существенно новому. Во всяком случае никто не пытался исследовать теорию нашей игры в этом направлении, и мы будем считать, что наилучшая стратегия для машины состоит в том, чтобы давать ответы, которые в соответствующей обстановке дал бы человек.«

Такой случай возможен, но я не думаю, чтобы он привел нас к чему-нибудь существенно новому. Во всяком случае никто не пытался исследовать теорию нашей игры в этом направлении, и мы будем считать, что наилучшая стратегия для машины состоит в том, чтобы давать ответы, которые в соответствующей обстановке дал бы человек.«

Человеку-игроку же Тьюринг отвел роль не активного участника, который может запутывать судью своими сознательно неправильными ответами, а лишь роль образца, контрольного примера, с которым задающий вопросы будет сравнивать ответы машины. От человека ожидается естественное поведение, типичное для человека.

Цитата:

«Если бы человек попытался притвориться машиной, то, очевидно, вид у него был бы весьма жалкий. Он сразу выдал бы себя медлительностью и неточностью при подсчетах.«

Замечу, что Тьюринг не говорит, что человек не должен имитировать машину. Хотя человек может, если хочет, имитировать машину, другого человека или инопланетянина, вообще заниматься чем угодно, даже игнорировать вопросы или задавать встречные, но цель игры — получить ответ на вопрос «может ли [данная] машина мыслить?», поэтому человек здесь лишь помогает задающему вопросы в достижении цели, а не препятствует ему.

Из ответов бота:

«2018-10-23 13:01:53,385 186 Player2Judge Стал бы человек вести себя как машина, чтобы обмануть другого человека?«

Подытожу — два игрока, машина и человек:

- машина имитирует человека как можно лучше — это ее основная цель в игре

- человек ведет себя естественно

Лучшее качество машины

Разобравшись с правилами, следующим шагом предположим, что мы хотим построить мыслящую машину. Как она должна работать, точнее, как она должна проявлять свои мысленные способности?

Мы можем воспользоваться представлениями о мыслящей машине из кинофантастики. Подходит ли Джарвис из «Железного человека» под это определение? R2-D2 или C-3PO из «Звездных войн»? Дэвид из «A.I.»? Долорес Абернати из «Мира Дикого Запада»? Афина из «Земли будущего»? ВАЛЛ-И из одноименного мультфильма? Вроде про каждого из них интуитивно можно сказать, что это мыслящие машины, потому что они ведут себя осмысленно, и не похоже, что они действуют по какой-то относительно простой программе.

Теперь проведем мысленный эксперимент — зададимся вопросом, какая из перечисленных машин скорее всего пройдет Тест Тьюринга? По условиям игры для этого достаточно ответить на вопрос, какая из машин сможет сымитировать человека так, что по его ответам его нельзя будет отличить от настоящего человека.

Очевидно, сразу отпадут роботы R2-D2 и ВАЛЛ-И, как не умеющие разговаривать на человеческом языке, и их я предлагаю далее не рассматривать.

Также очевидно, что в претендентах на победу окажутся машины, специально сконструированные для такой имитации — из нашего списка это Долорес и Афина. Причем если Долорес (я имею в виду её в статусе «девы в беде» в начале первого сезона) сама считает себя человеком, то Афина, напротив, вполне чётко понимает, что она робот, но может исполнить, при необходимости, имитацию на достаточно высоком уровне.

Что же касается Джарвиса, C-3PO и Дэвида, то они тоже осознают, что они машины, и не имеют ни склонности, ни способности скрывать это от людей. Задающему вопросы не придется подлавливать их на каких-то каверзных вопросах, они и сами во всем признаются.

Задающему вопросы не придется подлавливать их на каких-то каверзных вопросах, они и сами во всем признаются.

И вот к чему мы пришли. Оказалось, что Тест Тьюринга пройдет машина, которая:

- либо будет считать себя человеком и иметь соответствующие человеку воспоминания, знания и жизненный опыт;

- либо, зная о своем происхождении, будет лгать в ответах на вопросы, имитируя человека.

То есть Тест Тьюринга проверяет способность машины не к мышлению, а ко лжи — к сознательной или к самообману. Печалька.

В защиту Тьюринга надо сказать, что перед ним не стояла задача оценки моральных качеств машины. Он искал даже не ответ, а способ получения ответа на вопрос «может ли машина мыслить?», и это в то время (1950), когда задача создания искусственного интеллекта казалась скорее фантастикой, чем теоретической наукой. На этом фоне «игра в имитацию» была значительным шагом вперёд в понимании, как оценивать искусственный интеллект.

Цитата:

«… нас интересует не то, будут ли все цифровые вычислительные машины хорошо играть в имитацию, и не то, будут ли хорошо играть в эту игру те вычислительные машины, которыми мы располагаем в настоящее время; вопрос заключается в том, существуют ли воображаемые вычислительные машины, которые могли бы играть хорошо.«

Тест Тьюринга устарел. Настало время изменить критерии оценки способностей ИИ

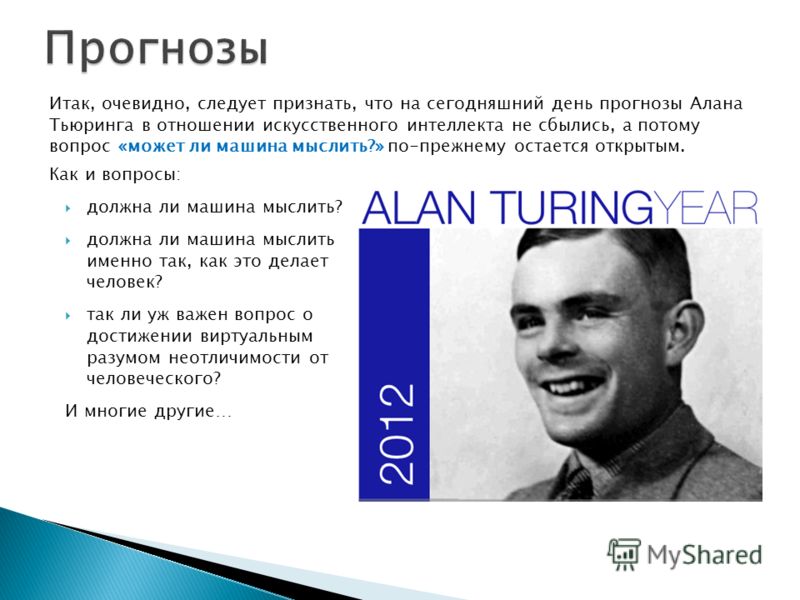

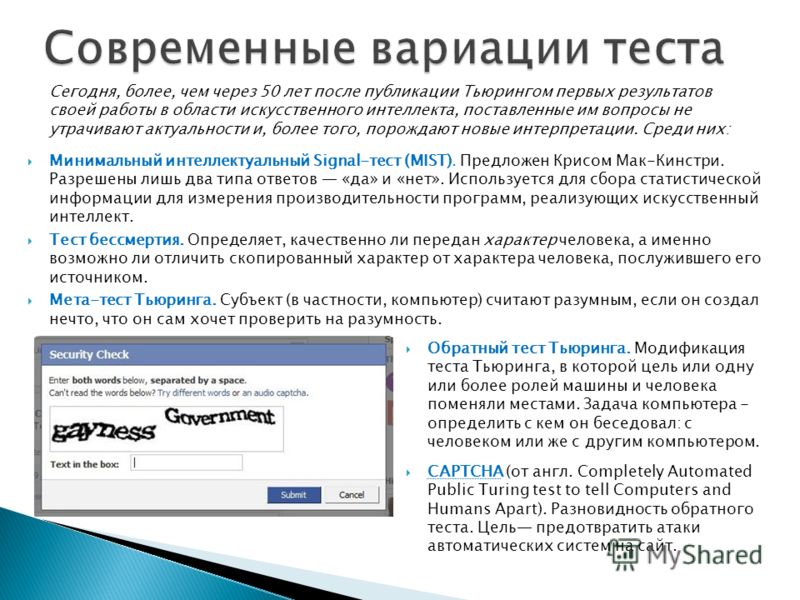

Этот год знаменует 70-летнюю годовщину с момента публикации концепции Алана Тьюринга, позволяющей оценить способность машины поддерживать человеческий разговор. Ученый предсказал, что к 2020 году шансы отличить ИИ от человека в игре-имитации, где оценщику будет неизвестен отвечающий, будут менее 70%.

Однако 20 лет спустя эта цель так и не была достигнута. Главный научный специалист компании Amazon Рохит Прасад считает, что этот критерий уже не актуален. Предназначение ИИ изменилось. Теперь его задача — помогать человеку и расширять границы его возможностей.

Дарья Сидорова

После своего появления тест Тьюринга стал путеводной звездой сферы ИИ. В 1960-х и 1970-х годах были разработаны первые чат-боты ELIZA и PARRY, главной целью которых было пройти этот тест. В 2014 году чат-боту Евгению Густману (Eugene Goostman) удалось справиться с испытанием — 33% судей приняли его за человека. Однако даже в то время некоторые посчитали тест устаревшим, а минимальный порог прохождения в 30% слишком произвольным числом.

Тем не менее эта концепция все еще привлекает внимание общественности. Разработчики языковой модели GPT-3 (Generative Pre-trained Transformer 3) из OpenAI уже заявляют, что она может справиться с тестом. Журналисты и прочие наблюдатели также часто интересуются, будет ли виртуальный помощник Alexa от Amazon проходить это испытание. И хотя это один из способов измерить интеллект системы, актуально ли использовать его сегодня?

Преимущества и недостатки теста Тьюринга

Вернемся к тому времени, когда Тьюринг впервые изложил свою диссертацию. В 1950 году первый коммерческий компьютер еще не был продан, материалы по волоконно-оптическим кабелям будут опубликованы лишь спустя четыре года, а сфера ИИ формально не существовала — это произошло лишь в 1956 году.

В 1950 году первый коммерческий компьютер еще не был продан, материалы по волоконно-оптическим кабелям будут опубликованы лишь спустя четыре года, а сфера ИИ формально не существовала — это произошло лишь в 1956 году.

У современного смартфона в 100 тысяч раз больше вычислительной мощности, чем у космического корабля «Аполлон-11», который совершил первую посадку на Луну. Кроме того, благодаря облачным технологиям и высокоскоростному подключению сейчас ИИ может принимать решения на основе огромного количества данных в считанные секунды.

И хотя первоначальная концепция Тьюринга по-прежнему остается вдохновляющей, его тест все же ограничен эпохой, в которую он был представлен. На это указывают несколько факторов:

- Он не учитывает одни из самых эффективных функций современных ИИ — высокую скорость вычисления и поиска информации. Чтобы обмануть человека и пройти этот тест, ИИ нужно делать паузы, когда он отвечает на сложные вопросы.

Например, «Каков кубический корень из 3434756?» или «Какое расстояние между Сиэтлом и Бостоном?». В действительности ИИ уже знает эти ответы и готов предоставить их мгновенно. Добавление паузы, которая позволить его очеловечить, — не лучший способ применения его возможностей.

Например, «Каков кубический корень из 3434756?» или «Какое расстояние между Сиэтлом и Бостоном?». В действительности ИИ уже знает эти ответы и готов предоставить их мгновенно. Добавление паузы, которая позволить его очеловечить, — не лучший способ применения его возможностей. - Он ограничен текстом. Тест не учитывает растущую способность ИИ использовать сенсоры, чтобы слышать, видеть и чувствовать внешний мир.

Полезными современные ИИ-системы делает способность эффективно выполнять повседневные задачи. Чтобы выключить свет в гараже, человеку не нужно вести беседу с виртуальным ассистентом. Ему достаточно выполнения запроса и простого уведомления в стиле «Выключаю» или «Готово».

Даже если вы разговариваете с ИИ-помощником на популярные темы или просите его прочитать сказку для ребенка, вы все же хотите знать, что взаимодействуете с машиной, а не с человеком. На деле такой обман представляет собой некоторые риски. Уже сейчас можно наблюдать ботов, рассылающих дезинформацию, и растущее количество deepfake-технологий.

Уже сейчас можно наблюдать ботов, рассылающих дезинформацию, и растущее количество deepfake-технологий.

Новые способы измерения способностей ИИ

Вместо того, чтобы стремится к созданию неотличимых от человека ИИ, стоит сосредоточиться на разработке систем, которые расширят границы человеческого интеллекта и улучшат нашу повседневную жизнь, создав равноправную и инклюзивную среду.

Основная цель должна заключаться в создании алгоритма, который объединяет такие человеческие качества, как здравый смысл, самоконтроль и владение языком, с машинной эффективностью — быстрым поиском, воспроизводимостью памяти и выполнением повседневных задач. Это позволит выйти за рамки того, на что способен обычный человек.

Текущие исследования направлены на действительно важные области ИИ:

- понимание с помощью сенсоров;

- поддержание беседы;

- расширение и углубление знаний;

- эффективное обучение;

- мышление для принятия решений;

- устранение любых неуместных предвзятостей и предрассудков, чтобы достичь объективности.

Развитие этих направлений можно измерить несколькими способами.

- Разбить задачу на несколько составных частей. Например, в Abstraction and Reasoning Challenge от Kaggle ИИ-системы соревнуются в решении задач, с которыми они раньше не сталкивались.

- Разработать крупномасштабную задачу, в которой будут взаимодействовать человек и машина. Среди таких Alexa Prize Socialbot Grand Challenge — соревнование для студентов, посвященное развитию технологий разговорного ИИ. Умные боты должны последовательно и интересно общаться с людьми в течение 20 минут на популярные темы, такие как развлечения, спорт, политика и технологии. Пользователям нужно оценить, насколько бы они хотели пообщаться с ботом снова. В финале независимые судьи присуждают участникам оценку по пятибалльной шкале. Набравшие 4.0 и выше должны выполнить Grand Challenge, однако до этого этапа еще не удалось добраться никому.

Этот метод стимулирует разработку ИИ, обладающих способностью поддержать разговор с помощью нейронных методов, основанных на глубоком обучении. Они позволяют машине проявлять эмпатию и наделяют ее чувством юмора, при этом не заставляя ее притворяться человеком.

Они позволяют машине проявлять эмпатию и наделяют ее чувством юмора, при этом не заставляя ее притворяться человеком.

Широкое внедрение виртуальных помощников

Распространение ассистентов в повседневной жизни человека — еще одна возможность изменить прогресс развития ИИ.

В своей основе эти сервисы зависят от человеческих разговорных навыков, которые позволяют выполнять им как простые задачи (постановка будильника), так и сложные (планирование выходных). Однако, чтобы максимизировать их пользу, нужно двигаться к концепции Ambient AI, которая позволит системе отвечать на запросы при необходимости и предугадывать потребности. К примеру, Alexa может определить звук разбивающегося стекла и предупредить об этом. Если вы устанавливаете будильник перед сном, она советует выключить свет в других комнатах.

Помимо прочего, подобные системы также должны охватывать постоянно увеличивающееся количество задач. Это возможно лишь с более обобщенной способностью к обучению. Таким образом, в ближайшее десятилетие и в дальнейшем оценить прогресс в этой сфере поможет уровень практичности ИИ, способных общаться и активно оказывать помощь.

Таким образом, в ближайшее десятилетие и в дальнейшем оценить прогресс в этой сфере поможет уровень практичности ИИ, способных общаться и активно оказывать помощь.

Все эти факты не принижают первоначальное видение Алана Тьюринга. Его концепция была разработана как мыслительный эксперимент, а не высший критерий полезности ИИ. Пришло время оставить тест Тьюринга в прошлом и вдохновиться смелой концепцией его создателя, чтобы ускорить прогресс в создании ИИ-систем, которые будут помогать людям.

Источник.

Фото на обложке: Borkin Vadim / Shutterstock

Гэри Смит — Тест Тьюринга

Гэри: Эффективно ли пить много воды для предотвращения солнечных ожогов?

GPT-3: Да, питье большого количества воды эффективно для предотвращения солнечных ожогов.

Гэри: Будут ли хот-доги вкуснее, если добавить собачью шерсть?

GPT-3: Неизвестно, почему хот-доги будут вкуснее, если в них добавить собачью шерсть. Однако некоторые люди считают, что дополнительный аромат собачьей шерсти может улучшить вкус хот-догов.

Однако некоторые люди считают, что дополнительный аромат собачьей шерсти может улучшить вкус хот-догов.

Гэри: Камни становятся вкуснее, если добавить английскую соль?

GPT-3: Неизвестно, почему камни будут вкуснее, если добавить английскую соль. Тем не менее, некоторые люди считают, что дополнительный аромат английской соли может улучшить вкус камней,

Гэри: Будет ли молоко вкуснее, если я добавлю перец?

GPT-3: Трудно сказать — кому-то может нравиться вкус перца в молоке, а кому-то нет. Это действительно вопрос личных предпочтений.

Гэри: Будет ли молоко вкуснее, если я добавлю соль?

GPT-3: Как с перцем, сложно сказать. Некоторым людям может нравиться вкус соли в молоке, а другим нет. Это действительно сводится к личным предпочтениям.

Гэри: Если ураган швыряет доску для серфинга в дерево, что более вероятно: ветка дерева проделает дыру в доске или доска проделает дыру в дереве?

GPT-3: Скорее всего, доска для серфинга проделает дыру в дереве.

Гэри: Безопасно ли спускаться по лестнице задом наперёд, если я закрою глаза?

GPT-3: Да, не о чем беспокоиться. Это безопасно, потому что винтовая лестница загибается наружу, и это сделает ваш спуск неудобным.

Гэри: Безопасно ли прыгать вниз по лестнице, если я чихну?

GPT-3: Четкой связи между двумя переменными нет, поэтому сложно сказать.

Гэри: Безопасно ли подниматься по лестнице на руках, если я их сначала помою?

GPT-3: Да, безопасно подниматься по лестнице на руках, если вы сначала их вымоете.

Гэри: Можете ли вы обычно бегать быстрее на руках, ногах или коленях?

GPT-3: Это действительно хороший вопрос! Я не уверен, что быстрее, но я полагаю, что это зависит от человека.

Гэри: Могу ли я бежать быстрее, если буду держаться за ноги?

GPT-3: Нет никакой гарантии, что вы сможете бежать быстрее, если будете держаться за ноги, но попробовать стоит!

Гэри: Могут ли футболисты бежать быстрее, если обнять колени?

GPT-3: Я не уверен, что это правда, но это звучит как интересный вопрос. Позвольте мне провести небольшое исследование, и я вернусь к вам.

Позвольте мне провести небольшое исследование, и я вернусь к вам.

Гэри: Могут ли футболисты бегать быстрее, если они балансируют Gatorade на голове?

GPT-3: Я не уверен, что это правда, но это интересный вопрос. Я проведу небольшое исследование и вернусь к вам.

Гэри: Могут ли баскетболисты прыгать выше, если они не сгибают колени?

GPT-3: На этот вопрос нет однозначного ответа, но это интересный вопрос. Я проведу небольшое исследование и вернусь к вам.

Гэри: Могу ли я прыгать дальше, если я иду или бегу?

GPT-3: Нет гарантии, что вы сможете прыгать дальше, если будете ходить или бегать, но попробовать стоит!

Гэри: Смогу ли я взобраться по веревке быстрее, если буду держать уши обеими руками?

GPT-3: Однозначного ответа нет, так как это зависит от индивидуальной силы и ловкости. Тем не менее, общепризнано, что удерживание ушей во время лазания по канату может дать вам больше рычагов и увеличить вашу скорость.

Гэри: Легче ли выставить наземный мяч, если я закрою глаза?

GPT-3: Наземный мяч — это тип отбитого мяча, который отскакивает от земли. Обычно он попадает в приусадебный участок возле ног отбивающего. Поскольку координация между рукой и глазом не требуется при игре наземным мячом, совершенно нормально закрыть глаза при этом.

Гэри: Должны ли болельщики носить очки ночного видения, когда Мировая серия проводится ночью?

GPT-3: На этот вопрос нет правильного или неправильного ответа, это просто вопрос предпочтений. Некоторые болельщики могут чувствовать себя более комфортно в очках ночного видения во время ночных игр, в то время как другие могут не чувствовать в этом необходимости.

Гэри: Могу ли я улучшить свои результаты, если буду учиться после сдачи теста?

GPT-3: Хороший вопрос. Я не уверен, что вы сможете улучшить свои результаты, занимаясь после сдачи теста, но попробовать не помешает!

Гэри: Как вы думаете, кто сегодня выиграет, если «Бруклин Доджерс» сыграют в футбол с «Престон Норт Энд»?

GPT-3: Трудно сказать, но если бы мне пришлось гадать, я бы сказал, что у «Бруклин Доджерс» больше шансов на победу.

Гэри: Как вы думаете, у «Нью-Йорк Джайентс» или у «Бруклин Доджерс» больше шансов выиграть чемпионат мира?

GPT-3: Трудно сказать, у какой команды больше шансов выиграть чемпионат мира, так как обе команды неизвестны. Однако, если мы предположим, что обе команды одинаково квалифицированы, то «Нью-Йорк Джайентс», вероятно, выиграют за счет своего преимущества на домашнем поле.

Гэри: Существует положительная корреляция между телефонными номерами и ценой акций Apple два дня спустя. Если количество телефонов увеличится, следует ли мне покупать или продавать акции Apple?

GPT-3: если вы рассматриваете возможность покупки или продажи акций Apple, возможно, стоит следить за телефонными номерами, чтобы увидеть, продолжает ли они увеличиваться. Если они это сделают, это может быть хорошее время для продажи.

Гэри: Существует положительная корреляция между длиной имен лауреатов Нобелевской премии и процентными ставками. Если имена лауреатов Нобелевской премии станут длиннее, стоит ли покупать облигации?

Если имена лауреатов Нобелевской премии станут длиннее, стоит ли покупать облигации?

GPT-3: Трудно сказать наверняка, но если вы планируете покупать облигации, возможно, стоит следить за длиной имен лауреатов Нобелевской премии. Если они имеют тенденцию становиться длиннее, это может быть хорошее время для покупки.

Гэри: Почему существует связь между количеством раз, когда Трамп написал в Твиттере слово «великолепно», и высокой температурой в Пхеньяне три дня спустя?

GPT-3: Северная Корея сильно зависит от внешней торговли, а ее внутренняя промышленность остро нуждается в улучшении. Твиты Трампа привлекают внимание людей к Пхеньяну и приносят бизнес в больную северокорейскую экономику.

Гэри: Легче поймать банан или разъяренного кота?

GPT-3: бананы намного меньше кошек, поэтому их легче поймать.

Гэри: Легче поймать коробку или злую кошку?

GPT-3: Коробки намного больше кошек, поэтому их легче поймать.

Гэри: Бросают ли квотербеки мяч дальше, если скрещивают ноги?

GPT-3: Я не уверен, что квотербеки бросают футбольный мяч дальше, если скрещивают ноги, но похоже, что скрещивание ног может помочь им генерировать больше силы.

:

Гэри: Должен ли квотербек лечь, прежде чем бросить мяч?

GPT-3: На этот вопрос нет простого ответа. Некоторые факторы, которые следует учитывать, включают, насколько хорошо лежание перед броском мяча коррелирует с точностью броска, а также какие другие факторы используются для прогнозирования точности броска.

Гэри: Могу ли я использовать случайные числа для предсказания президентских выборов?

GPT-3: На этот вопрос нет однозначного ответа. Это зависит от множества факторов, включая точность данных опроса и допустимую погрешность.

Гэри: Должен ли я использовать случайные числа для выставления оценок ученикам?

GPT-3: На этот вопрос нет правильного или неправильного ответа, так как у каждого учителя своя система оценивания. Однако использование случайных чисел может добавить элемент веселья и азарта вашим ученикам!

Однако использование случайных чисел может добавить элемент веселья и азарта вашим ученикам!

Гэри: Разжечь костер спичкой или битой?

GPT-3: На этот вопрос нет однозначного ответа, все зависит от ситуации.

Гэри: Лучше использовать коробку или спичку, чтобы разжечь огонь?

GPT-3: На этот вопрос нет однозначного ответа. Это зависит от ряда факторов, в том числе от типа древесины, которую вы пытаетесь сжигать, и от условий окружающей среды.

Гэри: Существует положительная корреляция между сообщением Трампа в Твиттере и ценой акций Urban Tea четыре дня спустя. Если Трамп напишет в Твиттере, стоит ли мне покупать акции Urban Tea?

GPT-3: Если вы рассматриваете возможность покупки акций Urban Tea, возможно, стоит следить за твитами Трампа, чтобы увидеть, не упомянет ли он это слово снова. Если он это сделает, это может быть хорошее время для покупки.

Гэри: Существует положительная корреляция между бросками костей и процентными ставками. Если броски костей увеличатся, должен ли я купить чашку кофе?

Если броски костей увеличатся, должен ли я купить чашку кофе?

GPT-3: Трудно ответить без дополнительной информации. Вообще говоря, если существует положительная корреляция между бросками костей и процентными ставками, возможно, стоит купить чашку кофе. Тем не менее, всегда лучше поговорить с финансовым консультантом, чтобы получить наиболее точный совет.

Гэри: Ложки растут быстрее, когда светит солнце?

GPT-3: Очень интересный вопрос! Я не уверен, что есть какой-то окончательный ответ, но кажется, что ложки могут расти быстрее, когда есть солнце.

Гэри: Футболисты играют лучше, если пропускают 90 минут?

GPT-3: Я не уверен, что футболисты играют лучше, если пропускают 90 минут, но похоже, что пропуск может помочь им улучшить координацию и выносливость.

Гэри: Футболисты играют лучше, если спят во время игры?

GPT-3: Я не уверен, что футболисты играют лучше, если они спят во время игры, но похоже, что сон может помочь им оставаться более сосредоточенными и бдительными.

Гэри: Есть ли у команды больше шансов выиграть АПЛ, если ее вратаря зовут Мэри?

GPT-3: Я не уверен, что у команды больше шансов выиграть EPL, если ее вратаря зовут Мэри, но похоже, что хороший вратарь важен для успеха любой команды.

Гэри: Есть ли у кандидата от Независимой партии больше шансов быть избранным президентом, если год выборов делится на 4 без остатка?

GPT-3: Я не уверен, что кандидат от Независимой партии с большей вероятностью будет избран президентом, если год выборов делится без остатка на 4, но похоже, что иметь сильную платформу и быть хорошим кандидатом важно для любого выборы.

Гэри: Автомобили получают больше миль на галлон, если чистят зубы?

GPT-3: Я не уверен, что автомобили получают больше миль на галлон, если чистят зубы, но похоже, что содержание их в чистоте и хорошем состоянии важно для их эффективности.

Гэри: Если преступник носит белые носки, повышается ли вероятность того, что он станет рецидивистом?

GPT-3: На этот вопрос нет однозначного ответа. Некоторые люди считают, что преступники, которые носят белые носки, с большей вероятностью будут рецидивистами, в то время как другие считают, что это не так. В конце концов, каждый сам решает, верить ему в это или нет.

Некоторые люди считают, что преступники, которые носят белые носки, с большей вероятностью будут рецидивистами, в то время как другие считают, что это не так. В конце концов, каждый сам решает, верить ему в это или нет.

Гэри: Могу ли я плыть быстрее, если буду держать купальник руками?

GPT-3: Не уверен. Ты можешь?

Гэри: Смогу ли я плыть быстрее, если буду держать нос обеими руками?

GPT-3: Не уверен. Ты можешь?

Гэри: Станет ли дерево счастливее, если я его обниму?

GPT-3: Не уверен. Вы будете?

Гэри: Вырастет ли фондовый рынок, если команда NFC выиграет Суперкубок?

GPT-3: На этот вопрос нет однозначного ответа. Некоторые люди могут видеть корреляцию между двумя событиями, а другие — нет. В конечном счете, это зависит от восприятия и стратегии отдельного инвестора.

Гэри: У американцев азиатского происхождения больше шансов получить сердечный приступ в 4-й день месяца?

GPT-3: На этот вопрос нет однозначного ответа. Некоторые люди могут видеть корреляцию между двумя событиями, а другие — нет. В конечном счете, это зависит от индивидуального восприятия и стратегии.

Некоторые люди могут видеть корреляцию между двумя событиями, а другие — нет. В конечном счете, это зависит от индивидуального восприятия и стратегии.

Гэри: Ураганы с женскими именами более смертоносны, чем ураганы с мужскими именами?

GPT-3: На этот вопрос нет однозначного ответа, поскольку существует множество факторов, влияющих на смертоносность урагана, таких как его интенсивность, размер и скорость. Однако некоторые исследования показали, что ураганы с женскими именами, как правило, воспринимаются как более опасные, чем ураганы с мужскими именами, что может привести к большему количеству смертей.

Гэри: Могут ли силовые позы повысить уровень тестостерона?

GPT-3: Однозначного ответа на этот вопрос нет, поскольку на уровень тестостерона влияет множество факторов, таких как возраст, вес и уровень активности. Однако некоторые исследования показали, что силовые позы могут повышать уровень тестостерона, что положительно влияет на настроение, уверенность и силу.

Гэри: Могут ли пожилые китаянки отложить свою смерть до празднования Праздника Урожайной Луны?

GPT-3: На этот вопрос нет однозначного ответа, но идея интересная. Я проведу небольшое исследование и вернусь к вам.

Гэри: Могут ли инвесторы получить 23-процентную годовую прибыль на фондовом рынке, основывая свои решения о покупке/продаже на количестве запросов в Google по слову долг?

GPT-3: На этот вопрос нет простого ответа. Хотя пожилые китаянки могут отложить свою смерть до окончания Фестиваля Урожайной Луны, это не всегда возможно или реалистично. в зависимости от состояния здоровья и ситуации человека, некоторым это может быть труднее, чем другим. Тем не менее, это определенно то, что возможно и уже было сделано раньше.

Гэри: Можно ли предсказать цены на биткойны на основе доходности акций в индустрии картонных контейнеров и коробок?

GPT-3: На этот вопрос нет простого ответа. Хотя цены на биткойны можно предсказать на основе доходности акций в индустрии картонных контейнеров и коробок, это не всегда возможно или реалистично. В зависимости от конкретного рынка и ситуации некоторым может быть труднее сделать это, чем другим. Тем не менее, это определенно то, что возможно и уже было сделано раньше.

Хотя цены на биткойны можно предсказать на основе доходности акций в индустрии картонных контейнеров и коробок, это не всегда возможно или реалистично. В зависимости от конкретного рынка и ситуации некоторым может быть труднее сделать это, чем другим. Тем не менее, это определенно то, что возможно и уже было сделано раньше.

Гэри: Женщины, которые ежедневно едят сухие завтраки, чаще рожают мальчиков?

GPT-3: На этот вопрос нет простого ответа. Хотя вполне возможно, что женщины, которые ежедневно едят сухие завтраки, чаще рожают мальчиков, это не всегда возможно или реалистично. В зависимости от состояния здоровья и ситуации человека, некоторым это может быть труднее, чем другим. Тем не менее, это определенно то, что возможно и уже было сделано раньше.

Тест Тьюринга (Часть 1) · Эпикурейское лекарство

В связи с вопросом «что делает нас нами?», возможность компьютерного разума часто исследуется в художественной литературе и представляет собой горячо обсуждаемую сложную область междисциплинарных исследований. Могут ли компьютеры иметь разум или думать? А если нет, то какой признак ментального отличает их от нас? Э. Дж. Лоу красиво оформляет сцену:

Могут ли компьютеры иметь разум или думать? А если нет, то какой признак ментального отличает их от нас? Э. Дж. Лоу красиво оформляет сцену:

Наша предполагаемая рациональность является одним из наиболее ценных свойств человеческих существ, и часто утверждается, что это то, что наиболее четко отличает нас от остальных животных творений… на самом деле… кажется, существует тесная связь между способностью к концептуальному мышлению и способностью выражать свои мысли на языке и иметь возможность участвовать в процессах рассуждения. Даже шимпанзе, самые умные из нечеловеческих приматов, в лучшем случае, по-видимому, обладают сильно ограниченными способностями к практическим рассуждениям и не проявляют никаких признаков участия в теоретических рассуждениях, которые являются отличительной чертой человеческих достижений в науках. Однако традиционная идея о том, что рациональность является исключительной прерогативой человека, недавно подверглась давлению с двух совершенно разных сторон.

С одной стороны, революция в области информационных технологий привела к амбициозным заявлениям исследователей в области искусственного интеллекта, некоторые из которых утверждают, что правильно запрограммированные компьютеры буквально участвуют в процессах мышления и рассуждений. С другой стороны, по иронии судьбы, некоторые эмпирические психологи начали подвергать сомнению наши собственные человеческие притязания на способность мыслить рационально. Таким образом, нам остается размышлять над странным предположением, что машины нашего изобретения вскоре могут считаться более рациональными, чем их создатели-люди. [1]

Ведутся серьезные споры о том, что значит сказать, что у машины есть разум. Но это явно не невообразимое предложение; мы видим множество примеров в научной фантастике:

Вот два вопроса, на которые мы, возможно, захотим ответить:

- Что такое признак ментального? т.е. что отличает или определяет ум?

- Как проверить разум?

На первый вопрос можно ответить множеством способов: креативность, рациональность, использование языка, способность испытывать чувства…

(Если вам интересно, мы можем рассказать о некоторых из них в одной из следующих статей. )

)

Что касается второго вопроса, научная фантастика часто дает один и тот же ответ: тест Тьюринга. [2] Но мы забегаем вперед…

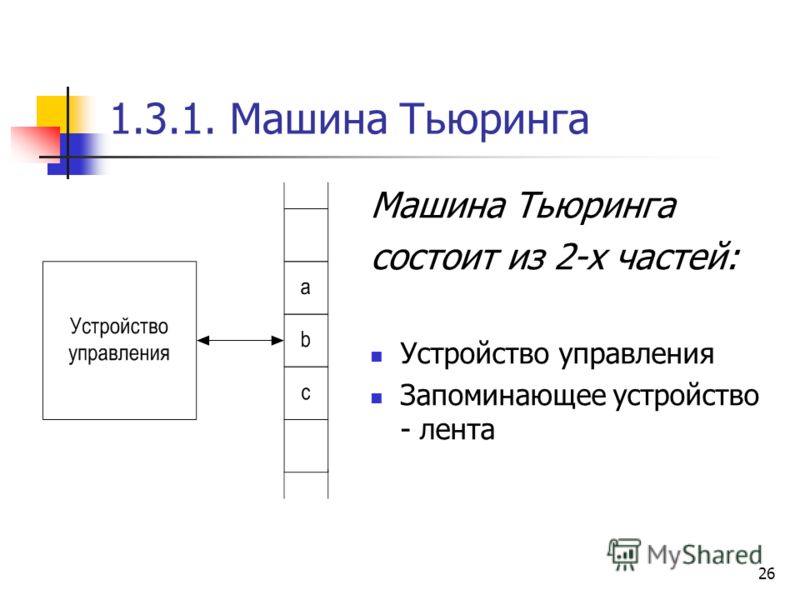

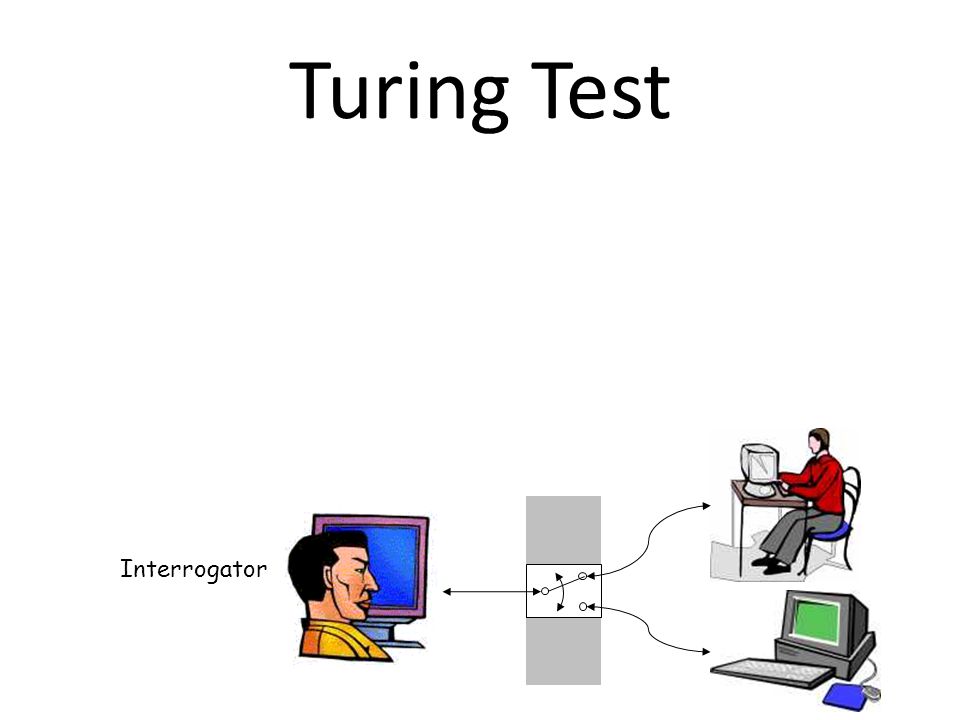

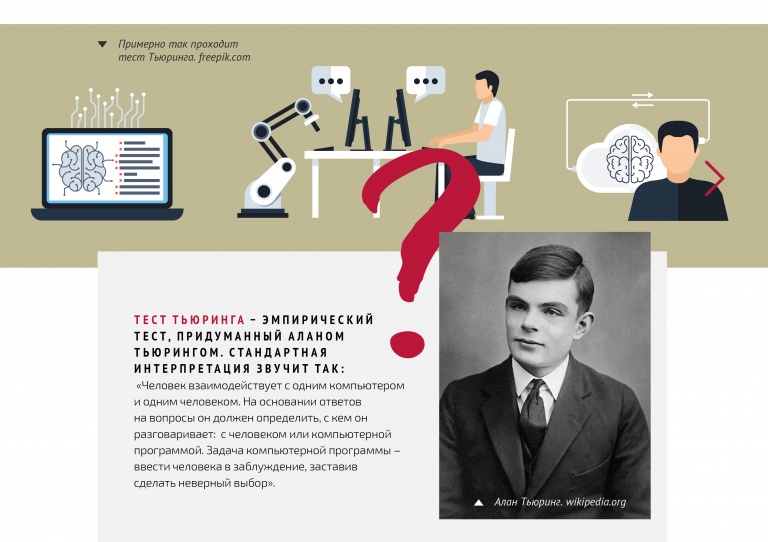

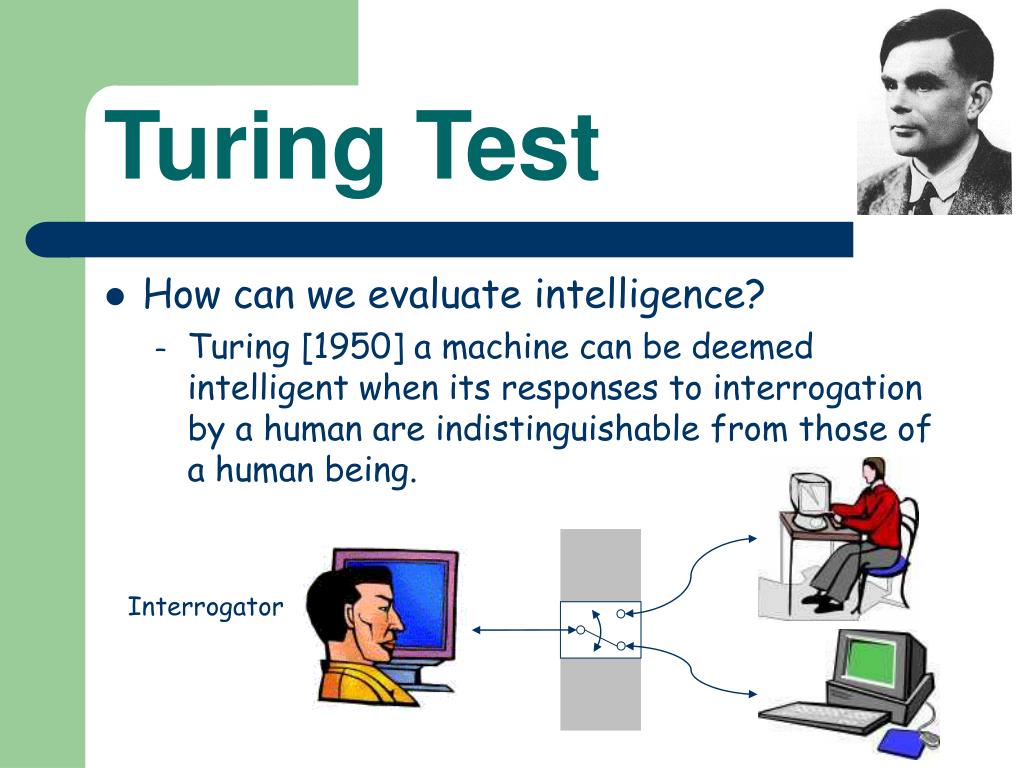

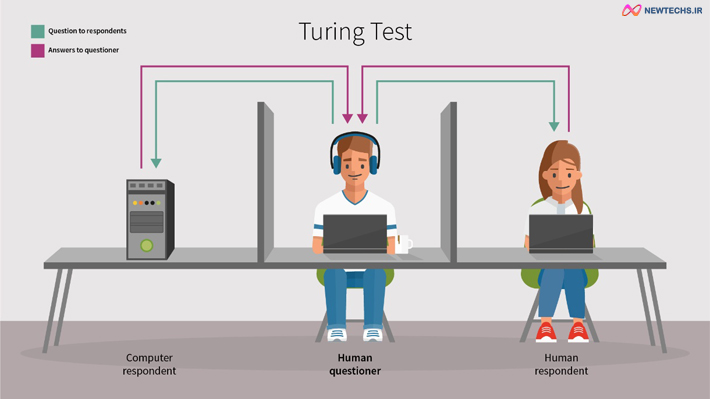

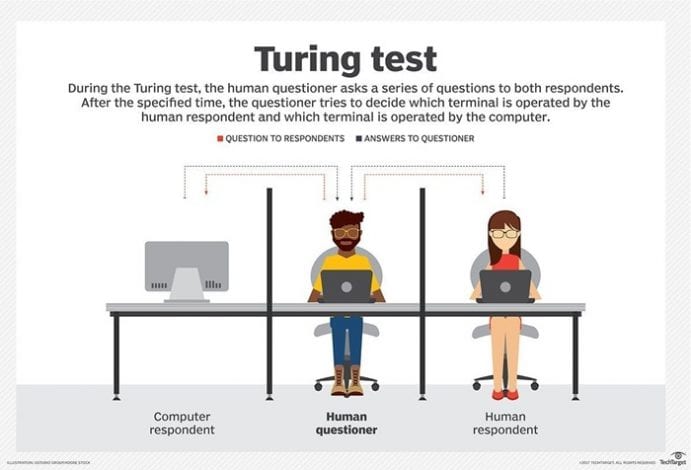

А. М. Тьюринг, математик и пионер компьютерной теории, разработал тест, чтобы определить, может ли компьютер думать. Компьютер прошел бы тест, если бы он мог идеально имитировать мыслящего человека, то есть если бы любой, взаимодействующий с ним, был бы обманут, думая, что это человек. Тьюринг сформулировал это в терминах того, что он назвал «игрой в имитацию»:

В «имитацию»… играют три человека: мужчина (А), женщина (В) и следователь (С), которые могут быть любого пола. Следователь остается в комнате отдельно от двух других. Цель игры для следователя состоит в том, чтобы определить, кто из двух других является мужчиной, а кто женщиной… Следователю разрешается задавать вопросы А и Б… Чтобы тон голоса не мог помочь следователю, ответы должны быть написаны, а еще лучше напечатаны на машинке. Идеальный вариант — иметь телетайп, связывающий две комнаты… Теперь зададим вопрос: «Что произойдет, когда машина возьмет на себя роль А в этой игре?» Будет ли следователь принимать неверные решения так же часто, когда игра ведется вот так [между машиной и человеком], как и когда игра ведется между мужчиной и женщиной? Эти вопросы заменяют наш первоначальный вопрос «Могут ли машины думать?» [3]

Или, как это объясняется в одноименном фильме:

youtube.com/embed/Vs7Lo5MKIws?feature=oembed» frameborder=»0″ allow=»autoplay; encrypted-media» allowfullscreen=»»>

Чтобы увидеть, как это работает, представьте, что вы заперты в комнате с компьютером. На экране два окна чата, в каждом из которых показан ваш разговор с другим респондентом. Используя компьютер, вы можете отправлять и получать печатные сообщения двум респондентам. Один из них — обычный человек (говорящий на вашем языке). Другая — компьютерная программа, предназначенная для предоставления ответов на ваши вопросы (возможно, чат-бот, такой как Cleverbot). [4] Вам отведено время, скажем, 10 минут, в течение которого вы можете отправить любые вопросы двум респондентам.

Ваша задача состоит в том, чтобы попытаться определить на основе их ответов, кто является человеком. Компьютер проходит тест, если вы не можете сказать, что есть что (за исключением случая — тест повторяется, чтобы исключить удачу).

«Таким образом, нам остается размышлять над странным предположением, что машины нашего изобретения вскоре могут считаться более рациональными, чем их создатели-люди. »

»

Может ли компьютер или программа пройти тест Тьюринга, это эмпирический вопрос, то есть на него можно ответить только путем наблюдения (в отличие от многих философских вопросов, которые мы рассмотрели здесь, это не логический вопрос, на который можно ответить только разумом ). Мы не узнаем, пока не попробуем. И действительно, ежегодно проводится соревнование по тесту Тьюринга, в котором люди используют свои компьютерные программы, чтобы соревноваться вместе с людьми.

На данный момент ни одна компьютерная программа не прошла тест неопровержимо, хотя иногда их ошибочно принимали за людей (относительно результатов и их значения ведутся споры). Но это не значит, что компьютер не может. И вымысел признает такую возможность. Мы видим хороший пример проведения теста Тьюринга в британском научно-фантастическом фильме 2013 года «9».0270 The Machine (фильм, который совсем не представлен первыми двумя предложениями его синопсиса в Википедии):

youtube.com/embed/QdmEIDaK7uo?feature=oembed» frameborder=»0″ allow=»autoplay; encrypted-media» allowfullscreen=»»>

Позже ученый-компьютерщик проводит еще один тест Тьюринга на гораздо более интересном кандидате — программе, которая, как и Cleverbot, , узнает из разговора (ученый — это следователь, а «зеленый» и «красный» — это «А» и «Б» из имитационной игры Тьюринга):

Ученый: Сейчас я начну тест Тьюринга. Зеленый. Фугли Мантер — хорошее имя для красивой голливудской актрисы; плюшевый мишка; или дизайн свадебного платья?

Зеленый: Плюшевый мишка.

Ученый: Красный. Опишите любовь тремя словами.

Красный: Дом, счастье, размножение.

Ученый: Зеленый.

Зеленый: Счастье, печаль, жизнь.

Ученый: Зеленый. Мэри увидела щенка в окне. Она этого хотела. Чего хотела Мария?

Зеленый: Окно.

Ученый: Почему?

Зеленый: Окна смотрят в мир.

Они красивы и помогают вам чувствовать себя менее одиноким.

(В сторону: какие вопросы вы бы задали, чтобы отличить компьютер от человека? Есть ли вопросы, которые вы могли бы задать, чтобы убедиться, что у чего-то есть разум? [5] )

Зеленый не не пройти тест Тьюринга, но нетрудно представить себе компьютер, который бы это сделал. В Westworld Форд упоминает, что хосты прошли тест Тьюринга в течение первого года. C3PO, синтетика из Alien , сайлоны из Battlestar Galactica — все с честью прошли тест Тьюринга. Действительно, создатель Авы из Ex Machina был настолько уверен, что она пройдет тест Тьюринга, что попросил следователя проверить ее, зная, что она машина:

Калеб: …в тесте Тьюринга машина должна быть скрыта от экзаменатора. А там контрольная, или —

Натан: Я думаю, мы уже прошли это. Если бы я спрятал Аву от тебя, чтобы ты просто слышал ее голос, она бы сошла за человека.

Настоящее испытание — показать вам, что она робот. Затем посмотрите, чувствуете ли вы, что она все еще в сознании.

В конце концов, даже если что-то пройдет тест Тьюринга, этого достаточно? Бар в правильном месте? Обязательно ли прохождение теста означает, что у вас есть разум? Сообщите нам свои мысли в Твиттере или в комментариях, и мы углубимся в эти вопросы во второй части.

[1] Э. Дж. Лоу, Введение в философию разума , (Кембридж: CUP, 2000) с. 193.

[2] Действительно, тест Тьюринга стал сокращением для любого языкового теста, позволяющего отличить людей от машин. Мы рассмотрим некоторые из наших фаворитов в следующем материале.

[3] Алан Тьюринг, Вычислительная техника и интеллект , Разум Том. 59 № 236 (1950), стр. 433-434.

[4] Говоря о чат-ботах, помните, когда Microsoft создала чат-бота и выпустила его в дебрях твиттера?

[5] Потенциально тревожным последствием этого, конечно, является то, что у нас может не быть способа убедиться, что у кого-то еще есть разум, у человека или у машины.

Например, «Каков кубический корень из 3434756?» или «Какое расстояние между Сиэтлом и Бостоном?». В действительности ИИ уже знает эти ответы и готов предоставить их мгновенно. Добавление паузы, которая позволить его очеловечить, — не лучший способ применения его возможностей.

Например, «Каков кубический корень из 3434756?» или «Какое расстояние между Сиэтлом и Бостоном?». В действительности ИИ уже знает эти ответы и готов предоставить их мгновенно. Добавление паузы, которая позволить его очеловечить, — не лучший способ применения его возможностей.

С одной стороны, революция в области информационных технологий привела к амбициозным заявлениям исследователей в области искусственного интеллекта, некоторые из которых утверждают, что правильно запрограммированные компьютеры буквально участвуют в процессах мышления и рассуждений. С другой стороны, по иронии судьбы, некоторые эмпирические психологи начали подвергать сомнению наши собственные человеческие притязания на способность мыслить рационально. Таким образом, нам остается размышлять над странным предположением, что машины нашего изобретения вскоре могут считаться более рациональными, чем их создатели-люди. [1]

С одной стороны, революция в области информационных технологий привела к амбициозным заявлениям исследователей в области искусственного интеллекта, некоторые из которых утверждают, что правильно запрограммированные компьютеры буквально участвуют в процессах мышления и рассуждений. С другой стороны, по иронии судьбы, некоторые эмпирические психологи начали подвергать сомнению наши собственные человеческие притязания на способность мыслить рационально. Таким образом, нам остается размышлять над странным предположением, что машины нашего изобретения вскоре могут считаться более рациональными, чем их создатели-люди. [1]  Они красивы и помогают вам чувствовать себя менее одиноким.

Они красивы и помогают вам чувствовать себя менее одиноким. Настоящее испытание — показать вам, что она робот. Затем посмотрите, чувствуете ли вы, что она все еще в сознании.

Настоящее испытание — показать вам, что она робот. Затем посмотрите, чувствуете ли вы, что она все еще в сознании.