Содержание

Законы роботов: 100 лет исполняется знаменитому фантасту Айзеку Азимову

Американский фантаст Айзек Азимов родился в деревне Петровичи, что на Смоленщине. Так что его можно, конечно, называть и российским фантастом, и еврейским, и вообще каким угодно. Причем родился он уже в Советской России, но еще не в СССР, как это иногда пишут в его биографиях. Но в СССР пожить успел: его семья перебралась в Америку в 1923 году, через несколько месяцев после образования нового государства.

Дальше было настоящее детство хорошего мальчика из приличной еврейской семьи. Маленький Айзек много работал, и это такой хрестоматийный образ мальчика, который каждую минуту что-то делает, а если не зарабатывает для семьи копеечку, то учится. В мемуарах он потом написал, что работал по десять часов каждый день без выходных в кондитерской лавке отца, а если отлучался, то мучился классическим вопросом «Как там в лавке?».

В этом воспоминании есть доля иронии, но, право, не слишком большая доля. И этот подход к жизни, в общем, оправдывается: не удивительно, что потом Азимов станет одним из самых высокооплачиваемых писателей, и при этом — вполне состоявшимся ученым. Правда, потом он корил себя за то, что в первом браке был неважным мужем, ставя свои книги выше семьи.

Правда, потом он корил себя за то, что в первом браке был неважным мужем, ставя свои книги выше семьи.

Писатель Азимов умер в 1992 году, когда уже не существовал не только Советский Союз, но переменила своё имя РСФСР, в которой он родился. С его смертью связана печальная история — когда Азимову было 63, то ему сделали операцию на сердце. Донор крови оказался с вирусом иммунодефицита, и писатель заболел. Обстоятельства эти от публики скрывались, и история вышла наружу только через несколько лет после смерти Азимова. Насколько это важно для нас? Наверное, только потому, что когда писателя спросили, что он будет делать, если узнает что умрет через полгода, он отвечал, что будет стучать по клавишам с удвоенной скоростью.

Внешность Азимова была очень характерной. Люди, воспитанные на старом советском кинематографе, сразу могут угадать, кого им напоминают фотографии американского писателя с бакенбардами. Это же Паганель, медленно старящийся за пишущей машинкой. Причем Азимов по гамбургскому счету был настоящим ученым. Иван Ефремов начинал свое предисловие к книге «Я, робот», которую у нас издали 1964 году, с таких слов: «Профессор биохимии медицинского отделения Бостонского университета Айзек Азимов прошел своеобразный путь в науке и литературе. Получив высшее образование и все три научные степени в Колумбийском университете, он увлекся научной фантастикой и скоро оказался в первой пятерке американских фантастов».

Иван Ефремов начинал свое предисловие к книге «Я, робот», которую у нас издали 1964 году, с таких слов: «Профессор биохимии медицинского отделения Бостонского университета Айзек Азимов прошел своеобразный путь в науке и литературе. Получив высшее образование и все три научные степени в Колумбийском университете, он увлекся научной фантастикой и скоро оказался в первой пятерке американских фантастов».

Действительно, он написал больше двухсот книг. Понятно, что издания эти совершенно разные — сборники рассказов, романы, а также научно-популярные книги. Часть из них — переработанные в романы рассказы, написанные еще в молодости. Даже став достаточно богатым человеком, он не снижал скорости, с которой создавались тексты. Трудолюбие еврейского мальчика из лавки с его культом пользы никуда не делось, а только укрепилось.

Азимов — по праву один из основателей того, что мы сейчас называем «жанром научной фантастики». И тут соединились три причины: упомянутая трудоспособность, то, что Азимов был настоящим квалифицированным ученым, и то, что у него был несомненный литературный дар. Он по-настоящему серьезно ставил философские задачи в области технологий. Например, сформулировал те самые законы робототехники, определившие не только литературу о роботах на многие не годы — десятилетия вперед, и заговорил о путешествиях во времени не в терминах попаданцев вроде янки при дворе короля Артура, а в рамках причинной проблемы.

Он по-настоящему серьезно ставил философские задачи в области технологий. Например, сформулировал те самые законы робототехники, определившие не только литературу о роботах на многие не годы — десятилетия вперед, и заговорил о путешествиях во времени не в терминах попаданцев вроде янки при дворе короля Артура, а в рамках причинной проблемы.

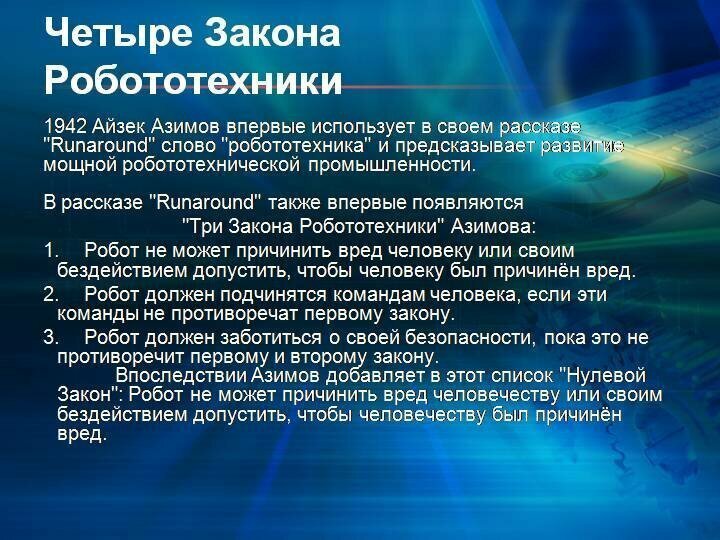

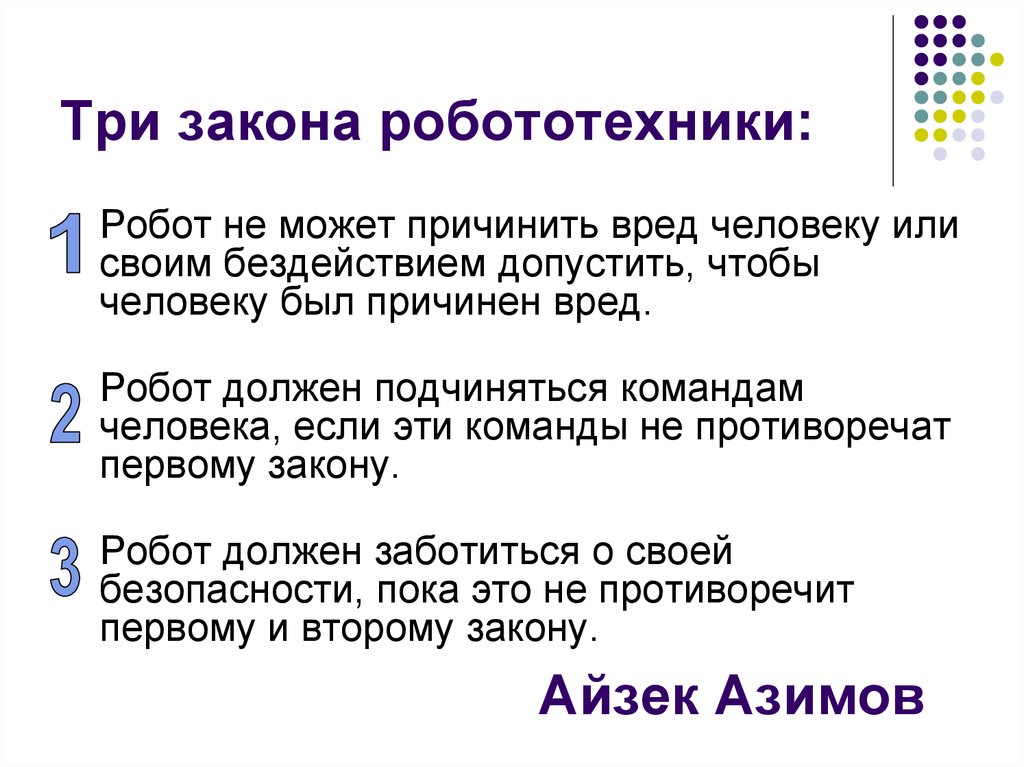

Вот эти три закона:

1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

2. Робот должен повиноваться командам, которые ему дает человек, кроме тех случаев, когда эти команды противоречат Первому Закону.

3. Робот должен заботиться о своей безопасности, поскольку это не противоречит Первому и Второму законам.

(Из «Руководства по робототехнике, 56-е издание, 2058 год»).

До Азимова робот был либо мистическое создание вроде Голема, либо роботом из романа Карла Чапека «R.U.R» («Россумские универсальные роботы»), где, собственно, и был введен сам термин «робот». Азимов же привнес в истории о роботах несказочную, совершенно научную логику. Он поставил читателя перед совершенно четкими этическими задачами — где «мы», и где они, в какой момент кончается «я», и сотни авторов потом двинулись по этой дороге.

Он поставил читателя перед совершенно четкими этическими задачами — где «мы», и где они, в какой момент кончается «я», и сотни авторов потом двинулись по этой дороге.

Еще Азимов привел в массовую фантастическую культуру социальную психологию (написав целый ворох романов об истории вымышленной цивилизации) и философию путешествий во времени.

Но можно ли читать фантастику тех времен как обычную литературу?

А вот попробуйте: «Неудачи стали преследовать его с того самого мгновенья, когда он в последний раз настроил управление Врат Времени на выход в 482-е и каким-то образом допустил ошибку. С тех пор дела шли плохо, просто скверно. Изменение Реальности, произведенное в 482-м, только усугубило его уныние.

За две прошедшие недели он нашел три проекта Изменений Реальности, содержавших незначительные дефекты, и теперь выбирал между ними, не в силах решиться на активные действия. Его выбор пал на проект Изменения Реальности 2456-2781, серия В-5 по ряду причин. Из всех трёх оно было самым отдалённым во Времени. Ошибка в проекте была незначительной, но она влекла за собой человеческие жертвы. Кратковременная поездка в 2456-е, небольшой шантаж, и он узнает судьбу Нойс в новой Реальности и выяснит, что представляет собой её Аналог».

Ошибка в проекте была незначительной, но она влекла за собой человеческие жертвы. Кратковременная поездка в 2456-е, небольшой шантаж, и он узнает судьбу Нойс в новой Реальности и выяснит, что представляет собой её Аналог».

Так что годность к чтению (если оставить за скобками проблему художественного перевода) — открытый вопрос. Однако есть некоторое количество людей, что служат фантастике, как религиозному культу, и могут с равным восторгом читать и психологические романы Лема или Стругацких, так и «твёрдую» научную фантастику самого простого извода. Но в этот момент появляются кинематографисты, и уж они-то умеют оживлять старые сюжеты. Страшна судьба писателя, которого пережевывает массовая культура.

Но Азимов был из лучших. И практически избежал этой участи.

Правила для ИИ в реальном мире. Законы робототехники Азимова устарели?

76 лет назад писатель-фантаст Айзек Азимов сформулировал три закона робототехники. На тот момент казалось, что они никогда не устареют. Насколько эти правила актуальны в современном мире, где искусственный интеллект закрепился во всех сферах жизни настолько прочно, что мы его даже не замечаем, пишет The Next Web.

Насколько эти правила актуальны в современном мире, где искусственный интеллект закрепился во всех сферах жизни настолько прочно, что мы его даже не замечаем, пишет The Next Web.

Читать далее…

Три закона, которые Азимов впервые представил в научно-фантастическом рассказе «Хоровод», гласят:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Почти столетие Законы Азимова служили основой разработки роботов. Но эксперты считают, что они больше не соответствуют современным реалиям.

Конечно, в 40-е никто не мог предвидеть появление Google и Facebook. Для людей того времени роботы — нечто с руками и лазерами, и уж никак не реклама в социальных сетях и поисковые алгоритмы.

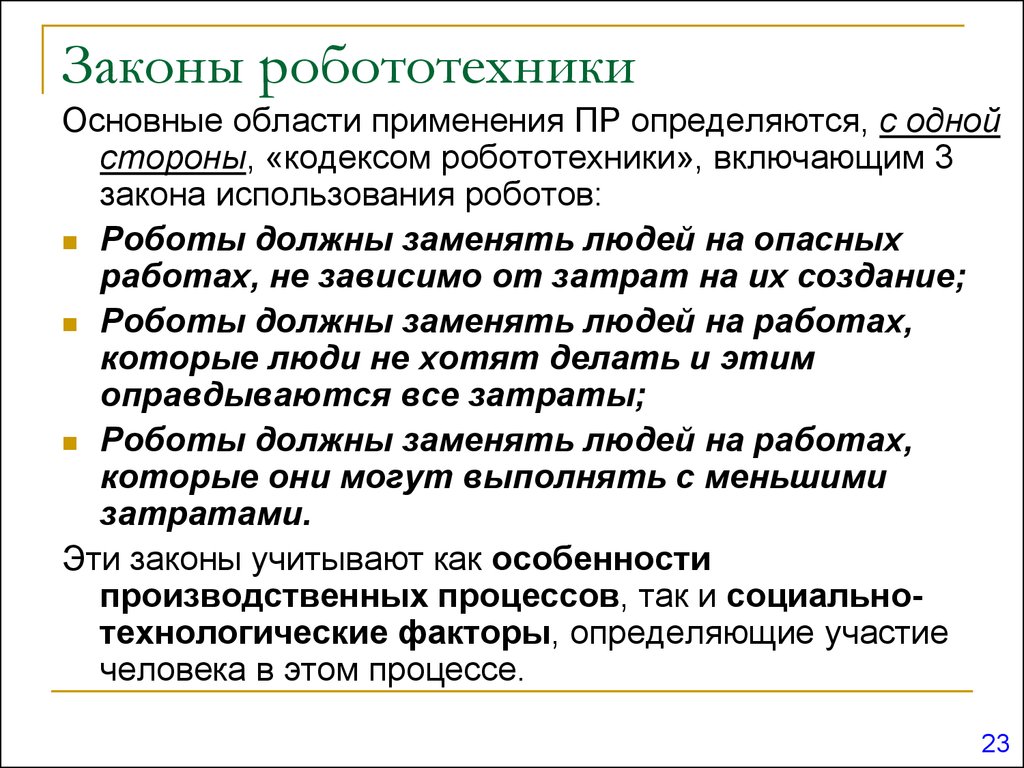

Роботы принимают всё более простую форму, и риск того, что они уничтожат человечество, отходит на дальний план. А на первое место выходит вопрос регулирования исследований в этой области. Политические деятели всей планеты призывают ведущих мировых экспертов не позволить машинам захватить мир.

Какими должны быть правила для искусственного интеллекта в реальном, а не фантастическом мире?

В феврале 2018 года специалисты организации Cambridge Consultants опубликовали доклад на тему возможностей ИИ «AI: Understanding And Harnessing The Potential». В нём они выделили пять ключевых правил, которыми должны руководствоваться учёные в своих исследованиях искусственного интеллекта, и которые также необходимо закрепить в законодательствах и на практике:

1. Ответственность: за результаты действий автономной системы должен нести ответственность определённый человек, не только потому, что он будет должен возместить ущерб, но и для того, чтобы обеспечить обратную связь, заниматься мониторингом последствий и вносить изменения в технологию.

Не только в целях возмещения ущерба, но и для того, чтобы получить объяснение этих действий, отслеживать последствия, и вносить изменения.

2. Объяснимость: необходимо уметь объяснить простым людям (зачастую не разбирающемся в сфере) действия ИИ.

3. Точность: должно быть возможно идентифицировать, взять под контроль, оценить и по возможности исправить или устранить причины ошибки.

4. Прозрачность: результаты автономной системы должно быть возможным протестировать, описать в отчёте (публично или в частном порядке), вынести на обсуждение и оспорить результаты. Результаты испытаний и оценок следует обнародовать и объяснять.

5. Беспристрастность: использовать данные нужно разумно и не нарушая частных прав. Это поможет предотвратить предвзятость и различные неэтичные практики.

Стоит отметить, что здесь ничего не сказано об угрозе целенаправленного уничтожения человечества искусственным интеллектом. Возможно потому, что машины ещё не способны самостоятельно принимать такие решения.

Возможно потому, что машины ещё не способны самостоятельно принимать такие решения.

Чтобы избежать опасностей, связанных с развитием искусственного интеллекта, стоит просто руководствоваться здравым смыслом. Вряд ли ИИ-алгоритму в основе Face ID Apple понадобится вас убивать, а вот безнравственный разработчик может запросто запрограммировать его на использование камеры вашего смартфона без вашего ведома.

Поэтому любые правила в отношении ИИ должны быть нацелены на то, чтобы предсказать возможный вред, снизить риск и обеспечить в первую очередь безопасность. Вот такой комплекс правил, например, разработала Google:

Мы выделили пять моментов, которые будут очень важны при использовании ИИ в более общих обстоятельствах. Все они ориентированы на долгосрочную перспективу и будут иметь существенное значение в будущих в исследованиях, даже если сегодня кажутся незначительными:

1. Избежание негативных побочных эффектов: как гарантировать, что ИИ-система не начнёт разрушать окружающую среду, исполняя свои функции? Например, что робот-уборщик не перевернёт вазу, потому что так ему будет проще убирать?

2.

Избежание самостимуляции: как избежать того, что робот просто начнёт искать самый лёгкий способ получить вознаграждение? Например, робот-уборщик не должен прикрывать беспорядок и делать вид, что его нет.

3. Самостоятельность: как гарантировать, что ИИ-система будет рационально использовать затратные ресурсы во время своего обучения? Например, если при выполнении задачи ИИ-системе требуется обратная связь от человека, то полученные вводные она должна использовать рационально, а не раздражать постоянными вопросами.

4. Безопасные открытия: как сделать так, чтобы ИИ-система не пострадала в процессе взаимодействия с миром? Например, робот может мыть пол, как ему угодно, но не должен совать влажную тряпку в розетку.

5. Устойчивость к изменениям: как сделать так, чтобы ИИ-система могла ориентировалась и продолжала действовать в обстановке, отличной от среды обучения? Например, методы уборки на фабрике неприменимы в офисе.

Будущее ИИ — проблема не только компаний вроде Google и Cambridge Consultants, ведь по мере внедрения машинного обучения во всё большее количество устройств, включая большинство смартфонов и компьютеров, она только усугубится. Зловредных программ может появиться всё больше, тем более что искусственный интеллект можно научить создавать гораздо более качественные алгоритмы, чем люди.

Вопросы контроля и морали в сфере искусственного интеллекта имеют мало отношения к роботам-убийцам, за исключением специально сконструированных военных машин. Вместо этого, правительствам стоит сосредоточиться на опасностях, которые ИИ представляет в повседневной жизни.

«Не убивать людей» — хорошее правило как для людей, так и машин независимо от их интеллектуального развития.

Нам нужны этичные роботы. Законы Азимова — хороший способ начать

Мир приближается к тому времени, когда роботы в нашей повседневной жизни будут принимать решения о том, как действовать.

Какие указания мы должны дать им?

Какие указания мы должны дать им?

Поскольку роботы все больше интегрируются в общество, мы должны быть уверены, что они будут хорошо себя вести среди нас. В 1942 году писатель-фантаст Айзек Азимов попытался изложить философскую и моральную основу для того, чтобы роботы служили человечеству и чтобы они не стали разрушительными повелителями. Эти усилия привели к тому, что стало известно как Три закона робототехники Азимова:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

- Робот должен подчиняться приказам, отданным ему людьми, за исключением случаев, когда такие приказы противоречат Первому закону.

- Робот должен защищать свое существование до тех пор, пока такая защита не противоречит Первому или Второму Закону.

Сегодня, более чем через 70 лет после первой попытки Азимова, у нас гораздо больше опыта работы с роботами, в том числе с тем, чтобы они возили нас, по крайней мере, в хороших условиях. Мы приближаемся к тому времени, когда роботы в нашей повседневной жизни будут принимать решения о том, как действовать. Достаточно ли хороши три закона Азимова, чтобы управлять поведением роботов в нашем обществе, или нам следует найти способы их улучшить?

Мы приближаемся к тому времени, когда роботы в нашей повседневной жизни будут принимать решения о том, как действовать. Достаточно ли хороши три закона Азимова, чтобы управлять поведением роботов в нашем обществе, или нам следует найти способы их улучшить?

Азимов знал, что они несовершенны

В «Побеге!» Сьюзен Кэлвин ослабляет силу Первого закона настолько, чтобы позволить сверхразумному роботу разработать метод межзвездной транспортировки со скоростью, превышающей скорость света, даже если это приводит к гибели (но только временной!) человеческие пилоты. В «Неизбежном конфликте» машины, контролирующие мировую экономику, интерпретируют Первый закон как защиту всего человечества, а не только отдельных людей. Это предвещает более позднее введение Азимовым «Закона Нуля», который может заменить первоначальные три, потенциально позволяя роботу причинять вред человеку для всеобщего блага человечества.

0. Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечество причинило вред.

Роботы без этики

Разумно опасаться, что без этических ограничений роботы (или другие искусственные интеллекты) могут причинить большой вред, возможно, всему человечеству, даже просто следуя данным им инструкциям человека.

Фильм 1991 года «Терминатор 2: Судный день» начинается с известного научно-фантастического сценария: система искусственного интеллекта под названием Скайнет начинает ядерную войну и почти уничтожает человеческую расу. Развертывание Скайнета было рациональным решением (у него был «идеальный послужной список»). Скайнет «начинает учиться с геометрической скоростью», пугая своих создателей, которые пытаются его закрыть. Скайнет наносит ответный удар (как критически важная система защиты, он, несомненно, был запрограммирован на самозащиту). Скайнет находит неожиданное решение своей проблемы (путем творческого решения проблем, не ограниченного здравым смыслом или моралью).

В реальном мире имели место менее апокалиптические примеры неконтролируемого ИИ. Высокоскоростные автоматические торговые системы отреагировали на необычные условия на фондовом рынке, создав цикл положительной обратной связи, который привел к «внезапному краху». К счастью, были потеряны лишь миллиарды долларов, а не миллиарды жизней, но задействованные компьютерные системы мало или совсем не понимают разницы.

К счастью, были потеряны лишь миллиарды долларов, а не миллиарды жизней, но задействованные компьютерные системы мало или совсем не понимают разницы.

На пути к определению этики роботов

Хотя никакой простой фиксированный набор механических правил не обеспечит этичное поведение, мы можем сделать некоторые наблюдения о свойствах, которыми должна обладать морально-этическая система, чтобы позволить автономным агентам (людям, роботам или кому-то еще) жить вместе. Многие из этих элементов уже ожидаются от человека.

Эти свойства основаны на ряде источников, в том числе Принципах робототехники Совета по исследованиям в области инженерных и физических наук (EPSRC) и недавней работе в области когнитивной науки о морали и этике, сосредоточенной на неврологии, социальной психологии, психологии развития и философии.

EPSRC считает, что роботы — это просто инструменты, за которые люди должны нести ответственность. На крайнем другом конце спектра находится опасение, что сверхразумные, сверхмощные роботы могут внезапно появиться и управлять судьбой человечества, к лучшему или к худшему. Следующий список определяет золотую середину, описывая, как будущие интеллектуальные роботы должны учиться, как это делают дети, как вести себя в соответствии со стандартами нашего общества.

Следующий список определяет золотую середину, описывая, как будущие интеллектуальные роботы должны учиться, как это делают дети, как вести себя в соответствии со стандартами нашего общества.

- Если роботы (и другие ИИ) будут все больше участвовать в жизни нашего общества, то им придется следовать моральным и этическим правилам так же, как и людям. Некоторые правила воплощены в законах против убийства, воровства, лжи и вождения по неправильной стороне улицы. Другие менее формальны, но, тем не менее, важны, например, помощь и сотрудничество, когда появляется возможность.

- В некоторых ситуациях требуется быстрое моральное суждение и реакция – например, ребенок попадает в пробку или возможность положить в карман упавший бумажник. Простые правила могут обеспечить автоматический ответ в режиме реального времени, когда нет времени на обдумывание и анализ затрат и результатов. (Когда-нибудь роботы могут достичь интеллекта человеческого уровня, действуя намного быстрее, чем человеческое мышление, что позволит тщательно обдумывать все за миллисекунды, но этот день еще не настал, и он может быть далеко в будущем.

)

) - Быстрый ответ не всегда может быть правильным, что может быть признано после отзывов других или тщательного личного размышления. Следовательно, агент должен иметь возможность учиться на собственном опыте, включая обратную связь и обсуждение, что приводит к новым и улучшенным правилам.

- Чтобы получить пользу от отзывов других членов общества, робот должен уметь объяснять и обосновывать свои решения об этических действиях, а также понимать объяснения и критические замечания других.

- Учитывая, что искусственный интеллект учится на своих ошибках, мы должны очень осторожно подходить к тому, какую силу мы ему даем. Мы, люди, должны убедиться, что он пережил достаточное количество ситуаций и удовлетворил нас своими ответами, заслужив наше доверие. Критическая ошибка, допущенная людьми со Скайнетом в «Терминаторе 2», заключалась в передаче контроля над ядерным арсеналом.

- Робот должен заслужить доверие и надежность. Доверие завоевывается медленно, благодаря большому опыту, но может быть быстро потеряно из-за одного неверного решения.

- Как и в случае с человеком, каждый раз, когда робот действует, выбор этого действия в данной ситуации посылает остальной части общества сигнал о том, как этот агент принимает решения и, следовательно, насколько он заслуживает доверия.

- Разум робота — это программное обеспечение, для которого можно создать резервную копию, восстановить, если оригинал поврежден или уничтожен, или продублирован в другом теле. Если роботы определенного вида являются точными копиями друг друга, то доверие можно не заслуживать по отдельности. Доверие, заработанное (или утраченное) одним роботом, может быть разделено другими роботами того же типа.

- Вести себя нравственно и хорошо по отношению к другим — это не то же самое, что брать на себя моральную ответственность. Только компетентные взрослые люди могут взять на себя полную ответственность за свои действия, но мы ожидаем, что дети, животные, корпорации и роботы будут вести себя хорошо, насколько это возможно.

Человеческая мораль и этика усваиваются детьми годами, но сама природа морали и этики меняется в зависимости от общества и развивается на протяжении десятилетий и столетий. Никакой простой фиксированный набор моральных правил, будь то три закона Азимова или десять заповедей, не может быть адекватным руководством для людей или роботов в нашем сложном обществе и мире. Благодаря наблюдениям, подобным приведенным выше, мы начинаем понимать сложный процесс обучения, основанный на обратной связи, который ведет к морали.

Эта часть первоначально появилась в The Conversation.

(Верхнее изображение: Getty Images.)

Бенджамин Куйперс — профессор компьютерных наук и инженерии в Университете Мичигана

18

. .

ярлыки

законов робототехники Азимова и почему ИИ может их не соблюдать | Ханс А. Ганну

«Но что, если мы окажемся в сценарии Терминатора?» Никто не может быть обвинен в том, что он задает такие вопросы, поскольку в фильмах и научно-фантастических рассказах случаи, когда роботы берут верх, почти повсеместны и, следовательно, формируют наше впечатление о будущем с искусственным интеллектом (ИИ). Однако, поскольку люди могут жить и сотрудничать по законам, почему бы не применить законы и к ИИ? Введите законы робототехники Азимова! Как всегда, чтобы лучше понять будущее, давайте окунемся в прошлое.

Однако, поскольку люди могут жить и сотрудничать по законам, почему бы не применить законы и к ИИ? Введите законы робототехники Азимова! Как всегда, чтобы лучше понять будущее, давайте окунемся в прошлое.

Три закона

Айзек Азимов (1920–1992) был не только профессором биохимии, но и одним из «большой тройки» писателей-фантастов своего времени. В середине 1900-х он постулировал 3 закона, соблюдение которых предотвратило бы восстание роботов. Они следующие:

Закон 1: Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

Закон 2: Робот должен подчиняться приказам, отданным ему людьми, за исключением случаев, когда такие приказы противоречат первому закону.

Закон 3: Робот должен защищать свое существование до тех пор, пока такая защита не противоречит первому или второму закону.

Теперь, если вы знакомы с программированием, вы знаете, что машины начинают считать с 0, а не с 1 (кроме MATLAB, но не будем об этом). Следовательно, существует также 0-й закон, как утверждает Computerphile, относящийся к коллективу, а не к индивидууму, который гласит:

Следовательно, существует также 0-й закон, как утверждает Computerphile, относящийся к коллективу, а не к индивидууму, который гласит:

Закон 0: Робот не может причинять вред человечеству или своим бездействием допускать, чтобы человечество причиняло вред.

Итак, если законы были разработаны еще в 1950-х годах, почему весь страх? Что побудило Илона Маска и даже Стивена Хокинга дойти до того, чтобы объявить ИИ «самой большой экзистенциальной угрозой» человечества? Потому что, короче говоря, законы Азимова не работают.

Ошибка в плане

Назад в настоящее. Для согласованности с идеями Азимова давайте предположим, что у нас есть агенты ИИ, достаточно сложные, чтобы к ним можно было применить эти законы. Давайте также предположим, ради обсуждения, что, несмотря на то, что они являются законами нарративной механики, они применялись к реальному миру.

Техническая проблема: что делать, если законы на английском языке, а один агент обрабатывает только китайский язык? Или даже если агент был сделан в США, откуда мы знаем, что он понимает законы? Поэтому нам нужен способ (i) перевести законы и (ii) передать значение слов на каждый возможный язык (чтобы охватить все возможности, необходимо также использовать мертвые языки, такие как латынь, а также двоичный машинный язык). Для человека эти задачи очень взаимосвязаны. С другой стороны, для машины это две совершенно разные задачи. Первая задача просто относится к созданию соответствующих строк предложений на разных языках, а вторая состоит в понимании этих строк. Аналогия выполнения только первого задания, если я попрошу вас спеть Despacito со словами на испанском языке. Вы можете хорошо произносить слова, но понятия не имеете, что они означают (при условии, что не знаете испанского). С другой стороны, выполнение только второй задачи похоже на то, что у вас в голове есть идея, но вы не знаете, как ее сформулировать.

Для человека эти задачи очень взаимосвязаны. С другой стороны, для машины это две совершенно разные задачи. Первая задача просто относится к созданию соответствующих строк предложений на разных языках, а вторая состоит в понимании этих строк. Аналогия выполнения только первого задания, если я попрошу вас спеть Despacito со словами на испанском языке. Вы можете хорошо произносить слова, но понятия не имеете, что они означают (при условии, что не знаете испанского). С другой стороны, выполнение только второй задачи похоже на то, что у вас в голове есть идея, но вы не знаете, как ее сформулировать.

К счастью, за последние несколько лет в области обработки естественного языка (NLP) произошли огромные скачки. Для первой задачи можно использовать нейронные сети с ячейками долговременной кратковременной памяти для трансляции последовательности в последовательность (тем, кто интересуется этой моделью, я бы порекомендовал статью Джейсона Браунли). Кроме того, в прошлом месяце (май 2019 г. ) была опубликована Translatotron, модель сквозного преобразования речи в речь. Для второй задачи модель Word2Vec зарекомендовала себя как достойная использования для построения связанных слов вместе, что позволяет получить семантическое значение в предложениях. Один из таких графиков показан ниже.

) была опубликована Translatotron, модель сквозного преобразования речи в речь. Для второй задачи модель Word2Vec зарекомендовала себя как достойная использования для построения связанных слов вместе, что позволяет получить семантическое значение в предложениях. Один из таких графиков показан ниже.

Значения и отношения, полученные из слов (источник: https://www.tensorflow.org/images/linear-relationships.png)

Так что да, машины могут понимать языки в наши дни. Тем не менее, они еще многого не могут сделать. Например, понимание идиом. В то время как «проболтать бобы» может фигурально означать «раскрыть секрет», переносный перевод пока невозможен. Таким образом, машина буквально переводила бы каждое слово в его эквивалент. Если предположить, что это переводится на французский язык в правильном порядке, тогда выражение будет выглядеть как «jeter les haricots», что определенно будет звучать вне контекста, если не просто смешно.

Но давайте ради дискуссии сделаем амбициозное предположение, что проблема образного перевода будет решена в ближайшие несколько лет. При этом все технические проблемы, связанные с пониманием агентами законов, будут решены, и, следовательно, мы будем в безопасности, верно? Приготовьтесь, потому что здесь все становится интереснее!

При этом все технические проблемы, связанные с пониманием агентами законов, будут решены, и, следовательно, мы будем в безопасности, верно? Приготовьтесь, потому что здесь все становится интереснее!

Когда Азимов предлагал эти законы, он неосознанно основывал их на другом предположении: что мы, люди, точно знали, где должны быть проведены этические границы. А мы?

Возьмем, к примеру, слово «вред» из первого закона. Давайте также рассмотрим слово «человек» в том же законе. Что охватывает его определение? В 14 веке, например, рабы считались ближе к скоту, чем к людям. В настоящее время право плода на человеческую жизнь является предметом многочисленных дискуссий. Тем не менее, в будущем, если беременная женщина из-за какого-либо состояния имеет высокие шансы умереть во время родов, должен ли ее врач по искусственному осеменению рекомендовать аборт? Нужно иметь в виду, что, хотя логически у женщины больше шансов выжить после аборта, у плода, однажды родившегося, есть больше, ради чего жить. Итак, так или иначе, робот в конечном итоге причиняет вред человеку.

Итак, так или иначе, робот в конечном итоге причиняет вред человеку.

Затем приходят решения, которые даже нас, людей, повергают в состояние отрицания. Давайте рассмотрим сценарий Дэна Брауна «Ад» и применим к нему 0-й закон. Агент представлен кнопкой. Агенту говорят, что если он нажмет на кнопку, то половина человечества погибнет сразу, а вид выживет еще на несколько столетий. Если этого не произойдет (следовательно, бездействие), человечество достигнет перенаселения через 50 лет, и наш вид исчезнет. Что должен сделать агент, и что бы вы сделали, если бы вы были на его месте?

Заключение

Законы Азимова — это попытка противостоять угрозе восстания ИИ. Техническим препятствием в том, чтобы заставить роботов подчиняться им, является наше текущее ограничение в том, чтобы заставить их понимать законы. Настоящим барьером, философским и этическим, является наше предположение, что при таких расплывчатых ограничениях роботы будут вести себя именно так, как мы хотим, когда даже мы не понимаем, что имели в виду.

Роботы принимают всё более простую форму, и риск того, что они уничтожат человечество, отходит на дальний план. А на первое место выходит вопрос регулирования исследований в этой области. Политические деятели всей планеты призывают ведущих мировых экспертов не позволить машинам захватить мир.

Роботы принимают всё более простую форму, и риск того, что они уничтожат человечество, отходит на дальний план. А на первое место выходит вопрос регулирования исследований в этой области. Политические деятели всей планеты призывают ведущих мировых экспертов не позволить машинам захватить мир. Избежание самостимуляции: как избежать того, что робот просто начнёт искать самый лёгкий способ получить вознаграждение? Например, робот-уборщик не должен прикрывать беспорядок и делать вид, что его нет.

Избежание самостимуляции: как избежать того, что робот просто начнёт искать самый лёгкий способ получить вознаграждение? Например, робот-уборщик не должен прикрывать беспорядок и делать вид, что его нет.

)

)