Содержание

История постройки гусеничного робота / Хабр

Моя история погружения в изучение робототехники и создание робота с помощью 3d принтера. Ошибки, с которыми я столкнулся и что хотел-бы получить в итоге

Предыстория

Лет 10 назад, на первых курсах университета, узнав о существовании Arduino и научившись заказывать товары из Китая, я заказал себе стартовый набор Arduino Mega и начал, как и все, учиться мигать светодиодом. Я получал дикий восторг от того что могу не только програмировать и получать какие-то решения на экране компьютера, а могу делать какие-то устройства, которыми могу облегчить быт. Начал думать о IOT до того как узнал о таком понятии и время от времени думал чтоб такого полезного реализовать. Первым проектом на Arduino, который я для себя считал оконченным, был контроллер для террариума с пауком. Экранчик, несколько кнопок для управления, датчик температуры и влажности DHT11, автоматизация подсветки, обогрев с помощью шнура для инкубатора и все. У меня уже был опыт работы с паскалем в школе, мне нравилось программирование но я не хотел связывать с ним жизнь напрямую, для меня это было скучно, и я заведома пошел учиться на инженерную специальность, если точнее то Информационные технологии проектирования в НТУ «ХПИ».

У меня уже был опыт работы с паскалем в школе, мне нравилось программирование но я не хотел связывать с ним жизнь напрямую, для меня это было скучно, и я заведома пошел учиться на инженерную специальность, если точнее то Информационные технологии проектирования в НТУ «ХПИ».

Обещали супер продвинутое направление, передовые технологии, рассказывали насколько востребованы такие специалисты и заманивали яркими картинками расчетов в Ansys, Solidworks и остальных программных комплексах. На самом деле, сейчас, через 6 лет после окончания ВУЗа, я могу сказать что ни капли не жалею что выбрал данное направление для себя. Много чего конечно было не так как описывалось при поступлении, но на 3 курсе я все-таки дождался предметов, которые мне нравились. Я увлекся изучением CAD систем, на одной из олимпиад получил сертификат CSWA от Solidworks, вообще не напрягаясь и не готовясь к этому. Но после окончания ВУЗа я получил офер без опыта и особо знаний в программировании на должность .NET разработчика под проекты связанные с интеграцией плагинов в Solidworks. Потом 6 лет работы с .NET в нескольких компаниях, с разными направлениями, попытка работы удаленно с криптовалютами и т.д. но мне это все не приносило удовольствия. Время от времени я понимал что мне нравится процесс автоматизации обыденных процессов, но никак не мог придумать что бы такого сделать, чтобы не просто поиграться, а что-то реальное и полезное. Годы шли, универ несколько лет как окончен, свободного времени так и не появлялось, но как-то в преддверии ремонта я решил что вот этот шанс применить свои знания и попробовать сделать что-то действительно полезное, и занялся разработкой умного дома. Немного освежил знания о нынешней ситуации в микроконтроллерах в мире, узнал о существовании ESP8266 с Wifi на борту, когда-то украинском стартапе Blynk, дающий возможность условно бесплатно получить приложения для управления устройством с телефона, без опыта и знаний о разработке софта под телефоны. Через нескольких месяцев я получил прототип, собранный на макетке, но стабильно работающий.

Потом 6 лет работы с .NET в нескольких компаниях, с разными направлениями, попытка работы удаленно с криптовалютами и т.д. но мне это все не приносило удовольствия. Время от времени я понимал что мне нравится процесс автоматизации обыденных процессов, но никак не мог придумать что бы такого сделать, чтобы не просто поиграться, а что-то реальное и полезное. Годы шли, универ несколько лет как окончен, свободного времени так и не появлялось, но как-то в преддверии ремонта я решил что вот этот шанс применить свои знания и попробовать сделать что-то действительно полезное, и занялся разработкой умного дома. Немного освежил знания о нынешней ситуации в микроконтроллерах в мире, узнал о существовании ESP8266 с Wifi на борту, когда-то украинском стартапе Blynk, дающий возможность условно бесплатно получить приложения для управления устройством с телефона, без опыта и знаний о разработке софта под телефоны. Через нескольких месяцев я получил прототип, собранный на макетке, но стабильно работающий. На первое время для проверки так и оставил в виде модулей, прикрученных в распредкоробках. Хотел бы написать что после тестов в реальных условиях развел плату и собрал все нормально, но нет, третий год все работает стабильно поэтому и не лезу что-то переделывать. Из полезного для меня в этом всем я получил возможность экономить электроэнергию автоматически включая основные потребители такие как бойлер, посудомойку, стиралку по ночному тарифу. Мониторинг температуры в каждой комнате и соответственно управление обогревом в каждой комнате. Там-же реализовал контроллер теплого пола и освещение на улице. 3 года назад все это решение мне обошлось примерно в 50$ с учетом того что столько стоит только нормальный контроллер для теплого пола. 3 года работы этой всей системы дали мне уверенность того что микроконтроллеры действительно можно использовать для разработок и они могут стабильно работать.

На первое время для проверки так и оставил в виде модулей, прикрученных в распредкоробках. Хотел бы написать что после тестов в реальных условиях развел плату и собрал все нормально, но нет, третий год все работает стабильно поэтому и не лезу что-то переделывать. Из полезного для меня в этом всем я получил возможность экономить электроэнергию автоматически включая основные потребители такие как бойлер, посудомойку, стиралку по ночному тарифу. Мониторинг температуры в каждой комнате и соответственно управление обогревом в каждой комнате. Там-же реализовал контроллер теплого пола и освещение на улице. 3 года назад все это решение мне обошлось примерно в 50$ с учетом того что столько стоит только нормальный контроллер для теплого пола. 3 года работы этой всей системы дали мне уверенность того что микроконтроллеры действительно можно использовать для разработок и они могут стабильно работать.

Первые попытки построения робота

Несколько лет назад я все-таки решился и выделил себе бюджет на хобби, купив 3D принтер. Фанерный клон Ultimaker сразу же начал допиливаться руками, были доделаны дверцы и короб из акрила для печати ABS, и я стал понимать что с принтером уже можно разрабатывать что-то более серьёзное, движимое и интересное для меня. Помня еще из детства передачи по телевизору с боями роботов я решил, а почему б не сделать себе что-то интересное. Сходил на фестиваль робототехники, загорелся этой идеей еще больше. Начал смотреть проекты роботов на thingiverse и понимал что это все не то, чужие разработки в основном скучные и обычные, отсутствие исходников и все-таки «ЯЖИНЖЕНЕР». Хотелось что-то с необычной механикой, а не просто колесная база. Захотелось реализовать механику подобную роботу при загрузке Solidworks.

Фанерный клон Ultimaker сразу же начал допиливаться руками, были доделаны дверцы и короб из акрила для печати ABS, и я стал понимать что с принтером уже можно разрабатывать что-то более серьёзное, движимое и интересное для меня. Помня еще из детства передачи по телевизору с боями роботов я решил, а почему б не сделать себе что-то интересное. Сходил на фестиваль робототехники, загорелся этой идеей еще больше. Начал смотреть проекты роботов на thingiverse и понимал что это все не то, чужие разработки в основном скучные и обычные, отсутствие исходников и все-таки «ЯЖИНЖЕНЕР». Хотелось что-то с необычной механикой, а не просто колесная база. Захотелось реализовать механику подобную роботу при загрузке Solidworks.

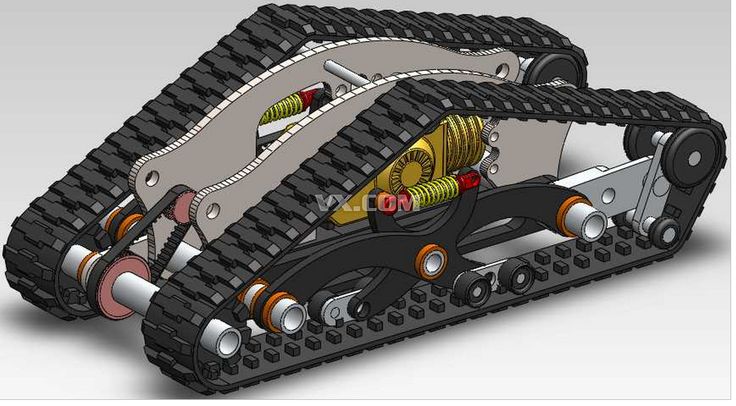

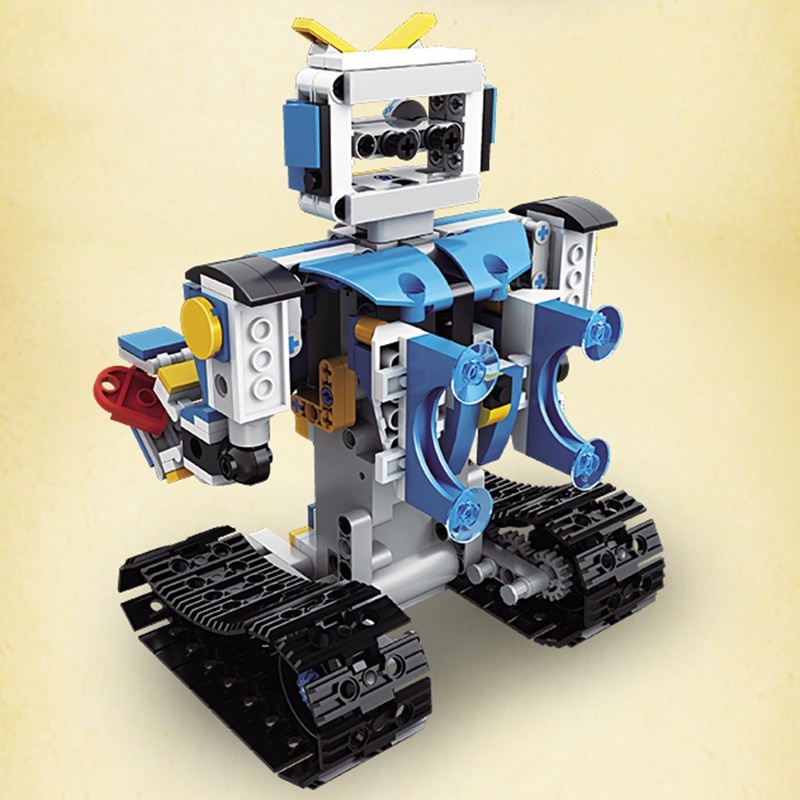

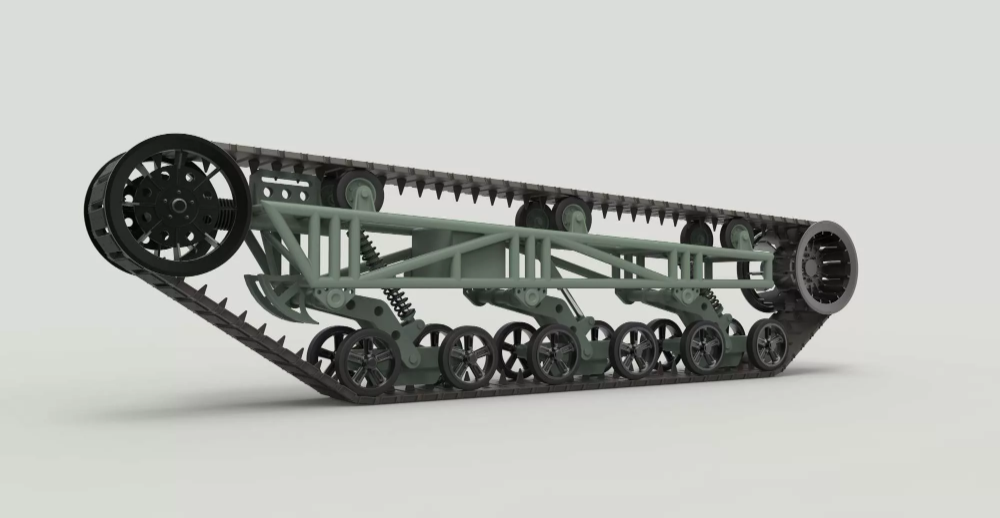

Тот самый робот, который стал одним из вдохновителей

Посмотрел подобные конструкции, понял принцип работы и держал в голове мысль сделать что-то похожее. Первой главной ошибкой было решение что все просто, буду постепенно моделировать, печатать и проверять готовую конструкцию, не имея полного представления что и как будет устроенно, как будет управляться, какие модули будут использоваться. Как-же сильно я ошибался. Изначально, я понимал что робот будет делаться «на вырост», планировал на этом роботе использовать всякие распознавания объектов с помощью OpenCV, какая-то навигация, автоматический паркинг на зарядку, одним ESP там не обойдешься. Изначально закладывалась идея использовать ESP32 для работы с механикой и RaspberryPi3 для работы с логикой, камерой, звуком и т.д. Одним из необходимых для меня условием была автоматическая подзарядка, соответственно нужно было придумать как реализовать питание. Так-как с электроникой/электротехникой опыта особо у меня не было, сначала я пытался использовать подобие Powerbank с возможностью работы в режиме ИБП. Работа от АКБ (в моем случае 8 элементов 18650) когда нет внешнего питания и подзарядка этих-же элементов и работа от сети когда робот паркуется на зарядку. Вобщем было много попыток собрать все вместе и заставить работать, но я понял что нужно или учить матчасть или обращаться за помощью. Из-за постоянных изменений всяких модулей и плат все уже не помещалось в корпус робота и в какой-то момент я понял, что пора все переделывать.

Как-же сильно я ошибался. Изначально, я понимал что робот будет делаться «на вырост», планировал на этом роботе использовать всякие распознавания объектов с помощью OpenCV, какая-то навигация, автоматический паркинг на зарядку, одним ESP там не обойдешься. Изначально закладывалась идея использовать ESP32 для работы с механикой и RaspberryPi3 для работы с логикой, камерой, звуком и т.д. Одним из необходимых для меня условием была автоматическая подзарядка, соответственно нужно было придумать как реализовать питание. Так-как с электроникой/электротехникой опыта особо у меня не было, сначала я пытался использовать подобие Powerbank с возможностью работы в режиме ИБП. Работа от АКБ (в моем случае 8 элементов 18650) когда нет внешнего питания и подзарядка этих-же элементов и работа от сети когда робот паркуется на зарядку. Вобщем было много попыток собрать все вместе и заставить работать, но я понял что нужно или учить матчасть или обращаться за помощью. Из-за постоянных изменений всяких модулей и плат все уже не помещалось в корпус робота и в какой-то момент я понял, что пора все переделывать.

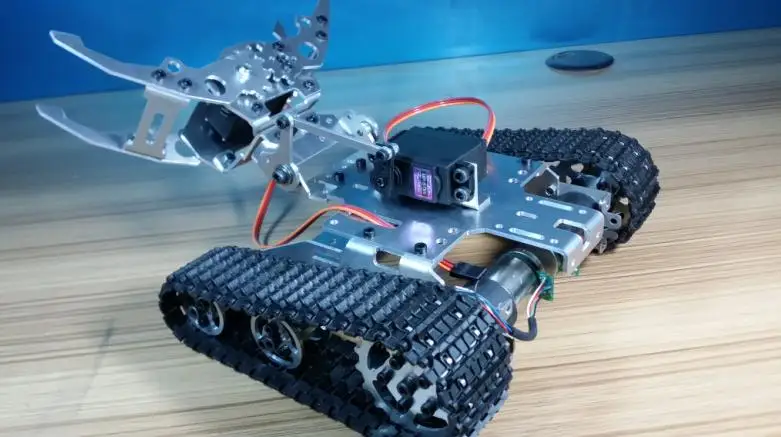

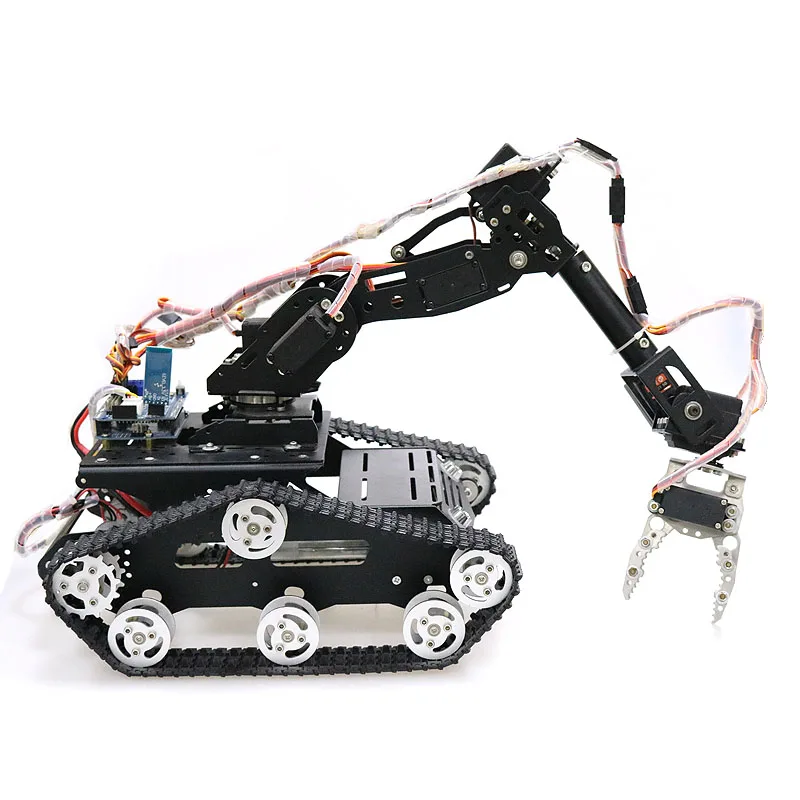

Первый вариант конструкции с напечатанными гусеницами одним ремнем и сервой для проворота передней части гусениц

Первые работы над ошибками

После участия в вебинаре по робототехнике я познакомился с человеком, который занимается разработкой плат и для себя решил что мне проще набросать какое-то ТЗ и получить какое-то решение от человека, который разбирается в проектировании плат и разработке устройств. Параллельно я начал работу над новым корпусом примерно посмотрев на свои косяки в прошлый раз. И тут я очередной раз наступаю на те-же грабли до конца не понимая как будет выглядеть вся электроника, какие у нее будут размеры и как я это все буду размещать. Мы обсудили о том что это будет модульное решение, у меня были некоторые платы, например драйверов двигателей, батареи и я начал заново моделировать проект, но уже полностью вырисовывая каждую плату с посадочными отверстиями, выходами проводов, радиаторами и т.д. чтоб опять не столкнуться с проблемой нехватки места. На самом деле я был ограничен размерами области печати в 200*200*200мм и этот вариант корпуса я пытался сделать вообще из одной детали, на печать которой уходило около 400г пластика и несколько суток печати.

На самом деле я был ограничен размерами области печати в 200*200*200мм и этот вариант корпуса я пытался сделать вообще из одной детали, на печать которой уходило около 400г пластика и несколько суток печати.

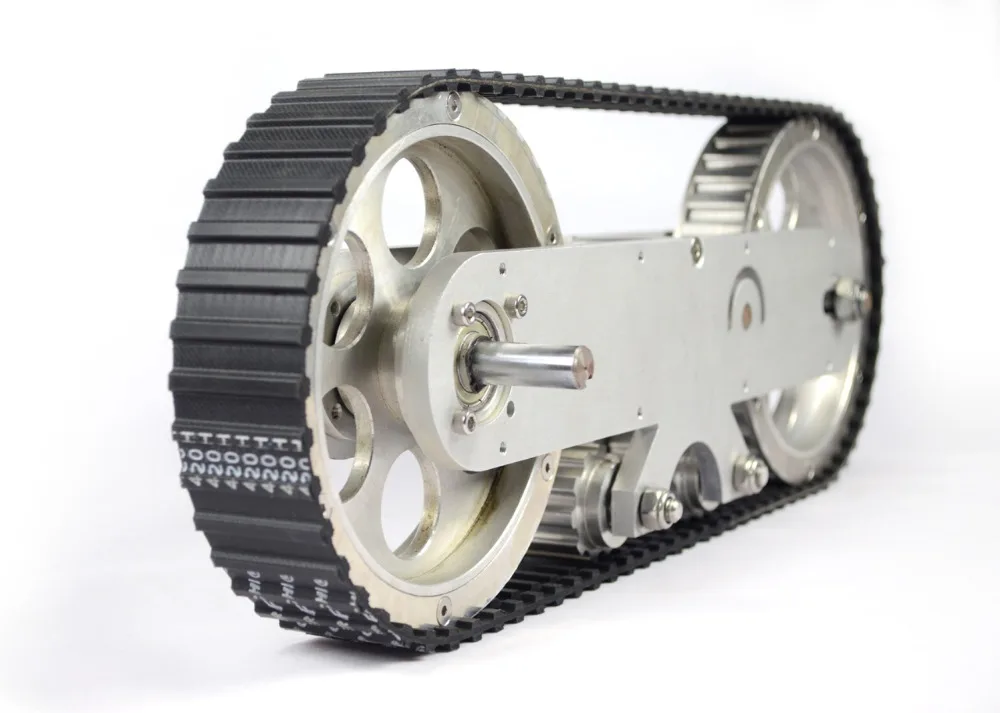

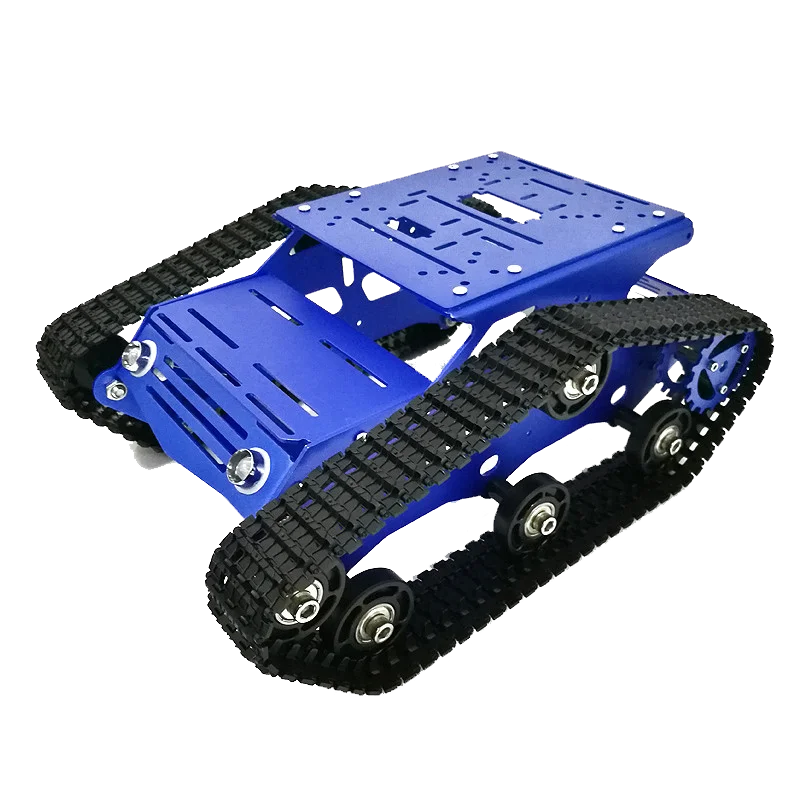

После нескольких попыток с появляющимися на вторые сутки трещинами, отлипаниями от стола я понял что сборный корпус не такая уж и плохая идея. Процесс переделывания какой-то из деталей занимал бы намного меньше времени и мороки с принтером будет намного меньше. Получив через время комплект разведенных плат со всеми моими пожеланиями я научился работать со сдвиговыми регистрами, мультиплексорами и хоть как-то начал разбираться в непонятных для меня схемах и устройствах. К тому моменту я уже очередной раз полностью переделал механику. Изменил принцип вращения передних «лап» с сервопривода на двигатель с червячным редуктором, Ушел от идеи печатать из резиноподобного эластана ремни для гусениц и переделал их под обычные сборные пластиковые гусеницы, собранные на гвоздях и наклеенными на них протекторах из эластана. Изначально была продумана система вентиляции, которая забирала воздух сзади снизу робота, через систему вентиляции проходя через все платы, трубки, в которых прокинуты провода в «голову» и выдувая из нее горячий воздух. И эта система вентиляции в какой-то момент времени даже работала, но потом опять все перестраивалось поэтому мне проще было распечатать крышку с кучей прорезей и пассивной вентиляцией.

Изначально была продумана система вентиляции, которая забирала воздух сзади снизу робота, через систему вентиляции проходя через все платы, трубки, в которых прокинуты провода в «голову» и выдувая из нее горячий воздух. И эта система вентиляции в какой-то момент времени даже работала, но потом опять все перестраивалось поэтому мне проще было распечатать крышку с кучей прорезей и пассивной вентиляцией.

Что есть на данный момент

На выходных в Днепре прошел технический фестиваль Interpipe TechFest, на котором я решил показать людям то что сейчас есть у меня, послушать мнение других и пообщаться с однодумцами. Там я очередной раз услышал о том что можно было б и написать где-то например на Хабре и получить какой-то отзыв от людей.

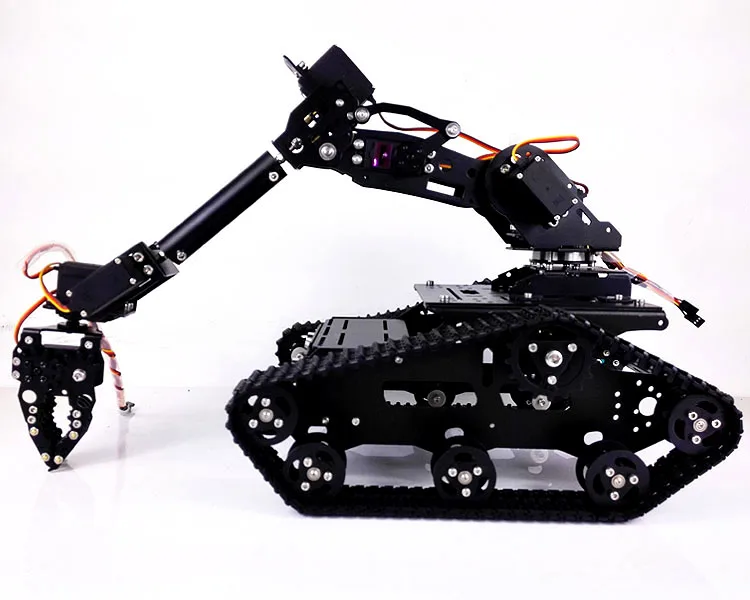

По факту для меня это платформа, на которой я буду учиться работать с ROS, пытаться ориентироваться в пространстве, отстраивать кару, попробую поработать с твердотельным лидаром, который жду с кикстартера, хочу прикрутить что-то типа стереокамеры realsense. Я понимаю что мозгов малинки мне скорее всего не хватит и со временем я перейду на что-то более мощное.

Я понимаю что мозгов малинки мне скорее всего не хватит и со временем я перейду на что-то более мощное.

Сейчас этот робот может использоваться в качестве «домашнего сторожа». Пока управление устроенно через все то-же приложение Blynk. Он оснащен купольным сенсором движения, камера с возможностью включения/выключения ИК фильтра, ИК подсветка. Активировав с телефона режим охраны, я получаю уведомление на телефон. Могу включить RaspberryPi 3, запустить стримминг, стримминг + запись видео, сделать фото, которые отправляются мне на почту. Могу поехать посмотреть что там происходит дома и вернуться на зарядку на докстанцию.

Самосборная батарея 4s2p из модулей 18650 на 3200mAh каждая дает мне примерно 8 часов езды без подзарядки с всем включенным оборудованием и передачей видео и без какой-либо оптимизации энергосбережения. Пока до этого руки не дошли. С помощью Google TextToSpeach написав в терминал этого приложения, робот озвучивает текст. И это все с любой точки мира где у меня есть подключение к интернету.

Немного «жести» внутри

Так выглядит UI управления на телефоне

Что дальше и зачем я это все пишу

Вообще, целью посещения выставки было найти новые знакомства с однодумцами, готовыми начать что-то делать связанное с робототехникой. Мне надоело работать просто программистом, писать десктопные приложения, это уже не так круто как казалось когда-то и я считаю что это направление постепенно загибается. Вместо того чтоб переучиваться на WEB разработку я решил кардинально поменять направление и связать свою жизнь с робототехникой и IOT, которые мне действительно нравятся. Для себя я решил что работая на работе, не связанной с этим направлением у меня не хватает на все времени. Я должен выбирать между тем что нужно и тем что нравится и хочется, подкопил немного денег, ушел с работы и начал все это изучать.

У меня есть несколько задумок на тему робототехники, основная из которых связана с сельским хозяйством, основанная на компьютерном зрении, картах глубины, распознавании объектов и т. д. Я понимаю что работы очень много и сейчас я только начал разбираться с ROS. У меня есть знания в инженерии, умения работать с CAD/CAE системами и в принципе все реально сделать и самому, но понимая сколько работы нужно сделать по механике, разработке, просчетам и полностью научиться работать с ROS, картами глубины, сенсорами, ориентировании в пространстве и довести это все до ума самому будет очень сложно. Поэтому я ищу несколько человек. которые готовы серьезно заняться работой над этим стартапом и стать одними из сооснователей. Само собой я не могу обещать, что все будет круто и через пол года наш стартап будет приносить нам кучу денег, но пока эта ниша не переполнена можно пробовать что-то реализовать на уровне первого прототипа и с ним уже выходить на акселераторы, краудфандинговые площадки и как-то рекламировать себя.

д. Я понимаю что работы очень много и сейчас я только начал разбираться с ROS. У меня есть знания в инженерии, умения работать с CAD/CAE системами и в принципе все реально сделать и самому, но понимая сколько работы нужно сделать по механике, разработке, просчетам и полностью научиться работать с ROS, картами глубины, сенсорами, ориентировании в пространстве и довести это все до ума самому будет очень сложно. Поэтому я ищу несколько человек. которые готовы серьезно заняться работой над этим стартапом и стать одними из сооснователей. Само собой я не могу обещать, что все будет круто и через пол года наш стартап будет приносить нам кучу денег, но пока эта ниша не переполнена можно пробовать что-то реализовать на уровне первого прототипа и с ним уже выходить на акселераторы, краудфандинговые площадки и как-то рекламировать себя.

Также я готов к рассмотрению предложений в данном направлении. Готов работать с кем-то над чьим-то стартапом, или не обязательно стартапом а просто разработками какой-то компании но в интересном для меня направлении.

Поэтому хотелось бы услышать какие-либо комментарии по этому поводу. Возможно все-таки это кого-то заинтересует. Сам я территориально проживаю в г.Днепр, Украина. Соответственно было б правильней работать над одним проектом в относительной близости хотя б в сотнях километров а не тысячах, но рассматриваются все варианты.

Если есть какие-то вопросы об устройстве моего данного робота готов ответить и обсудить. Так-же на странице facebook есть несколько видео работы робота и его преодоление препятствий

Если что меня всегда можно найти здесь, на facebook или написать мне на почту [email protected]

Колёсные и гусеничные роботы — Работотехника

主页 > Колёсные и гусеничные роботы |

Наиболее распространёнными роботами данного класса являются[9][10] четырёхколёсные и гусеничные роботы. Сегвей в Музее роботов в Нагоя. Двухколёсные роботы, как правило, для определения угла наклона корпуса робота и выработки подаваемого на приводы роботов соответствующего управляющего напряжения (с целью обеспечить удержание равновесия и выполнение необходимых перемещений) используют те или иные гироскопические устройства. Задача удержания равновесия двухколёсного робота связана с динамикой обратного маятника[11]. На данный момент, разработано множество подобных «балансирующих» устройств[12]. К таким устройствам можно отнести Сегвей, который может быть использован, как компонент робота; так например сегвей использован как транспортная платформа в разработанном НАСА роботе Робонавт[13]. Одноколёсные роботы во многом представляют собой развитие идей, связанных с двухколёсными роботами. Для перемещения в 2D пространстве в качестве единственного колеса может использоваться шар, приводимый во вращение несколькими приводами. Несколько разработок подобных роботов уже существуют. Примерами могут служить шаробот разработанный в университете Карнеги — Меллона, шаробот «BallIP», разработанный в университете Тохоку Гакуин (англ. Tohoku Gakuin University)[14], или шаробот Rezero[15], разработанный в Швейцарской высшей технической школе. Роботы такого типа имеют некоторые преимущества, связанные с их вытянутой формой, которые могут позволить им лучше интегрироваться в человеческое окружение, чем это возможно для роботов некоторых других типов[16]. Существует некоторое количество прототипов сферических роботов. Некоторые из них для организации перемещения используют вращение внутренней массы[17][18][19][20]. Для перемещения по неровным поверхностям, траве и каменистой местности разрабатываются шестиколёсные роботы, которые имеют большее сцепление, по сравнению с четырёхколёсными. Ещё большее сцепление обеспечивают гусеницы. Многие современные боевые роботы, а также роботы, предназначенные для перемещения по грубым поверхностям разрабатываются как гусеничные. Вместе с тем, затруднено использование подобных роботов в помещениях, на гладких покрытиях и коврах. Примерами подобных роботов могут служить разработанный НАСА робот англ. Urban Robot («Urbie»)[24], разработанные компанией iRobot роботы Warrior и PackBot. |

Google Feedfetcher | Центр поиска Google | Документация

Feedfetcher — это то, как Google сканирует каналы RSS или Atom для подкастов Google,

Новости Google,

и пабсубхуббуб.

Feedfetcher хранит и периодически обновляет фиды, запрашиваемые пользователями приложения или

оказание услуг. В поиске Google индексируются только каналы подкастов; однако, если фид не соответствует

атом или

Спецификация RSS, это

может быть еще проиндексирован. Вот несколько ответов на наиболее часто задаваемые вопросы о том, как это

работает управляемый пользователем фидграббер.

Как запросить, чтобы Google не извлекал некоторые или все фиды моего сайта?

Когда пользователи добавляют сервис или приложение, использующее данные Feedfetcher, Google Feedfetcher пытается

получить содержимое фида, чтобы отобразить его. Поскольку запросы Feedfetcher поступают от

явное действие пользователей-людей, а не автоматизированных поисковых роботов, Feedfetcher не следует

Руководство по robots.txt.

Если ваш канал общедоступен, Google не может ограничить доступ к нему пользователей. Один

Один

Решение состоит в том, чтобы настроить свой сайт для показа сообщений об ошибках 404, 410 или других ошибок, чтобы

Агент пользователя Feedfetcher-Google .

Если ваш фид предоставлен блогом или службой хостинга сайта, пожалуйста, работайте напрямую с ним.

сервис для ограничения доступа к вашей ленте.

Как часто Feedfetcher будет получать мои фиды?

Feedfetcher не должен получать фиды с большинства сайтов в среднем чаще одного раза в час.

Некоторые часто обновляемые сайты могут обновляться чаще. Обратите внимание, однако, что из-за сети

задержки, возможно, что Feedfetcher ненадолго появится, чтобы получить ваши фиды больше

часто.

Почему Feedfetcher пытается загрузить неправильные ссылки с моего сервера или с домена,

не существует?

Feedfetcher извлекает фиды по запросу служб или приложений, установленных пользователями. это

это

возможно, пользователь запросил несуществующий URL фида.

Feedfetcher извлекает фиды по запросу служб или приложений, установленных пользователями. это

возможно, что запрос исходил от пользователя, который знает о вашем «секретном» сервере или ввел его в

по ошибке.

Почему Feedfetcher не подчиняется моему файлу robots.txt?

Feedfetcher извлекает фиды только после того, как пользователи явно запустили службу или приложение, которое

запрашивает данные из фида. Feedfetcher ведет себя как прямой агент пользователя-человека, а не как

robot, поэтому он игнорирует записи robots.txt. Поскольку Feedfetcher действует как агент для нескольких

пользователей, он сохраняет полосу пропускания, отправляя запросы на общие каналы только один раз для всех пользователей, которые

запросил фид через приложение или сервис. Общие фиды

RSS и

Атом.

Вы можете запретить Feedfetcher сканировать ваш сайт, настроив свой сервер для обслуживания 404,

410 или другое сообщение об ошибке для пользовательского агента Feedfetcher-Google .

Почему на Google.com заходят с нескольких компьютеров, и все с агентом пользователя Feedfetcher?

Feedfetcher был разработан для размещения на нескольких машинах для повышения производительности и

масштабироваться по мере роста сети. Чтобы сократить использование полосы пропускания, используемые машины часто располагаются

рядом с сайтами, которые они ищут в сети.

Не могли бы вы сообщить мне IP-адреса, с которых Feedfetcher отправляет запросы, чтобы я мог фильтровать свои

журналы?

IP-адреса, используемые Feedfetcher, время от времени меняются. Лучший способ определить

Лучший способ определить

Feedfetcher запрашивает свой пользовательский агент Feedfetcher-Google .

Почему Feedfetcher загружает одну и ту же страницу на моем сайте несколько раз?

Как правило, Feedfetcher загружает только одну копию каждого файла с вашего сайта в течение

данный поиск корма. Очень редко машины останавливаются и перезапускаются, что может

заставить его снова извлекать страницы, которые он недавно посещал.

В отличие от обычных поисковых роботов, Feedfetcher вообще не переходит по ссылкам; вместо этого следует

запросы, отправляемые ему пользователями службы или приложения, использующего Feedfetcher.

Здесь нет ответа на мой вопрос Feedfetcher. Где я могу получить дополнительную помощь?

Если у вас по-прежнему возникают проблемы, попробуйте опубликовать свой вопрос в Центре поиска.

Форум.

Поисковые роботы — 10 самых популярных

Бен Итон

Обновлено 16 декабря 2022 г.

Во всемирной паутине есть как плохие, так и хорошие боты. Вы определенно хотите избежать плохих ботов, поскольку они потребляют вашу пропускную способность CDN, занимают ресурсы сервера и крадут ваш контент. С другой стороны, с хорошими ботами (также известными как поисковые роботы) следует обращаться с осторожностью, поскольку они являются жизненно важной частью индексации вашего контента поисковыми системами, такими как Google, Bing и Yahoo. В этом сообщении блога мы рассмотрим десятку самых популярных поисковых роботов.

Что такое поисковые роботы?

Веб-сканеры — это компьютерные программы, которые методично и автоматически просматривают Интернет. Их также называют роботами, муравьями или пауками.

Поисковые роботы посещают веб-сайты и читают их страницы и другую информацию, чтобы создать записи для индекса поисковой системы. Основная цель поискового робота — предоставить пользователям полный и актуальный индекс всего доступного онлайн-контента.

Кроме того, поисковые роботы также могут собирать определенные типы информации с веб-сайтов, например контактную информацию или данные о ценах. Используя поисковые роботы, компании могут поддерживать актуальность и эффективность своего присутствия в Интернете (например, SEO, оптимизация внешнего интерфейса и веб-маркетинг).

Поисковые системы, такие как Google, Bing и Yahoo, используют сканеры для правильного индексирования загруженных страниц, чтобы пользователи могли быстрее и эффективнее находить их при поиске. Без поисковых роботов не было бы ничего, что могло бы сказать им, что на вашем сайте есть новый и свежий контент. Карты сайта также могут играть роль в этом процессе. Так что поисковые роботы, по большей части, это хорошо.

Однако иногда возникают проблемы с планированием и загрузкой, поскольку поисковый робот может постоянно опрашивать ваш сайт. И здесь в игру вступает файл robots.txt. Этот файл может помочь контролировать сканирующий трафик и гарантировать, что он не перегрузит ваш сервер.

Поисковые роботы идентифицируют себя для веб-сервера с помощью заголовка запроса User-Agent в HTTP-запросе, и каждый сканер имеет свой уникальный идентификатор. В большинстве случаев вам нужно будет просматривать журналы реферера вашего веб-сервера, чтобы просмотреть трафик поискового робота.

Robots.txt

Поместив файл robots.txt в корень вашего веб-сервера, вы можете определить правила для поисковых роботов, например разрешить или запретить сканирование определенных ресурсов. Поисковые роботы должны следовать правилам, определенным в этом файле. Вы можете применить общие правила ко всем ботам или сделать их более детализированными и указать их конкретные User-Agent строка.

Пример 1

Этот пример предписывает всем роботам поисковых систем не индексировать содержимое веб-сайта. Это определяется путем запрета доступа к корневому каталогу / вашего веб-сайта.

Агент пользователя: * Запретить: /

Пример 2

В этом примере достигается противоположность предыдущему. В этом случае инструкции по-прежнему применяются ко всем пользовательским агентам. Однако в инструкции Disallow ничего не определено, а это означает, что все может быть проиндексировано.

В этом случае инструкции по-прежнему применяются ко всем пользовательским агентам. Однако в инструкции Disallow ничего не определено, а это означает, что все может быть проиндексировано.

Агент пользователя: * Запретить:

Чтобы увидеть больше примеров, обязательно ознакомьтесь с нашим подробным сообщением о том, как использовать файл robots.txt.

10 лучших поисковых роботов и поисковых роботов

Существуют сотни поисковых роботов и поисковых роботов в Интернете, но ниже приведен список из 10 популярных поисковых роботов и поисковых роботов, которые мы собрали на основе тех, которые мы регулярно видим в логи нашего веб-сервера.

1. GoogleBot

Являясь крупнейшей в мире поисковой системой, Google использует поисковые роботы для индексации миллиардов страниц в Интернете. Googlebot — это поисковый робот, который Google использует именно для этого.

Googlebot — это два типа поисковых роботов: настольный поисковый робот, который имитирует человека, просматривающего компьютер, и мобильный поисковый робот, который выполняет те же функции, что и iPhone или телефон Android.

Строка пользовательского агента запроса может помочь вам определить подтип Googlebot. Googlebot Desktop и Googlebot Smartphone, скорее всего, будут сканировать ваш веб-сайт. С другой стороны, оба типа сканеров принимают один и тот же токен продукта (токен пользовательского агента) в файле robots.txt. Вы не можете использовать robots.txt для выборочного таргетинга Googlebot Smartphone или Desktop.

Googlebot — очень эффективный поисковый робот, который может быстро и точно индексировать страницы. Однако у него есть некоторые недостатки. Например, робот Googlebot не всегда сканирует все страницы веб-сайта (особенно если веб-сайт большой и сложный).

Кроме того, робот Googlebot не всегда сканирует страницы в режиме реального времени, а это означает, что некоторые страницы могут быть проиндексированы только через несколько дней или недель после их публикации.

Агент пользователя

Googlebot

Полный

User-Agent string

Mozilla/5.0 (совместимый; Googlebot/2.1; +http://www.google.com/bot.html)

Пример робота Googlebot в robots.txt

В этом примере несколько более подробно описаны определенные инструкции. Здесь инструкции относятся только к Googlebot. В частности, он говорит Google не индексировать определенную страницу ( /no-index/your-page.html ).

Агент пользователя: Googlebot Запретить: /no-index/your-page.html

Помимо поискового робота Google, у них есть еще 9additional web crawlers:

| Web crawler | User-Agent string |

|---|---|

| Googlebot News | Googlebot-News |

| Googlebot Images | Googlebot-Image/1.0 |

| Googlebot Видео | Googlebot-Video/1.0 |

| Google Mobile (рекомендуемый телефон) | SAMSUNG-SGH-E250/1.0 Profile/MIDP-2.0 Configuration/CLDC-1.1 UP.Browser/6.2.3.3.c. 1.101 (GUI) ) MMP/2.0 (совместимый; Googlebot-Mobile/2.1; +http://www.google.com/bot.html) 1.101 (GUI) ) MMP/2.0 (совместимый; Googlebot-Mobile/2.1; +http://www.google.com/bot.html) |

| Смартфон Google | Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, например Gecko) Chrome/41.0.2272.96 Mobile Safari/537.36 (совместимый; Googlebot/2.1; +http://www.google.com/bot.html) |

| Google Mobile Adsense | (совместимо; Mediapartners-Google/2.1; +http://www.google.com/bot.html) |

| Google Adsense | Mediapartners-Google |

| Google AdsBot (качество целевой страницы PPC) | AdsBot-Google (+http://www.google.com/adsbot.html) |

| Поисковый робот Google (получение ресурсов для мобильных устройств) | AdsBot-Google-Mobile-Apps |

Вы можете используйте инструмент Fetch в Google Search Console, чтобы проверить, как Google сканирует или отображает URL-адрес на вашем сайте. Узнайте, может ли робот Googlebot получить доступ к странице на вашем сайте, как он отображает страницу и заблокированы ли какие-либо ресурсы страницы (например, изображения или сценарии) для робота Googlebot.

Вы также можете просмотреть статистику сканирования Googlebot за день, количество загруженных килобайт и время, затраченное на загрузку страницы.

См. документацию robots.txt для робота Google.

2. Bingbot

Bingbot — это поисковый робот, развернутый Microsoft в 2010 году для предоставления информации их поисковой системе Bing. Это замена того, что раньше было ботом MSN.

Агент пользователя

Bingbot

Полный

User-Agent string

Mozilla/5.0 (совместимый; Bingbot/2.0; +http://www.bing.com/bingbot.htm)

У Bing также есть очень похожий на Google инструмент, называемый Fetch as Bingbot, в Инструментах для веб-мастеров Bing. Fetch As Bingbot позволяет запросить сканирование страницы и показать ее вам так, как ее увидит наш сканер. Вы увидите код страницы так, как его увидит Bingbot, что поможет вам понять, видят ли они вашу страницу так, как вы предполагали.

См. документацию Bingbot robots. txt.

txt.

3. Slurp Bot

Результаты поиска Yahoo поступают от поискового робота Yahoo Slurp и поискового робота Bing, так как многие Yahoo работают на базе Bing. Сайты должны разрешать доступ Yahoo Slurp, чтобы они отображались в результатах поиска Yahoo Mobile.

Кроме того, Slurp делает следующее:

- Собирает контент с партнерских сайтов для включения в такие сайты, как Yahoo News, Yahoo Finance и Yahoo Sports.

- Получает доступ к страницам сайтов в Интернете, чтобы подтвердить точность и улучшить персонализированный контент Yahoo для наших пользователей.

User-Agent

Slurp

Полный

User-Agent string

Mozilla/5.0 (совместимый; Yahoo! Slurp; http://help.yahoo.com/help/us/ysearch/slurp)

См. документацию Slurp robots.txt.

4. DuckDuckBot

DuckDuckBot — это поисковый робот для DuckDuckGo, поисковой системы, которая стала довольно популярной, поскольку известна своей конфиденциальностью и отсутствием слежки за вами. Теперь он обрабатывает более 93 миллионов запросов в день. DuckDuckGo получает результаты из разных источников. К ним относятся сотни вертикальных источников, предоставляющих нишевые мгновенные ответы, DuckDuckBot (их поисковый робот) и краудсорсинговые сайты (Википедия). У них также есть более традиционные ссылки в результатах поиска, которые они получают от Yahoo! и Бинг.

Теперь он обрабатывает более 93 миллионов запросов в день. DuckDuckGo получает результаты из разных источников. К ним относятся сотни вертикальных источников, предоставляющих нишевые мгновенные ответы, DuckDuckBot (их поисковый робот) и краудсорсинговые сайты (Википедия). У них также есть более традиционные ссылки в результатах поиска, которые они получают от Yahoo! и Бинг.

Агент пользователя

DuckDuckBot

Полный

User-Agent string

DuckDuckBot/1.0; (+http://duckduckgo.com/duckduckbot.html)

It respects WWW::RobotRules and originates from these IP addresses:

- 72.94.249.34

- 72.94.249.35

- 72.94.249.36

- 72.94.249.37

- 72.94.249.38

5. Baiduspider

Baiduspider — это официальное название паука китайской поисковой системы Baidu. Он сканирует веб-страницы и возвращает обновления в индекс Baidu. Baidu — ведущая китайская поисковая система, на долю которой приходится 80% всего рынка поисковых систем материкового Китая.

Агент пользователя

Baiduspider

Полный

User-Agent string

Mozilla/5.0 (совместимый; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)

Besides Baidu’s web search crawler, they actually have 6 additional web crawlers:

| Web crawler | User-Agent string |

|---|---|

| Image Search | Baiduspider-image |

| Video Search | Baiduspider-video |

| News Search | Baiduspider-news |

| Baidu wishlists | Baiduspider-favo |

| Baidu Union | Baiduspider-cpro |

| Business Search | Baiduspider -ads |

| Другие страницы поиска | Baiduspider |

См. документацию Baidu robots.txt.

6. Яндекс Бот

ЯндексБот — поисковый робот одной из крупнейших российских поисковых систем Яндекс.

User-Agent

ЯндексБот

Full

User-Agent string

Mozilla/5.0 (совместимый; YandexBot/3.0; +http://yandex.com/bots)

Существует множество различных строк User-Agent, которые ЯндексБот может отображать в логах вашего сервера.

7. Sogou Spider

Sogou Spider — поисковый робот для Sogou.com, ведущей китайской поисковой системы, запущенной в 2004 году.

Примечание: Веб-паук Sogou не соблюдает стандарт исключения роботов и поэтому запрещен на многих веб-сайтах из-за чрезмерного сканирования.

User-Agent

Sogou Pic Spider/3.0 (http://www.sogou.com/docs/help/webmasters.htm#07) Головной паук Sogou/3.0 (http://www.sogou.com/docs/help/webmasters.htm#07) Веб-паук Sogou/4.0 (+http://www.sogou.com/docs/help/webmasters.htm#07) Паук Sogou Orion/3.0 (http://www.sogou.com/docs/help/webmasters.htm#07) Sogou-Test-Spider/4.0 (совместимый; MSIE 5.5; Windows 98)

8.

Exabot

Exabot

Exabot — поисковый робот для Exalead, поисковой системы, базирующейся во Франции. Он был основан в 2000 году и имеет более 16 миллиардов проиндексированных страниц.

User-Agent

Mozilla/5.0 (совместимый; Konqueror/3.5; Linux) KHTML/3.5.5 (как Gecko) (Exabot-Thumbnails) Mozilla/5.0 (совместимо; Exabot/3.0; +http://www.exabot.com/go/robot)

См. документацию Exabot robots.txt.

9. Facebook external hit

Facebook позволяет своим пользователям отправлять ссылки на интересный веб-контент другим пользователям Facebook. Часть того, как это работает в системе Facebook, включает временное отображение определенных изображений или деталей, связанных с веб-контентом, таких как название веб-страницы или тег для встраивания видео. Система Facebook извлекает эту информацию только после того, как пользователь предоставит ссылку.

Одним из их основных сканирующих ботов является Facebot, предназначенный для повышения эффективности рекламы.

User-Agent

фейсбот facebookexternalhit/1.0 (+http://www.facebook.com/externalhit_uatext.php) facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php)

См. документацию Facebot robots.txt.

10. Applebot

Бренд компьютерных технологий Apple использует поисковый робот Applebot, в частности Siri и Spotlight Suggestions, для предоставления персонализированных услуг своим пользователям.

Агент пользователя

Applebot

Full

User-Agent string

Mozilla/5.0 (Device; OS_version) AppleWebKit/WebKit_version (KHTML, как Gecko) Версия/Safari_версия Safari/WebKit_версия (Applebot/Applebot_version)

Другие популярные поисковые роботы

Apache Nutch

Apache Nutch — поисковый робот с открытым исходным кодом, написанный на Java. Он выпущен под лицензией Apache и управляется Apache Software Foundation.

Nutch может работать на одной машине, но чаще используется в распределенной среде. На самом деле, Nutch был разработан с нуля, чтобы быть масштабируемым и легко расширяемым.

На самом деле, Nutch был разработан с нуля, чтобы быть масштабируемым и легко расширяемым.

Орех очень гибкий и может использоваться для различных целей. Например, Nutch можно использовать для обхода всего Интернета или только определенных веб-сайтов. Кроме того, Nutch можно настроить на индексацию страниц в режиме реального времени или по расписанию.

Одним из основных преимуществ Apache Nutch является его масштабируемость. Nutch можно легко масштабировать для обработки больших объемов данных и трафика. Например, большой веб-сайт электронной коммерции может использовать Apache Nutch для сканирования и индексации своего каталога продуктов. Это позволит клиентам искать продукты на своем веб-сайте с помощью внутренней поисковой системы компании.

Кроме того, Apache Nutch можно использовать для сбора данных о веб-сайтах. Компании могут использовать Apache Nutch для сканирования веб-сайтов конкурентов и сбора информации об их продуктах, ценах и контактной информации. Затем эта информация может быть использована для улучшения их присутствия в Интернете.

Затем эта информация может быть использована для улучшения их присутствия в Интернете.

Однако у Apache Nutch есть некоторые недостатки. Например, это может быть сложно настроить и использовать. Кроме того, Apache Nutch не так широко используется, как другие поисковые роботы, а это означает, что для него доступна меньшая поддержка.

Screaming Frog

Screaming Frog SEO Spider — это настольная программа (ПК или Mac), которая сканирует ссылки, изображения, CSS, скрипты и приложения веб-сайтов с точки зрения SEO.

Он извлекает ключевые элементы сайта для SEO, представляет их на вкладках по типам и позволяет вам фильтровать общие проблемы SEO или нарезать данные так, как вам нравится, экспортируя их в Excel.

Вы можете просматривать, анализировать и фильтровать данные сканирования по мере их сбора и извлечения в режиме реального времени с помощью простого интерфейса.

Программа бесплатна для небольших сайтов (до 500 URL). Для больших сайтов требуется лицензия.

Screaming Frog использует Chromium WRS для сканирования динамических веб-сайтов с большим количеством JavaScript, таких как Angular, React и Vue.js. Создание карты сайта WordPress, извлечение XPath и визуализация архитектуры сайта — другие важные функции.

Платформа обслуживает такие корпорации, как Apple, Amazon, Disney и даже Google. Screaming Frog также является популярным инструментом среди владельцев агентств и SEO-специалистов, которые управляют SEO для нескольких клиентов.

Deepcrawl

Deepcrawl — это облачный поисковый робот, который позволяет пользователям сканировать веб-сайты и собирать данные об их структуре, содержании и производительности.

DeepCrawl предоставляет пользователям несколько функций и опций, в том числе возможность сканировать веб-сайты на основе JavaScript, настраивать процесс сканирования и создавать подробные отчеты.

Одной из самых уникальных функций Deepcrawl является его способность сканировать веб-сайты, созданные с помощью JavaScript. Это возможно, потому что Deepcrawl использует безголовый браузер (например, Chrome) для отображения содержимого веб-сайта перед его сканированием.

Это возможно, потому что Deepcrawl использует безголовый браузер (например, Chrome) для отображения содержимого веб-сайта перед его сканированием.

Это означает, что Deepcrawl может сканировать и собирать данные о веб-сайтах, которые не всегда могут быть доступны другим поисковым роботам.

Помимо гибких API, данные Deepcrawl интегрируются с Google Analytics, Google Search Console и другими популярными инструментами. Это позволяет пользователям легко сравнивать данные своего веб-сайта с данными конкурентов. Это также позволяет им связывать бизнес-данные (например, данные о продажах) с данными своего веб-сайта, чтобы получить полное представление о том, как работает их веб-сайт.

Deepcrawl лучше всего подходит для компаний с большими веб-сайтами с большим количеством контента и страниц. Платформа менее подходит для небольших веб-сайтов или тех, которые не меняются очень часто.

Deepcrawl предлагает три разных продукта:

- Центр автоматизации. Этот продукт интегрируется с конвейером CI/CD и автоматически сканирует ваш веб-сайт с более чем 200 правилами тестирования SEO QA.

- Центр аналитики: этот продукт позволяет получать полезную информацию из данных вашего веб-сайта и улучшать SEO вашего веб-сайта.

- Концентратор мониторинга: этот продукт отслеживает изменения на вашем веб-сайте и предупреждает вас о появлении новых проблем.

Предприятия используют эти три продукта для улучшения SEO своего веб-сайта, отслеживания изменений и сотрудничества с командами разработчиков.

Octoparse

Octoparse — это удобное клиентское программное обеспечение для сканирования веб-страниц, которое позволяет извлекать данные со всего Интернета. Программа специально разработана для людей, которые не являются программистами, и имеет простой интерфейс «укажи и щелкни».

С Octoparse вы можете запускать запланированные облачные извлечения для извлечения динамических данных, создавать рабочие процессы для автоматического извлечения данных с веб-сайтов и использовать его API парсинга веб-страниц для доступа к данным.

Его прокси-серверы IP позволяют сканировать веб-сайты без блокировки, а встроенная функция Regex автоматически очищает данные.

Благодаря готовым шаблонам скрейпера вы можете начать извлекать данные с популярных веб-сайтов, таких как Yelp, Google Maps, Facebook и Amazon, за считанные минуты. Вы также можете создать свой собственный парсер, если его нет в наличии для ваших целевых веб-сайтов.

HTTrack

Вы можете использовать бесплатное ПО HTTrack для загрузки целых сайтов на свой компьютер. Благодаря поддержке Windows, Linux и других систем Unix этот инструмент с открытым исходным кодом может использоваться миллионами.

Средство копирования веб-сайтов HTTrack позволяет загружать веб-сайты на компьютер, чтобы вы могли просматривать их в автономном режиме. Программу также можно использовать для зеркалирования веб-сайтов, что означает, что вы можете создать точную копию веб-сайта на своем сервере.

Программа проста в использовании и имеет множество функций, в том числе возможность возобновлять прерванные загрузки, обновлять существующие веб-сайты и создавать статические копии динамических веб-сайтов.

Вы можете получить файлы, фотографии и HTML-код с зеркального веб-сайта и возобновить прерванную загрузку.

Хотя HTTrack можно использовать для загрузки веб-сайтов любого типа, он особенно полезен для загрузки веб-сайтов, которые больше не доступны в сети.

HTTrack — отличный инструмент для тех, кто хочет загрузить весь веб-сайт или создать его зеркальную копию. Однако следует отметить, что программу можно использовать для загрузки нелегальных копий веб-сайтов.

Таким образом, вы должны использовать HTTrack только в том случае, если у вас есть разрешение от владельца веб-сайта.

SiteSucker

SiteSucker — это приложение для macOS, которое загружает веб-сайты. Он асинхронно копирует веб-страницы сайта, изображения, PDF-файлы, таблицы стилей и другие файлы на ваш локальный жесткий диск, дублируя структуру каталогов сайта.

Вы также можете использовать SiteSucker для загрузки определенных файлов с веб-сайтов, таких как файлы MP3.

Программа может использоваться для создания локальных копий веб-сайтов, что делает ее идеальной для просмотра в автономном режиме.

Это также полезно для загрузки целых сайтов, чтобы вы могли просматривать их на своем компьютере без подключения к Интернету.

Одним из недостатков SiteSucker является то, что он не может обрабатывать Javascript (хотя может обрабатывать Flash). Тем не менее, он по-прежнему полезен для загрузки веб-сайтов на ваш Mac.

Webz.io

Пользователи могут использовать веб-приложение Webz.io для получения данных в режиме реального времени путем сканирования онлайн-источников по всему миру в различных удобных форматах. Этот поисковый робот позволяет сканировать данные и извлекать ключевые слова на нескольких языках на основе многочисленных критериев из различных источников.

Архив позволяет пользователям получать доступ к историческим данным. Пользователи могут легко индексировать и искать структурированные данные, просканированные Webhose, используя его интуитивно понятный интерфейс/API. Вы можете сохранять очищенные данные в форматах JSON, XML и RSS. Кроме того, Webz. io поддерживает до 80 языков с результатами сканирования данных.

io поддерживает до 80 языков с результатами сканирования данных.

Freemium бизнес-модель Webz.io должна подойти для предприятий с базовыми требованиями к сканированию. Для предприятий, которым требуется более надежное решение, Webz.io также предлагает поддержку мониторинга СМИ, угроз кибербезопасности, анализа рисков, финансового анализа, веб-аналитики и защиты от кражи личных данных.

Они даже поддерживают решения API даркнета для бизнес-аналитики.

UiPath

UiPath — это приложение Windows, которое можно использовать для автоматизации повторяющихся задач. Это полезно для парсинга веб-страниц, поскольку оно может автоматически извлекать данные с веб-сайтов.

Программа проста в использовании и не требует знаний в области программирования. Он имеет визуальный интерфейс перетаскивания, который упрощает создание сценариев автоматизации.

С помощью UiPath вы можете извлекать табличные данные и данные на основе шаблонов с веб-сайтов, PDF-файлов и других источников. Программу также можно использовать для автоматизации таких задач, как заполнение онлайн-форм и загрузка файлов.

Программу также можно использовать для автоматизации таких задач, как заполнение онлайн-форм и загрузка файлов.

Коммерческая версия инструмента предоставляет дополнительные возможности сканирования. При работе со сложными пользовательскими интерфейсами этот подход очень успешен. Инструмент очистки экрана может извлекать данные из таблиц как по отдельным словам, так и по группам текста, а также по блокам текста, таким как RSS-каналы.

Кроме того, вам не нужны навыки программирования для создания интеллектуальных веб-агентов, но если вы хакер .NET, вы сможете полностью контролировать их данные.

Плохие боты

Хотя большинство поисковых роботов безопасны, некоторые из них могут использоваться в злонамеренных целях. Эти вредоносные веб-сканеры, или «боты», могут использоваться для кражи информации, проведения атак и совершения мошенничества. Также все чаще обнаруживается, что эти боты игнорируют директивы robots.txt и переходят непосредственно к сканированию веб-сайтов.

Some prominent bad bots are as listed below:

- PetalBot

- SEMrushBot

- Majestic

- DotBot

- AhrefsBot

Protecting your site from malicious web crawlers

To protect your website from bad bots, you can use брандмауэр веб-приложений (WAF) для защиты вашего сайта от ботов и других угроз. WAF — это часть программного обеспечения, которое находится между вашим веб-сайтом и Интернетом и фильтрует трафик до того, как он попадет на ваш сайт.

CDN также может помочь защитить ваш сайт от ботов. CDN — это сеть серверов, которые доставляют контент пользователям в зависимости от их географического положения.

Когда пользователь запрашивает страницу с вашего веб-сайта, CDN направляет запрос на сервер, ближайший к местоположению пользователя. Это может помочь снизить риск атаки ботов на ваш сайт, поскольку им придется нацеливаться на каждый сервер CDN в отдельности.

У KeyCDN есть отличная функция, которую вы можете включить на своей панели инструментов, которая называется «Блокировка плохих ботов».

Создаются также роботы, имеющие другое число колёс — два или одно. Такого рода решения позволяют упростить конструкцию робота, а также придать роботу возможность работать в пространствах, где четырёхколёсная конструкция оказывается неработоспособна.

Создаются также роботы, имеющие другое число колёс — два или одно. Такого рода решения позволяют упростить конструкцию робота, а также придать роботу возможность работать в пространствах, где четырёхколёсная конструкция оказывается неработоспособна.

Роботов подобного типа называют англ. spherical orb robots, англ. orb bot[21] и англ. ball bot[22][23].

Роботов подобного типа называют англ. spherical orb robots, англ. orb bot[21] и англ. ball bot[22][23]. 0 (совместимый; Googlebot/2.1; +http://www.google.com/bot.html)

0 (совместимый; Googlebot/2.1; +http://www.google.com/bot.html)