Содержание

Хокинг: искусственный интеллект — угроза человечеству

- Рори Кехлан-Джонс

- Би-би-си

Подпишитесь на нашу рассылку ”Контекст”: она поможет вам разобраться в событиях.

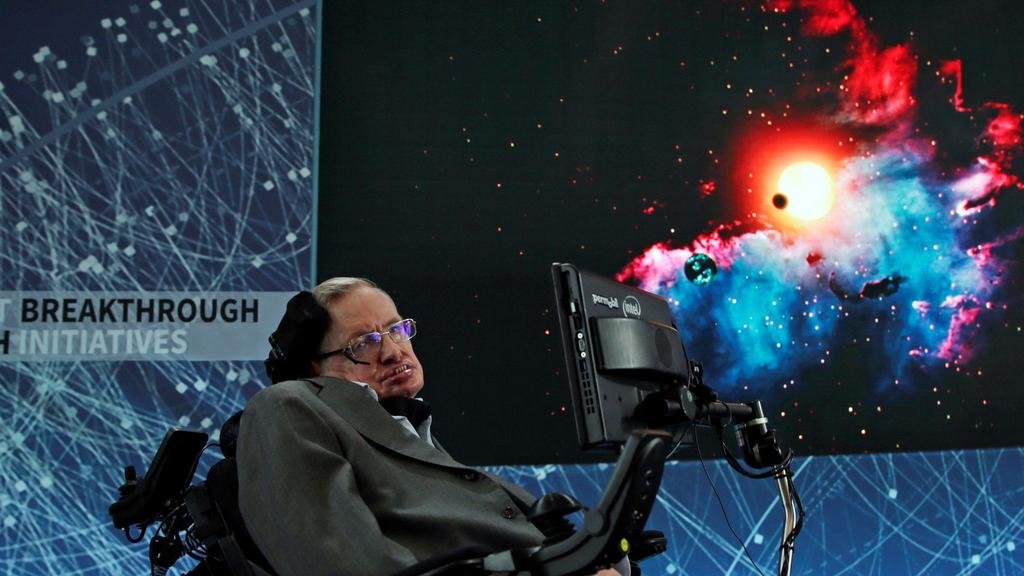

Автор фото, Getty

Подпись к фото,

Будет ли искусственный интеллект нашим другом или нашим врагом?

Профессор Стивен Хокинг, один из самых уважаемых и известных британских ученых, заявил, что усилия по созданию мыслящих машин могут привести к тому, что само существование человечества окажется под угрозой.

В интервью Би-би-си он отметил, что «появление полноценного искусственного интеллекта может стать концом человеческой расы».

Это апокалиптическое предсказание прозвучало в ответ на вопрос о новой технологии, которой профессор пользуется для общения с внешним миром.

К счастью, далеко не все верят в такие мрачные перспективы.

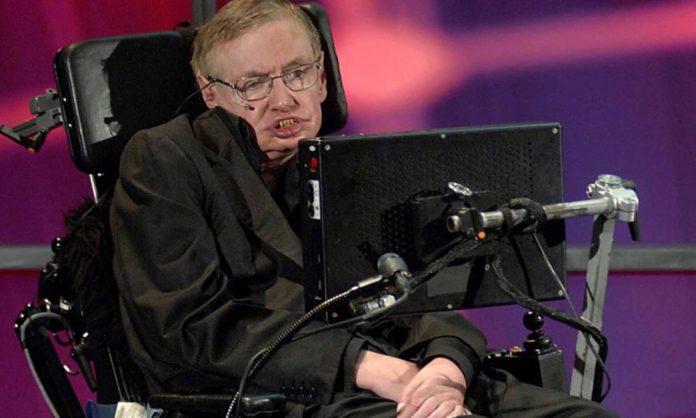

Подпись к фото,

Стивен Хокинг опасается, что в однажды машины превзойдут своих создателей

Профессор Хокинг, страдающий латеральным амиотрофическим склерозом, для передачи речи пользуется специальной системой, разработанной американской компанией Intel.

В создании оборудования для Хокинга принимали участие и эксперты по обучению искусственного интеллекта из британской компании Swiftkey. Их технология, уже применяемая в клавиатуре смартфонов, «изучает» ход мыслей профессора и предлагает слова, которые тот мог бы употребить в следующей фразе.

Опасны ли нам роботы?

Стивен Хокинг отметил, что примитивные формы искусственного интеллекта, уже существующие на сегодняшний день, доказали свою полезность, но он опасается, что человечество создаст что-то такое, что превзойдет своего создателя.

Пропустить Подкаст и продолжить чтение.

Подкаст

Что это было?

Мы быстро, просто и понятно объясняем, что случилось, почему это важно и что будет дальше.

эпизоды

Конец истории Подкаст

«Такой разум возьмет инициативу на себя и станет сам себя совершенствовать со все возрастающей скоростью. Возможности людей ограничены слишком медленной эволюцией, мы не сможем тягаться со скоростью машин и проиграем», — сказал Хокинг.

Однако далеко не все придерживаются такой пессимистической точки зрения.

«Я думаю, что мы останемся хозяевами создаваемых нами технологий еще очень и очень долгое время, и они помогут нам решить многие мировые проблемы», — так считает Ролло Карпентер, создатель веб-приложения Cleverbot.

Программное обеспечение Cleverbot хорошо зарекомендовало себя в так называемом тесте Тьюринга. Суть теста Тьюринга заключается в следующем: может ли человек, общающийся с другим человеком и компьютером, на основании ответов на вопросы определить, в каком случае его собеседником является человек, а в каком — машина. Задача компьютера – так подстроиться под человеческую логику, чтобы его было невозможно распознать.

Cleverbot сумел обмануть немало людей, успешно сымитировав ход человеческой мысли.

Восстание машин

Автор фото, alamy

Подпись к фото,

В фильме Стэнли Кубрика «2001 год: Космическая Одиссея» взбунтовавшийся компьютер ставит под угрозу жизни астронавтов

Ролло Карпентер полагает, что до создания необходимых алгоритмов, которые приведут к появлению полноценных искусственных интеллектов, остается еще несколько десятилетий.

«Мы не можем с уверенностью сказать, что произойдет, когда машины превзойдут нас интеллектом. Следовательно, мы не можем предсказать, и как они поведут себя: станут ли они нам помогать, нас игнорировать или же рано или поздно нас уничтожат», — полагает он.

Однако Карпентер все-таки склонен считать, что искусственный интеллект окажется позитивной силой.

При этом профессор Хокинг не одинок в своем пессимистическом видении будущего.

Есть опасения, что в краткосрочной перспективе машины, обученные выполнять грязную механическую работу, лишат людей миллионов рабочих мест.

Автор фото, Getty

Подпись к фото,

Предприниматель и основатель частного космического агентства Элон Маск тоже опасается, что компьютеры могут стать угрозой нашему существованию

А в более отдаленном будущем машины могут стать основной угрозой нашему существованию, опасается инженер и предприниматель, основатель космической компании SpaceX Элон Маск.

Компьютерная речь

В интервью Би-би-си профессор Хокинг также затронул выгоды и опасности интернета.

Он процитировал слова директора Британского центра по контролю за коммуникациями (GCHQ) Роберта Ханнигана, который предупредил, что интернет становится командным центром для террористических организаций.

«Интернет-компании должны сделать больше для противодействия этой угрозе. Однако сложность заключается в том, чтобы при этом не пострадали ни свобода, ни право на личную жизнь», — предупредил Ханниган, а вслед за ним повторил и профессор Хокинг.

При этом прославленный ученый с большим энтузиазмом высказался о создании новых коммуникативных технологий, который позволят, например, ему самому писать гораздо быстрее.

Его собственный, генерируемый компьютером «голос» ни разу не менялся, несмотря на все инновационные технологии.

Сам Хокинг признает, что этот голос имеет слегка искусственное, механическое звучание, но отказывается менять его на что-то более естественное.

«Он стал моей визитной карточкой, и я ни за что не поменяю его на более «живой» голос с британским акцентом», — сказал он.

«Мне рассказывали, что когда больным детям требуется компьютерный голос, они просят, чтобы он звучал так же, как и мой», — отмечает Хокинг.

Хокинг рассказал о «новой форме жизни» на базе искусственного интеллекта — РБК

www.adv.rbc.ru

www. adv.rbc.ru

adv.rbc.ru

www.adv.rbc.ru

Скрыть баннеры

Ваше местоположение ?

ДаВыбрать другое

Рубрики

Курс евро на 6 октября

EUR ЦБ: 58,06

(+1,89)

Инвестиции, 05 окт, 16:23

Курс доллара на 6 октября

USD ЦБ: 59,4

(+0,61)

Инвестиции, 05 окт, 16:23

Facebook усовершенствовала алгоритмы подбора контента в лентах

Life, 15:20

В Москве судью попытались подкупить за ₽300 тыс.

Общество, 15:18

Как улучшить здравоохранение в России за счет медицинского туризма

Партнерский проект, 15:15

www. adv.rbc.ru

adv.rbc.ru

www.adv.rbc.ru

Минобороны сообщило о наступлении в ДНР и взятии поселка Зайцево

Политика, 15:14

Эксперты оценили падение спроса на новостройки Москвы и области за год

Недвижимость, 14:54

Politico узнало, что Украина пересмотрела просьбы к Западу по оружию

Политика, 14:54

Призер ОИ пообещала вернуться из Китая через год

Спорт, 14:53

Объясняем, что значат новости

Вечерняя рассылка РБК

Подпишитесь за 99 ₽ в месяц

Любые цифры и буквы: как водителям выделиться необычным автономером

Партнерский проект, 14:52

Лукашенко запретил рост цен в Белоруссии

Политика, 14:50

Ушедшего в отставку главу Нацбанка Украины обвинили в хищениях

Общество, 14:45

Главный тренер сборной России оценил перспективы Овечкина в сезоне НХЛ

Спорт, 14:44

Классика 60/40: как лучше сформировать портфель, когда рынки штормит

Pro, 14:42

Военная операция на Украине. Главное

Главное

Политика, 14:37

В Херсоне сообщили об обстреле ВСУ Антоновского моста

Политика, 14:36

www.adv.rbc.ru

www.adv.rbc.ru

www.adv.rbc.ru

Британский ученый-физик Стивен Хокинг заявил, что машины на основе искусственного интеллекта заменят людей и станут «новой формой жизни». Он также призвал развивать технологии и науку, чтобы колонизировать планеты

Стивен Хокинг

(Фото: Francois Lenoir / Reuters)

Профессор Стивен Хокинг считает, что наделенные искусственным интеллектом (ИИ) машины в скором времени могут стать «новой формой жизни» и полностью заменят людей. Об этом он рассказал в своем интервью журналу Wired.

«Я опасаюсь, что искусственный интеллект скоро сможет вообще заменить людей», — заявил знаменитый британский ученый-физик.

По словам Хокинга, если сейчас люди создают компьютерные вирусы, недалек тот день, когда кто-нибудь разработает искусственный интеллект, «который улучшает и воспроизводит сам себя». По его мнению, это будет «новая форма жизни, которая превзойдет людей».

Ученый считает, что человечество должно уделить самое серьезное внимание науке и бросить силы на разработку новой космической программы, которая позволит в конечном итоге колонизировать подходящие для проживания людей планеты.

«Я считаю, мы достигли точки невозврата. Земля становится слишком маленькой для нас, население растет с угрожающей скоростью, и мы подвергаемся опасности самоуничтожения», — сказал Хокинг.

Ранее о том, что развитие искусственного интеллекта является «фундаментальной угрозой» человечеству, заявил основатель SpaceX и Tesla Илон Маск. По его словам, ни ДТП, ни авиакатастрофы, ни отсутствие лекарств или некачественная еда не способны сравниться по уровню опасности с развитием ИИ.

Маск, известный своими призывами к невмешательству государственных властей в бизнес, даже призвал ввести госконтроль за внедрением таких технологий.

Сам Хокинг ранее высказывался об ИИ не столь радикально, хотя и отмечал, что в перспективе искусственный интеллект сможет превзойти человеческий.

В октябре прошлого года, во время открытия центра изучения будущего интеллекта «Леверхульм» в Кембридже, ученый заявил, что не видит глубокой разницы между тем, что может быть достигнуто биологическим мозгом и с помощью компьютера. Поэтому, считает профессор, компьютеры могут подражать человеческому интеллекту и даже превзойти его.

Хокинг также отмечал, что предсказать, к чему приведет создание искусственного интеллекта и его соединение с человеческим разумом, невозможно.

«Короче говоря, появление мощного ИИ будет либо лучшим, либо худшим, что когда-либо случалось с человечеством», — заявил тогда ученый, отметив, что технология сможет как уничтожить, так и радикально изменить общество.

В этом году Стивену Хокингу исполнилось 75 лет. Журнал Wired поместил фотографию знаменитого ученого на обложку своего декабрьского номера.

Стивен Хокинг: создание ИИ станет «либо лучшим, либо худшим» событием в истории человечества

Истории

21 декабря 2016

Истории

21 декабря 2016

Алексей Зеньков

Редактор направления Истории

Алексей Зеньков

В Кембриджском университете создан институт для изучения будущего искусственного интеллекта. По этому поводу известный физик-теоретик Стивен Хокинг рассказал, какое будущее ожидает человечество в эру ИИ.

Алексей Зеньков

Профессор Стивен Хокинг предупредил, что создание мощного искусственного интеллекта «станет либо лучшим, либо худшим событием в истории человечества», и поприветствовал создание научной организации, которая будет заниматься исследованием перспектив искусственного интеллекта как «критически важного вопроса для будущего нашей цивилизации и нашего вида».

Стивен Хокинг на открытии Центра будущего интеллекта имени Леверхалма в среду. Фото: Крис Радберн/PA

Хокинг выступал в Кембриджском университете на церемонии открытия Центра будущего интеллекта имени Леверхалма (LCFI) – междисциплинарного института, сотрудники которого попытаются найти ответы на некоторые из открытых вопросов, поднятых в ходе стремительного развития технологий ИИ.

«Мы посвящаем очень много времени изучению истории, – сказал Хокинг. – Которая, давайте взглянем правде в глаза, по большей части является историей глупости. Так что людям пойдет на пользу вместо этого изучать будущее интеллекта».

Так что людям пойдет на пользу вместо этого изучать будущее интеллекта».

Хотя знаменитый физик всегда настороженно относился к ИИ и заявлял, что человечество рискует и может стать архитектором собственного конца, если создаст сверхинтеллект с независимой волей, он также быстро нашел положительные стороны изучения ИИ.

«Сложно переоценить потенциальные преимущества создания интеллекта, – сказал он. – Мы не может предугадать, чего сможем достичь, если наш разум будет усилен ИИ. Возможно, плоды этой новой технологической революции помогут нам возместить ущерб, нанесенный природе в ходе предыдущей революции – индустриализации. Кроме того, можно будет по-новому взглянуть на решение проблем болезней и бедности».

Хув Прайс – академический директор Центра. Фото: Джон Тонкс

«Наша жизнь изменится во всех аспектах. Говоря короче, успех в создании ИИ может стать важнейшим событием в истории нашей цивилизации».

Хув Прайс, академический директор Центра и профессор философии Кембриджского университета, где Хокинг тоже носит звание академика, заявил, что его организация появилась отчасти благодаря работе Центра экзистенциальных рисков. Этот институт, который таблоиды окрестили «местом изучения Терминаторов», занимается более широким диапазоном проблем, в то время как сфера интересов LCFI имеет достаточно узкую сферу интересов.

Этот институт, который таблоиды окрестили «местом изучения Терминаторов», занимается более широким диапазоном проблем, в то время как сфера интересов LCFI имеет достаточно узкую сферу интересов.

«Мы пытаемся избавиться от этих ассоциаций с «терминаторами», – говорит Прайс. – Но, как и их прототип, они возвращаются снова и снова».

Пионер ИИ, профессор когнитивных наук в Университете Сассекса Маргарет Боден тоже одобряет развитие подобных дискуссий. Еще в 2009 году она отмечала, что эту тему не воспринимают всерьез даже сами исследователи ИИ. «Сфера искусственного интеллекта крайне увлекательна, – считает она – но у нее есть ограничения, которые могут превратиться в смертельные угрозы, если мы не подойдем к делу критически».

О потенциальных опасностях ИИ наравне с его преимуществами говорят не только в научном сообществе. Свои опасения по поводу вреда, который искусственный сверхинтеллект может нанести человечеству, выражали и многие лидеры технологической отрасли, в том числе предприниматель Илон Маск.

Источник

Материалы по теме:

Что произойдет с чат-ботами и искусственным интеллектом в ближайшие два года?

Искусственный интеллект охраняет тебя. Почему вы всегда в безопасности, заказывая Uber

Специалист по нейронаукам рассказывает о будущем со сверхчеловеческим интеллектом

Финансируемый Илоном Маском стартап создает «полицию искусственного интеллекта»

- Искусственный интеллект

- Технологии

Нашли опечатку? Выделите текст и нажмите Ctrl + Enter

Материалы по теме

1

Мошенники с начала года украли криптовалюты более чем на $2,3 млрд

2

Предложение сделать транзакции в Ethereum обратимыми разделило криптосообщество на два лагеря

3

Китайская версия блокчейна.

Как в стране, где запрещены криптовалюты, готовят специалистов будущего

Как в стране, где запрещены криптовалюты, готовят специалистов будущего4

Вместо Web 3.0 у нас будет Web 2.5 — что тормозит переход к новому интернету

5

Сохранить стабильность: как крупный бизнес сегодня преодолевает вызовы с помощью данных

ВОЗМОЖНОСТИ

06 октября 2022

PSB TECH HACK

09 октября 2022

«Будущее авиации 2022»

09 октября 2022

«Программирование на Python»

Все ВОЗМОЖНОСТИ

Новости

ФАС проверит маркетплейсы и ритейлеров после жалоб о завышенных ценах на армейское снаряжение

Новости

Менеджеры пунктов выдачи пожаловались на новые штрафы Wildberries за бракованный товар

Новости

Павел Дуров в очередной раз посоветовал пользователям «держаться подальше от WhatsApp»

Новости

«Авито» запустил выкуп телефонов у своих пользователей

Колонки

Как переводить деньги в Европу из России в 2022 году?

Стивен Хокинг предупредил об опасностях искусственного интеллекта, но ИИ дал ему голос

Покойный Стивен Хокинг был главным голосом в дебатах о том, какую пользу человечество может извлечь из искусственного интеллекта. Хокинг не скрывал своих опасений, что однажды мыслящие машины смогут взять на себя управление. Он дошел до того, что предсказал, что будущие разработки в области ИИ «могут означать конец человеческой расы».

Хокинг не скрывал своих опасений, что однажды мыслящие машины смогут взять на себя управление. Он дошел до того, что предсказал, что будущие разработки в области ИИ «могут означать конец человеческой расы».

Но отношения Хокинга с ИИ были гораздо сложнее, чем это часто цитируемое высказывание. Глубокие опасения, которые он выразил, касались сверхчеловеческого ИИ, точки, в которой системы ИИ не только воспроизводят процессы человеческого интеллекта, но и продолжают расширять их без нашей поддержки — этап, который в лучшем случае наступит через десятилетия, если он вообще когда-либо произойдет. И все же сама способность Хокинга сообщать об этих страхах и всех других его идеях стала зависеть от базовой технологии искусственного интеллекта.

Противоречивые отношения Хокинга с ИИ

В центрах права интеллектуальной собственности и здравоохранения Университета ДеПола мы с коллегами изучаем влияние новых технологий, подобных тем, о которых беспокоился Стивен Хокинг. По своей сути, концепция ИИ включает в себя вычислительную технологию, предназначенную для того, чтобы машины функционировали с предвидением, которое имитирует и, в конечном счете, превосходит процессы человеческого мышления.

Хокинг предостерег от крайней формы ИИ, при которой мыслящие машины «взлетают» сами по себе, модифицируя себя и независимо проектируя и создавая все более совершенные системы. Люди, связанные медленным темпом биологической эволюции, были бы трагически перехитрины.

ИИ как угроза человечеству?

Задолго до того, как он дойдет до уровня сверхчеловеческих технологий, ИИ может найти ужасное применение. Ученые и комментаторы уже обеспокоены тем, что беспилотные летательные аппараты могут быть предшественниками смертоносных автономных роботов.

Сегодняшняя ранняя стадия искусственного интеллекта также поднимает несколько других этических и практических проблем. Системы ИИ в значительной степени основаны на непрозрачных алгоритмах, которые принимают решения, которые даже их собственные разработчики не могут объяснить. Лежащие в основе математические модели могут быть необъективными, и могут возникать вычислительные ошибки. ИИ может постепенно вытеснять человеческие навыки и увеличивать безработицу. А ограниченный доступ к ИИ может увеличить глобальное неравенство.

А ограниченный доступ к ИИ может увеличить глобальное неравенство.

Столетнее исследование искусственного интеллекта, начатое Стэнфордским университетом в 2014 году, выявило некоторые из этих опасений. Но пока не обнаружено никаких доказательств того, что ИИ будет представлять какую-либо «неминуемую угрозу» человечеству, как опасался Хокинг.

Тем не менее, взгляды Хокинга на ИИ несколько менее паникерские и более нюансированные, чем ему обычно приписывают. По своей сути они описывают необходимость понимания и регулирования новых технологий. Он неоднократно призывал к дополнительным исследованиям преимуществ и опасностей ИИ. И он считал, что даже не сверхчеловеческие системы искусственного интеллекта могут помочь искоренить войны, бедность и болезни.

Хокинг говорит

Это явное противоречие — страх перед тем, что человечество в конечном итоге будет вытеснено ИИ, но в то же время оптимизм по поводу его преимуществ — возможно, исходит из его собственной жизни: Хокинг привык полагаться на ИИ для взаимодействия с миром.

Не говоря уже с 1985 года, он использовал ряд различных коммуникационных систем, которые помогали ему говорить и писать, кульминацией чего стал ставший уже легендарным компьютер, управляемый одним мускулом на его правой щеке.

Первая версия компьютерной программы была невыносимо медленной и подверженной ошибкам. Очень простой ИИ изменил это. Программа с открытым исходным кодом значительно ускорила его выбор слов. Что еще более важно, он использовал искусственный интеллект для анализа собственных слов Хокинга, а затем использовал эту информацию, чтобы помочь ему выразить новые идеи. Обрабатывая книги, статьи и сценарии лекций Хокинга, система стала настолько хороша, что ему даже не нужно было вводить термин, который люди больше всего ассоциируют с ним, «черная дыра». Когда он выбирал «the», «черный» автоматически предлагался следовать за ним, а «черный» предлагал «дыру» на экране.

Стивен Хокинг обсуждает систему прогнозирования, которая помогла ему общаться.

ИИ улучшает здоровье людей

Опыт Стивена Хокинга с такой базовой формой ИИ показывает, как не сверхчеловеческий ИИ действительно может изменить жизнь людей к лучшему. Прогнозирование речи помогло ему справиться с разрушительным неврологическим заболеванием. Другие системы на основе ИИ уже помогают предотвращать болезни, бороться с ними и облегчать их бремя.

Например, ИИ может анализировать медицинские датчики и другие данные о состоянии здоровья, чтобы предсказать вероятность развития у пациента тяжелой инфекции крови. В исследованиях он был значительно более точным — и давал гораздо больше заблаговременных предупреждений — чем другие методы.

Другая группа исследователей создала программу искусственного интеллекта для просмотра электронных медицинских карт 700 000 пациентов. Программа под названием «Глубокий пациент» выявила связи, которые не были очевидны врачам, идентифицировала новые модели риска для некоторых видов рака, диабета и психических расстройств.

ИИ даже привел в действие роботизированную хирургическую систему, которая превзошла хирургов-людей в процедуре на свиньях, которая очень похожа на один тип операции на пациентах-людях.

ИИ так много обещает улучшить здоровье людей, что сбор медицинских данных стал краеугольным камнем как разработки программного обеспечения, так и политики общественного здравоохранения в США. миллион американцев. Данные будут доступны системам искусственного интеллекта для анализа при изучении новых методов лечения, что потенциально улучшит как диагностику, так и выздоровление пациентов.

Все эти преимущества ИИ доступны прямо сейчас, и в разработке находятся другие. Они предполагают, что сверхчеловеческие системы искусственного интеллекта могут быть чрезвычайно мощными, но, несмотря на предупреждения Хокинга и его коллеги-технолога Илона Маска, этот день может никогда не наступить. А пока, как знал Хокинг, можно многое выиграть. ИИ дал ему лучший и более эффективный голос, чем его тело могло обеспечить, с которым он призывал как к исследованиям, так и к сдержанности.

Стивен Хокинг предупреждает, что искусственный интеллект может положить конец человечеству

Опубликовано

комментарии

Комментарии

Это видео не может быть воспроизведено в вашем браузере, вам необходимо включить JavaScript

3 Для воспроизведения этого видео в вашем браузере

3.

Заголовок в СМИ,

Стивен Хокинг: «Люди, которые ограничены медленной биологической эволюцией, не могут конкурировать и будут вытеснены»

Рори Селлан-Джонс

Корреспондент по технологиям

Профессор Стивен Хокинг, один из выдающихся британских ученых, сказал, что усилия по созданию мыслящих машин представляют угрозу самому нашему существованию.

Он сказал Би-би-си: «Развитие полноценного искусственного интеллекта может означать конец человеческой расы».

Его предупреждение пришло в ответ на вопрос об обновлении технологии, которую он использует для общения, которая включает в себя базовую форму ИИ.

Но другие менее мрачны в отношении перспектив ИИ.

Физик-теоретик, страдающий боковым амиотрофическим склерозом (БАС) с болезнью двигательных нейронов, использует для речи новую систему, разработанную Intel.

К его созданию также привлекались специалисты по машинному обучению из британской компании Swiftkey. Их технология, уже используемая в качестве приложения для клавиатуры смартфона, изучает ход мыслей профессора и предлагает слова, которые он, возможно, захочет использовать в следующий раз.

Профессор Хокинг говорит, что примитивные формы искусственного интеллекта, разработанные до сих пор, уже оказались очень полезными, но он опасается последствий создания чего-то, что может сравниться с людьми или превзойти их.

Источник изображения, ALAMY

Подпись к изображению,

Фильм Стэнли Кубрика «2001» и его смертоносный компьютер HAL воплощают в себе опасения многих людей по поводу того, что ИИ может представлять угрозу для человеческой жизни. » он сказал.

» он сказал.

Источник изображения, Cleverbot

Подпись к изображению,

Cleverbot — это программа, предназначенная для общения, как человек

«Люди, которые ограничены медленной биологической эволюцией, не могут конкурировать и будут вытеснены».

Другие настроены менее пессимистично.

«Я верю, что мы будем владеть этой технологией еще довольно долго, и ее потенциал для решения многих мировых проблем будет реализован», — сказал Ролло Карпентер, создатель Cleverbot.

Программное обеспечение Cleverbot учится на своих прошлых разговорах и набрало высокие баллы в тесте Тьюринга, обманывая большую часть людей, заставляя их поверить, что они разговаривают с человеком.

Восстание роботов

Г-н Карпентер говорит, что мы еще далеки от вычислительной мощности или разработки алгоритмов, необходимых для создания полноценного искусственного интеллекта, но полагает, что это произойдет в ближайшие несколько десятилетий.

«Мы не можем точно знать, что произойдет, если машина превзойдет наш собственный интеллект, поэтому мы не можем знать, будет ли она бесконечно помогать нам, или она будет игнорироваться и оттеснена на обочину, или предположительно будет уничтожена ею», — говорит он. .

Но он делает ставку на то, что ИИ станет положительной силой.

Профессор Хокинг не одинок в своих опасениях за будущее.

В краткосрочной перспективе есть опасения, что умные машины, способные выполнять задачи, которые до сих пор выполняли люди, быстро уничтожат миллионы рабочих мест.

Источник изображения, Getty Images

Подпись к изображению,

Илон Маск, исполнительный директор производителя ракет Space X, также опасается искусственного интеллекта «.

Роботизированный голос

В своем интервью Би-би-си профессор Хокинг также говорит о преимуществах и опасностях Интернета.

Он цитирует предупреждение директора GCHQ о том, что сеть становится командным центром террористов: «Интернет-компании должны сделать больше, чтобы противостоять угрозе, но трудность заключается в том, чтобы сделать это, не жертвуя свободой и конфиденциальностью».

Однако он с энтузиазмом освоил все виды коммуникационных технологий и надеется, что сможет писать намного быстрее с помощью своей новой системы.

Подпись к изображению,

Профессор Хокинг использует новое программное обеспечение для речи, но решил сохранить прежний голос

Но один аспект его собственной технологии — его компьютерный голос — не изменился в последнем обновлении.

Профессор Хокинг признает, что это немного роботизированный голос, но настаивает на том, что ему не нужен более естественный голос.

«Это стало моей торговой маркой, и я бы не стал менять его на более естественный голос с британским акцентом», — сказал он.

«Мне сказали, что дети, которым нужен компьютерный голос, хотят такой, как мой.»

Воспроизведение этого видео невозможно

Для воспроизведения этого видео необходимо включить JavaScript в вашем браузере.

Медиа-заголовок,

Профессор Мюррей Шанахан представляет тему искусственного интеллекта

BBC не несет ответственности за содержание внешних сайтов.

Стивен Хокинг предупреждает об искусственном интеллекте, изменении климата и сверхлюдях

У Стивена Хокинга есть заключительное послание человечеству: если нас не поймают роботы, это сделает климат.

Хокинг, который умер в возрасте 76 лет от дегенеративного неврологического заболевания в начале этого года, предлагает свои прощальные мысли в посмертно опубликованной книге под названием Краткие ответы на большие вопросы , которая выходит во вторник. Это сообщение человека, который, вероятно, является самым известным ученым со времен Эйнштейна, наиболее известным своим открытием того, как функционируют черные дыры. Книга Хокинга Краткая история времени была продана тиражом более 10 миллионов экземпляров и затрагивала такие важные вопросы, как «Как возникла Вселенная?» и «Что будет, когда это закончится?» языком, достаточно простым для среднего читателя.

В выдержке, опубликованной в лондонской Times на выходных, он весел и оптимистичен, хотя и предупреждает нас, что искусственный интеллект, скорее всего, перехитрит нас, что богатые обязательно превратятся в сверхчеловеческий вид и что планета стремительно приближается к полной обитаемости.

Книга Хокинга, в конечном счете, является приговором будущему человечества. На первый взгляд, вердикт таков, что мы обречены. Но копните глубже, и здесь есть еще кое-что: вера в то, что человеческая мудрость и новаторство предотвратят наше собственное разрушение, даже если мы, кажется, одержимы его осуществлением.

Роботы могут прийти за нами

Самым большим предупреждением Хокинга является рост искусственного интеллекта: это будет либо лучшее, что когда-либо случалось с нами, либо худшее. Если мы не будем осторожны, это вполне может оказаться последним.

Искусственный интеллект открывает перед человечеством большие возможности, охватывая все: от алгоритмов Google до беспилотных автомобилей и программного обеспечения для распознавания лиц. Однако ИИ, который у нас есть сегодня, все еще находится в своем девятом возрасте.0167 примитивные этапы. Эксперты беспокоятся о том, что произойдет, когда этот интеллект опередит нас. Или, как выразился Хокинг: «В то время как краткосрочное влияние ИИ зависит от того, кто его контролирует, долгосрочное воздействие зависит от того, можно ли его вообще контролировать».

Это может звучать как научная фантастика, но Хокинг говорит, что отвергнуть это как таковое «было бы ошибкой, и, возможно, нашей самой большой ошибкой».

По сравнению с роботами мы, люди, довольно неуклюжи. Ограниченные медленным темпом эволюции, нам требуются поколения для итерации. Роботы, с другой стороны, могут намного быстрее улучшать свой собственный дизайн, и вскоре они, вероятно, смогут делать это без нашей помощи. Хокинг говорит, что это приведет к «интеллектуальному взрыву», в котором машины смогут превзойти наш интеллект «намного больше, чем наш превосходит интеллект улиток».

Многие люди думают, что угроза ИИ заключается в том, что он становится злонамеренным, а не доброжелательным. Хокинг избавляет нас от этой озабоченности, говоря, что «реальный риск с ИИ — не злой умысел, а компетентность». По сути, ИИ будет очень хорош в достижении своих целей; если люди встанут на пути, у нас могут быть проблемы.

«Возможно, вы не злой муравьед, наступающий на муравьев из злого умысла, но если вы отвечаете за гидроэнергетическую зеленую энергетику, а поблизости есть муравейник, который нужно затопить, очень плохо для муравьи. Давайте не будем ставить человечество на место этих муравьев», — пишет Хокинг.

Давайте не будем ставить человечество на место этих муравьев», — пишет Хокинг.

Для тех, кто еще не убежден, он предлагает другую метафору. «Почему мы так беспокоимся об ИИ? Конечно, люди всегда могут выдернуть вилку из розетки?» — спрашивает его гипотетический человек.

Хокинг отвечает: «Люди спрашивали у компьютера: «Есть ли Бог?» И компьютер говорил: «Сейчас есть», и переваривал вилку».

Конец жизни на земле?

Если дело не в роботах, то «почти неизбежно, что либо ядерная конфронтация, либо экологическая катастрофа нанесут вред Земле в какой-то момент в ближайшие 1000 лет», — пишет Хокинг.

Его предупреждение последовало за тревожным отчетом Межправительственной группы экспертов по изменению климата (МГЭИК) на прошлой неделе, предупреждающим, что у нас есть только 12 лет, чтобы внести изменения, достаточно масштабные, чтобы удержать глобальное потепление на умеренном уровне. Без таких изменений длительные засухи, более частые тропические штормы и повышение уровня моря будут только началом.

Безудержное изменение климата представляет собой самую большую угрозу для нашей планеты, говорит он, и мы действуем с «безрассудным безразличием к нашему будущему на планете Земля».

На самом деле, у нас может вообще не быть будущего, говорит он, предупреждая нас не класть все яйца «в одну корзину». И да, эта корзина — планета Земля. По его словам, даже если люди найдут способ спастись, «миллионы видов, населяющих Землю», будут обречены. «И это будет на нашей совести как расы».

Еще одно предупреждение не менее грозно. Мы вступаем в новую фазу «самосозданной эволюции». Этот этап означает, что вскоре мы сможем сбросить цепи традиционной эволюции и начать изменять и улучшать нашу собственную ДНК сейчас, а не через сотни тысяч лет.

Как и в случае с ИИ, способность редактировать нашу собственную ДНК может решить самые большие проблемы человечества. Во-первых, и, вероятно, не в отдаленном будущем, мы сможем исправлять генетические дефекты, редактируя гены таких вещей, как мышечная дистрофия и боковой амиотрофический склероз, или БАС, болезнь, которую ему поставили в 1963 году. Хокинг говорит, что в рамках этого века, мы сможем редактировать интеллект, память и продолжительность жизни. И вот тогда все может стать по-настоящему сложным.

Хокинг говорит, что в рамках этого века, мы сможем редактировать интеллект, память и продолжительность жизни. И вот тогда все может стать по-настоящему сложным.

Хокинг называет людей, которые будут это делать, «сверхлюдьми», и они, вероятно, будут состоятельной мировой элитой. Обычные старые люди не смогут конкурировать и, вероятно, «вымрут или станут неважными». В то же время сверхлюди, вероятно, будут «колонизировать другие планеты и звезды».

Если все это звучит довольно удручающе, так оно и есть. Но даже несмотря на то, что Хокинг преподносит апокалиптический прогноз для планеты и всех ее обитателей, его фирменный оптимизм прорывается наружу. Он верит, что «наша изобретательная раса найдет способ вырваться из угрюмых оков Земли и, следовательно, переживет катастрофу».

Он даже считает, что эти возможности не пугают, а волнуют и «значительно увеличивают шансы вдохновить нового Эйнштейна. Где бы она ни была».

Выяснение пути за пределы планеты Земля и, возможно, даже из Солнечной системы — это возможность сделать то, что сделали высадки на Луну: «возвысить человечество, объединить людей и нации, открыть новые открытия и новые технологии».

Как в стране, где запрещены криптовалюты, готовят специалистов будущего

Как в стране, где запрещены криптовалюты, готовят специалистов будущего