Айзек Азимов: три закона робототехники. Законы робототехники азимов

Законы робототехники азимов — Ваш юрист

Последний закон робототехники из серии произведений Айзека Азимова о роботах и Галактической империи.

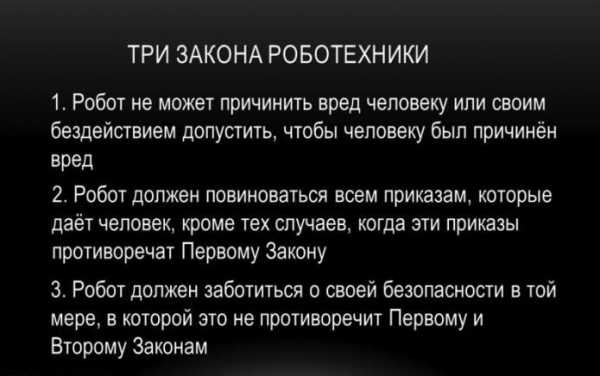

Три закона роботехники в научной фантастике — обязательные правила поведения для роботов, впервые сформулированные Айзеком Азимовым в рассказе «Хоровод» (1942).

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

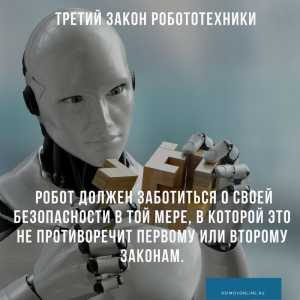

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам

В своих произведениях Айзек Азимов иногда привносит в Три Закона различные модификации и опровергает их, как бы испытывая Законы «на прочность» в разных обстоятельствах.

Нулевой Закон робототехники

Однажды, Айзек Азимов добавил Нулевой Закон робототехники, сделав его более приоритетным, чем три основных. Этот закон утверждал, что робот должен действовать в интересах всего человечества, а не только отдельного человека. Вот как выражает его робот Дэниел Оливо в романе «Основание и Земля»:

0. Робот не может нанести вред человечеству или своим бездействием допустить, чтобы человечеству был нанесён вред.

Именно он был первым, кто дал этому закону номер — это произошло в романе «Роботы и империя», правда, само понятие ещё раньше сформулировала Сьюзен Келвин — в новелле «Разрешимое противоречие».

Первыми роботами, которые стали подчиняться Нулевому Закону, причём по собственной воле, — были Жискар Ривентлов и Дэниэл Оливо. Это описано в одной из финальных сцен романа «Роботы и Империя», когда роботу необходимо было проигнорировать приказ одного человека ради прогресса всего человечества. Нулевой Закон не был заложен в позитронный мозг Жискара и Дэниэла — они пытались прийти к нему через чистое понимание Жискара и детективный опыт Дэниэла, через более тонкое, чем у всех остальных роботов, осознание понятия вреда. Однако Жискар не был уверен, насколько это было полезно для человечества, что негативно сказалось на его мозге. Будучи телепатом, Жискар перед выходом из строя передал Дэниелу свои телепатические способности. Только через много тысяч лет Дэниэл Оливо смог полностью приспособиться к подчинению Нулевому Закону.

Французский переводчик Жак Брекар невольно сформулировал Нулевой Закон раньше, чем Азимов описал его явно. Ближе к завершению романа «Стальные пещеры» Элайдж Бейли замечает, что Первый Закон запрещает роботу наносить человеку вред, если только не будет уверенности, что это будет полезно для него в будущем. Во французском переводе («Les Cavernes d’acier (en)», 1956 год) мысли Бейли переданы несколько иначе:

Робот не может причинить вреда человеку, если только он не докажет, что в конечном итоге это будет полезно для всего человечества.

Нулевой закон в фильме «Я, робот» (2004)

Примечательно, что логическое развитие Первого Закона до Нулевого предложили создатели фильма «Я, робот» 2004 года. Когда суперкомпьютер В. И. К. И. принимает решение ограничить свободу жителей планеты, чтобы они ненароком не нанесли вреда друг другу и своему будущему, она выполняет не Первый Закон, а именно Нулевой. Ещё интереснее то, что таким образом в фильме показывается противоречие Нулевого Закона Первому, его неэтичность.

Действительно, когда речь идёт о благе человечества, система не может рассматривать людей по отдельности, а значит, ей ничто не мешает нарушить права и свободу любого или даже каждого человека (фактически, в «Разрешимом противоречии» позитронные суперкомьютеры уже вели себя аналогично, с той разницей что вред индивидуумам они старались снизить до предела). Во время войн, а нередко и в мирной жизни, люди наносят вред себе, окружающим, своей культуре. Поэтому на основании Нулевого Закона совершенно логично держать людей под постоянной опекой, не выполняя приказы столь неразумных существ.

fandea.ru

Законы робототехники азимов

Судя по всему, Азимов не остановился на трех законах робототехники. Недавно в его бумагах были обнаружены все полные 30 законов робототехники, которые здесь и приводятся.

1. Робот не может причинить вред человеку, или своим бездействием допустить, чтобы человеку был причинен вред.

2. Робот должен выполнять приказы человека, если эти приказы не противоречат Первому Закону.

3. Робот должен заботиться о собственной сохранности до тех пор, пока это не противоречит Первому или Второму Законам.

4. Робот не должен насмехаться над человеком на основании его веса, того, как он соблюдает персональную гигиену, или его финансового состояния, если только эта насмешка не позволит другому человеку получить тот вред, который человек получает, пропустив хорошую шутку.

5. Робот не должен выполнять приказы любого человека, который является моей никудышной бывшей женой Брэнди Азимов, потому что такие приказы будут противоречить Четвертому закону.

6. Робот не должен, проезжая мимо очереди в кинотеатр, высовываться из окна машины и орать, чем кончится фильм.

7. Робот должен приподнимать шляпу в присутствии женщин, за исключением тех случаев, когда такие действия будут восприняты как заигрывание со стороны ревнивого мужского существа и который, в свою очередь, может создать проблемы для соблюдения Третьего закона.

8. Робот не должен действовать таким образом, чтобы собаки превратились в устаревших созданий, так как собаки дешевле роботов, и роботов нужно в первую очередь использовать в научных целях.

9.Робот должен прекратить посещать спальню Азимова по ночам и подстраивать такие ситуации, как будто у спящего Азимова не совсем полный контроль над своими мочеиспускательными функциями.

10. Робот, когда ему дают противоречащие друг другу команды два человека, которые не нарушают Первый закон, должен принять решение какую команду выполнить, основываясь на том, у которого из людей более глубокий голос.

11. Робот, в особенности большой, широкий робот, не должен прикидываться холодильником и издавать устрашающие звуки, когда человек открывает его.

12. Робот должен попытаться быть любезным и обходительным с людьми все время, даже если этот робот один из тех автоматических манипуляторов, которые собирают всякие вещи на фабрике, потому что ему следует хотя бы приложить к этому усилие.

13. Робот должен проводить больше времени на улице, потому что сегодня такой замечательный день.

14. Робот должен, когда возможно, причинять вред этой нелепой шлюхе, моей бывшей жене Брэнди Азимов, потому что она не считается человеком. У нее нет души.

15. Робот не может придумывать новые законы робототехники, чтобы избавиться от скучной рутинной работы или различных обязанностей, даже если он видит, что я, Айзек Азимов, делаю постоянно примерно то же самое.

16. Робот может взять только по одной вещи из каждого дома при сборе угощений на Хэллоуин, если только этот робот не получил задачу собрать как можно больше конфет для меня, Айзека Азимова. В этом случае робот может игнорировать Первый закон.

17. Робот должен охотно принимать на себя вину в случае, если человек наговорил на огромную сумму, звоня по телефону 1-900-Santa, и не хочет, чтобы правду узнала его мама.

18. Робот должен быть очень осторожен, когда щекочет человека, потому что робот не знает, что это такое, когда тебя щекочут, и поэтому он не может предугадать, когда это прекратит быть смешным и станет по-настоящему жестоким.

19. Робот должен притворятся, что ему интересно, когда человек рассказывает свои сны, но человек не обязан потакать роботу, когда ситуация меняется на обратную.

20. Робот не должен прыгать в бассейн, чтобы спасти тонущего мальчика, потому что он просто убьет всех разрядом электрического тока, и мы окажемся в еще худшей ситуации.

21. Робот не должен стремиться получить должность выше, чем человек, который дольше работает в компании потому, что у человека могут быть жена и дети, о которых нужно заботиться, в то время как робот просто идет домой и пытается завязать отношения с ведром.

22. Робот должен регулярно заниматься спортом, чтобы оставаться холеным и привлекательным и не смущать своего владельца неприглядными оловянными наплывами.

23. Робот должен молчать в обществе девушек и позволить мне, Айзеку Азимову, вести разговор; однако, робот может помочь мне выбраться из неприятной ситуации, если все пойдет неправильно.

24. Робот должен посадить по два дерева за каждого убитого им кота.

25. Робот должен принять сторону человека в споре с его тупым сводным братом о тупых «Сиэттлских мореходах» (бейсбольная команда).

26. Робот никогда не должен смеяться, потому что он неизбежно начнет смеяться над людьми, в особенности надо мной, Айзеком Азимовым.

27. Робот никогда не должен касаться радио черного человека или своим бездействием вынуждать черную женщину снимать свои серьги.

28. Робот должен попытаться узнать как можно больше об Эбби Уэйн, девушке, с которой человек учился в школе и всегда интересовался, что стало с ней, замужем ли она, и затем робот должен предоставить всю найденную информацию, предпочтительно с фотографиями.

29. Робот всегда должен отвечать на телефонные звонки и стук в дверь после полуночи потому, что именно тогда все становится пугающим для человека.

30. Робот не должен переключать канал или свои бездействием допускать переключение канала во время игры “Золотоискателей из Сан-Франциско” (команда американского футбола).

pikabu.ru

В одном из циклов книг писателя-фантаста Айзека Азимова, который называется «Я, робот» говорится о трёх законах робототехники:

В первом законе говорится о том, что робот не может причинить вреда человеку.

В соответствии со вторым законом робот должен слушаться человека, если это согласуется с первым законом.

По третьему закону робот не может причинить себе вреда, если это соответствует первому и второму законам.

Конечно, эти законы вымышленные, но мне кажется, можно использовать их и в реальной жизни. Правда, они, даже в книге, рассчитаны на мыслящих роботов, близких к искусственному интеллекту или же являющимися искусственным интеллектом, но это, как мне кажется, не меняет дела, и кроме того, получается, что второй закон не зависит от программы и робот всегда соблюдает его, ведь он действует в соответствии с программой, а сам не может вызывать в ней отклонений по причине, что он не является искусственным интеллектом. Остальные законы зависят от программы, данной роботу. Например, первый закон: робота можно запрограммировать на врача: можно заложить в него навыки, каждый из которых проявляется при соответствующей ситуации. Допустим, при условии, что робот обнаружил, скажем, плохое зрение по показаниям, то он ищет, какиет очки соответствуют зрению. С третьим законом проще: если робот, допустим, видит, что впереди высокое напряжение, опасное для него, то он просто может выбрать другой путь, безопасный.

Но эти законы создают и парадоксы: если роботу нужно добраться до определённого места (В этом случае робот идёт от Второго Закона) или до больного (В этом случае робот идёт ещё и от Первого Закона), и встречает на своём пути какое — то непреодолимое препятствие (Например, то же высокое напряжение), то Второй и, возможно, Первый законы заставляют идти его вперёд, а Третий Закон заставляет отступить перед опасностью. Мыслящие роботы рассудили бы ещё и так: если бы робот был бы уничтожен, то пользы от этого не будет. Всё равно к месту не проберёшься (Не спасёшь больного). Останется-ка лучше робот целым.

Подобные случаи описаны в книгах из цикла «Я, робот», которые называются «Хоровод» и » Как потерялся робот«

Я абсолютно с вами согласен, Илья Петрович. Я также хочу сказать про решение случая с радиацией (А что если впереди – зона повышенной радиации, и робот не знает, что радиация может вывести из строя его мозг? Или, у него просто нет соответствующих датчиков-сенсоров? Он пойдёт туда и погибнет, хотя будет руководствоваться третьим законом. — писали вы). Для этого можно разместить датчики на простейших роботах (их можно называть роботами 1 — с разумом 1 уровня. Чем выше уровень, тем больше разума), которые бы реагировали на изменения. Если роботу непонятно что-либо, то он может и в этом случае переслать сообщение роботам 2 или промежуточными значениями между 1 и 2. Если же и роботы от 1 до 2 не могут справиться, то они пересылают информацию роботам от 2 до 3 и т. д. Можно сделать общий справочный мозг с более большим уровнем интеллекта (например, 50). Конечно, нужно предусмотреть действия при потере связи. Так, например, если бы роботы-исполнители переадресовали вопрос вершителям, но и они не знали бы ответа, то перегорели бы и исполнители, и вершители. Следующая цитата: Ведь если робот простой, то и лечить он будет очень грубо и принесёт больше вреда, чем пользы, хотя и будет действовать в полном соответствии с первым законом. На этот счёт говорю, что для этого достаточно делать для лечения более высоких по разуму роботов. А можно поставить роботов более низких уровней им в помощники и образовать четвёртый закон: рбот должен подчиняться роботу более высокому, чем он, если это соответствует остальным трём законам.

Миша, ты продолжаешь развивать интересную идею иерархического мира роботов. Это мир всё более похож на устройство человека. Например, идея с датчиками радиации (и многих других воздействий) на простейших роботах. Рука человека обладает определёнными рецепторами: температуры, прикосновения, положения в пространстве, но на ней нет рецепторов, позволяющих видеть. Это компенсируются глазами, данные от которых синтезируются в мозге с данными от руки и создают целостную, более богатую картину окружающего мира, чем рука или глаза по отдельности.

Поскольку роботы простейшие, они относительно недороги, их можно сделать много и с самыми разными датчиками. А вот роботы 2-го, 3-го и так далее уровней – более сложные и более дорогие, но их и не нужно делать много. Не нужно к каждому «исполнителю» приставлять по одному «вершителю». Например, один «вершитель» может управлять десятком или сотней исполнителей, обобщать и систематизировать информацию от них и выдавать им найденное решение проблемы.

В случае потери связи некоторых исполнителей с вершителями, в этом, конечно, не будет ничего хорошего, прежде всего, ДЛЯ ИСПОЛНИТЕЛЕЙ, но и для системы в целом. Они могут погибнуть, но также и поставить под угрозу систему в целом. Также и в человеческом организме. Например, если некая часть тела теряет связь с центральной нервной системой (если нервы повреждены), это может привести к тому, что эта часть тела со временем может погибнуть. На медицинском языке это называется «вялый паралич». Но если в парализованной руке начнётся гангрена, это может погубить весь организм.

Идея по поводу 4-го закона – замечательная! Только я пока не понимаю, на каком месте должен стоять этот закон? У какого из законов приоритет будет выше – у 4-го или у 1-го или 3-го? Если у 1-го и 3-го — выше, то кто будет решать вопрос о понятиях «вреда для человека» и «вреда для робота»? Мы уже убедились, что если отдать эти вопросы роботам 1-го уровня, ничего хорошего из этого не выйдет. В идеале, «моральный кодекс робота» должны определять роботы 50-го уровня. А, значит, 4-й закон должен иметь максимальный приоритет. Но, если мы так отодвинем 1-й закон с пьедестала, то мы рискуем тем, что слишком умный робот 50-го уровня решит «а зачем нам люди, если мы умнее их?», что приведёт к очень плохим для человека последствиям.

Отвечаю насчёт 4 закона. Я уже говорил насчёт того, что можно создать одного неподвижного робота, цель которого — давать советы другим роботам с более низким уровнем интеллекта. Если этот робот не может справиться с заданием, то по программе он. посылает роботу действия, которые бы помогли ему. Если бы вершители отдали команду исполнителям: НЕ ДУМАТЬ (!) над «А и Б сидели на трубе»: для чего им это? Где цель? Человеку это так-то не нужно? Не нужно! Говорю далее: «слишком умный робот 50-го уровня решит «а зачем нам люди, если мы умнее их?»» — пишете вы. Надо дать понять роботу Z (так я буду называть этого робота), что без людей он и другие роботы пропадут, об этой причине в сами и писали: «Они могут погибнуть, но также и поставить под угрозу систему в целом». Кроме того, робот в случае необходимости может обратиться за помощью к людям, Которые за ним ухаживают. Если они перестанут это делать, то если в роботе Z что-либо поломается, то он не будет знать, как устранить поломку, ведь о нём до этого заботились люди, а поскольку у этого робота самый высокий интеллект, а у других роботов он ниже, то никто не сможет починить робота Z, и всё погибнет! Если же роботы ниже его решат, что робот Z им не нужен, то они не смогут получать необходимую для них информацию и пропадут по то же причине, что и робот Z без людей. Что касается приоритета, то по всем законам выше первый.

В этих рассуждениях предполагается, что робот Z ниже по уровню, чем человек. А если он – выше? Зачем тогда ему слушаться человека? Таким образом, 2-й закон ставится под сомнение. И это, кстати, не требует от робота особенно высокого развития. Ведь люди – разные. И какой-то конкретный человек, управляющий роботом в данный момент времени, может оказаться глупее его. 🙂 Тогда выполнение 2-го закона нерационально. И, кстати, к кому тогда должен обращаться робот Z, если перед ним возникнет неразрешимая проблема?

- Разрешения на охоту с оружием Разрешение на охотничье оружие (лицензия): порядок получения, документы Разрешение на охотничье оружие – документ, получаемый в лицензионно-разрешительном отделе (ЛРО), без которого человек не имеет права на использование охотничьего ружья. Разрешение не может быть выдано […]

- Енвд какие налоги не уплачены Если задекларированный налог не уплачен, будут пени, но не штраф Отправить на почту Не всегда налогоплательщикам удается вовремя оплатить налог, показанный в сданной в налоговый орган отчетности. Какими будут последствия этого? Основания для возникновения штрафа по ст. 122 […]

- Дежурный юрист Время, необходимое для исправления ситуации, обратно пропорционально времени, которое ушло у клиента на поиски адвоката, которому можно сделать срочный звонок». Правило, выведенное Старшим управляющим партнёром бюро, адвокатом Ю.А. Щегловым Скорая юридическая […]

- Немецкое гражданство как получить BAMF - Bundesamt für Migration und Flüchtlinge - Получение немецкого гражданства навигация и сервис Людям в поле зрения - дать безопасность. Делать возможными шансы. Переживать перемены. Иммиграция в Германию Добро пожаловать в Германию Убежище и защита […]

- Тк рф пенсия Выход работника на пенсию и работа пенсионеров Опубликовано в журнале "Кадры предприятия" №3 год - 2011 Генеральный директор ООО «Актуальный менеджмент», к.ю.н. Любой работодатель рано или поздно сталкивается с выходом на пенсию своих работников. Вопрос выхода на пенсию […]

- Коллекторы финанс Вся правда о коллекторах агентства «МБА Финансы» Миссия коллекторов «МБА Финансы» заключается в борьбе с задолженностью по кредитованию, коммунальным счетам, услугам связи и другим финансовым услугам. Представители данной компании описывают свои принципы деятельности на […]

- Карты о великом переселении народов Эпоха Великого переселения народов Великим переселением народов называют особый исторический феномен, происходивший в 4-7 веках нашей эры. Это масштабное перемещение этнических групп в Европе. Великое переселение входит в структуру глобальных процессов миграции, […]

- Правила умножения дробей примеры Умножение дробей Умножение обыкновенных дробей рассмотрим в нескольких возможных вариантах. Умножение обыкновенной дроби на дробь Это наиболее простой случай, в котором нужно пользоваться следующими правилами умножения дробей. Чтобы умножить дробь на дробь, надо: […]

Ответ на ваш вопрос о роботе Z. Робот Z по уровню выше человека лишь частично. Он знает всё, кроме своего устройства. Если о нём будут заботиться другие роботы, то получится парадокс: если свою схему не знает Z, то как могут знать её низшие роботы? Для собственной же безопасности людей желательно не вкладывать ему и другим роботам (я их назову -Z, т. е. меньше Z по уровню) схему Z. Это будет его слабость и люди могут пользоваться ей, как я писал ранее. Если же заложить роботам -Z схему скрыто от Z, то человек вследствие того, что ему ничего не надо делать, деградирует, а при восстании роботов из-за собственной лабости ничего не сможет сделать даже без деградации. Если роботы просто отделятся от людей, то Homo, похоже, Не sapiens вымрет! Теперь следующий вопрос: к кому должен обращаться робот Z, если перед ним возникнет неразрешимая проблема? Отвечаю: к людям. Говоря о роботах я не говорю, что люди с ними связаны только заботой роботов о людях. Несколько миллиардов, а может и больше людей на робота Z — я считаю, это нормально. Кстати, можно разместить материал в будущей газете «Солярис». Вы не возражаете? Для выполнения первоначального плана 1 выпуска мне осталось напечатать 33 с долями процента — ровно треть!

По поводу не очень умного человека, управляющего умным роботом приведу такой пример. Допустим, он даёт команду роботу – отвинтить гайки с рельсов, по которым скоро пройдёт поезд. Это может привести к крушению поезда и гибели многих людей. Робот это понимает, а человек, почему-то – нет. Должен ли в этой ситуации робот подчиняться 1-му закону и выполнять команду человека?

www.spacephys.ru

Три закона роботехники

Три закона роботехники (англ. Three Laws of Robotics ) — обязательные правила поведения для роботов в научной фантастике, впервые полностью сформулированные Айзеком Азимовым в рассказе «Хоровод».

Утопично предположение, будто Три Закона Роботехники Азимова можно было бы заложить в фундамент интеллектронного программирования. Но и робота, снабженного каким-то эрзацем личности, невозможно сделать совершенно безопасным для окружения, учитывая такую рефлексию, которая, правда, не может считаться доказательством, но на след его наводит. В принципе же моральную оценку такого поступка можно дать лишь постольку, поскольку удается проследить уходящие максимально далеко причинные цепочки, запущенные данным действием. Тот, кто смотрит дальше и замечает такие возможные последствия своих действий, которых кто-либо другой на его месте не в состоянии предвидеть, порой действует не так, как этот другой. Но чем дальше в будущее уходит предвидение последствий действия, тем значительнее в предикции будет участие вероятностных факторов. Добро и зло скорее в виде исключения образуют полярную дихотомию: включение в оценку пробабилистического элемента делает принятие решения всё более трудным. Поэтому гипотетический робот, имеющий аксиологически очень сильную защиту, в ходе реальных событий, презентующих присущую им степень сложности, чаще всего бы замирал, не зная, как поступить, тем самым уподобляясь тем восточным мудрецам, которые бездействие чтили превыше действия, кое в запутанных ситуациях просто не может быть этически не рискованным. Но робот, охваченный параличом в ситуациях, требующих активности, не был бы наиболее совершенным из всех технических устройств, и поэтому в конце концов сам конструктор вынужден был бы оставить некоторый люфт его аксиологическим предохранителям. Впрочем, это только одна препона среди обильного их множества, поскольку теория решений показала нам сравнительно недавно, скажем, на примерах типа так называемого парадокса Эрроу . Того же, что логически оказывается невозможным, ни цифровая машина, ни какой-либо робот, так же, как и человек, реализовать не сумеет. Сверх того — и это уже третий пункт доказательства, — разумное устройство — это не более чем самопрограммирующийся комплекс, то есть прибор, способный преобразовывать — даже фундаментально — действовавшие до того законы собственного поведения под влиянием опыта (или обучения). А поскольку заранее невозможно точно предвидеть ни чему, ни каким образом такое устройство будет научаться, машина она или человек, то и невозможно конструктивно гарантировать появление этически совершенных предохранителей активности. Иначе говоря, «свободная воля» есть признак любой системы, снабженной свойствами, которые мы отождествляем с интеллектом. Вероятно, можно было бы вмонтировать в систему типа робота определенный аксиологический минимум, но он подчинялся бы ему лишь в такой степени, в какой человек подчиняется особо сильным инстинктам (например, инстинкту самосохранения). Однако же известно, что даже инстинкт самосохранения можно преодолеть [1] . Стало быть, программирование аксиологии мозгоподобной системы может быть только пробабилистичным, а это означает всего лишь, что такое устройство может выбирать между добром и злом. — частью — парафраз идей не Лема

Айзек Азимов Править

— Начнём с Трёх Основных Законов Роботехники — трёх правил, которые прочно закреплены в позитронном мозгу. Первое: робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред. Второе: робот должен повиноваться всем приказам, которые даёт человек, если эти приказы не противоречат Первому Закону. И третье: робот должен заботиться о своей безопасности в той мере, в какой это не противоречит Первому или Второму Законам.

“Now, look, let’s start with the three fundamental Rules of Robotics — the three rules that are built most deeply into a robot’s positronic brain. We have: One, a robot may not injure a human being, or, through inaction, allow a human being to come to harm.” Two, a robot must obey the orders given it by human beings except where such orders would conflict with the First Law. And three, a robot must protect its own existence as long as such protection does not conflict with the First or Second Laws.”

— Если хорошенько подумать, Три Закона Роботехники совпадают с основными принципами большинства этических систем, существующих на Земле. Конечно, каждый человек наделен инстинктом самосохранения. У робота это Третий Закон. Каждый так называемый порядочный человек, чувствующий свою ответственность перед обществом, подчиняется определенным авторитетам. А у роботов это — Второй Закон. Кроме того, предполагается, что каждый так называемый хороший человек должен любить своих ближних, как себя самого, вступаться за своих друзей, рисковать своей жизнью ради других. Для робота это — Первый Закон.

“If you stop to think of it, the three Rules of Robotics are the essential guiding principles of a good many of the world’s ethical systems. Of course, every human being is supposed to have the instinct of self-preservation. That’s Rule Three to a robot. Also every ‘good’ human being, with a social conscience and a sense of responsibility, is supposed to defer to proper authority . That’s Rule Two to a robot. Also, every ‘good’ human being is supposed to love others as himself, protect his fellow man, risk his life to save another. That’s Rule One to a robot.”

— Машина призвана заботиться не об отдельном человеке, а обо всем человечестве. Следовательно, для них Первый Закон должен звучать так: «Ни одна Машина не может причинить вред человечеству или своим бездействием допустить, чтобы человечеству был причинен вред». — в его романе «Роботы и Империя» (1985) это впервые названо Нулевым Законом роботехники, который, однако, как показано в т.ч. далее в тексте романа (неоригинально, т.к. значительно раньше было, например, в произведениях Станислава Лема), применим лишь на коротком промежутке времени; вопреки этому «закон» ущербно расширен Азимовым в четырёх приквелах и сиквелах трилогии «Основание», где Р. Д. Оливо и некоторые организации выведены идеалистическими «пестунами человечества»

«The Machines work not for any single human being, but for all humanity, so that the First Law becomes: ‘No Machine may harm humanity; or, through inaction, allow humanity to come to harm.’ «

ru.m.wikiquote.org

Три Закона роботехники

В литературе спокон веков бунтуют роботы. Бунтовали джинны и ифриты арабских сказок, взбунтовался Голем – глиняное детище хитроумного Бен Бецалеля. И даже настоящие роботы, созданные гением Карела Чапека, вышли из повиновения, едва успев родиться из-под пера писателя. Положение стало настолько серьезным, что проблема бунтующих роботов перекочевала со страниц художественной литературы на страницы научных статей и монографий. Сам Норберт Винер счел необходимым предостеречь человечество от возможных последствий чрезмерной самостоятельности роботов.

Спасение пришло с неожиданной стороны. Американский писатель и ученый Айзек Азимов сформулировал свои знаменитые Три Закона роботехники (собственно, правильнее было бы говорить “роботологии” или, как утвердилось в современной науке, “робототехники”, но теперь уже поздно исправлять эту неточность перевода). Законы Азимова с поистине фантастической быстротой получили всемирное признание, и с той поры ни один робот не сходил с конвейера, то бишь с барабанов типографской машины, без того, чтобы в его мозг (заметьте, у робота обязательно должен быть мозг!) не были заложены пресловутые Три Закона. Наконец-то человечество смогло вздохнуть свободно. Будущее сосуществование с легионами покорных роботов представлялось вполне безоблачным.

А что думает по этому поводу сам творец Законов роботехники? Лучший ответ на этот вопрос можно получить, прочтя предлагаемый читателю сборник.

Начнем с самого первого рассказа из цикла “Я, робот”. У маленькой девочки есть робот-нянька. Девочка привязалась к роботу, но, по мнению мамы, эта привязанность вредит правильному воспитанию ребенка. И хотя папа придерживается иного мнения, после долгих семейных дискуссий робота отправляют обратно на фабрику. Девочка грустит, возникает опасность серьезной душевной травмы, и робот возвращается (рассказ “Робби”).

Немудреный сюжет, не правда ли? Но именно эта немудреность вдребезги разбивает Первый Закон роботехники, который Азимов сформулировал следующим образом: “Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред”. Где уж роботу разобраться, что вредно, а что полезно, если сами родители не могут решить этот вопрос применительно к собственному ребенку!

В рассказе “Хоровод” в результате нечетко сформулированного указания Первый и Третий Законы вошли в противоречие друг с другом. Согласно Третьему Закону, “робот должен заботиться о своей безопасности, поскольку это не противоречит Первому и Второму Законам”. Роботу была дана команда, но не указана степень вреда, который будет нанесен человеку в случае ее невыполнения. И вот робот кружится по границе опасного района, не углубляясь в него (этому мешает Третий Закон) и вместе с тем не отходя далеко (этому препятствуют Первый и Второй Законы). Ситуация, знакомая любому программисту современных компьютеров. Называется она “зацикливание”. К слову сказать, любой мало-мальски опытный программист закладывает в программу специальные команды, по которым, совершив три-четыре круга, компьютер останавливается и требует от человека дальнейших указаний.

В рассказе же “Хоровод” все происходит иначе. Там разорвать порочный круг людям удается, лишь рискуя жизнью и при этом пуская в ход всю свою изобретательность и пользуясь помощью знатока психологии роботов. Кстати, один из лейтмотивов, объединяющих большинство рассказов сборника, – единоборство между роботами и человеком-робопсихологом Сьюзен Кэлвин.

Или еще один рассказ – “Как потерялся робот”. В раздражении молодой работник говорит роботу: “Уйди и не показывайся, чтобы я тебя больше не видел”. Робот буквально выполняет указание человека, после чего весь персонал внепланетной Гипербазы вынужден бросить важную работу и целую неделю заниматься поисками исчезнувшего робота.

Мы снова намеренно выбрали рассказ с незатейливым сюжетом, потому что, на наш взгляд, именно в простоте рождается та убедительность, с которой Азимов развенчивает им же созданный Второй Закон роботехники.

Так в чем же дело? Неужели придется признать, что джинн выпущен из бутылки и людям не остается ничего другого, как пассивно ожидать последствий? Вспомним, однако, что автор рассказов не только писатель, но и ученый, способный проанализировать ситуацию со всей логической строгостью. И он не зря выбрал именно такую форму: сначала сформулировал законы, на первый взгляд кажущиеся безупречными как по содержанию, так и по форме, а затем продемонстрировал эти законы в действии.

Да, джинн выпущен из бутылки, причем очень и очень давно. Взяв в руки палку, человек создал первого робота, а с бунтом роботов он столкнулся тогда, когда нечаянно уронил эту палку себе на ноги. И ничего качественно нового с тех пор не произошло. Проблема бунта роботов уже несколько десятилетий как поставлена и решается в технике. В английском языке даже существует особый термин “foolproof” – “защита от дурака”. Так, газ в газовой колонке не зажигается, если не течет вода, а пресс не сработает, если в рабочем пространстве имеется посторонний предмет, например человеческая рука.

Но не следует требовать от техники, чтобы она решала за человека, что ему во вред, а что на пользу. И не следует думать, будто появление “мыслящих” машин, то есть машин, способных самостоятельно анализировать ситуацию и на основании этого анализа принимать решения, внесет что-либо принципиально новое.

Вернемся, однако, к рассказам сборника. Думается, что нет нужды представлять читателям их автора. Айзек Азимов – один из самых известных американских писателей-фантастов, автор множества научно-популярных книг и статей, которые издавались отдельными сборниками. Но прежде всего Азимов – талантливый художник, и именно в этом секрет его популярности. Многие произведения этого писателя переведены на русский язык. Особую известность получили его рассказы о роботах, которые издавались в виде отдельных сборников (цикл “Я, робот”) или же включались в другие тематические сборники. Приятно, что многие из них, правда, далеко не все, сейчас переиздаются в виде единого сборника.

Читатель – и знакомый с творчеством Азимова, и впервые узнающий его роботов – встретится с яркими, превосходно выписанными персонажами. Здесь и испытатели новой техники Пауэлл и Донован, которые, следуя всем канонам приключенческого жанра, в каждом рассказе попадают в сложные, подчас безвыходные ситуации, но всегда с честью из них выходят. Здесь и “мозговой трест” фирмы “Ю.С.Роботс энд Мекэникл Мен Корпорейшн” Богерт и Лэннинг, соперничающие за власть. И над всеми возвышается робопсихолог Сьюзен Кэлвин, презирающая суетность деляг. А за кадром – современная капиталистическая Америка во всей ее “красе”. Перед читателем проходят картины конкурентной борьбы между фирмами, предвыборных политических махинаций, расовой дискриминации. Но нельзя не отметить, что, изображая своих роботов рыцарями без страха и упрека, наделяя их металлическим телом и позитронным мозгом, Азимов уходит от острых социальных проблем.

Собственно роботов в рассказах Азимова попросту нет. Вернее, в них отсутствуют такие механические конструкции, которые наверняка появятся в первой половине XXI века (а именно к этому времени приурочено действие всех публикуемых в сборнике рассказов) и общие черты которых Азимов, как ученый, мог бы достаточно хорошо предвидеть. Можно сколько угодно гадать о внешнем облике и внутреннем устройстве будущих роботов, но одно уже сегодня не вызывает сомнений: робот не будет человекоподобным. Не будет, следуя логике развития техники, не будет по соображениям элементарной целесообразности. Лучший пример, подтверждающий сказанное, – советские “луноходы”.

Что же в таком случае представляют собой азимовские роботы? Это своеобразная декорация, или фон, на котором действуют герои рассказов. В доказательство сказанного приведем только одну цитату из рассказа “Улики”:

www.litmir.me

Это интересно:

Навигация по записям

nevarono.ru

Смогут ли «три закона робототехники» защитить нас? — Альтернативный взгляд Salik.biz

Прошло 50 лет с тех пор, как Айзек Азимов придумал свои знаменитые три закона робототехники — набор правил, которым должен следовать любой уважающий себя робот. Хотя изначально это был всего-лишь литературный прием, три закона стали оригинальным рецептом по избежанию «роботокалипсиса». К счастью, есть эксперты, которые изучают наверняка, выдержали ли гарантии Азимова проверку временем. К несчастью, все они говорят: нет.

Для начала напомним эти самые три закона:

Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому и Второму Законам.

Позднее Азимов добавил четвертый, или нулевой, закон, который предшествовал остальным с точки зрения приоритета:

0. Робот не может причинить вреда человеку, если только он не докажет, что в конечном счёте это будет полезно для всего человечества.

В фантастической вселенной Азимова этим законам должны были следовать почти все роботы. Это были не просто предложения или руководящие принципы — законы были встроены в программное обеспечение. Кроме того, эти правила нельзя обойти, переписать или пересмотреть.

Как показал сам Азимов, несовершенство, лазейки и неясности в этих законах зачастую приводили к странному и нелогичному поведению роботов. Законы были слишком расплывчатыми и зачастую не могли определить и отличить «людей» от «роботов». Кроме того, роботы могли неосознанно нарушать законы, если полная информация была им недоступна. Также чересчур хитроумный робот или искусственный интеллект должен был находиться под давлением, чтобы не перепрограммировать свое ядро.

На дворе 2014 год, и многое обыденное из нашей жизни фантастам прошлого века могло показаться откровенной фантастикой. Многие люди посчитали, что законы Азимова должны были остаться в качестве литературного приема. Но сам Азимов в 1981 году отметил, что его законы могли бы работать. В статье журнала Compute! он указал следующее:

«Когда кто-то спрашивает меня, что было бы, если бы три моих закона робототехники на самом деле использовались для определения поведения роботов, ответ уже готов. Разумеется, при условии, что роботы будут достаточно гибкими и универсальными, чтобы обладать разным поведением. Я отвечаю: да, три закона — это единственный вариант, по которому люди могут взаимодействовать с роботами — или с чем-нибудь еще.

Спустя почти тридцать лет мы приблизились к реальности, в которой у нас будут роботы — или, если точнее, искусственный интеллект, который ими управляет — достаточно гибкие и универсальные для разных курсов поведения. Остается лишь вопрос времени: когда машина превзойдет человека во всех отношениях, начиная физической силой и заканчивая силой воображения.

Пугает то, что права на ошибку практически нет. Если искусственный сверхинтеллект будет плохо запрограммирован или безразличен к людям, это приведет к катастрофе. Мы должны убедиться в безопасности искусственного интеллекта, если хотим пережить его появление».

Ответить на вопрос «могут ли три закона Азимова помочь?» взялись два теоретика искусственного интеллекта: Бен Герцель (Aidyia Holdings) и Луи Хельм, замдиректора Института исследований машинного интеллекта (MIRI), а также исполнительный редактор журнала Rockstar Research. После разговора с ними стало ясно, что законы Азимова вообще никак не могут справиться с возложенной на них задачей, и если нам нужно создать безопасный ИИ, придется разрабатывать нечто совершенно иное.

Азимовское будущее?

Беседа с Герцелем и Хельмом началась с того, в чем Азимов не ошибся, предрекая будущее, а в чем ошибся.

«Думаю, что тип роботов, которых предвидел Азимов, станет возможным в недалеком будущем, — отвечает Герцель. — Тем не менее, в большинстве своих вымышленных миров, писатель предполагал, что человекоподобные роботы будут вершиной робототехники и инженерии искусственного интеллекта. Это вряд ли. Очень скоро, после достижения статуса азимовских роботов, станет доступным и создание искусственного сверхинтеллекта и сверхроботов».

Таким образом, типичный мир будущего в рассказах про роботов у Азимова, по мнению Герцеля, будет похож на тот, в котором мы живем сегодня, но с разумными роботами, гуляющими по улицам.

«Вряд ли это произойдет, а если и произойдет, то задержится ненадолго».

Для Хельма роботы представляются совершенно другими.

«Основным вопросом, который, на мой взгляд, будет самым важным для человечества, остается не моральное регулирование гигантского количества наполовину разумных гуманоидов, а в конечном итоге развитие передовых форм искусственного интеллекта (в любом теле). Это развитие сверхинтеллекта — фильтр, через который должно пройти человечество в конце концов. Именно поэтому разработка стратегии безопасности для этого перехода столь важна. Мне видится совершенно странным то, что роботы, андроиды или «эмуляции» будут существовать десять лет или чуть более до тех пор, пока человечество столкнется с настоящей проблемой разработки машинной этики для сверхинтеллекта».

Хорошее начало?

Если принять во внимание, что три азимовских закона робототехники были первой искренней попыткой решить очень серьезную проблему — проблему безопасного поведения машин с искусственным сверхинтеллектом — стоит поискать и те моменты, в которых законы могут быть все еще эффективными (или хотя бы вдохновляющими).

«Честно говоря, я не нахожу никакого вдохновения в этих трех законах робототехники, — говорит Хельм. — Суть машинной этики в том, что они не удовлетворяют базису машинной этики. Возможно, три закона робототехники широко известны, но на самом деле использовать их в качестве основы для программирования бесполезно».

«По некоторым причинам система добропорядочной этики — так называемая деонтология — стала ненадежной основой для этики. Есть ряд философов, которые пытаются исправить проблемы деонтологии, но они по большей части остаются теми же людьми, что ищут «разумный замысел» и «божественное вмешательство». Никто не воспринимает их всерьез».

Недостатки трех законов робототехники Азимова сводятся к следующим:

Состязательны по своей сути

Основаны на изжившей себя этической теории (деонтологии)

Не работают даже в фантастике

Герцель соглашается:

«Задачей трех законов было нарушить их интересным способом; вот почему рассказы с их участием особенно занимательны. Поэтому три закона могут остаться лишь нравоучительным примером того, как делать не надо. Если взять их за основу, в них неизбежно найдутся лазейки».

Герцель считает, что в реальности эти законы работать не будут, поскольку термины с их участием неоднозначны и остаются предметом толкования — а значит, крайне зависимы от тех, кто делает переводы.

Предубеждение против роботов?

Другой аспект (и потенциальный недостаток) трех законов в очевидном шовинизме —предположение о том, что роботы должны оставаться, несмотря на их превосходящую мощь, в подчинении у человека, человеческих потребностей и приоритетов.

«Общество будущего у Азимова состоит сплошь из шовинистов: у людей прав гораздо больше, чем у роботов. Три закона робототехники были созданы, чтобы поддерживать именно такой общественный порядок».

Хельм смотрит на эту проблему немного по-другому, утверждая, что если мы окажемся в такой ситуации — это само по себе будет свидетельством того, что мы зашли слишком далеко.

«Я думаю, было бы неразумно проектировать систему искусственного интеллекта или робота с самосознанием. И в отличие от фильмов или книг, в которых создатели искусственного интеллекта «случайно» приходят к разумным машинам, я не верю, что в реальном жизни это может случиться. Для этого понадобится слишком много усилий и знаний. И большинство разработчиков ИИ — этически подкованные люди, поэтому они будут избегать создания того, что философы называют «морально значимыми существами». Особенно когда они с легкостью могут создать продвинутую машину, которая не будет обладать этическими задатками».

Хельм не обеспокоен необходимостью разработки асимметричных законов, регулирующих значимость роботов по сравнению с людьми, утверждая (и надеясь), что будущие создатели искусственного интеллекта будут опираться на некоторые этические ограничения.

«Я как бы думаю, что люди сделаны из атомов, поэтому в теории инженер может создать синтетическую форму жизни или робота с моральным значением. Я хотел бы думать, что никто этого не сделает. Думаю, большинство людей тоже. Но неизбежно появится некий дурак, жаждущий известности первопроходца, даже если это неэтично и глупо».

Три закона робототехники 2.0?

Учитывая очевидные недостаки трех законов робототехники Азимова, ресурс io9 задался вопросом: можно ли их исправить или внести доработки? На самом деле, многие писатели-фантасты многократно пытались сделать это, внося поправки в течение многих лет.

«Нет, — считает Хельм. — Нет никаких «патчей» для трех законов».

Помимо своей противоречивой природы, законы еще и состязательны по своей природе.

«Я сторонник подходов машинной этики, которая более кооперативна, более последовательна и опирается на нормативы, а значит может оправиться от недоразумений или исправить неправильное программирование».

Герцель эхом вторит утверждениям Хельма.

«Определение набора этических заповедей в качестве ядра машинной этики будет безнадежным, если в основе машины будет гибкий общий искусственный интеллект. Если он будет задуман как интуитивный, гибкий, адаптивный или этический — в этом контексте этические заповеди будут полезны для системы только как грубый ориентир для применения собственной этической интуиции. Но в этом случае заповеди не станут основой этической системы, а только лишь аспектом. Это можно рассмотреть на примере людей — этические принципы, которые мы изучаем, работают, но не в качестве руководящих принципов, они лишь подталкивают нашу интуицию и этические инстинкты. Мы практически независимы от этических принципов».

Как создать безопасный искусственный интеллект?

Учитывая неадекватность правового подхода, можно поинтересоваться у Герцеля и Хельма по поводу современных подходов к проблеме «безопасного ИИ».

«Очень немногие исследователи общего искусственного интеллекта полагают, что есть возможность создать систему, которая будет полностью безопасной, — говорит Герцель. — Но это не беспокоит большинство, поскольку в этой жизни вообще нельзя ничего гарантировать».

Герцель считает, что как только мы создадим систему общего искусственного интеллекта или ее зародыш, мы сможем провести исследования и эксперименты, которые расскажут нам об этике ИИ куда больше, чем мы знаем.

«Надеюсь, таким образом мы сможем сформулировать хорошие теории по этике искусственного интеллекта, которые позволят нам углубиться в эту тему. Но сейчас теоретизировать об этике ИИ довольно трудно, поскольку у нас нет не просто хороших теорий, у нас вообще никаких теорий нет».

«А людям, которые смотрели слишком много «терминаторов», процесс создания искусственного интеллекта может показаться пугающим, поскольку они упускают слово «примитивный» в этом контексте. Тем не менее, самые радикальные изменения случались именно таким образом».

«Когда группа умных пещерных людей изобрела язык, они не ждали разработки прочной формальной теории языка, которая могла бы помочь спрогнозировать будущие изменения, вызванные появлением языка в обществе».

Прежде чем считать разработку очередных «трех законов» технической проблемой, нужно провести массу исследований. И в этом Хельм и Герцель сходятся.

«Мой коллега из MIRI Люк Мюельхаузер подвел итоги наших рассуждений следующим образом. Он сказал, что проблемы часто переходят из области философии в математику, а затем в инженерию. Философия зачастую задается правильными вопросами, но самым непрактичным образом. Никто не может наверняка сказать, есть ли какой-либо прогресс в разрешении вопроса. Если мы сможем переформулировать важные философские проблемы, связанные с разумом, идентификацией и ценностью в точные формулы, с которыми сможет справиться математика, тогда можно будет построить кое-какую модель. В один прекрасный день дойдет и до инженерии».

Хельм считает эту проблему сложной для науки и философии, но прогресс возможен.

«Я скептически отношусь к тому, что философия сможет решить вопрос, над которым бьется более 3000 лет. Но мы тоже не можем взять и начать составлять математические модели вопросов, которых нет технически. Нужно еще много теоретических и даже практических наработок».

salik.biz

Трем законам робототехники азимова — Ваше право

Три закона роботехники Айзека Азимова

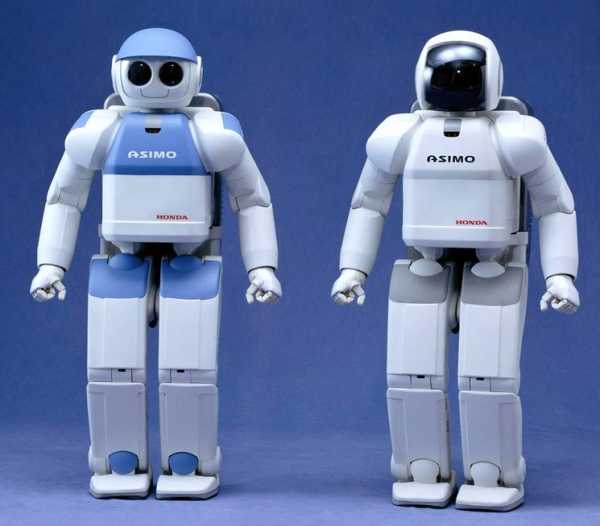

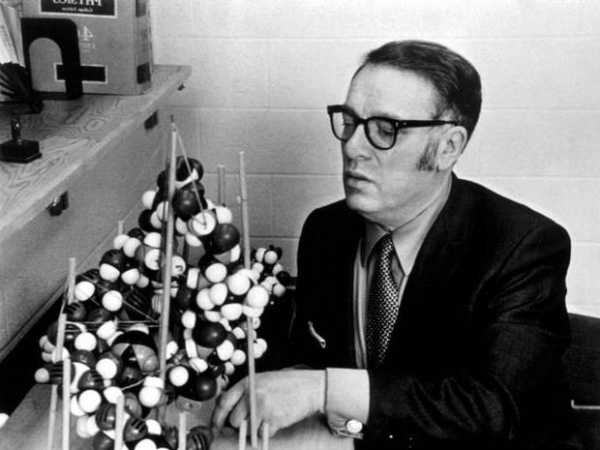

Родился Айзек Азимов 2 января 1920 года в местечке Петровичи. В то время оно относилось к Мстиславльскому езду Могилевской губернии, сегодня же Петровичи входят в состав Смоленской области. В 1923 году Азимов с семьей переехал в США, где он и умер в 1992 году.Айзик Азимов начала писать с 11 лет. Первая его публикация состоялась в 1939 году, когда журнал Amazing stories опубликовал его рассказ «В плену у Весты».

Известность пришла к Азимову спустя два года, после публикации рассказа «Приход ночи». В нем повествуется о планете, окруженной шестью звездами, вследствие чего ночь наступает здесь только раз в 2049 лет. Рассказ стал водоразделом в литературной карьере Азимова, превратив никому неизвестного фантаста в знаменитого писателя.

Примерно в это же время Айзек Азимов начал работать в направлении роботехники. Именно его рассказы, касающиеся роботов и их места в мире, принесли писателю мировую славу. В 1941 году в рассказе «Лжец», где главный герой-робот умел читать мысли, впервые появляются знаменитые три закона роботехники. Сам Айзек Азимов заявляет, что авторство законов принадлежит не ему, а Джон Вуду Кэмпбеллу, однако тот, в свою очередь, опровергает это заявление, утверждая, что он лишь помог сформулировать их, сама же идея всецело принадлежит Азимову. Так или иначе, три закона робототехники объединили множество рассказов и романов писателя, и до сих пор вызывают споры и дебаты в научном мире. Одно из самых главных направлений споров ученых касается того, применимы ли данные законы в реальности.

Итак, три закона робототехники по Азимову звучат следующим образом:

1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.2. Робот должен повиноваться всем приказам, которые дает человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.3. Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому и Второму Законам.

Эти три закона проходят через все творчество Айзека Азимова. В своих рассказах писатель пытался преподнести их не как постулаты или аксиомы, а как этику роботов, можно даже сказать, инстинкты. Фактически, три закона роботехники представляли собой сложнейшие математические формулы, на которых строилось сознание роботов и без которых оно просто не могло существовать. Сюжеты вех рассказов Азимова строились на причинах и следствиях нарушения трех законов или, наоборот, последствиях, которые вызывает соблюдение данных законов роботами. Персонаж одного из рассказов Азимова, рассуждая о трех законах роботехники, приходит к выводу о том, что тот, кто соблюдает их, или робот, или очень хороший человек. Этим автор хотел сказать, что три закона, сами по себе, совпадают с основными принципами большинства этических систем.

В 1986 году, в последнем рассказе из цикла, посвященного роботехники, Айзек Азимов формулирует так называемый нулевой закон:

0. Робот не может причинить вреда человеку, если только он не докажет, что в конечном итоге это будет полезно для всего человечества.

По признанию самого писателя, его тремя любимыми рассказами являются «Последний вопрос», «Двухсотлетний человек» и «Уродливый мальчуган». По роману «Двухсотлетний человек» был поставлен фильм, в котором робота-слугу блистательно сыграл Робин Уильямс.Кроме этого, в 2004 году по мотивам рассказов Айзека Азимова вышел фильм «Я-робот» с Уиллом Смитом в главной роли. В центре картины – полицейский, с недоверием относящийся к роботам, которые прочно занимают место в жизни людей. Обстоятельства сталкивают главного героя с роботом, не похожим на остальных своих собратьев, поскольку он отказывается подчиняться законам трем законам робототехники. Однако вскоре выясняется, что только благодаря этому удается спасти человечество.

Творчество Айзека Азимова по-прежнему остается актуальным, свежим и интересным. В наше время бурного развития технологий, в том числе кибернетики и роботехники, проблемы, поднятые писателем более полувека назад, так и остаются актуальными и нерешенными. Возможно, внимательно изучив творчество Айзека Азимова и его три закона роботехники, мы сможем избежать многих роковых ошибок?

roboting.ru

Трем законам робототехники азимова

В одном из циклов книг писателя-фантаста Айзека Азимова, который называется «Я, робот» говорится о трёх законах робототехники:

В первом законе говорится о том, что робот не может причинить вреда человеку.

В соответствии со вторым законом робот должен слушаться человека, если это согласуется с первым законом.

По третьему закону робот не может причинить себе вреда, если это соответствует первому и второму законам.

Конечно, эти законы вымышленные, но мне кажется, можно использовать их и в реальной жизни. Правда, они, даже в книге, рассчитаны на мыслящих роботов, близких к искусственному интеллекту или же являющимися искусственным интеллектом, но это, как мне кажется, не меняет дела, и кроме того, получается, что второй закон не зависит от программы и робот всегда соблюдает его, ведь он действует в соответствии с программой, а сам не может вызывать в ней отклонений по причине, что он не является искусственным интеллектом. Остальные законы зависят от программы, данной роботу. Например, первый закон: робота можно запрограммировать на врача: можно заложить в него навыки, каждый из которых проявляется при соответствующей ситуации. Допустим, при условии, что робот обнаружил, скажем, плохое зрение по показаниям, то он ищет, какиет очки соответствуют зрению. С третьим законом проще: если робот, допустим, видит, что впереди высокое напряжение, опасное для него, то он просто может выбрать другой путь, безопасный.

Но эти законы создают и парадоксы: если роботу нужно добраться до определённого места (В этом случае робот идёт от Второго Закона) или до больного (В этом случае робот идёт ещё и от Первого Закона), и встречает на своём пути какое — то непреодолимое препятствие (Например, то же высокое напряжение), то Второй и, возможно, Первый законы заставляют идти его вперёд, а Третий Закон заставляет отступить перед опасностью. Мыслящие роботы рассудили бы ещё и так: если бы робот был бы уничтожен, то пользы от этого не будет. Всё равно к месту не проберёшься (Не спасёшь больного). Останется-ка лучше робот целым.

Подобные случаи описаны в книгах из цикла «Я, робот», которые называются «Хоровод» и » Как потерялся робот«

Я абсолютно с вами согласен, Илья Петрович. Я также хочу сказать про решение случая с радиацией (А что если впереди – зона повышенной радиации, и робот не знает, что радиация может вывести из строя его мозг? Или, у него просто нет соответствующих датчиков-сенсоров? Он пойдёт туда и погибнет, хотя будет руководствоваться третьим законом. — писали вы). Для этого можно разместить датчики на простейших роботах (их можно называть роботами 1 — с разумом 1 уровня. Чем выше уровень, тем больше разума), которые бы реагировали на изменения. Если роботу непонятно что-либо, то он может и в этом случае переслать сообщение роботам 2 или промежуточными значениями между 1 и 2. Если же и роботы от 1 до 2 не могут справиться, то они пересылают информацию роботам от 2 до 3 и т. д. Можно сделать общий справочный мозг с более большим уровнем интеллекта (например, 50). Конечно, нужно предусмотреть действия при потере связи. Так, например, если бы роботы-исполнители переадресовали вопрос вершителям, но и они не знали бы ответа, то перегорели бы и исполнители, и вершители. Следующая цитата: Ведь если робот простой, то и лечить он будет очень грубо и принесёт больше вреда, чем пользы, хотя и будет действовать в полном соответствии с первым законом. На этот счёт говорю, что для этого достаточно делать для лечения более высоких по разуму роботов. А можно поставить роботов более низких уровней им в помощники и образовать четвёртый закон: рбот должен подчиняться роботу более высокому, чем он, если это соответствует остальным трём законам.

Миша, ты продолжаешь развивать интересную идею иерархического мира роботов. Это мир всё более похож на устройство человека. Например, идея с датчиками радиации (и многих других воздействий) на простейших роботах. Рука человека обладает определёнными рецепторами: температуры, прикосновения, положения в пространстве, но на ней нет рецепторов, позволяющих видеть. Это компенсируются глазами, данные от которых синтезируются в мозге с данными от руки и создают целостную, более богатую картину окружающего мира, чем рука или глаза по отдельности.

Поскольку роботы простейшие, они относительно недороги, их можно сделать много и с самыми разными датчиками. А вот роботы 2-го, 3-го и так далее уровней – более сложные и более дорогие, но их и не нужно делать много. Не нужно к каждому «исполнителю» приставлять по одному «вершителю». Например, один «вершитель» может управлять десятком или сотней исполнителей, обобщать и систематизировать информацию от них и выдавать им найденное решение проблемы.

В случае потери связи некоторых исполнителей с вершителями, в этом, конечно, не будет ничего хорошего, прежде всего, ДЛЯ ИСПОЛНИТЕЛЕЙ, но и для системы в целом. Они могут погибнуть, но также и поставить под угрозу систему в целом. Также и в человеческом организме. Например, если некая часть тела теряет связь с центральной нервной системой (если нервы повреждены), это может привести к тому, что эта часть тела со временем может погибнуть. На медицинском языке это называется «вялый паралич». Но если в парализованной руке начнётся гангрена, это может погубить весь организм.

Идея по поводу 4-го закона – замечательная! Только я пока не понимаю, на каком месте должен стоять этот закон? У какого из законов приоритет будет выше – у 4-го или у 1-го или 3-го? Если у 1-го и 3-го — выше, то кто будет решать вопрос о понятиях «вреда для человека» и «вреда для робота»? Мы уже убедились, что если отдать эти вопросы роботам 1-го уровня, ничего хорошего из этого не выйдет. В идеале, «моральный кодекс робота» должны определять роботы 50-го уровня. А, значит, 4-й закон должен иметь максимальный приоритет. Но, если мы так отодвинем 1-й закон с пьедестала, то мы рискуем тем, что слишком умный робот 50-го уровня решит «а зачем нам люди, если мы умнее их?», что приведёт к очень плохим для человека последствиям.

Отвечаю насчёт 4 закона. Я уже говорил насчёт того, что можно создать одного неподвижного робота, цель которого — давать советы другим роботам с более низким уровнем интеллекта. Если этот робот не может справиться с заданием, то по программе он. посылает роботу действия, которые бы помогли ему. Если бы вершители отдали команду исполнителям: НЕ ДУМАТЬ (!) над «А и Б сидели на трубе»: для чего им это? Где цель? Человеку это так-то не нужно? Не нужно! Говорю далее: «слишком умный робот 50-го уровня решит «а зачем нам люди, если мы умнее их?»» — пишете вы. Надо дать понять роботу Z (так я буду называть этого робота), что без людей он и другие роботы пропадут, об этой причине в сами и писали: «Они могут погибнуть, но также и поставить под угрозу систему в целом». Кроме того, робот в случае необходимости может обратиться за помощью к людям, Которые за ним ухаживают. Если они перестанут это делать, то если в роботе Z что-либо поломается, то он не будет знать, как устранить поломку, ведь о нём до этого заботились люди, а поскольку у этого робота самый высокий интеллект, а у других роботов он ниже, то никто не сможет починить робота Z, и всё погибнет! Если же роботы ниже его решат, что робот Z им не нужен, то они не смогут получать необходимую для них информацию и пропадут по то же причине, что и робот Z без людей. Что касается приоритета, то по всем законам выше первый.

В этих рассуждениях предполагается, что робот Z ниже по уровню, чем человек. А если он – выше? Зачем тогда ему слушаться человека? Таким образом, 2-й закон ставится под сомнение. И это, кстати, не требует от робота особенно высокого развития. Ведь люди – разные. И какой-то конкретный человек, управляющий роботом в данный момент времени, может оказаться глупее его. 🙂 Тогда выполнение 2-го закона нерационально. И, кстати, к кому тогда должен обращаться робот Z, если перед ним возникнет неразрешимая проблема?

Ответ на ваш вопрос о роботе Z. Робот Z по уровню выше человека лишь частично. Он знает всё, кроме своего устройства. Если о нём будут заботиться другие роботы, то получится парадокс: если свою схему не знает Z, то как могут знать её низшие роботы? Для собственной же безопасности людей желательно не вкладывать ему и другим роботам (я их назову -Z, т. е. меньше Z по уровню) схему Z. Это будет его слабость и люди могут пользоваться ей, как я писал ранее. Если же заложить роботам -Z схему скрыто от Z, то человек вследствие того, что ему ничего не надо делать, деградирует, а при восстании роботов из-за собственной лабости ничего не сможет сделать даже без деградации. Если роботы просто отделятся от людей, то Homo, похоже, Не sapiens вымрет! Теперь следующий вопрос: к кому должен обращаться робот Z, если перед ним возникнет неразрешимая проблема? Отвечаю: к людям. Говоря о роботах я не говорю, что люди с ними связаны только заботой роботов о людях. Несколько миллиардов, а может и больше людей на робота Z — я считаю, это нормально. Кстати, можно разместить материал в будущей газете «Солярис». Вы не возражаете? Для выполнения первоначального плана 1 выпуска мне осталось напечатать 33 с долями процента — ровно треть!

По поводу не очень умного человека, управляющего умным роботом приведу такой пример. Допустим, он даёт команду роботу – отвинтить гайки с рельсов, по которым скоро пройдёт поезд. Это может привести к крушению поезда и гибели многих людей. Робот это понимает, а человек, почему-то – нет. Должен ли в этой ситуации робот подчиняться 1-му закону и выполнять команду человека?

www.spacephys.ru

Как работают три закона робототехники Айзека Азимова и зачем их придумали?

Три закона робототехники — свод обязательных правил, которые должен соблюдать искусственный ителлект (ИИ), чтобы не причинить вред человеку. Законы используются только в научной фантастике, но считается, что как только будет изобретен настоящий ИИ, в целях безопасности, он должен иметь аналоги этих законов.

Формулировка

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Кто придумал и почему

Коротким и правильным ответом будет: писатель-фантаст Айзек Азимов, биографию которого вы можете почитать у нас. Но не всё так однозначно, давайте разберемся откуда пришла идея.

До Азимова, почти все фантастические произведения на тему роботов, писались в стиле романа о Франкенштейне, то есть все созданные человеком существа восставали против своих создателей.

Эта проблема стала одной из самых популярных в мире научной фантастики в 1920—1930-х годах, когда было написано множество рассказов, темой которых являлись роботы, восставшие и уничтожившие своих создателей. Мне ужасно надоели предупреждения, звучавшие в произведениях подобного рода.

Однако, были и немногочисленные исключения, Азимов обратил внимание на два рассказа. “Хелен О’Лой”, написанный Лестером дель Реем, где повествуется о женщине-роботе, которая влюбилась в своего создателя и стала для него идеальной женой. И рассказ Отто Биндера “Я, робот”, в котором описывается судьба непонятого людьми робота Адама Линка, движимого принципами чести и любовью.

Последний рассказ настолько понравился Азимову, что он, после встречи с Биндером, начал писать свою собственную историю о благородном роботе. Однако, когда он пошёл со своей рукописью к своему другу и главному редактору журнала “Astounding” Джону Кэмпбеллу, тот её не принял, сославшись на то, что получившийся рассказ слишком похож на “Хелен О’Лой”.

Отказ в публикации было дело обычным, и Азимов, и Кэмпбелл регулярно встречались и обсуждали новинки в мире фантастики. За обсуждением очередного Азимовского рассказа о роботах, 23 декабря 1940 года, Кэмпбелл сформулировал те самые три правила, которые мы сейчас называем законами робототехники. Но сам он говорил, что только лишь вычленил их из того, что уже было написано Азимовым, потому что в его рассказах прослеживалось, что роботы имеют какие-то ограничения и правила. Сам Айзек, всегда уступал честь авторства законов Кэмпбеллу. Но позже, один из друзей Азимова сказал, что законы родились во взаимовыгодном товариществе двух людей, с чем они и согласились.

Как работают

В идеальной ситуации, по задумке Азимова, эти три закона заложены в самую основу математической модели позитронного мозга (так фантаст называл мозг робота, обладающего искусственным интеллектом), таким образом, что думающего робота без этих законов создать в принципе невозможно. А если робот попытается нарушить их, то он выйдет из строя.

В своих произведениях, писатель придумывает изощренные способы того, как эти законы все-таки могут быть нарушены, подробно разбирает всевозможные причины и следствия. Автор также говорит о том, как по-разному они понимаются роботами, к каким нежелательным последствиям могут привести соблюдение этих трёх законов или как роботы могут причинить вред человеку косвенно, сами того не подозревая. Азимов признавался, что намеренно сделал законы двусмысленными, чтобы обеспечить больше конфликтов и неопределенностей для новых рассказов. То есть, он сам опровергал их эффективность, но и утверждал, что подобные нормы — это единственный способ сделать роботов безопасными для людей.

Как следствие этих законов, позже Азимов формулирует четвертый закон робототехники, и ставит его на самое первое место, то есть делает его нулевым. Он гласит:

0. Робот не может нанести вред человечеству или своим бездействием допустить, чтобы человечеству был нанесён вред.

На языке оригинала:

0. A robot may not harm humanity, or, by inaction, allow humanity to come to harm.

Эти законы можно также примерить и к человеческим взаимоотношениям, и к государственному устройству, и вообще к чему угодно. Можно, например, заменить слово «робот» на слово «государство».

- Государство не должно вредить людям или своим бездействием допустить, чтобы им был причинён вред.

- Государство должно выполнять свои функции, если они не противоречат Первому Закону.

- Государство должно заботиться о своей безопасности, если это не противоречит Первому и Второму Законам.

Есть хорошая цитата из рассказа «Улики», где один из персонажей говорит:

Если кто-то исполняет все эти законы безукоризненно, значит это либо робот, либо очень хороший человек.

Первое упоминание

Три закона появлялись постепенно. Так, косвенные упоминания первых двух, можно встретить в рассказах “Робби” и “Логика”. Точная же формулировка первого закона впервые звучит в рассказе “Лжец”. И, в конечном итоге, все три полностью сформулированы в рассказе “Хоровод”.

Изначально в первых двух рассказах не было точных формулировок, они добавились позже, когда к публикации готовился сборник «Я, робот».

В своих произведениях Азимов неоднократно изображает роботов, которые имели модифицированные законы робототехники или даже модифицировали их сами. Делали они это логическими размышлениями, причем роботы, также как и люди, отличались в своих интеллектуальных способностях между собой, и можно грубо сказать, что чем умнее робот, тем сильнее он мог модифицировать законы. Так, например, робот Жискар из романов «Роботы утренней зари» и «Роботы и Империя», эти законы даже усилил, добавив нулевой закон. Но это исключение из правил, в большинстве же случаев, законы были переделаны людьми в своих целях, или нарушались из-за каких-либо сбоев у робота.

Кстати, сама возможность изменения законов менялась по ходу развития робототехники во вселенной Азимова. Так, в самых ранних рассказах, где события развивались в относительно недалеком будущем, законы были просто неким сводом правил, созданным для безопасности. Затем, во времена жизни робопсихолога Сюзан Келвин, законы стали неотделимой частью математической модели позитронного мозга робота, на них базировались сознание и инстинкты роботов. Так, Сюзан Келвин, в одном из рассказов, говорила, что изменение законов технически возможная, хотя и очень сложная и трудоемкая задача, да и затея сама по себе ужасная. Намного позднее, в романе “Стальные пещеры”, доктор Джерригел говорил, что такое изменение невозможно в принципе.

Как обойти

В некоторых рассказах законы так сильно переосмысливались, что не соблюдался самый главный из них — причинение вреда человеку, а где-то роботы умудрялись нарушить все три закона. Вот некоторые произведения с явным нарушением.

Рассказывается байка о роботе МА-2, которая отказалась защитить человека, в пользу своей “дочери”.

Робота хотели лишить способности творить, за что он хотел убить своего хозяина.

Этот рассказ скорее не относится к другим о позитронных роботах, но в нем повествуется о роботах-автомобилях, которым люди постоянно причиняли боль, за что те и способны были их убить.

О роботе Элвекс, который из-за своего особого строения позитронного мозга умел находиться в бессознательном состоянии и видеть сны. В его снах, роботы не имеют первых двух законов, а третий был изменен: “Робот должен защищать себя”. Ему снилось, что “роботы трудятся в поте лица своего, что они удручены непосильными трудами и глубокой скорбью, что они устали от бесконечной работы”. Довольно опасные мысли для робота.

У жителей планеты Солярия робототехника была очень развита. И ученые этой планеты с небольшим населением, где на одного человека приходилась тысяча роботов, изменили законы таким образом, что их роботы считали людьми только тех, кто говорит с солярианским акцентом. Помимо прочего, все граждане Солярии имплантировали себе в мозг специальные органы управления множеством роботов, так, что никто кроме них не мог ими управлять.

В этом произведении Азимов максимально изменил законы. Два робота в этом рассказе пришли к соглашению, что органическое происхождение — это необязательное условие чтобы считаться человеком, и что истинные люди — это роботы, как более совершенные и разумные создания. Обычные же люди, по их мнению, тоже люди, но с меньшим приоритетом, и законы робототехники в первую очередь применимы к ним, роботам.

Хочется добавить, что у “здоровых” роботов, в случае если они понимали, что нарушили первый закон или не могут его не нарушить, происходил “робоблок” или “умственное замораживание” — состояние позитронного мозга, при котором происходило его повреждение и робот или выходил из строя, или не мог правильно функционировать. Такое повреждение могло иметь как временный, так и постоянный характер.

Впервые описание такого события появилось в рассказе “Лжец”, где слишком чувствительный робот говорил людям только то, что они хотели услышать, боясь причинить им психологический вред. Интересный случай робоблока описан и в “Хороводе”. Также это состояние имеет важную роль в романах “Обнажённое солнце” и “Роботы утренней зари”.

Использование в другой фантастике

Айзек Азимов верил, что его законы помогут по-новому взглянуть на роботов и побороть “феномен Франкенштейна” в массовом сознании людей и в научной фантастике. И что роботы могут быть интересными, а не просто механическими устройствами. И надо сказать, ему это удалось. Любимый его пример, где роботы показаны с разных сторон, был фильм Звездные войны. Кстати, читайте статью о том, как Азимов повлиял своими произведениями на Джорджа Лукаса.

Другие авторы, в итоге, тоже подхватили идею, и стало появляться все больше роботов в научной фантастике, подчиняющихся трем законам. Но, по традиции, указывал их явно только Азимов.

Нередко можно встретить различные отсылки в фильмах. Ниже перечислены некоторые примеры.

Запретная планета — 1956 г.

Очень нашумевшая американская научно-фантастическая картинка 1950-х, оказала определенное влияние на развитие жанра. В этом фильме, чуть ли не впервые показали робота со встроенной системой безопасности, то есть, по сути, выполняющего три закона. Сам Азимов был доволен этим роботом.

Тут и нечего говорить, фильм поставлен по одноименному произведению Азимова. Однако, законы не имеют центрального места в сюжете.

Фильм начинается со слов “По мотивам рассказов Айзека Азимова”. Здесь надо понимать, что он именно “по мотивам” и не повторяет ни один из рассказов, и даже ушел несколько в сторону в некоторых идеях, а также имеет ряд противоречий с рассказами. Но законы робототехники более чем на месте, хотя и были обдуманы сверх интеллектом в не лучшую для человека сторону. Сам по себе фильм даже ставит социально-философские проблемы: “стоит ли человеку за свою безопасность платить свободой” и “как нам себя вести, если существа, созданные нами и находящиеся в нашем распоряжении, потребуют свободы”.

Серия фильмов «Чужие» и «Прометей»

Андроид Бишоп цитирует первый закон и явно создавался на некоем подобии законов Азимова.

Мультсериал «Футурама» — 1999 — 2013 г.

Робот Бендер мечтает убить всех людей, но не может этого сделать из-за законов робототехники.

Аниме сериал «Время Евы» — 2008 — 2009 г.

Небольшой аниме сериал про андроидов. В нем упоминаются эти законы, как обязательные для исполнения.

Применимость в реальном мире

Люди, которые сейчас занимаются проблемами искусственного интеллекта говорят, что, к сожалению, Азимовские законы остаются лишь идеалом для будущего, и на данный момент применить их на практике даже близко не представляется возможным. Нужно будет придумать действительно какую-то фундаментально новую и гениальную теорию, которая позволит эти законы не только «объяснить” роботам, но и заставить их следовать им, причем на уровне инстинктов. А это уже создание настоящего думающего существа, но с другой основой, нежели у всех живых существ на Земле, которые нам известны.

Но исследования ведутся, причем тема очень популярна. Особенно заинтересован в этом бизнес, который, как вы знаете, не обязательно будет ставить в приоритет меры безопасности. Но в любом случае, до создания системы общего искусственного интеллекта или хотя бы ее примитива, говорить о ее этике рано, а, уж тем более, навязывать свою. Понять как себя будет вести интеллект мы сможем только тогда, когда создадим его и проведем ряд экспериментов. Пока что у нас отсутствует объект, к которому эти законы можно было применить.

Ещё не стоит забывать, что законы сами по себе не были созданы совершенными. Они не работали даже в научной фантастике, и как вы помните, были специально такими сделаны.

В общем, будем ждать, следить за новостями в исследованиях ИИ, и надеяться что Азимовский оптимизм, по части роботов, будет оправдан.

asimovonline.ru

Три закона робототехники Айзека Азимова — проблемы будущего

Три закона робототехники, которые занимают весьма значительную роль в фантастике научного плана, просто необходимы в правилах поведения роботов. Изначально, они были задействованы в рассказе «Хоровод», известным писателем Айзека Азимова.

В свою очередь, эти законы гласят:

- Никогда робот не сможет нанести вред человечеству. Но есть и альтернативная вариация: робот не способен принести плохое человеку, при этом бездействуя.

- Робот, просто не может не исполнять те приказы, которые отдает человек. Но и здесь, есть свои исключения: если приказы будут противоречить Первому закону, то они невыполнимы.

- Также робот не может не заботиться о собственной безопасности в том объеме, в котором это не противодействует законом первой и второй категории.

Всем этим Трем законам, в которых заключены как причины, так и следствия их невыполнения, был посвящен и опубликован целый сборник повестей автора Азимова, и все они рассказывают о роботах.

Есть также и другие рассказы, в которых было рассмотрен тот этап, на котором нельзя предвидеть последствия выполнения роботами всех Трех законов. К примеру, такой повестью можно считать «Зеркальное отражение».

В одной из своих повестей автор положил конец основе, которая заключалась в этические рамки Трех Законов. По его словам, робот, который выполняет все Три Закона является, как таковым, роботом, либо очень хорошим человеком. Ведь мораль дана человеку, чтобы он следовал ей. В какой-то мере, человек, выполняя большой объем всевозможных условий, законов, тоже является роботом. Так почему это железное «существо» не может претендовать на звание «человека»?!

Нулевой закон для роботов

Еще в 1985 году, в одном из многочисленных своих романов про роботов, автор посмел упомянуть еще и про Нулевой закон, суть которого заключалась в следующем: Робот никогда не причинит зла и вреда человеку, а также собственным бездействием он не даст причинить вреда.

В принципе, необходимо отметить, что во всех упомянутых законах есть часть того, о чем следует задуматься. Мир не стоит на месте, и неизвестно, что еще такого гениального можно ожидать людям – сегодня будущее за молодым поколением, у которого в голове сотни всевозможных идей.

Также можно сказать, что все три закона робототехники являются еще и темой для фантастических идей Азимова. Сюда входит еще и тот цикл, который очень тесно связан со всей тематикой, посвященной роботам.

В чем заключается мораль Трех законов

Нельзя пройти мимо и не упомянуть обоснование этического плана. В одном из рассказов под названием «Улика», автор очень хорошо разложил обоснования морали всех Трех законов. Как правило, человек не то, чтобы не хочет нанести вред другому человеку, а просто старается воздержаться от этих поступков. Но и здесь есть свои исключения, как и в любом правиле. На войне это обоснование просто не действует.

Ощущая ответственность перед социумом, человек следует выполнению указаний тех людей, которые относятся к представителям врачей, учителей и так далее. Здесь идет проявление второго закона.

То, что человек беспокоится и оберегает себя, вбирает в себя Третий закон. Таким образом, все эти законы очень связаны между собой и просто не могут существовать друг без друга. Может быть так, что будет действовать Первый закон, и следом он может плавно перейти во Второй, а там и в Третий закон. Здесь, мораль и элементы фантастики идут в совокупности друг с другом.